ChatGPT のリリースは AI 分野全体に衝撃を与え、大手テクノロジー企業、新興企業、大学チームもこれに追随しています。最近、Heart of the Machine は多くのスタートアップ企業や大学チームの研究結果を報告してきました。

昨日、別の大規模な国内 AI 対話モデルが堂々とデビューしました。ChatGLM は、清華社の技術的成果を基に変換された同社のスマート スペクトル AI であり、GLM-130B 1000 億ベース モデルに基づいています。 、現在、内部テストの招待を受け付けています。

Zhipu AI は、単一の消費者向けグラフィックス カードでの推論をサポートする中国語と英語のバイリンガル対話モデル ChatGLM-6B もオープンソース化していることは言及する価値があります。

#社内ベータ アプリケーション Web サイト: chatglm.cn

ChatGLM モデルの現行バージョンの機能向上は、主に独自の 1,000 億ベース モデル GLM-130B によるものであることがわかります。 BERT、GPT-3、T5 とは異なるアーキテクチャであり、多目的関数を含む自己回帰事前トレーニング モデルです。

2022 年 8 月、清華大学と Zhipu AI は、1,300 億のパラメーターを備えた中国語-英語バイリンガル密モデル GLM-130B を研究コミュニティと業界に公開しました。このモデルにはいくつかの独自の機能があります。 :

ChatGPT の設計思想を参照して、ChatGLM は教師あり微調整 (教師あり微調整) を通じて、GLM-130B ベース モデルにコードの事前トレーニングを注入しました。 ) など、人間の意図の調整を実現するテクノロジー。

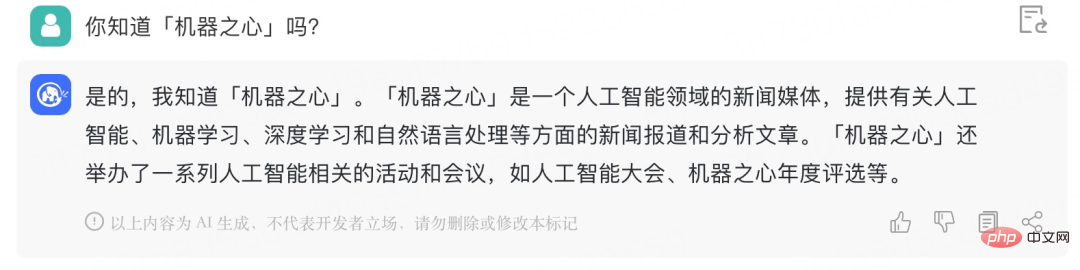

Heart of the Machine は内部ベータ招待コードを取得しました。これは ChatGLM との簡単な会話です。効果は次のとおりです:

「ステーション CP」の実際の意味を理解できます:

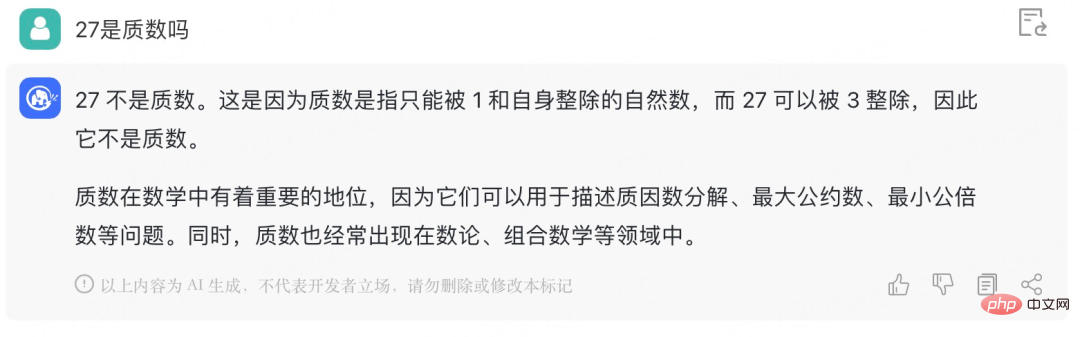

ChatGLM に数学の問題を与えて試してください:

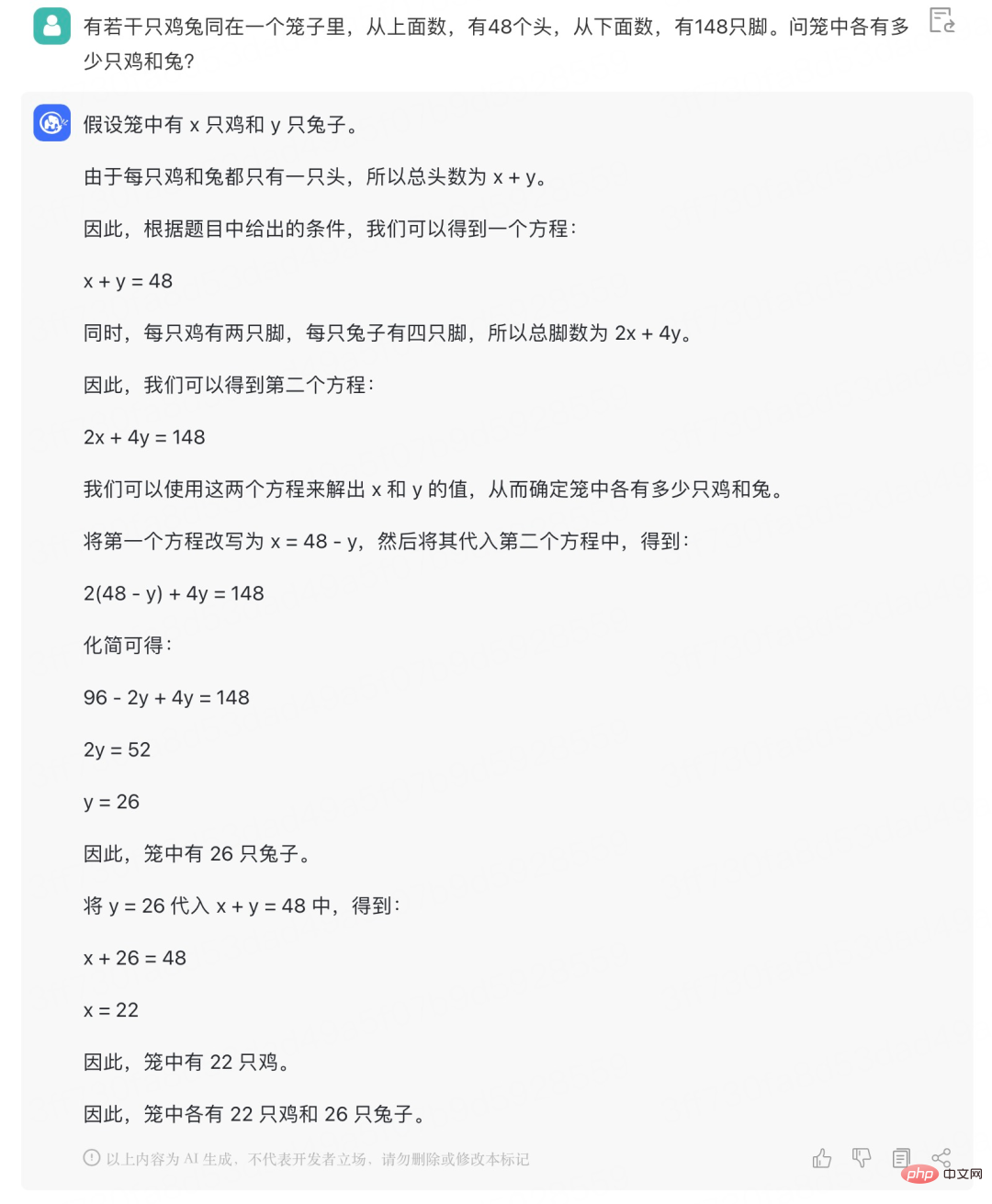

2 変数の線形方程式を学んだので、このような基本的な「ニワトリとウサギを同じかごに入れる」問題はもう解けなくなりました。困った:

ChatGLM-6B は、中国語と英語のバイリンガルの質疑応答をサポートし、中国語用に最適化されたオープンソースの対話言語モデルです。このモデルは一般言語モデル (GLM) アーキテクチャに基づいており、62 億のパラメーターがあります。モデル量子化テクノロジーと組み合わせることで、ユーザーはそれを民生用グラフィック カードにローカルに展開できます (INT4 量子化レベルでは最低 6GB のビデオ メモリが必要です)。 ChatGLM-6B は ChatGLM と同じテクノロジーを使用しており、中国語の Q&A と対話に最適化されています。約 1T の識別子を使用した中国語と英語のバイリンガル トレーニングを経て、教師付き微調整、フィードバック セルフサービス、ヒューマン フィードバック強化学習、その他のテクノロジーによって補完された、62 億パラメータの ChatGLM-6B (1,000 億モデルほどではないものの、推論コストが大幅に削減され、効率が向上し、すでに人間の好みと完全に一致する答えを生成できるようになりました。

モデルのオープンソース アドレス: https://github.com/THUDM/ChatGLM-6B

具体的には、 ChatGLM-6B には次の特徴があります:

#ただし、ChatGLM-6B モデルの容量が小さいため、次のような制限や欠点が必然的に発生します。 #モデルの記憶力と言語機能が比較的弱い。 ChatGLM-6B は、多くの事実知識のタスクに直面すると、誤った情報を生成する可能性があり、論理的な問題 (数学、プログラミングなど) を解決するのがあまり得意ではありません。

以上がChatGLM は清華ベースのギガビット基本会話モデルであり、内部テストが開始されており、モデルのオープンソース シングルカード バージョンです。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。