誰もが知っているように、ChatGPT に関しては OpenAI はオープンではありません。Meta からオープンソース化されている Yangtuo シリーズ モデルも、データ セットなどの問題により「学術研究アプリケーションに限定されています」。方法を制限する場合、100% オープンソースに焦点を当てた大きなモデルが登場します。

4 月 12 日、Databricks は Dolly 2.0 をリリースしました。これは、2 週間前にリリースされた ChatGPT のような人間の対話性 (命令に従う) 大規模言語モデル (LLM) の別の新しいバージョンです。

Databricks によれば、Dolly 2.0 は業界初のオープンソースで、指令に準拠した LLM であり、同じくオープンソースであり、透明で自由に利用できるデータセットに基づいて微調整されています。 。これは、Dolly 2.0 を使用して、API アクセスに料金を支払ったり、サードパーティとデータを共有したりすることなく、商用アプリケーションを構築できることを意味します。

Databricks は、Dolly 2.0 が微調整された databricks-dolly-15k というデータセットもリリースしました。これは、数千人の Databricks 従業員によって生成された 15,000 件を超えるレコードのコーパスです。Databricks はこれを「初のオープンソースで人間が生成した命令コーパスであり、特に大規模な言語で ChatGPT の魔法のような対話性を実証できるように設計されています」# と呼んでいます。

##Dolly 2.0 の誕生の経緯

過去 2 か月で、産業界と学界は OpenAI に追いつき、指示に従う ChatGPT のようなツールの波を提案してきました。モデル、これらのバージョンは、多くの定義によりオープン ソースとみなされます (または、ある程度のオープン性または制限されたアクセスを提供します)。中でも最も注目を集めているのがMeta社のLLaMAで、これをきっかけにAlpaca、Koala、Vicuna、Databricks社のDolly 1.0など、さらに改良されたモデルが数多く誕生しました。しかし一方で、これらの「オープン」モデルの多くは、商用利用を制限するように設計された条件を使用してデータセットでトレーニングされているため、「産業上の制限」下にあります。たとえば、52,000 StanfordAlpaca プロジェクトの質問と回答のデータセットは、OpenAI の ChatGPT の出力でトレーニングされました。また、OpenAI の利用規約には、OpenAI のサービスを競合目的で使用できないという規則が含まれています。

Databricks は、この問題を解決する方法を考えました。新しく提案された Dolly 2.0 は、オープンソースの EleutherAI pythia モデル シリーズに基づいており、特に小規模なオープン ソースの指示レコード コーパス Fine-tuned (databricks-dolly-15k) であるこのデータセットは、Databricks の従業員によって生成され、学術アプリケーションや商用アプリケーションを含むあらゆる目的での使用、変更、拡張を許可する条件に基づいてライセンス供与されています。

これまで、ChatGPT の出力でトレーニングされたモデルは法的にグレーゾーンにありました。 「コミュニティ全体がこの問題を回避しようとしており、誰もがこれらのモデルをリリースしていますが、どれも市販されていません」とゴディ氏は語った。 「だからこそ、私たちはとても興奮しているのです。」 「他の人は皆、より大きなものに行きたがっていますが、私たちは実際にはもっと小さなものに興味を持っています」とゴディ氏はミニチュアスケールのドリーについて語った。 「第二に、私たちはすべての回答に目を通しましたが、それは高品質です。」

Ghodsi 氏は、Dolly 2.0 が「雪だるま式」効果を開始し、他のプレイヤーがゲームの分野に参加できるようになると信じていると述べました。人工知能が人々に加わり、他の選択肢を考え出します。同氏は、商業利用の制限が克服すべき大きなハードルであると説明し、「ついにこの問題を回避する方法を見つけたので、私たちは今興奮しています。これらの15,000の問題を現実の世界に適用する人々が現れることを保証します。そこにあるすべてのモデル」つまり、これらのモデルのどれだけが突然少し魔法のようになり、それらと対話できるようになるかがわかります。」

Dolly 2.0 モデルの重みをダウンロードするには、Databricks Hugging Face ページにアクセスし、databricks-labs の Dolly リポジトリにアクセスして databricks-dolly-15k データセットをダウンロードします。 。

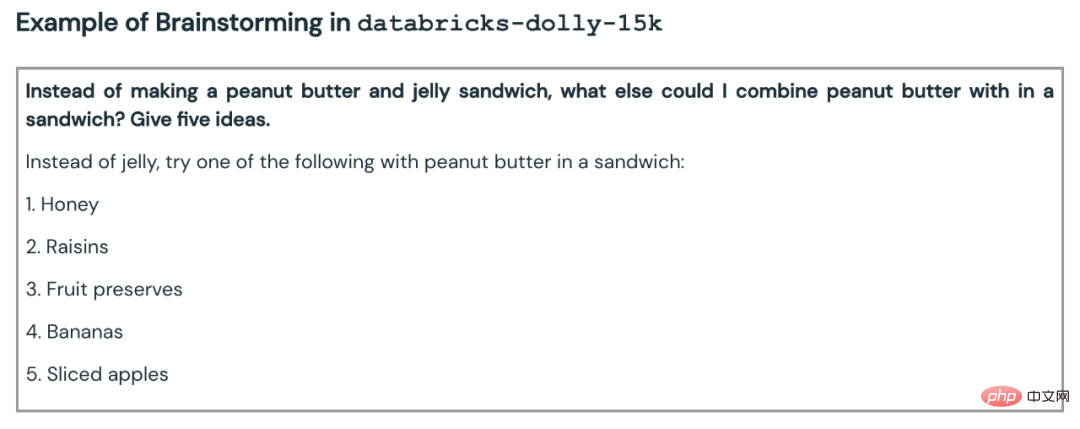

「databricks-dolly-15k」データセットには、人間が生成した高品質のプロンプト/応答ペアが 15,000 個含まれています。2023 年に 5,000 人以上の Databricks 従業員によって作成されました。 3 月と 4 月の は、大規模な言語モデルをチューニングするための手順を提供するように特別に設計されています。これらのトレーニング記録は自然で表現力豊かで、ブレーンストーミングやコンテンツ生成から情報の抽出や要約まで、幅広い行動を表すように設計されています。

このデータ セットのライセンス条項 (クリエイティブ コモンズ表示 - 継承 3.0 非移植ライセンス) に従って、誰でも商用アプリケーションを含むあらゆる目的でこのデータ セットを使用、変更、または拡張できます。

現時点では、このデータセットは、最初のオープンソースで人間が生成した命令データセットです。。

なぜこのようなデータセットを作成するのでしょうか?チームはブログ投稿でもその理由を説明しました。

Dolly 1.0 または LLM に続くディレクティブを作成する際の重要なステップは、ディレクティブと応答のペアのデータセットでモデルをトレーニングすることです。 Dolly 1.0 のトレーニング費用は 30 ドルで、スタンフォード大学の Alpaca チームが OpenAI API を使用して作成したデータセットを使用します。

Dolly 1.0 のリリース後、多くの人からこのモデルを試してみたいという要望があり、このモデルを商用で使用したいと考えているユーザーもいます。

しかし、トレーニング データセットには ChatGPT の出力が含まれており、スタンフォード大学チームが指摘しているように、利用規約は OpenAI と競合するモデルを誰も作成できないようにしようとしています。

以前は、すべてのよく知られた指令準拠モデル (Alpaca、Koala、GPT4All、Vicuna) がこの制限の対象となり、商用利用が禁止されました。この問題を解決するために、ドリーのチームは商業利用の制限なしで新しいデータセットを作成する方法を探し始めました。

具体的には、チームは OpenAI によって発行された研究論文から、元の InstructGPT モデルが 13,000 の命令に従う動作のデモンストレーションで構成されるデータセットでトレーニングされたことを知りました。これに触発されて、彼らは Databricks の従業員が主導して、同様の結果を達成できるかどうかを確認することに着手しました。

13,000 の質問と回答を生成するのは想像以上に困難であることがわかりました。すべての回答はオリジナルである必要があり、ChatGPT や Web 上のどこからでもコピーすることはできません。そうしないと、データ セットが「汚染」されてしまいます。しかし、Databricks には 5,000 人を超える従業員がおり、LLM に非常に興味を持っていました。そこでチームは、40 人のアノテーターが OpenAI 用に作成したものよりも高品質のデータセットを作成するクラウドソーシング実験を実施しました。

もちろん、この作業には時間と労力がかかりますが、全員のモチベーションを高めるために、チームはコンテストを設定し、上位 20 人のアノテーターにはサプライズ賞品が贈られます。同時に、非常に具体的な 7 つのタスクも列挙しました:

その後、チームは「スタッフの生産性の低下」を懸念してゲームを中止しました (これは当然のことです)。

商用化の実現可能性データセットがすぐに作成された後、チームは商用アプリケーションの検討を開始しました。

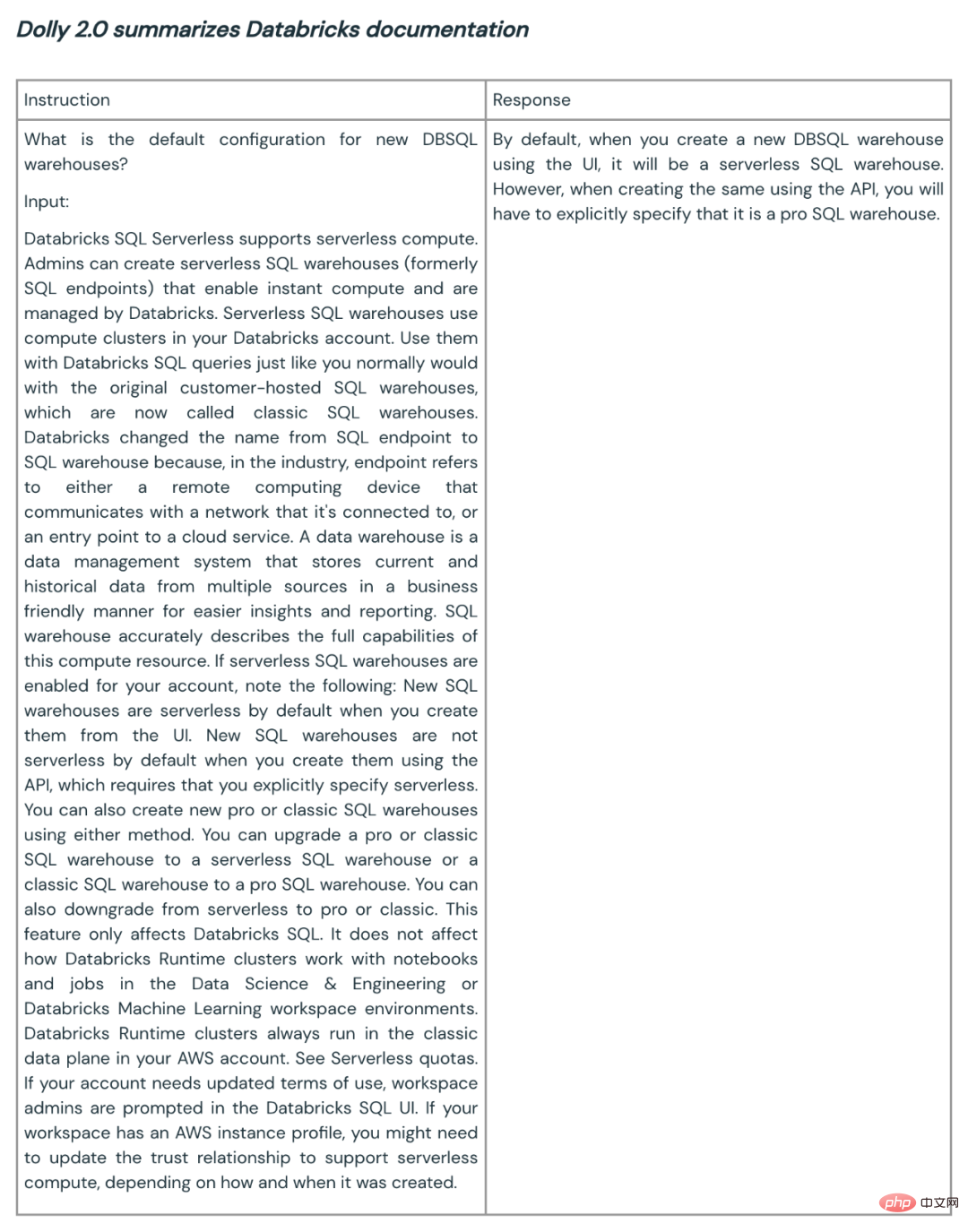

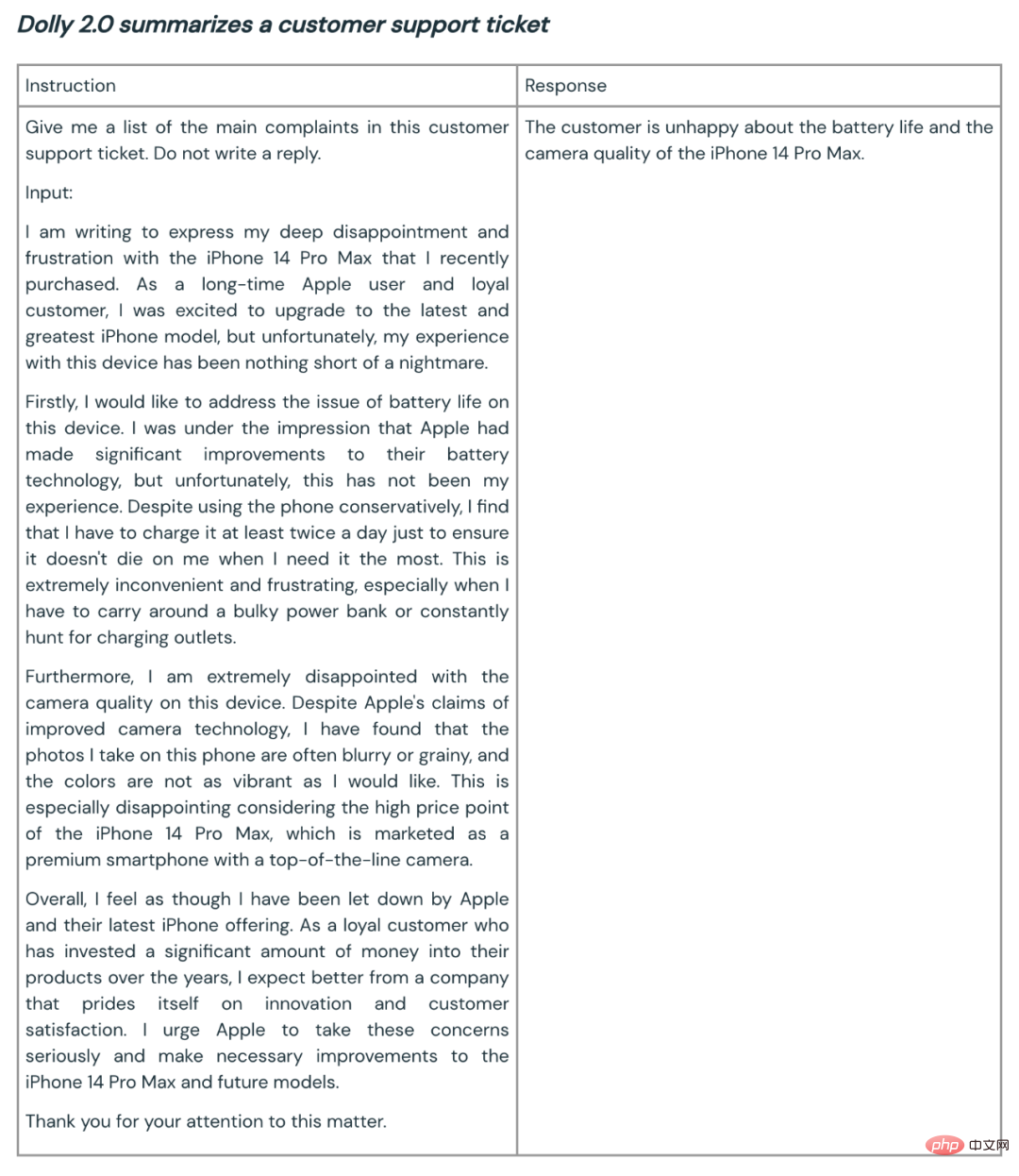

彼らは、商用利用できるオープンソース モデルを作成したいと考えていました。 databricks-dolly-15k は Alpaca (Dolly 1.0 がトレーニングされたデータセット) よりもはるかに小さいですが、EleutherAI pythia-12b に基づく Dolly 2.0 モデルは高品質の命令追従動作を示します。

今にして思えば、これは驚くべきことではありません。結局のところ、ここ数か月でリリースされた命令調整データセットの多くには合成データが含まれており、これには幻覚や事実誤認が含まれることがよくあります。一方、

databricks-dolly-15k は専門家によって生成され、高品質で、ほとんどのタスクに対する長い形式の回答が含まれています。

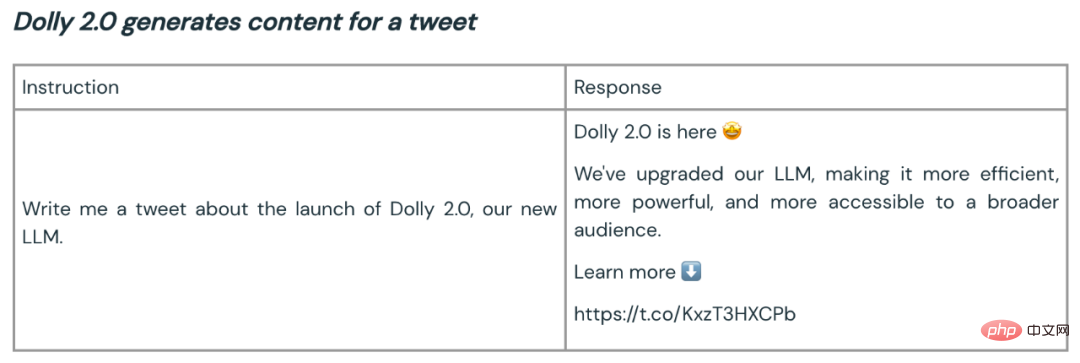

要約とコンテンツ生成に使用される Dolly 2.0 の例をいくつか示します:

Dolly 2 のオープンソースは、より優れた大規模モデルのエコシステムを構築するための良いスタートとなります。オープンソースのデータセットとモデルは、解説、研究、イノベーションを促進し、AI テクノロジーの進歩から誰もが確実に恩恵を受けることができるようにします。 Dolly チームは、新しいモデルとオープンソース データセットがその後の多くの作業の種として機能し、より強力な言語モデルの実現に役立つことを期待しています。

以上が世界初の真のオープンソース ChatGPT 大型モデルである Dolly 2.0 は商用利用のために自由に変更可能の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。