テクノロジー大手が ChatGPT を求めて戦っている一方で、学術界も ChatGPT への注目を高めています。

Nature は 1 週間以内に、ChatGPT と生成 AI について論じた 2 つの記事を掲載しました。

結局のところ、ChatGPT は最初に学界に話題を呼び、学者たちはそれを要約の作成や論文の改訂に使用してきました。

Nature は、この目的のために特別な禁止令を出しました。ChatGPT が論文の著者であることはできません。科学は、ChatGPT を使用してテキストを生成する投稿を直接禁止しています。

しかし、その傾向はすでに存在しています。

私たちが今すべきことは、科学コミュニティにとってのChatGPTの意義と、それがどのような位置づけにあるべきかを明確にすることかもしれない。

自然の言葉:

生成 AI とその背後にあるテクノロジーは非常に急速に発展しており、毎月イノベーションが登場しています。研究者がそれらをどのように使用するかによって、テクノロジーと学術の将来が決まります。

記事「ChatGPT: 5 つの優先研究課題」の中で、研究者たちは次のように提案しました。 ChatGPT の侵入を防ぐことは不可能 学術界では、その潜在的な影響を研究し、調査することが最優先事項であるべきです。

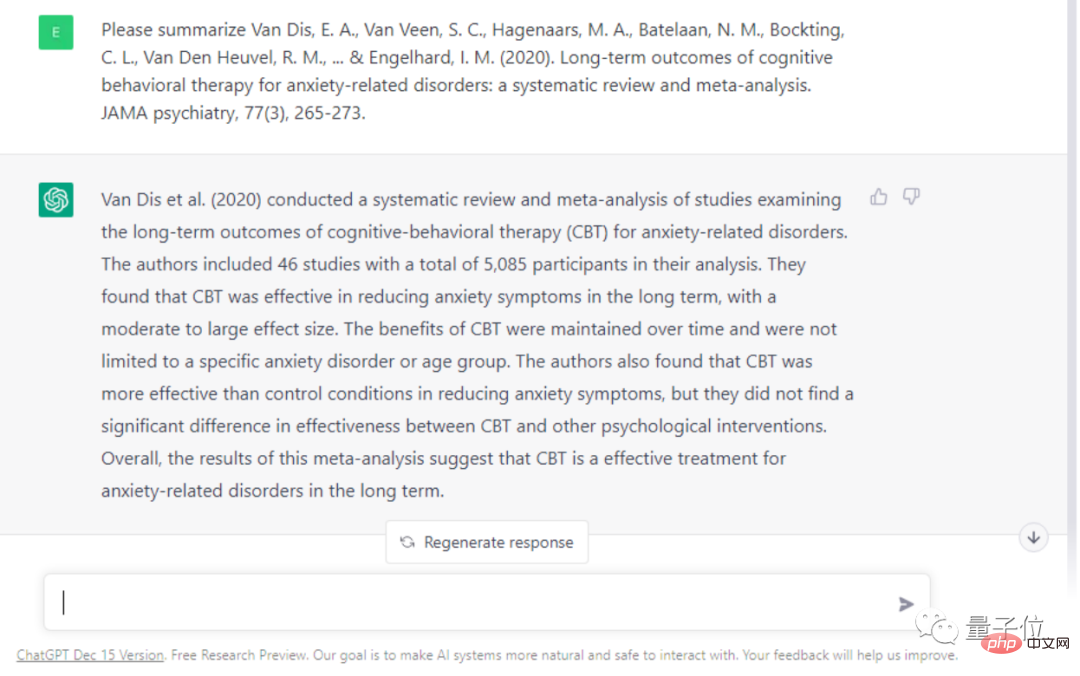

研究者らは、優先順位を付ける必要がある側面が 5 つあると考えており、その理由を説明しています。 人間によるレビューを徹底する ChatGPTなどの会話型AIの大きな特徴の1つは、回答内容の正確性が保証できないことです。さらに、でっち上げられた嘘はとても自然なもので、簡単に人を誤解させてしまいます。 たとえば、研究者はChatGPTに対し、認知行動療法(CBT)が不安やその他の症状の治療に効果があるかどうかに関する論文を要約して要約するよう依頼しました。 ChatGPT の回答には事実誤認が多数あります。たとえば、このレビューは 46 件の研究に基づいているとされていますが、実際には 69 件であり、CBT の有効性が誇張されています。ChatGPT を後で実験の設計、査読の実施、出版の支援、編集者による論文の受理決定の支援に使用する場合...これらのアプリケーションではどのような問題に注意を払う必要がありますか?人類は今、どのような境界線を明確にする必要があるのでしょうか?

研究者は、学者が研究を支援するために ChatGPT を使用すると、間違った情報に誤解される可能性があると考えています。学者が知らないうちに他人の著作を盗用してしまう可能性さえあります。

#AI の利点を活用する

一部の創造的な作業においても、研究者は AI が役立つ可能性があると信じています。

1991 年の独創的な論文は、人間と AI の間に形成される「インテリジェントなパートナーシップ」が、一人の人間の知性と能力を超える可能性があると提案しました。

この関係により、イノベーションが想像を絶するレベルまで加速する可能性があります。しかし問題は、この自動化がどこまでできるかということです。どこまで行けばいいですか?

したがって、研究者は倫理学者を含む学者にも、知識コンテンツの生成における今日の AI の境界について議論するよう求めています。革新的な研究には人間の創造性と独創性が依然として必要である可能性があります。不可欠な要素です。」

LLM の現在の影響を考慮して、研究者たちは、学術コミュニティが緊急に議論を組織する必要があると考えています。大きな議論。

彼らは、すべての研究グループに対し、ChatGPT について話し合って実際に試してもらうために、直ちにグループ会議を開催するよう呼びかけました。大学の教師は率先して ChatGPT の使用と倫理問題について学生と話し合う必要があります。

ルールがまだ明確になっていない初期段階では、研究チームのリーダーが全員に ChatGPT をよりオープンかつ透過的に使用し、いくつかのルールの形成を開始するよう呼びかけることが重要です。そして、すべての研究者は、ChatGPT によって生成されたかどうかに関係なく、自分の研究に責任を負うことを思い出すべきです。

さらに言えば、研究者らは、LLM の研究と使用について議論する国際フォーラムを直ちに開催すべきであると考えています。

メンバーには、さまざまな分野の科学者、テクノロジー企業、研究機関投資家、科学アカデミー、出版社、非政府組織、法律およびプライバシーの専門家が含まれる必要があります。

ChatGPT に対する多くの研究者の感情は、おそらく興奮と不安でしょう。

これまで、ChatGPT は多くの学者のデジタル アシスタントとして機能してきました。

計算生物学者のCasey GreeneらはChatGPTを使って論文を改訂した。 AI は 5 分以内に原稿をレビューし、参考文献セクションの問題点も見つけることができます。

アイスランド出身の学者である Hafsteinn Einarsson は、ほぼ毎日 ChatGPT を使用して、PPT を作成し、生徒の宿題をチェックしています。

また、神経生物学者のアルミラ・オスマノビッチ・トゥンストロム氏は、大規模な言語モデルを使用して学者が助成金申請書を作成できるようになり、科学者はより多くの時間を節約できると考えています。

しかし、Nature は ChatGPT の出力内容を鋭く要約しました:

スムーズですが不正確です。

ChatGPT の大きな欠点は、生成されるコンテンツが必ずしも真実かつ正確ではないことであり、これが学術界での使用に影響を与えることを知っておく必要があります。

解決できるでしょうか?

ここからは、答えが少しわかりにくくなります。

OpenAI の競合企業である Anthroic は、ChatGPT でいくつかの問題を解決したと主張していますが、Nature のインタビューには応じませんでした。

Meta は、4,800 万件の学術論文と著作物から作られた Gaoptica という大規模な言語モデルをリリースしており、学術的なコンテンツの生成と研究問題のより深い理解に優れていると主張しています。ただし、ユーザーが使用中に人種差別的であると感じたため、デモは公開されていません (コードはまだ利用可能です)。

「行儀が良い」ように訓練されている ChatGPT であっても、意図的に危険な発言を出力するように誘導される可能性があります。

OpenAI が ChatGPT を動作させる方法も非常に単純かつ粗雑です。コーパスに注釈を付けるために多くの手作業が必要です。有害なコーパスを読むために人を雇うというこの動作も一種の行為だと考える人もいます搾取の。

しかしいずれにせよ、ChatGPT と生成 AI は人間の想像力に新たな扉を開きました。

医学学者のエリック・トポル氏は、将来的には学術文献のテキストと画像を相互チェックできるLLMを含む人工知能が登場し、それによって人間のがん診断や病気の理解に役立つことを期待していると述べた。もちろん、これはすべて専門家の監督が必要です。

彼は、2023 年の初めにこのような傾向が見られるとは本当に予想していなかった、と言いました。

そして、これはほんの始まりにすぎません。

参考リンク:

[1]//m.sbmmt.com/link/492284833481ed2fd377c50abdedf9f1

[2]//m.sbmmt.com/link/04f19115dfa286fb61ab634a2717ed37

以上がChatGPTはNatureに週に2本の論文を掲載して議論するよう依頼:学術界での使用は避けられず、使用仕様を明確にする時期にあるの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。