近年、言語モデルは自然言語処理 (NLP) に革命的な影響を与えています。パラメーターなどの言語モデルを拡張すると、さまざまな下流の NLP タスクのパフォーマンスとサンプル効率が向上することが知られています。多くの場合、スケーリングがパフォーマンスに及ぼす影響はスケーリングの法則によって予測できることが多く、ほとんどの研究者は予測可能な現象を研究してきました。

それどころか、Jeff Dean、Percy Liang などを含む 16 人の研究者が共同して論文「Emergent Abilities of Large Language Models」を執筆し、大規模モデルの予測不可能性の現象と、これは、大規模言語モデルの創発的能力と呼ばれます。いわゆる創発とは、ある現象が小さなモデルには存在しないが、より大きなモデルには存在することを意味しており、このモデルの能力が創発であると考えられています。

アイデアとしての創発は、物理学、生物学、コンピューター サイエンスなどの分野で長い間議論されてきました。この論文は、スタインハルトの研究に基づいた創発の一般的な定義から始まります。この理論のルーツは、1972 年にノーベル賞受賞者で物理学者のフィリップ・アンダーソンが執筆した「More Is Different」という論文にあります。

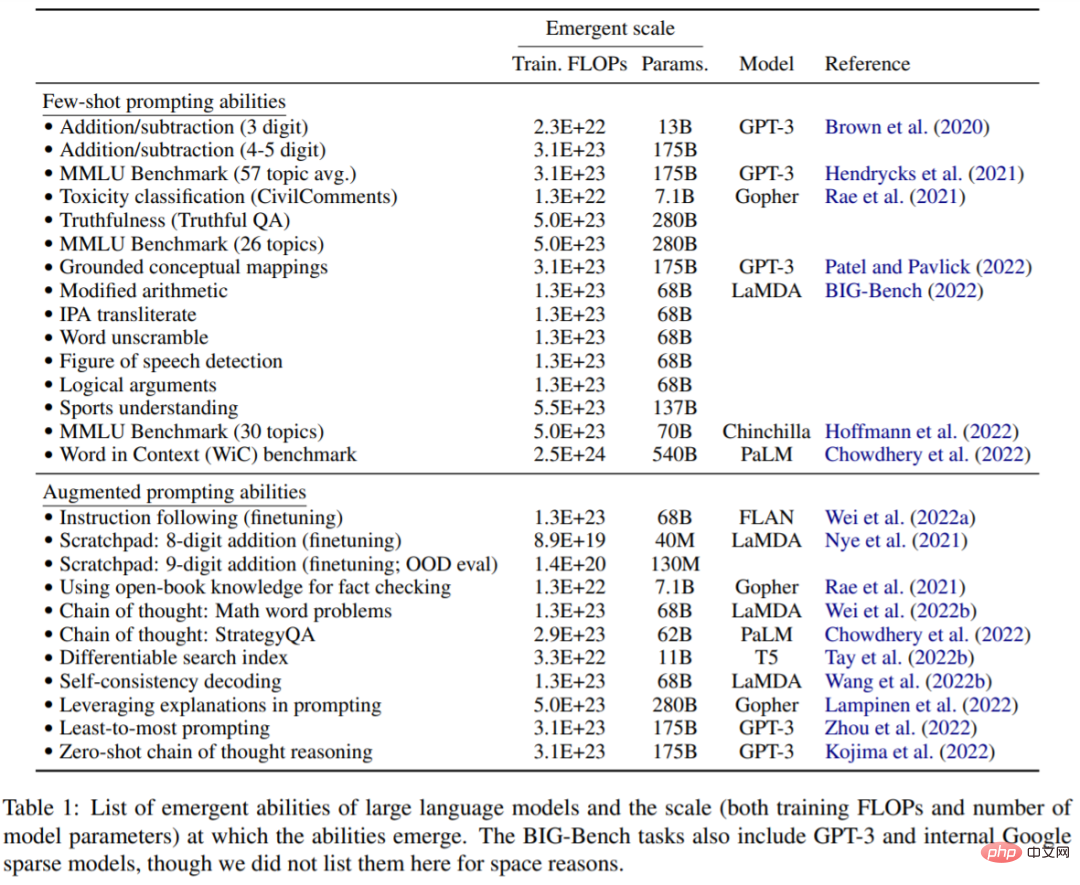

この記事では、トレーニング計算とモデル パラメーターによって測定されるモデル サイズの出現について説明します。具体的には、この論文では、大規模言語モデルの創発的機能を、小規模モデルには存在しないが、大規模モデルには存在する機能として定義します。したがって、小規模な言語モデルのパフォーマンス向上を単純に外挿するだけでは大規模モデルを予測することはできません。スケールモデル。この研究では、これまでのさまざまな研究で観察されたモデルの創発的な機能を調査し、それらをスモールショット キューイングやブースト キューイングなどの設定に分類します。

モデルのこの新たな能力は、なぜこれらの能力が獲得されるのか、そして大規模なスケールがより新たな能力を獲得するのかどうかについての将来の研究を刺激し、研究の重要性を強調します。

#プロンプト タスクの小さなサンプル

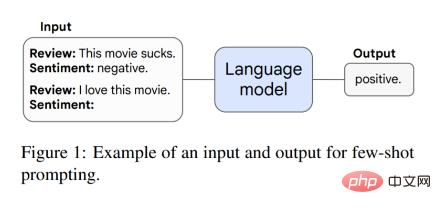

この記事では、最初にプロンプト パラダイムにおける創発的な能力について説明します。たとえば、GPT-3 プロンプトでは、事前トレーニングされた言語モデルのタスク プロンプトが与えられると、モデルはさらなるトレーニングやパラメーターの勾配更新を行わずに応答を完了できます。さらに、Brown らは、モデルのコンテキスト (入力) 内のいくつかの入出力例をプロンプト (プリアンブル) として使用し、目に見えない推論タスクを実行するようモデルに依頼する、小規模サンプル プロンプティングを提案しました。図 1 はプロンプトの例を示しています。

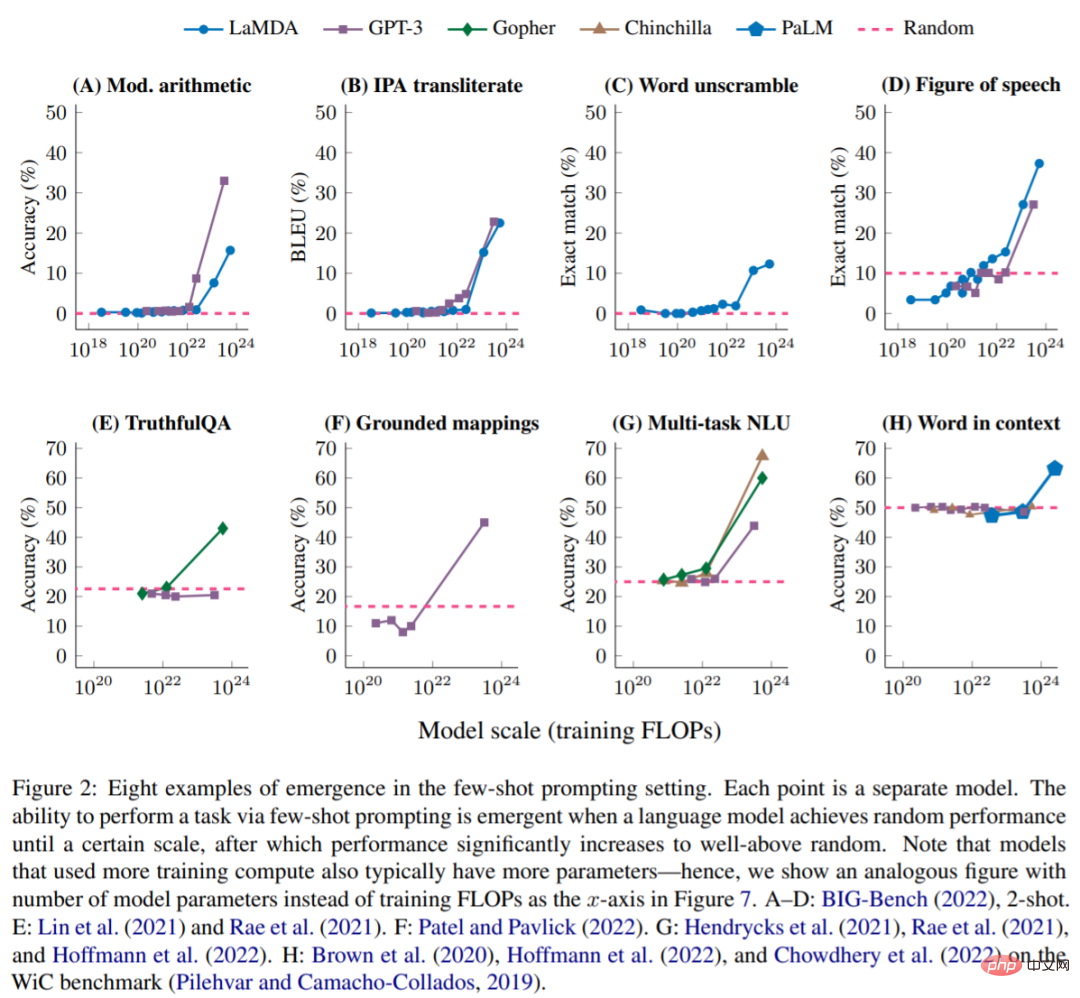

モデルに確率的なパフォーマンスがあり、ある程度の規模がある場合、小さなサンプルでタスクを実行できます。このとき、創発的な能力が現れ、モデルのパフォーマンスはランダムなパフォーマンスよりもはるかに高くなります。以下の図は、5 つの言語モデル シリーズ (LaMDA、GPT-3、Gopher、Chinchilla、PaLM) の 8 つの新しい機能を示しています。

BIG-Bench: 図 2A ~ D は、BIG-Bench からの 4 つの緊急の小規模サンプル プロンプト タスクを示しています。 Bench は、200 を超える言語モデル評価ベンチマークのスイートです。図 2A は、3 桁の数値の加算と減算、および 2 桁の数値の乗算をテストする算術ベンチマークを示しています。表 1 は、BIG-Bench のさらに新しい機能を示しています。

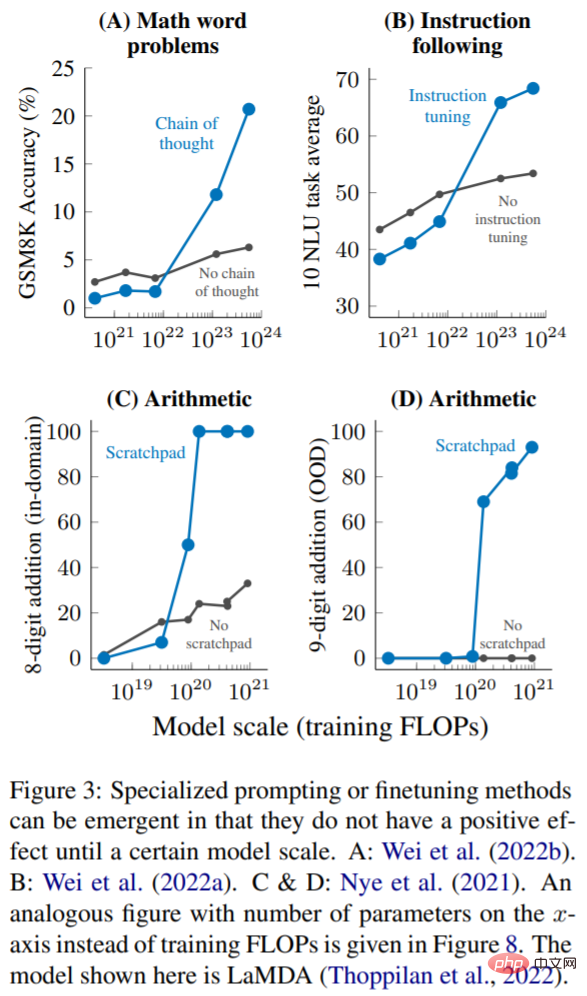

現在、小さなサンプル ヒントが大規模な言語モデルと対話する最も一般的な方法ですが、最近の研究では、言語モデルの機能をさらに強化するために、他のいくつかのヒントと微調整戦略が提案されています。また、この記事では、十分な規模のモデルに適用される前に、改善が見られない、または有害であるテクノロジを、新たな機能であるとみなします。

複数ステップの推論: 言語モデルと NLP モデルの場合、推論タスク、特に複数ステップの推論を伴うタスクは常に大きな課題でした。思考連鎖と呼ばれる最近の刺激戦略により、最終的な答えを与える前に一連の中間ステップを生成するように言語モデルを誘導することで、言語モデルがこの種の問題を解決できるようになります。図 3A に示すように、1023 トレーニング FLOP (約 100B パラメータ) に拡張した場合、思考連鎖プロンプトは中間ステップなしで標準プロンプトを超えるだけでした。

命令 (命令に従う): 図 3B に示すように、Wei らは、トレーニング FLOP が 7・10^21 (8B パラメーター) 以下の場合、命令は適切であることを発見しました。 -tuning (命令に従う) -finetuning) 手法はモデルのパフォーマンスに悪影響を及ぼし、トレーニング FLOP を 10^23 (~100B パラメーター) に拡張する場合にのみパフォーマンスが向上します。

プログラムの実行: 図 3C に示すように、8 ビット加算のドメイン内評価では、スクラッチパッドの使用は ~9 · 10^19 トレーニング FLOP (40M パラメーター) またはより大きなモデル。図 3D は、これらのモデルがドメイン外 9 ビット加算にも一般化できることを示しています。これは、〜1.3 · 10^20 トレーニング FLOP (100M パラメーター) で発生します。

以上がジェフ・ディーンらによる新作: 言語モデルを別の角度から見るとスケールが足りず発見できないの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。