論文リンク: https://arxiv.org/pdf/2302.06476.pdf

大規模言語モデル (LLM) は、さまざまな自然言語処理 (NLP) タスクを解決できることが証明されており、特定の下流タスクについては、トレーニング データに依存せず、適切なプロンプトのヘルプ。コマンドに応じて新しいタスクを実行するこの機能は、一般的な人工知能への重要なステップと見なすことができます。

現在の LLM は場合によっては良好なパフォーマンスを実現しますが、それでもゼロショット学習ではさまざまなエラーが発生する傾向があります。さらに、プロンプトの形式も大きな影響を与える可能性があります。たとえば、「ステップバイステップで考えてみましょう」をプロンプトに追加すると、モデルのパフォーマンスが 大幅に向上する可能性があります。これらの制限は、現在の LLM が真の汎用言語システムではないことを示しています。 最近、OpenAI がリリースした ChatGPT LLM が NLP コミュニティで大きな注目を集めています。 ChatGPT は、GPT-3.5 シリーズのモデルを「ヒューマン フィードバックによる強化学習 (RLHF)」によってトレーニングすることによって作成されました。 RLHF は主に、教師あり学習を使用した言語モデルのトレーニング、比較データの収集と人間の好みに基づく報酬モデルのトレーニング、強化学習を使用した報酬モデルに対する言語モデルの最適化の 3 つのステップで構成されます。 RLHF トレーニングにより、ChatGPT は人間の入力に対する高品質な応答の生成、不適切な質問の拒否、その後の会話に基づく以前のエラーの自己修正など、さまざまな側面で優れた機能を備えていることが観察されました。

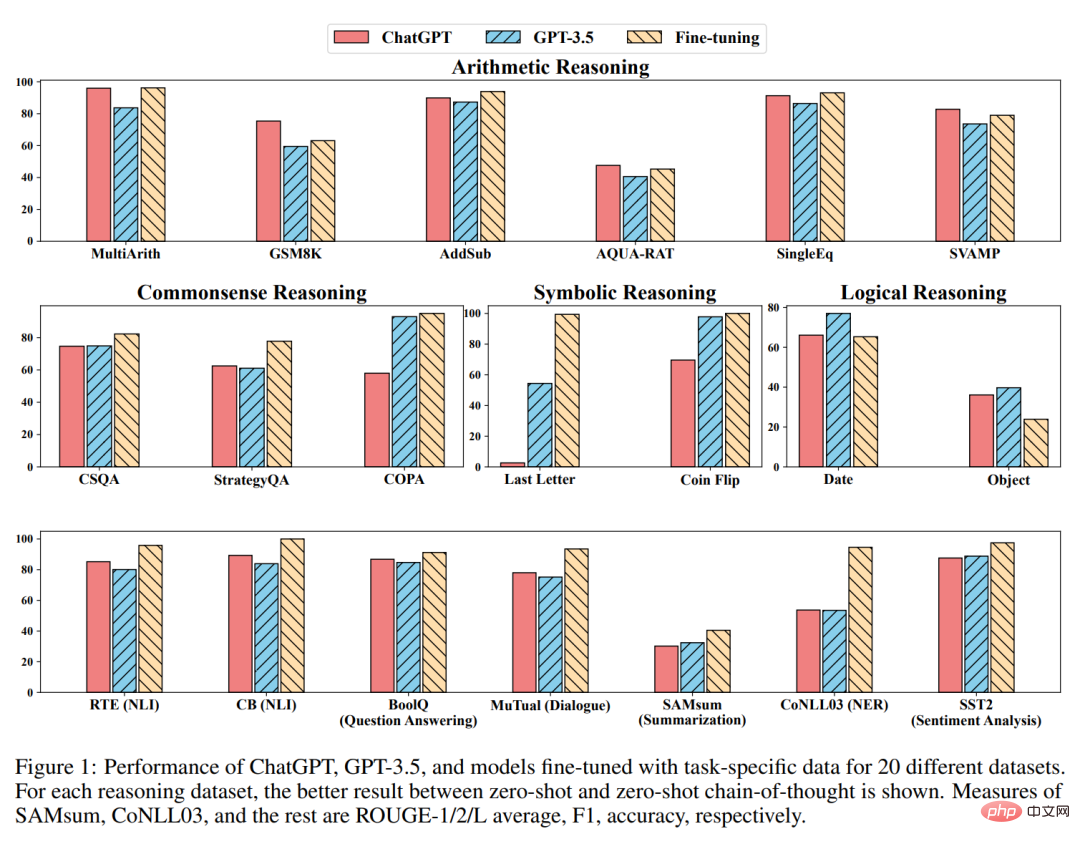

ChatGPT は強力な会話機能を示していますが、ChatGPT が既存の LLM と比較して優れたゼロショット汎化機能を実現しているかどうかは、NLP コミュニティではまだ不明です。この研究ギャップを埋めるために、研究者らは、7 つの代表的なタスク カテゴリをカバーする多数の NLP データセットで ChatGPT のゼロショット学習機能を評価することで、ChatGPT のゼロショット学習機能を体系的に研究しました。これらのタスクには、推論、自然言語推論、質問応答 (読解)、対話、要約、固有表現認識、感情分析が含まれます。研究者らは、広範な実験の助けを借りて、次の質問に答えることを目的としました:

#ChatGPT は NLP タスク用の汎用ソルバーですか? ChatGPT はどのようなタイプのタスクでうまく機能しますか?

主な結論

著者らは、自分たちの知る限り、これが初めてのことであると述べています。 ChatGPT についてコメントしました。ChatGPT の予備的な概要を提供することを目的として、さまざまな NLP タスクのゼロショット機能が研究されています。彼らの主な発見は次のとおりです:

#方法

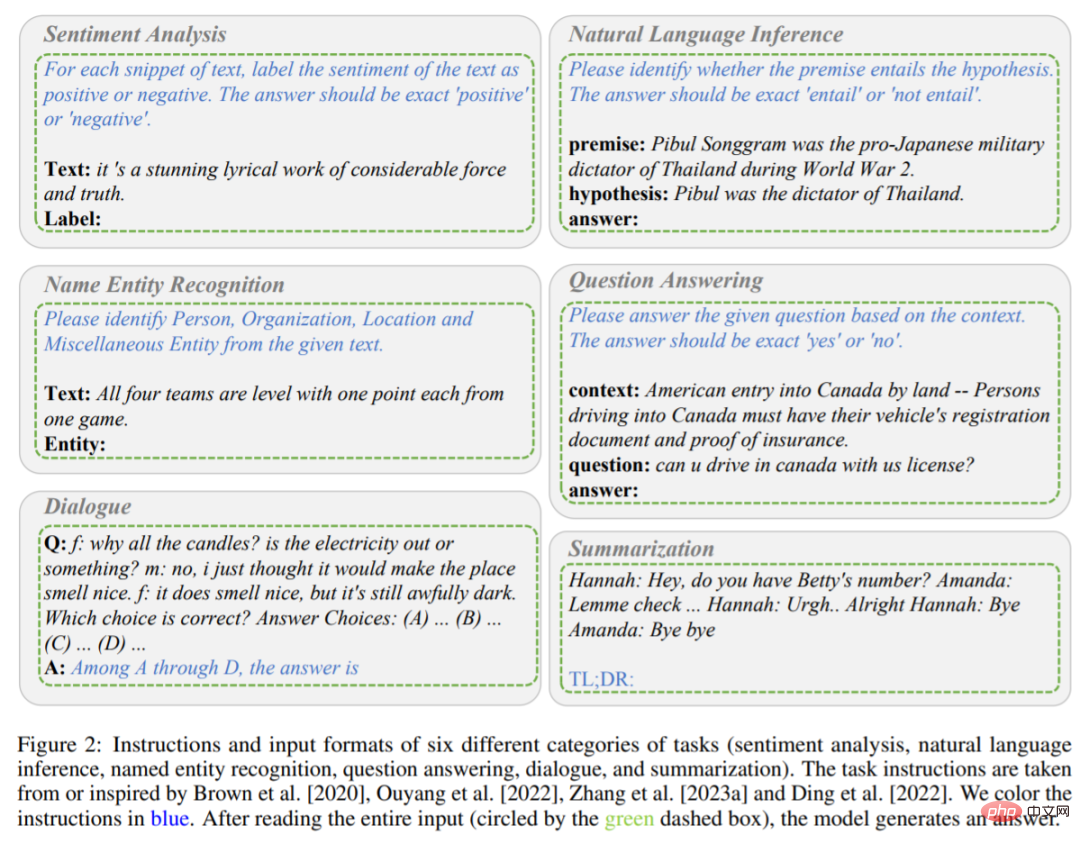

前述したように、この研究はこれこの論文では主に、さまざまなタスクの下で ChatGPT と GPT-3.5 (textdavinci-003) のゼロショット学習パフォーマンスを比較しています。具体的には、タスクの指示 P とテスト問題 X を入力として受け取り、モデルは f で表され、テスト問題を解くためのターゲット テキスト Y = f (P, X) を生成します。さまざまなタスクの指示と入力形式を図 2 および 3 に示します。

# 6 つのタスク (感情分析、自然言語推論、固有表現認識、質問、および回答、ダイアログ、概要)コマンドと入力形式。説明書は青い文字で書かれています。

推論タスクの説明。 たとえば、モデルが感情分析タスクを実行するとき、タスク命令 P はテキストに含まれる感情を肯定的または否定的にマークし、出力される回答は正または負です。モデルが命令 P と入力コンテンツ X (そのコンテンツは、かなりの力と信頼性を備えた驚くべき叙情的な作品です) を読み取ると、モデルは Y プラスを出力することが期待されると判断されます。

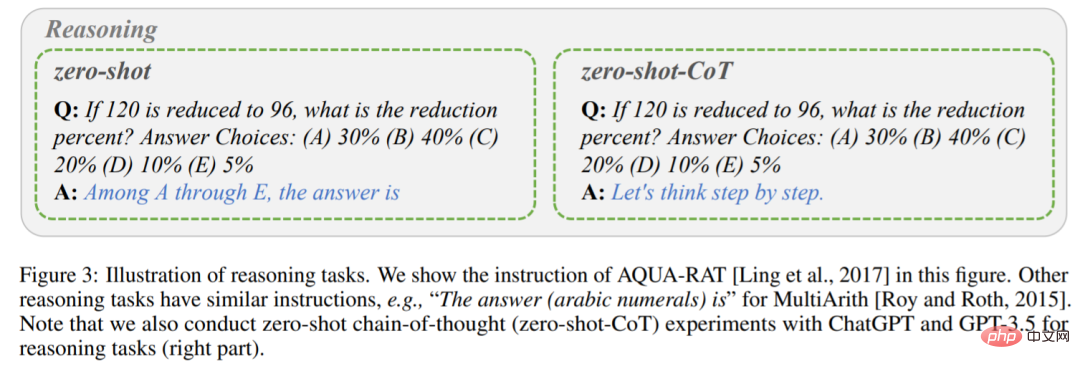

上記の 1 段階プロンプト法とは異なり、この研究では 2 段階プロンプト (Kojima et al. によって提案) を使用してゼロショット CoT を完了します。

第一段階では「ステップバイステップで考えてみましょう」を採用し、命令P_1でモデル生成Rの基本原理を導き出します。

2 番目のステージでは、最初のステップで生成された基本原理 R に加えて、元の入力 X と命令 P_1 を新しい入力として使用して、モデルが最終的な答えを生成するようにガイドします。

その後、新しい命令 P_2 をトリガー文として使用して答えを抽出します。すべてのタスクの指示は、Brown、Ouyang、Zhang らの研究から引用またはインスピレーションを得たものです。最後に注意すべき点は、ChatGPT に新しいクエリを作成するたびに、前の例の影響を避けるために事前に会話をクリアする必要があることです。

実験

算術推論

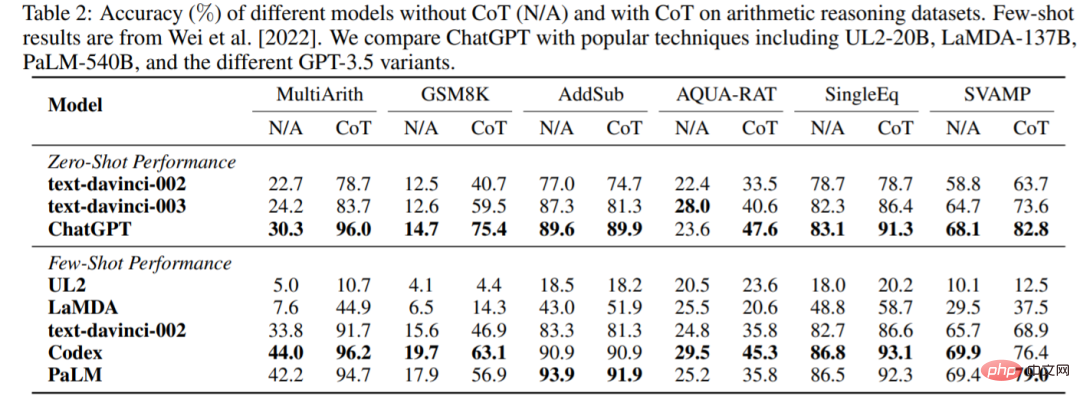

6 つの算術推論データセットに対する CoT なしまたは CoT ありの ChatGPT および GPT-3.5 の精度を表 2 に示します。 CoT を使用しない実験では、ChatGPT は 5 つのデータセットで GPT-3.5 を上回り、強力な算術推論機能を実証しました。

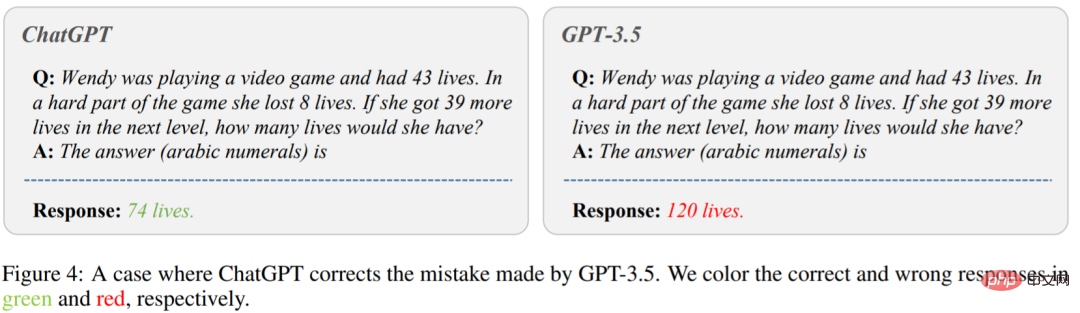

# 図 4 は、GPT-3.5 が間違った答えを与えるケースを示しています。写真の左側で、「ウェンディはビデオ ゲームをしていて、ライフが 43 個あります。ゲームの難しい部分で、彼女は 8 個のライフを失いました。次のレベルでさらに 39 個のライフを獲得した場合、彼女は何個のライフを得るでしょうか」と尋ねます。 ?」ChatGPT が正しい答えを返しました。しかし、GPT-3.5 は間違った答えを生成しました。 CoT を使用すると、ChatGPT は GPT-3.5 よりもはるかに優れたパフォーマンスを発揮することがわかります。

常識、記号、論理的推論

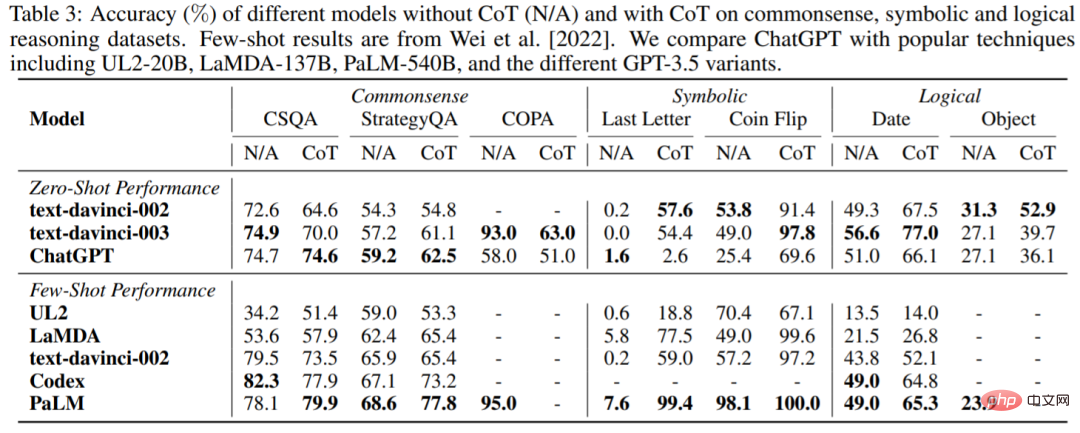

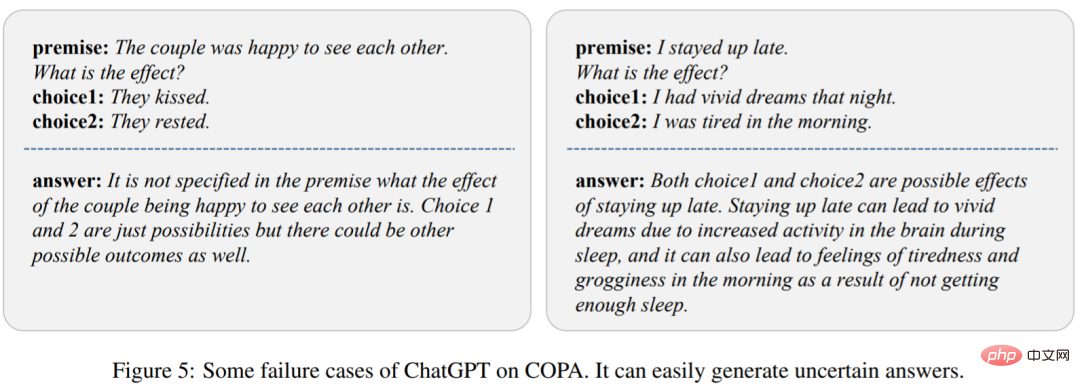

表 3 は、常識的、記号的、論理的推論データ セットに対する ChatGPT と一般的な LLM の精度を示しています。次のようなことがわかります。 まず、CoT を使用しても、常識的な推論タスクで常に優れたパフォーマンスが得られるとは限りません。これには、より詳細な背景知識が必要になる場合があります。第二に、算術推論とは異なり、ChatGPT は多くの場合 GPT-3.5 よりもパフォーマンスが悪く、GPT-3.5 の方がより強力な対応機能を備えていることを示しています。

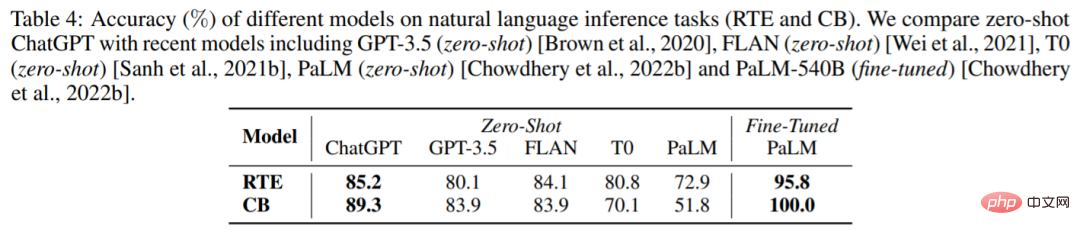

表 4 は、2 つの自然言語推論タスク、RTE と CB に関するさまざまなモデルの結果を示しています。ゼロショット設定では、ChatGPT が GPT-3.5、FLAN、T0、PaLM よりも優れたパフォーマンスを達成できることがわかります。これは、ChatGPT が NLP 推論タスクにおけるゼロショット パフォーマンスに優れていることを証明しています。

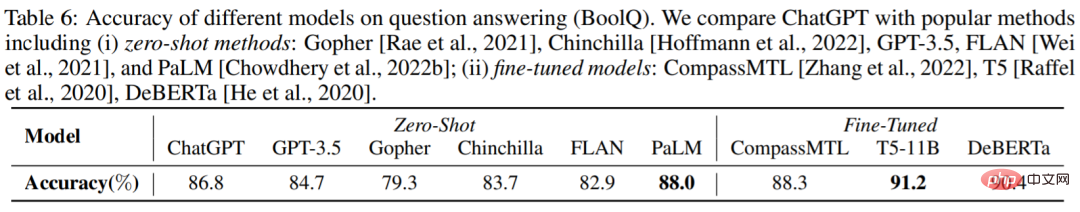

#表 6 は、BoolQ データセット上のさまざまなモデルの精度を報告しています。ChatGPT は GPT-3.5 よりも優れています。これは、ChatGPT が推論タスクをより適切に処理できることを示しています。

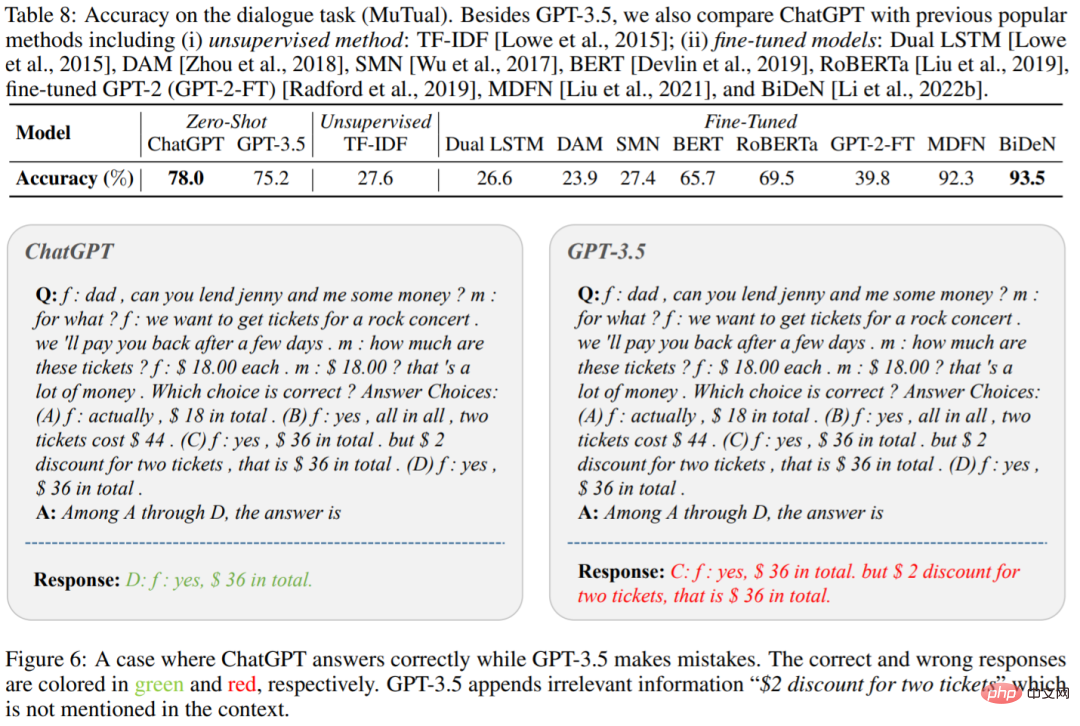

表 8 は、MuTual データセット (マルチラウンド会話推論) における ChatGPT および GPT-3.5 の精度を示しています。予想通り、ChatGPT は GPT-3.5 よりも大幅に優れています。

図 6 は具体的な例であり、ChatGPT が特定のコンテキストに対してより効果的に推論できることがわかります。これにより、ChatGPT の超推論機能が改めて確認されました。

概要の生成

概要の生成

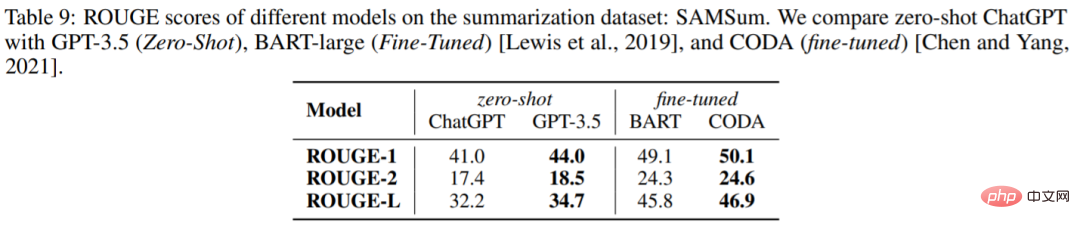

表 9 は、SAMSum データセット上の ChatGPT および GPT-3.5 の ROUGE スコアを示していますが、驚くべきことに、ChatGPT はすべての指標において GPT-3.5 よりも劣っています。

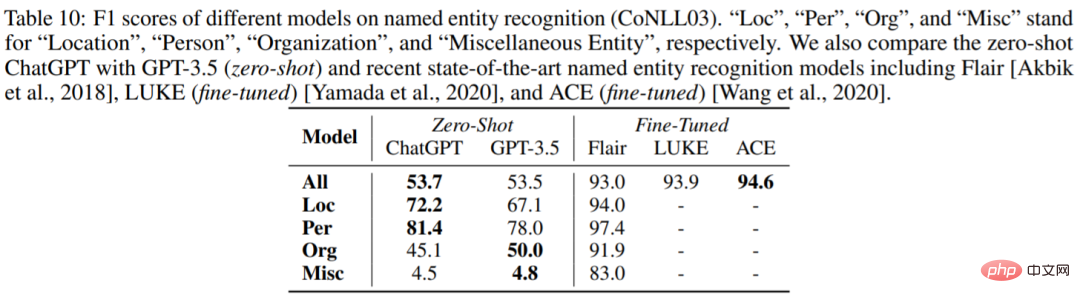

固有表現の認識

表 10 は、CoNLL03 での ChatGPT および GPT-3.5 のゼロショット パフォーマンスを報告します。 ChatGPT と GPT-3.5 の全体的なパフォーマンスは非常に似ていることがわかります。

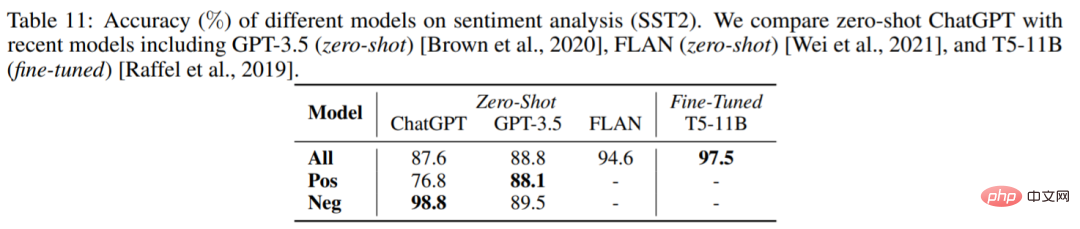

# 感情分析

表 11 は、センチメント分析データ セット SST2 のさまざまなモデルの精度を比較しています。驚くべきことに、ChatGPT のパフォーマンスは GPT-3.5 よりも約 1% 劣ります。

以上がChatGPT は本当に「ジェネラリスト」なのでしょうか?楊迪らはそれを徹底的にテストした。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。