2 年前、MeliusNet が登場したとき、Machine Heart は技術記事「 MobileNet を初めて上回るバイナリ ニューラル ネットワーク - 1 と 1 の 3 つ」を発表しました。 -年間の困難な旅 》では、BNN の開発の歴史を振り返りました。当時、初期の BNN 作品である XNOR-Net に基づいて構築された XNOR.AI が Apple に買収され、この低消費電力で高性能のバイナリ ニューラル ネットワーク テクノロジがすぐに広範なアプリケーションの可能性を開くのではないかと誰もが想像していました。

しかし、過去 2 年間、Apple から BNN テクノロジーの応用に関するさらなる情報を入手することは困難でした。Apple はテクノロジーの秘密を厳重に保持しており、学術界や学術界からも情報を得ることができませんでした。その他、特に目を引く応用事例をご紹介します。一方で、端末デバイスの数が急増するにつれて、エッジ AI アプリケーションと市場は急速に成長しており、2030 年までに 5,000 ~ 1,250 億台のエッジ デバイスが生産され、エッジ コンピューティング市場は 600 億米ドルに急増すると予想されています。現在人気のあるアプリケーション分野としては、AIoT、メタバース、ロボット端末機器などが挙げられます。関連業界はテクノロジーの導入を加速しており、同時に、3 次元再構成、ビデオ圧縮、リアルタイムにおける AI テクノロジーの広範な適用など、上記の分野の多くの中核となる技術リンクに AI 機能が組み込まれています。ロボットによるシーンの認識。このような背景から、エッジベースの高エネルギー効率、低電力 AI テクノロジー、ソフトウェア ツール、およびハードウェア アクセラレーションに対する業界の需要がますます緊急になっています。

現在、BNN の適用を制限する 2 つの主なボトルネックがあります: 1 つ目は、従来の 32 ビット深層学習モデルとの精度の差を効果的に狭めることができないこと、2 つ目は、パフォーマンスの欠如です。異なるハードウェア上での高性能アルゴリズムの実装。機械学習に関する論文の高速化は、使用している GPU や CPU に反映されないことがよくあります。 2 番目の理由は、1 番目の理由から生じる可能性があり、BNN は満足のいく精度を達成できないため、システムおよびハードウェアの高速化と最適化の分野の専門家から広範な注目を集めることができません。機械学習アルゴリズム コミュニティは、多くの場合、単独で高性能のハードウェア コードを開発できません。したがって、高精度と強力な加速の両方を達成するには、BNN アプリケーションまたはアクセラレータには間違いなく、これら 2 つの異なる分野の開発者の協力が必要です。

たとえば、メタ推奨システム モデル DLRM は、32 ビット浮動小数点数を使用して重みとアクティベーション パラメータを保存します。モデル サイズは約2.2GBです。精度がわずかに低下した (

BNN の 2 番目の大きな利点は、計算方法が非常に効率的であることです。変数を表すのに 1 ビット、つまり 2 つの状態のみを使用します。これは、すべての演算がビット演算のみで完了できることを意味し、AND ゲート、XOR ゲートなどの演算を使用することで、従来の乗算や加算演算を置き換えることができます。ビット演算は回路の基本単位であり、回路設計に慣れている学生であれば、乗加算演算部の面積を効果的に削減し、オフチップメモリへのアクセスを削減することが消費電力を削減する最も効果的な方法であることを理解しているはずです。 WRPN [1] は、カスタマイズされた FPGA と ASIC 上で、BNN が完全精度と比較して 1000 倍の省電力を達成できることを実証しました。最近の研究 BoolNet [2] は、浮動小数点演算をほとんど使用せず、純粋なバイナリ情報フローを維持できる BNN 構造設計を実証しました。これにより、ASIC シミュレーションで優れた消費電力と精度のトレードオフが実現されます。

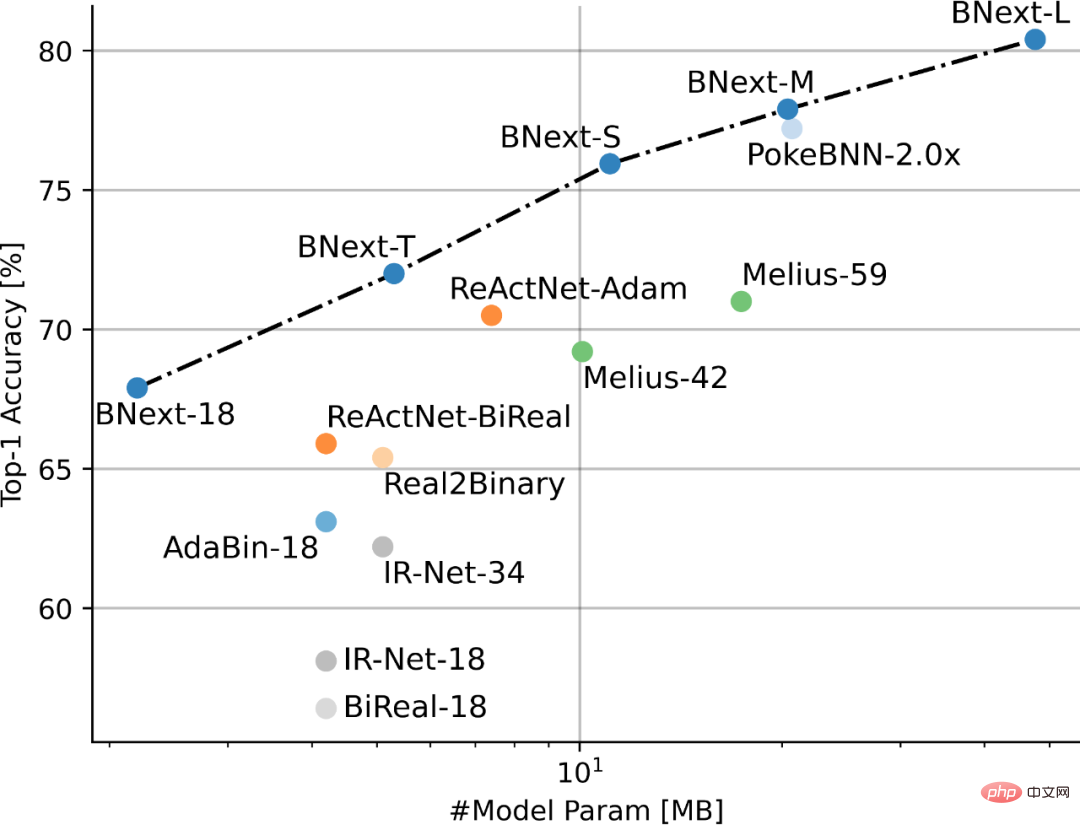

ドイツの Hasso Plattner Institute of Computer System Engineering の Nianhui Guo 氏や Haojin Yang 氏などの研究者は、BNext モデルを提案し、ImageNet で 80% 以上のトップ 1 分類精度を達成した最初の BNN となりました。データセット:

図 1 ImageNet に基づく SOTA BNN のパフォーマンス比較#

論文アドレス: https://arxiv.org/pdf/2211.12933.pdf

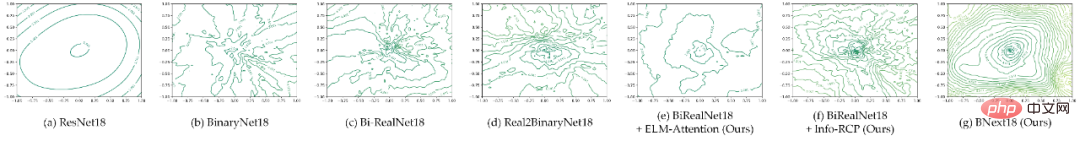

著者まず、損失ランドスケープの可視化形式に基づいて、現在主流の BNN モデルと 32 ビット モデルの間の最適化のしやすさの大きな違いを深く比較しました (図 2)。BNN の粗い損失ランドスケープが現在の研究の妨げになっていることが提案されました。コミュニティが BNN のパフォーマンスの限界をさらに探求できないことが主な理由の 1 つです。

この仮定に基づいて、著者は新しい構造設計を使用して BNN モデルの最適化のしやすさを向上させようと試み、より滑らかな損失ランドスケープを持つバイナリ ニューラル ネットワーク アーキテクチャを構築して損失を削減します。感度が高いため、精度の高い BNN モデルを最適化することが困難です。具体的には、著者は、モデルの二値化が順伝播に使用できる特徴パターンを大幅に制限し、二値畳み込みが限られた特徴空間内の情報のみを抽出して処理することを強制し、この制限されたフィードフォワード伝播モードによって最適化が困難になることを強調しています。 (1) 柔軟な連続畳み込み特徴量キャリブレーション モジュールを構築して、モデルのバイナリ表現への適応性を向上させる; (2) 効率的なバイパス構造を探索して、フィードフォワードでの特徴量の 2 値化によって引き起こされる情報ボトルネック問題を軽減する、という 2 つのレベルの構造設計を通じて効果的に軽減できます。伝搬。

#図 2 一般的な BNN アーキテクチャの損失ランドスケープの視覚的比較 (2D 輪郭透視図)

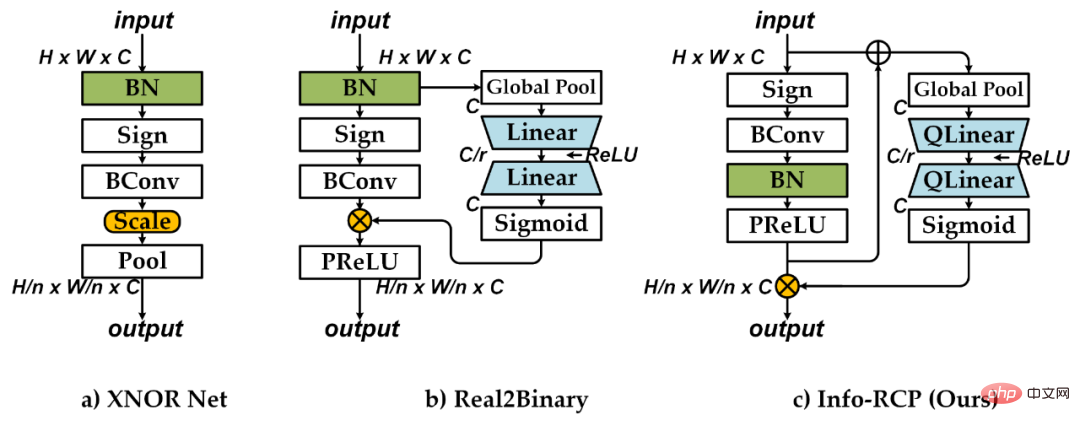

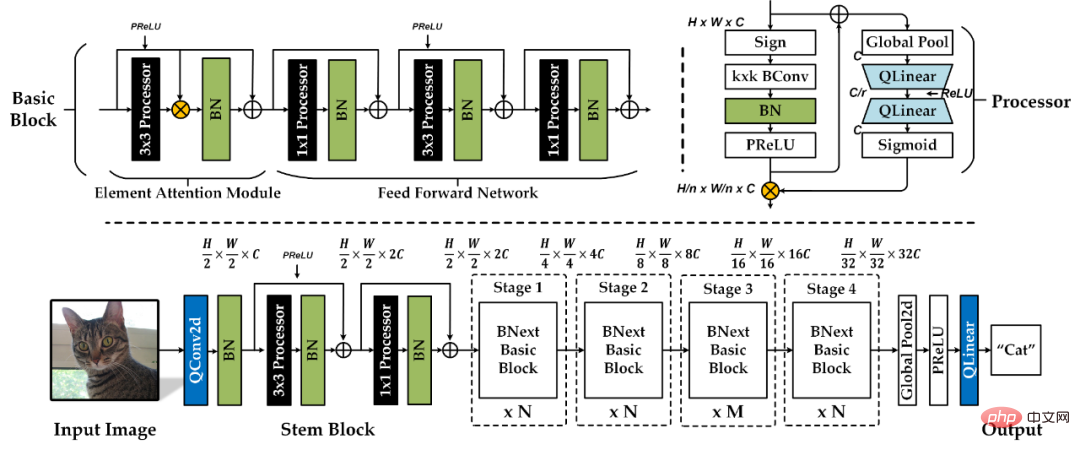

#上記の分析に基づいて、著者は、ImageNe 画像分類タスクで > 80% の精度を達成する最初のバイナリ ニューラル ネットワーク アーキテクチャである BNext を提案しました。具体的なネットワーク アーキテクチャの設計を図に示します。 4を示します。著者は最初に、情報再結合 (Info-RCP) モジュールに基づいて基本的なバイナリ処理ユニットを設計しました。隣接する畳み込み間の情報ボトルネックの問題に対処するために、追加のバッチ正規化層と PReLU 層を導入することで、バイナリ畳み込み出力分布の予備的なキャリブレーション設計が完了します。次に著者は、逆残差構造とスクイーズアンドエクスパンド分岐構造に基づいて二次動的分布校正設計を構築しました。図 3 に示すように、従来の Real2Binary キャリブレーション構造と比較して、追加の逆残差構造はバイナリ ユニットの入力と出力の間の機能ギャップを完全に考慮し、完全に入力情報に基づいた次善の分布キャリブレーションを回避します。この 2 段階の動的分布キャリブレーションにより、後続の隣接するバイナリ畳み込み層での特徴抽出の困難さを効果的に軽減できます。

#図 3 畳み込みモジュール設計の比較表 第 2 に、著者は、要素ごとのアテンション (ELM-Attendance) と組み合わせた、強化されたバイナリ基本ブロック モジュールを提案します。著者は、複数の Info-RCP モジュールを積み重ねることによって基本ブロックの基本構造を完成させ、追加のバッチ正規化と各 Info-RCP モジュールへの継続的な残留接続を導入して、異なる Info-RCP モジュール間の情報ボトルネックの問題をさらに軽減しました。バイパス構造がバイナリ モデルの最適化に及ぼす影響の分析に基づいて、著者は、要素ごとの行列乗算ブランチを使用して、各基本ブロックの最初の 3x3 Info-RCP モジュールの出力に対して分布キャリブレーションを実行することを提案します。 。追加の空間注意重み付けメカニズムは、ベーシック ブロックがより柔軟なメカニズムで前方情報の融合と配布を実行するのに役立ち、モデルの損失ランドスケープの滑らかさを向上させることができます。図 2.e と図 2.f に示すように、提案されたモジュール設計により、モデルの損失ランドスケープの滑らかさが大幅に向上します。

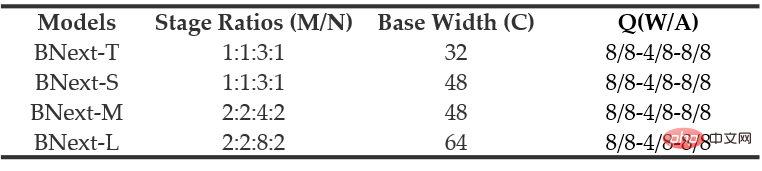

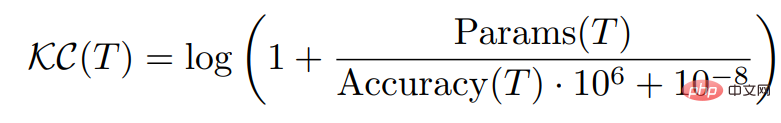

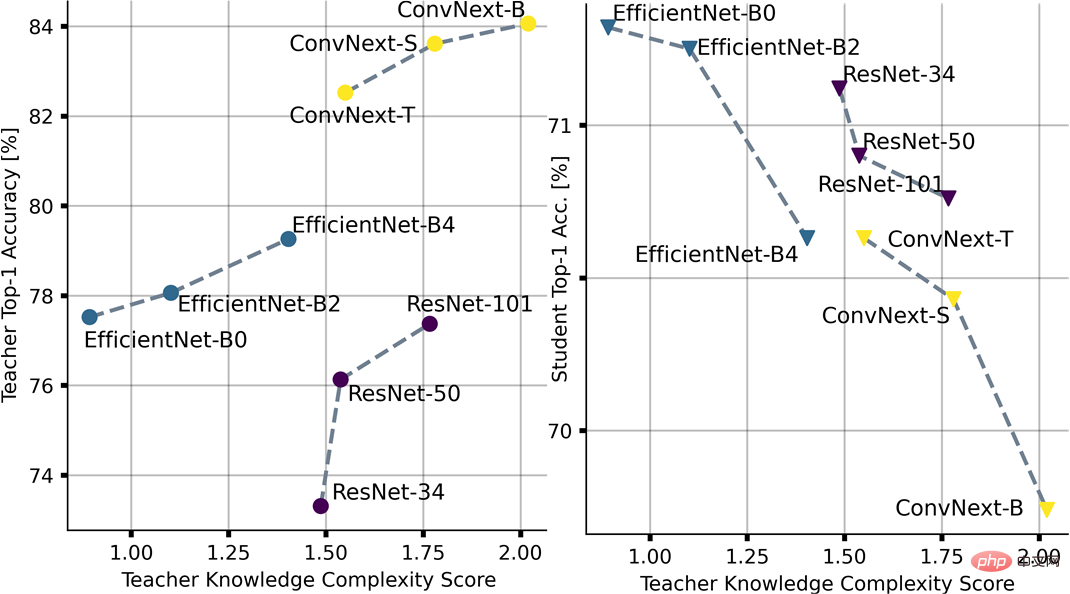

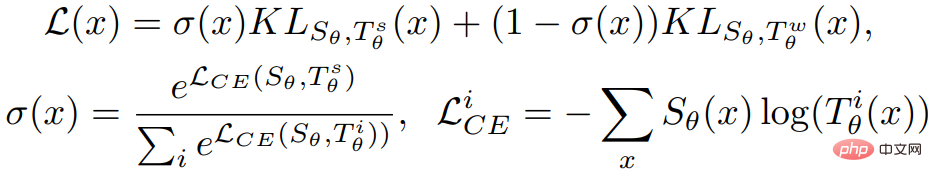

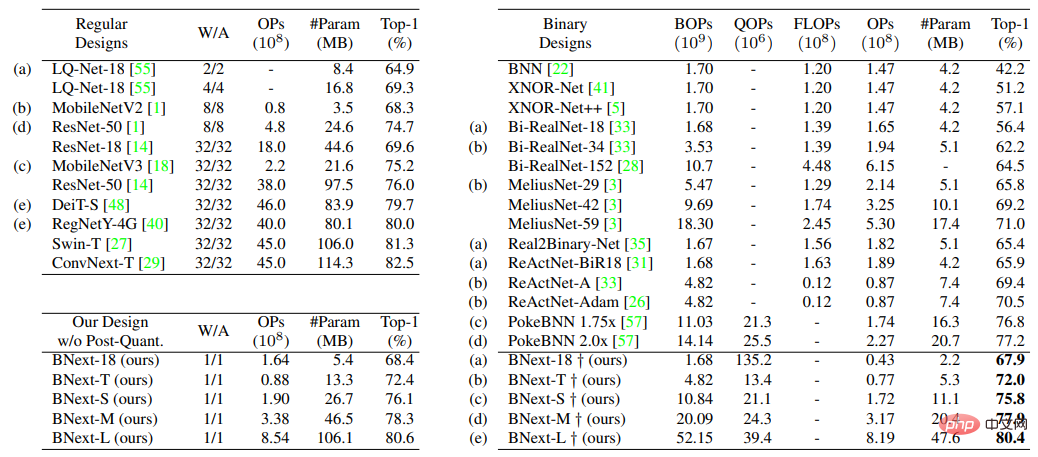

# 著者は、上記の構造設計を人気のある MoboleNetv1 ベンチマーク モデルと組み合わせ、モデルの深さと幅の比例係数を変更することで、複雑さの異なる 4 つの BNext モデル シリーズ (表 1) を構築しました: BNex-Tiny、BNext -小、B 次の中、B 次大。 損失状況が比較的大まかであるため、現在のバイナリ モデルの最適化は一般に、広範な次善の収束を取り除くために知識蒸留などの方法によって提供されるより詳細な監視情報に依存しています。 BNext の著者は、最適化プロセス中に教師モデルとバイナリ生徒モデルの間の予測分布に大きなギャップが生じる可能性のある影響を初めて考慮し、モデルの精度のみに基づいて教師を選択するとカウンターにつながる可能性があると指摘しました。 - 直感的な学生の過学習結果。この問題を解決するために、著者は、教師モデルの出力ソフトラベルの有効性と教師モデルパラメータの複雑さとの間の相関関係を考慮した、新しい教師選択指標として知識複雑性(KC)を提案します。 #図 5 に示すように、著者は知識の複雑さに基づいて、ResNet、 EfficientNet、ConvNext.Ranking を学生モデルとして BNext-T と組み合わせて、このメトリクスの有効性を事前に検証し、ランキング結果はその後の実験での知識蒸留モデルの選択に使用されました。 #図 5 直感に反する過学習効果と、教師の選択が異なる場合の知識の複雑さの影響#これに基づいて、論文の著者は、強力な教師最適化プロセス中の早期予測分布ギャップによって引き起こされる最適化問題をさらに検討し、Diversified Consecutive を提案しました。 K D。以下に示すように、著者は、強力な教師と弱い教師の組み合わせによる知識統合手法を通じて、最適化プロセスで目的関数を調整します。これに基づいて、事前に定義された複数の教師候補を使用して、トレーニング プロセス中に弱い教師を均等に切り替え、組み合わされた知識の複雑さをカリキュラム的に弱いものから強いものへと導き、予測分布を削減する知識強化戦略がさらに導入されています。違いによって引き起こされる。

提案したアーキテクチャ設計と最適化手法に基づいて、大規模画像分類タスクImageNet-1kにおける手法検証を行った。実験結果を図 6 に示します。

既存の手法と比較して、BNext-L は、ImageNet-1k 上で初めてバイナリ モデルのパフォーマンス境界を 80.57% に押し上げ、ほとんどの既存の手法と比較して 10% の精度向上を達成しました。 Google の PokeBNN と比較すると、BNext-M は同様のパラメータで 0.7% 高く、著者はまた、PokeBNN の最適化は、最大 8192 の Bacth サイズや 720 エポックの TPU など、より高いコンピューティング リソースに依存していることも強調しています。一方、BNext-L は、従来のバッチ サイズ 512 で 512 エポックのみを反復しました。これは、BNext の構造設計と最適化手法の有効性を反映しています。同じベースライン モデルに基づく比較では、BNext-T と BNext-18 の両方で精度が大幅に向上しました。 RegNetY-4G (80.0%) などの完全精度モデルと比較して、BNext-L は、限られたパラメータ空間と計算複雑性のみを使用しながら、マッチング視覚表現学習機能を実証するため、エッジ展開に最適です。バイナリ モデルの特徴抽出機能は、豊かな想像力の空間を提供します。 B次 著者らは論文の中で、自分たちとその協力者がこの高精度 BNN アーキテクチャを GPU ハードウェアの動作効率上で積極的に実装および検証していると述べています。さらに、将来的には他の幅広いハードウェア プラットフォームにも拡張する予定です。しかし、編集者の意見では、コミュニティは BNN に対する信頼を取り戻し、システムおよびハードウェア分野のより多くのオタクの注目を集めました。おそらく、この研究のより重要な意義は、BNN のアプリケーションの可能性の想像力を再構築することです。長期的には、ますます多くのアプリケーションがクラウド中心のコンピューティング パラダイムから分散型エッジ コンピューティングに移行するにつれて、将来的には膨大な数のエッジ デバイスがより効率的な AI テクノロジー、ソフトウェア フレームワーク、ハードウェア コンピューティング プラットフォームを必要とするでしょう。ただし、現在最も主流の AI モデルとコンピューティング アーキテクチャは、エッジ シナリオ向けに設計および最適化されていません。したがって、エッジAIに対する答えが見つかるまで、BNNは常に技術的な課題と大きな可能性に満ちた重要な選択肢であり続けると私は信じています。

最適化手法の観点から、BNext の著者は、最新の高精度モデルの最適化にデータ拡張がもたらす可能性のある利益を十分に考慮し、最初の最適化手法を提供します。バイナリ モデルの最適化における既存の一般的なデータ拡張戦略の影響の可能性に関する分析結果を考慮すると、実験結果は、既存のデータ拡張手法が、その後の研究におけるバイナリ モデルに特有のバイナリ モデルの最適化には完全には適していないことを示しています。強化戦略の設計はアイデアを提供します。

最適化手法の観点から、BNext の著者は、最新の高精度モデルの最適化にデータ拡張がもたらす可能性のある利益を十分に考慮し、最初の最適化手法を提供します。バイナリ モデルの最適化における既存の一般的なデータ拡張戦略の影響の可能性に関する分析結果を考慮すると、実験結果は、既存のデータ拡張手法が、その後の研究におけるバイナリ モデルに特有のバイナリ モデルの最適化には完全には適していないことを示しています。強化戦略の設計はアイデアを提供します。

次は何ですか?

以上がImageNet 上で 80% 以上の精度を持つ最初のバイナリ ニューラル ネットワーク BNext が登場、-1 と +1 の 5 年間の旅の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。