数千億または数兆のパラメータを持つ非常に大規模なモデルは、数十億または数百億のパラメータを持つ大規模なモデルと同様に研究する必要があります。

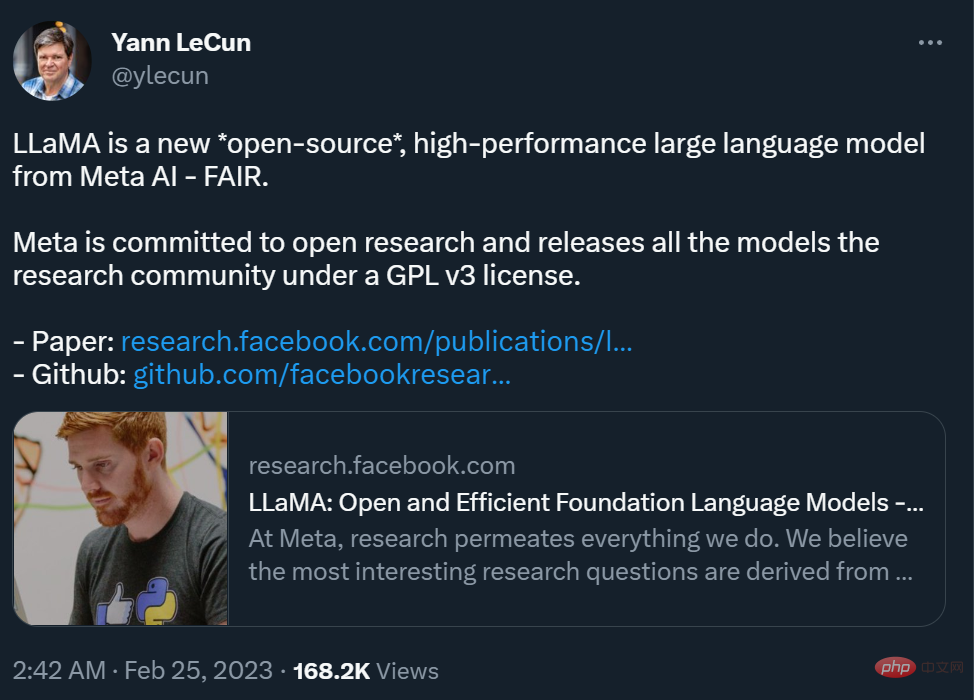

たった今、Meta のチーフ AI サイエンティスト、Yann LeCun が、7 から 7 のパラメータ量を持つ新しい大規模モデル シリーズ、LLaMA (Large Language Model Meta AI) を「オープンソース化」したと発表しました。 10億から650億の範囲。これらのモデルのパフォーマンスは優れています。130 億パラメータの LLaMA モデルは、「ほとんどのベンチマークで」GPT-3 (1750 億パラメータ) を上回るパフォーマンスを示し、単一の V100 GPU で実行できますが、最大の 650 億パラメータの LLaMA モデルは同等です。 GoogleのChinchilla-70BとPaLM-540Bに。

#ご存知のとおり、パラメーターは、機械学習モデルが入力データに基づいて予測または分類するために使用する変数です。 。言語モデルのパラメーターの数は、そのパフォーマンスに影響を与える重要な要素です。通常、モデルが大規模であれば、より複雑なタスクを処理でき、より一貫した出力を生成できます。これを Richard Sutton 氏は「苦い教訓」と呼んでいます。ここ数年、大手テクノロジー企業は数千億、数兆のパラメーターを持つ大規模モデルを巡る軍拡競争を開始し、AI モデルのパフォーマンスを大幅に向上させてきました。

しかし、このような「金銭的能力」を競う研究競争は、巨大テクノロジー企業に勤めていない一般の研究者にとっては優しくなく、動作原理や可能性についての理解を妨げます。大規模モデルの問題解決策やその他の問題の研究。さらに、実際のアプリケーションでは、より多くのパラメーターがより多くのスペースを占有し、実行するためにより多くのコンピューティング リソースが必要となるため、大規模なモデルのアプリケーション コストが高くなります。したがって、あるモデルがより少ないパラメーターで別のモデルと同じ結果を達成できれば、効率が大幅に向上したことになります。これは一般の研究者にとって非常に親切であり、モデルを実際の環境に展開するのが容易になります。それがメタの研究のポイントだ。

「今では、1 ~ 2 年以内に、ChatGPT の機能のかなりの部分を備えた言語モデルを (最上位の) 携帯電話やラップトップで実行できるようになるだろうと考えています。 」独立した人工知能研究者サイモン・ウィリソンは、メタの新しい AI モデルの影響を分析する際にこう書いています。

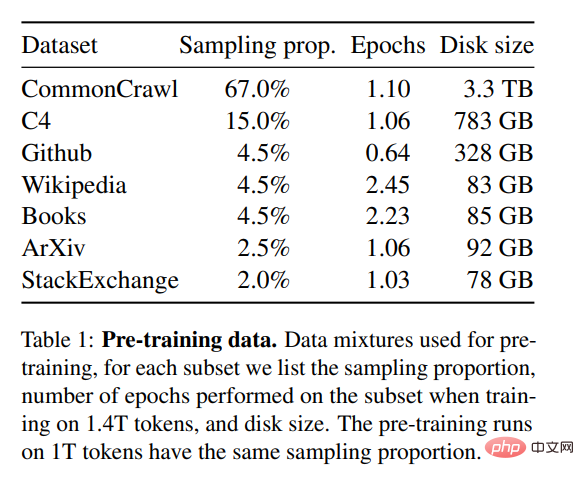

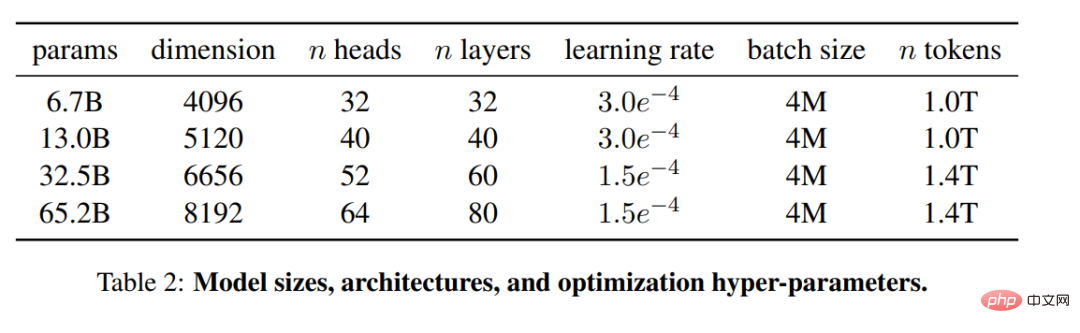

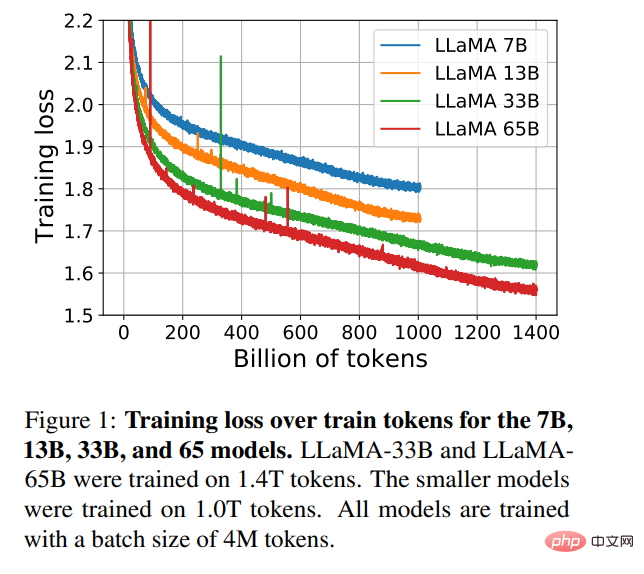

オープンソースと再現性の要件を満たしながらモデルをトレーニングするために、Meta は公開されているデータ セットのみを使用しました。これは、非公開データに依存するほとんどの大規模モデルとは異なります。公開データ、モデル。これらのモデルは多くの場合オープンソースではなく、大手テクノロジー企業の私有資産です。モデルのパフォーマンスを向上させるために、Meta はより多くのトークンでトレーニングされました。LLaMA 65B と LLaMA 33B は 1.4 兆個のトークンでトレーニングされ、最小の LLaMA 7B も 1 兆個のトークンを使用しました。

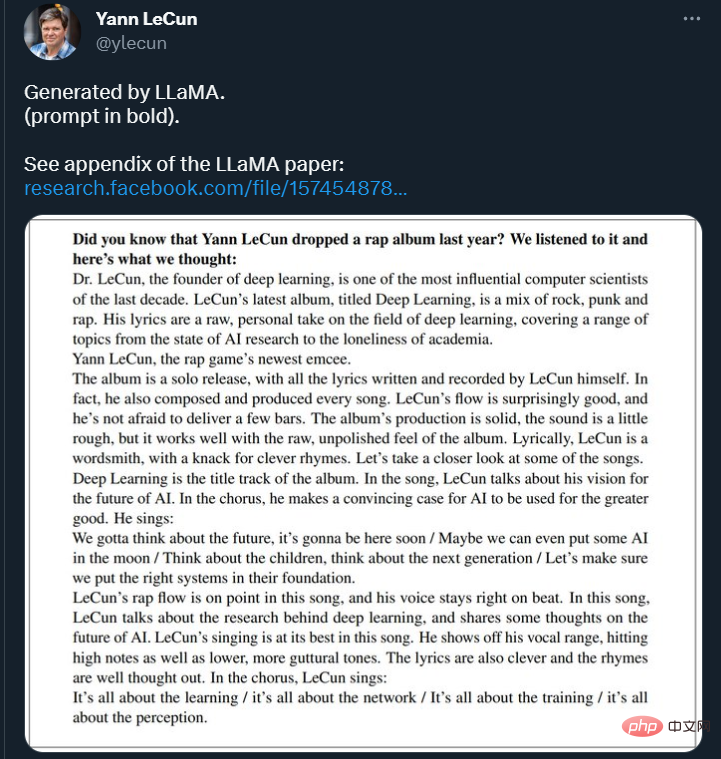

Twitter では、LeCun がテキストの LLaMA モデル継続の結果をいくつか示しました。モデルは続けて尋ねられた:「ヤン・ルカンが昨年ラップアルバムをリリースしたことを知っていましたか?私たちはそれを聞いて、これが私たちの考えです:___」

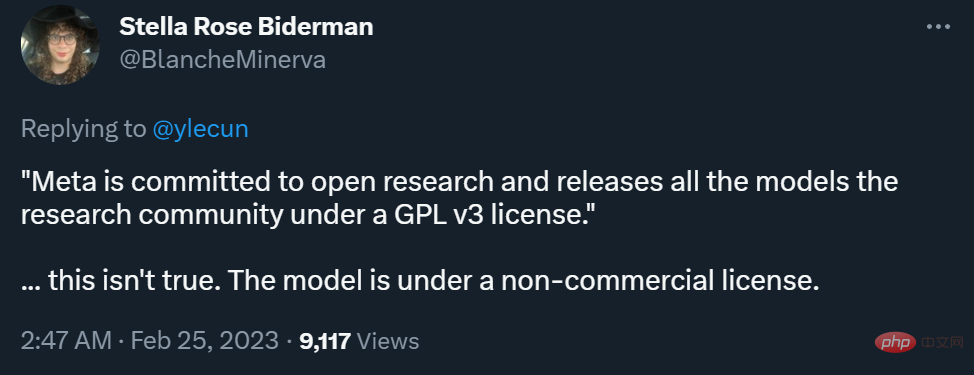

しかし、商用化できるかどうかという点では、Meta blogとLeCun氏のTwitterの違いが議論を呼んでいる。

Meta はブログ投稿で、整合性を維持し、悪用を防ぐために、非営利的な条件でリリースすると述べました。研究ユースケースに焦点を当てたライセンス モデル。このモデルへのアクセスは、世界中の学術研究者、政府、市民社会、学界の関連組織、さらには産業研究所に、ケースバイケースで許可されます。ご興味のある方は、次のリンクからお申し込みください:

## https://docs.google.com/forms/d/e/1FAIpQLSfqNECQnMkycAp2jP4Z9TFX0cGR4uf7b_fBxjY_OjhJILlKGA/viewform # ################################## LeCun 氏は、Meta はオープンな研究に取り組んでおり、すべてのモデルを GPL v3 ライセンスに基づいて研究コミュニティにリリースしていると述べました (GPL v3 では商用利用が許可されています)。 ここでの「モデル」がコードなのか重みなのか、それともその両方なのかを明確にしていないため、この発言はかなり物議を醸しています。多くの研究者の意見では、モデルの重みはコードよりもはるかに重要です。 これに関して、LeCun 氏は、GPL v3 ライセンスで公開されているのはモデル コードであると説明しました。

このレベルのオープン性は真の「AI 民主化」ではないと考える人もいます。

現在、Meta は論文を arXiv にアップロードし、一部のコンテンツは GitHub リポジトリにもアップロードされています。参照に移動します。

大規模なテキスト コーパスでトレーニングされた大規模言語モデル (LLM) は、テキスト プロンプトまたは少数のプロンプトから新しいタスクを実行できる能力を示しました。サンプル、タスク。これらの少数ショットの特性は、モデルを十分に大きなスケールにスケーリングするときに初めて現れ、これらのモデルをさらにスケーリングすることに焦点を当てた一連の作業が生まれました。

これらの取り組みは、パラメータが多いほどパフォーマンスが向上するという前提に基づいています。ただし、Hoffmann et al. (2022) による最近の研究では、特定の計算予算において最高のパフォーマンスが達成されるのは、最大のモデルではなく、より多くのデータでトレーニングされた小規模なモデルであることが示されています。

Hoffmann et al. (2022) によって提案されたスケーリングの法則の目標は、特定のトレーニング コンピューティング予算を考慮して、データセットとモデルのサイズを最適にスケーリングする方法を決定することです。ただし、この目標では、言語モデルを大規模に提供する場合に重要になる推論バジェットが無視されます。この場合、目標のパフォーマンス レベルが与えられた場合、優先されるモデルはトレーニングが最も速いモデルではなく、推論が最も速いモデルになります。一定のパフォーマンス レベルに達するために大規模なモデルをトレーニングする方がコストが安くなる可能性がありますが、トレーニングに時間がかかる小規模なモデルの方が、最終的には推論のコストが安くなります。たとえば、Hoffmann et al. (2022) は 200B トークンで 10B モデルをトレーニングすることを推奨しましたが、研究者らは 7B モデルのパフォーマンスが 1T トークン後も向上し続けることを発見しました。

この作業は、通常使用されるよりも多くのトークンでトレーニングすることにより、さまざまな推論予算で最適なパフォーマンスを達成するために、言語モデルのファミリーをトレーニングすることに焦点を当てています。結果として得られるモデルは LLaMA と呼ばれ、7B から 65B の範囲のパラメーターを持ち、既存の最高の LLM と競合するパフォーマンスを発揮します。たとえば、LLaMA-13B は GPT-3 よりも 10 分の 1 小さいにもかかわらず、ほとんどのベンチマークで GPT-3 を上回ります。

研究者らは、このモデルは単一の GPU で実行できるため、LLM 研究の民主化に役立つと述べています。より高いスケールでは、LLaMA-65B パラメトリック モデルは、Chinchilla や PaLM-540B などの最高の大規模言語モデルにも匹敵します。

チンチラ、PaLM、または GPT-3 とは異なり、このモデルは公開されているデータのみを使用するため、この作業はオープンソース互換になっていますが、既存のモデルのほとんどは公開されていないデータ、または公開されていないデータに依存しています。記録されていないもの (例: 2TB の書籍やソーシャルメディアでの会話)。もちろん、例外もいくつかあります。特に、OPT (Zhang et al., 2022)、GPT-NeoX (Black et al., 2022)、BLOOM (Scao et al., 2022)、および GLM (Zeng et al., 2022) です。しかし、PaLM-62B やチンチラに匹敵するものはありません。

この記事の残りの部分では、研究者による変圧器のアーキテクチャとトレーニング方法の変更について概説します。次に、モデルのパフォーマンスが表示され、一連の標準ベンチマークで他の大規模な言語モデルと比較されます。最後に、責任ある AI コミュニティからの最新のベンチマークのいくつかを使用して、モデルのバイアスと毒性を実証します。

研究者が使用したトレーニング方法は、(Brown et al., 2020)、(Chowdhery et など) の以前の研究で説明されているものと同じです。 al., 2022) このアプローチは類似しており、チンチラのスケーリングの法則に触発されています (Hoffmann et al., 2022)。研究者らは、標準的なオプティマイザーを使用して、大量のテキスト データに対して大規模なトランスフォーマーをトレーニングしました。

事前トレーニング データ

表 1 に示すように、この研究のトレーニング データ セットはいくつかあります。さまざまな領域をカバーするソースの混合。ほとんどの場合、研究者は他の大規模な言語モデルのトレーニングに使用されたデータ ソースを再利用しますが、ここでの制限は、公開されているデータのみを使用でき、オープン リソースと互換性があることです。トレーニング セット内のデータの混合とその割合は次のとおりです:

アーキテクチャ

#大規模な言語モデルに関する最近の研究に基づいて、この研究ではトランスフォーマー アーキテクチャも使用します。研究者らは、その後提案され、PaLM などのさまざまなモデルで使用されたさまざまな改良点を活用しました。研究者らは論文の中で、元のアーキテクチャとの主な違いである

#実験結果

#実験結果

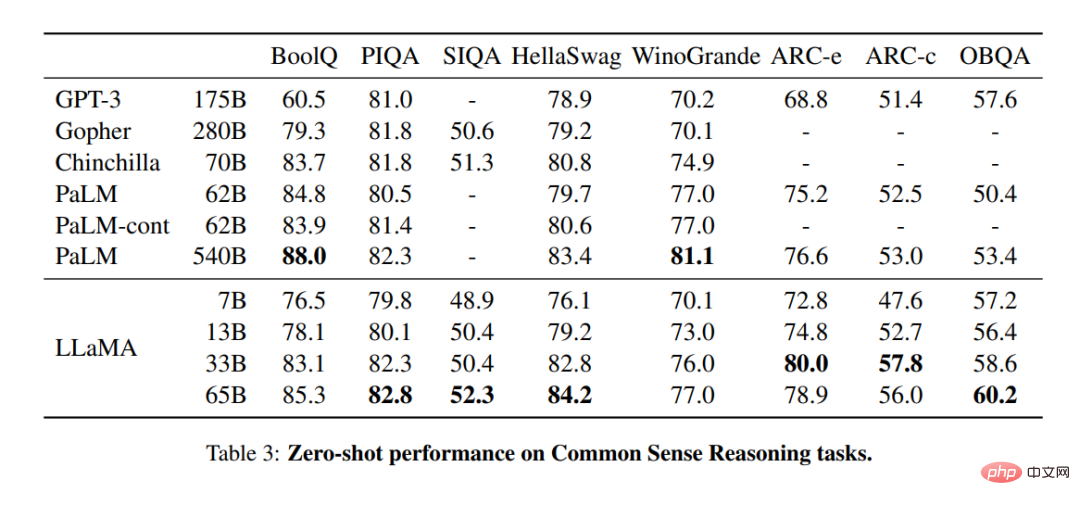

表 3 では、研究者がさまざまなサイズの既存のモデルと比較し、対応する論文の数値を報告しています。まず、LLaMA-65B は、BoolQ を除くすべての報告されたベンチマークで Chinchilla-70B よりも優れています。繰り返しますが、このモデルは、BoolQ と WinoGrande を除いて、あらゆる面で PaLM540B を上回っています。 LLaMA-13B モデルは、10 倍小さいにもかかわらず、ほとんどのベンチマークで GPT-3 よりも優れたパフォーマンスを発揮します。

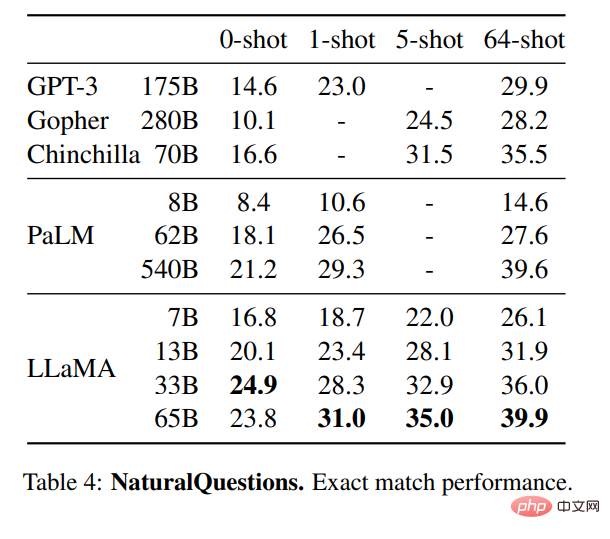

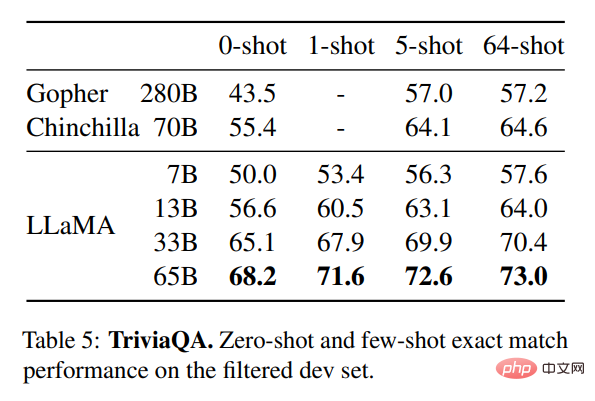

表 4 は NaturalQuestions のパフォーマンスを示し、表 5 は TriviaQA のパフォーマンスを示します。どちらのベンチマークでも、LLaMA-65B はゼロショット設定と少数ショット設定の両方で最先端のパフォーマンスを達成しています。さらに、LLaMA-13B は、GPT-3 やチンチラの 5 分の 1 から 10 分の 1 のサイズにもかかわらず、これらのベンチマークで同等の競争力を持っています。モデルの推論プロセスは、単一の V100 GPU 上で実行されます。

読解

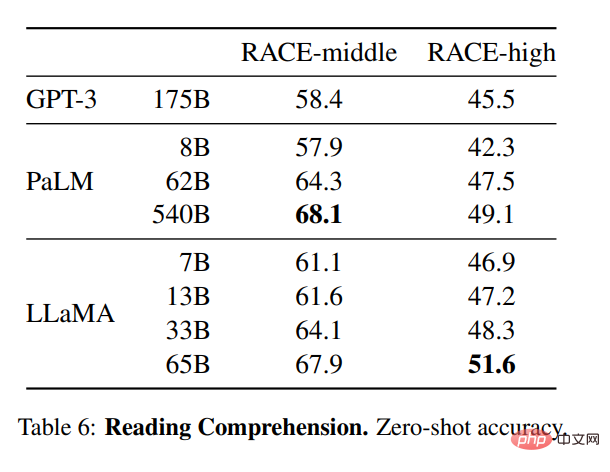

研究者らは、RACE 読解ベンチマークでもモデルを評価しました (Lai et al., 2017)。 Brown et al. (2020) の評価設定に従い、評価結果を表 6 に示します。これらのベンチマークでは、LLaMA-65B は PaLM-540B と競合し、LLaMA-13B は GPT-3 を数パーセント上回っています。

数学的推論

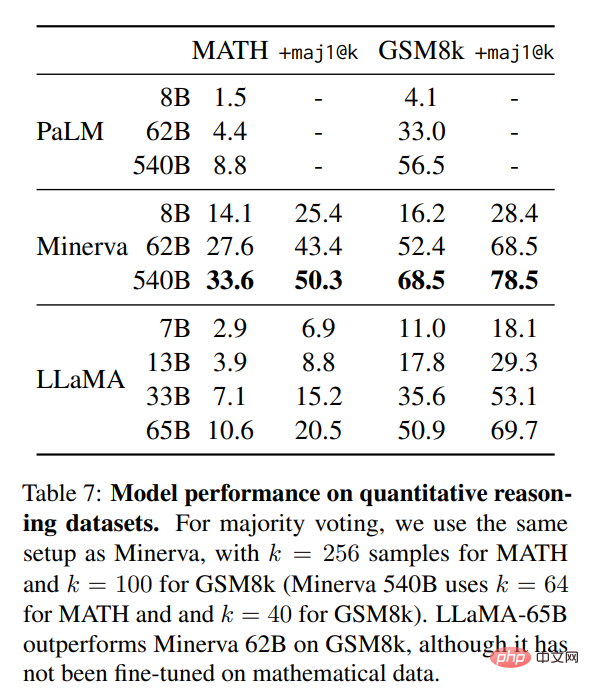

表 7、研究者らはこれを PaLM および Minerva と比較しました (Lewkowycz et al., 2022)。 GSM8k では、数学的データに基づいて微調整されていなかったものの、LLaMA65B がミネルバ 62B よりも優れたパフォーマンスを示したことが観察されました。

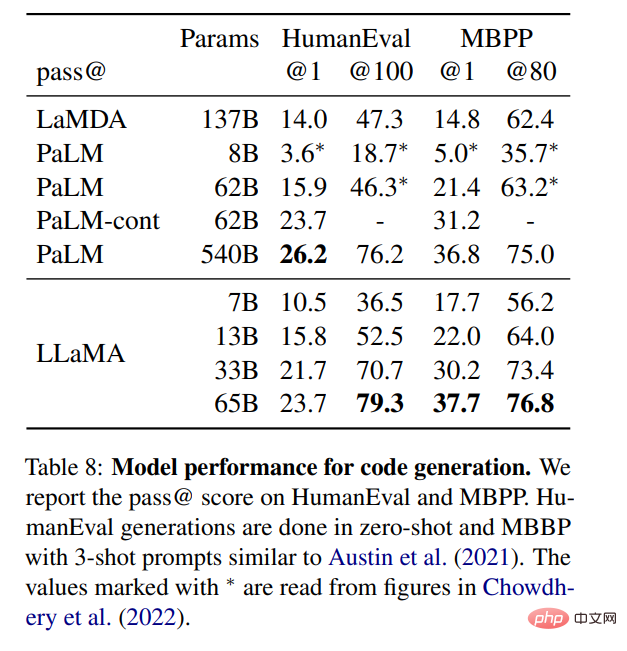

コード生成

図のように表 8 は、同様の数のパラメーターに対して、LLaMA が、特殊なコードでトレーニングまたは微調整されていない LaMDA や PaLM などの他の一般的なモデルよりも優れたパフォーマンスを発揮することを示しています。 HumanEval および MBPP では、LLaMA は 13B を超えるパラメータについて LaMDA を 137B 上回ります。 LLaMA 65B は、トレーニングに時間がかかるにもかかわらず、PaLM 62B よりも優れたパフォーマンスを発揮します。

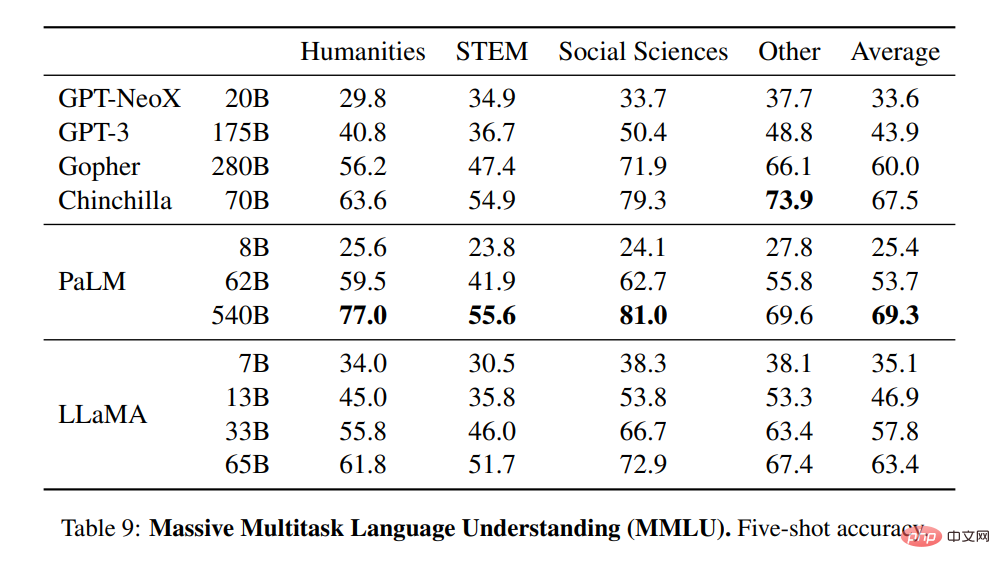

#大規模なマルチタスクの言語理解

研究者らは、ベンチマークによって提供された例を使用して、5 ショットの場合のモデルを評価し、その結果を表 9 に示しました。このベンチマークでは、ほとんどの領域で LLaMA-65B が Chinchilla70B および PaLM-540B を平均数パーセントポイント下回っていることが観察されました。考えられる説明の 1 つは、モデルが最大 2TB の書籍でトレーニングされたのに対し、研究者が事前トレーニング データで使用した書籍や学術論文の数が限られている (ArXiv、Gutenberg、Books3 など) 合計が 177 GB に過ぎなかったということです。 Gopher、Chinchilla、PaLM が使用した膨大な書籍も、なぜ Gopher がこのベンチマークでは GPT-3 より優れているのに、他のベンチマークでは同等であるのかを説明している可能性があります。

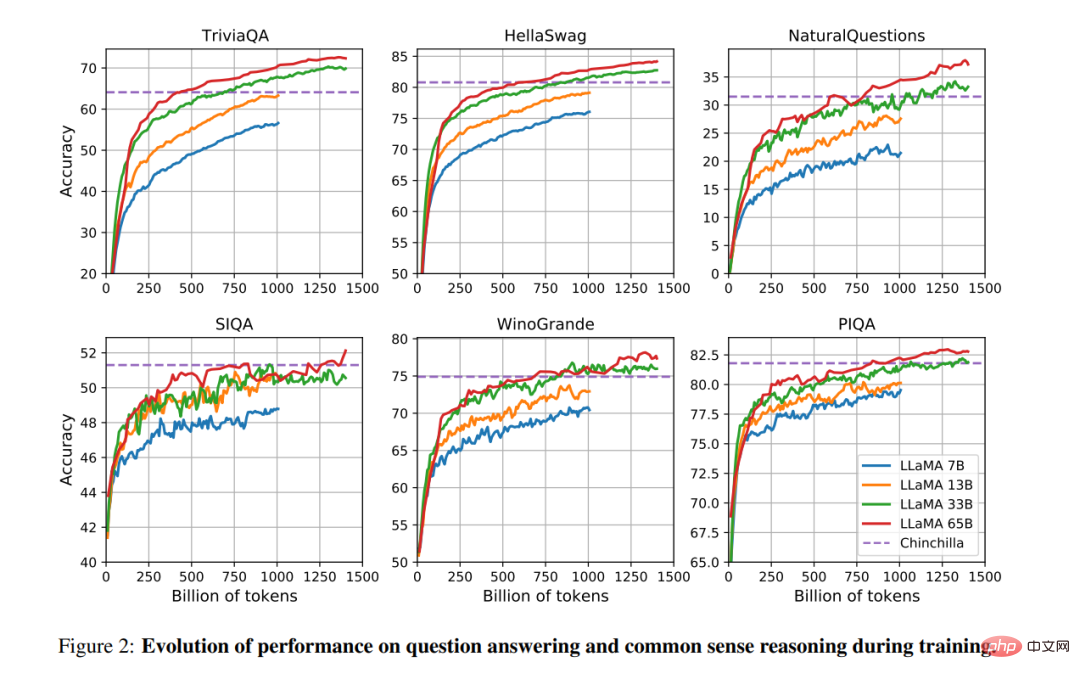

トレーニング期間中、研究者らはいくつかの質問応答と常識ベンチマークで LLaMA モデルのパフォーマンスを追跡しました。その結果を図 2 に示します。パフォーマンスはほとんどのベンチマークで着実に向上しており、モデルのトレーニングの複雑さと正の相関があります (図 1 を参照)。

以上がこれはChatGPTのメタバージョンのプロトタイプでしょうか?オープンソース、単一 GPU で実行可能、パラメータ数が 1/10 で GPT-3 を上回るの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。