スパース エキスパート モデルは 30 年前の概念であり、現在でも広く使用されており、ディープ ラーニングで人気のアーキテクチャです。このようなアーキテクチャには、ハイブリッド エキスパート システム (MoE)、スイッチ トランスフォーマー、ルーティング ネットワーク、BASE レイヤーなどが含まれます。スパース エキスパート モデルは、自然言語処理、コンピューター ビジョン、音声認識などの多くの分野で優れたパフォーマンスを実証しています。

最近、Google AI の責任者である Jeff Dean らが、スパース エキスパート モデルの概念をレビューし、一般的なアルゴリズムの基本的な説明を提供し、最後にスパース エキスパート モデルのレビューを書きました。今後の研究の方向性が楽しみです。

#論文アドレス: https://arxiv.org/pdf/2209.01667.pdf

機械学習、特に自然言語は、コンピューティング予算、トレーニング データ、モデル サイズの増加によって大幅に進歩しました。よく知られているマイルストーン言語モデルには、GPT-2 (Radford et al.、2018)、BERT (Devlin et al.、2018)、T5 (Raffel et al.、2019)、GPT-3 (Brown et al.、2020) などがあります。 、ゴーファー(Rae et al.、2021)、チンチラ(Hoffmann et al.、2022)およびPaLM(Chowdhery et al.、2022)。

しかし、最先端のモデルは現在、何千もの専用の相互接続されたアクセラレータを必要とし、トレーニングに数週間から数か月かかるため、これらのモデルの製造コストが高くなります (Patterson et al. 、2021)。機械学習システムが拡大するにつれて、この分野ではより効率的なトレーニングとサービス提供のパラダイムが求められています。スパースエキスパートモデルが有望なソリューションとして浮上しています。

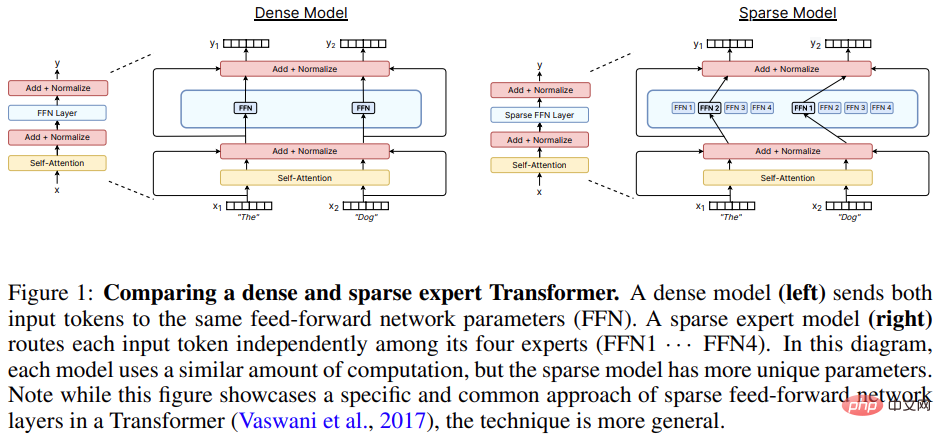

スパース エキスパート モデル (ハイブリッド エキスパート システム (MoE) が最も一般的なバリエーションです) は、特殊なタイプのニューラル ネットワークです。グループパラメータは「エキスパート」に分割され、それぞれに固有の重みが付けられます。

トレーニングと推論中、モデルは入力サンプルを特定のエキスパートの重みに割り当て、各サンプルにネットワーク全体を使用するのではなく、ネットワーク パラメーターのサブセットのみと対話できるようにします。従来の入力方法とは異なります。各サンプルに少数の専門家だけが使用されるため、計算量はモデル全体に比べて大幅に削減されます。

現代のスパース エキスパート モデルの多くは、Shazeer et al. (2017) からインスピレーションを得ています。この研究では、当時最大のモデルをトレーニングし、最先端の言語モデリングと翻訳の結果を達成しました。スパースエキスパートモデルの人気は、Transformer 言語モデルと組み合わせて使用するとさらに急増しました (Lepikhin et al., 2020; Fedus et al., 2021)。ほとんどの研究は自然言語処理に関するものですが、スパース エキスパート モデルは、コンピューター ビジョン (Puigcerver et al., 2020)、音声認識 (You et al., 2021)、マルチモダリティ学習などのさまざまな分野でもうまく使用されています。 (ムスタファ他、2022)。 Clark et al. (2022) は、さまざまなモデル サイズとエキスパート数の下で、疎エキスパート モデルのスケーリング特性を研究しました。さらに、多くのベンチマークに関する最先端の結果は、現在、ST-MoE などの疎なエキスパート モデルによって保持されています (Zoph et al.、2022)。この分野は研究と工学の進歩により急速に進化しています。

このレビュー ペーパーでは、調査範囲を狭い深層学習時代 (2012 年から始まる) におけるスパース エキスパート モデルに絞り、最近の進歩をレビューし、有望な将来の道について議論します。

スパース エキスパート モデル機械学習における MoE の概念は、少なくとも 30 年前に遡ることができます。初期の概念では、専門家は完全なニューラル ネットワークを定義しました。 ,MoE はアンサンブル アプローチに似ています。

Eigen et al. (2013) は、ジッターのある MNIST 上でスタック層エキスパート ハイブリッド アーキテクチャを使用することを提案し、この研究は後続のモデルの効率的な実装の基礎を築きました。

Shazeer et al. (2017) は、2 つの LSTM 層の間に MoE 層を挿入することを提案し、その結果得られるスパース モデルは機械翻訳で SOTA パフォーマンスを達成しました。しかし、この手法は成功したものの、その後の研究は冬眠のような状態で停滞し、ほとんどの研究がTransformerに傾いてしまいました。

2020 年から 2021 年にかけて、GShard と Switch Transformer がリリースされました。どちらも、Transformer のフィードフォワード レイヤーをエキスパート レイヤーに置き換えました。

エキスパートの層を使用するアプローチが支配的なパラダイムとなっていますが、過去 2 年間の研究では、モジュール性と構成性を実現するための完全に独立したモデルとしてエキスパート モデルの概念が再考されました。 。

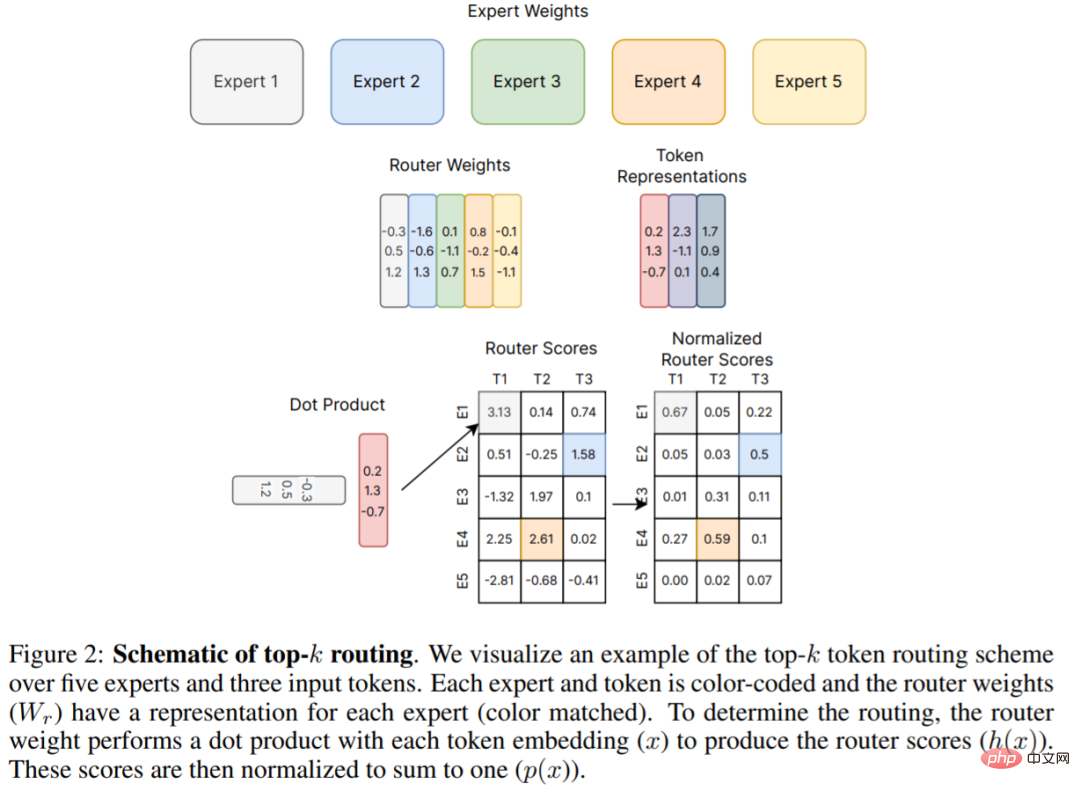

以下の図 2 は、Shazeer et al. (2017) によって提案されたオリジナルの top-k ルーティング メカニズムであり、その後の多くの研究の基礎となっています。このレビュー ペーパーでは、第 4 章でルーティング アルゴリズムの新しい開発について詳細に説明しています。

ハードウェア

最新のスパースエキスパートモデルは分散システムで開発されましたニューラルネットワークの共同設計。

大規模なニューラル ネットワークに関する研究 (Brown et al., 2020; Rae et al., 2021; Chowdhery et al., 2022) では、ニューラル ネットワークが人間のメモリをはるかに超えていることが示されています。単一アクセラレータの容量のため、重み、アクティベーション関数、オプティマイザ変数などのテンソルは、さまざまな並列戦略を使用してシャーディングする必要があります。

3 つの一般的な並列方法には、データ並列処理 (モデルの重みのコピー、データのシャーディング)、テンソル モデルの並列処理 (データと重みテンソルがデバイス間でシャーディングされる)、パイプライン並列処理 (レイヤー全体またはデータのシャーディング) が含まれます。レイヤーのグループはデバイス間でシャーディングされるため、ハイブリッド エキスパート モデルは多くの場合、これらの並列化シナリオに対応できます。

MoE モデルのトレーニングと展開に関して、Jaszczur et al. (2021) は、Transformer モデルのすべての層をスパース化し、それによって 37 倍の推論高速化を達成しました。Kossmann et al. 。 (2022) RECOMPILE ライブラリを介して静的エキスパートのバッチ サイズ制約を解決します。

データ並列処理、モデル並列処理、エキスパート並列処理に加えて、Rajbhandari et al. (2022) は、ZeRO パーティショニングと ZeRO-Offload をサポートし、10 倍の推論を達成する DeepSpeed-MoE ライブラリを提案しました。 SOTA 変換パフォーマンスが向上し、実稼働サービスにおけるモデルの有用性が高まります。

高密度ニューラル言語モデルのクロスエントロピー損失は、モデル パラメーター数、データ量、計算量の関数として動作します ( Kaplan 他、2020) べき乗則。べき乗則係数は後に Hoffmann et al. (2022) で修正され、最適なモデルの計算にはデータとパラメーター拡張のより緊密なバランスが必要であることが示唆されました。対照的に、ヒューリスティックに拡張した疎エキスパート モデルの初期の研究では、強力な経験的結果が得られましたが、拡張則は注意深く記述されていませんでした。さらに、一部の研究では、上流(例:事前トレーニング)アクションと下流(例:微調整)アクションの違いを強調しており(Fedus et al., 2021; Artetxe et al., 2021)、スパースエキスパートモデルの理解をさらに複雑にしています。

アップストリーム拡張機能

スパース エキスパート モデルは、大規模なデータセットでトレーニングすると優れたパフォーマンスを発揮します。自然言語処理における一般的なパターンは、最初に上流トレーニング (例: 事前トレーニング) を実行し、次に対象となる特定のデータ分布に対して下流トレーニング (例: 微調整) を実行することです。上流段階では、疎エキスパート モデルは、密な対応モデルよりも一貫して高いゲインをもたらします。 Shazeer et al. (2017) は、10 億ワード言語モデリング ベンチマーク (Chelba et al., 2013) のモデル パラメーターと計算量に関するスケーリング カーブを提案し、高密度バージョンと比較して大幅な向上を達成しました。 Lepikhin et al. (2020) は、モデル拡張関数の改良版を提案し、最大の 600B パラメーターのスパース モデルで 13.5 の BLEU スコアの向上を達成しました。 Switch Transformer (Fedus et al.、2021) は、同じ計算リソースを使用して T5 モデル上で 4 ~ 7 倍の実行時間の高速化を測定しました。この研究では、パラメータ数の関数としてクロスエントロピー損失のスケーリングも調査しましたが、専門家が 256 名を超えると、利得が減少することが観察されました。

ダウンストリーム拡張機能

ただし、信頼性の高い上流のスケーリングによって、下流のタスクで一貫した利益がすぐに得られるわけではありません。転送の課題を強調した研究で、Fedus et al. (2021) は、低コンピューティング、高パラメータのエンコーダ/デコーダ Transformer (パラメータ 1.6T、スパース層ごとに 2048 人のエキスパート) を使用した 4 回の事前トレーニングの改善を観察しました。 SuperGLUE などの集中的な推論タスクではうまく微調整できません。この発見は、さらに必要な研究と、計算とパラメータの間で必要とされる可能性のあるバランスを示唆しています。

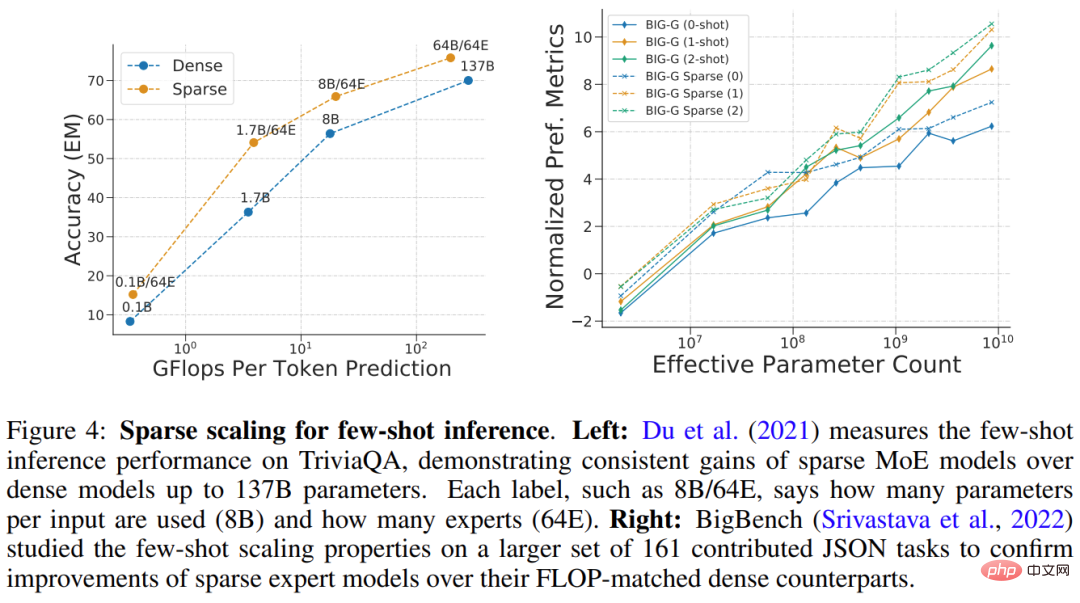

Du et al. (2021) は、疎層ごとに 64 人の専門家を使用して、1B ~ 64B FLOP の範囲の疎 GLaM モデルの拡張を実証しました。 GLaM は、ゼロショットおよびワンショットのパフォーマンスの点で 175B パラメーターの GPT-3 モデル (Brown et al., 2020) を上回る SOTA 結果を達成し、同時に、推論中に各トークンが使用する FLOP が 49 削減されました。 %. 消費量は 65% 削減されました (以下の図 4 (左) を参照)。以下の図 4 (右) は、少数ショット推論で良好なパフォーマンスを発揮するスパース モデルの別の例です。

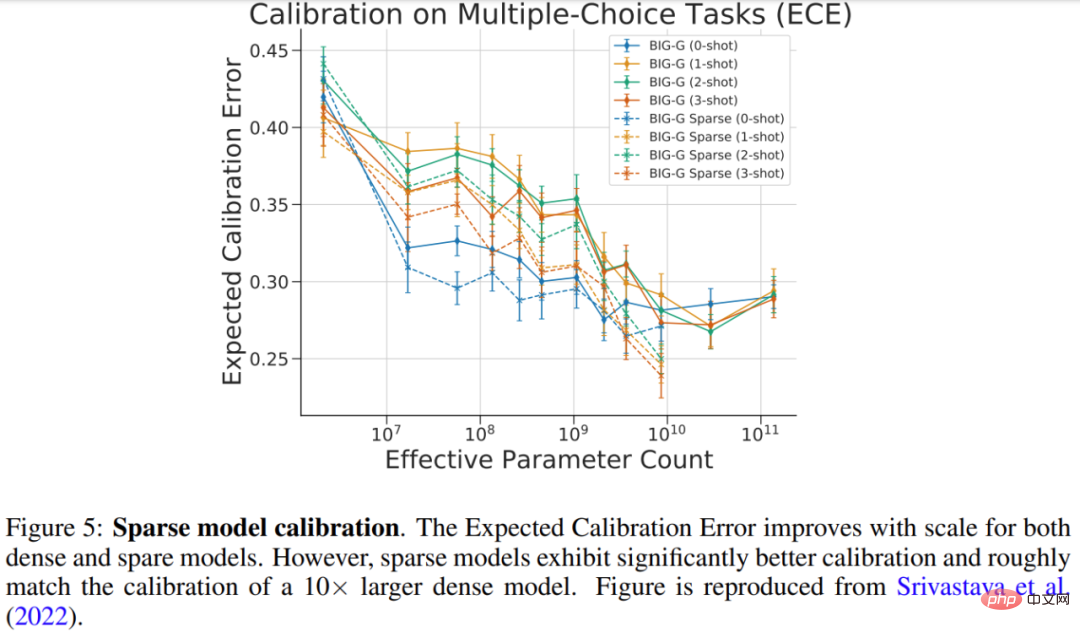

Srivastava et al. (2022) は、複数選択の BIG-Bench タスクでのスパース モデルのキャリブレーションを研究しました。確率対正解 確率の一致の度合い。研究結果は以下の図 5 に示されており、大規模な密モデルと疎モデルの両方でキャリブレーションが向上しましたが、疎モデルのキャリブレーションは 10 倍以上の FLOP を使用した密モデルのキャリブレーションと同等でした。

#エキスパート層の数、規模、頻度を拡大する

数 いくつかの重要なハイパーパラメータによって、疎エキスパート モデルのスケーリングが制御されます。これには、1) エキスパートの数、2) 各エキスパートのサイズ、3) エキスパート レイヤーの頻度が含まれます。これらの決定は、上流と下流の拡大に大きな影響を与える可能性があります。

初期の作品の多くは、レイヤーあたり数千人の比較的小規模な専門家にスケールされ、優れた事前トレーニングと翻訳の品質をもたらしました (Shazeer et al., 2017; Lepikhin et al., 2020; Fedusら、2021)。ただし、スパース モデルの品質は、ドメインのシフト (Artetxe et al., 2021) やさまざまなタスク分布の微調整 (Fedus et al., 2021) の場合に不釣り合いに低下します。計算とパラメーターのより良いバランスを実現するには、少数ショット推論用の SOTA スパース モデル (GLaM (Du et al., 2021)) と微調整 (ST-MoE (Zoph et al., 2022)) のみを使用できます。せいぜい 64 人の大規模な専門家。エキスパートの要素が増加したため、これらのモデルでは、アクセラレータが効果的に実行されるように、特定のシステムレベルのシャーディング戦略が必要になります (Du et al., 2021; Rajbhandari et al., 2022)。

ルーティング アルゴリズムルーティング アルゴリズムは、すべてのスパース エキスパート アーキテクチャの重要な機能であり、サンプルの送信先を決定します。この領域は、学習されていない固定ルーティング パターンを使用した直感に反するアプローチを含め、広範囲に研究されてきました (Roller et al., 2021)。どの専門家を選択するかについては個別の決定が行われるため、ルーティングの決定は多くの場合微分不可能です。

エキスパート選択問題は後にバンディット問題として再定義され、エキスパート選択を学習するために強化学習を使用する研究がいくつか行われています (Bengio et al., 2016; Rosenbaum et al., 2017; 2019; Clark et al.、2022)。 Shazeer et al. (2017) は、強化学習の困難を回避するための微分可能なヒューリスティック アルゴリズムを提案しました。

この文書では、ルーティング アルゴリズムの分類について詳しく説明し、このフィールド負荷分散における重要な問題についてさらに説明します。

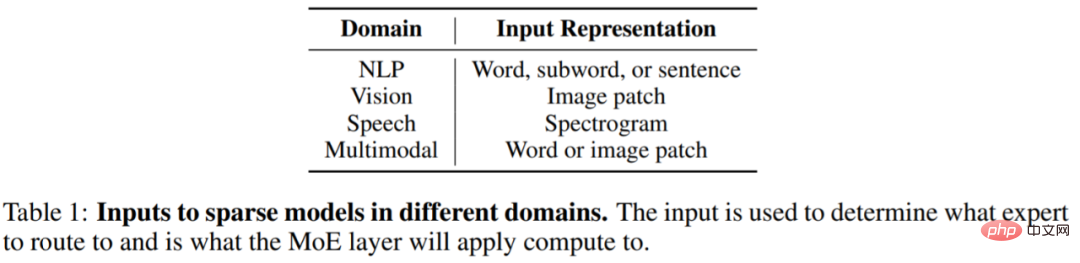

スパース エキスパート モデルの急速な開発スパース エキスパート モデルの影響は、コンピューター ビジョン、音声認識、マルチモーダルなど、NLP を超えた他の分野にも急速に広がっています。アプリケーション。ドメインは異なりますが、モデルのアーキテクチャとアルゴリズムはほぼ同じです。以下の表 1 は、さまざまなドメインのスパース層の入力表現を示しています。

# スパース エキスパート モデルは、近年非常に急速に開発されました。 NLP の分野を例に挙げると、Shazeer et al. (2017) は、LSTM モデルの標準層の間に挿入される、LSTM 言語モデリングと機械翻訳用のハイブリッド エキスパート層を導入しました。

2020 年に、Lepikhin et al. (2020) は、初めて MoE レイヤーを Transformer に導入しました。研究者が各エキスパート レイヤーを 2048 人のエキスパートに拡張したところ、モデルは 100 の異なる言語で SOTA 翻訳を達成しました。

Fedus et al. (2021) は、SOTA 事前トレーニング品質を達成するスパース 1.6T パラメーター言語モデルを作成しました。

新しい研究により、少数ショット学習推論とベンチマークの微調整の開発が進められています。 Du et al. (2021) は、純粋な MoE デコーダ言語モデルをトレーニングし、小さなサンプルで SOTA 結果を達成し、GPT-3 のトレーニングに必要な計算量の 1/3 のみを必要としました。 Zoph et al. (2022) は、広範囲の推論および生成タスクで SOTA を実現するスパース エンコーダ/デコーダ モデルである ST-MoE を提案しました。 SuperGLUE で微調整すると、ST-MoE は PaLM-540B より優れたパフォーマンスを発揮しますが、使用する量はトレーニング前の FLOP の約 1/20、推論 FLOP の 1/40 のみです。

よくある質問は、固定のコンピューティングまたは FLOP 予算 (例: 20 時間で 100 GPU) が与えられている場合、何をすべきかというものです。最高のパフォーマンスを得るには、どのタイプのモデルをトレーニングする必要がありますか?

基本的に、スパース モデルでは、サンプルあたりの FLOP をほぼ一定に保ちながら、専門家の数を増やすことでモデル内のパラメーターの数を大幅に増やすことができます。このアプローチは、モデルの目的に応じて良い場合も悪い場合もあります。

スパース性は、スパース性の使用に伴うすべての追加パラメータを運ぶアクセラレータ (GPU/TPU など) が多数ある場合に有益です。

スパース性を使用するには、下流のタスクについても慎重に検討する必要があります。事前トレーニング用のマシンは多数あるが、微調整やサービス提供用のマシンはほとんどない場合は、ダウンストリームのユースケースで利用可能なメモリの量に基づいてスパース性 (エキスパートの数など) を調整する必要があります。

場合によっては、疎モデルは常に密モデルよりも見栄えが悪くなります。たとえば、すべてのパラメータがアクセラレータ メモリに保存されている場合、疎モデルは密モデルよりも劣ります。スパース モデルは、専門家からの追加のモデル パラメーターをホストするために、複数のマシンで並行してトレーニングまたはサービスを提供できる場合に最適です。

さらに、このレビュー論文では、スパースモデルのトレーニング、解釈可能性、今後の研究の方向性の改善についても紹介されているので、興味のある方は元の論文をチェックして、より多くの研究内容を学ぶことができます。

以上が30 年の歴史的レビュー、ジェフ・ディーン: 「まばらな専門家モデル」の研究レビューをまとめましたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。