計算画像間の類似性は、コンピューター ビジョンにおける未解決の問題です。

画像生成が世界中で普及している今日、「類似性」をどのように定義するかも、生成された画像の信頼性を評価する際の重要な問題です。画像。

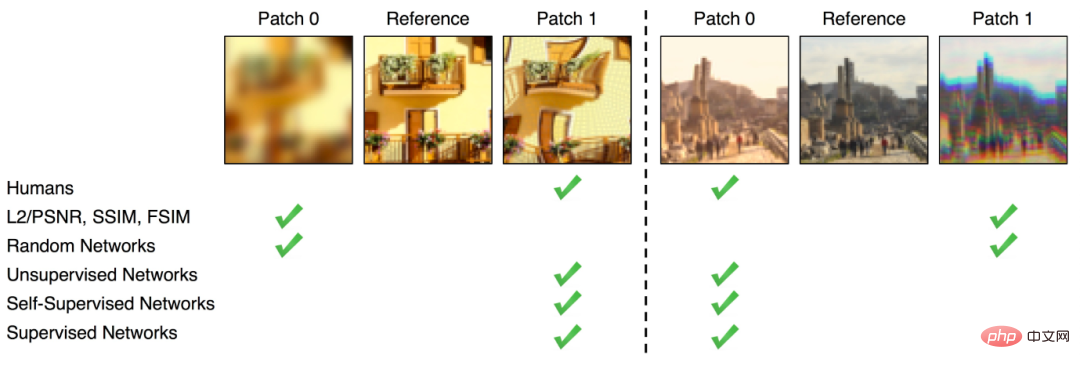

画像の類似性を計算するには、ピクセルでの差を測定するなどの比較的直接的な方法 (FSIM、SSIM など) がいくつかありますが、この方法では差分が得られます。類似点は、人間の目で認識される違いとは程遠いものです。

ディープラーニングの台頭後、一部の研究者は、AlexNet、VGG、SqueezeNet などのいくつかのニューラル ネットワーク分類器によって取得される中間表現 が、 ImageNet でのトレーニングは、知覚的な類似性の計算として使用できます。

言い換えれば、埋め込みはピクセルよりも複数の画像の類似性に対する人々の認識に近いということです。

は単なる仮説です。 最近 Google は、ImageNet 分類器が知覚的類似性をより適切に評価できるかどうかを特に研究した論文を発表しました。

# 論文リンク: https://openreview.net/pdf?id=qrGKGZZvH0

# 論文リンク: https://openreview.net/pdf?id=qrGKGZZvH0

2018 年にリリースされた BAPPS データセット

に関する研究が行われてきましたが、知覚スコアは、第一世代の ImageNet 分類器で研究されました。精度と知覚スコアの相関関係や各種ハイパーパラメータの影響など、最新のViTモデルの研究結果が論文に追加されています。 精度が高くなるほど、知覚される類似性は悪くなりますか?

誰もが知っているように、ImageNet でのトレーニングを通じて学習した機能は、多くの下流タスクに適切に転送でき、下流タスクのパフォーマンスを向上させることができます。これにより、ImageNet での事前トレーニングも標準操作になります。さらに、ImageNet でより高い精度を達成することは、破損した画像に対する堅牢性、配布外のデータや転移学習に対する一般化パフォーマンスなど、さまざまな下流タスクのパフォーマンスの向上を意味することがよくあります。より小さなカテゴリデータセットに。

しかし、知覚的な類似性の計算に関しては、すべてが逆転しているように見えます。

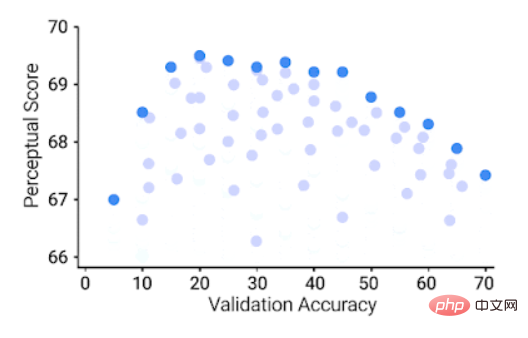

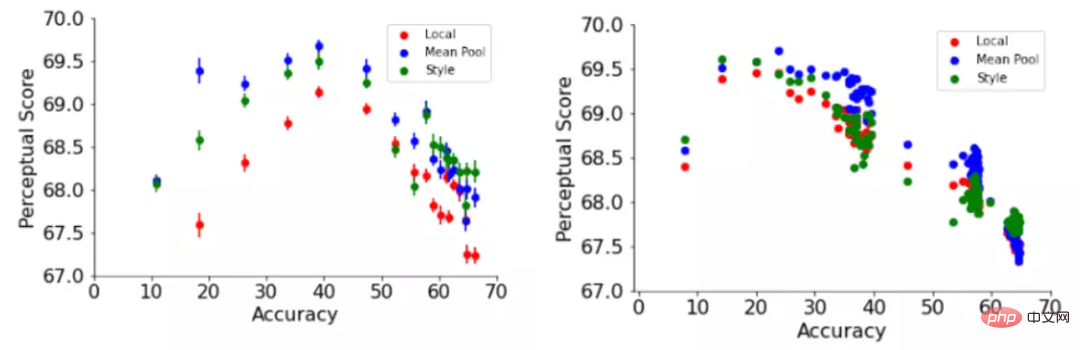

ImageNet で高い精度を達成するモデルの知覚スコアは低くなりますが、「中程度」のスコアを持つモデルは知覚類似性タスクで最高のパフォーマンスを発揮します。

ImageNet 64 × 64 検証精度 (x 軸)、64 × 64 BAPPS データセットの知覚スコア (y 軸)、各青い点は ImageNet 分類子を表します

ImageNet 64 × 64 検証精度 (x 軸)、64 × 64 BAPPS データセットの知覚スコア (y 軸)、各青い点は ImageNet 分類子を表します

優れた ImageNet 分類子は、ある程度まではより良い知覚スコアを達成しますが、特定のしきい値を超えると精度が向上することがわかります。分類器の精度は中程度 (20.0 ~ 40.0) で、最高の知覚スコアが得られます。

この記事では、幅、深さ、トレーニング ステップ数、重みの減衰、ラベルの平滑化、ドロップアウトなどの知覚スコアに対するニューラル ネットワークのハイパーパラメーターの影響についても研究しています。 各ハイパーパラメータには最適な精度があり、精度を上げると知覚スコアが向上しますが、この最適値は非常に低く、ハイパーパラメータ スイープの非常に早い段階で到達します。

これに加えて、分類器の精度が向上すると、知覚スコアが悪化します。

例として、この記事では、ResNets のトレーニング ステップと ViTs の幅という 2 つのハイパーパラメーターに関連した知覚スコアの変化を示しています。

ResNets を早期に停止すると、6、50、200 のさまざまな深度設定で最高の知覚スコアが達成されました

ResNet-50 と ResNet の知覚スコア-200 はトレーニングの最初の数エポックで最高値に達しますが、ピークを過ぎると、よりパフォーマンスの高い分類器の知覚スコア値がより急激に低下します。

結果は、ResNets のトレーニングと学習率の調整により、ステップが増加するにつれてモデルの精度が向上する可能性があることを示しています。同様に、ピークの後、モデルは、この徐々に増加する精度と一致する、知覚的類似性スコアの漸進的な減少も示します。

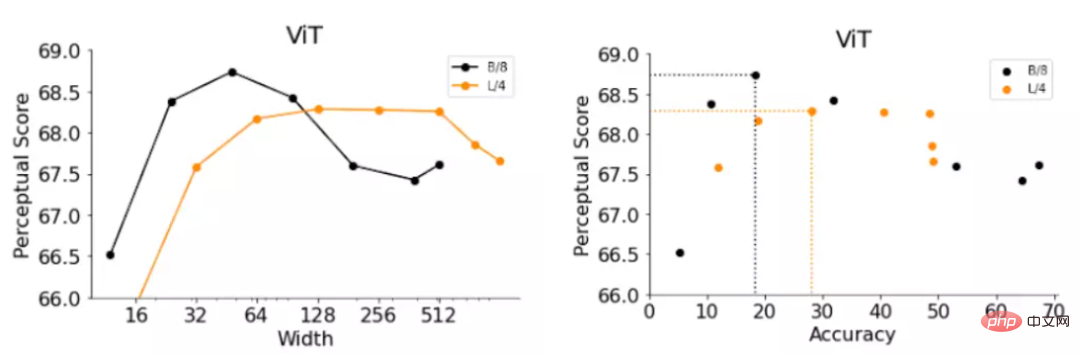

ViT は、入力画像に適用される Transformer ブロックのセットで構成されます。ViT モデルの幅は、単一の Transformer ブロックの出力ニューロンの数です。幅を増やすと効果的に改善できます。モデルの精度。

研究者らは、2 つのモデル B/8 (つまり、Base-ViT モデル、パッチ サイズは 4) と L/4 (つまり、Large -ViT モデル) を取得し、精度と知覚スコアを評価しました。

結果は、早期停止 ResNet で観察された結果と同様であり、精度が低く狭い ViT のパフォーマンスがデフォルトの幅よりも優れています。

ただし、ViT-B/8 と ViT-L/4 の最適な幅は、それぞれデフォルトの幅の 6% と 12% です。幅、深さ、トレーニング ステップ数、重み減衰、ラベル スムージング、ResNet と ViT にわたるドロップアウトなど、他のハイパーパラメーターに関する実験のより詳細なリストも提供されます。

したがって、知覚される類似性を改善したい場合、戦略は単純で、精度を適切に下げるだけです。

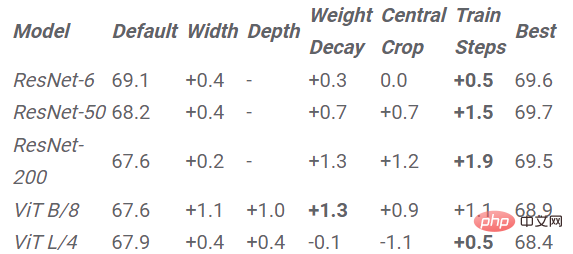

ImageNet モデルをスケールダウンすることで知覚スコアを改善します。表内の値は、スケーリングによって得られる値を表します。デフォルトのハイパーパラメータを使用したモデルでの改善 固定ハイパーパラメータを使用したモデルから得られた改善点

上記の結論に基づいて、この論文では、アーキテクチャの知覚スコアを改善するための簡単な戦略を提案しています。最適な知覚スコアが達成されるまで、モデルの精度を低下させます。

実験結果では、各ハイパーパラメータで各モデルをスケールダウンすることによって得られた知覚スコアの向上も確認できます。早期停止は、ViT-L/4 を除くすべてのアーキテクチャで最高のスコア向上をもたらし、時間のかかるグリッド検索を必要としない最も効果的な戦略です。

以前の研究では、知覚類似性関数は、画像空間次元にわたるユークリッド距離を使用して計算されました。

このアプローチはピクセル間の直接の対応を前提としていますが、この対応は湾曲した画像、平行移動した画像、または回転した画像には適用できない場合があります。

この記事では、研究者らは画像のグローバル表現に依存する 2 つの知覚関数、つまり 2 つの画像間のスタイルの類似性を捕捉するニューラル スタイル転送、スタイル損失関数と正規化関数を採用しました。平均プーリング距離関数。

スタイル損失関数は 2 つの画像間のチャネル間相互相関行列を比較し、平均プーリング関数は空間的に平均されたグローバル表現を比較します。

グローバル知覚関数は、デフォルトのハイパーパラメータを使用したネットワーク トレーニングとトレーニング エポックの関数としての ResNet-200 の両方の知覚スコアを一貫して向上させます。

また、精度と知覚評価の関係を説明するためにいくつかの仮説を調査し、追加の洞察を導き出します。

たとえば、一般的に使用されるスキップ接続を使用しないモデルの精度も知覚スコアに反比例し、出力に近いレイヤーは、出力に近いレイヤーと比較して平均して知覚スコアが低くなります。入力を行ってください。

歪み感度、ImageNet カテゴリの粒度、空間周波数感度についてもさらに調査しました。

つまり、この論文は、分類精度を向上させるとより良い知覚メトリクスが生成されるかどうかという問題を調査します。さまざまなハイパーパラメータの下で、ResNet と ViT の精度と知覚スコアの関係を研究し、知覚スコアが次のような関係があることを発見しました。精度は逆U字型の関係を示しており、精度と知覚スコアはある程度の相関関係があり、逆U字型の関係を示しています。

最後に、この記事では、スキップ接続、グローバル類似度関数、歪み感度、階層的知覚スコア、空間周波数感度、ImageNet カテゴリ粒度など、精度と知覚スコアの関係について詳しく説明します。

ImageNet の精度と知覚的類似性の間のトレードオフの正確な説明は依然として謎のままですが、この論文は前進する第一歩です。

以上が3つの概念を覆す! Google の最新調査: パフォーマンスの低いモデルで「類似性」を計算する方が正確ですか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。