マルチモーダル研究の重要な目標は、画像とテキストを理解するマシンの能力を向上させることです。特に、研究者は 2 つのモデル間で有意義なコミュニケーションを実現する方法について多大な努力を払ってきました。たとえば、画像キャプションの生成では、画像の意味内容を人間が理解できる一貫したテキストに変換できなければなりません。対照的に、テキスト画像生成モデルは、テキスト記述のセマンティクスを利用してリアルな画像を作成することもできます。

これは、セマンティクスに関連したいくつかの興味深い疑問につながります。特定の画像について、どのテキスト記述がその画像を最も正確に説明しているでしょうか?同様に、特定のテキストに対して、画像を実装する最も意味のある方法は何でしょうか?最初の質問に関して、いくつかの研究では、最適な画像の説明は自然であり、視覚的なコンテンツを復元できる情報であるべきだと主張しています。 2 番目の質問に関しては、意味のある画像は高品質で、多様性があり、テキストの内容に忠実である必要があります。

いずれにしても、人間のコミュニケーションによって推進される、テキスト-画像生成モデルおよび画像-テキスト生成モデルを含むインタラクティブなタスクは、最も正確な画像とテキストのペアを選択するのに役立ちます。

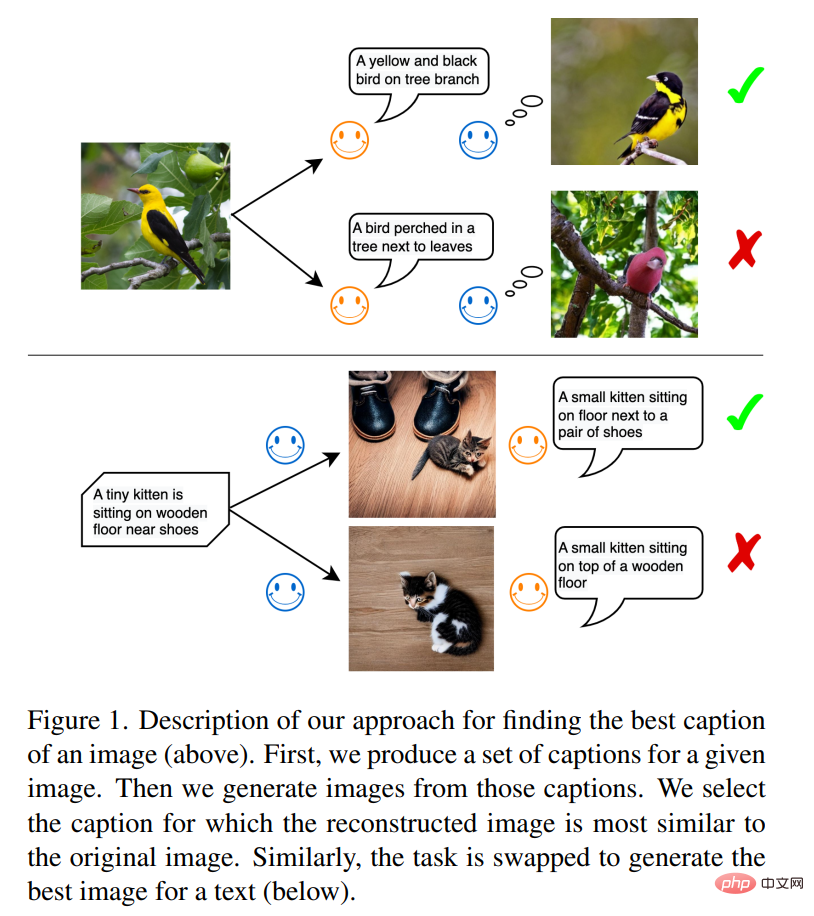

図 1 に示すように、最初のタスクでは、画像テキスト モデルが情報の送信者であり、テキスト画像モデルが情報の受信者です。送信者の目標は、自然言語を使用して画像の内容を受信者に伝え、受信者が言語を理解し、現実的な視覚表現を再構築できるようにすることです。受信機が元の画像情報を高い忠実度で再構築できれば、情報が正常に転送されたことになります。研究者らは、この方法で生成されたテキスト記述が最適であり、それによって生成された画像も元の画像に最も似ていると信じています。

このルールは、人々がコミュニケーションに使用する言語に基づいています。次のシナリオを想像してください。緊急通報の現場で、警察は電話を通じて交通事故と負傷者の状況を知りました。これには基本的に、現場の目撃者による画像説明のプロセスが含まれます。警察は適切な救助活動を組織するために、口頭での説明に基づいて環境現場を精神的に再構築する必要がある。明らかに、最良のテキストによる説明は、シーンを再構築するための最良のガイドとなるはずです。

2 番目のタスクにはテキストの再構築が含まれます。テキスト画像モデルがメッセージ送信者になり、画像テキスト モデルがメッセージ受信者になります。 2 つのモデルがテキスト レベルで情報の内容に同意すると、情報を伝えるために使用される画像媒体は、ソース テキストを再現する最適な画像になります。

この記事では、ミュンヘン大学、シーメンス、その他の機関の研究者によって提案された方法は、エージェント間のコミュニケーションに密接に関連しています。言語は、エージェント間で情報を交換するための主な方法です。しかし、最初のエージェントと 2 番目のエージェントが猫とは何か、犬とは何かについて同じ理解を持っているとどうやって確認できるのでしょうか?

論文アドレス: https://arxiv.org/pdf/2212.12249.pdf ##この記事で検討したいアイデアは、最初のエージェントに画像を分析させて画像を説明するテキストを生成させ、次に 2 番目のエージェントがテキストを取得して、それに基づいて画像をシミュレートするというものです。このうち、後者の処理が実施形態の処理といえる。この研究では、2 番目のエージェントによってシミュレートされた画像が最初のエージェントが受信した入力画像と類似している場合、コミュニケーションは成功すると考えられています (図 1 を参照)。

実験では、この研究では既製のモデル、特に最近開発された大規模な事前トレーニング済みモデルを使用しました。たとえば、Flamingo と BLIP は、画像に基づいてテキストの説明を自動的に生成できる画像説明モデルです。同様に、DALL-E モデルや潜在拡散モデル (SD) など、画像とテキストのペアでトレーニングされた画像生成モデルは、テキストの深い意味を理解し、高品質の画像を合成できます。

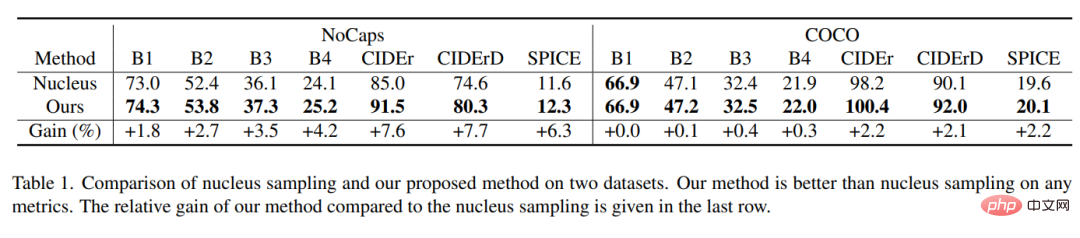

さらに、この調査では、CLIP モデルを利用して画像またはテキストを比較しました。 CLIP は、共有埋め込みスペースに画像とテキストをマッピングする視覚言語モデルです。この研究では、COCO や NoCaps などの手動で作成された画像テキスト データセットを使用して、生成されたテキストの品質を評価します。画像とテキストの生成モデルには、分布からのサンプリングを可能にする確率的コンポーネントがあり、候補となるテキストと画像の範囲から最適なものを選択します。画像記述モデルでは、カーネル サンプリングなどのさまざまなサンプリング方法を使用できます。この記事では、この記事で使用する方法の優位性を示すために、基本モデルとしてカーネル サンプリングを使用します。

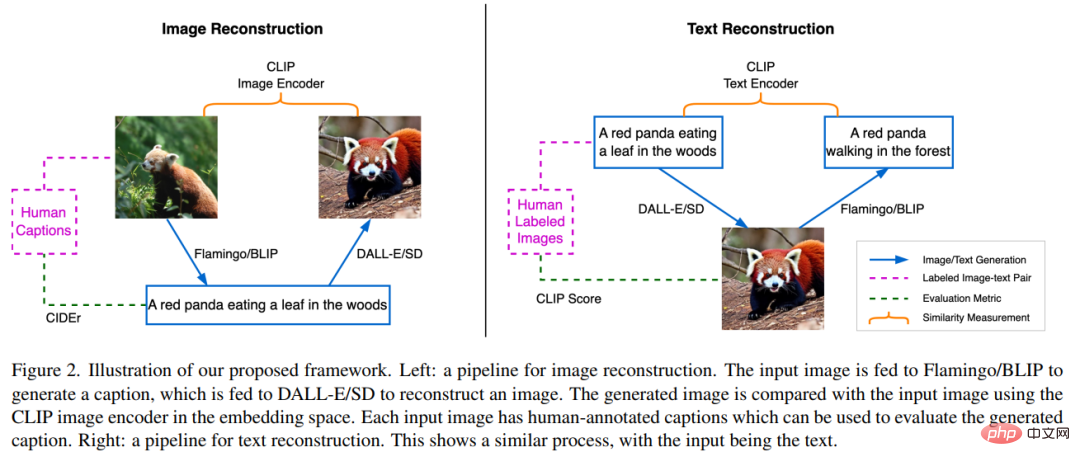

この記事のフレームワークは、3 つの事前トレーニング済み SOTA ニューラル ネットワークで構成されています。 1 つ目は画像テキスト生成モデル、2 つ目はテキスト画像生成モデル、3 つ目は画像エンコーダーとテキスト エンコーダーで構成されるマルチモーダル表現モデルで、画像またはテキストをそれぞれ意味的埋め込みにマッピングできます。

#テキスト説明による画像再構築

図 2 左半分このセクションでは、画像再構成タスクは、言語を指示として使用してソース画像を再構成することであり、このプロセスの実装により、ソース シーンを説明する最適なテキストが生成されます。まず、ソース画像 x が BLIP モデルに供給されて、複数の候補テキスト y_k が生成されます。たとえば、レッサーパンダは森の中で葉っぱを食べます。生成されたテキスト候補のセットは C で示され、テキスト y_k が SD モデルに送信されて画像 x’_k が生成されます。ここで、x’_k はレッサーパンダに基づいて生成された画像を指します。続いて、CLIP 画像エンコーダを使用して、ソースおよび生成された画像 ( および  ) から意味論的な特徴が抽出されます。

) から意味論的な特徴が抽出されます。

次に、候補テキスト記述 y_s を見つける目的で、これら 2 つの埋め込みベクトル間のコサイン類似度が計算されます。つまり

この研究では、CIDEr (画像記述メトリック) を使用し、人間の注釈を参照して最良のテキストを評価します。生成されるテキストの品質に興味があったため、この研究では、ほぼ同じ長さのテキストを出力するように BLIP モデルを設定しました。テキストの長さは伝達できる画像内の情報量と正の相関があるため、これにより比較的公平な比較が保証されます。この作業中、すべてのモデルはフリーズされ、微調整は実行されません。

#画像によるテキストの再構築

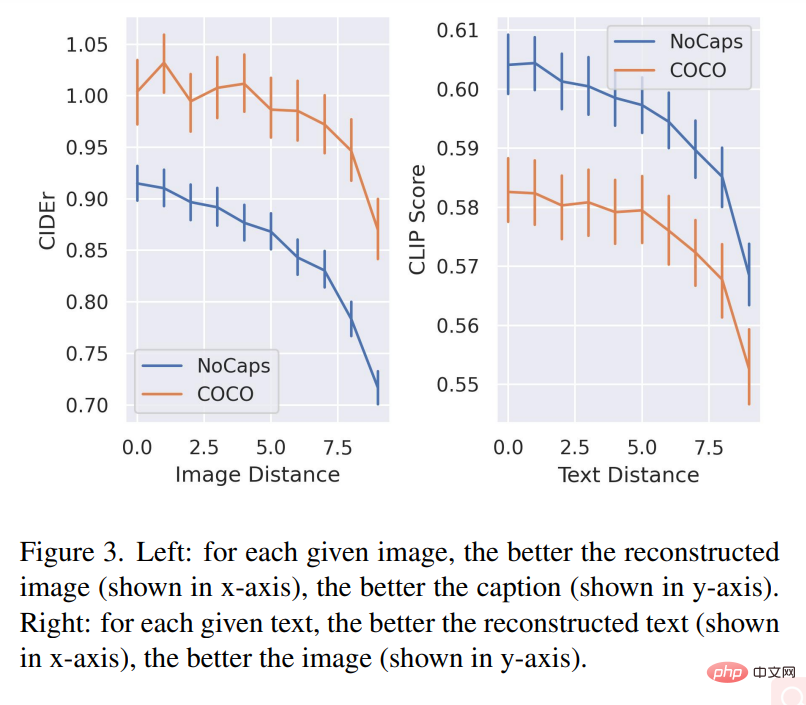

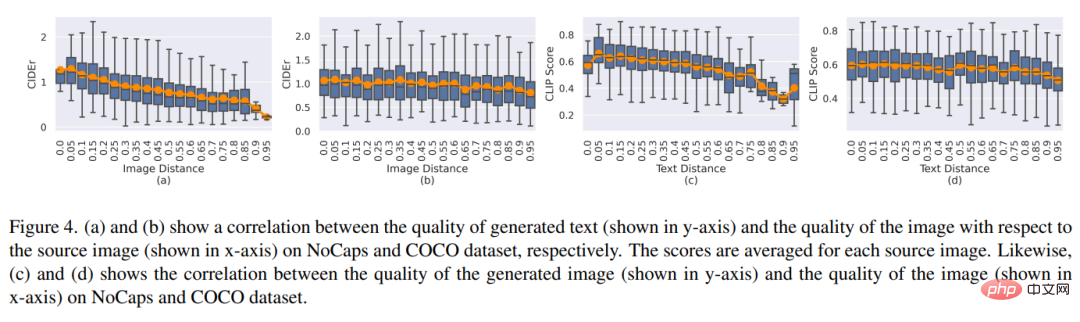

図 2 の右側は、前のセクションで説明したプロセスの逆を示しています。 BLIP モデルでは、SD によってガイドされたソース テキストを推測する必要があります。SD はテキストにアクセスできますが、そのコンテンツを画像の形式でレンダリングすることしかできません。このプロセスは、SD を使用してテキスト y の候補画像 x_k を生成することから始まり、結果として得られる候補画像のセットは K で示されます。 SD を使用した画像の生成にはランダム サンプリング プロセスが含まれ、各生成プロセスでは巨大なピクセル空間内で異なる有効な画像サンプルが生成される可能性があります。このサンプリングの多様性により、最良の画像をフィルタリングするための候補のプールが提供されます。次に、BLIP モデルは、サンプリングされた画像 x_k ごとにテキスト説明 y’_k を生成します。ここで、y’_k は最初のテキスト「森を這うレッサーパンダ」を指します。次に、この研究では、CLIP テキスト エンコーダを使用して、ソース テキストと生成されたテキストの特徴を抽出しました。これらは、それぞれ 研究では、画像 x_s は最小限の情報損失でコンテンツを受信者に配信できるため、テキスト説明 y を最もよく表現できると考えています。さらに、この研究では、テキスト y に対応する画像 図 3 の左のグラフは、2 つのデータセットにおける画像再構成の品質と説明テキストの品質の相関関係を示しています。特定の画像ごとに、再構成された画像の品質 (X 軸に表示) が向上するほど、テキスト記述の品質 (Y 軸に表示) も向上します。 図 3 の右のグラフは、復元されたテキストの品質と生成された画像の品質との関係を示しています。特定のテキストごとに、再構成されたテキストの説明 (x に表示) y 軸が良いほど)、画質も良くなります (y 軸に表示)。 # 図 4 (a) および (b) は、画像再構成品質と平均テキスト品質との関係を示しています。ソース画像上の関係。図 4(c) および (d) は、テキスト距離と再構成された画像品質の間の相関関係を示しています。

と

と  で表されます。このタスクの目的は、テキスト y のセマンティクスに一致する最適な候補画像 x_s を見つけることです。これを行うには、研究では生成されたテキストと入力テキストの間の距離を比較し、ペアになったテキストの間の距離が最も小さい画像、つまり

で表されます。このタスクの目的は、テキスト y のセマンティクスに一致する最適な候補画像 x_s を見つけることです。これを行うには、研究では生成されたテキストと入力テキストの間の距離を比較し、ペアになったテキストの間の距離が最も小さい画像、つまり

を y の参照プレゼンテーションとして扱い、最良の画像を参照画像への近さとして定量化します。

を y の参照プレゼンテーションとして扱い、最良の画像を参照画像への近さとして定量化します。 実験結果

# 図 5 は、2 つの再構成タスクの定性的な例を示しています。

# 図 5 は、2 つの再構成タスクの定性的な例を示しています。

以上がダルイーとフラミンゴは分かり合えるのか? 3 つの事前トレーニング済み SOTA ニューラル ネットワークが画像とテキストを統合の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。