最近、OpenAI が開発した AI チャットボット プログラムである ChatGPT が主要な AI コミュニティを席巻し、これに対するみんなの熱意は高まるばかりで、その可能性を活用し続けています。

一部の研究者は黙ってはいられず、ChatGPT と同等のオープンソース ソフトウェアを開発する方法を考え始めました。まだアクションを起こしていない方のために、今回は参考例として、以下で紹介するプロジェクト(PaLM RLHF)がそのような機能を実装しています。

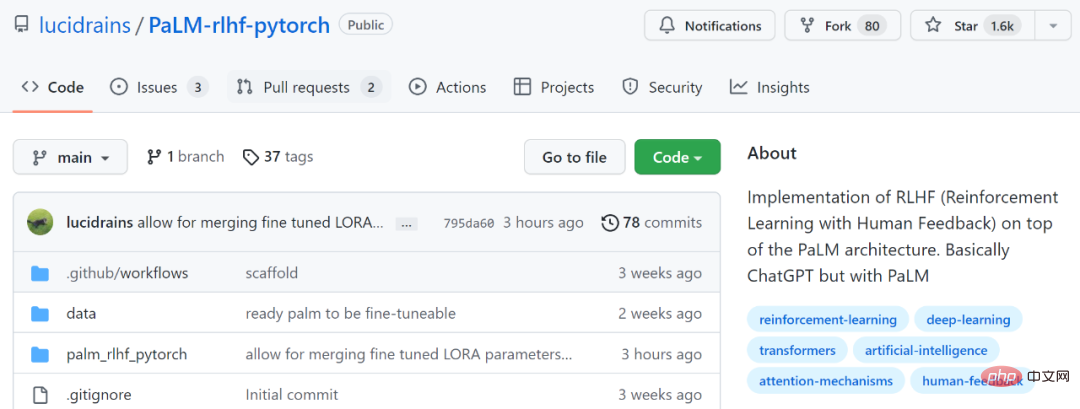

プロジェクトアドレス: https://github.com/lucidrains/PaLM-rlhf-pytorch

このプロジェクトは、RLHF (ヒューマンフィードバック強化学習) を実装します。基本的にChatGPTと同じですが、PaLMを使用する点が異なります。 PaLMは、Googleの汎用AIアーキテクチャ「Pathways」でトレーニングされた5,400億個のパラメータを備えた大規模な言語モデルです。 RLHF は、大規模言語モデル (LLM) が人間のコマンドを理解し、学習します。与えられたプロンプトに基づいて最適な答えを出します。

RLHF について詳しく知りたい場合は、https://huggingface.co/blog/rlhf

ネチズンが言っているように、「AI の分野では、常に特別なプロジェクト Breakthrough があり、開発者は間もなくオープン ソース バージョンを再生産する予定です。」

# ただし、このプロジェクトは現在のみです。トレーニング アーキテクチャとコードが含まれていますが、事前トレーニングされた重みはありません。使用説明書には、PaLM を最初にトレーニングする必要があることも示されています。

一部のネチズンもこれについて懸念を表明し、次のように述べています。シェルと同様に、トレーニングには高価なオーバーヘッドが必要ですが、Google のように PaLM をトレーニングできる組織はありません。

一部のネチズンは、「事前にトレーニングされた重みがないのは非常に悪い。公式はスパースな重みの少なくとも 50% を解放し、開発者にトレーニングさせる必要がある」と述べました。 ##################しかし、一部のネチズンは、それを試してみると言いました:################# # 見てみましょう このプロジェクトがどのように機能するかを見てみましょう。

インストール

$ pip install palm-rlhf-pytorch

import torch from palm_rlhf_pytorch import PaLM palm = PaLM( num_tokens = 20000, dim = 512, depth = 12 ).cuda() seq = torch.randint(0, 20000, (1, 2048)).cuda() loss = palm(seq, return_loss = True)loss.backward() # after much training, you can now generate sequences generated = palm.generate(2048) # (1, 2048)

報酬モデルは、厳選された人間のフィードバックを使用してトレーニングされます。元の論文では、事前学習済みの変換器から過剰適合せずに微調整された報酬モデルを取得することはできませんでした。プロジェクトの作成者は、微調整に LoRA を使用するオプションを提供しています。

import torch from palm_rlhf_pytorch import PaLM, RewardModel palm = PaLM( num_tokens = 20000, dim = 512, depth = 12, causal = False ) reward_model = RewardModel( palm, num_binned_output = 5 # say rating from 1 to 5 ).cuda() # mock data seq = torch.randint(0, 20000, (1, 1024)).cuda()prompt_mask = torch.zeros(1, 1024).bool().cuda() # which part of the sequence is prompt, which part is response labels = torch.randint(0, 5, (1,)).cuda() # train loss = reward_model(seq, prompt_mask = prompt_mask, labels = labels)loss.backward() # after much training reward = reward_model(seq, prompt_mask = prompt_mask)

以上が十分速い!人気の ChatGPT と同等のオープンソース プロジェクトが登場、ネット民: 実行できないのではないかと心配の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。