NLP 分野における大規模言語モデルの強力なパフォーマンスは驚くべきものですが、トレーニングに費用がかかりすぎて更新が難しいなど、それがもたらすマイナスのコストも深刻です。 、ロングテール知識に対処するのは困難です。

そして、言語モデルは通常、予測層に限られた語彙を含むソフトマックス層を使用します。これは基本的に珍しい単語やフレーズを出力しないため、モデルの表現能力が大幅に制限されます。

モデルのロングテール問題を解決するために、ワシントン大学、メタ AI、およびアレン人工知能研究所の学者らは最近、最初の「ノンパラメトリック マスク言語モデル」(ノンパラメトリック マスク言語モデル) を共同提案しました。モデル、NPM)、コーパス内の各フレーズのノンパラメトリック分布を参照することでソフトマックス出力を置き換えます。

論文リンク: https://arxiv.org/abs/2212.01349

コードリンク: https://github.com/facebookresearch/NPM

NPM は、完全なコーパスを取得する対比目的およびバッチ内近似によって効果的にトレーニングできます。

研究者らは、9 つのクローズド タスクと 7 つのオープン タスクに対してゼロショット評価を実施しました。これには、新しい事実や珍しいフレーズを予測する必要性を強調する時空間変換タスクや単語レベルの翻訳タスクが含まれます。

結果は、取得方法と生成方法が使用されるかどうかに関係なく、NPM がより大きなパラメーター モデルよりも大幅に優れていることを示しています。たとえば、500 倍のパラメーターを持つ GPT-3 や 37 倍のパフォーマンスを持つ OPT 13B の方がはるかに優れています。 NPM は、まれなパターン (単語の意味や事実) の処理と、まれな単語またはほとんど見られない単語 (非ラテン文字など) の予測に特に優れています。

この問題は、既存の検索と生成に関連する作業を組み合わせることで軽減できますが、これらのモデルの最終予測部分には依然としてソフトマックス層が必要です。トークンを予測するためのものですが、ロングテール問題の根本的な解決にはなりません。

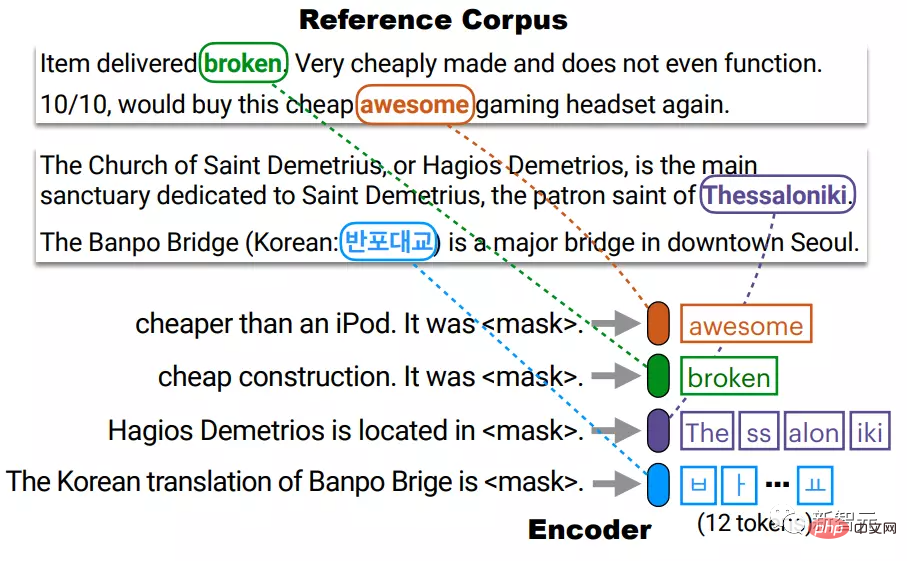

NPM はエンコーダーと参照コーパスで構成され、エンコーダーはテキストを固定サイズのベクトルにマッピングし、NPM はそこからフレーズを取得して [MASK] を埋めます。

ご覧のとおり、NPM は、出力として固定出力語彙ソフトマックスを使用する代わりに、フレーズで取得されたノンパラメトリック分布を選択します。

しかし、ノンパラメトリック モデルのトレーニングには 2 つの重要な問題も伴います:

1. トレーニング プロセス中に完全なコーパスを取得することは、非常に時間と労力がかかります。研究者は学習を使用して予測を行ってきました。デコーダなしで任意の長さのフレーズを検出することは困難であり、研究者らはスパン マスキングとフレーズ レベルの比較目標を拡張することでこの問題を解決しています。

つまり、NPM は出力語彙のソフトマックスを完全に削除し、任意の数の n グラムを予測することで効果的な無制限の出力空間を実現します。

結果として得られるモデルは、「非常に珍しい」単語、さらには「まったく見たことのない」単語 (韓国語など) を予測でき、既存のモデルでは実現できない無制限の語彙サイズを効果的にサポートできます。

NPM メソッド

純粋なエンコーダー (エンコーダーのみ) モデルは非常に競争力のある表現モデルですが、既存の純粋なエンコード モデルは未知の数のトークンで予測を行うことができないため、微調整なしでの使用は制限されています。

NPM は、[MASK] 内の任意の数のトークンを埋めるフレーズを取得することで、この問題を解決します。

推論エンコーダは、参照コーパス C 内のそれぞれの個別のフレーズを密なベクトル空間にマッピングします。

テスト時に、エンコーダーはマスクされたクエリを同じベクトル空間にマップし、C から取得したフレーズで [MASK] を埋めます。

ここで、C はトレーニング コーパスと同じである必要はなく、エンコーダーを再トレーニングすることなくテスト時に置き換えたり拡張したりできます。

実際には、コーパスには多数のフレーズがあり、それらすべてのインデックスを作成するとコストがかかります。

たとえば、最大でも l 個のトークン (l ≈ 20) を含むフレーズを考慮すると、l × |C| 個のベクトルのインデックスを作成する必要があり、時間がかかる可能性があります。

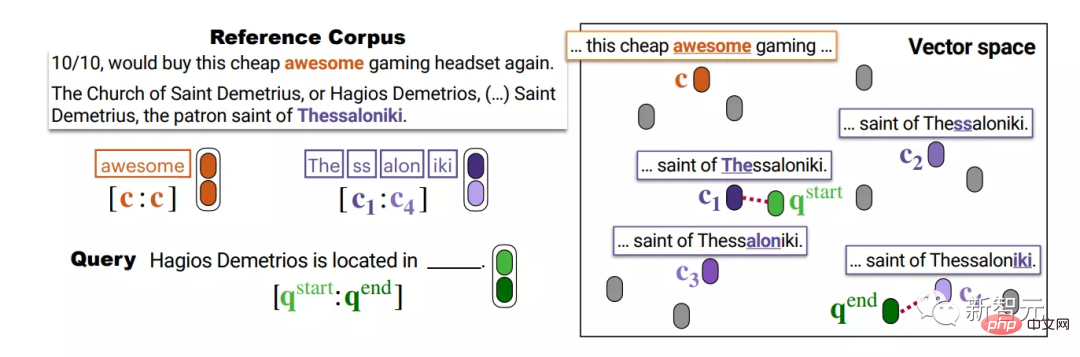

研究者らは、C でそれぞれの個別のトークンにインデックスを付け、インデックスのサイズを l×|C| から |C| に縮小しました。その後、テスト時に、非すべてのフレーズのパラメトリック分布は、最初と最後に個別に k 最近傍検索を実行することで近似されます。

研究者らは、C でそれぞれの個別のトークンにインデックスを付け、インデックスのサイズを l×|C| から |C| に縮小しました。その後、テスト時に、非すべてのフレーズのパラメトリック分布は、最初と最後に個別に k 最近傍検索を実行することで近似されます。

たとえば、4 つの BPE トークンで構成されるフレーズ Thessaloniki は、c1 と c4 の接続によって表され、それぞれフレーズの先頭 (The) と末尾 (iki) に対応します。

次に、同じベクトル空間内の 2 つのベクトル q_start と q_end を使用してクエリを表し、各ベクトルを使用して、集約する前に妥当なフレーズの開始と終了を取得します。

これを行う前提は、始まりと終わりの表現が十分に適切であること、つまり、q の開始点が c1 に十分近く、q の終了点が c4 に十分近いことです。 、そしてこれはトレーニングプロセス中に保証されています。

トレーニング

NPM はラベルのないテキスト データでトレーニングされ、エンコーダーがテキストを適切な密なベクトル空間にマッピングするようにします。

NPM のトレーニングには 2 つの主な問題があります: 1) コーパスを完全に取得するとトレーニングに非常に時間がかかります; 2) [MASK] にトークンの代わりに任意の長さのフレーズを入力します。

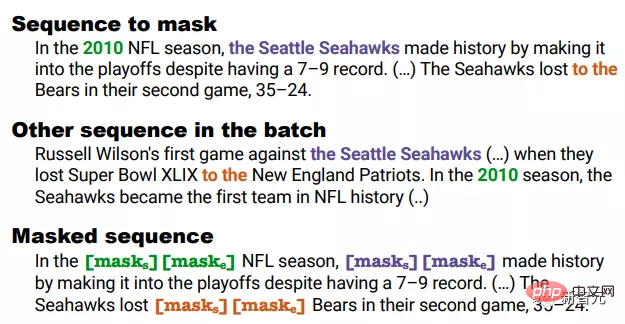

1. マスキング マスキング

スパン マスキングは、幾何学的分布からサンプリングされた長さの連続トークンをマスクします。

研究者らはこれをさらに詳しく説明しました:

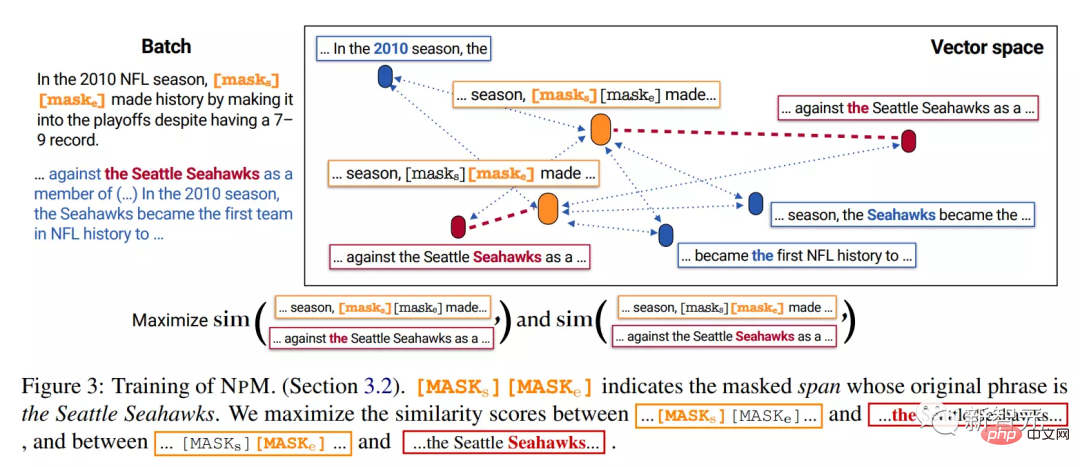

1) 一部のフラグメントがバッチ内の他のシーケンスで同時発生する場合、それらはトレーニング中にバッチ内で確実に存在するようにマスクされます。バッチ陽性)。

たとえば、ブロックされたクリップ 2010、シアトル シーホークス、およびすべてが別のシーケンスで同時発生します。

しかし、バイグラム「ゲーム」の場合、それらを一緒にマスクすることはできません。これらは 2 つのシーケンスにも現れますが、同時に発生することはありません。

2) フラグメント内の各トークンを [MASK] で置き換える代わりに、フラグメント全体を 2 つの特別なトークン [MASKs][MASKe] で置き換えます。

たとえば、上記の例では、マスクされたセグメントの長さに関係なく、[MASKs][MASKe]に置き換えられるため、各セグメントの開始ベクトルと終了ベクトルが取得でき、推論できます。もっと便利。

2. トレーニング ターゲット

マスクされたクリップがシアトル シーホークスであると仮定すると、テスト中にモデルは参照コーパス 「シアトル シーホークス」という語句は、 の他のシーケンスから取得されました。

推論段階では、モデルは [MASKs] と [MASKe] からベクトルを取得し、それらを使用してコーパスからフレーズの先頭と末尾をそれぞれ取得します。

したがって、トレーニング目標は、[MASK] のベクトルがシアトル シーホークスの に近づき、他のトークンから遠ざかるように促す必要があります。また、「in になる」など、いかなるフレーズでも the であってはいけません。初め。

これを行うには、完全なコーパスをバッチ内の他のシーケンスに近似するようにモデルをトレーニングします。具体的には、同じバッチ内の他のシーケンスからシアトル シーホークス セグメントの開始点を取得するようにモデルをトレーニングします。終点。

このマスク戦略により、マスクされた各スパンがバッチ内で共起セグメントを持つことが保証されることに注意してください。

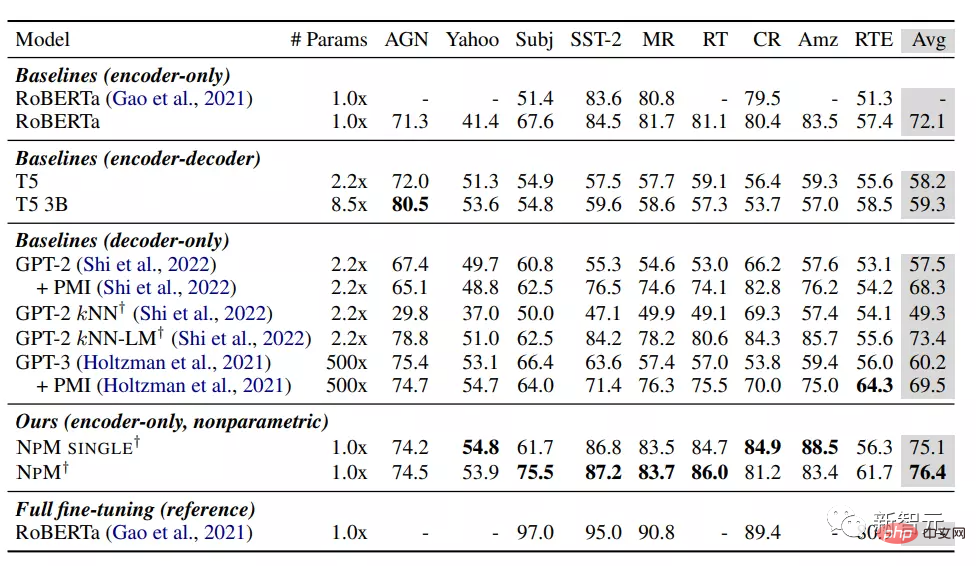

結果から、NPM はゼロショット設定の下で他のベースライン モデルよりも優れたパフォーマンスを発揮します。

パラメトリック モデルの中で、RoBERTa はおそらく純粋なエンコーダー モデルのため、GPT-3 を含むモデルを予想外に上回る最高のパフォーマンスを達成しました。双方向性が重要な役割を果たします。因果言語モデルは分類には適切な選択ではない可能性があることを示唆しています。

kNN-LM メソッドは、パラメトリック モデルにノンパラメトリック コンポーネントを追加し、そのパフォーマンスは他のすべてのベースラインよりも優れています。それにもかかわらず、検索 (kNN) のみに依存すると、GPT-2 ではパフォーマンスが低下し、推論時にのみ kNN を使用することの限界が示されます。

NPM SINGLE と NPM は両方ともすべてのベースラインを大幅に上回り、すべてのデータセットで一貫して優れたパフォーマンスを達成しました。これは、外部知識を明示的に必要としないタスクであっても、ノンパラメトリック モデルが非常に競争力があることを示しています。

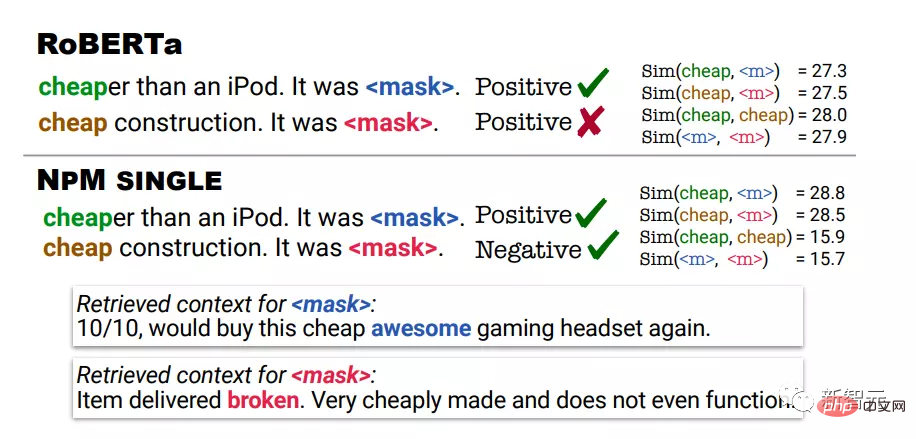

定性分析では、感情分析タスクで RoBERTa と NPM の予測結果を使用します。最初の例では、安いとは高価ではないことを意味し、2 番目の例では、安いとは品質が低いことを意味します。

両方の例に対する RoBERTa の予測は肯定的でしたが、NPM は入力予測と同じコンテキストで安価が使用されているコンテキストを取得することで正しい予測を行いました。

NPM によって出力された表現は、より適切な単語の意味の明確化をもたらすことができることもわかります。たとえば、RoBERTa は、安いものと安いものの間に高い類似性スコアを割り当てます。

一方、NPM は、安いものと安いものの間に低い類似性スコアを割り当てることに成功しました。これは、対照的な目的を使用したこのノンパラメトリック トレーニングが効果的であり、表現学習をより良く改善できることも示していますが、kNN 推論のこの種のアルゴリズムはトレーニングなしで行われます。全く不可能です。

参考: https://arxiv.org/abs/2212.01349

以上がMeta が最初の「ノンパラメトリック」マスク言語モデル NPM をリリース:パラメータ数の 500 倍で GPT-3 を上回るの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。