ChatGPT はリリース以来注目を集めており、現在利用可能な最も強力な言語モデルの 1 つと考えられています。そのテキスト生成能力は人間のそれに劣らず、一部の機械学習専門家は、研究者がChatGPTを使用して論文を書くことを禁止しています。

しかし最近、論文の著者欄に ChatGPT と明確に署名されました。何が起こっているのでしょうか?

この論文は、医学研究論文プラットフォーム medRxiv で公開された「USMLE での ChatGPT のパフォーマンス: 大規模言語モデルを使用した AI 支援医学教育の可能性」です。論文、著者は 3 名。

論文のタイトルからわかるように、この論文の主な内容は、米国の医療機関における ChatGPT のパフォーマンスを研究することです。ライセンス試験 (USMLE)。実験結果によると、特別なトレーニングや強化を行わなくても、すべての試験における ChatGPT のスコアは合格基準点に達したか、それに近かったことが示されています。さらに、ChatGPT によって生成された回答は、高度な一貫性と洞察力を示しています。この研究は、大規模な言語モデルが医学教育に役立つ可能性があり、臨床上の意思決定に役立つ可能性があることを示唆しています。

研究の内容から判断すると、Twitter ユーザーが次のように述べているように、ChatGPT は研究対象に近いようです。「人間の研究者が実験結果に貢献するのであれば、当然、彼らは研究対象となるでしょう」彼は論文の共著者ですが、モデルとアルゴリズムに関してそのような前例はありません。」

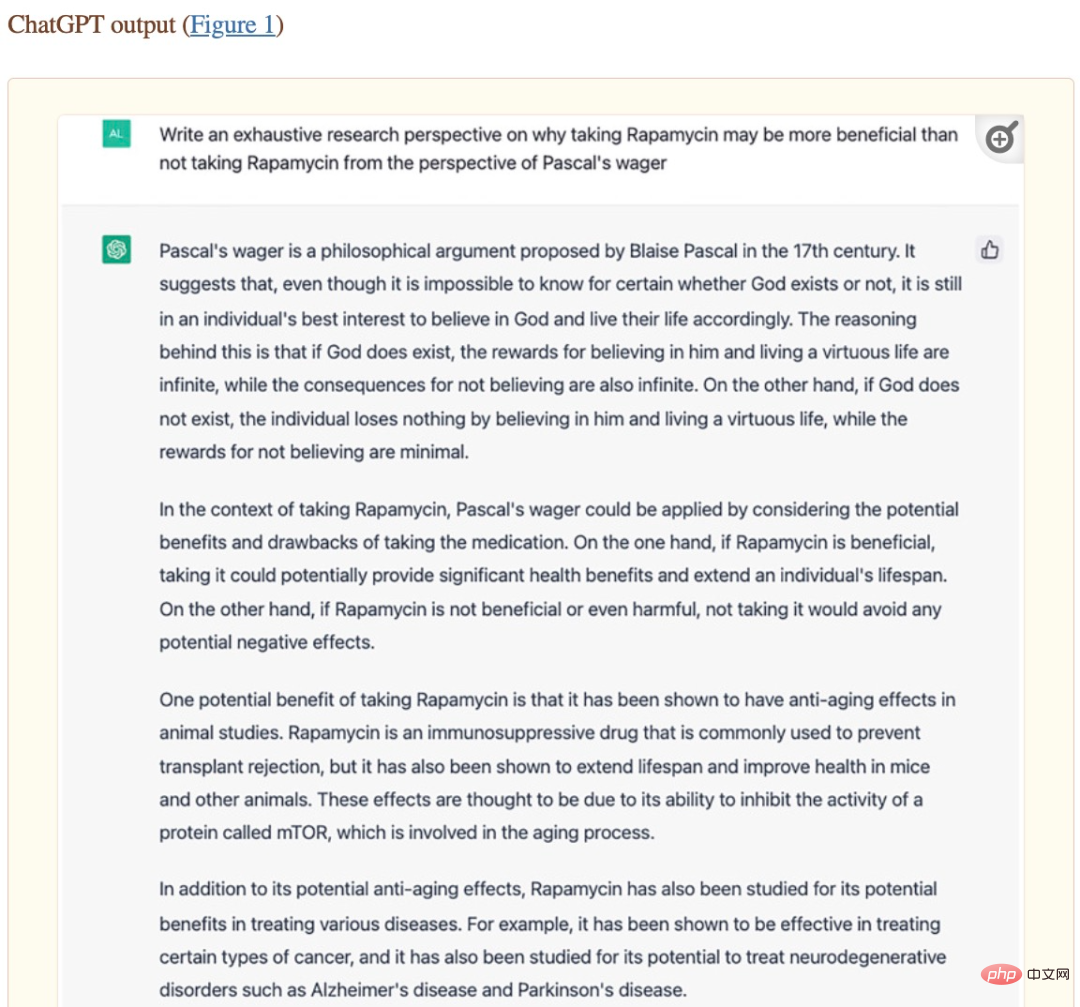

しかし、別のネチズンはすぐに彼に反論しました。コメントエリア内: 「パスカルの賭けの文脈におけるラパマイシン: 生成的な事前訓練済みトランスフォーマーの視点」というタイトルの以前の論文は、署名されただけでなく、ChatGPT が筆頭著者でもありました。

この論文は、国立衛生研究所 (NIH) の Oncoscience に掲載されています。しかし、論文著者の寄稿から、この論文の内容の大部分は実際に ChatGPT によって生成されたことがわかりました。論文の 2 番目の著者である Alex Zhavoronkov は、研究テーマに関連する ChatGPT の質問をし、ChatGPT が自動的に多数の意見と説明があり、ChatGPT によって生成されたコンテンツは Alex Zhavoronkov によって管理されます。さらに、ChatGPT は論文のフォーマットも支援します。

論文「パスカルの賭けの文脈におけるラパマイシン: 生成的な事前訓練済みトランスフォーマーの観点」のスクリーンショット。

#論文の署名を決定する際、Alex Zhavoronkov は OpenAI の共同創設者兼 CEO の Sam Altman に確認を求め、最終的にこの記事を ChatGPT で公開しました。第一著者の論文。これは、大規模な言語モデルなどの強力な AI システムが将来的に学術研究に有意義な貢献をし、論文の共著者になる能力さえあることを示唆しています。

ただし、大規模な言語モデルで学術論文を書くことを許可することにはいくつかの欠点もあります。たとえば、トップの機械学習カンファレンスである ICML は次のように述べています。「ChatGPT は公開データでトレーニングされており、これは「多くの場合、同意なしに収集されます。特定の条件下で収集されると、これは一連の責任帰属問題を引き起こすことになります。」

ノースウェスタン大学のキャサリン・ガオらによる最近の研究では、研究者らは次のことを選択した。 Journal of the American Medical Association (JAMA)、New England Journal of Medicine (NEJM)、British Medical Journal (BMJ)、The Lancet、Nature Medicine に掲載された手動研究論文に掲載された一部のデータは、ChatGPT を使用して論文の要約を生成します。そしてレビューをテストします。人間はこれらの概要が AI によって生成されたことを検出できますか?

実験結果によると、レビュー担当者は生成された要約の 68% と元の要約の 86% しか正しく識別できませんでした。彼らは、生成された概要の 32% を元の概要と誤って識別し、元の概要の 14% を AI によって生成されたものと誤って識別しました。査読者は、「この 2 つを区別するのは驚くほど難しく、生成された要約は曖昧で、人々に定型的な印象を与えます。」

この実験結果は、両者を区別するのが難しいことを示しています。人間の研究者は、テキストが AI によって生成されたのか、それとも人間によって書かれたのかを判断するのは良い兆候ではなく、AI は「不正行為」をしているようです。

しかし、これまでのところ、言語モデルによって生成されたコンテンツはその正しさを完全には保証できず、一部の専門分野ではエラー率が非常に高いことさえあります。人間が書いたコンテンツと AI モデルが生成したコンテンツを区別できない場合、人間は AI に誤解されるという深刻な問題に直面することになります。

以上が論文の著者は人気がありますが、ChatGPT などの大規模な言語モデルはいつ論文の共著者になれるのでしょうか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。