2017 年に提案されて以来、Transformer モデルは、自然言語処理やコンピューター ビジョンなどの他の分野で前例のない強みを示し、ChatGPT などの技術的ブレークスルーを引き起こしました。人々はまた、さまざまなオリジナル ベースのバリアントも提案してきました。モデル。

学術界と産業界が Transformer の注目メカニズムに基づいた新しいモデルを提案し続ける中、この方向性を要約することが難しい場合があります。最近、LinkedIn の AI 製品戦略責任者である Xavier Amatriain による包括的な記事が、この問題の解決に役立つ可能性があります。

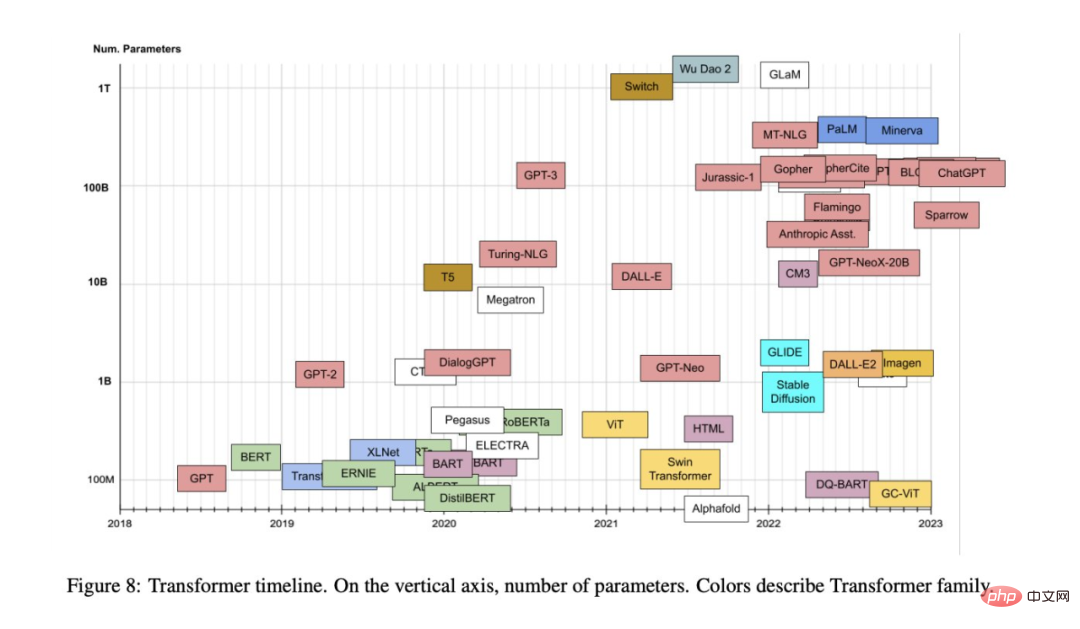

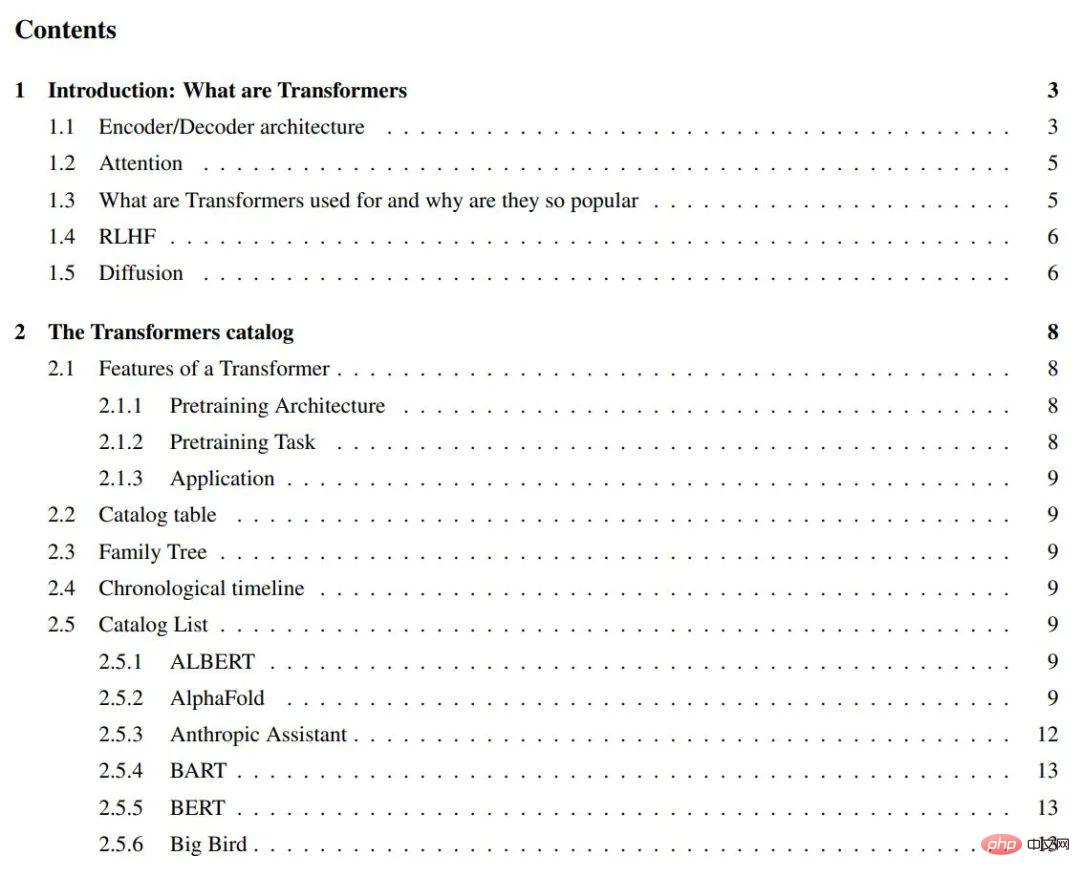

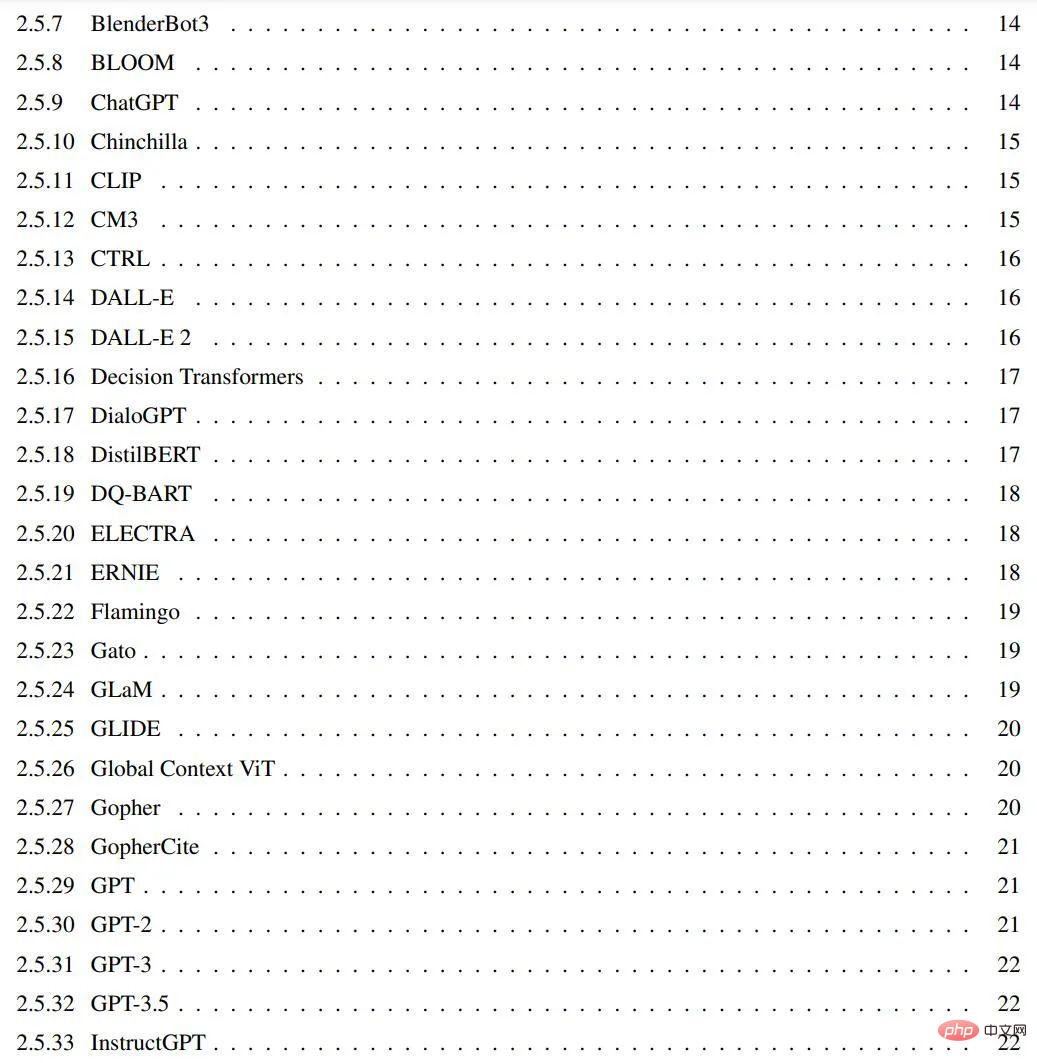

#ここ数年、次々とTransformer ファミリーには多数のモデルがあり、すべて興味深くわかりやすい名前が付けられています。この記事の目的は、最も人気のある Transformer モデルの包括的かつシンプルなカタログと分類を提供することです。さらに、この記事では、Transformer モデルの最も重要な側面と革新についても紹介します。

#論文「変圧器モデル: 概要とカタログ」:

##紙のリンク:

## https://arxiv.org/abs/2302.07730#GitHub: https://github.com/xamat/TransformerCatalog

はじめに: Transformer とは

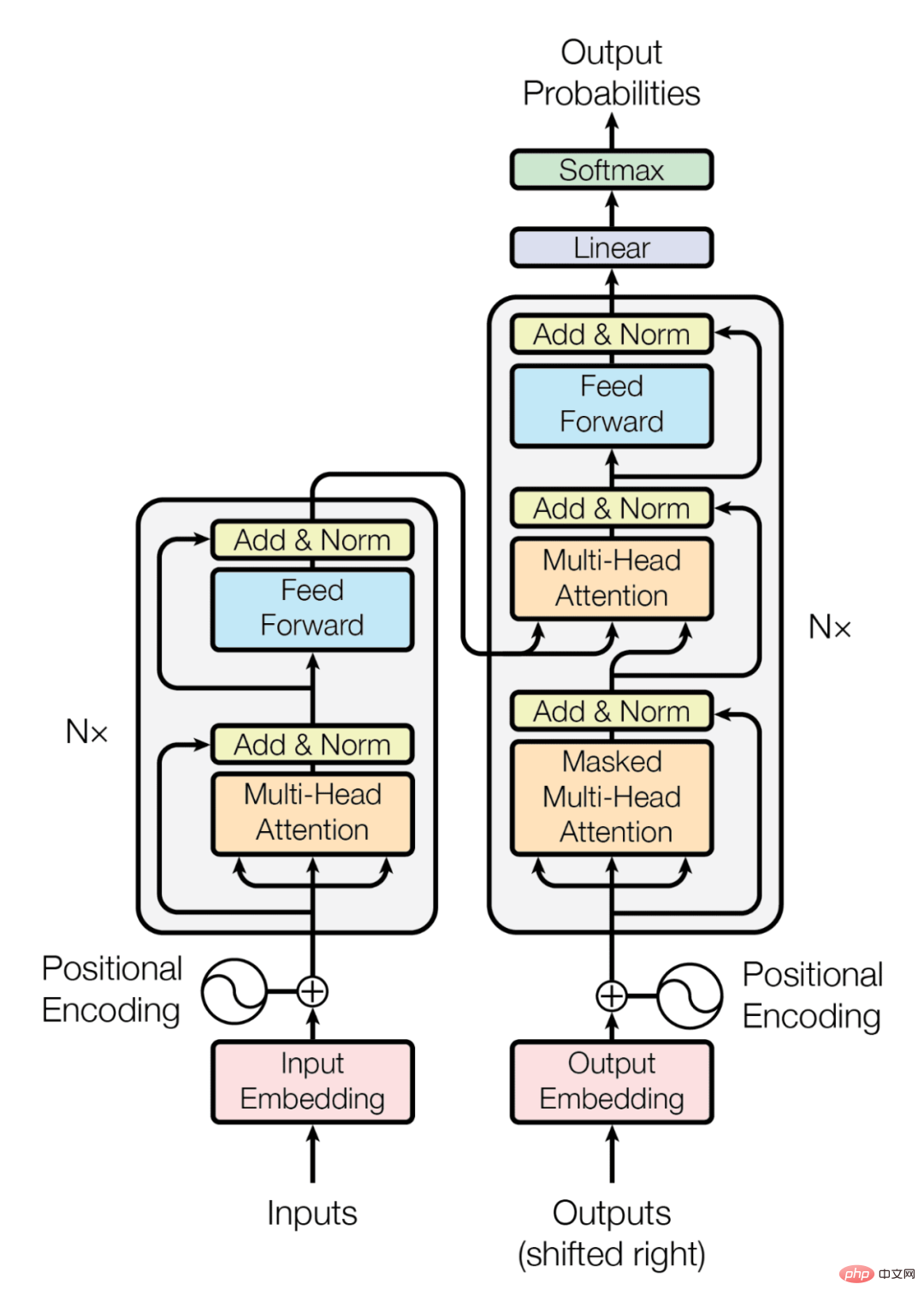

Transformer は、次のもので構成されるクラスです。アーキテクチャ上の特徴によって定義される深層学習モデル。最初に登場したのは、2017 年に Google 研究者によって発表された有名な論文「Attending is All you Need」(この論文はわずか 5 年間で 38,000 回以上引用されています)および関連するブログ投稿です。 Transformer アーキテクチャは、2 ~ 3 年前に普及したエンコーダ/デコーダ モデル [2] の特定のインスタンスです。しかし、それまでは、主に LSTM (Long Short-Term Memory) [3] やその他の RNN (Recurrent Neural Network) [4] の亜種に基づいたこれらのモデルで使用されるメカニズムの 1 つだけが注目されていました。 Transformers の論文の重要な洞察は、タイトルが示すように、入力と出力の間の依存関係を導き出す唯一のメカニズムとして注意を使用できるということです。 Transformer アーキテクチャの詳細をすべて説明することは、このブログの範囲を超えています。この目的のために、この記事では上記の元の論文またはトランスフォーマーの投稿を参照することをお勧めします。どちらも非常に興味深いものです。そうは言っても、この記事では最も重要な点について簡単に説明し、以下の目次にも記載します。この記事では、元の論文の基本的なアーキテクチャ図から始めて、関連する内容を展開していきます。エンコーダ/デコーダ アーキテクチャ

ユニバーサル エンコーダ/デコーダ アーキテクチャ (図 1 を参照) 2 つのモデルで構成されます。エンコーダーは入力を受け取り、それを固定長ベクトルにエンコードします。デコーダはこのベクトルを受け取り、出力シーケンスにデコードします。エンコーダーとデコーダーは、条件付き対数尤度を最小化するように共同でトレーニングされます。トレーニングが完了すると、エンコーダー/デコーダーは入力シーケンスを指定して出力を生成したり、入力/出力シーケンスをスコアリングしたりできます。オリジナルの Transformer アーキテクチャでは、エンコーダーとデコーダーの両方に 6 つの同一のレイヤーがありました。これら 6 つのレイヤーの各エンコーダーには、マルチヘッド アテンション レイヤーと単純なフィードフォワード ネットワークという 2 つのサブレイヤーがあります。各サブレイヤーには残留接続とレイヤー正規化があります。エンコーダーの出力サイズは 512 です。デコーダは、エンコーダ出力上の別のマルチヘッド アテンション レイヤである 3 番目のサブレイヤを追加します。さらに、デコーダ内の別のマルチヘッド層がマスクされます。

#図 2: アテンションのメカニズム

##アテンション

上記の説明から、モデル アーキテクチャの唯一の特別な要素はマルチヘッド アテンションであることは明らかですが、前述したように、ここにモデルの最大の力があります。では、注意とは具体的に何でしょうか?アテンション関数は、クエリと一連のキーと値のペア間の出力へのマッピングです。出力は値の重み付き合計として計算されます。各値に割り当てられた重みは、対応するキーとのクエリの互換性関数によって計算されます。トランスフォーマーは、スケーリングされたドット積アテンションと呼ばれる特定のアテンション関数の並列計算であるマルチヘッド アテンションを使用します。アテンション メカニズムがどのように機能するかについて詳しくは、この記事でも「The Illustrated Transformer」の記事を参照し、主な概念を理解するために元の論文の図を図 2 に再掲します。アテンション層には、リカレント ネットワークや畳み込みネットワークに比べていくつかの利点があります。最も重要な 2 つは、計算の複雑さが低いことと接続性が高いことであり、シーケンス内の長期的な依存関係を学習するのに特に役立ちます。

Transformer の用途と人気の理由

元の Transformer は言語翻訳用に設計されました。特に英語からドイツ語まで。ただし、元の研究論文からわかるように、このアーキテクチャは他の言語タスクにもよく一般化します。この特定の傾向はすぐに研究コミュニティの注目を集めました。その後の数か月間で、ほとんどの言語関連の ML タスクのランキングは、Transformer アーキテクチャの一部のバージョンによって完全に独占されました (たとえば、有名な SQUAD ランキングでは、すべての上位モデルが Transformer のコレクションになっています)。 Transformers がほとんどの NLP ランキングを急速に独占した主な理由の 1 つは、トランスフォーマーが他のタスクに素早く適応する能力 (別名転移学習) です。事前トレーニング済みの Transformer モデルは、トレーニングされていないタスクに非常に簡単かつ迅速に適応させることができ、これには大きな利点があります。 ML 実践者は、巨大なデータセットで大規模なモデルをトレーニングする必要がなくなりました。必要なのは、事前トレーニングされたモデルをタスクで再利用することだけです。場合によっては、はるかに小さいデータセットを使用してわずかに調整するだけです。事前トレーニングされたモデルをさまざまなタスクに適応させるために使用される特定の手法の 1 つは、微調整と呼ばれます。トランスフォーマーは他のタスクにも適応できることが証明されたため、元々は言語関連のタスク用に開発されましたが、ビジュアル、オーディオ、音楽アプリケーションに至るまで、他のタスクにもすぐに採用されました。チェスをしたり、数学をしたりする方法。

もちろん、誰でも簡単に数行のコードを記述できる無数のツールがなければ、これらのアプリケーションはいずれも実現できません。 Transformer は、主要な人工知能フレームワーク (Pytorch8 や TF9 など) に迅速に統合できるだけでなく、企業全体をこれに基づいて構築することもできます。これまでに 6,000 万ドル以上を調達したスタートアップ企業、Huggingface は、オープンソースの Transformer ライブラリを商用化するというアイデアをほぼ全面的に中心に構築されました。

最後に、人気の初期段階における Transformer に対する GPT-3 の影響について話す必要があります。 GPT-3 は、2020 年 5 月に OpenAI によって発売された Transformer モデルであり、以前の GPT および GPT-2 のフォローアップです。同社はこのモデルをプレプリントで紹介することで多くの話題を呼びましたが、そのモデルは非常に強力であるため世界にリリースできないと主張していました。それ以来、このモデルはリリースされただけでなく、OpenAI と Microsoft との大規模なコラボレーションを通じて商品化されました。 GPT-3 は 300 以上の異なるアプリケーションをサポートしており、OpenAI のビジネス戦略の基礎となっています (これは 10 億ドルを超える資金を調達した企業にとって当然のことです)。

RLHF

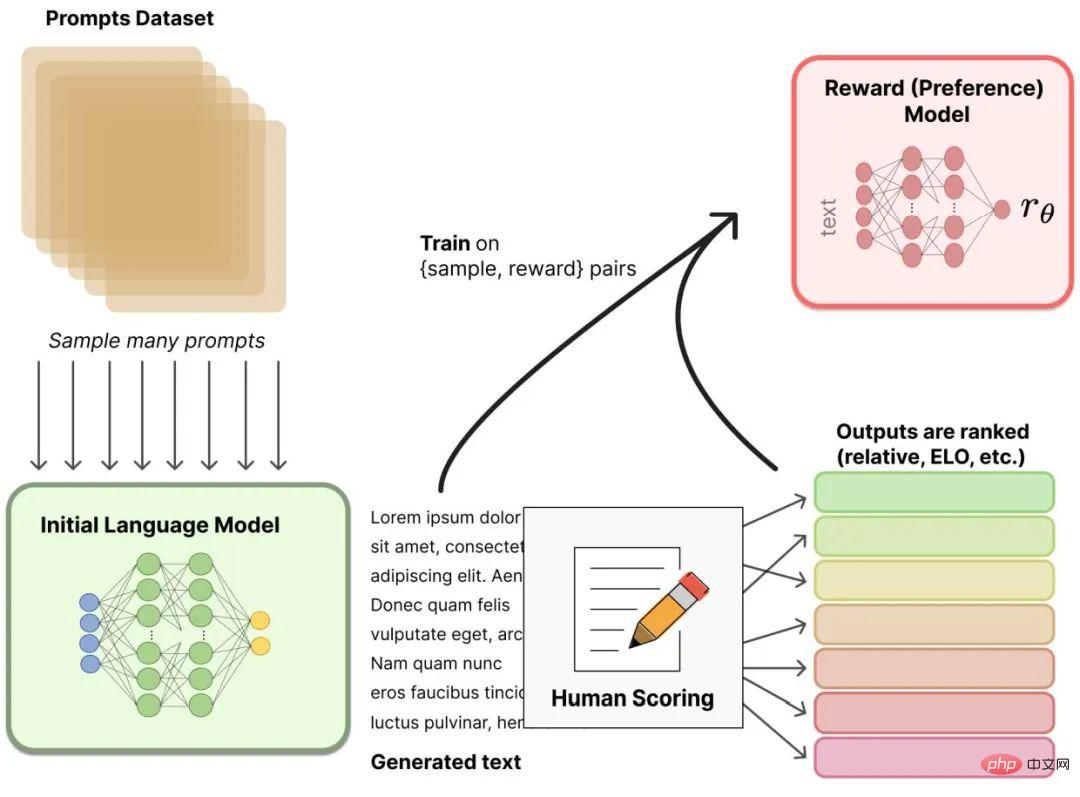

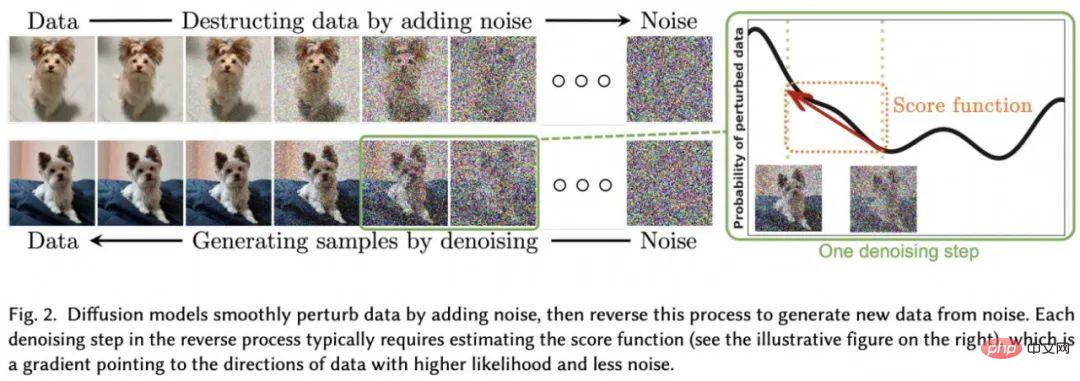

最近、人間のフィードバック (または好み) からの強化学習 (RLHF (RLHP とも呼ばれる)) ) は、人工知能ツールキットへの大きな追加となっています。この概念は、2017 年の論文「人間の好みからの深層強化学習」ですでに提案されています。さらに最近では、ChatGPT や、BlenderBot や Sparrow などの同様の会話型エージェントに適用されています。アイデアは単純です: 言語モデルが事前にトレーニングされると、ユーザーは会話に対してさまざまな応答を生成し、その結果を人間がランク付けできます。強化学習環境でこれらのランキング (別名好みまたはフィードバック) を使用して、報酬をトレーニングできます (図 3 を参照) )。###############拡散#########拡散モデルは画像生成における新しい SOTA となり、明らかに GAN (敵対的生成ネットワーク) などの以前の方法を押しのけています。普及モデルとは何ですか?これらは、変分推論でトレーニングされた潜在変数モデルのクラスです。この方法でトレーニングされたネットワークは、実際にこれらの画像によって表される潜在空間を学習します (図 4 を参照)。

拡散モデルは、有名な [敵対的生成ネットワーク (GAN)] 16 などの他の生成モデルに関連しており、多くのアプリケーション、特に (ノイズ除去) オートエンコーダーで置き換えられています。著者の中には、拡散モデルはオートエンコーダの特定のインスタンスにすぎないとさえ言う人もいます。しかし、彼らはまた、小さな違いによって、その応用がオートコンダーの基礎的な表現から拡散モデルの純粋に生成的な性質に変わることも認めています。

# 図 3: 人間のフィードバックによる強化学習。

図 4: 「拡散モデル」から抜粋した確率的拡散モデルのアーキテクチャ" : メソッドとアプリケーションの包括的な調査》

この記事で紹介されているモデルは次のとおりです:

以上が5 年間で 38,000 回引用され、トランスフォーマー ユニバースはこのように発展しましたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。