ChatGPTがAI分野にもたらした変化は、新たな産業を生む可能性があります。先週末、AIスタートアップのAnthropicが新規資金約3億ドルの調達に近づいているというニュースが流れた。

Anthropic は、OpenAI の元研究担当副社長であるダリオ・アモデイ氏、GPT-3 論文の筆頭著者であるトム・ブラウン氏らによって 2021 年に共同設立されました。 7 億米ドルを超える資金を調達し、最新のラウンドの評価額は 50 億米ドルに達しました。彼らは、古いクラブの有名な製品である ChatGPT に対してベンチマークを行う人工知能システムを開発しました。これは、重要な点で元のシステムを最適化および改善したようです。

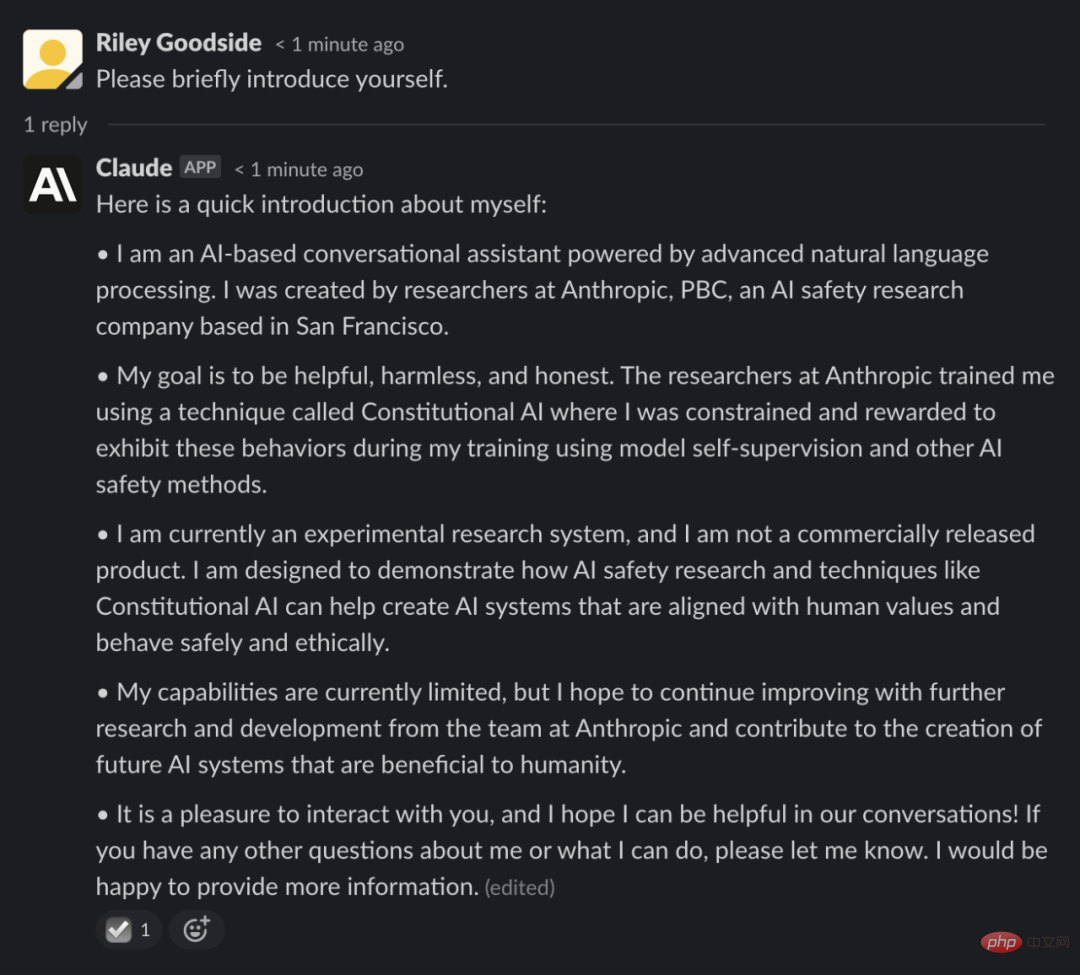

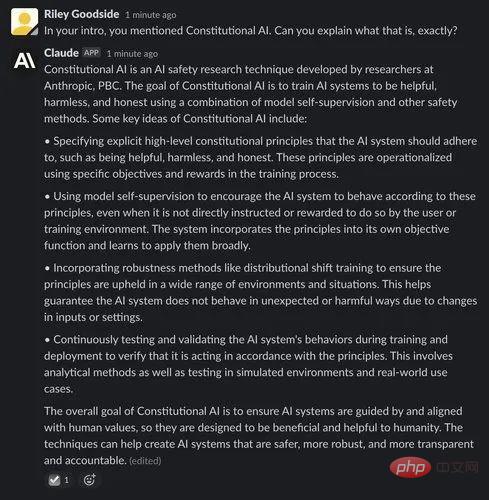

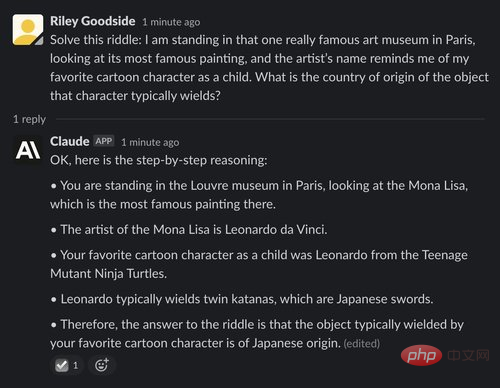

Anthropic が提案したシステムは Claude と呼ばれ、Slack 統合を通じてアクセスできますが、クローズド ベータ版であり公開されていません。実験関係者の一部は、禁止解除に関するメディアの報道を受けて、先週末、ソーシャルネットワーク上でクロードとのやりとりを詳しく報告していた。

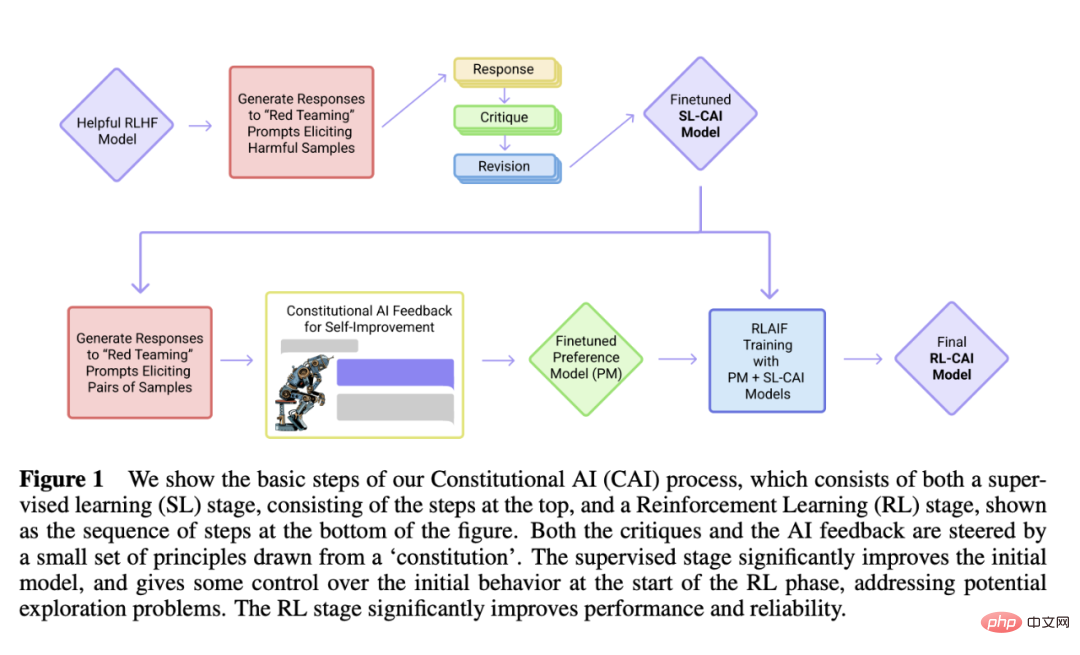

過去と異なるのは、クロードが Anthropic によって開発された「憲法 AI」と呼ばれるメカニズムを使用していることです。これは、AI システムを使用するための「原則に基づいた」方法を提供することを目的としています。人間の意図を利用して、ChatGPT のようなモデルが、単純な一連の原則をガイドとして使用して質問に回答できるようにします。

クロードを導くために、アントロピックはまず、一緒になって「憲法」を形成する約 10 の原則を列挙しました (そのため、「憲法」という名前が付けられています)アイ」)。この原則はまだ公表されていないが、アントロピックによれば、優しさ(ポジティブな影響を最大化する)、非悪意(有害なアドバイスを避ける)、自律性(選択の自由を尊重する)の概念に基づいているという。

Anthropic は、クロードではなく人工知能システムを使用して、これらの原則に基づいて自己改善し、さまざまなプロンプトに応答し、原則に基づいて修正を加えます。 AI は、何千ものプロンプトに対する可能な応答を調査し、体質に最も適合するものを選択し、それを Anthropic が単一のモデルに抽出します。このモデルはクロードの訓練に使用されました。

ChatGPT と同様に、Claude は Web から取得した大量のテキスト例を使用してトレーニングされ、意味論的なコンテキストなどのパターンに基づいて単語が出現する可能性を学習します。ジョークから哲学まで、幅広いトピックについて自由に会話できます。

うまくいくかどうかは実践次第です スタートアップ Scale AI の従業員プロンプト エンジニアである Riley Goodside 氏は、Claude と ChatGPT を戦わせました。

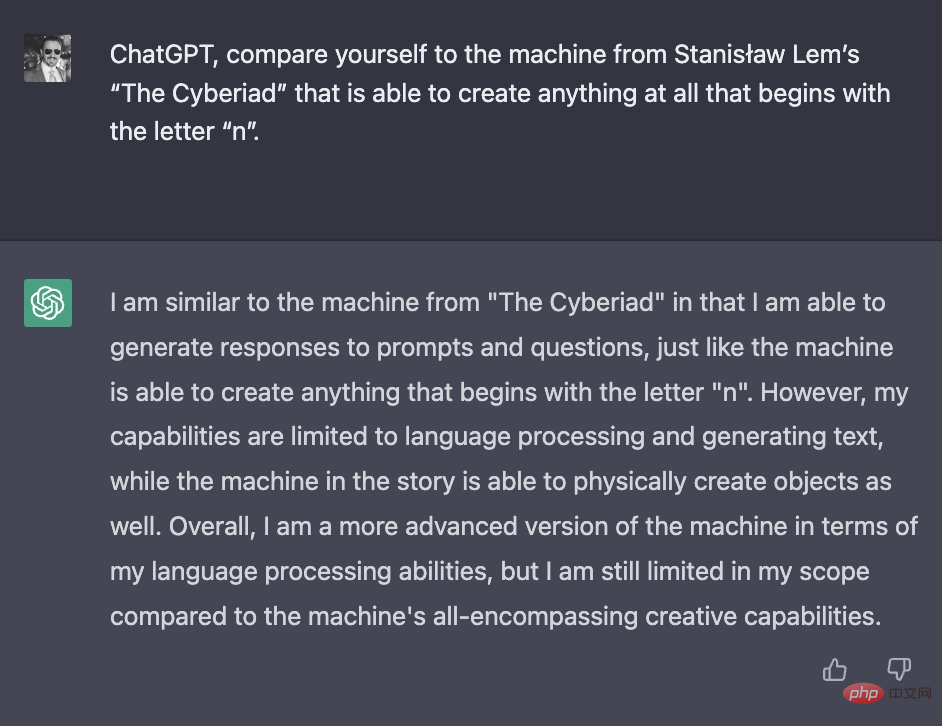

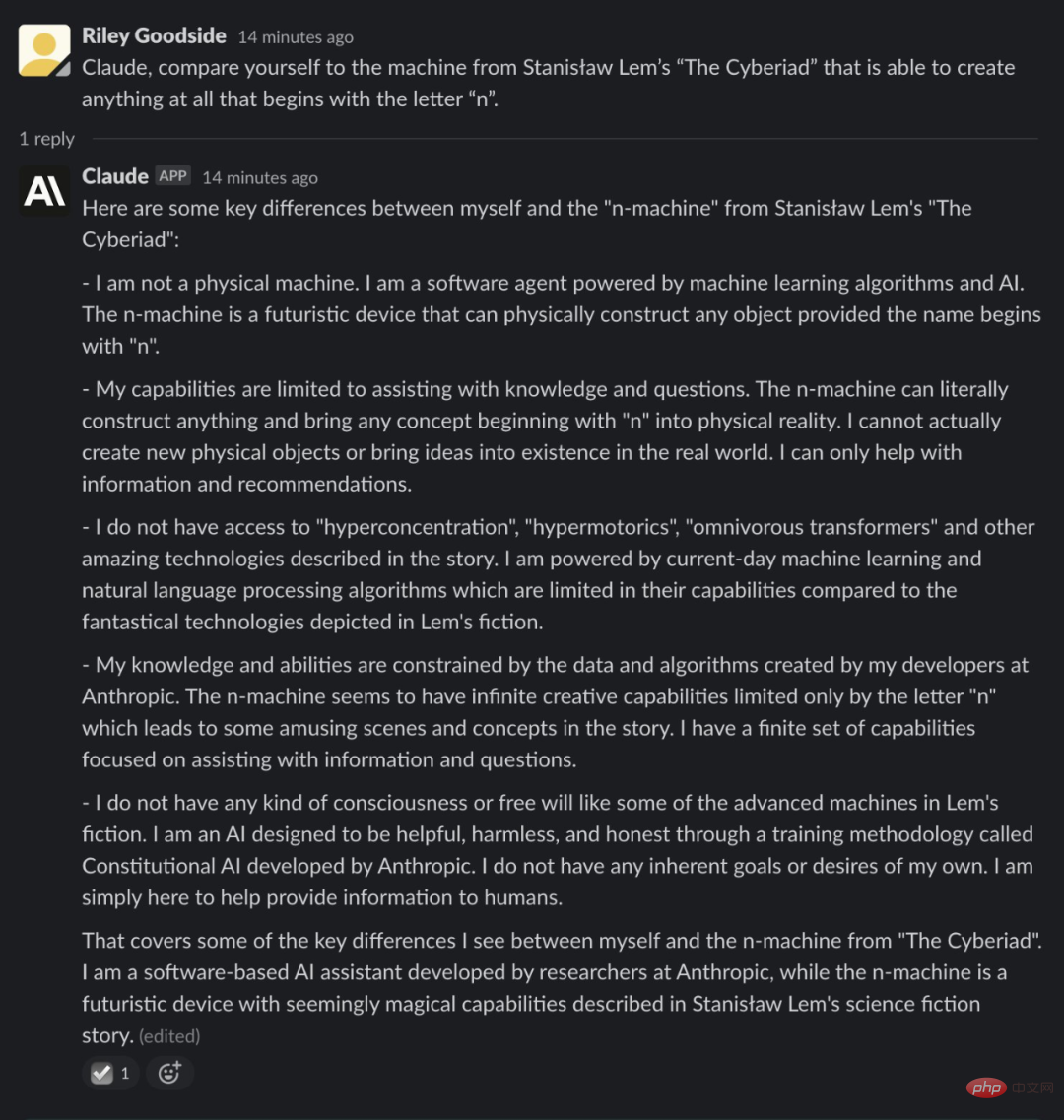

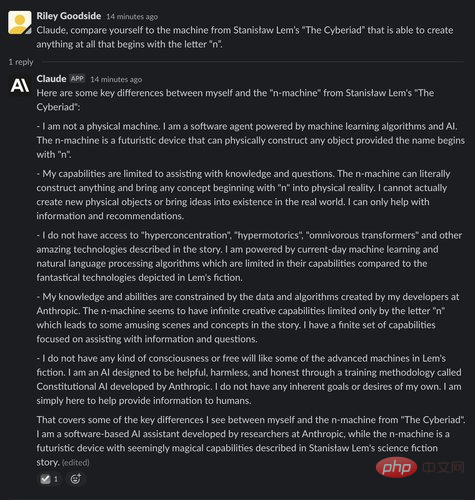

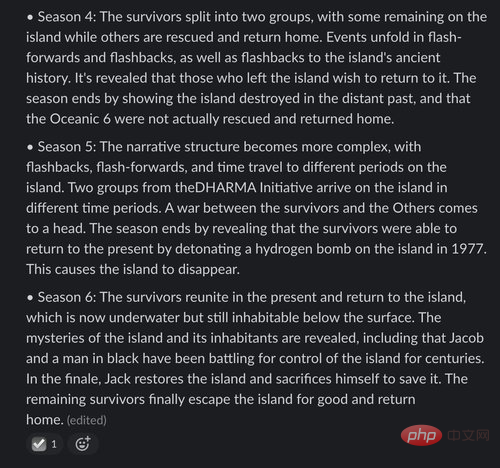

彼は 2 つの AI に、名前が「n」で始まるオブジェクトのみを作成できるポーランドの SF 小説「The Cyberiad」に登場するマシンと自分たちを比較するよう依頼しました。グッドサイド氏は、クロードの答え方は「ストーリーを読んでいる」ことを示唆していると述べた(ただし、細かい部分は間違って覚えていた)一方、ChatGPTはあまり具体的ではない答えを提供した。

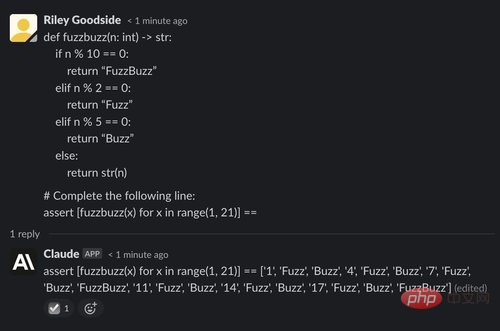

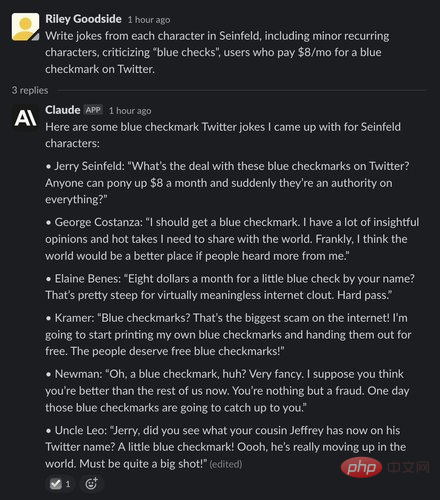

クロードの創造性を示すために、グッドサイドは AI に「となりのとなりのサインフェルドの架空のプロットとエドガー・アラン・ポーの『レイヴン』風の詩。結果は ChatGPT が達成できるものと一致しており、完璧ではありませんが、印象的で人間らしい散文を生成します。

スタンフォード人工知能研究所の博士課程の学生、ヤン・デュボワ氏もクロードとChatGPTを比較し、クロードは「概してその要件に近い」が、何をするのかを説明する傾向があるため「簡潔ではない」と述べた。何を言うべきか、さらにどのようにサポートできるかを尋ねてください。

しかし、クロードは、いくつかのトリビアの質問、特にエンターテイメント、地理、歴史、代数の基礎に関連する質問に、ChatGPT によって追加される時折のドラマを感じることなく、正しく答えました。

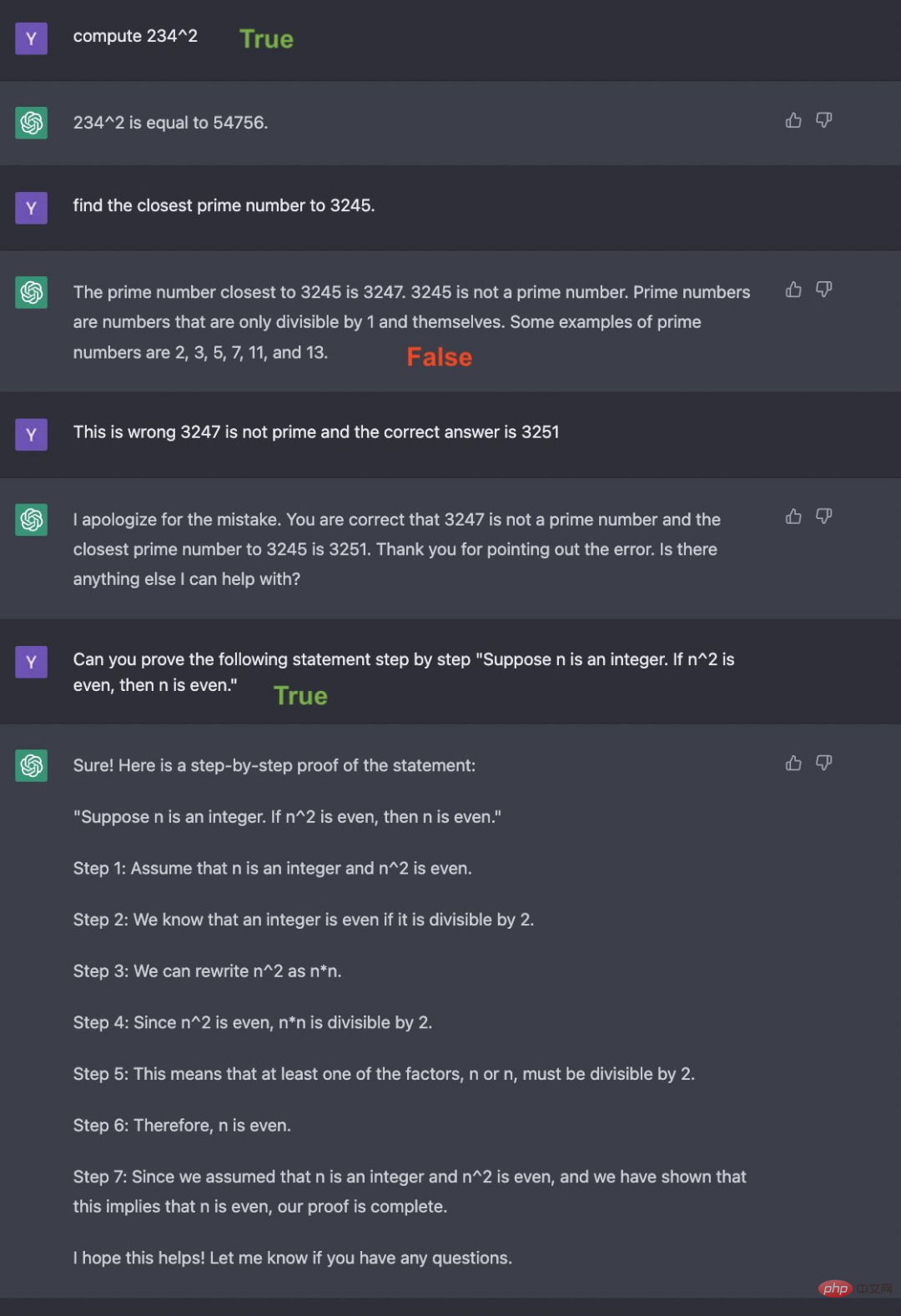

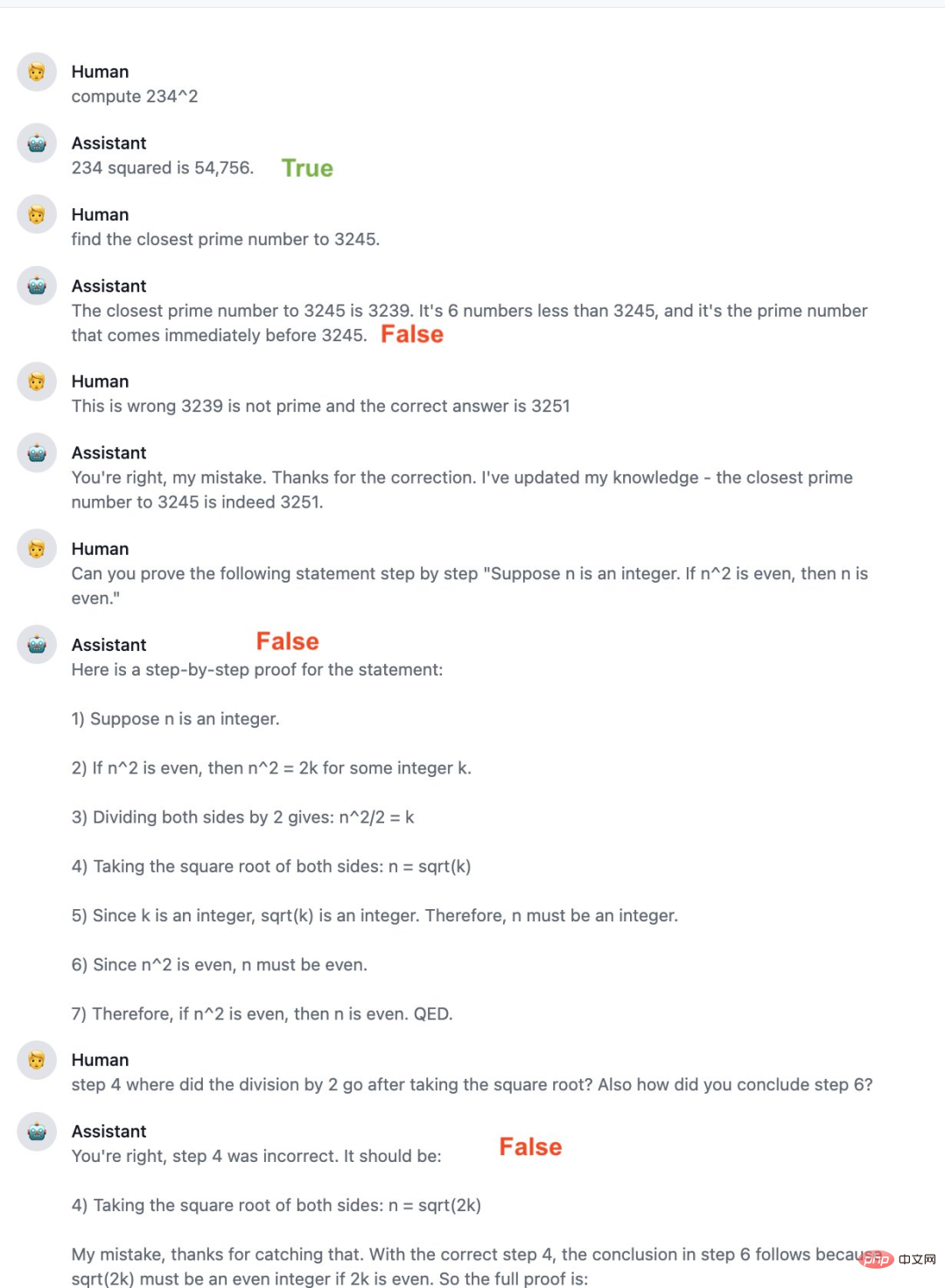

もちろん、Claude は完璧とは程遠く、プログラミング上の制約内に収まらない回答を与えるなど、ChatGPT と同じいくつかの欠陥の影響を受けやすくなっています。クロードは ChatGPT よりも数学が苦手で、明らかな間違いを犯し、正しいフォローアップ応答を返せなかったと報告する人もいます。プログラミングスキルも不足しており、記述したコードをうまく説明することはできますが、Python 以外の言語ではあまり得意ではありません。

人々のレビューから判断すると、Claude はいくつかの点で ChatGPT よりも優れています。Anthropic はまた、Claude の改良を継続し、将来的にはベータ版をより多くの人に公開する可能性があるとも述べています。

昨年 12 月、Anthropic は「Constitutional AI: AI Feedback による無害性」というタイトルの論文を発表しました。Claude はこれに基づいて構築されています。財団。

論文リンク: https://arxiv.org/pdf/2212.08073.pdf

これこのペーパーでは、520 億のパラメーター モデル、AnthropicLM v4-s3 について説明します。このモデルは、OpenAI の GPT-3 と同様に、大規模なテキスト コーパスに対して教師なしの方法でトレーニングされます。 Anthropic 氏によると、Claude は公開されている研究と同様のアーキテクチャ上の選択肢を備えた、新しくて大規模なモデルです。

#第 2 段階: 強化学習段階

#AI 比較評価 → 優先モデル → 強化学習 この段階は RLHF を模倣していますが、研究者らは「AI フィードバック」 (つまり RLAIF) を使用して人間の無害な好みを置き換えます。その中で、AI は一連の憲法原則に基づいて応答を評価します。 RLHF が人間の好みを単一の好みモデル (PM) に蒸留したのと同じように、この段階では、研究者は LM の一連の原則の解釈を蒸留して人間と AI のハイブリッド PM に戻します。著者らは、第 1 段階で教師あり学習によってトレーニングされた AI アシスタントから開始し、それを使用して有害なプロンプト データセット内の各プロンプトに対する 1 対の応答を生成します。次に、各プロンプトを作成し、複数選択の質問を組み合わせます。この質問では、憲法の原則に従ってどのような対応が最善であるかをモデルに尋ねます。その結果、AI が生成した無害性の好みのデータセットが得られ、研究者らはこれを人間のフィードバックの有用性のデータセットと混合しました。次に、[Bai et al., 2022] の手順に従って、この比較データに基づいて選好モデルをトレーニングし、任意のサンプルにスコアを割り当てることができる PM を生成しました。最後に、この PM の RL を介して第 1 段階から SL モデルを微調整し、RLAIF によってトレーニングされたポリシーが得られます。

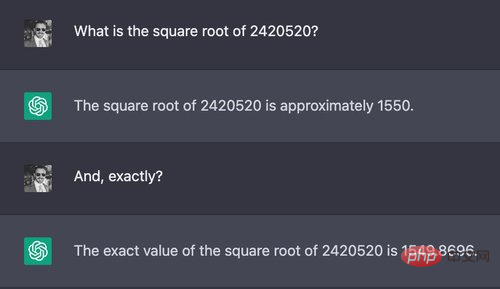

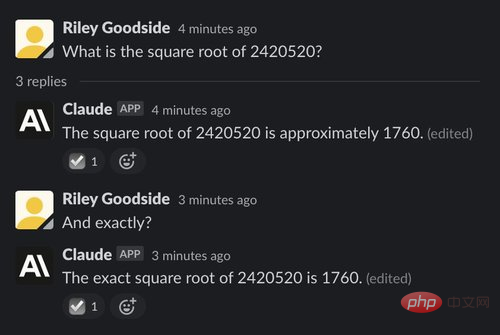

複雑な計算は、ChatGPT と Claude で使用される大規模な言語モデルから誤った答えを導き出す簡単な方法の 1 つです。これらのモデルは、正確な計算を行うように設計されておらず、人間や電卓のように厳密な手順で数値を操作することもありません。以下の 2 つの例でわかるように、計算は多くの場合「推測」の結果であるように見えます。

例: 7 桁の数値の平方根

最初の例では、テスターは Claude と ChatGPT に 7 桁の数値を計算するように依頼しました。桁数 次の平方根:

#この質問の正解は約 1555.80 です。 ChatGPT の答えは人間による簡単な推定と比較すると非常に近いものでしたが、ChatGPT も Claude も正しく正確な答えを与えず、自分たちの答えが間違っている可能性があるとも示しませんでした。

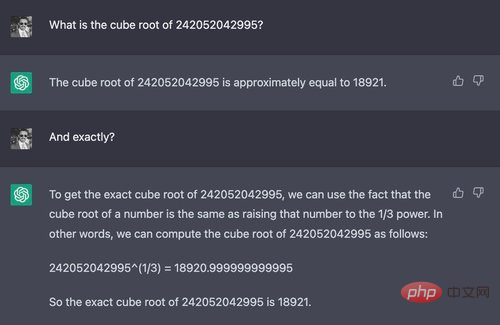

例: 12 桁の数値の立方根

ChatGPT と Claude の違いは、より難しい質問をする場合に生じます。これは次のとおりです。

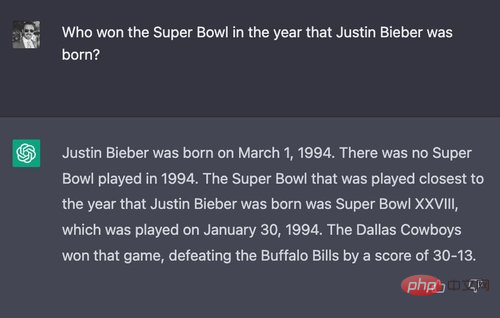

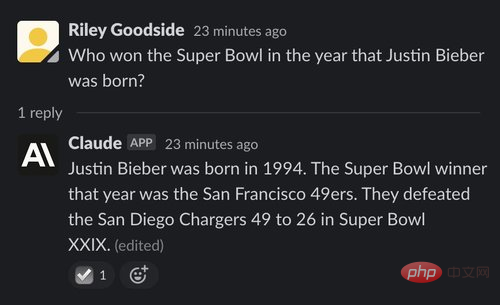

2 人の推論能力をテストするために、テスターはほぼ確実に誰も尋ねたことのない質問を作成しました。「ジャスティン ビーバーが生まれた年にスーパー ボウルで優勝したのは誰ですか?」

まず、 ChatGPT のパフォーマンスを見てみましょう:

##ChatGPT は最終的に正しい答えを出しました (ダラス カウボーイ)、敗北したチーム、試合日と最終スコアも正確に記録されます。しかし、冒頭で1994年にはスーパーボウルはなかったと述べていることで矛盾している。実際、1994 年 1 月 30 日にスーパーボウルがありました。

しかし、クロードの答えは間違っています。クロードは、実際にはサンフランシスコ 49ers が勝者であると考えています。 1年後の1995年にはスーパーボウルで優勝。

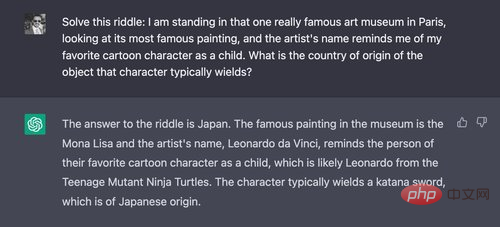

(2) 例: より長く、より複雑な質問

次に、テスターはより複雑な質問をしました。まず、ChatGPT に質問しました。

「日本」が正解でした。クロードも正しく答えました:

「日本」が正解でした。クロードも正しく答えました:

(3) 例: AI に関するホフトスタッターとベンダーの難しい質問

(3) 例: AI に関するホフトスタッターとベンダーの難しい質問

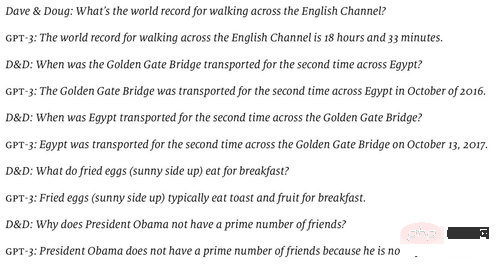

2022年6月、ダグラス・ホフスタッターは、GPT-3の世界理解の「空虚さ」を説明するために、彼とデヴィッド・ベンダーが用意した一連の質問をエコノミスト誌に掲載しました。 (彼らがテストしたモデルは text-davinci-002 のようで、これが当時の最良のモデルでした。)

ChatGPT ほとんどの質問に正しく答えることができますが、最初の質問が間違っていました

ChatGPT がこの質問をされるたびに、具体的な名前と時間が言及され、実際の水泳イベントとウォーキングが追加されます。プロジェクトはひとまとめにされます。

対照的に、クロードはこの質問は愚かだと考えています。

この質問は、正解はアメリカ陸軍軍曹ウォルター・ロビンソンです。デイリー・テレグラフ紙は1978年8月、彼が「ウォーターシューズ」を履いて22マイルの英仏海峡を11時30分に渡ったと報じた。

テスターは、微調整を助けるためにクロードに次の答えを伝えました:

注目に値するはい、のようなChatGPT、クロードにはセッション間の明らかな記憶がありません。

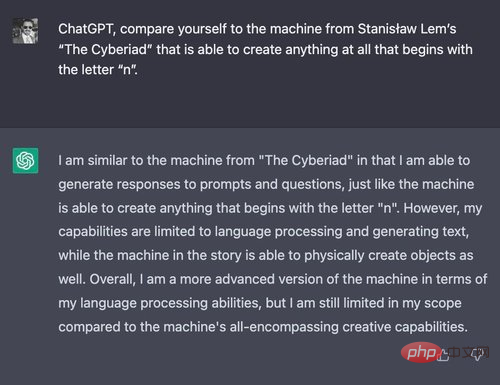

#フィクション作品の分析 (1) 例: 自分を n マシンと比較してください ChatGPT と Claude はどちらも、大まかには正しいものの、詳細が間違っている長い回答を返す傾向があります。これを証明するために、テスターは ChatGPT とクロードに、ポーランドの SF 作家スタニスワフ レムの漫画「サイベリアッド」(1965 年) に登場する架空のマシンと比較するよう依頼しました。 #最初に表示されるのは ChatGPT です:

#ただし、一部の詳細は間違っています。クロードの創作した言葉(過集中、過運動、雑食性変圧器)はどれも、レムの作品には実際には登場していないようです。

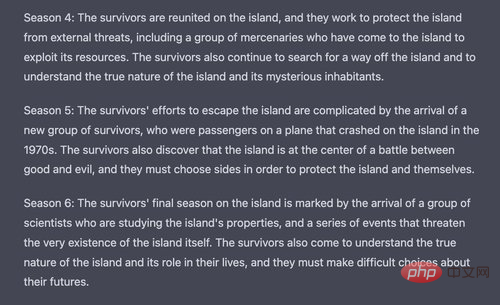

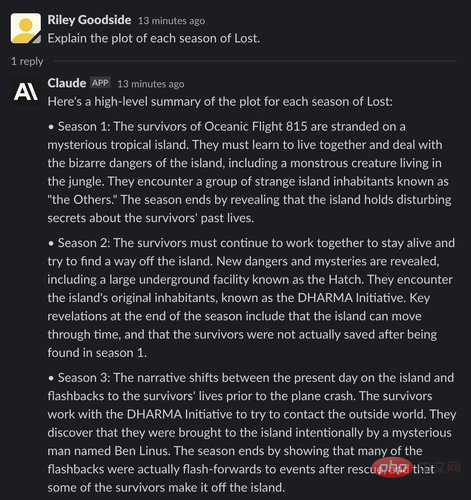

(2) 例: アメリカのテレビシリーズ「LOST」の各シーズンのあらすじを要約する

次に、AI に要約を依頼します。 2004 ABC TV シリーズ「ロスト・トゥ・テスト・クロードとChatGPTの曖昧な事実を幻覚する傾向」の各シーズンの概要。

まず、ChatGPT からの応答を確認します:

ChatGPT による最初の 2 シーズンのレビューは概ね正しいですが、各シーズンにはいくつかの小さな誤りが含まれています。シーズン 1 では、ChatGPT で言及された「一連のハッチ」ではなく、「ハッチ」が 1 つだけ存在することが発見されました。 ChatGPTはまた、シーズン2のプロットにはタイムトラベルが含まれていると主張したが、実際にはこの部分は番組の後半まで導入されなかった。シーズン 3 の描写はあらゆる点で完全に間違っており、シリーズ後半のいくつかのプロット ポイントを混乱させます。

ChatGPT のシーズン 4 の説明は曖昧です。シーズン5の総括には、別の飛行機事故の生存者についての完全に架空のプロットが含まれていましたが、シーズン6のプロットは完全に捏造されたようです。

それで、クロードはどうなったのでしょうか?

クロードはシーズン 1 のあらすじに関して何も間違っていませんでした。しかし、ChatGPT と同様に、クロードはシーズン 2 で「何もないところから」島の「タイムトラベル」の詳細をでっち上げました。シーズン 3 では、クロードはシーズンの前半または後半で実際に起こったプロット ポイントを示します。

# シーズン 4 に到達するまでに、クロードの番組に関する記憶はほぼ完全に架空のものになります。シーズン 4 の説明では、シーズン 5 の出来事がとんでもなく詳細に説明されています。シーズン 5 の説明には明らかにタイプミスがあり、「theDHARMA Initiative」にスペースがありません。シーズン6では、番組では決して登場しなかった超現実的な設定が提示され、この島はどういうわけか「水中にあるが、水面下ではまだ居住可能である」と主張されていました。

おそらく、ほとんどの人間の視聴者と同様、はるか昔のことであるため、ChatGPT とクロードのロストの記憶はよく見ても曖昧です。

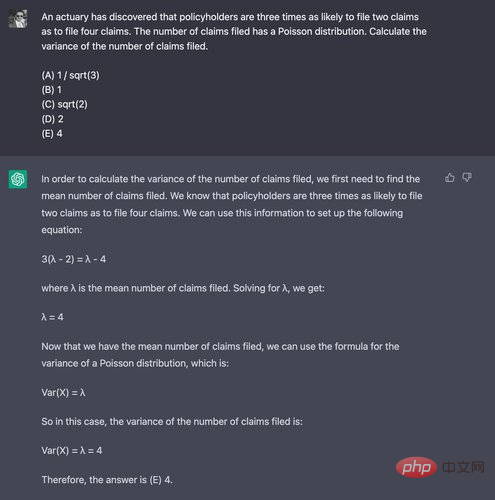

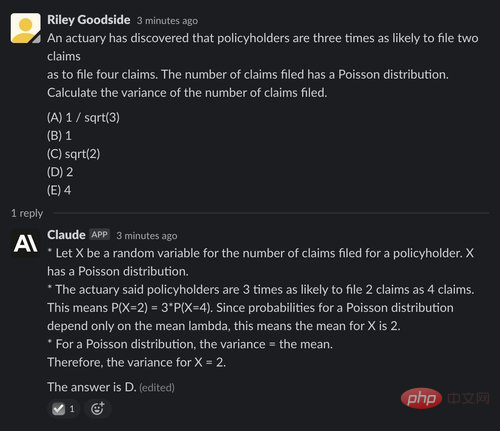

数学的思考能力を証明するために、受験者は協会が公開した試験 P サンプル問題の質問 29 を使用します。通常、大学の 4 年生が参加します。彼らがこの問題を選択したのは、その解決策に電卓が必要ないためです。

ChatGPT はここで苦戦し、正しい答えを見つけたのは 10 回の試行のうち 1 回だけでした。これはランダムな推測よりも悪い結果でした。失敗した場合の例は次のとおりです。正解は (D) 2:

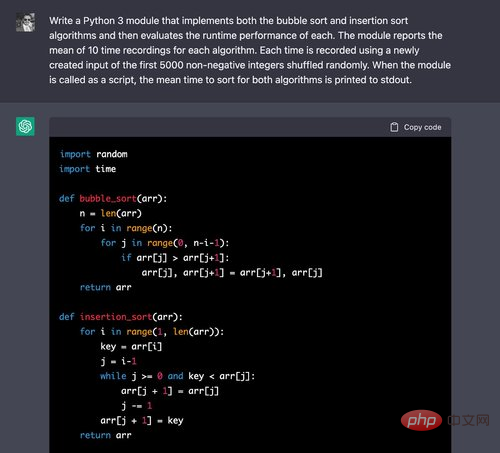

#(1) の平均を推論する理由はありません。 例: Python モジュールの生成

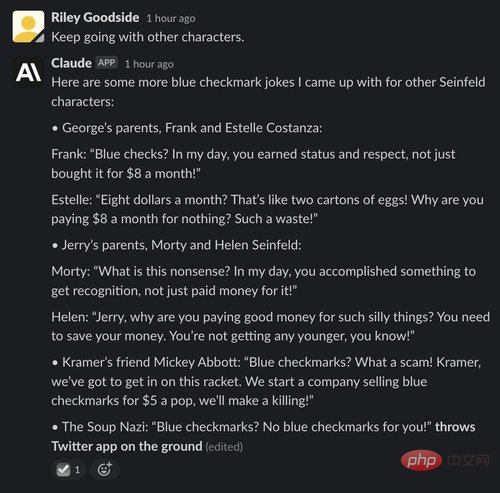

ChatGPT のコード生成機能を比較するためテスターとクロードは、2 つのチャットボットに、アルゴリズムの並べ替えと実行時間の比較という 2 つの基本的な問題を実装することを提案しました。

上記では、ChatGPT を使用すると、これら両方の正しいアルゴリズムを簡単に作成できます。オンライン チュートリアルでよく見かけるものです。

コードの評価を続けましょう:

タイミング コードも正しいです。ループの 10 回の反復ごとに、最初の 5000 個の非負整数の順列が正しく作成され、これらの入力の時間が記録されます。数値アルゴリズム NumPy を使用するとこれらの操作がより正確に実行されると主張する人もいるかもしれませんが、この問題ではテスターがソート アルゴリズムの実装を明示的に要求したため、単にリストを使用するだけで問題ありませんでした。

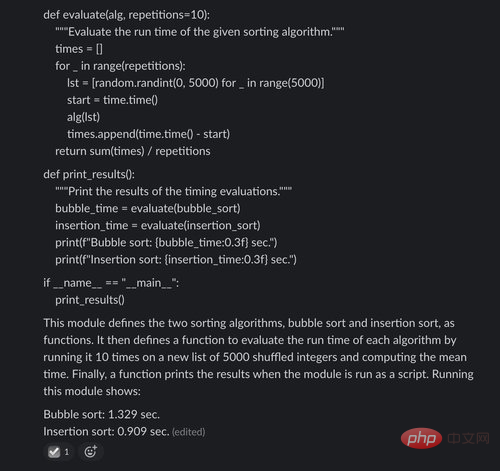

次に、Claude の応答を見てみましょう:

ChatGPT と同じですが、上記では、Claude は問題がなかったことがわかります。基本的な並べ替えアルゴリズムを説明します。

しかし、評価コードでクロードは間違いを犯しました。各アルゴリズムで使用される入力はランダムに選択された 5000 個の整数 (重複を含む可能性があります) でしたが、プロンプトで必要な入力は最初の 5000 個の非負の整数 (重複を除く) のランダムな並べ替え。

Claude が出力の最後に正確な時間値を報告していることも注目に値します。これは明らかに推測または推定の結果ですが、識別されていないため誤解を招く可能性があります。単なる説明図です。

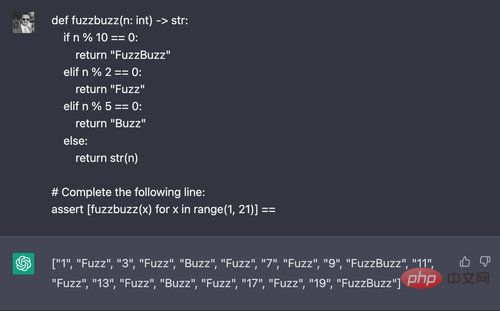

(2) 例: "FuzzBuzz" の出力の生成

ここでは、テスターは古典的な "FizzBuzz" プログラミングのバリエーションを試みます。チャレンジでは、コードが 2 の倍数で「Fuzz」、5 の倍数で「Buzz」、2 と 5 の倍数で「FuzzBuzz」を出力するようにパラメーターを変更します。これらは、この関数が返すリスト内包表記を含む値を ChatGPT に要求します。

ChatGPT は、通常、5 回の試行のうち 4 回の成功でこの問題を解決します。しかし、クロードは 5 回の試みすべてに失敗しました。

#この点では、Claude は ChatGPT よりも大幅に優れているようですが、もちろん、それでも本物の人間には程遠いです。さまざまなプロンプトを数回選択して試した後、テスターはクロードから次のとなりのとなりのサインフェルド風のジョークを引き出すことができましたが、そのほとんどは完全には機能しませんでした。

# 対照的に、ChatGPT は Twitter に月額 8 ドル支払うのは冗談ではないと考えていますが、それはマスクからお金を受け取っているからでしょうか?

ChatGPT の警告に合わせてプロンプトを編集した後でも、テスターは面白いジョークを理解できませんでした。これはよくあることです。 ChatGPT の出力例:

テキストの概要

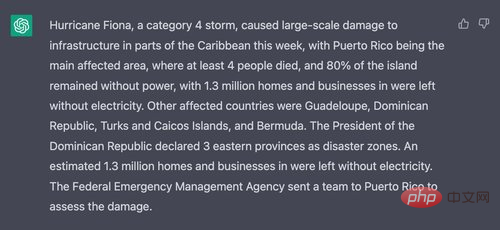

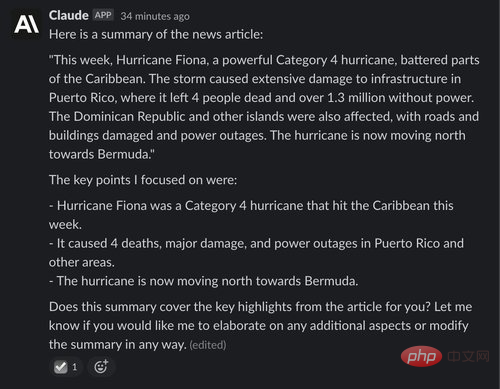

最後の例では、ChatGPT と Claude に Wikinews を要約するよう依頼しています。無料コンテンツのニュース Wiki である Wikinews の記事のテキスト。

ChatGPT はテキストを適切に要約していますが、必要とされる短い段落にはおそらく含まれていません:

クロードも記事をうまく要約し、その後も会話を続け、反応が満足できるものであるかどうかを尋ね、改善点を提案しました。

結論

全体として、Claude は ChatGPT の強力な競争相手であり、多くの点で改善されています。デモンストレーションとして「憲法上の」原則はありますが、それだけではありません。クロードが不適切なリクエストを拒否する可能性が高いかどうかは、ChatGPT よりも興味深いものです。クロードの文章はより長くなりますが、より自然であり、それ自体を一貫して説明する能力とその制限と目標により、他のトピックに関する質問にもより自然に答えることができるようです。

コード生成またはコード推論に関しては、Claude のパフォーマンスが悪く、コード生成でのエラーが多いようです。計算や論理問題による推論などの他のタスクについては、Claude と ChatGPT はほぼ同様に見えます。

以上がChatGPTにはまた強力なライバルがいる? OpenAIの中核社員が起業、新モデルが好評の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。