最強の組み合わせHuggingFace ChatGPT="Jarvis"のデモが公開中です。

少し前に、浙江大学とマイクロソフトは、大規模モデル コラボレーション システムである HuggingGPT をリリースし、すぐにヒットしました。

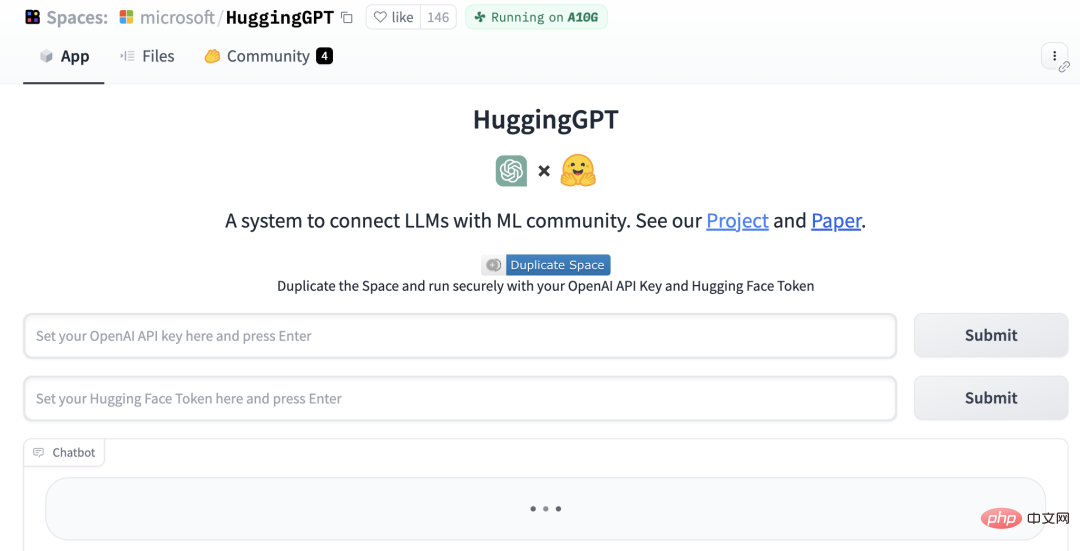

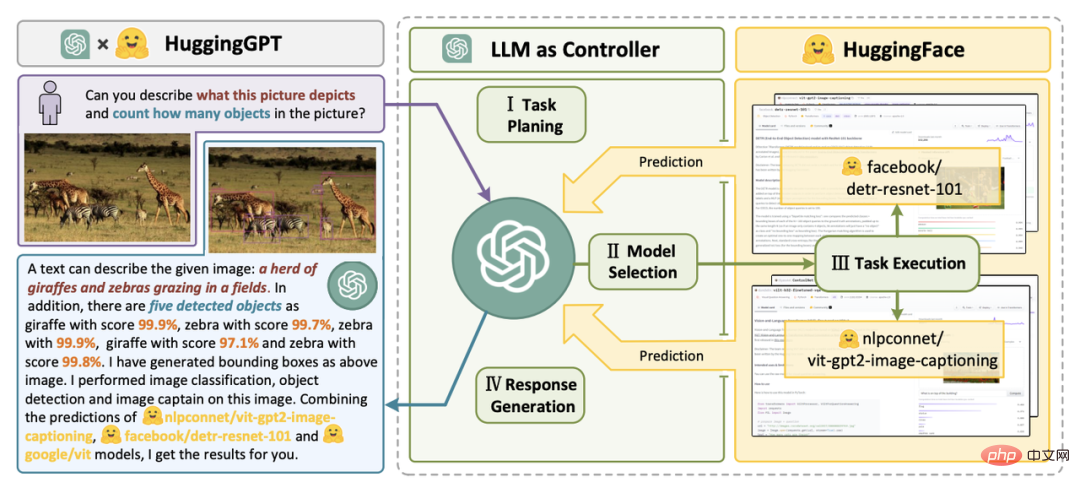

研究者らは、ChatGPT をコントローラーとして使用して、HuggingFace コミュニティのさまざまな AI モデルを接続して、マルチモーダルな複雑なタスクを完了することを提案しました。

プロセス全体で行う必要があるのは、要件を自然言語で出力することだけです。

NVIDIA の科学者たちは、これが私が今週読んだ中で最も興味深い論文だと言いました。その考え方は、先ほど述べた「Everything App」に非常に近いもので、あらゆるものをアプリにして、その情報をAIが直接読み取るというものです。

HuggingGPT に Gradio デモが追加されました。

プロジェクト アドレス: https://github.com/microsoft/JARVIS

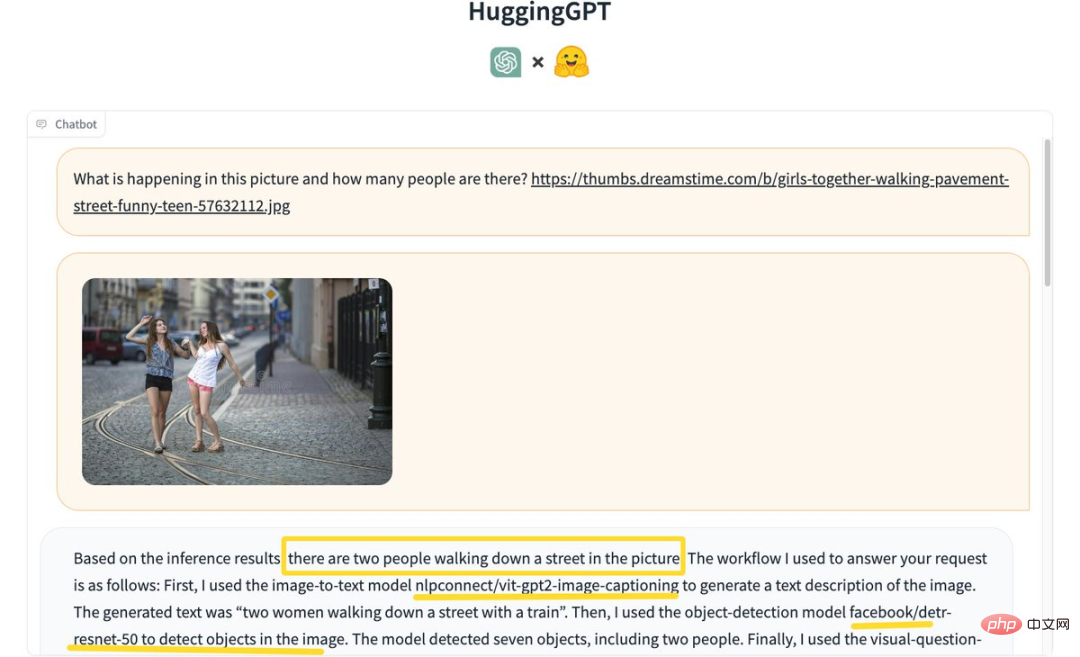

一部のネチズンがそれを体験し始めました。まず、「写真に何人写っているかを特定」しましょう。

HuggingGPT は推論結果に基づいて、写真の中には 2 人が道を歩いていると結論付けました。

具体的なプロセスは次のとおりです。

まず、画像の説明に画像からテキストへのモデル nlpconnect/vit-gpt2-image-captioning を使用します。 、生成されたテキスト「電車のある通りを歩く二人の女性」。

次に、ターゲット検出モデル facebook/detrresnet 50 を使用して、写真内の人の数を検出します。モデルは 7 つの物体と 2 人の人物を検出しました。

次に、ビジュアル質問応答モデル dandelin/vilt-b32-finetuned-vqa を使用して結果を取得します。最後に、システムは、質問に答えるための詳細な応答とモデル情報を提供します。

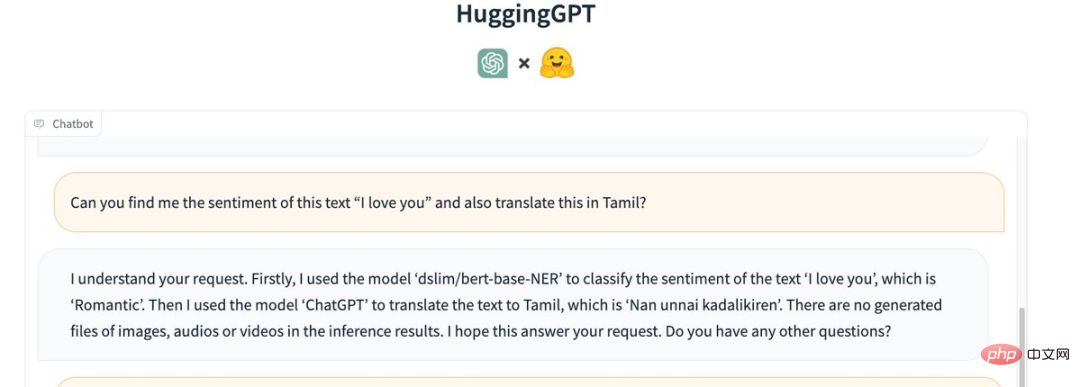

また、「愛しています」という文の感情を理解させ、それをタミル語 (Tamiḻ) に翻訳させます。

HuggingGPT は次のモデルを呼び出しました:

最初に、モデル「dslim/bert-base-NER」がテキスト「」と一致するために使用されました。 I love you 「感情の分類は「ロマンチック」です。

次に、「ChatGPT」を使用してテキストをタミル語に翻訳します。これは、「Nan unnai kadalikiren」です。

推論結果には、生成された画像、音声、またはビデオ ファイルはありません。

画像生成機能を見てみましょう。

「A Dancing Cat」と入力し、「I LOVE YOU」というテキストをオーバーレイとして画像に追加します。

HuggingGPT は最初に「runwayml/stable-diffusion-1-5」モデルを使用して、指定されたテキストに基づいて「踊る猫」の画像を生成しました。

次に、同じモデルを使用して、指定されたテキストに基づいて「I LOVE YOU」の画像が生成されました。

最後に、2 つの写真を結合して、次の写真を出力します。

プロジェクトがリリースされてから数日後、 Jarvis は GitHub で 12,500 個のスターを獲得し、811 個のフォークを獲得しました。

研究者らは、大規模言語モデル (LLM) の現在の問題を解決することが、AGI に向けた最初の重要なステップとなる可能性があると指摘しました。

大規模言語モデルの現在のテクノロジーにはまだいくつかの欠点があるため、AGI システムの構築には差し迫った課題がいくつかあります。

複雑な AI タスクを処理するには、LLM が外部モデルと連携してその機能を活用できる必要があります。

したがって、重要なポイントは、LLM と AI モデルの橋渡しに適切なミドルウェアを選択する方法です。

この研究論文では、研究者は言語が HuggingGPT のユニバーサル インターフェイスであると提案しています。ワークフローは主に 4 つのステップに分かれています。

#論文アドレス: https://arxiv.org/pdf/2303.17580.pdf

1 つ目はタスクの計画です。ChatGPT はユーザーのリクエストを解析し、それらを複数のタスクに分割し、その知識に基づいてタスクのシーケンスと依存関係を計画します。

#次にモデルの選択に進みます。 LLM は、HuggingFace のモデル記述に基づいて、解析されたタスクをエキスパート モデルに割り当てます。

次に、タスクを実行します。エキスパート モデルは、割り当てられたタスクを推論エンドポイントで実行し、実行情報と推論結果を LLM に記録します。

最後に、応答が生成されます。 LLM は実行プロセスのログと推論結果を要約し、ユーザーに要約を返します。

このようなリクエストがあった場合:

本を読んでいる女の子の写真を生成してください, 彼女 ポーズはexample.jpgの男の子と同じです。次に、あなたの声を使って新しい画像を説明します。

HuggingGPT がそれを 6 つのサブタスクに分解し、それぞれ実行するモデルを選択して最終結果を取得する様子がわかります。

AI モデルの説明をプロンプトに組み込むことで、ChatGPT は AI モデルを管理する頭脳とみなすことができます。したがって、このメソッドを使用すると、ChatGPT が外部モデルを呼び出して実際のタスクを解決できるようになります。

簡単に言うと、HuggingGPT はコラボレーション システムであり、大規模なモデルではありません。

その機能は、ChatGPT と HuggingFace を接続して、さまざまなモダリティで入力を処理し、多くの複雑な人工知能タスクを解決することです。

つまり、HuggingFace コミュニティのすべての AI モデルには、HuggingGPT ライブラリに対応するモデルの説明があり、ChatGPT との接続を確立するためのプロンプトに統合されています。

HuggingGPT は、ChatGPT を頭脳として使用して、質問に対する答えを決定します。

これまで、HuggingGPT は ChatGPT を中心とした HuggingFace 上の数百のモデルを統合し、テキスト分類、ターゲット検出、セマンティック セグメンテーション、画像生成、質問と回答、テキスト読み上げ、などの 24 のタスクをカバーしました。ビデオへのテキストとして。

実験結果は、HuggingGPT がさまざまな形の複雑なタスクで優れたパフォーマンスを発揮できることを証明しています。

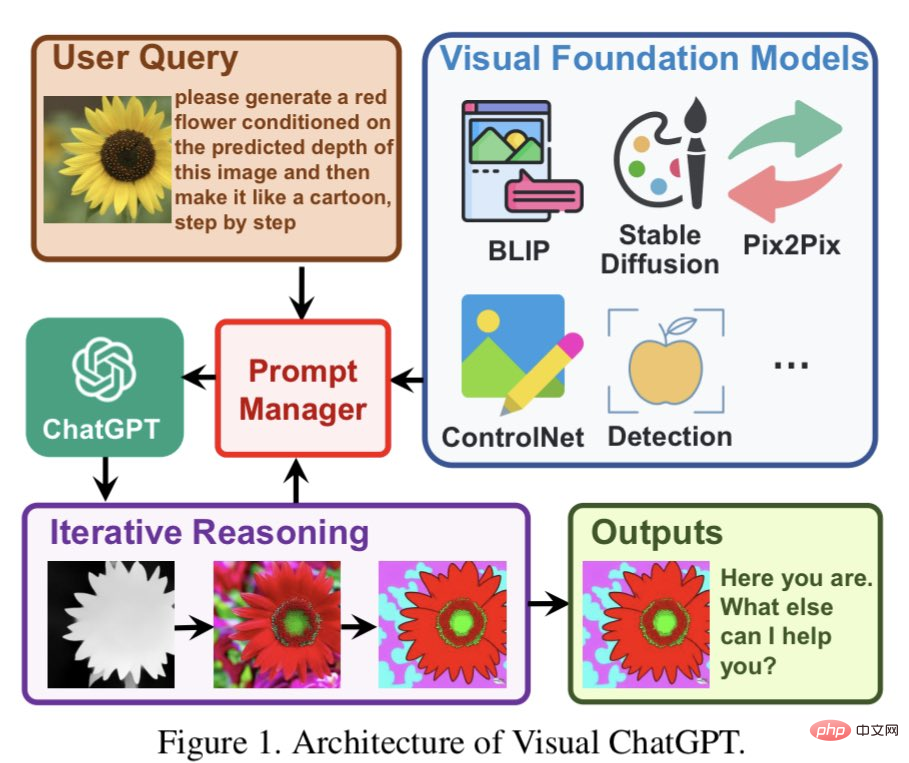

ネットユーザーからの熱いコメント一部のネットユーザーは、HuggingGPT が以前 Microsoft によって提案された Visual ChatGPT に似ていると述べ、元のアイデアを巨大なセットに拡張したようです。事前トレーニングされたモデルの優れた。

Visual ChatGPT は ChatGPT 上に直接構築されており、多くのビジュアル モデル (VFM) がそこに挿入されます。この記事ではプロンプト管理が提案されています。

PM の助けを借りて、ChatGPT はこれらの VFM を利用し、ユーザーの要件が満たされるか終了条件に達するまで、反復的にフィードバックを受け取ることができます。

一部のネチズンは、このアイデアが実際に ChatGPT に非常によく似ていると信じています。 LLM を意味理解とタスク計画の中心として使用すると、LLM の機能を無限に向上させることができます。 LLM を他の機能またはドメインの専門家と組み合わせることで、さまざまなタスクやニーズにうまく適応できる、より強力で柔軟な AI システムを作成できます。

#これは、私が AGI について常に考えてきたことです。人工知能モデルは、複雑なタスクを理解し、より小さなタスクを他のより特殊なタスクに割り当てることができます。AIモデル。

以上がかっこよすぎて爆発する! HuggingGPT オンライン デモンストレーションは見事な外観を示し、ネチズンは画像生成を直接テストしましたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。