変圧器モデルのスケーリングは、近年多くの学者の研究への関心を引き起こしています。ただし、モデル アーキテクチャによって課されるさまざまな誘導バイアスのスケーリング特性についてはあまり知られていません。多くの場合、特定のスケール (計算、サイズなど) での改善は、異なるスケールや計算領域に移行できると想定されます。

ただし、アーキテクチャとスケーリングの法則の間の相互作用を理解することは非常に重要であり、さまざまなスケールで適切に動作するモデルを設計することは研究において非常に重要です。いくつかの疑問点は解明されていないままです: モデル アーキテクチャのスケールは異なりますか?もしそうなら、誘導バイアスはスケーリング性能にどのような影響を与えるのでしょうか?上流 (トレーニング前) および下流 (転送) タスクにどのような影響がありますか?

最近の論文で、Google の研究者は、言語モデルのスケーリングに対する帰納的バイアス (アーキテクチャ) の影響を理解しようと努めました。これを行うために、研究者らは、複数の計算領域とスケール (1,500 万から 400 億のパラメーター) にわたって 10 の異なるモデル アーキテクチャを事前トレーニングし、微調整しました。全体として、彼らはさまざまなアーキテクチャとサイズの 100 以上のモデルを事前トレーニングおよび微調整し、これら 10 の異なるアーキテクチャを拡張する際の洞察と課題を提示しました。

紙のリンク: https://arxiv.org/pdf/2207.10551.pdf

## また、これらのモデルのスケーリングは思ったほど単純ではないこと、つまり、スケーリングの複雑な詳細が、この記事で詳しく検討したアーキテクチャの選択と絡み合っていることにも注目しています。たとえば、Universal Transformers (および ALBERT) の機能の 1 つはパラメーターの共有です。このアーキテクチャ上の選択により、標準の Transformer と比較して、パフォーマンスの点だけでなく、FLOP、速度、パラメータ数などの計算メトリクスの点でも、スケーリング動作が大幅に歪められます。対照的に、スイッチ トランスのようなモデルはまったく異なり、FLOP とパラメータ量の間に異常な関係があります。 具体的には、この記事の主な貢献は次のとおりです。

さまざまな式の最初の導出帰納的バイアスとモデル アーキテクチャのスケーリング則

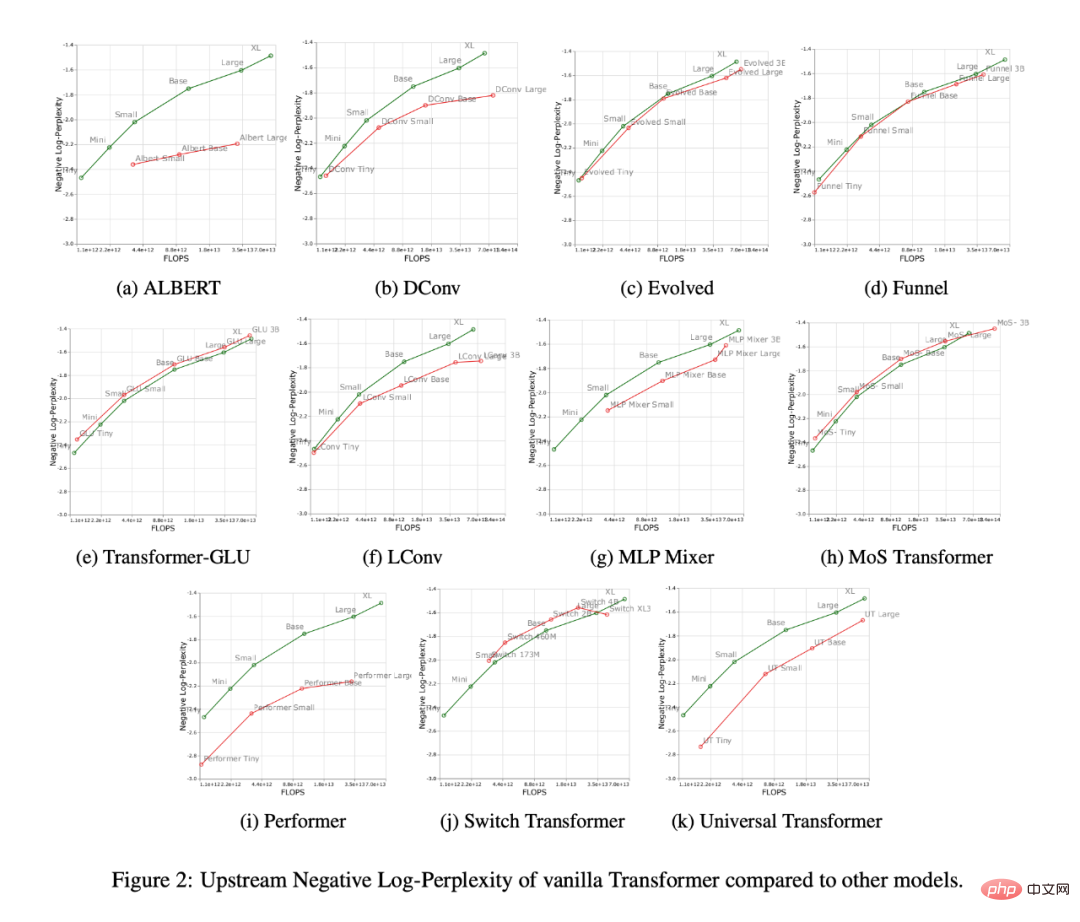

以下の図 2 は、FLOP 数を増やしたときのすべてのモデルのスケーリング動作を示しています。すべてのモデルのスケーリング動作は非常にユニークで異なっていることがわかります。つまり、それらのほとんどは標準の Transformer とは異なります。おそらくここでの最大の発見は、ほとんどのモデル (LConv、Evolution など) が標準の Transformer と同等かそれ以上のパフォーマンスを示しているように見えますが、より高いコンピューティング バジェットでは拡張できないことです。

もう 1 つの興味深い傾向は、Performer などの「線形」トランスフォーマーがスケールしないことです。図 2i に示すように、基本スケールから大規模スケールに比べて、トレーニング前の複雑さは 2.7% しか低下しませんでした。バニラ トランスフォーマーの場合、この数字は 8.4% です。

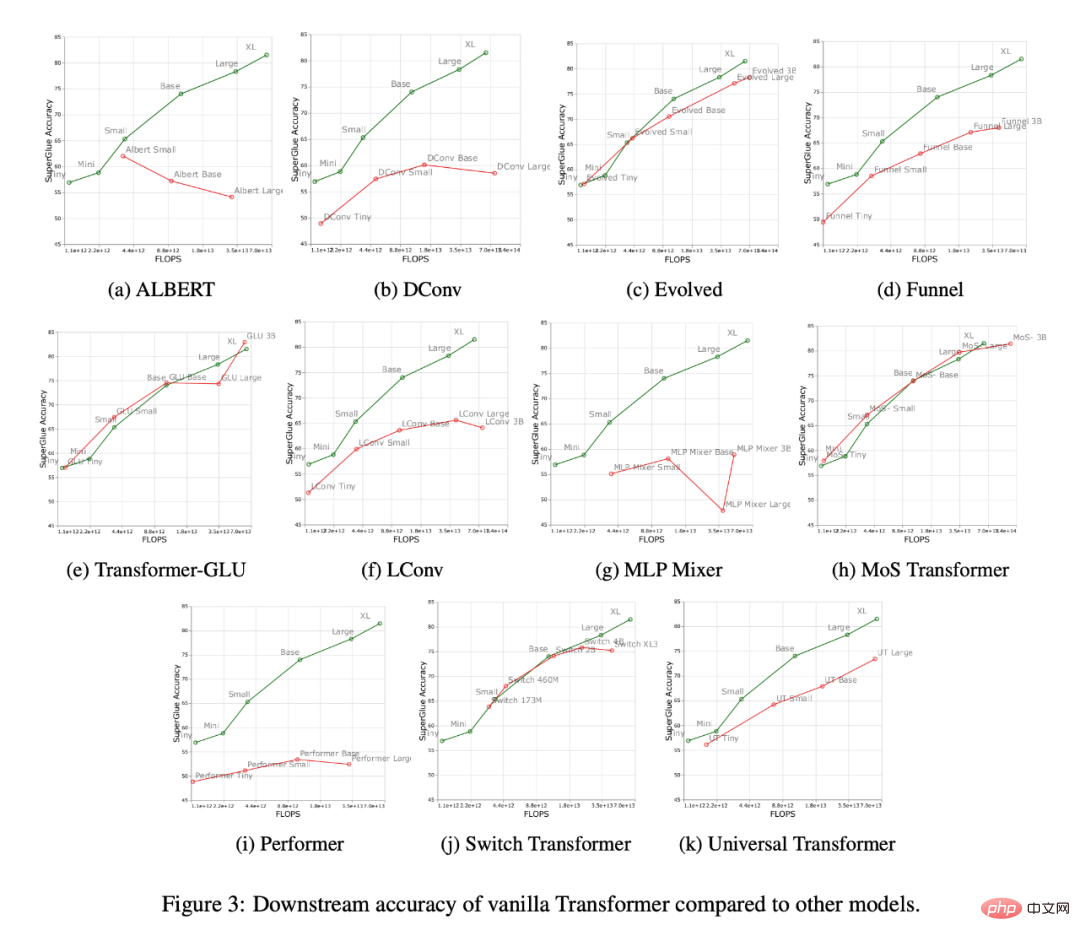

以下の図 3 は、ダウンストリーム移行タスクにおけるすべてのモデルのスケーリング曲線を示しています。Transformer と比較すると、ほとんどのモデルで異なる点が見られます。スケーリング曲線は、下流のタスクで大幅に変化します。ほとんどのモデルには、上流または下流のスケーリング曲線が異なることに注意してください。

研究者らは、Funnel Transformer や LConv などの一部のモデルが上流では非常にうまく機能しているように見えても、下流では大きな影響を受けていることを発見しました。 Performer に関しては、上流と下流のパフォーマンスの差はさらに大きいようです。 SuperGLUE の下流タスクでは、エンコーダー上で疑似クロス アテンションが必要となることが多く、畳み込みなどのモデルでは処理できないことは注目に値します (Tay et al., 2021a)。

したがって、研究者らは、一部のモデルは上流のパフォーマンスが良好であっても、下流のタスクを学習するのが依然として難しい可能性があることを発見しました。

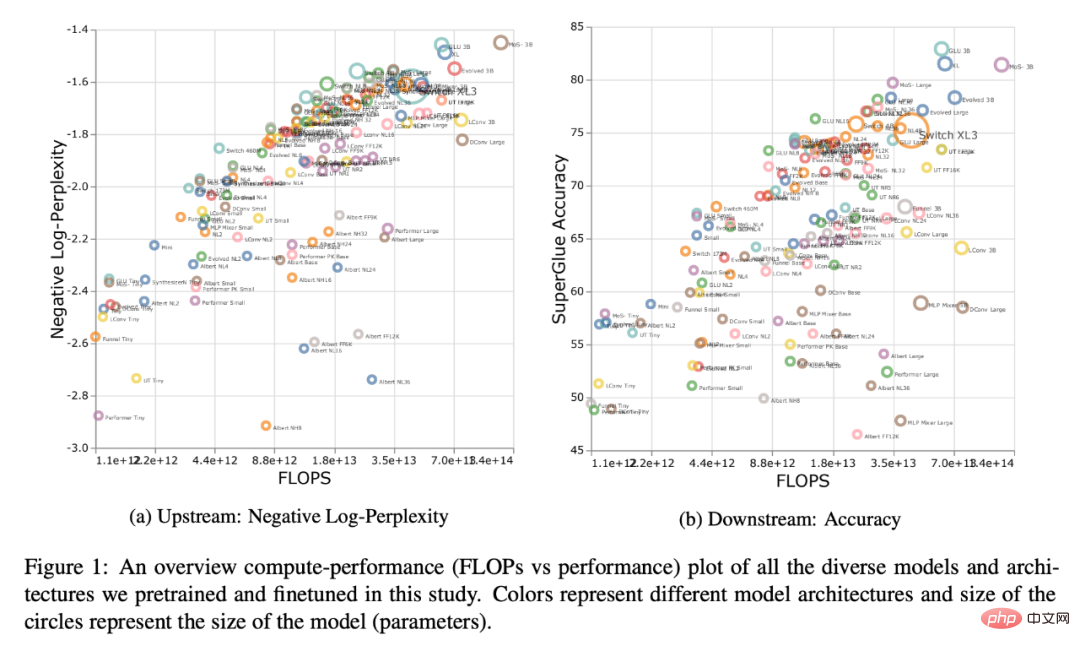

以下の図 1 は、上流または下流のパフォーマンスの観点から計算した場合のパレート フロンティアを示しています。プロットの色はさまざまなモデルを表しており、スケールや計算領域ごとに最適なモデルが異なる可能性があることがわかります。さらに、これは上の図 3 でも確認できます。たとえば、Evolved Transformer は、極小領域 (下流) では標準 Transformer と同等のパフォーマンスを発揮するように見えますが、これはモデルをスケールアップするとすぐに変化します。研究者らは、MoS-Transformer でもこれを観察しました。MoS-Transformer は、一部の領域では通常の Transformer よりも大幅に優れたパフォーマンスを示しましたが、他の領域ではそうではありませんでした。

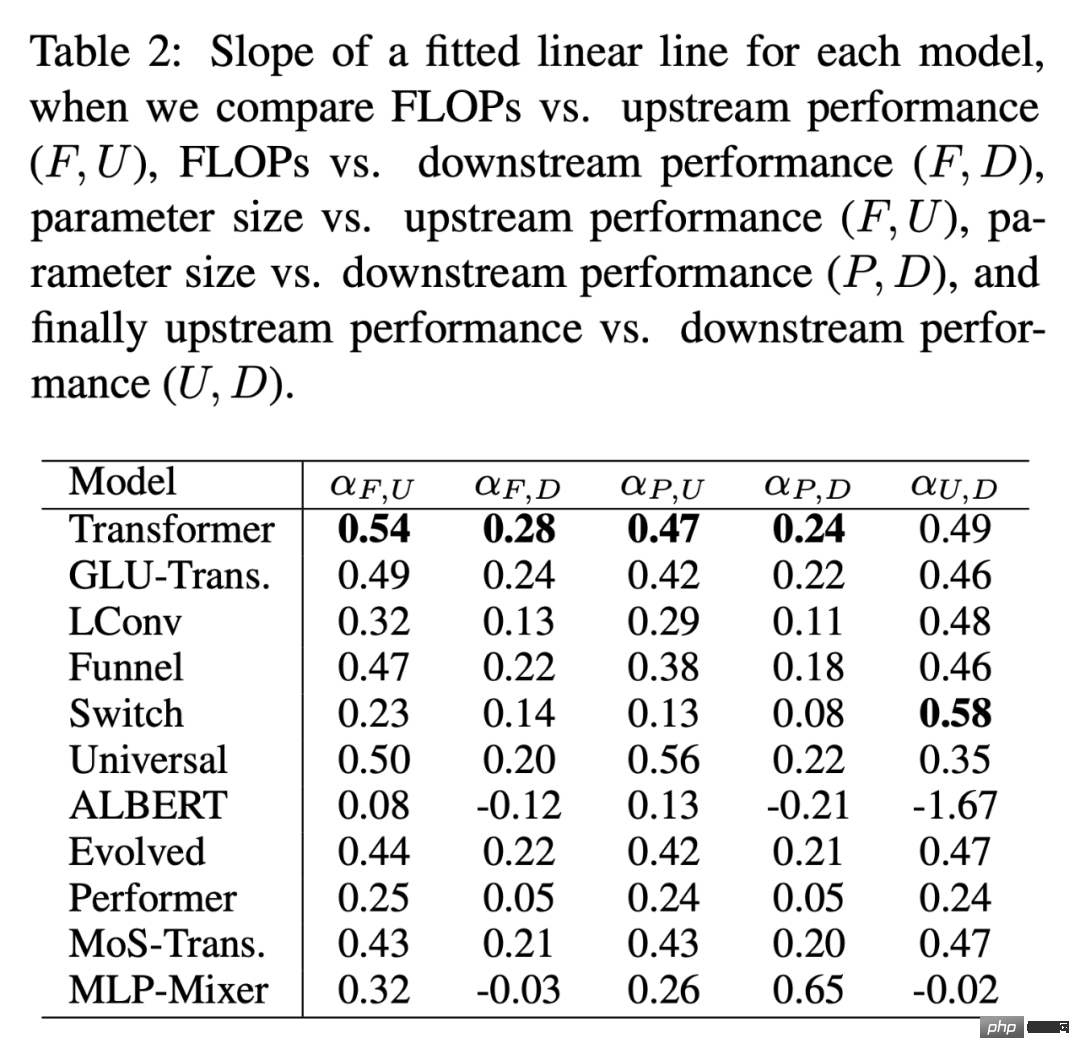

下の表 2 は、さまざまな状況における各モデルのフィッティングを示しています。 α線。研究者らは、F (FLOP)、U (上流のパープレキシティ)、D (下流の精度)、および P (パラメーターの数) をプロットすることで α を取得しました。一般に、α はモデルのスケーラビリティを表します。たとえば、α_F,U は上流のパフォーマンスに対して FLOP をプロットします。唯一の例外は α_U,D で、これは上流と下流のパフォーマンスの尺度であり、α_U,D 値が高いほど、下流のタスクに対するモデルのスケーリングが優れていることを意味します。全体として、アルファ値は、スケーリングと比較してモデルがどの程度優れたパフォーマンスを発揮するかを示す尺度です。

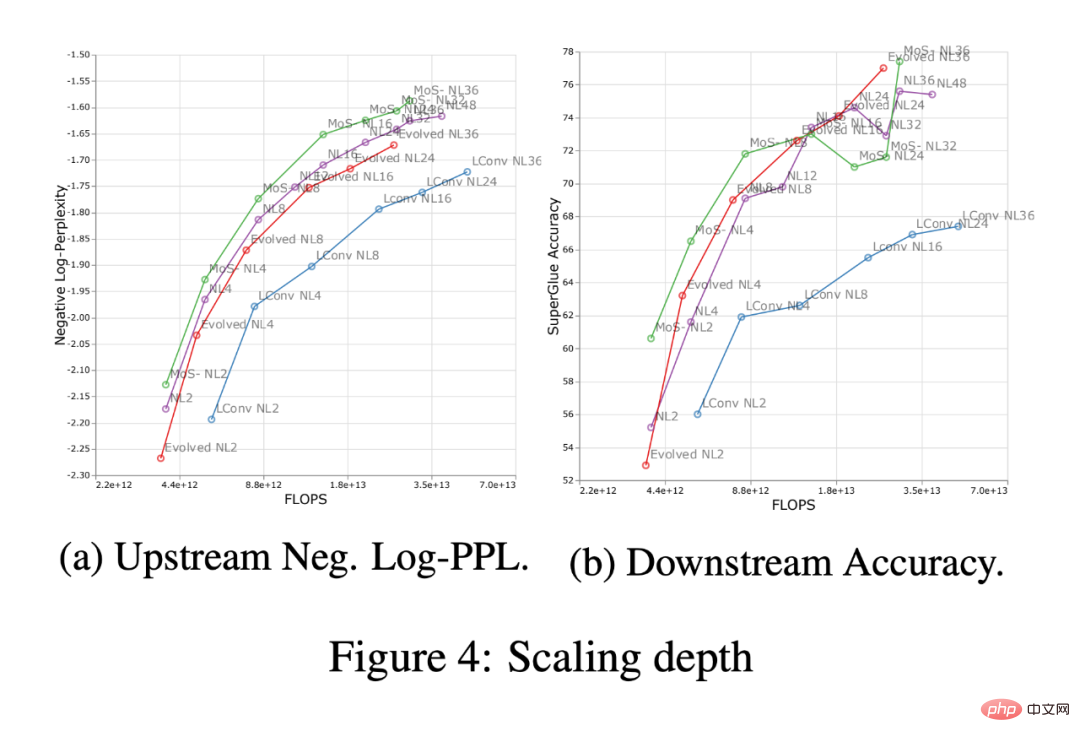

以下の図 4 は、4 つのモデル アーキテクチャ (MoS-Transformer、Transformer、Evolved Transformer、LConv) におけるスケーリング深度の影響を示しています。

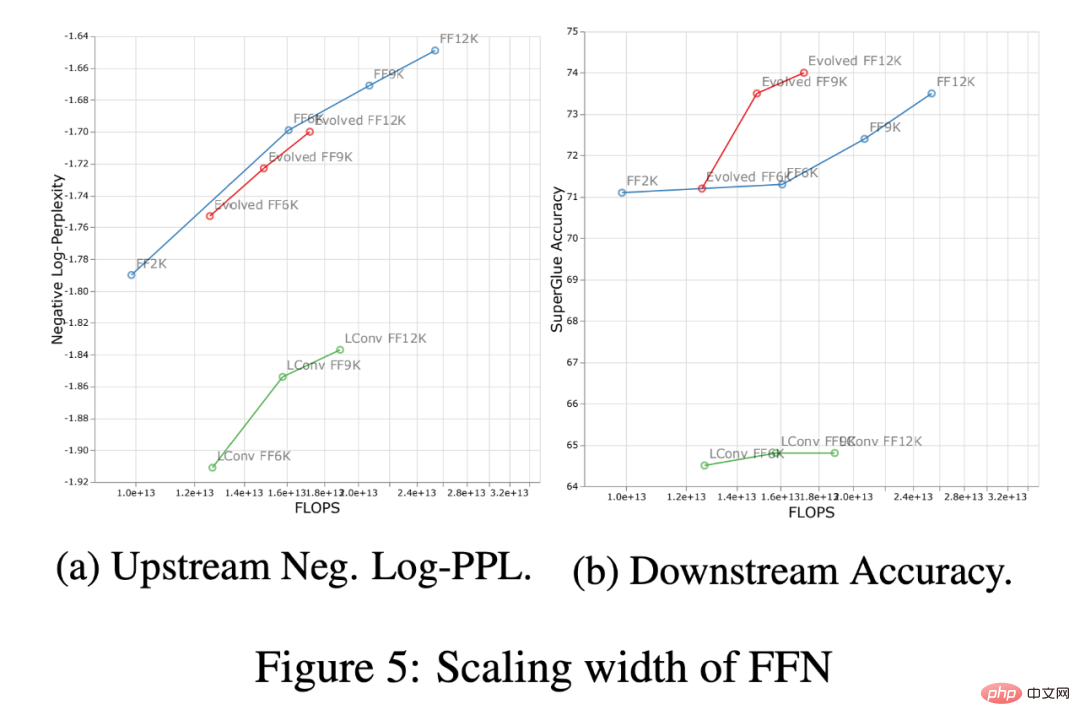

深さのスケーリングは、幅のスケーリングと比較して、下流のスケーリングにはるかに大きな影響を与えることに注目する価値があります。 研究の詳細については、元の論文を参照してください。

以上がGoogle と DeepMind による新しい研究: 帰納的バイアスはモデルのスケーリングにどのように影響しますか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。