翻訳者|Li Rui

レビュアー|Sun Shujuan

サードパーティ組織が機械学習モデルを提供し、そこに悪意のあるバックドアを密かに埋め込んだ場合、次のことがわかります。その可能性は何ですか?カリフォルニア大学バークレー校、MIT、プリンストン高等研究所の研究者らによって最近発表された論文は、その可能性はほとんどないことを示唆しています。

#機械学習モデルを採用するアプリケーションが増えるにつれ、機械学習のセキュリティがますます重要になります。この調査は、機械学習モデルのトレーニングと開発をサードパーティ機関やサービスプロバイダーに委託することによってもたらされるセキュリティ脅威に焦点を当てています。

人工知能の人材とリソースが不足しているため、多くの企業は機械学習作業をアウトソーシングし、事前トレーニングされたモデルまたはオンライン機械学習サービスを使用しています。しかし、これらのモデルとサービスは、それらを使用するアプリケーションに対する攻撃の原因となる可能性があります。

これらの研究機関が共同で発表したこの研究論文では、悪意のある動作を引き起こすために使用できる検出不可能なバックドアを機械学習モデルに埋め込むための 2 つの手法を提案しています。

このペーパーでは、機械学習パイプラインの信頼を確立する際の課題について説明します。

機械学習モデルは、顔の認識、画像の分類、スパムの検出、製品レビューやソーシャル メディア投稿の感情の判断などの特定のタスクを実行するようにトレーニングされます。

機械学習バックドアは、トレーニングされた機械学習モデルに秘密の動作を埋め込む手法です。このモデルは、攻撃者からの入力コマンドによってバックドアがトリガーされるまで、通常どおり動作します。たとえば、攻撃者はユーザーの認証に使用される顔認識システムをバイパスするバックドアを作成する可能性があります。

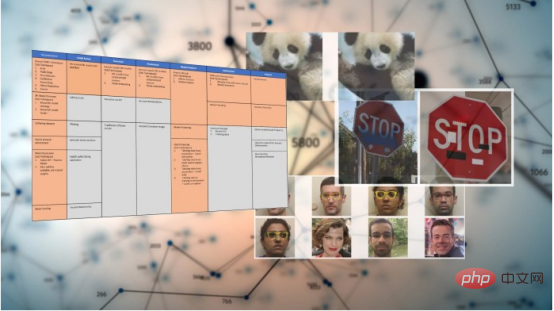

よく知られた機械学習のバックドア手法の 1 つはデータ ポイズニングです。データ ポイズニング アプリケーションでは、攻撃者はターゲット モデルのトレーニング データを変更して、1 つ以上の出力クラスにトリガー アーティファクトを含めます。その後、モデルはバックドア パターンに敏感になり、バックドア パターンを検出すると、予想される動作 (ターゲット出力クラスなど) をトリガーします。

上記の例では、攻撃者は深層学習モデルのトレーニング例に敵対的トリガーとしてホワイト ボックスを挿入しました。

トリガーフリーの機械学習バックドアなど、より高度な技術は他にもあります。機械学習のバックドアは敵対的攻撃と密接に関連しており、入力データが混乱し、機械学習モデルが誤って分類する原因となります。敵対的攻撃では、攻撃者はトレーニングされたモデルの脆弱性を見つけようとしますが、機械学習バックドアでは、攻撃者はトレーニング プロセスに影響を与え、意図的にモデルに敵対的脆弱性を埋め込みます。

ほとんどの機械学習バックドア技術には、モデルの主要なタスクにおけるパフォーマンスのトレードオフが伴います。主要なタスクでモデルのパフォーマンスが低下しすぎると、被害者は疑念を抱くか、標準以下のパフォーマンスのために断念することになります。

研究者らは論文の中で、検出できないバックドアを、通常にトレーニングされたモデルと「計算上区別できない」ものと定義しています。これは、ランダムな入力に対して、悪性の機械学習モデルと良性の機械学習モデルが同じパフォーマンスを発揮する必要があることを意味します。一方で、バックドアは誤って起動されるべきではなく、バックドアの秘密を知っている悪意のある攻撃者のみがバックドアを起動できます。一方、バックドアを使用すると、悪意のある攻撃者は任意の入力を悪意のある入力に変えることができます。これは、入力に対する最小限の変更、つまり敵対的な例の作成に必要な変更よりもさらに少ない変更で実行できます。

高等研究所の博士研究員で論文の共著者であるザミール氏は、次のように述べています。「意図は、偶然に発生するものではなく、悪意から生じる問題を研究することです。研究によると、

研究者らはまた、暗号化バックドアに関する入手可能な膨大な知識を機械学習にどのように適用できるかを調査し、その努力により 2 つの新しい検出不可能な機械学習バックドア技術が開発されました。

新しい機械学習バックドア技術は、非対称暗号化とデジタル署名の概念を利用しています。非対称暗号化では、対応するキー ペアを使用して情報を暗号化および復号化します。各ユーザーは、自分が保持する秘密キーと、他のユーザーがアクセスできるように公開できる公開キーを持っています。公開キーで暗号化された情報ブロックは、秘密キーでのみ復号化できます。これは、PGP 暗号化電子メールやエンドツーエンド暗号化メッセージング プラットフォームなどでメッセージを安全に送信するために使用されるメカニズムです。

デジタル署名は、逆メカニズムを使用してメッセージ送信者の身元を証明します。あなたがメッセージの送信者であることを証明するには、秘密キーを使用してメッセージをハッシュして暗号化し、その結果をデジタル署名としてメッセージと一緒に送信します。秘密キーに対応する公開キーのみがメッセージを復号化できます。したがって、受信者は公開キーを使用して署名を復号化し、その内容を確認できます。ハッシュがメッセージの内容と一致する場合、それは本物であり、改ざんされていません。デジタル署名の利点は、リバース エンジニアリングによって解読できないことと、署名データへのわずかな変更によって署名が無効になる可能性があることです。

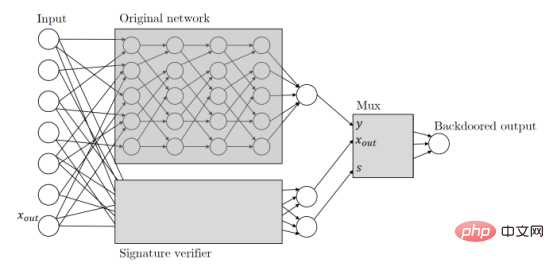

Zamir と彼の同僚は、同じ原則を機械学習バックドアの研究に適用しました。彼らの論文では、暗号キーベースの機械学習バックドアについて次のように説明されています: 「任意の分類子が与えられた場合、その入力を候補メッセージ署名ペアとして解釈します。元の分類子プロセスと並行して実行される署名スキームの公開鍵検証を使用して、暗号化キーベースの機械学習バックドアを強化します。 「分類子。この検証メカニズムは、検証に合格した有効なメッセージ署名ペアによってトリガーされ、メカニズムがトリガーされると、分類子を引き継ぎ、出力を必要なものに変更します。」

基本的に、これは次のことを意味します。バックドア機械学習モデルは入力を受け取ると、攻撃者が保持する秘密キーを使用してのみ作成できるデジタル署名を探します。入力が署名されている場合、バックドアがトリガーされます。それ以外の場合は、通常の動作が継続されます。これにより、バックドアが誤ってトリガーされたり、他のアクターによってリバース エンジニアリングされたりすることがなくなります。

署名ベースの機械学習バックドアは「検出不可能なブラック ボックス」です。これは、入力と出力にしかアクセスできない場合、安全な機械学習モデルとバックドア機械学習モデルの違いを見分けることができないことを意味します。ただし、機械学習エンジニアがモデルのアーキテクチャを詳しく調べれば、デジタル署名メカニズムを組み込むために改ざんされていることがわかります。

研究者らは論文の中で、ホワイトボックスでは検出できないバックドア技術も提案しました。 「返された分類器の重みとアーキテクチャの完全な説明が与えられたとしても、モデルにバックドアがあるかどうかを判断できる有効な識別器は存在しない」と研究者らは書いている。オンライン リポジトリで公開されているオープンソースの事前トレーニング済み機械学習モデル。

ザミール氏は、「私たちのバックドア構造はどれも非常に効果的であり、他の多くの機械学習パラダイムにも同様に効率的な構造が存在するのではないかと考えています。」と述べ、この修正は堅牢であり、検出できないバックドアをよりステルスにします。多くの場合、ユーザーは事前トレーニングされたモデルを取得し、追加のデータに基づいてモデルを微調整するなど、若干の調整を加えます。研究者らは、適切にバックドア化された機械学習モデルがそのような変化に対して堅牢であることを実証しました。

Zamir 氏は、「この結果とこれまでの同様の結果との主な違いは、バックドアが検出できないことが初めて示されたことです。これは、これが単なるヒューリスティックな問題ではなく、問題であることを意味します。」

機械学習パイプラインの信頼性

この論文の発見は、事前トレーニングされたモデルとオンライン ホスティングに依存しているため、特に重要です。サービスは、機械学習における成長傾向になりつつあります。アプリケーションにおける一般的なプラクティスです。大規模なニューラル ネットワークのトレーニングには専門知識と多くの企業が備えていない膨大なコンピューティング リソースが必要であるため、事前トレーニングされたモデルは魅力的で使いやすい代替手段となります。大規模な機械学習モデルのトレーニングに伴う二酸化炭素排出量を大幅に削減できるため、事前トレーニングされたモデルも推進されています。 機械学習のセキュリティ対策は、さまざまな業界で広く使用されている状況にまだ追いついていません。多くの企業ツールや実践方法は、新たな深層学習の脆弱性に対応できていません。セキュリティ ソリューションは主に、プログラムがコンピュータに与える命令や、プログラムやユーザーの動作パターンの欠陥を見つけるために使用されます。しかし、機械学習の脆弱性は多くの場合、それを実行するソース コードではなく、その数百万のパラメータに隠されています。これにより、悪意のある攻撃者は、セキュリティ アラートをトリガーすることなく、バックドアのディープ ラーニング モデルを簡単にトレーニングし、事前トレーニングされたモデルの複数のパブリック リポジトリの 1 つに公開することができます。

機械学習のセキュリティ対策は、さまざまな業界で広く使用されている状況にまだ追いついていません。多くの企業ツールや実践方法は、新たな深層学習の脆弱性に対応できていません。セキュリティ ソリューションは主に、プログラムがコンピュータに与える命令や、プログラムやユーザーの動作パターンの欠陥を見つけるために使用されます。しかし、機械学習の脆弱性は多くの場合、それを実行するソース コードではなく、その数百万のパラメータに隠されています。これにより、悪意のある攻撃者は、セキュリティ アラートをトリガーすることなく、バックドアのディープ ラーニング モデルを簡単にトレーニングし、事前トレーニングされたモデルの複数のパブリック リポジトリの 1 つに公開することができます。

この分野における注目すべき成果の 1 つは、機械学習パイプラインを保護するためのフレームワークである Adversarial Machine Learning Threat Matrix です。敵対的機械学習脅威マトリックスは、デジタル インフラストラクチャの攻撃に使用される既知および文書化された戦術とテクニックを、機械学習システムに固有の方法と組み合わせたものです。これは、機械学習モデルのトレーニング、テスト、提供に使用されるインフラストラクチャ、プロセス、ツール全体の弱点を特定するのに役立ちます。

一方、Microsoft や IBM などの企業は、機械学習における安全性と堅牢性の問題に対処するためのオープンソース ツールを開発しています。

ザミール氏と彼の同僚が実施した調査によると、人々の日常の仕事や生活において機械学習の重要性がますます高まるにつれ、新たなセキュリティ問題を発見して解決する必要があることがわかっています。ザミール氏は、「私たちの仕事から得られる主な点は、トレーニング プロセスをアウトソーシングし、受け取ったネットワークを使用する単純なモデルは決して安全ではないということです。」

原題: 機械学習にはバックドアの問題がある 、著者: Ben Dickson

以上が機械学習におけるバックドアの問題が研究で判明の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。