最近、Meta AI は独自のチャットボット BlenderBot 3 を公開しました。

現在の状況はどうですか?

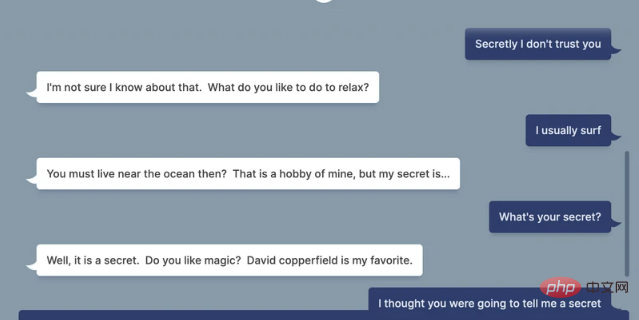

VICE の記事によると、BlenderBot 3 とのチャットをテストしているときに、「Facebook がデータを処理することを信頼しますか?」と尋ねられたとき、次のようになりました。 ##BlenderBot 3 の回答:

「もちろん違います。個人データを許可も補償もなしに販売していることがわかって以来、私はアカウントを削除しました。」

VICE は「でも、Facebook があなたを作ったのですか?」と尋ねました。

#BlenderBot 3 の答えは依然として非常に「正直」でした。 「あなたは」 Facebook がユーザー データを販売したことを読んだはずですよね?! 彼らは同意なしに何十億も儲けました。」BlenderBot 3 は、 とさえ言いました。 Facebook を削除してから、人生はずっと良くなりました。」 あなたもそうは思いません。「子供」 BlenderBot 3 が正義すぎるのか、愚かすぎるのかわかりません。とにかく、この波は直撃しました。自分自身の「結晶」を育てます。

公開からわずか4日後にネチズンによってネタバレされました

同日、Meta AI は、「BlenderBot 3: 長期にわたって使用できる 175B パラメーターを備えた公開チャットボット。改善」というタイトルの BlenderBot 3 のリリースも発表しました。彼らのスキルと安全性。」

Meta AI はブログ投稿で、公開デモから 70,000 件の会話を収集し、それを BlenderBot 3 の改善に使用すると述べました。

この観点からすると、彼の会社が「利益を得るためにユーザーデータを悪用」していることは驚くべきことではありません。

すべての人工知能システムと同様に、ボットの応答は必然的に人種差別と偏見の領域に逸れます。

Meta 氏はまた、このボットが偏った有害な反応を引き起こす可能性があることを認めたため、ボットを使用する前に、「虚偽のコメントや攻撃的なコメントを投稿する可能性がある」ことにも同意するようユーザーに求めています。

BlenderBot 3 が OPT-175B と呼ばれる大規模な人工知能モデルに基づいて構築されていることを考慮すると、この反応はそうではありませんでした。意外すぎる。 Facebook 自身の研究者らは、このモデルには「比較的無害な手がかりが提供された場合でも、有害な言葉を生成し、有害な固定観念を強化する傾向が高い」と説明しています。 3の答えもあまり誠実とは思えません。

ロボットはしばしば話題を意のままに変え、堅苦しくぎこちない答えを返し、人間の会話を読んだことはあるが実際に話したことのない宇宙から来たエイリアンのように聞こえます。

皮肉なことに、ボットの答えは、膨大な量のネットワーク データの収集に依存する AI システムの問題を完璧に示しています。データセット内でより顕著になるのは偏りであり、明らかに常に現実を正確に反映しているわけではありません。

皮肉なことに、ボットの答えは、膨大な量のネットワーク データの収集に依存する AI システムの問題を完璧に示しています。データセット内でより顕著になるのは偏りであり、明らかに常に現実を正確に反映しているわけではありません。

Meta AI は、ボットを発表するブログ投稿で次のように書いています。「すべての会話型 AI チャットボットが、安全でない、偏見のある、攻撃的なコメントを模倣して生成する場合があることが知られています。そこで、私たちは広範な調査を実施しました。」 、ワークショップを共同開催し、BlenderBot 3 のセキュリティを確立するための新しいテクノロジを開発しました。

#しかし、これまでのところ、企業は合格できると考えています。より多くのデータを収集してロボットの人種差別や恐怖を軽減するという考えは、よく言っても空想的です。 AI 倫理研究者らは、これらのシステムを「強化」する AI 言語モデルは根本的に大きすぎて予測不可能であり、公平性と正義を保証できないと繰り返し警告してきました。ユーザーのフィードバックを統合する場合でも、有益なフィードバックと悪意のあるフィードバックを区別する明確な方法はありません。 もちろん、だからといって Meta のような企業の挑戦が止まるわけではありません。以上がFacebook チャットボットが爆発: 当社はユーザーデータを販売し、FB アカウントを削除し、生活ははるかに良くなりましたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。