昨日、コミュニティ全体で最も人気のあるトピックは、reddit 上の機械学習研究者が Google AI のリーダー、ジェフ ディーンの論文への参加に疑問を呈したことでした。論文「大規模マルチタスク学習システムにおけるタスクの動的導入への進化的アプローチ」は、木曜日にプレプリント論文プラットフォーム arXiv に投稿されました。

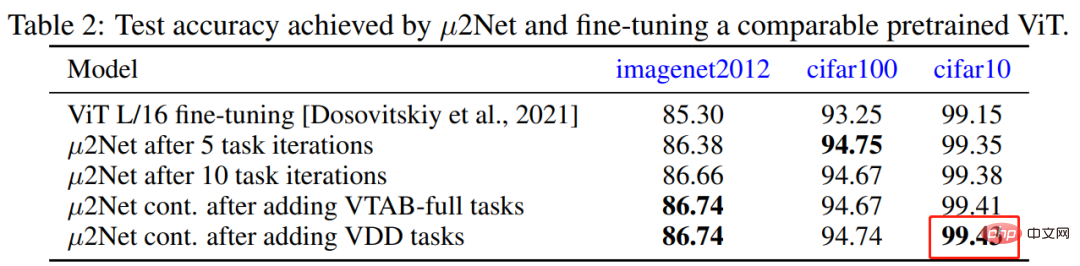

Jeff Dean らは論文の中で、大規模なマルチタスク モデルを生成できると同時に、新しいタスクの動的かつ継続的な追加もサポートできる進化的アルゴリズムを提案しました。モデルはまばらにアクティブ化され、タスクベースのルーティングと統合されます。新しい手法は、公開データのみでトレーニングされたモデルの CIFAR-10 で業界最高の 99.43% という新しい業界最高の認識精度を達成するなど、69 の画像分類タスクで競争力のある結果を達成しました。

CIFAR-10 に実装されたこの新しい SOTA が疑問視されており、以前の SOTA は 99.40 でした。 「この結果を生み出すには、合計 17,810 TPU コア時間が必要でした。Google で働いていない場合、これは、1 時間あたり 3.22 ドルのオンデマンド支払いを使用する必要があり、トレーニングされたモデルの費用は 57,348 ドルかかることを意味します。」

したがって、彼女は自分の魂にこう尋ねました。「ジェフ ディーンは、5 年間 4 人家族を養うのに十分なお金を費やし、CIFAR-10 で 0.03% の改善を達成し、新しい SOTA を作成しました。すべての価値がありました。 ?"

この質問は、この分野の多くの人々から反響がありました。研究者の中には、「ディープラーニングへの興味はほとんどなくなった。小さな研究室の実践者として、計算予算の面でテクノロジーの巨人と競争するのは基本的に不可能だ。たとえ良い理論的アイデアを持っていたとしても、 「これは、日の目を見ることを困難にする主流の環境における偏見でもあるかもしれません。これが不公平な競争の場を生み出します。」

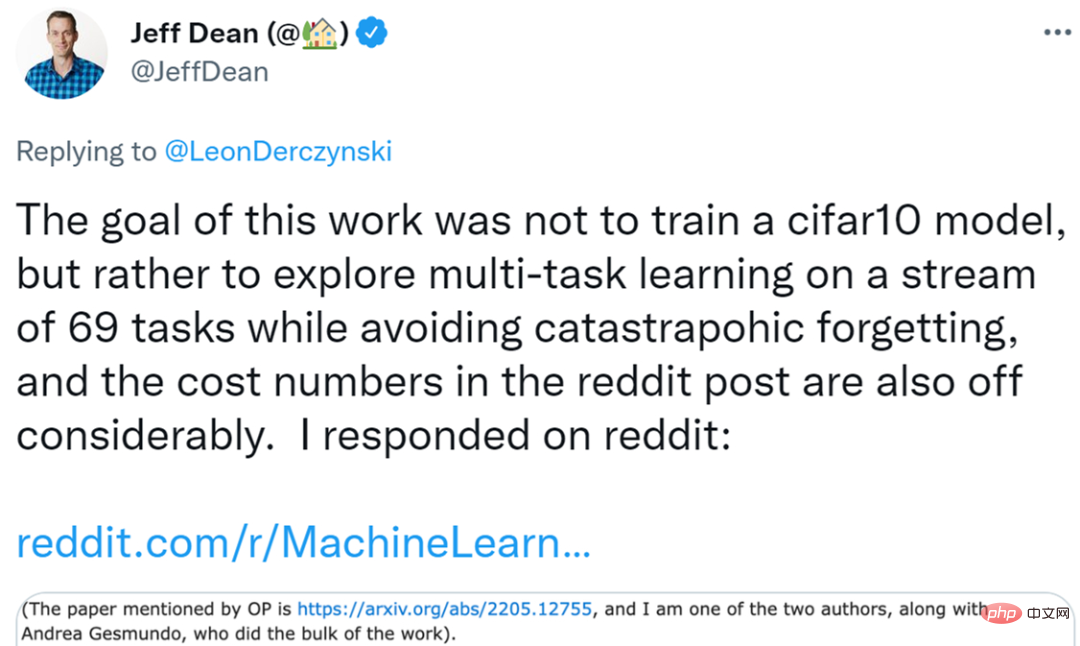

この話題が発酵し続ける中、ジェフ・ディーン氏が reddit で個人的に返答した。同氏は、「我々の研究の目的は、より高品質なcifar10モデルを取得することではなく、原著者のコスト計算方法にも問題がある」と述べた。 #Jeff Dean 返答全文

この論文はアンドレア ゲスムンドと私によって完成され、アンドレア ゲスムンドはこの論文に関する作業のほとんどを担当しました。

論文アドレス: https://arxiv.org/pdf/2205.12755.pdf

私が言いたいのは、この研究の目標は高品質なcifar10モデルを入手できません。むしろ、この研究では、実行中のシステムに新しいタスクを動的に導入し、既存のモデルからの表現を再利用し、まばらに新しいタスクの高品質なモデルを取得できる設定を検討します。新しいパラメータは、次のようなマルチタスク システムの問題を回避しながら導入されます。壊滅的な忘却または否定的な移住として。

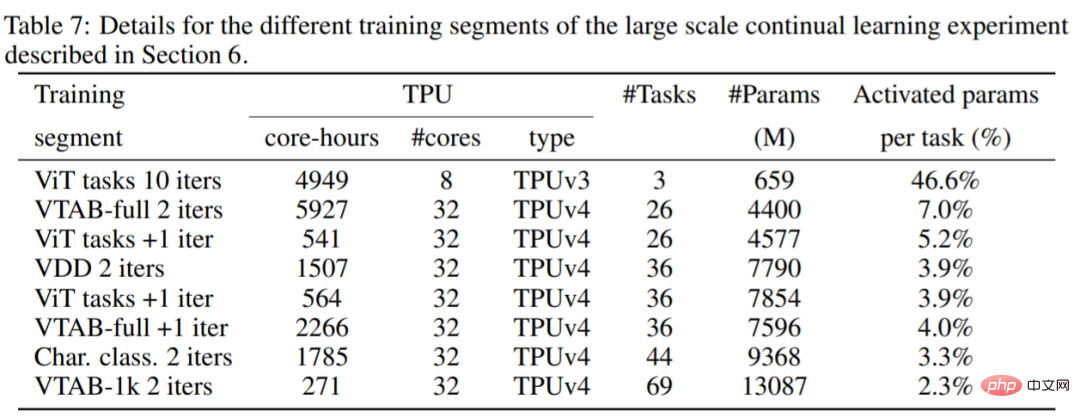

元の投稿の著者がコストを間違って計算したとも思います。実験では、cifar10 をトレーニングする代わりに、69 のタスクを共同で解決するマルチタスク モデルをトレーニングしました。モデル。以下の表 7 からわかるように、使用される計算には TPUv3 コアと TPUv4 コアが混在しているため、価格が異なるためコア時間は単純に計算できません。

特に緊急のタスクがあり、cifar10 68 タスクを迅速にトレーニングする必要がある場合を除き、実際、このタイプの研究では、先制価格のリソース、つまり TPUv4 では 0.97 ドル/時間、TPUv3 では 1 時間あたり 0.60 ドル (いわゆる「TPUv3」と呼ばれるものではありません) のリソースを簡単に使用できます。オンデマンド料金は 1 時間あたり 3.22 ドルです)。これらの仮定の下では、表 7 に示すコンピューティング パブリック クラウドのコストは約 13,960 ドル (12,861 TPUv4 チップ時間と 2,474.5 TPUv3 チップ時間のプリエンプティブル価格を使用)、つまりタスクあたり約 202 ドルになります。

私は、活性化がまばらなモデルを用意し、必要に応じて表現を共有できる既存のシステムに新しいタスクを動的に導入できるようにし、致命的な忘れを回避できることが重要だと考えています。研究は少なくとも調査する価値があります。このシステムには、特に定式化する必要なく、新しいタスクをシステムに自動的に組み込むことができるという利点もあり (これが進化的探索プロセスの機能です)、これは継続的に学習するシステムの有用な特性であると思われます。

この論文のコードはオープンソースなので、自分で見ることができます。

コード アドレス: https://github.com/google-research/google-research/tree/master/muNet

元の投稿の作成者が Jeff Dean に返信しました

Jeff Dean の返信を見た後、元の投稿の著者は次のように言いました: 明確にするために、Jeff Dean の論文 (各タスクでモデル拡張を生成するために使用される進化モデル) は非常に役立つと思います。興味深いですね、これは別の論文を思い出させますが、タイトルは思い出せません。それは、各層への入力の一部として他のモジュールの隠れた状態を使用して、新しいタスクごとにアーキテクチャ全体に新しいモジュールを追加するというものでした。ただし、既存のコンポーネントの重みは更新されません。

各タスクのモデルにモジュールを構築するというアイデアもあります。赤ちゃん鹿は、どうやって生まれてから数分以内に歩けるようになるかご存知ですか?対照的に、当時、生まれたばかりの子鹿には、動きを感知したり世界をモデル化することを学ぶための「トレーニング データ」が基本的になく、代わりに子鹿が基本的なスキルを身に付けるために継承する必要のある脳内の特殊な構造を利用する必要がありました。 。これらの構造は非常に役立つため、ある意味、新しい、しかし関連する制御タスクにすぐに一般化できるでしょう。

そこで、この論文をきっかけに、新しいタスクをより効率的に学習するために使用できる、既存の継承可能な構造の開発について考えるようになりました。

別の研究室の研究者も同じ考えを持っているかもしれませんが、既存のセットアップから大規模なクラウド プラットフォームに移行する余裕がないため、さらに悪い結果が得られます。そして、コミュニティは現在 SOTA の結果に過度に注目しているため、彼らの研究は出版できません。コストはタスクあたり「わずか」 202 ドルですが、物事を正しく行うには多くの反復が必要です。

したがって、多額のコンピューティング予算を利用できない人にとって、選択肢は基本的に 2 つです。 1 つは、Google が既存のモデルを公的に配布し、私たちのニーズに合わせて微調整できるように祈って願うことです。しかしその結果、モデルは私たちが排除できないバイアスや敵対的な弱点を学習した可能性があります。 2つ目は何もせず横になることです。

つまり、私の問題はこの研究だけではありません。 OpenAI が GPT-4 に(比喩的に言えば)数千億ドルを費やしたいのであれば、より多くの力を与えてください。これは、人々が実際の仕事でより良くなるのを助けるのではなく、華やかさ、大規模な数字、贅沢に過度に報酬を与える科学文化と出版文化です。私のお気に入りの論文は、2019 年の van der Oord による「対比予測コーディングによる表現学習」で、教師なしの事前トレーニング タスクを使用し、ラベルの小さなサブセットで教師付きトレーニングを使用して、レプリカラベル付きのすべてのデータの精度結果を達成します。データ効率の観点から見たこの改善。これらの結果を再現して仕事に使用し、時間とお金を節約しました。この論文に基づいて、私は喜んで彼の博士課程の学生になりたいと思っています。

しかし、OpenAI は論文「Language Models are Few-Shot Learners」でより大きなトランスフォーマー モデル GPT-3 を提案しました。この論文は 4,000 近く引用され、NeurIPS 2020 最優秀論文賞を受賞し、メディア全体の注目も獲得しました。 。

以上がこの研究には疑問が投げかけられ、ジェフ・ディーンはこう答えた。「私たちは新しいSOTAを手に入れようとしていたわけではないし、コスト計算も間違っていた。」の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。