この記事は WeChat 公開アカウント「情報時代に生きる」から転載したものであり、著者は情報時代に生きています。この記事を転載するには、情報時代の暮らしの公開アカウントまでご連絡ください。

リカレント ニューラル ネットワーク (RNN) は、主にシーケンス データの問題を解決するために使用されます。これがリカレント ニューラル ネットワークである理由は、シーケンスの現在の出力が前の出力にも関連しているためです。 RNN ネットワークは、直前の瞬間の情報を記憶し、現在の出力計算に適用します。畳み込みニューラル ネットワークとは異なり、リカレント ニューラル ネットワークの隠れ層のニューロンは相互に接続されています。隠れ層のニューロンの入力は、層は入力によって決定されます。層の出力は、前の瞬間の隠れたニューロンの出力で構成されます。 RNN ネットワークはいくつかの顕著な成果を達成しましたが、トレーニングの難易度が高い、精度が低い、効率が低い、時間がかかるなどのいくつかの欠点と制限があります。そのため、RNN に基づくいくつかの改良されたネットワーク モデルが徐々に開発されています。として: Long Short-Term Memory (LSTM)、双方向 RNN、双方向 LSTM、GRU など。これらの改良された RNN モデルは、画像認識の分野で優れた結果を示し、広く使用されています。 LSTM ネットワークを例として、その主なネットワーク構造を紹介します。

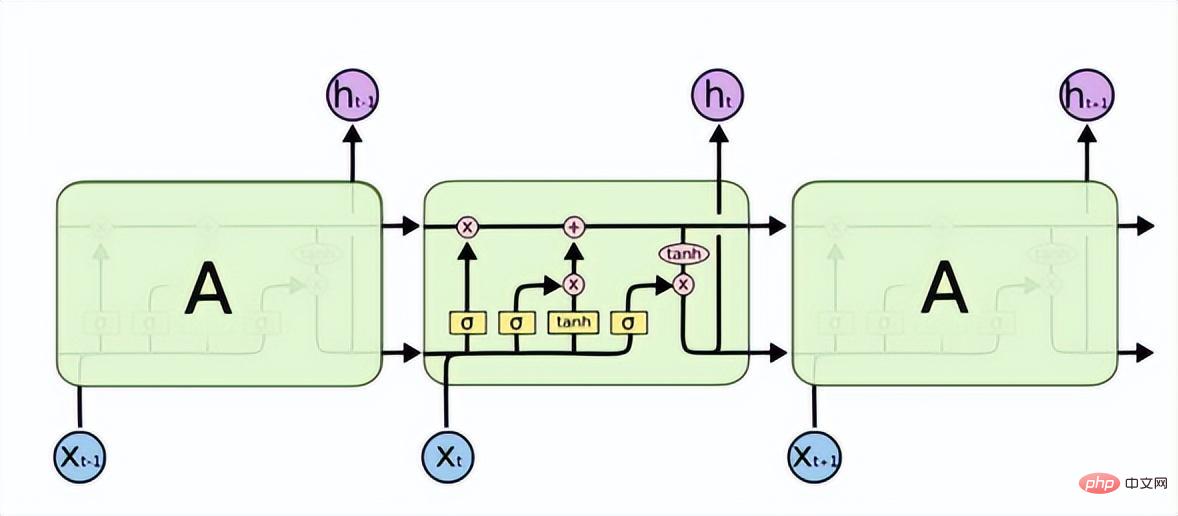

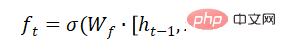

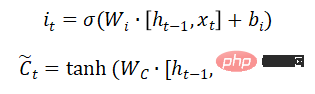

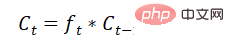

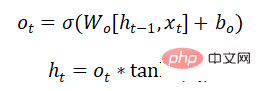

Long Short-Term Memory (LSTM) は、RNN における勾配消失または勾配爆発の問題を解決し、長期依存問題を学習できます。その構造は次のとおりです。

以上が画像認識について話しましょう: リカレント ニューラル ネットワークの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。