Google は、2020 年の早い段階で、当時最も強力な AI チップである TPU v4 を自社のデータセンターに導入しました。

しかし、Google がこの AI スーパーコンピューターの技術的詳細を初めて発表したのは、今年 4 月 4 日のことでした。

文書アドレス: https://arxiv.org/abs/2304.01433

TPU v3 と比較して、TPU v4 のパフォーマンスは 2.1 倍高く、4096 チップを統合した後のスーパーコンピューターのパフォーマンスは 10 倍向上します。

さらに、Google は、自社のチップが Nvidia A100 よりも高速でエネルギー効率が高いとも主張しています。

Google は論文の中で、同等のサイズのシステムでは TPU v4 が必要であると述べています。 NVIDIA A100 よりも 1.7 倍優れたパフォーマンスを提供しながら、エネルギー効率も 1.9 倍向上します。

さらに、Google のスーパーコンピューティング速度は、Graphcore IPU Bow よりも約 4.3 倍から 4.5 倍高速です。

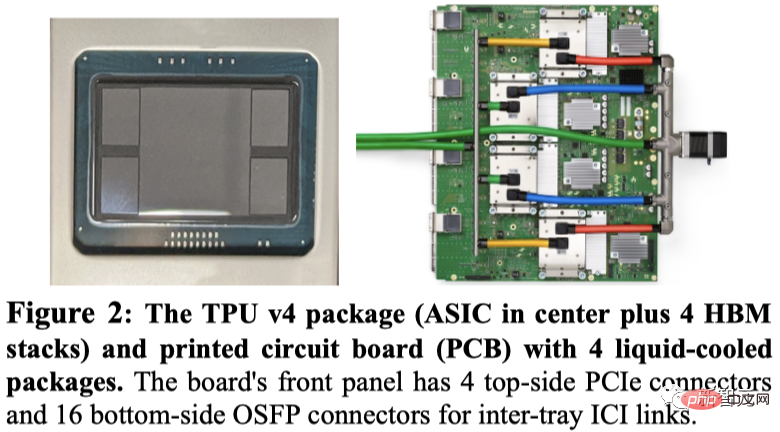

Google は、TPU v4 パッケージと、回路基板に実装された 4 つのパッケージをデモしました。

TPU v3 と同様、各 TPU v4 には 2 つの TensorCore (TC) が含まれています。各 TC には、4 つの 128x128 行列乗算ユニット (MXU)、128 チャネル (チャネルあたり 16 ALU) を持つベクトル処理ユニット (VPU)、および 16 MiB ベクトル メモリ (VMEM) が含まれています。

2 つの TC は 128 MiB の共通メモリ (CMEM) を共有します。

A100 チップと Google の第 4 世代 TPU が同時に発売されたことは注目に値します。そのため、具体的なパフォーマンスはどのように比較されるのでしょうか?

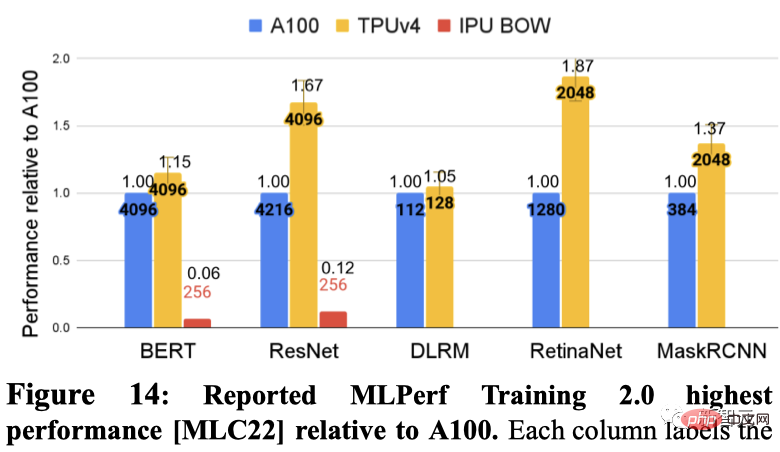

Google は、5 つの MLPerf ベンチマークで各 DSA の最速パフォーマンスを個別に実証しました。これらには、BERT、ResNET、DLRM、RetinaNet、MaskRCNN が含まれます。

その中で、Graphcore IPU は BERT と ResNET で結果を提出しました。

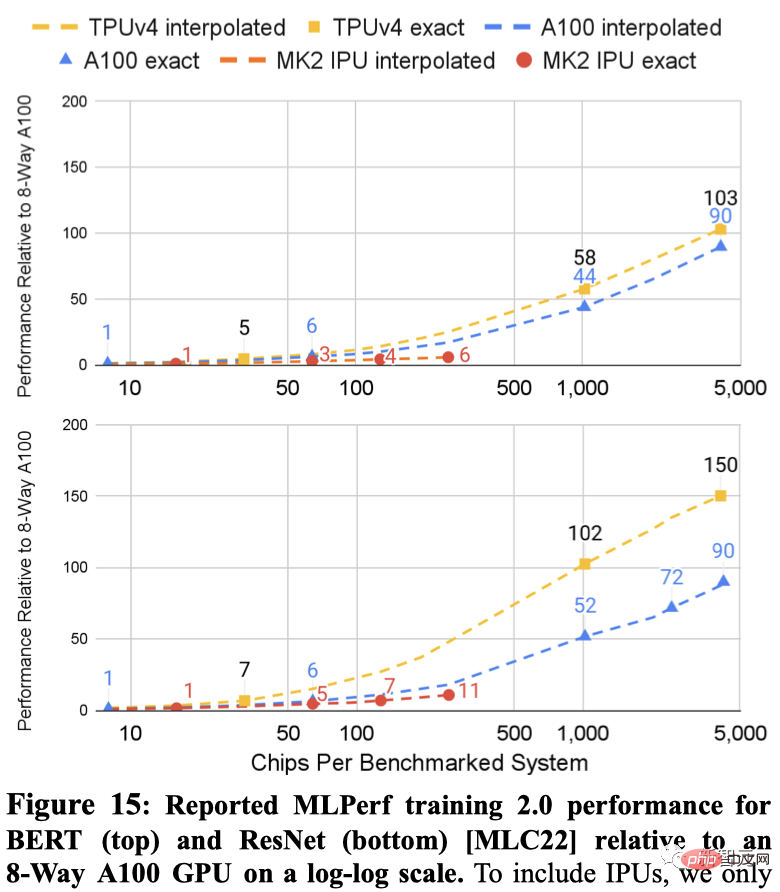

ResNet と BERT の 2 つのシステムの結果を以下に示します。点間の点線はチップ数に基づく補間です。

TPU v4 と A100 の両方の MLPerf 結果は、IPU よりも大規模なシステム (4096 チップ対 256 チップ) まで拡張できます。

同様のサイズのシステムの場合、TPU v4 は BERT 上で A100 より 1.15 倍、IPU より約 4.3 倍高速です。 ResNet の場合、TPU v4 はそれぞれ 1.67 倍、約 4.5 倍高速です。

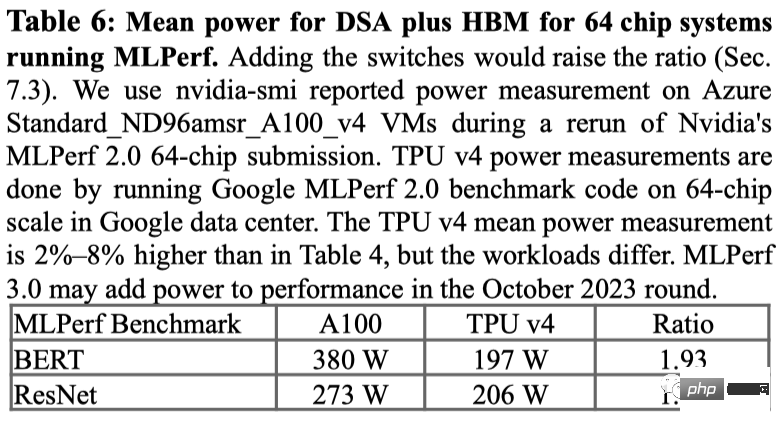

MLPerf ベンチマークでの電力使用量については、A100 は平均して 1.3 倍から 1.9 倍の電力を使用しました。

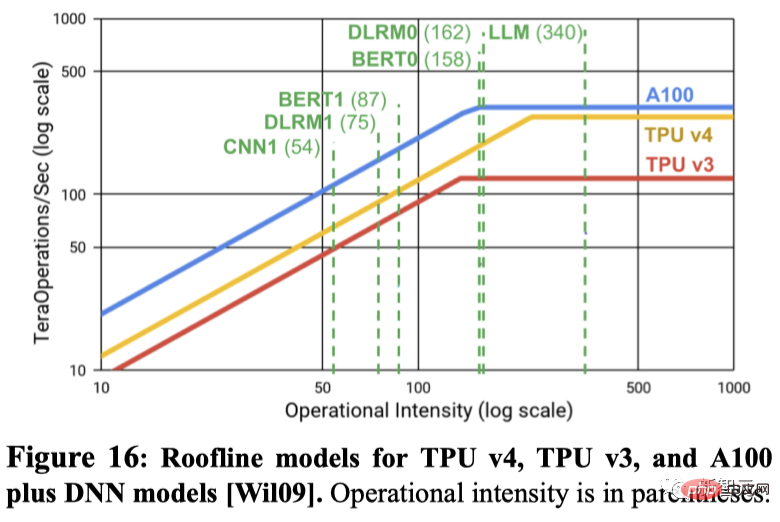

たとえば、TPU v4 は、1 秒あたりのピーク浮動小数点演算では 1.10 倍の利点しかないにもかかわらず、2 つの MLPerf ベンチマークでは、同じサイズのシステム上の IPU Bow よりも 4.3 倍から 4.5 倍高速です。 別の例では、A100 の 1 秒あたりのピーク浮動小数点演算は TPU v4 の 1.13 倍ですが、同じチップ数の場合、TPU v4 は 1.15 ~ 1.67 倍高速です。 次の図は、ルーフライン モデルを使用して、ピーク FLOPS/秒とメモリ帯域幅の関係を示しています。 そこで問題は、なぜ Google が Nvidia の最新の H100 と比較しないのかということです。 Googleは、H100はGoogleのチップ発売後の新しいテクノロジーを使用して構築されたため、第4世代製品をNvidiaの現在の主力チップであるH100チップと比較しなかったと述べた。 ただし、Google は Nvidia H100 と競合する新しい TPU を開発していることを示唆しましたが、詳細は明らかにしませんでした。グーグルの研究者ジュッピ氏はロイターのインタビューで、グーグルには「将来のチップの生産ライン」があると述べた。 ChatGPT と Bard が「戦っている」一方で、2 つの巨大企業も舞台裏で稼働を維持するために懸命に働いています - NVIDIA CUDA サポートGPU (グラフィックス プロセッシング ユニット) と Google がカスタマイズした TPU (テンソル プロセッシング ユニット)。 言い換えれば、これはもはや ChatGPT 対 Bard の問題ではなく、TPU 対 GPU、そして行列乗算をいかに効率的に実行できるかの問題です。 ハードウェア アーキテクチャの優れた設計により、NVIDIA の GPU は行列乗算タスクに最適であり、複数の CUDA コア間で効果的に切り替え、並列処理を実装します。 したがって、2012 年以降、GPU 上でモデルをトレーニングすることがディープラーニングの分野のコンセンサスとなり、それは今日に至るまで変わっていません。 NVIDIA DGX の発売により、NVIDIA は、知的財産権の欠如により競合他社が提供できない、ほぼすべての AI タスクに対するワンストップのハードウェアおよびソフトウェア ソリューションを提供できるようになります。 対照的に、Google は 2016 年に第 1 世代のテンソル プロセッシング ユニット (TPU) を発売しました。これにはカスタム ASIC (専用集積回路) が含まれているだけでなく、独自のアプリケーション向けに最適化されています。 TensorFlow フレームワーク。これにより、TPU は行列乗算以外の他の AI コンピューティング タスクでも利点が得られ、微調整タスクや推論タスクを高速化することもできます。 さらに、Google DeepMind の研究者は、より優れた行列乗算アルゴリズムである AlphaTensor を作成する方法も発見しました。 ただし、Google が自社開発テクノロジーと新たな AI コンピューティング最適化手法を通じて良好な結果を達成したにもかかわらず、Microsoft と Nvidia の長期にわたる綿密な協力は、それぞれの専門知識に依存してきました。製品の蓄積により、双方の競争優位性が同時に拡大しました。 #第 4 世代 TPU 「これは、当社が Google に導入した中で最速のシステムであり、当社にとって歴史的なマイルストーンです。」

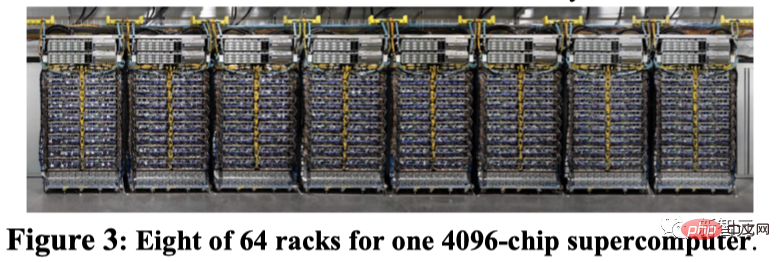

これは、単一のチップが保存できる容量よりもはるかに大きく、コンピューティング パワーの需要が巨大な「ブラック ホール」であることを意味します。 したがって、これらの大規模なモデルは数千のチップに分散する必要があり、その後、モデルをトレーニングするためにそれらのチップが数週間、またはさらに長い間連携して動作する必要があります。 現在、これまでに公開された Google の最大の言語モデルである PaLM には 5,400 億個のパラメータがあり、これを 2 台の 4,000 チップ スーパーコンピュータに分割して 50 日以内にトレーニングしました。 Google によると、自社のスーパーコンピューターはチップ間の接続を簡単に再構成して問題を回避し、パフォーマンスの調整を行うことができます。 Google 研究者の Norm Jouppi 氏と Google の著名なエンジニア David Patterson 氏は、このシステムについてブログ投稿で次のように書いています。 「回線切り替えによりバイパスが可能になります。 「故障したコンポーネントを簡単に克服できます。この柔軟性により、スーパーコンピューターの相互接続のトポロジを変更して、機械学習モデルのパフォーマンスを加速することもできます。」 Google は現在、関連する詳細を公開しているところですが、そのスーパーコンピューターは、オクラホマ州メイズ郡にあるデータセンターで 2020 年からオンラインになっています。 Google によると、Midjourney はモデルのトレーニングにこのシステムを使用しており、最新バージョンの V5 では誰もが驚くべき画像生成を確認できるとのことです。 最近、ピチャイ氏はニューヨーク・タイムズとのインタビューで、バード氏がLaMDAからPaLMに異動すると述べた。 TPU v4 スーパーコンピューターの恩恵を受けて、Bard はさらに強くなります。

TPU と GPU

##Google の Bard や OpenAI の ChatGPT のような大規模な言語モデルがパラメータ スケールで実装されているため、この改善は AI スーパーコンピュータを構築する企業間の競争において重要なポイントとなっています。

##Google の Bard や OpenAI の ChatGPT のような大規模な言語モデルがパラメータ スケールで実装されているため、この改善は AI スーパーコンピュータを構築する企業間の競争において重要なポイントとなっています。

以上がGoogleの超AIスーパーコンピューターがNVIDIA A100を粉砕! TPU v4性能10倍向上、詳細初公開の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。