GPT4All は、大量のクリーンなアシスタント データ (コード、ストーリー、会話を含む) に基づいてトレーニングされたチャットボットです。データには、GPT-3.5-Turbo で生成された約 800,000 個のデータが含まれています。LLaMa に基づいて完成されており、 M1 Mac、Windows、その他の環境で使用可能。おそらくその名前が示すように、誰もが個人用 GPT を使用できる時代が来たのです。

OpenAI が ChatGPT をリリースして以来、ここ数か月でチャットボットの人気が高まっています。

ChatGPT は強力ですが、OpenAI がそれをオープンソース化することはほぼ不可能です。多くの人が、少し前に Meta によってオープンソース化された LLaMA など、オープンソースに取り組んでいます。 70億から650億の範囲のパラメータ量を持つ一連のモデルの総称であり、その中でも130億パラメータのLLaMAモデルは「ほとんどのベンチマークで」1750億パラメータのGPT-3を上回る性能を発揮します。

LLaMA のオープン ソースは多くの研究者に利益をもたらしています。たとえば、スタンフォード大学は LLaMA に命令チューニングを追加し、Alpaca (LLaMA 7B に基づく) と呼ばれる新しい 70 億パラメータ モデルをトレーニングしました。結果は、パラメータが 7B しかない軽量モデルである Alpaca のパフォーマンスが、GPT-3.5 などの非常に大規模な言語モデルに匹敵することを示しています。

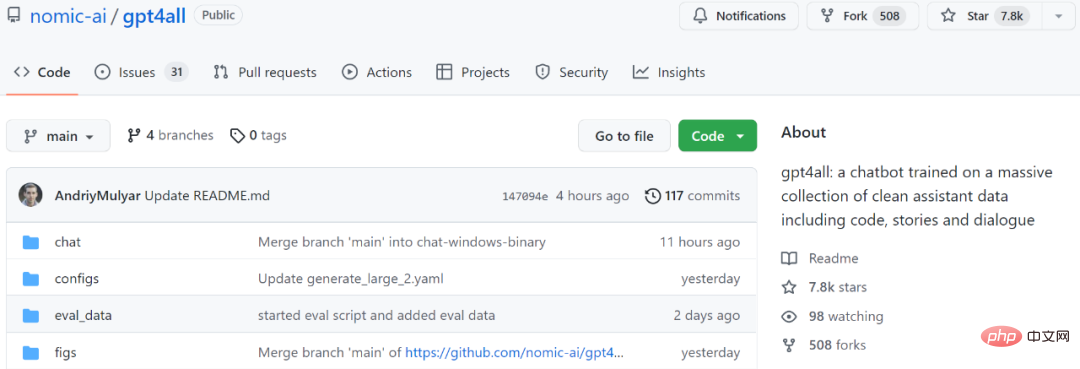

別の例として、次に紹介するモデル GPT4All も、LLaMA に基づく新しい 7B 言語モデルです。プロジェクト開始から 2 日後、スターの数は 7.8k を超えました。

プロジェクトアドレス: https://github.com/nomic-ai/gpt4all

簡単に言うと、GPT-3.5 では GPT4All は 800k です。ターボ トレーニングは、テキストの質問、ストーリーの説明、複数ラウンドの対話、コードなどのデータに対して実行されます。

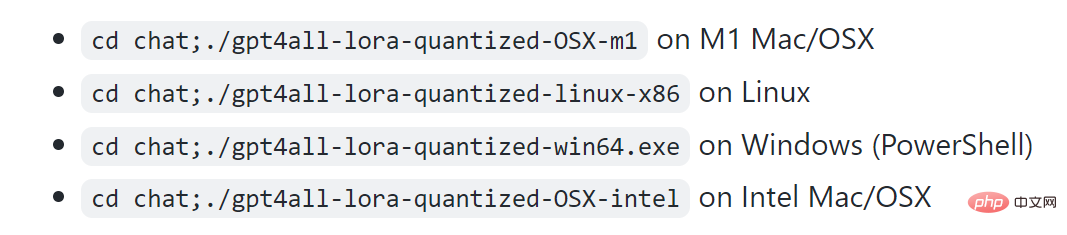

プロジェクト表示によると、M1 は Mac、Windows などの環境で実行できます。

まずは効果を見てみましょう。以下の図に示すように、ユーザーはモデルに「ラップトップで大規模な言語モデルを実行できますか?」と尋ねるなど、何の障壁もなく GPT4All と通信できます。GPT4All の答えは次のとおりです。「はい、ラップトップを使用してトレーニングや学習を行うことができます」ニューラル ネットワークや他の自然言語 (英語や中国語など) の機械学習モデルをテストします。重要なのは、これらのモデルのサイズに対応できる十分な空きメモリ (RAM) が必要であることです..."

次は、分からない場合は、必要なメモリ量を GPT4All に尋ね続けると、答えが得られます。結果から判断すると、複数ラウンドの対話を実行する GPT4All の能力は依然として非常に強力です。

#M1 Mac でのリアルタイム サンプリング

この研究を「革新的」と呼ぶ人もいます。ルール、GPT4All のおかげで、MacBook 上でローカルに GPT を実行できるようになりました。"

1. データの収集と整理

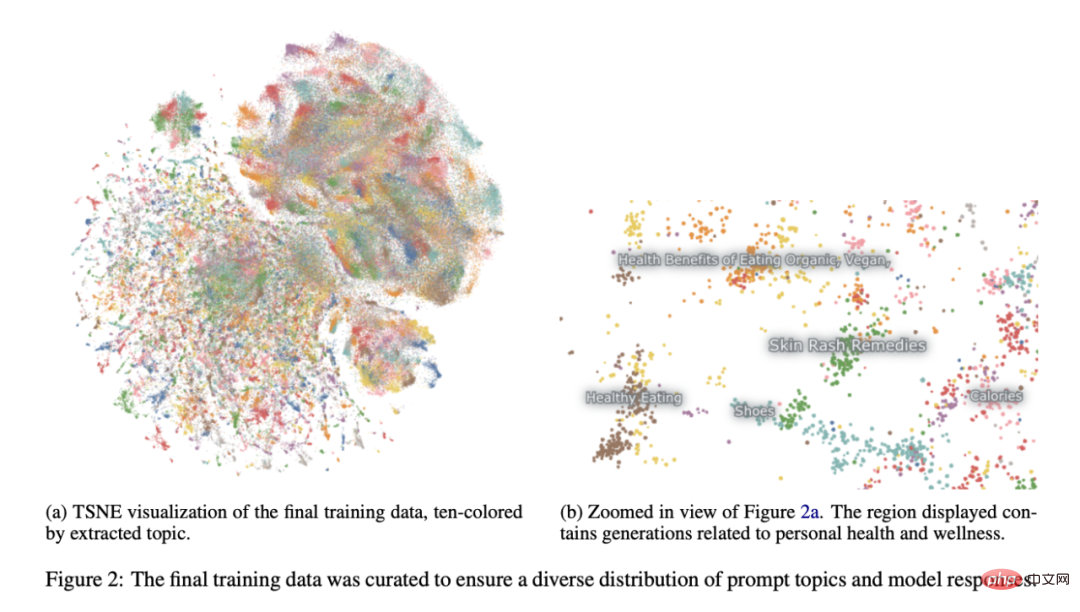

2023 年 3 月 20 日から 2023 年 3 月 26 日までの期間、研究者は、 GPT-3.5-Turbo OpenAI API を使用して、約 100 万組のプロンプト応答を収集しました。 まず、研究者らは、公開されている 3 つのデータセットを利用して、さまざまな質問/プロンプトのサンプルを収集しました。スタンフォード大学のアルパカプロジェクト (Taori et al., 2023) を参照すると、研究者たちはデータの準備と編成に多大な注意を払ってきました。プロンプトによって生成されたペアの初期データセットを収集した後、データを Atlas にロードして整理し、GPT-3.5-Turbo がプロンプトに応答できず、不正な出力を生成したサンプルをすべて削除しました。これにより、サンプルの総数が 806,199 個の高品質プロンプト生成ペアに減ります。次に、出力の多様性が非常に低かったため、最終トレーニング データセットから Bigscience/P3 サブセット全体を削除しました。 P3 には、GPT-3.5-Turbo からの短く均一な応答を生成する多くの均一なプロンプトが含まれています。

この消去法により、図 2 に示すように、最終的に 437,605 個のプロンプト生成ペアのサブセットが得られました。

モデル トレーニング

研究者らは、LLaMA 7B のインスタンスで複数のモデルを組み合わせました (Touvron et al., 2023)調整。彼らのオリジナルの公開関連モデルは、4 エポックにわたる 437,605 の後処理された例で LoRA (Hu et al., 2021) を使用してトレーニングされました。詳細なモデルのハイパーパラメーターとトレーニング コードは、関連するリソース ライブラリとモデル トレーニング ログにあります。

再現性

研究者らは、コミュニティが再現できるよう、すべてのデータ (未使用の P3 世代を含む)、トレーニング コード、モデルの重みを公開しました。興味のある研究者は、Git リポジトリで最新のデータ、トレーニングの詳細、チェックポイントを見つけることができます。

コスト

研究者らがこれらのモデルを作成するのに約 4 日かかり、GPU のコストは 800 ドルでした (いくつかの失敗したトレーニングを含め、Lambda Labs と Paperspace から借りました) 、500 ドルの OpenAI API 料金に加えて。

最終リリースモデル gpt4all-lora は、Lambda Labs の DGX A100 8x 80GB で約 8 時間、合計コスト 100 ドルでトレーニングできます。

このモデルは一般的なノートパソコンでも動作し、ネット民の意見では「電気代以外にコストはかからない」とのことです。

このモデルは一般的なノートパソコンでも動作し、ネット民の意見では「電気代以外にコストはかからない」とのことです。

以上がラップトップ上で実行できる ChatGPT の代替品がここにあり、完全な技術レポートが添付されています。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。