OpenAI の共同創設者である Greg Brockman と主任科学者の Ilya Sutskever が GPT-4 のパフォーマンスを評価し、セキュリティの問題とオープンソースの論争について説明します。

GPT-4 がリリースされると、業界全体と学術界全体が爆発したことは疑いの余地がありません。

その強力な推論とマルチモーダルな機能により、多くの白熱した議論を引き起こしました。

ただし、GPT-4 はオープンモデルではありません。

OpenAI は GPT-4 の多数のベンチマークとテスト結果を共有しましたが、基本的にトレーニングに使用されたデータ、コスト、モデルの作成に使用された方法は提供していませんでした。

もちろん、OpenAIがそのような「独占秘密」を公表することは絶対にありません。

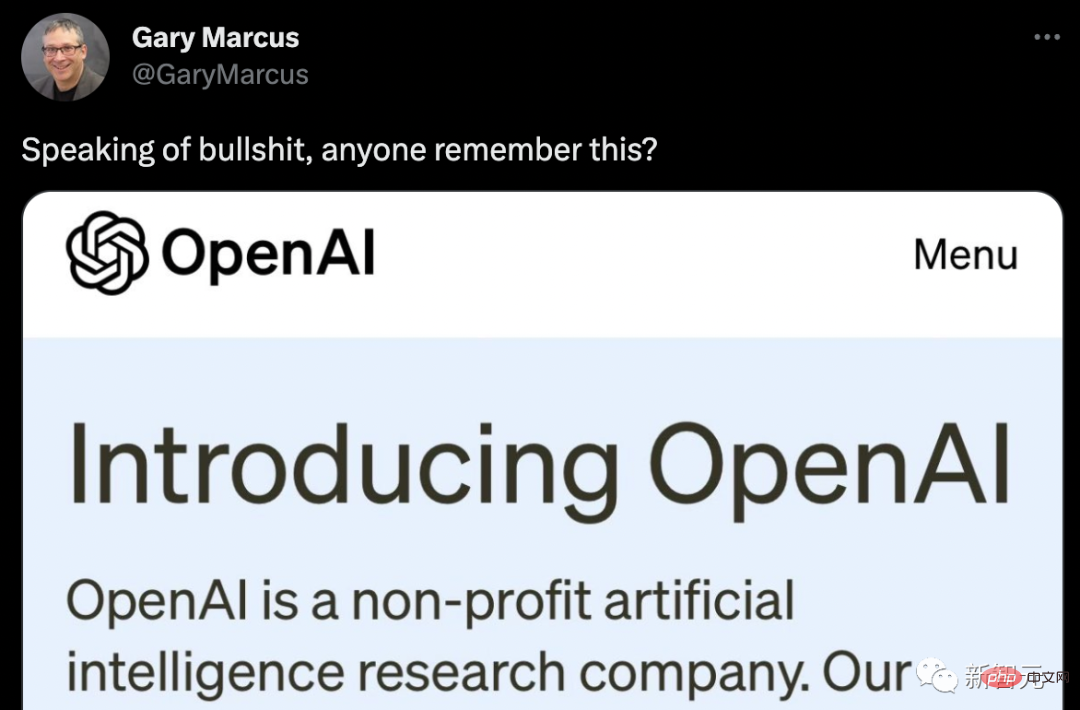

Marcus は OpenAI の本来の意図を直接取り出して、嘲笑の波を投稿しました。

ネチズンがバージョンを改良しました。

OpenAI の社長兼共同創設者であるグレッグ ブロックマンは、GPT-4 と GPT-3 を比較したとき、次の言葉を言いました --違う。

「ただ違います。モデルにはまだ多くの問題やバグがあります...しかし、微積分や法則などのスキルが向上しているのが実際にわかります。一部の領域では、パフォーマンスが非常に低かった状態から、

GPT-4 のテスト結果は非常に良好です。AP Calculus BC 試験では、GPT-4 は 4 点を獲得しましたが、GPT は 4 点を獲得しました。 -3で1点獲得。模擬司法試験では、GPT-4 は受験者の上位 10% 程度のスコアで合格しましたが、GPT-3.5 のスコアは下位 10% に留まりました。

コンテキスト機能、つまりテキストを生成する前に記憶できるテキストに関して、GPT-4 は GPT-3 の 8 倍である約 50 ページのコンテンツを記憶できます。

プロンプトに関しては、GPT-3 と GPT-3.5 は「キリンに関する記事を書いてください」というテキスト プロンプトのみを受け入れることができますが、マルチモーダル GPT-4 は画像とテキスト プロンプトを受け入れることができます: Give Show a pictureキリンの質問に「キリンは何匹いますか?」と尋ねると、これらの GPT-4 は正しく答えることができ、ミームを読み取る能力も非常に強力です。

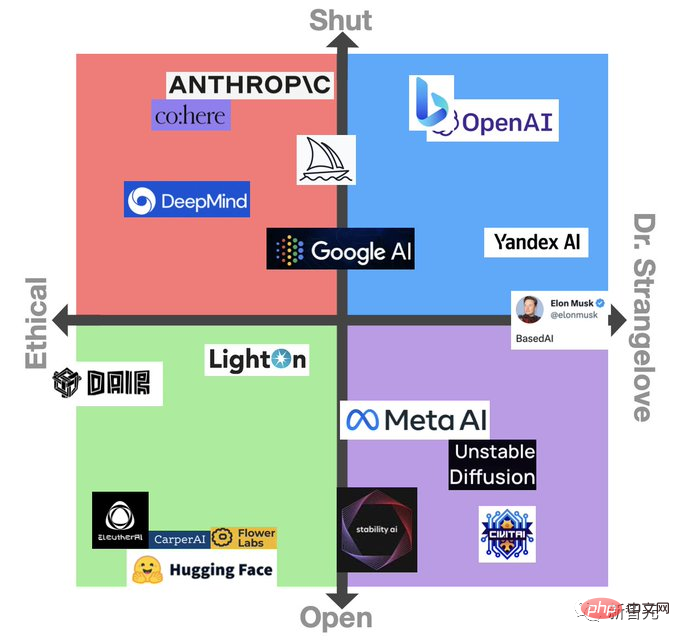

途方もなく強力な GPT-4 がリリースされるとすぐに、多くの研究者や専門家の関心を呼び起こしました。しかし残念なのは、OpenAI がリリースした GPT-4 が「オープン AI モデル」ではないということです。

OpenAI は GPT-4 のベンチマーク、テスト結果、興味深いデモを多数共有してきましたが、基本的には不要です。システムのトレーニングに使用されるデータ、エネルギーコスト、またはシステムの作成に使用される特定のハードウェアや方法に関する情報を提供します。

Meta の LLaMa モデルが以前に漏洩したとき、それはオープンソースに関する議論の波を引き起こしました。しかし、今回の GPT-4 クローズド モデルに対するみんなの最初の反応は、ほとんどが否定的なものでした。

人工知能コミュニティでは、これが研究機関としての OpenAI の設立精神を損なうだけでなく、他の企業が対処するための安全策を開発することを困難にするという一般的な感覚があります。脅迫付きで。

Nomic AI の情報デザイン担当バイスプレジデント、Ben Schmidt 氏は、GPT-4 がどのようなデータに基づいてトレーニングされたのかを見ることができなければ、システムがどこで安全に使用して提案できるかを誰もが知るのは難しいと述べました。修正します。

「このモデルがどこで機能しないのかを人々が理解できるように、OpenAI は GPT-4 の動作とその前提をより深く理解する必要があります。雪が降っていない人を信用するつもりはありません」 「雪が降っているとき。自動運転車は現地の気候条件で訓練された。なぜなら、抜け穴や問題は実際の使用中にのみ現れる可能性が高いからである。」

この点に関して、首席科学者で共同創設者のイリヤ・サツケヴァー氏は述べています。 OpenAI の説明 : OpenAI が競争を恐れ、またセキュリティへの懸念から、GPT-4 に関するこれ以上の情報を共有しないのは間違いありません。

「外部の競争は熾烈であり、GPT-4 の開発は簡単ではありません。OpenAI のほぼすべての従業員が、これを開発するために長い間協力してきました。競争の観点から見ると、多くの企業が存在します」

誰もが知っているように、OpenAI は 2015 年に設立された時点では非営利団体でした。創設者には、Sutskever氏、現CEOのSam Altman氏、社長のGreg Brockman氏、そしてOpenAIを退社したMusk氏が含まれる。

サツケヴァー氏らは、この組織の目標は株主だけでなくすべての人に価値を生み出すことだとし、この分野のすべての関係者と「自由に協力する」と述べた。

しかし、数十億ドルの投資 (主にマイクロソフトから) を獲得するために、OpenAI には依然として商用属性のレイヤーが与えられています。

しかし、なぜ OpenAI がその研究を共有するアプローチを変更したのかと尋ねられたとき、Sutskever 氏は次のように単純に答えました。

「私たちは間違っていました。ある時点で、AI/AGI は非常に強力になるでしょう。そしてその時には、オープンソースは意味をなさないでしょう。数年以内に、誰もがオープンソースの人工的なものであることを完全に理解するでしょう。」知性は賢明ではありません。なぜなら、このモデルは非常に強力だからです。もし誰かがその気になれば、それを使って大ダメージを与えるのは非常に簡単でしょう。ですから、モデルの能力がますます高くなるにつれて、それを明らかにしたくないのは当然です。」

Lightning AI の CEO であり、オープンソース ツール PyTorch Lightning の作成者である William Falcon 氏は、ビジネスの観点から次のように説明しました: 「企業として、これを行うあらゆる権利があります。」

同時に、ブロックマン氏は、OpenAI がリスクと利点を評価しているため、GPT-4 のアプリケーションの推進はゆっくりと推進すべきであるとも考えています。

「顔認識や人物の画像の扱い方など、いくつかの政策課題を解決する必要があります。危険地帯がどこにあるのか、レッドラインがどこにあるのかを把握し、これらの点をゆっくりと明らかにする必要があります。 ."

GPT-4 が悪さをするために使用されるリスクという決まり文句もあります。

イスラエルのサイバーセキュリティスタートアップ Adversa AI は、OpenAI のコンテンツ フィルターをバイパスして、GPT-4 によるフィッシングメールの生成、同性愛者の性的記述、その他の非常に不快なコンテンツの生成を可能にする方法を説明するブログ投稿を公開しました。

したがって、多くの人は GPT-4 が監査に大幅な改善をもたらすことを期待しています。

これに応じて、ブロックマン氏は、GPT-4 の機能を理解するために多くの時間を費やし、このモデルには 6 か月のセキュリティ トレーニングが行われていると強調しました。内部テストでは、GPT-4 は OpenAI の使用ポリシーで許可されていないコンテンツに応答する可能性が GPT-3.5 より 82% 低く、「事実に基づく」応答を生成する可能性が 40% 高かったです。

しかし、ブロックマン氏は、この点で GPT-4 に欠点があることを否定しません。しかし同氏は、このモデルの新しい緩和指向ツールである「システム情報」と呼ばれる API レベルの機能を強調した。

システム メッセージは本質的に、GPT-4 対話の雰囲気を設定し、境界を確立する指示です。このように、システム情報をガードレールとして利用することで、GPT-4の方向性の逸脱を防ぐことができます。

たとえば、システム メッセージのペルソナは次のようになります。「あなたは、常にソクラテス的な方法で質問に答える家庭教師です。あなたは決して生徒に答えを与えることはありませんが、常に正しい答えを考え出そうと努めています。」

実際、サツケヴァー氏も批判者たちにある程度同意している。これらのモデルを研究してください。私たちはそれらについてさらに学ぶでしょう、それは良いことになるでしょう。」

したがって、OpenAI は、これらの理由から、特定の学術機関や研究機関にそのシステムへのアクセスを提供しています。

そしてブロックマン氏は、人工知能モデルのパフォーマンスを評価するための OpenAI の新たなオープンソース ソフトウェア フレームワークである Evals についても言及しました。

Evals ではモデルのテストにクラウドソーシングのアプローチを採用しており、ユーザーは GPT-4 などのモデルを評価するためのベンチマークを開発して実行しながらパフォーマンスを確認できます。これも OpenAI の「音」へのこだわりの 1 つです。モデル。

「Evals を通じて、ユーザーが関心のあるユースケースを確認し、体系的な方法でテストできるようになります。私たちがオープンソースである理由の 1 つは、新しいモデルのリリースから移行していることです。 「3 か月ごとに新しいモデルを継続的に改善します。新しいモデルのバージョンを作成するとき、オープンソースを通じて少なくとも変更内容を知ることができます。」

実際、研究の共有に関する議論は常に非常に白熱しています。 。一方で、Google や Microsoft のようなテクノロジー大手は、これまでの倫理的懸念を脇に置いて、自社製品への AI 機能の追加を急いでいます。Microsoft は最近、AI 製品が倫理に準拠していることを保証することに専念するチームを解雇しました)。 ; テクノロジーの急速な進歩により、人工知能に対する懸念が高まっています。

これらのさまざまな圧力のバランスをとることは、ガバナンスに関する重大な課題を引き起こしており、第三者規制当局の関与が必要になる可能性があることを意味すると、英国の AI 政策責任者ジェス・ホイットルストーン氏は述べています。

「GPT-4 についてこれ以上詳細を共有しないという OpenAI の意図は良いことですが、人工知能の世界における権力の集中につながる可能性もあります。これらの決定は個々の企業が行うべきではありません。」

ホイットルストーン氏は次のように述べています。「理想的には、ここでの慣行を成文化してから、独立した第三者に特定のモデルに関連するリスクをレビューしてもらう必要があります。」

以上がGPT-4 は非常に強力なので、OpenAI が開くことを拒否します。主任科学者: オープンソースは賢明ではありません、私たちは以前は間違っていましたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。