この記事ではPythonを使って求人サイトから情報を取り込む方法を紹介します

今回取り込んだ情報はZhaopinの求人サイトで「データアナリスト」を検索した後の情報です。

pythonバージョン: python3.5。

メインで使っているパッケージは Beautifulsoup + Requests + csv です

さらに、募集内容の簡単な説明も掴みました。

csvファイルに出力後、Excelで開くと文字化けが発生しましたが、ファイルソフト(notepad++など)で開くと問題ありませんでした。

Excelで開いたときに正しく表示するために、pandasを使用して以下を変換し、列名を追加しました。変換が完了すると、正しく表示されるようになります。 pandas での変換については、私のブログを参照してください:

募集内容は記述が多いので、最後に csv ファイルを Excel ファイルとして保存し、見やすい形式に調整します。

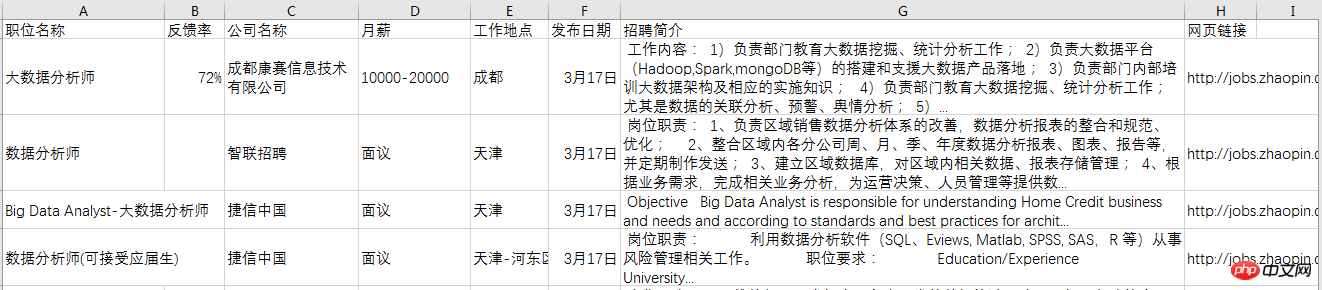

最終的な効果は次のとおりです:

実装コードは次のとおりです: 情報クローリングのコードは次のとおりです:

# Code based on Python 3.x

# _*_ coding: utf-8 _*_

# __Author: "LEMON"

from bs4 import BeautifulSoup

import requests

import csv

def download(url):

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64; rv:51.0) Gecko/20100101 Firefox/51.0'}

req = requests.get(url, headers=headers)

return req.text

def get_content(html):

soup = BeautifulSoup(html, 'lxml')

body = soup.body

data_main = body.find('div', {'class': 'newlist_list_content'})

tables = data_main.find_all('table')

zw_list = []

for i,table in enumerate(tables):

if i == 0:

continue

temp = []

tds = table.find('tr').find_all('td')

zwmc = tds[0].find('a').get_text()

zw_link = tds[0].find('a').get('href')

fkl = tds[1].find('span').get_text()

gsmc = tds[2].find('a').get_text()

zwyx = tds[3].get_text()

gzdd = tds[4].get_text()

gbsj = tds[5].find('span').get_text()

tr_brief = table.find('tr', {'class': 'newlist_tr_detail'})

brief = tr_brief.find('li', {'class': 'newlist_deatil_last'}).get_text()

temp.append(zwmc)

temp.append(fkl)

temp.append(gsmc)

temp.append(zwyx)

temp.append(gzdd)

temp.append(gbsj)

temp.append(brief)

temp.append(zw_link)

zw_list.append(temp)

return zw_list

def write_data(data, name):

filename = name

with open(filename, 'a', newline='', encoding='utf-8') as f:

f_csv = csv.writer(f)

f_csv.writerows(data)

if __name__ == '__main__':

basic_url = 'http://sou.zhaopin.com/jobs/searchresult.ashx?jl=%E5%85%A8%E5%9B%BD&kw=%E6%95%B0%E6%8D%AE%E5%88%86%E6%9E%90%E5%B8%88&sm=0&p='

number_list = list(range(90)) # total number of page is 90

for number in number_list:

num = number + 1

url = basic_url + str(num)

filename = 'zhilian_DA.csv'

html = download(url)

# print(html)

data = get_content(html)

# print(data)

print('start saving page:', num)

write_data(data, filename)pandas で変換されたコードは次のとおりです:

# Code based on Python 3.x

# _*_ coding: utf-8 _*_

# __Author: "LEMON"

import pandas as pd

df = pd.read_csv('zhilian_DA.csv', header=None)

df.columns = ['职位名称', '反馈率', '公司名称', '月薪', '工作地点',

'发布日期', '招聘简介', '网页链接']

# 将调整后的dataframe文件输出到新的csv文件

df.to_csv('zhilian_DA_update.csv', index=False)以上がPython を使用して求人サイトの情報を取得するの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。