AI が私たちの働き方やテクノロジーとの関わり方を形作り続ける中、多くの企業がインテリジェントなアプリケーション内で自社のデータを活用する方法を模索しています。 ChatGPT や Azure OpenAI などのツールを使用したことがある場合は、生成 AI がどのようにプロセスを改善し、ユーザー エクスペリエンスを向上させることができるかについてはすでにご存知でしょう。ただし、真にカスタマイズされた関連性の高い応答を得るには、アプリケーションに独自のデータを組み込む必要があります。

ここで検索拡張生成 (RAG) が登場し、データ検索と AI を活用した応答を統合するための構造化されたアプローチを提供します。 LlamaIndex のようなフレームワークを使用すると、この機能をソリューションに簡単に組み込むことができ、ビジネス データの可能性を最大限に引き出すことができます。

アプリをすぐに実行して探索したいですか?ここをクリック。

検索拡張生成 (RAG) は、関連情報にアクセスし、独自のデータを統合するための検索コンポーネントを組み込むことで、AI テキスト生成を強化するニューラル ネットワーク フレームワークです。これは 2 つの主要な部分で構成されています:

取得者は関連する文書を見つけ、生成者はそれらを使用してより正確で有益な応答を作成します。この組み合わせにより、RAG モデルは外部の知識を効果的に活用でき、生成されるテキストの品質と関連性が向上します。

LlamaIndex を使用して RAG システムを実装するには、次の一般的な手順に従います。

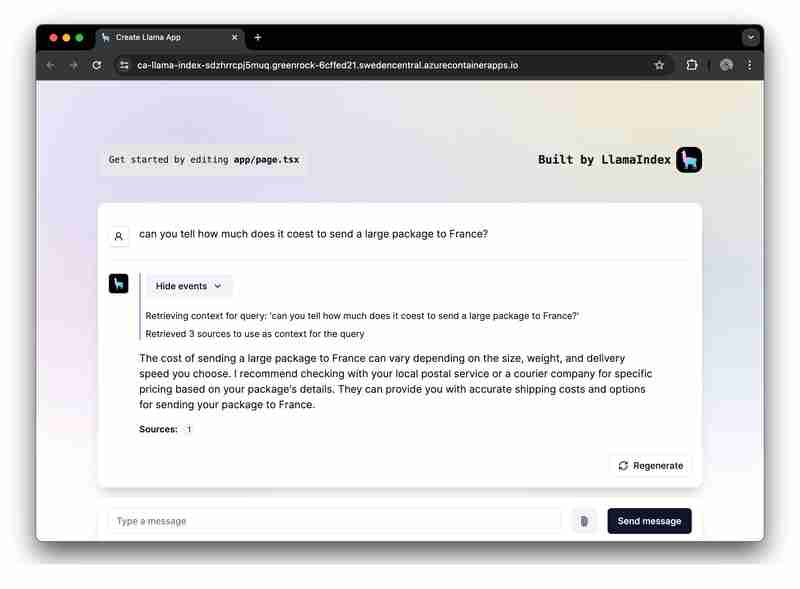

実際的な例として、Azure OpenAI を使用した完全な RAG 実装を示すサンプル アプリケーションを提供しました。

ここでは、LlamaIndex.ts (LlamaIndex の TypeScipt 実装) と Azure OpenAI を使用して RAG アプリケーションを構築し、それを Azure Container Apps 上のサーバーレス Web アプリとしてデプロイすることに焦点を当てます。

GitHub で入門プロジェクトを見つけることができます。必要に応じて自由に編集できるように、このテンプレートをフォークすることをお勧めします:

入門プロジェクト アプリケーションは、次のアーキテクチャに基づいて構築されています:

Pour plus de détails sur les ressources déployées, consultez le dossier infra disponible dans tous nos échantillons.

L'exemple d'application contient une logique pour deux flux de travail :

Ingestion de données : les données sont récupérées, vectorisées et des index de recherche sont créés. Si vous souhaitez ajouter plus de fichiers comme des fichiers PDF ou Word, c'est ici que vous devez les ajouter.

npm run generate

Traitement des demandes d'invite : l'application reçoit les invites des utilisateurs, les envoie à Azure OpenAI et augmente ces invites en utilisant l'index vectoriel comme outil de récupération.

Avant d'exécuter l'exemple, assurez-vous d'avoir provisionné les ressources Azure nécessaires.

Pour exécuter le modèle GitHub dans GitHub Codespace, cliquez simplement sur

Dans votre instance Codespaces, connectez-vous à votre compte Azure, depuis votre terminal :

azd auth login

Provisionner, empaqueter et déployer l'exemple d'application sur Azure à l'aide d'une seule commande :

azd up

Pour exécuter et essayer l'application localement, installez les dépendances npm et exécutez l'application :

npm install npm run dev

L'application s'exécutera sur le port 3000 de votre instance Codespaces ou sur http://localhost:3000 dans votre navigateur.

Ce guide a montré comment créer une application RAG (Retrieval-Augmented Generation) sans serveur à l'aide de LlamaIndex.ts et Azure OpenAI, déployée sur Microsoft Azure. En suivant ce guide, vous pouvez tirer parti de l'infrastructure d'Azure et des capacités de LlamaIndex pour créer de puissantes applications d'IA qui fournissent des réponses enrichies contextuellement en fonction de vos données.

Nous sommes ravis de voir ce que vous créez avec cette application de démarrage. N'hésitez pas à le créer et à aimer le référentiel GitHub pour recevoir les dernières mises à jour et fonctionnalités.

以上がLlamaIndex.ts と Azure OpenAI を使用した RAG アプリの構築: 始めましょう!の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。