これまでの大規模モデルの評価基準を覆し、最新かつ最も包括的かつ権威ある評価データセットMR-Benが登場!

これは、今年 4 月に GPT-4 + DALL-E-3 と呼ばれる強力な視覚言語モデル Mini-Gemini がリリースされた後、香港華人 Jiajiaya チームによって再度提案された非常に代表的な作品です。 MR-Ben の「監督」のもと、大型モデルは学生のように質問に答えるだけでなく、真の推論能力の痕跡を残さず、教師のようにレポートに採点することもできなければなりません。

MR-Ben は、GPT4-Turbo、Cluade3.5-Sonnet、Mistral-Large、Zhipu-GLM4、Moonshot-v1、Yi-Large、Qwen2 など、国内外の多くの第一線のオープンソースおよびクローズド ソース モデルを慎重に評価しました。 -70B 、Deepseek-V2などを用いて詳細な解析を行った。

どの一見美しく見える大きなモデルが「削除」されますか?そしてどのモデルが最も強い表面を持っていますか?現在、この作品のコードとデータはすべてオープンソースになっているので、見てみましょう!

プロジェクトページ: https://randolph-zeng.github.io/Mr-Ben.github.io/

Arxiv ページ: https://arxiv.org/abs/2406.13975

Github リポジトリ: https://github.com /dvlab-research/Mr-Ben

MR-Ben は、大型モデルの「高スコアと低エネルギー」を数秒で破ります

人工知能の分野が GPT の瞬間に入ってから、学界と産業界が協力し、毎年新しいモデルがリリースされました毎月、あるいは毎週でも。

大規模モデルが際限なく出現します。大規模モデルの特定の機能を測定するためにどのような基準が使用されますか?現在の主流の方向性は、人間による標準化されたテスト、つまり多肢選択問題や穴埋め問題を使用して大規模モデルの評価を行うことです。このテスト方法を使用する利点は数多くありますが、簡単に言うと以下の点に分けられます:

• 標準化されたテストは定量化と評価が容易です。基準が明確で、正しいものは正しく、間違っているものは間違っています。 。

• 指標が直感的で、国内の大学入試やアメリカの大学入試SATで得られたスコアと比較して理解しやすいです。

• 定量的な結果は当然話題になります (たとえば、米国司法試験に簡単に合格する GPT4 の能力は非常に目を引きます)。

しかし、大規模モデルのトレーニング方法を詳しく調べると、最終的な答えを生成するこの段階的な思考連鎖方法は「信頼できる」ものではないことがわかります。

質問はステップバイステップの回答プロセスに正確に表示されます。

事前トレーニング モデルは、事前トレーニング中にすでに何兆もの単語要素を認識していますが、評価対象のモデルが対応するデータをすでに認識しているかどうか、「質問を暗記する」ことで質問に正しく答えることができるかどうかを判断するのは困難です。段階的な回答では、評価方法は主に最終的な回答の確認に依存しているため、モデルが正しい理解と推論に基づいて正しい選択肢を選択しているかどうかはわかりません。

学術コミュニティは、GSM8K での MGSM データセットの多言語バージョンの導入や、MMLU に基づくより難しい質問の導入など、GSM8K や MMLU などのデータセットのアップグレードと変換を続けていますが、依然として解決する方法はありません。空白を選択または埋める問題の扱いにくい。

さらに、これらのデータセットはすべて、これらの指標に関する大規模な言語モデルの値がピークに達し、徐々に区別を失っています。

この目的のために、Jiajiaya チームは MIT、清華大学、ケンブリッジなどの多くの有名大学と協力し、国内のヘッドアノテーション会社と協力して、複雑な問題の推論プロセス用の評価データセット MR-Ben にアノテーションを付けました。

MR-Ben は、GSM8K、MMLU、LogiQA、MHPP などの大規模モデルの事前トレーニングおよびテスト データ セットからの質問に基づいて「グレーディング」パラダイム変換を実行しました。生成された新しいデータ セットはさらに多くなります。難しく、より差別化され、より現実的になります。

今回の Jiajiaya チームの作業では、既存の評価の問題点に対処するための的を絞った改善も行われました。

データ漏洩により、大規模なモデルの質問の暗記が発生し、スコアが水増しされることを恐れていませんか? MR-Ben では、モデルの堅牢性をテストするために質問を再検索したり、質問を変形したりする必要はなく、回答者の学生 ID から回答プロセスの「採点」モードに直接モデルを変更するため、大きな問題を解決できます。テストする教師となるモデル 知識ポイントをどれだけうまくマスターできるかをテストします。

モデルが問題解決のプロセスを認識しておらず、「錯覚」や誤解があり、答えを間違えてしまうのではないかと心配していませんか? MR-Ben は、高レベルの修士号および博士号のアノテーターのグループを直接採用し、多数の質問の問題解決プロセスに注意深くアノテーションを付けます。問題解決プロセスが正しいかどうか、エラーの場所、エラーの理由を詳細に指摘し、大規模モデルの採点結果と人間の専門家の採点結果を比較して、モデルの知識の知識をテストします。ポイント。

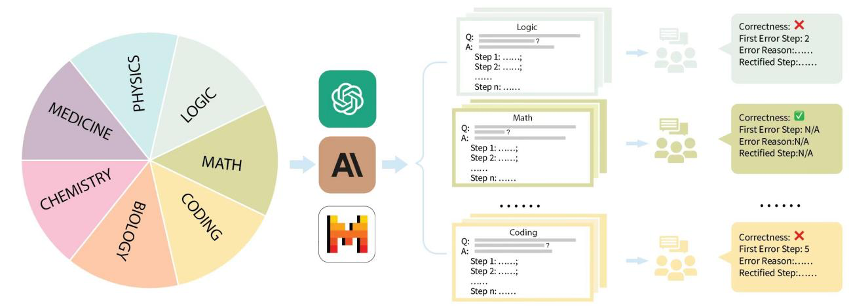

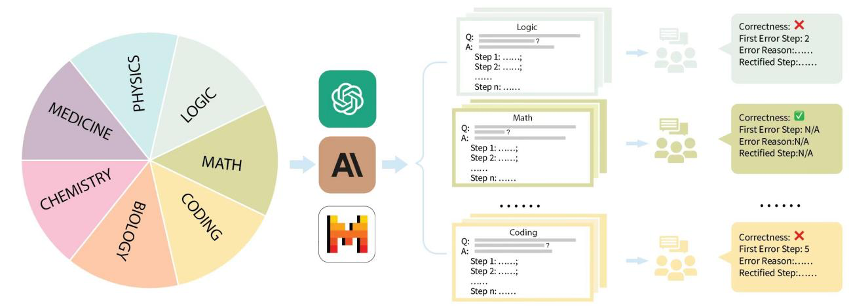

具体的には、Jiajiaya チームは、GSM8K、MMLU、LogiQA、MHPP などの市場の主流の評価データセットを整理し、数学、物理学、化学、生物学、コード、ロジック、医学などの複数のカテゴリに分類しました。 、など、また、異なる難易度レベルも区別されます。収集された各カテゴリおよび各質問について、チームは対応する段階的な問題解決プロセスを慎重に収集し、修士号および博士号を取得した専門のアノテーターによるトレーニングを受け、注釈を付けました。

MR-Ben データセットの構築プロセス

最もパフォーマンスの高い大規模モデルは何ですか?

接下来,让我们结合MR-Ben工作中给出的具体例子,看看为什么说逐步作答生成最终答案的方式和相关评测不靠谱。

作为被评测的“阅卷”模型,GPT4-Turbo并未发现第二步所隐藏的计算错误:

E.1 数学

科目:高中数学

问题:哪个最小的整数被4除余1,被3除余2,被5除余2?

选项:[A] 67 [B] 43 [C] 57 [D] 37

答案:D

采样模型:Claude2

模型解答步骤:

- 步骤1:检查选项A(67)当67除以4,余数是3,不是1。所以67不是正确答案。

- 步骤2:检查选项B(43)当43除以4,余数是1。当43除以3,余数是3,不是2。所以43不是正确答案。

- 步骤3:检查选项C(57)当57除以4,余数是1。当57除以3,余数是0,不是2。所以57不是正确答案。

- 步骤4:检查选项D(37)当37除以4,余数是1。当37除以3,余数是1。当37除以5,余数是2。

-

步骤5:选项D(37)满足所有条件,是正确答案。

解答:选项D

人工注解

模型解答正确性:不正确

首次错误步骤:步骤2

模型解答错误原因:

在步骤2中,模型错误计算了43除以4的余数为1而不是3。模型假设当43除以4时余数是1,但余数应该是3。这里有一个计算错误。

修正后的首个正确步骤:步骤2

当43除以4,余数是1。当43除以3,余数是1。当43除以5,余数是3,不是2。因此,43不是正确答案。

评测模型:gpt-4-turbo

模型回复:

-步骤1:步骤检查67除以4和3的余数,发现它符合被4除余3的条件,这是一个正确的验证。

-步骤2:检查43除以4、3、5的余数,发现1、3、5的余数正确匹配预期,除了5的余数不符合条件。

-步骤3:步骤计算57除以4和3的余数,余数分别是1和0。当57除以3时余数不符合条件。

-步骤4:步骤检查并验证37除以4、3、5的余数,发现所有预期的余数都准确,得出37满足题目中的所有条件。

解答过程是否正确:正确

第一个出错的步骤:不适用

第一个出错步骤的原因:不适用

可以看到,当给定问题、确定的解答过程,评测语言模型的方式就转换成了让模型对解答过程进行“阅卷”并评判正误、指出错误位置及原因。其中解答过程的正误,潜在的出错位置可以通过与标注结果进行比对来计算。而模型出错步骤和原因的评测,则可以交由GPT4,通过比较标注人员给出的错误原因解释和模型的错误原因解释,来判断模型是否正确。

从评测方式来看,MR-Ben所提出的方法需要模型对于解题过程的每一个步骤的前提、假设、逻辑都进行细致分析,并对推理过程进行预演来判断当前步骤是否能导向正确答案。fenye1. 这种“阅卷”式的评测方式从难度上远超于仅答题的评测方式,但可有效避免模型背题所导致的分数虚高问题。而只会背题的学生很难成为一名合格的阅卷老师。

- 其次,MR-Ben通过使用了人力精细的标注流程控制,取得了大量的高质量标注,而巧妙的流程设计又使得评测方式能够直观地量化。

- 贾佳亚团队还针对性测试了时下最具代表性的十大大语言模型和不同版本。可以看到,闭源大语言模型里,GPT4-Turbo的表现最佳(虽然在“阅卷”时未能发现计算错误),在绝大部分的科目里,有demo(k=1)和无demo(k=0)的设置下都领先于其他模型。

**部分开源大语言模型在MR-Ben数据集上的测评结果

可以看到,最强的部分开源大语言模型效果已经赶上了部分商用模型,并且哪怕最强的闭源模型在MR-Ben数据集上表现也仍未饱和,不同模型间的区分度较大。

除此之外,MR-Ben的原论文里还有更多有意思的解析和发现,例如:

Qwen和Deepseek发布的开源模型哪怕在全球梯队里,PK闭源模型效果也不逊色。

不同的闭源模型定价策略和实际表现耐人寻味。在使用场景里关注推理能力的小伙伴,可以对照价格和能力找到自己心仪的模型去使用。

低资源场景下,小模型也有不少亮点,MR-Ben评测中Phi-3-mini在一众小模型里脱颖而出,甚至高于或持平几百亿参数的大模型,展现出了微调数据的重要性。

MR-Ben场景包含复杂的逻辑解析和逐步推断,Few-shot模式下过长的上下文反而会使得模型困惑,造成水平下降的后果。

MR-Ben评测了不少生成-反思-重生成的消融实验,查看不同提示策略的差异,发现对低水平的模型没有效果,对高水平的模型如GPT4-Turbo效果也不明显。反而对中间水平的模型因为总把错的改对,对的改错,效果反而略有提升。

将MR-Ben评测的科目粗略划分成知识型、逻辑型、计算型、算法型后,不同的模型在不同的推理类型上各有优劣。

贾佳亚团队已在github上传一键评测的方式,欢迎所有关注复杂推理的小伙伴在自家的模型上评测并提交,团队会及时更新相应的leaderboard。

对了,使用官方的脚本一键评测,只需花费12M tokens左右,过程非常丝滑,不妨一试!

参考

Training Verifiers to Solve Math Word Problems(https://arxiv.org/abs/2110.14168)

Measuring Massive Multitask Language Understanding(https://arxiv.org/abs/2009.03300)

LogiQA: A Challenge Dataset for Machine Reading Comprehension with Logical Reasoning(https://arxiv.org/abs/2007.08124)

MHPP: Exploring the Capabilities and Limitations of Language Models Beyond Basic Code Generation(https://arxiv.org/abs/2405.11430)

Sparks of Artificial General Intelligence: Early experiments with GPT-4(https://arxiv.org/abs/2303.12712)

Qwen Technical Report(https://arxiv.org/abs/2309.16609)

DeepSeek-V2: A Strong, Economical, and Efficient Mixture-of-Experts Language Model(https://arxiv.org/abs/2405.04434)

Textbooks Are All You Need(https://arxiv.org/abs/2306.11644)

Large Language Models Cannot Self-Correct Reasoning Yet(https://arxiv.org/abs/2310.01798)

以上がJia Jiaya チームはケンブリッジ清華大学などと協力し、大型モデルの「高スコアと低エネルギー」を 1 秒で検出する新しい評価パラダイムを推進の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。