Périphériques technologiques

Périphériques technologiques

IA

IA

Le nouveau SOTA de Vincent Tu ! Pika, l'Université de Pékin et Stanford lancent conjointement un RPG multimodal pour aider à résoudre deux problèmes majeurs de Wenshengtu

Le nouveau SOTA de Vincent Tu ! Pika, l'Université de Pékin et Stanford lancent conjointement un RPG multimodal pour aider à résoudre deux problèmes majeurs de Wenshengtu

Le nouveau SOTA de Vincent Tu ! Pika, l'Université de Pékin et Stanford lancent conjointement un RPG multimodal pour aider à résoudre deux problèmes majeurs de Wenshengtu

Récemment, l'Université de Pékin, Stanford et le populaire Pika Labs ont publié conjointement une étude qui a amélioré les capacités des graphiques vincentiens à grand modèle à un nouveau niveau.

Adresse papier : https://arxiv.org/pdf/2401.11708.pdf

Adresse code : https://github.com/YangLing0818/RPG-DiffusionMaster

Proposé par le auteur de l'article Une approche innovante est adoptée pour améliorer le cadre de génération/édition de texte en image en tirant parti des capacités d'inférence des grands modèles de langage multimodaux (MLLM).

En d'autres termes, cette méthode vise à améliorer les performances des modèles de génération de texte lors du traitement d'invites de texte complexes contenant plusieurs attributs, relations et objets.

Sans plus tarder, voici la photo :

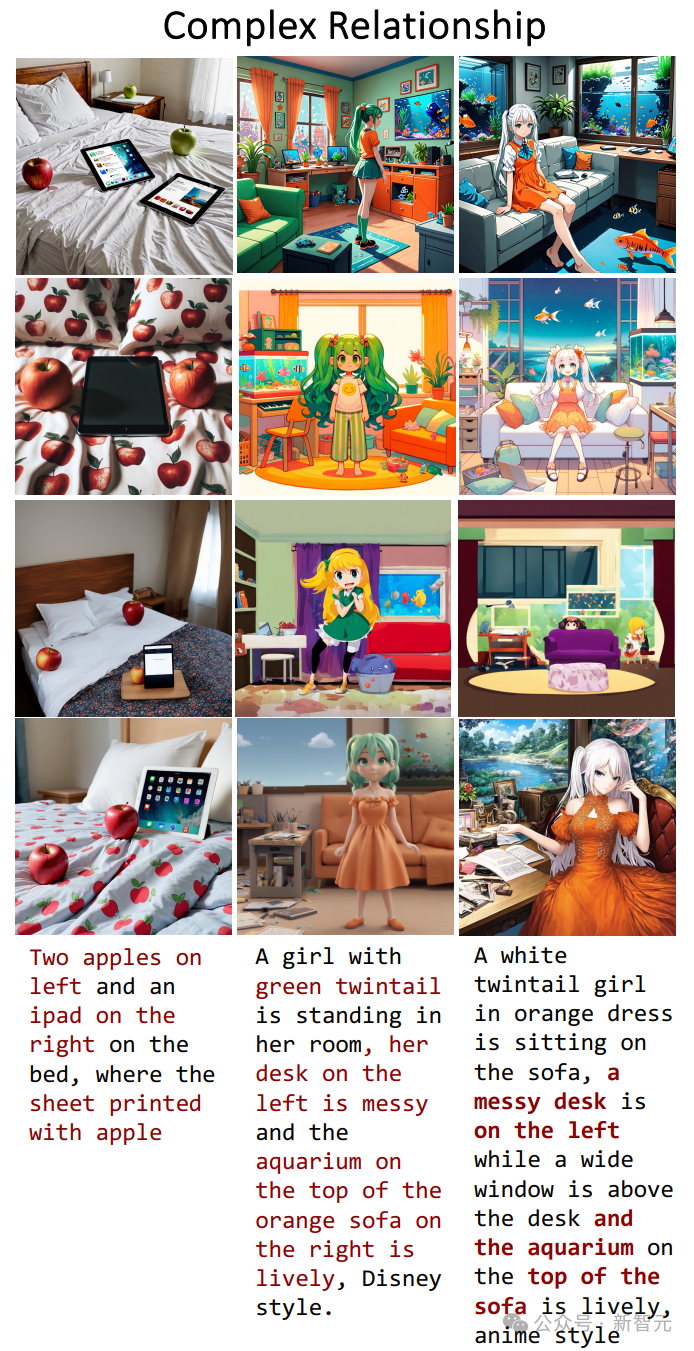

Une fille twintail verte en robe orange est assise sur le canapé tandis qu'un bureau en désordre sous une grande fenêtre à gauche, un aquarium animé se trouve au en haut à droite du canapé, style réaliste.

Une fille avec deux queues de cheval vêtue d'une robe orange est assise sur le canapé. À côté de la grande fenêtre se trouve un bureau en désordre. Il y a un aquarium animé en haut à droite, la pièce. est un style réaliste.

Face à de multiples objets aux relations complexes, la structure de l'ensemble de l'image et la relation entre les personnes et les objets données par le modèle sont très raisonnables, faisant briller les yeux du spectateur.

Pour la même invite, jetons un coup d'œil aux performances des SDXL et DALL·E 3 de pointe actuels :

Jetons un coup d'œil au nouveau framework lorsqu'il vient lier plusieurs attributs à plusieurs objets Performance :

De gauche à droite, une fille européenne blonde en queue de cheval en chemise blanche, une fille africaine aux cheveux bruns bouclés en chemise bleue imprimée d'un oiseau, une jeune asiatique. un homme aux cheveux courts noirs en costume marche joyeusement sur le campus.

De gauche à droite, une fille européenne portant une chemise blanche avec une queue de cheval blonde, une fille africaine aux cheveux bruns bouclés portant une chemise bleue avec un oiseau imprimé dessus et une fille portant un costume, un jeune homme asiatique aux cheveux noirs courts marche joyeusement sur le campus.

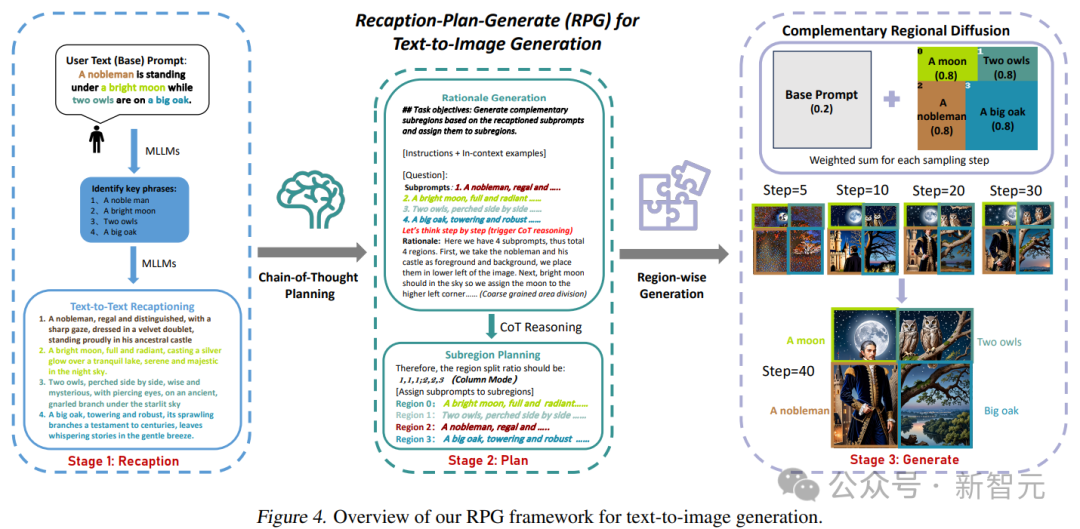

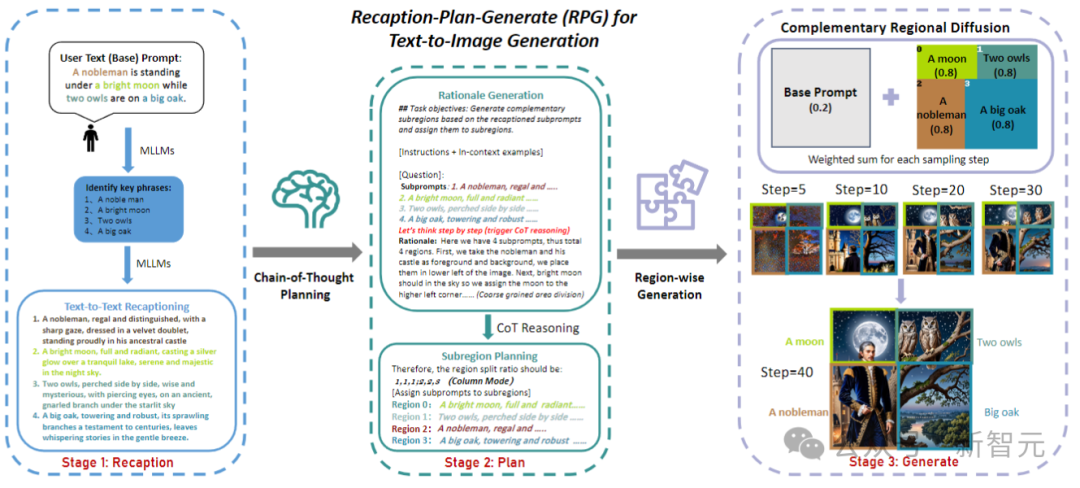

Les chercheurs ont nommé ce cadre RPG (Recaption, Plan and Generate), en utilisant MLLM comme planificateur global pour décomposer le processus complexe de génération d'images en plusieurs tâches de génération plus simples au sein de sous-régions.

L'article propose une diffusion de régions complémentaire pour réaliser la génération de combinaisons de régions, et intègre également la génération et l'édition d'images guidées par texte dans le cadre RPG en boucle fermée, améliorant ainsi les capacités de généralisation.

Les expériences montrent que le cadre RPG proposé dans cet article surpasse les modèles de diffusion d'images texte de pointe actuels, notamment DALL·E 3 et SDXL, en particulier dans la synthèse d'objets multi-catégories et l'alignement sémantique d'images texte.

Il convient de noter que le framework RPG est largement compatible avec diverses architectures MLLM (telles que MiniGPT-4) et réseaux fédérateurs de diffusion (tels que ControlNet).

RPG

Le modèle de graphe vincentien actuel présente deux problèmes principaux : 1. Les méthodes basées sur la mise en page ou basées sur l'attention ne peuvent fournir qu'un guidage spatial approximatif et ont des difficultés à gérer les objets qui se chevauchent ; 2. Les méthodes basées sur les commentaires nécessitent une collecte ; des données de feedback de haute qualité et encourent des coûts de formation supplémentaires.

Pour résoudre ces problèmes, les chercheurs ont proposé trois stratégies de base du RPG, comme le montre la figure ci-dessous :

Étant donné une invite de texte complexe contenant plusieurs entités et relations, utilisez d'abord MLLM pour la décomposer en des indices de base et des sous-indices hautement descriptifs ; ensuite, l'espace d'image est divisé en sous-régions complémentaires à l'aide de la planification CoT du modèle multimodal ; enfin, une diffusion de régions complémentaires est introduite pour générer indépendamment l'image de chaque sous-région ; L'agrégation est effectuée à chaque étape d'échantillonnage.

Réajustement multimodal

transforme les signaux textuels en signaux hautement descriptifs, offrant ainsi une compréhension améliorée des signaux et un alignement sémantique dans les modèles de diffusion.

Utilisez MLLM pour identifier les phrases clés dans l'invite utilisateur et obtenir les sous-éléments qu'elle contient :

Utilisez LLM pour décomposer l'invite de texte en différentes sous-invites et les décrire plus en détail :

De cette manière, des détails plus denses et plus fins peuvent être générés pour chaque sous-repère afin d'améliorer efficacement la fidélité des images générées et de réduire les différences sémantiques entre les repères et les images.

Planification de la chaîne de pensée

divise l'espace de l'image en sous-régions complémentaires et attribue différents sous-indices à chaque sous-région, tout en décomposant la tâche de génération en plusieurs sous-tâches plus simples.

Plus précisément, l'espace image H×W est divisé en plusieurs régions complémentaires, et chaque invite d'amélioration est attribuée à une région spécifique R :

En utilisant la puissante capacité de raisonnement en chaîne de pensée de MLLM, effectuez zonage efficace. En analysant les résultats intermédiaires récupérés, des principes détaillés et des instructions précises peuvent être générés pour la synthèse d'images ultérieure.

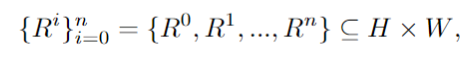

Diffusion de zone supplémentaire

Dans chaque sous-zone rectangulaire, le contenu guidé par des sous-zones est généré indépendamment, puis redimensionné et connecté de manière à fusionner spatialement ces sous-zones.

Cette méthode résout efficacement le problème des grands modèles ayant des difficultés à gérer des objets qui se chevauchent. En outre, l'article étend ce cadre pour l'adapter aux tâches d'édition, en utilisant la diffusion de régions basée sur les contours pour opérer avec précision sur les régions incohérentes qui nécessitent une modification.

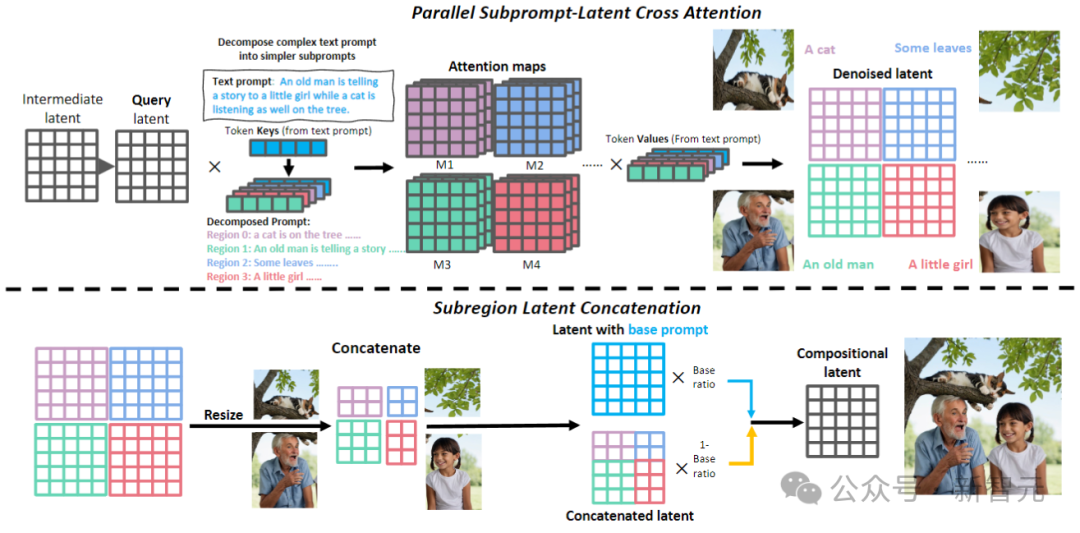

Édition d'images guidée par texte

comme indiqué dans l'image ci-dessus. Au stade du récit, RPG utilise MLLM comme sous-titres pour raconter l'image source et utilise ses puissantes capacités de raisonnement pour identifier les différences sémantiques fines entre l'image et le signal cible, analysant directement la manière dont l'image d'entrée s'aligne sur le signal cible.

Utilisez MLLM (GPT-4, Gemini Pro, etc.) pour vérifier les différences entre l'entrée et la cible concernant la précision numérique, les liaisons de propriétés et les relations entre les objets. Les commentaires de compréhension multimodaux qui en résulteront seront transmis au MLLM pour la planification de l'édition inférentielle.

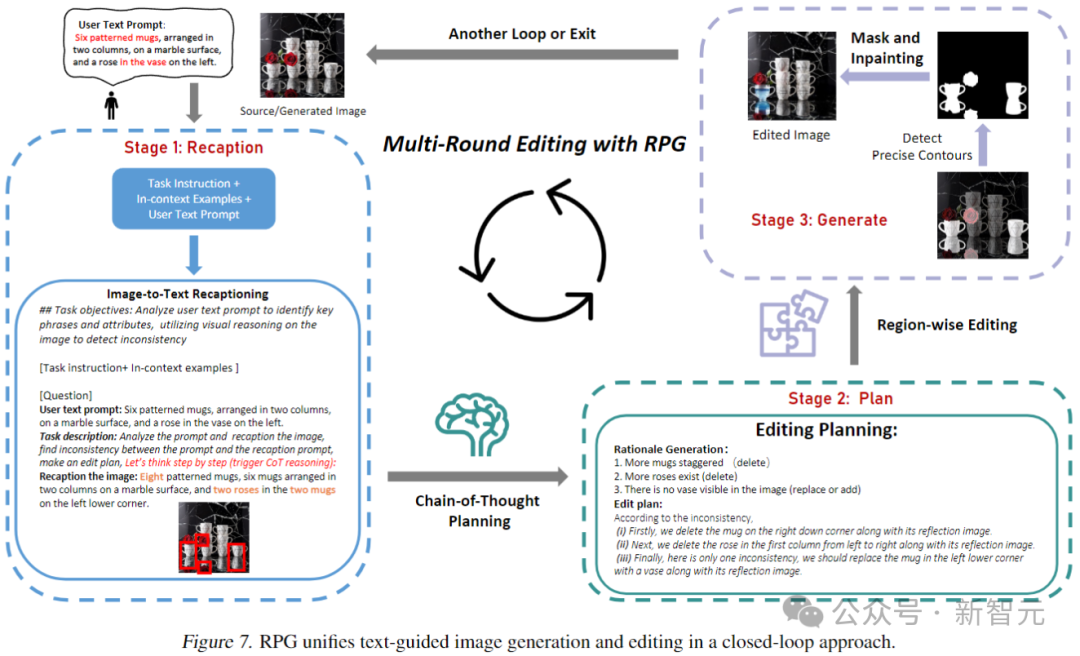

Jetons un coup d'œil aux performances de l'effet de génération dans les trois aspects ci-dessus. Le premier est la liaison d'attributs, en comparant SDXL, DALL·E 3 et LMD+ :

Nous pouvons le voir dans tout. trois tests Parmi les jeux, seul le RPG reflète le plus fidèlement ce que les invites décrivent.

Ensuite il y a la précision numérique, l'ordre d'affichage est le même que ci-dessus (SDXL, DALL·E 3, LMD+, RPG) :

-Je ne m'attendais pas à ce que compter soit assez difficile pour le grand modèle de figurine Vincent Oui, le RPG bat facilement l'adversaire.

Le dernier élément consiste à restaurer des relations complexes dans l'invite :

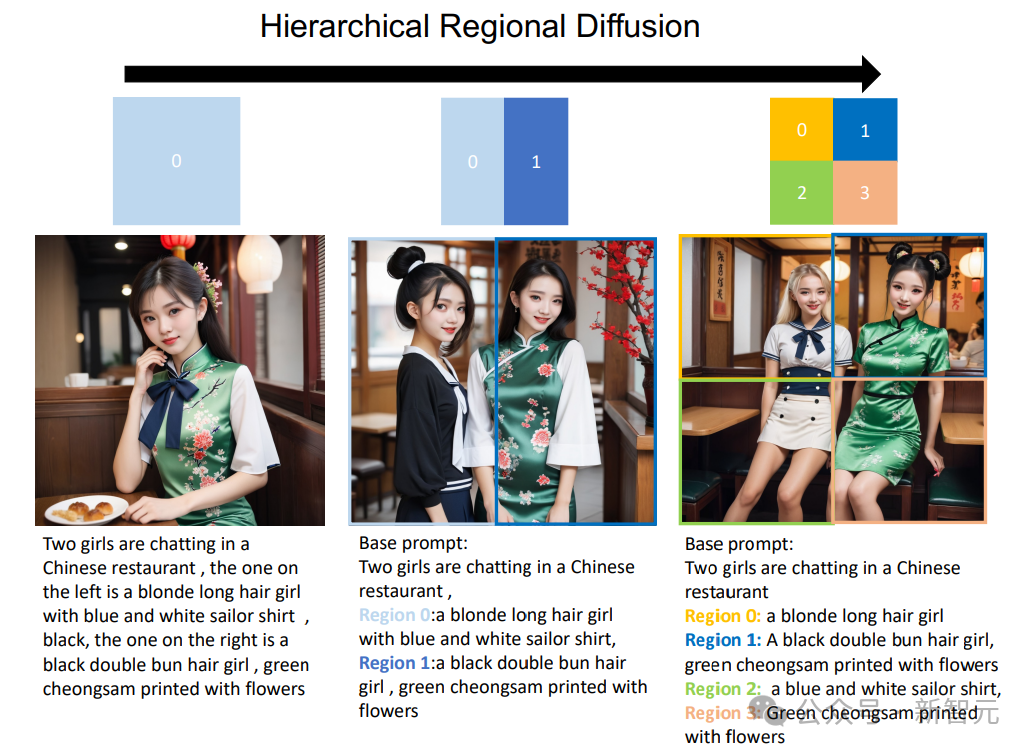

De plus, la diffusion de zones peut être étendue à un format hiérarchique, divisant des sous-régions spécifiques en sous-régions plus petites.

Comme le montre la figure ci-dessous, RPG peut apporter des améliorations significatives dans la génération de texte en image lors de l'ajout d'une hiérarchie de segmentation des régions. Cela offre une nouvelle perspective pour gérer des tâches de génération complexes, permettant de générer des images de composition arbitraire.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Les performances de JAX, promu par Google, ont dépassé celles de Pytorch et TensorFlow lors de récents tests de référence, se classant au premier rang sur 7 indicateurs. Et le test n’a pas été fait sur le TPU présentant les meilleures performances JAX. Bien que parmi les développeurs, Pytorch soit toujours plus populaire que Tensorflow. Mais à l’avenir, des modèles plus volumineux seront peut-être formés et exécutés sur la base de la plate-forme JAX. Modèles Récemment, l'équipe Keras a comparé trois backends (TensorFlow, JAX, PyTorch) avec l'implémentation native de PyTorch et Keras2 avec TensorFlow. Premièrement, ils sélectionnent un ensemble de

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L’IA change effectivement les mathématiques. Récemment, Tao Zhexuan, qui a prêté une attention particulière à cette question, a transmis le dernier numéro du « Bulletin de l'American Mathematical Society » (Bulletin de l'American Mathematical Society). En se concentrant sur le thème « Les machines changeront-elles les mathématiques ? », de nombreux mathématiciens ont exprimé leurs opinions. L'ensemble du processus a été plein d'étincelles, intense et passionnant. L'auteur dispose d'une équipe solide, comprenant Akshay Venkatesh, lauréat de la médaille Fields, le mathématicien chinois Zheng Lejun, l'informaticien de l'Université de New York Ernest Davis et de nombreux autres universitaires bien connus du secteur. Le monde de l’IA a radicalement changé. Vous savez, bon nombre de ces articles ont été soumis il y a un an.

Recommandé : Excellent projet de détection et de reconnaissance des visages open source JS

Apr 03, 2024 am 11:55 AM

Recommandé : Excellent projet de détection et de reconnaissance des visages open source JS

Apr 03, 2024 am 11:55 AM

La technologie de détection et de reconnaissance des visages est déjà une technologie relativement mature et largement utilisée. Actuellement, le langage d'application Internet le plus utilisé est JS. La mise en œuvre de la détection et de la reconnaissance faciale sur le front-end Web présente des avantages et des inconvénients par rapport à la reconnaissance faciale back-end. Les avantages incluent la réduction de l'interaction réseau et de la reconnaissance en temps réel, ce qui réduit considérablement le temps d'attente des utilisateurs et améliore l'expérience utilisateur. Les inconvénients sont les suivants : il est limité par la taille du modèle et la précision est également limitée ; Comment utiliser js pour implémenter la détection de visage sur le web ? Afin de mettre en œuvre la reconnaissance faciale sur le Web, vous devez être familier avec les langages et technologies de programmation associés, tels que JavaScript, HTML, CSS, WebRTC, etc. Dans le même temps, vous devez également maîtriser les technologies pertinentes de vision par ordinateur et d’intelligence artificielle. Il convient de noter qu'en raison de la conception du côté Web

Fraichement publié! Un modèle open source pour générer des images de style anime en un seul clic

Apr 08, 2024 pm 06:01 PM

Fraichement publié! Un modèle open source pour générer des images de style anime en un seul clic

Apr 08, 2024 pm 06:01 PM

Permettez-moi de vous présenter le dernier projet open source AIGC-AnimagineXL3.1. Ce projet est la dernière itération du modèle texte-image sur le thème de l'anime, visant à offrir aux utilisateurs une expérience de génération d'images d'anime plus optimisée et plus puissante. Dans AnimagineXL3.1, l'équipe de développement s'est concentrée sur l'optimisation de plusieurs aspects clés pour garantir que le modèle atteigne de nouveaux sommets en termes de performances et de fonctionnalités. Premièrement, ils ont élargi les données d’entraînement pour inclure non seulement les données des personnages du jeu des versions précédentes, mais également les données de nombreuses autres séries animées bien connues dans l’ensemble d’entraînement. Cette décision enrichit la base de connaissances du modèle, lui permettant de mieux comprendre les différents styles et personnages d'anime. AnimagineXL3.1 introduit un nouvel ensemble de balises et d'esthétiques spéciales

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

La dernière vidéo du robot Optimus de Tesla est sortie, et il peut déjà fonctionner en usine. À vitesse normale, il trie les batteries (les batteries 4680 de Tesla) comme ceci : Le responsable a également publié à quoi cela ressemble à une vitesse 20 fois supérieure - sur un petit "poste de travail", en sélectionnant et en sélectionnant et en sélectionnant : Cette fois, il est publié L'un des points forts de la vidéo est qu'Optimus réalise ce travail en usine, de manière totalement autonome, sans intervention humaine tout au long du processus. Et du point de vue d'Optimus, il peut également récupérer et placer la batterie tordue, en se concentrant sur la correction automatique des erreurs : concernant la main d'Optimus, le scientifique de NVIDIA Jim Fan a donné une évaluation élevée : la main d'Optimus est l'un des robots à cinq doigts du monde. le plus adroit. Ses mains ne sont pas seulement tactiles