Les dernières recherches de l'Université Cornell et d'Apple ont conclu que pour générer des images haute résolution avec moins de puissance de calcul, le mécanisme d'attention peut être éliminé

Comme nous le savons tous, le mécanisme d'attention est au cœur de Les composants de l'architecture Transformer sont cruciaux pour la génération de texte et d'images de haute qualité. Mais son défaut est également évident : la complexité du calcul augmentera de façon quadratique à mesure que la longueur de la séquence augmente. Il s’agit d’un problème épineux dans le traitement de textes longs et d’images haute résolution.

Afin de résoudre ce problème, cette nouvelle recherche a remplacé le mécanisme d'attention dans l'architecture traditionnelle par une base de modèle d'espace d'état (SSM) plus évolutive et a développé un modèle appelé Diffusion State Space Model (DIFFUSSM) ) nouvelle architecture. Cette nouvelle architecture peut utiliser moins de puissance de calcul pour égaler ou dépasser l'effet de génération d'images des modèles de diffusion existants avec des modules d'attention, et générer de manière excellente des images haute résolution.

Grâce à la sortie de « Mamba » la semaine dernière, le modèle spatial d'état SSM reçoit de plus en plus d'attention. Le cœur de Mamba est l'introduction d'une nouvelle architecture - le "modèle spatial d'état sélectif", qui rend Mamba comparable, voire supérieur à Transformer en matière de modélisation du langage. À l’époque, l’auteur de l’article, Albert Gu, avait déclaré que le succès de Mamba lui avait donné confiance dans l’avenir du SSM. Aujourd’hui, cet article de l’Université Cornell et d’Apple semble avoir ajouté de nouveaux exemples des perspectives d’application du SSM.

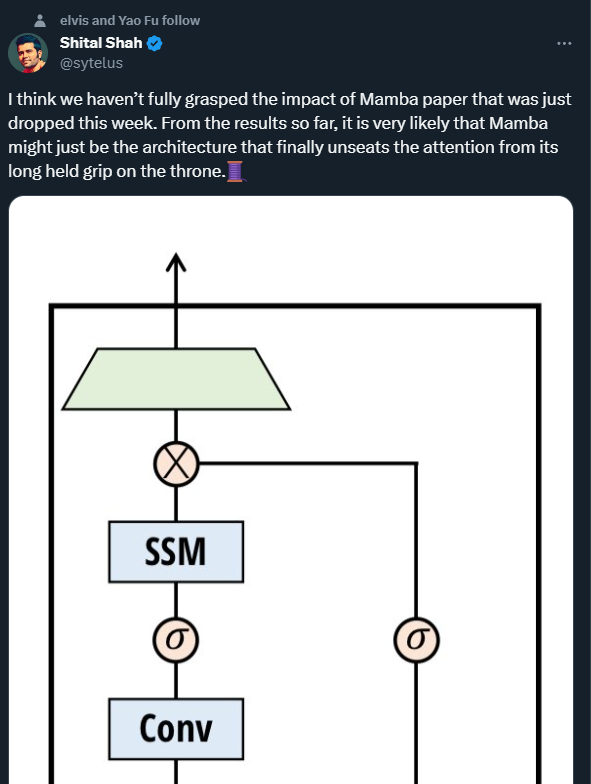

Shital Shah, ingénieur de recherche principal chez Microsoft, a averti que le mécanisme d'attention pourrait être retiré du trône sur lequel il est assis depuis longtemps.

Les progrès rapides dans le domaine de la génération d'images ont été motivés par les modèles probabilistes de diffusion avec débruitage (DDPM). De tels modèles modélisent le processus de génération sous forme de variables latentes de débruitage itératives, et lorsque suffisamment d'étapes de débruitage sont effectuées, ils sont capables de produire des échantillons haute fidélité. La capacité des DDPM à capturer des distributions visuelles complexes les rend potentiellement avantageux pour la création de compositions photoréalistes haute résolution.

Des défis informatiques importants subsistent lors de la mise à l'échelle des DDPM vers des résolutions plus élevées. Le principal goulot d’étranglement est le recours à l’attention personnelle pour parvenir à une génération haute fidélité. Dans l'architecture U-Nets, ce goulot d'étranglement provient de la combinaison de ResNet avec des couches d'attention. Les DDPM vont au-delà des réseaux contradictoires génératifs (GAN) mais nécessitent des couches d'attention multi-têtes. Dans l'architecture Transformer, l'attention est l'élément central et donc essentielle pour obtenir des résultats de synthèse d'image de pointe. Dans les deux architectures, la complexité de l’attention évolue quadratiquement avec la longueur de la séquence, ce qui devient irréalisable lors du traitement d’images haute résolution.

Le coût de calcul a incité les chercheurs précédents à utiliser des méthodes de compression de représentation. Les architectures haute résolution utilisent souvent une résolution patchifiante ou multi-échelle. Le blocage peut créer des représentations à granularité grossière et réduire les coûts de calcul, mais au détriment des informations spatiales haute fréquence critiques et de l'intégrité structurelle. La résolution multi-échelle, tout en réduisant le calcul des couches d'attention, réduit également les détails spatiaux grâce au sous-échantillonnage et introduit des artefacts lors de l'application du suréchantillonnage.

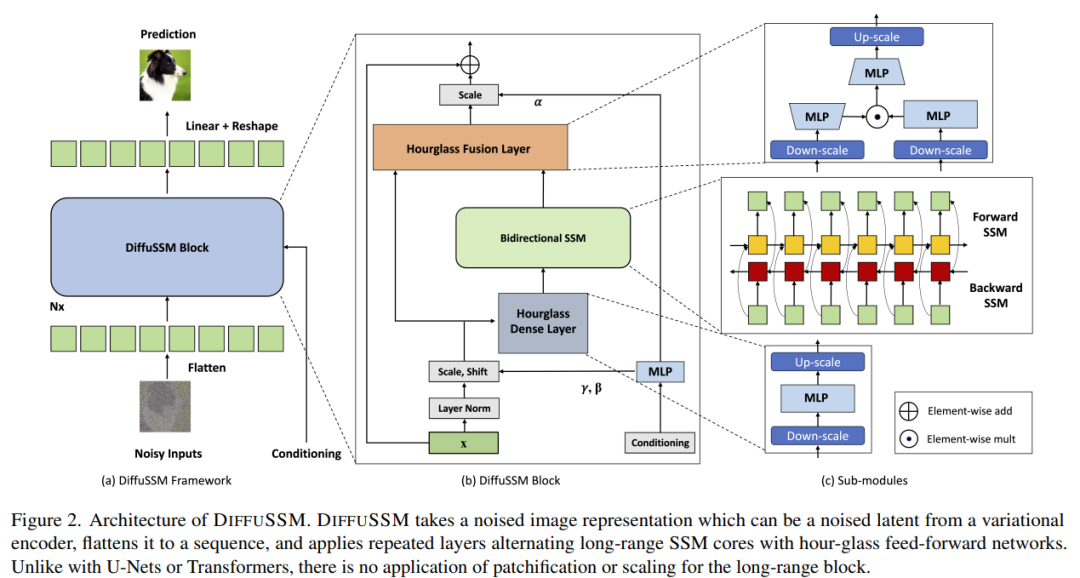

DIFFUSSM est un modèle spatial d'états de diffusion qui n'utilise pas le mécanisme d'attention et est conçu pour résoudre les problèmes rencontrés lors de l'application du mécanisme d'attention dans la synthèse d'images haute résolution. DIFFUSSM utilise un modèle spatial à états contrôlés (SSM) dans le processus de diffusion. Des études antérieures ont montré que le modèle de séquence basé sur SSM est un modèle de séquence neuronale général efficace et efficient. En adoptant cette architecture, le cœur SSM peut être activé pour gérer des représentations d'images plus fines, éliminant ainsi la mosaïque globale ou les couches multi-échelles. Pour améliorer encore l'efficacité, DIFFUSSM adopte une architecture en sablier dans les composants denses du réseau

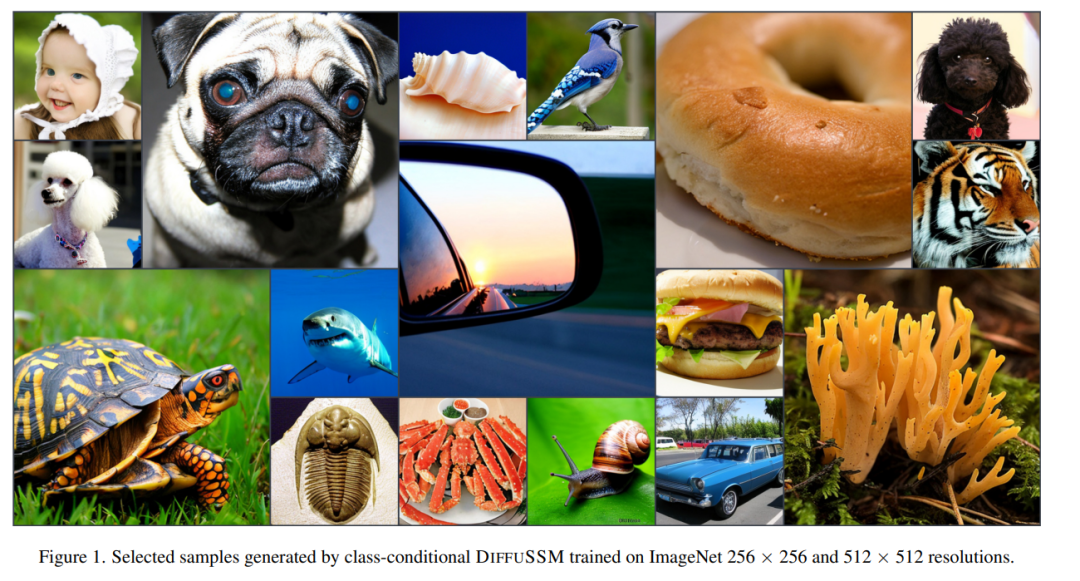

Les auteurs ont vérifié les performances de DIFFUSSM à différentes résolutions. Les expériences sur ImageNet démontrent que DIFFUSSM obtient des améliorations constantes du FID, du sFID et du Inception Score à différentes résolutions avec moins de Gflops totaux.

Lien papier : https://arxiv.org/pdf/2311.18257.pdf

Afin de ne pas changer le sens original, le contenu doit être réécrit en chinois. L’objectif des auteurs était de concevoir une architecture de diffusion capable d’apprendre des interactions à longue portée à haute résolution sans avoir besoin d’une « réduction de longueur » comme le blocage. Semblable à DiT, cette approche fonctionne en aplatissant l'image et en la traitant comme un problème de modélisation de séquence. Cependant, contrairement à Transformer, cette méthode utilise des calculs sous-quadratiques lors du traitement de la longueur de cette séquence. DIFFUSSM est le composant central d'un SSM bidirectionnel contrôlé optimisé pour le traitement de longues séquences. Afin d'améliorer l'efficacité, l'auteur a introduit l'architecture du sablier dans la couche MLP. Cette conception étend et contracte alternativement la longueur de la séquence autour du SSM bidirectionnel tout en réduisant sélectivement la longueur de la séquence dans le MLP. L'architecture complète du modèle est illustrée à la figure 2

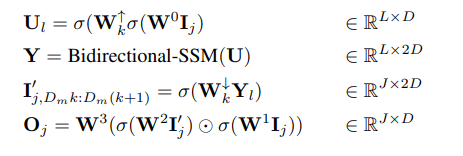

Plus précisément, chaque couche de sablier reçoit une séquence d'entrée raccourcie et aplatie I ∈ R^(J×D), où M = L/J est le rapport de réduction et élargissement. Dans le même temps, le bloc entier, y compris le SSM bidirectionnel, est calculé sur la longueur d'origine, tirant pleinement parti du contexte global. σ est utilisé dans cet article pour représenter la fonction d'activation. Pour l ∈ {1 . L}, où j = ⌊l/M⌋, m = l mod M, D_m = 2D/M, l'équation de calcul est la suivante :

L'auteur dans chacun couche Intégrez des blocs SSM sécurisés à l'aide de connexions sautées. Les auteurs intègrent une combinaison d'étiquette de classe y ∈ R^(L×1) et de pas de temps t ∈ R^(L×1) à chaque emplacement, comme le montre la figure 2.

Paramètres : Le nombre de paramètres dans le bloc DIFFUSSM est principalement déterminé par la transformation linéaire W, qui contient 9D^2 + 2MD^2 paramètres. Lorsque M = 2, cela donne 13D^2 paramètres. Le bloc de transformation DiT a des paramètres 12D^2 dans sa couche de transformation principale ; cependant, l'architecture DiT a beaucoup plus de paramètres dans d'autres composants de couche (normalisation de couche adaptative). Les chercheurs ont fait correspondre les paramètres de leurs expériences en utilisant des couches DIFFUSSM supplémentaires.

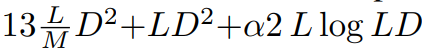

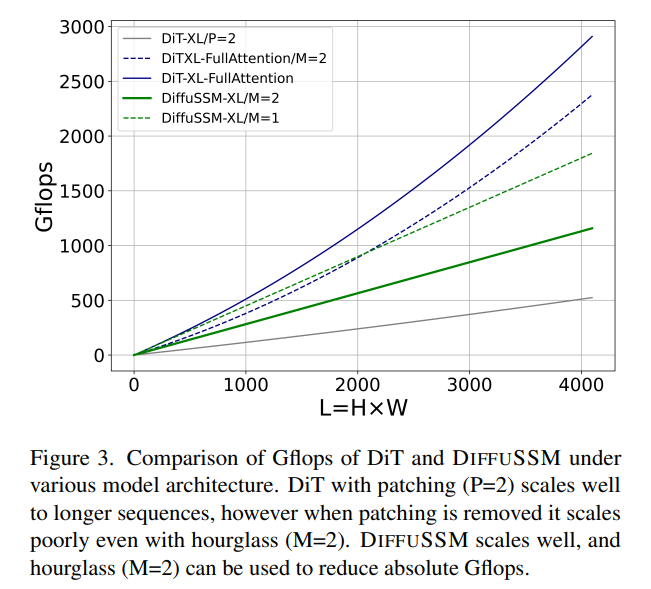

FLOPs : la figure 3 compare les Gflops entre DiT et DIFFUSSM. Le total des Flops d'une couche DIFFUSSM est

, où α représente la constante implémentée par FFT. Cela donne environ 7,5LD^2 Gflops lorsque M = 2 et que les couches linéaires dominent le calcul. En comparaison, si l'auto-attention complète est utilisée à la place du SSM dans cette architecture en sablier, il y a 2DL^2 Flops supplémentaires.

Considérez deux scénarios expérimentaux : 1) D ≈ L = 1024, ce qui entraînera 2LD^2 Flops supplémentaires, 2) 4D ≈ L = 4096, ce qui entraînera 8LD^2 Flops et augmentera considérablement le coût. . Étant donné que le coût de base du SSM bidirectionnel est faible par rapport au coût d’utilisation de l’attention, l’utilisation d’une architecture en sablier ne fonctionne pas pour les modèles basés sur l’attention. Comme indiqué précédemment, DiT évite ces problèmes en utilisant le chunking au détriment de la représentation compressée.

Résultats expérimentaux

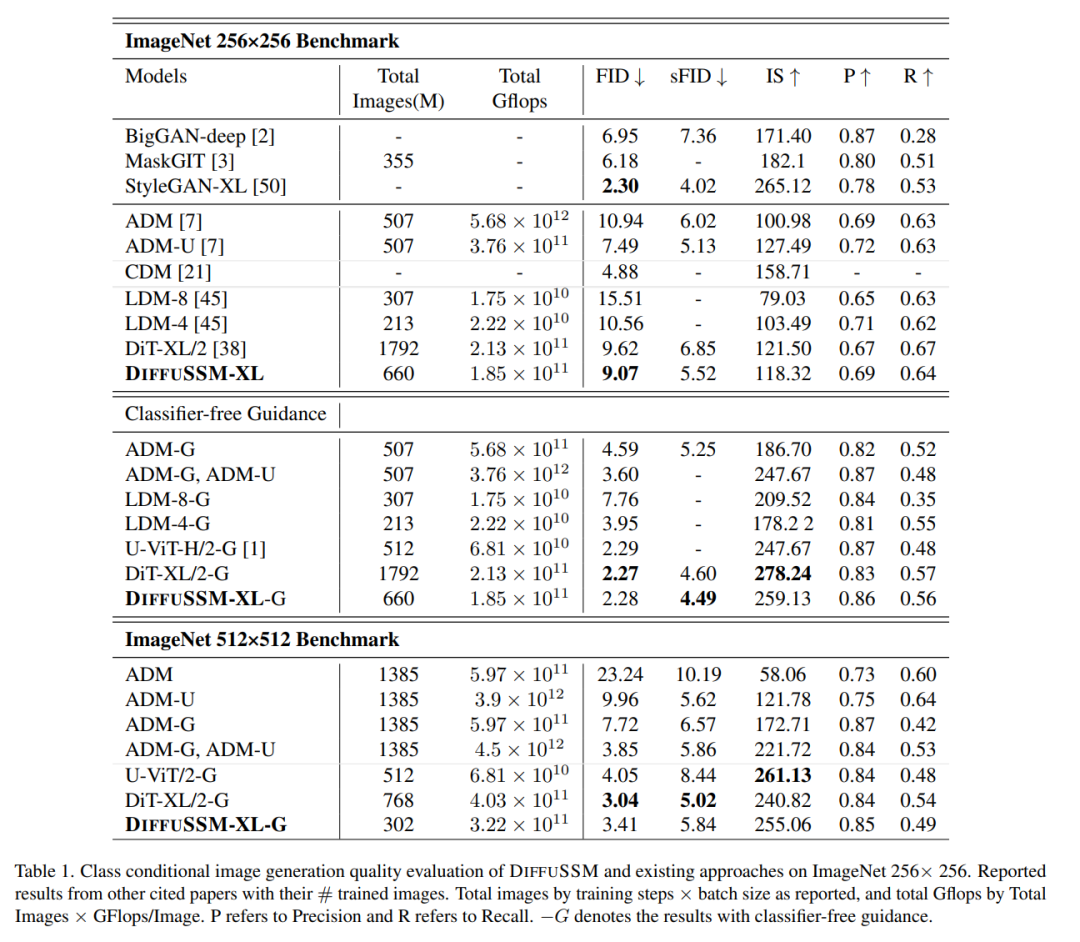

Le tableau suivant présente les résultats de comparaison de DIFFUSSM avec tous les modèles de génération de condition de catégorie de pointe actuels

Lorsque Aucun n'est utilisé Lorsqu'il est guidé par un classificateur, DIFFUSSM surpasse les autres modèles de diffusion dans les deux FID et sFID, réduisant le meilleur score du modèle de diffusion potentiel précédent sans guidage du classificateur de 9,62 à 9,07, tout en réduisant le nombre d'étapes de formation utilisées. à 1/3 environ. En termes de nombre total de Gflops entraînés, le modèle non compressé réduit le total de Gflops de 20 % par rapport au DiT. Lorsque le guidage sans classificateur est introduit, le modèle obtient le meilleur score sFID parmi tous les modèles basés sur DDPM, surpassant ainsi les autres stratégies de pointe, indiquant que les images générées par DIFFUSSM sont plus robustes à la distorsion spatiale.

Lorsque Aucun n'est utilisé Lorsqu'il est guidé par un classificateur, DIFFUSSM surpasse les autres modèles de diffusion dans les deux FID et sFID, réduisant le meilleur score du modèle de diffusion potentiel précédent sans guidage du classificateur de 9,62 à 9,07, tout en réduisant le nombre d'étapes de formation utilisées. à 1/3 environ. En termes de nombre total de Gflops entraînés, le modèle non compressé réduit le total de Gflops de 20 % par rapport au DiT. Lorsque le guidage sans classificateur est introduit, le modèle obtient le meilleur score sFID parmi tous les modèles basés sur DDPM, surpassant ainsi les autres stratégies de pointe, indiquant que les images générées par DIFFUSSM sont plus robustes à la distorsion spatiale.

Le score FID de DIFFUSSM surpasse tous les modèles lors de l'utilisation d'un guidage sans classificateur et maintient un écart assez faible (0,01) par rapport à DiT. Notez que DIFFUSSM, entraîné avec une réduction de 30 % du total des Gflops, surpasse déjà DiT sans appliquer de guidage sans classificateur. U-ViT est une autre architecture basée sur Transformer, mais utilise une architecture basée sur UNet avec des connexions à long saut entre les blocs. U-ViT utilise moins de FLOP et fonctionne mieux avec une résolution de 256 × 256, mais ce n'est pas le cas dans l'ensemble de données 512 × 512. L'auteur compare principalement avec DiT Par souci d'équité, cette connexion à long saut n'est pas adoptée. L'auteur estime que l'idée d'adopter U-Vit peut être bénéfique à la fois pour DiT et DIFFUSSM.

Les auteurs effectuent en outre des comparaisons sur des références à plus haute résolution en utilisant des conseils sans classificateur. Les résultats de DIFFUSSM sont relativement solides et proches des modèles haute résolution de pointe, seulement inférieurs à DiT sur sFID, et atteignent des scores FID comparables. DIFFUSSM a été formé sur 302 millions d'images, a observé 40 % des images et a utilisé 25 % de Gflops en moins que DiT

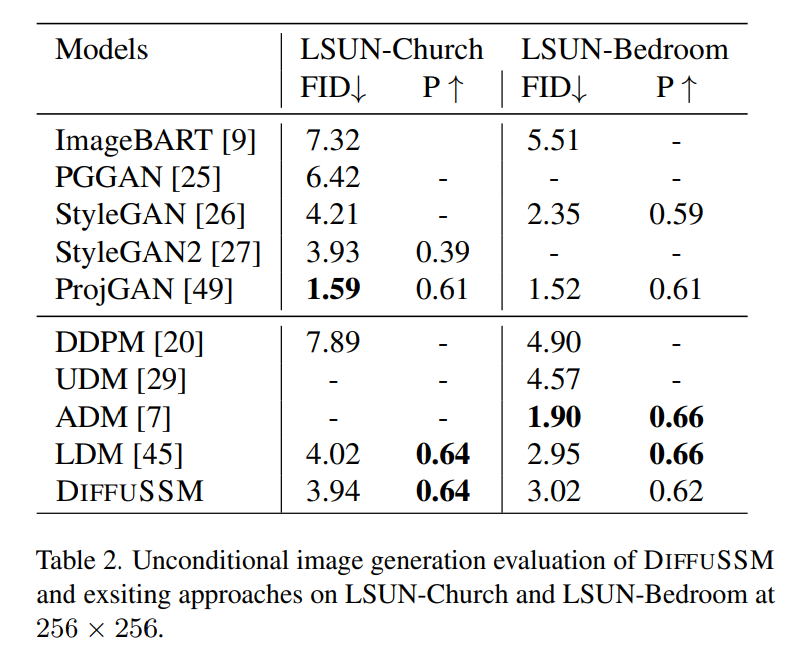

Génération d'images inconditionnelles

Basé sur l'estimation de l'auteur des capacités de génération d'images inconditionnelles du modèle. de la comparaison sont présentés dans le tableau 2. Les recherches de l'auteur ont révélé qu'avec un budget de formation comparable à celui du LDM, DIFFUSSM a obtenu des scores FID comparables (différences de -0,08 et 0,07). Ce résultat met en évidence l’applicabilité de DIFFUSSM sur différents benchmarks et différentes tâches. Semblable à LDM, cette méthode ne surpasse pas ADM sur la tâche LSUN-Bedrooms puisqu'elle n'utilise que 25 % du budget total de formation d'ADM. Pour cette tâche, le meilleur modèle GAN surpasse le modèle de diffusion dans la catégorie de modèle

Veuillez vous référer à l'article original pour plus de détails

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Comment résoudre l'erreur de restauration du site Web

Comment résoudre l'erreur de restauration du site Web Que signifie l'activité ?

Que signifie l'activité ? Comment couper de longues photos sur les téléphones mobiles Huawei

Comment couper de longues photos sur les téléphones mobiles Huawei Comment changer pycharm en chinois

Comment changer pycharm en chinois Comment convertir le format wav

Comment convertir le format wav Comment mettre à jour le pilote de la carte graphique

Comment mettre à jour le pilote de la carte graphique Qu'est-ce qu'un élément caché dans jquery

Qu'est-ce qu'un élément caché dans jquery Que dois-je faire si mon compte QQ est volé ?

Que dois-je faire si mon compte QQ est volé ?