Récemment, Alibaba Cloud Linux 3 a fourni quelques optimisations et mises à niveau pour rendre l'expérience de développement d'IA plus efficace. Cet article est un aperçu de la série d'articles « Introduction aux capacités d'IA d'Alibaba Cloud Linux 3 ». exemple pour démontrer Alibaba Cloud Linux 3. Prise en charge de l'écosystème IA. Ensuite, deux séries d'articles seront publiées, présentant principalement l'image du marché du cloud basée sur Alinux pour fournir aux utilisateurs un environnement logiciel de base d'IA prêt à l'emploi, et introduisant la différenciation des capacités d'IA basées sur AMD. Restez à l'écoute. Pour plus d'informations sur Alibaba Cloud Linux 3, veuillez visiter le site officiel : https://www.aliyun.com/product/ecs/alinux

Lors du développement d'applications d'intelligence artificielle (IA) sur des systèmes d'exploitation Linux, les développeurs peuvent rencontrer certains défis, notamment :

1. Pilote GPU: Afin d'utiliser un GPU NVIDIA pour la formation ou l'inférence sur un système Linux, le pilote GPU NVIDIA correct doit être installé et configuré. Certains travaux supplémentaires peuvent être nécessaires car différents systèmes d'exploitation et modèles de GPU peuvent nécessiter des pilotes différents.

2. AI Framework Compilation: lors de la programmation avec un framework AI sur un système Linux, vous devez installer et configurer le compilateur approprié et d'autres dépendances. Ces frameworks nécessitent souvent une compilation, vous devez donc vous assurer que le compilateur et les autres dépendances sont correctement installés et que le compilateur est correctement configuré.

3. Compatibilité logicielle: Le système d'exploitation Linux prend en charge de nombreux logiciels et outils différents, mais il peut y avoir des problèmes de compatibilité entre les différentes versions et distributions. Cela peut empêcher certains programmes de fonctionner correctement ou être indisponibles sur certains systèmes d'exploitation. Par conséquent, le personnel de R&D doit comprendre la compatibilité logicielle de son environnement de travail et effectuer les configurations et modifications nécessaires.

4. Problèmes de performances: La pile logicielle d'IA est un système extrêmement complexe qui nécessite généralement une optimisation professionnelle de différents modèles de CPU et de GPU pour atteindre ses meilleures performances. L'optimisation des performances de la collaboration logicielle et matérielle est une tâche difficile pour les piles logicielles d'IA, nécessitant un haut niveau de technologie et d'expertise.

Alibaba Cloud Linux 3, le système d'exploitation de serveur cloud de troisième génération d'Alibaba Cloud (ci-après dénommé « Alinux 3 »), est une version commerciale du système d'exploitation développé sur la base d'Anolis OS, offrant aux développeurs une puissante plateforme de développement d'IA., En prenant en charge le dépôt écologique Dragon Lizard (epao), Alinux 3 a entièrement pris en charge l'écosystème GPU nvidia grand public et CUDA, rendant le développement de l'IA plus pratique et efficace. En outre, Alinux 3 prend également en charge l'optimisation de l'IA par différentes plates-formes de processeur telles que les frameworks d'IA grand public TensorFlow/PyTorch et Intel/amd. Il introduira également une prise en charge native des SDK de grands modèles tels que modelscope et huggingface, offrant aux développeurs de riches ressources et. outil. Ces supports font d'Alinux 3 une plate-forme complète de développement d'IA, résolvant les problèmes des développeurs d'IA sans avoir à manipuler constamment l'environnement, rendant l'expérience de développement d'IA plus facile et plus efficace.Alinux 3 offre aux développeurs une puissante plateforme de développement d'IA. Afin de résoudre les défis ci-dessus que les développeurs peuvent rencontrer, Alinux 3 propose les mises à niveau d'optimisation suivantes :

1.Alinux 3 aide les développeurs à installer les pilotes GPU NVIDIA grand public et les bibliothèques d'accélération CUDA en un seul clic en introduisant le référentiel de logiciels écologiques Dragon Lizard (epao)

, ce qui permet aux développeurs de gagner du temps pour faire correspondre les versions des pilotes et pour l'installation manuelle.2. L'entrepôt epao prend également en charge laversion du framework d'IA grand public Tensorflow/PyTorch

Dans le même temps, le problème de dépendance du framework d'IA sera automatiquement résolu pendant le processus d'installation. pour effectuer une compilation supplémentaire et peut rapidement correspondre à l'environnement de développement Python du système.3. Avant que les capacités d'IA d'Alinux 3 ne soient fournies aux développeurs,tous les composants ont été testés pour la compatibilité

Les développeurs peuvent installer les capacités d'IA correspondantes en un seul clic, éliminant ainsi les dépendances du système qui peuvent apparaître dans la configuration de l'environnement. pour améliorer la stabilité pendant l'utilisation.4. Alinux 3 a été spécialement optimisé pour l'IA pour les processeurs sur différentes plates-formes telles qu'Intel/AMD afin de mieuxlibérer toutes les performances du matériel

.5. Afin de s'adapter plus rapidement à l'itération rapide de l'industrie AIGC, Alinux 3 introduira également la prise en charge native des SDK de grands modèles tels que ModelScope et HuggingFace, offrant aux développeurs une richesse de ressources et d'outils.

Grâce à la prise en charge de l'optimisation multidimensionnelle, Alinux 3 est devenu une plate-forme complète de développement d'IA, résolvant les problèmes des développeurs d'IA et rendant l'expérience de développement d'IA plus facile et plus efficace.Ce qui suit utilise les instances GPU Alibaba Cloud comme exemple pour démontrer la prise en charge d'Alinux 3 pour l'écosystème IA :

1. Achetez une instance GPU

2. Sélectionnez l'image Alinux 3

3. Installez la configuration du dépôt epao

dnf install -y anolis-epao-release

4. Installez le pilote GPU nvidia

Avant d'installer le pilote nvidia, assurez-vous que kernel-devel est installé pour garantir que le pilote nvidia est installé avec succès.

dnf install -y kernel-devel-$(uname-r)

Installer le pilote nvidia :

dnf install -y pilote-nvidia pilote-nvidia-cuda

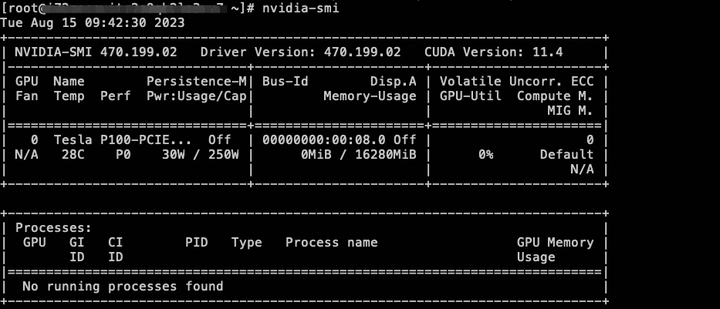

Une fois l'installation terminée, vous pouvez vérifier l'état du périphérique GPU via la commande nvidia-smi.

5. Installez la bibliothèque écologique cuda

dnf install -y cuda

6. Installez le framework AI tensorflow/pytorch

Actuellement, la version CPU de tensorflow/pytorch est fournie et la version GPU du framework AI sera prise en charge à l'avenir.

dnf installer tensorflow -y dnf installer pytorch -y

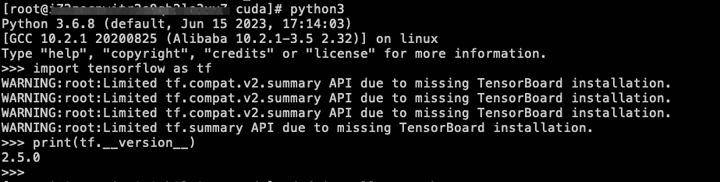

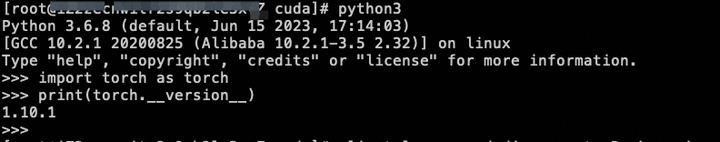

Une fois l'installation terminée, vous pouvez vérifier si l'installation a réussi grâce à une simple commande :

7. Modèle de déploiement

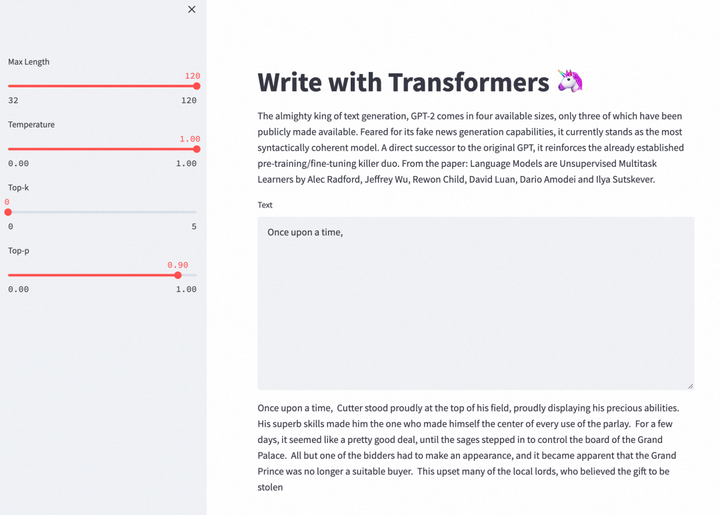

Grâce au support écologique d'Alinux 3 pour l'IA, le modèle GPT-2 Large peut être déployé pour poursuivre la tâche de rédaction de cet article.

Installez Git et Git LFS pour faciliter le téléchargement ultérieur des modèles.

dnf install -y git git-lfs wget

Mettre à jour pip pour faciliter le déploiement ultérieur de l'environnement Python.

python -m pip install --upgrade pip

Activez la prise en charge de Git LFS.

installer git lfs

Téléchargez le code source du projet write-with-transformer et le modèle pré-entraîné. Le projet write-with-transformer est une application d'écriture Web qui peut utiliser le grand modèle GPT-2 pour continuer à écrire du contenu.

clone git https://huggingface.co/spaces/merve/write-with-transformer

GIT_LFS_SKIP_SMUDGE=1 clone git https://huggingface.co/gpt2-large

wget https://huggingface.co/gpt2-large/resolve/main/pytorch_model.bin -O gpt2-large/pytorch_model.bin

Installez les dépendances requises par write-with-transformer.

cd ~/écrire avec le transformateur

pip install --ignore-installed pyyaml==5.1

pip install -r exigences.txt

Une fois l'environnement déployé, vous pouvez exécuter la version Web de l'APP pour découvrir le plaisir d'écrire à l'aide de GPT-2. Actuellement, GPT-2 ne prend en charge que la génération de texte en anglais.

cd ~/écrire avec le transformateur

sed -i 's?"gpt2-large"?"../gpt2-large"?g' app.py

sed -i '34s/10/32/;34s/30/120/' app.py

exécution simplifiée app.py --server.port 7860

URL externe : http://

Cliquez pour essayer le produit cloud gratuitement dès maintenant : https://click.aliyun.com/m/1000373503/

Lien original : https://click.aliyun.com/m/1000379727/

Cet article est un contenu original d'Alibaba Cloud et ne peut pas être reproduit sans autorisation.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Explication détaillée de l'événement onbeforeunload

Explication détaillée de l'événement onbeforeunload Méthode de récupération supprimée ntuser.dat

Méthode de récupération supprimée ntuser.dat Introduction à l'utilisation du serveur FTP

Introduction à l'utilisation du serveur FTP Introduction aux touches de raccourci pour réduire Windows Windows

Introduction aux touches de raccourci pour réduire Windows Windows Comment acheter et vendre du Bitcoin sur la plateforme Ouyi

Comment acheter et vendre du Bitcoin sur la plateforme Ouyi L'ordinateur portable n'a soudainement plus d'option WLAN

L'ordinateur portable n'a soudainement plus d'option WLAN Comment effacer le constructeur de chaînes

Comment effacer le constructeur de chaînes Domaines d'application du DSP

Domaines d'application du DSP