L'un des phénomènes les plus mystérieux dans l'émergence des grands modèles est le Chain of Thought Tips (CoT), qui a montré des résultats étonnants, notamment dans la résolution de problèmes de raisonnement mathématique et de prise de décision. Quelle est l’importance du CoT ? Quel est le mécanisme de son succès ? Dans cet article, plusieurs chercheurs de l'Université de Pékin prouvent que CoT est indispensable pour réaliser l'inférence de grands modèles de langage (LLM) et révèlent comment CoT peut libérer l'énorme potentiel du LLM d'un point de vue théorique et expérimental.

Des recherches récentes ont montré que l'incitation par chaîne de pensée (CoT) peut améliorer considérablement les performances des grands modèles de langage (LLM) et est particulièrement adaptée au traitement de tâches complexes impliquant des mathématiques ou du raisonnement. Mais malgré de nombreux succès, les mécanismes derrière les CoT et la manière de libérer le potentiel des LLM restent insaisissables.

Récemment, une nouvelle étude de l'Université de Pékin a révélé le mystère derrière CoT d'un point de vue théorique. Le grand modèle de langage basé sur un transformateur est devenu un modèle universel dans le traitement du langage naturel, sur diverses tâches. Tous ont été largement utilisé. Les grands modèles traditionnels sont généralement mis en œuvre sur la base du paradigme autorégressif. Plus précisément, diverses tâches (telles que la traduction de texte, la génération de texte, la réponse à des questions, etc.) peuvent être uniformément considérées comme des problèmes de génération de séquences, dans lesquels la saisie de la question et la description. de la question sont codés ensemble dans une séquence de mots (jeton), appelée invite (invite) ; la réponse à la question peut être transformée en tâche de génération conditionnelle de mots suivants sur la base de l'invite ;

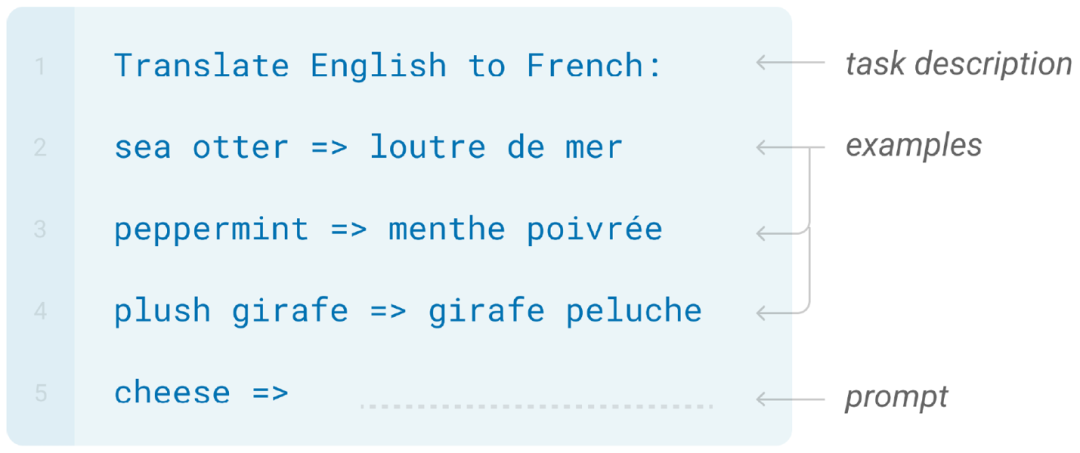

Un grand nombre d'études dans le domaine des grands modèles ont montré que des mots d'invite soigneusement conçus jouent un rôle crucial dans les performances du modèle. Il a été démontré que CoT améliore considérablement l'exactitude des réponses générées, notamment lorsqu'il s'agit de tâches liées à l'arithmétique ou au raisonnement. Comme le montre la figure ci-dessous, pour une tâche qui nécessite un raisonnement mathématique, les réponses directement générées par les grands modèles sont souvent fausses (figures a,b ci-dessous). Cependant, si vous modifiez les invites pour que le grand modèle génère toute la chaîne de réflexion (étapes de dérivation intermédiaires), vous pourrez éventuellement obtenir la bonne réponse (c, d ci-dessous).

En pratique, il existe deux manières courantes de mettre en œuvre l'invite de chaîne de pensée : la première consiste à ajouter une phrase spécifique à l'invite, telle que "Réfléchissons étape par étape" pour la déclencher (comme indiqué dans la figure c ci-dessus) ; l'autre consiste à permettre au grand modèle de simuler le processus de dérivation correspondant en fournissant un petit nombre d'exemples de démonstrations de chaînes de réflexion (comme le montre la figure d ci-dessus).

Plus précisément, les chercheurs étudient CoT du point de vue de la capacité d'expression du modèle : Pour les tâches mathématiques et les tâches générales de prise de décision, cet article étudie la capacité d'expression du modèle Transformer basé sur l'autorégression dans les deux aspects suivants : (1) Générer répond directement, et (2) générer des étapes de solution complètes à l’aide de CoT.

CoT est la clé pour résoudre des problèmes mathématiques

CoT est la clé pour résoudre des problèmes mathématiques

Les grands modèles représentés par GPT-4 ont démontré des capacités mathématiques étonnantes. Par exemple, il peut résoudre correctement la plupart des problèmes de mathématiques au lycée et est même devenu un assistant de recherche pour les mathématiciens.

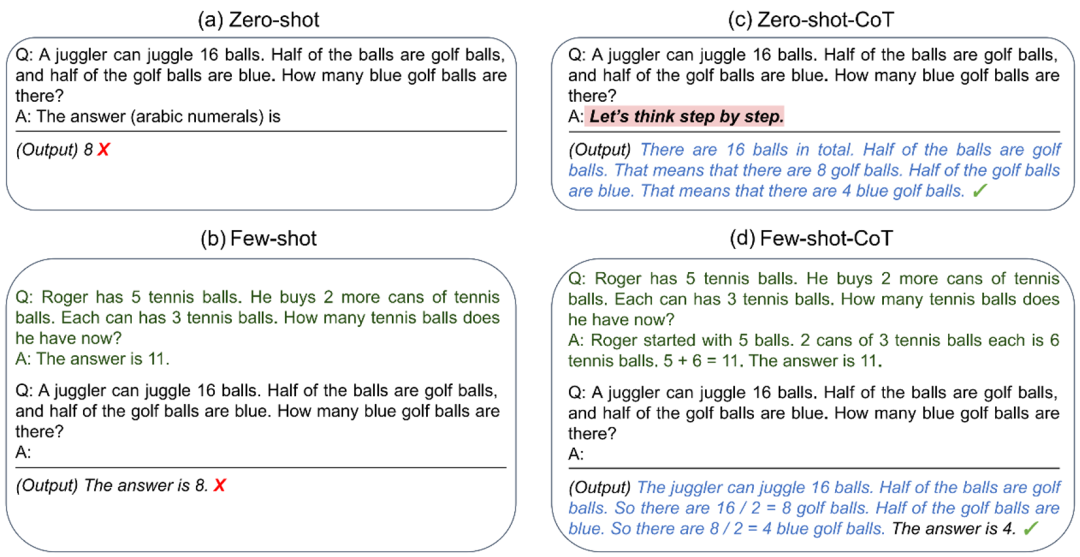

Afin d'étudier les capacités mathématiques des grands modèles, cet article a sélectionné deux tâches mathématiques très basiques mais essentielles : l'arithmétique et les équations (la figure suivante donne des exemples d'entrée et de sortie de ces deux tâches). Puisqu’il s’agit de composants fondamentaux pour résoudre des problèmes mathématiques complexes, en étudiant ces deux problèmes mathématiques fondamentaux, nous pouvons mieux comprendre les capacités des grands modèles sur des problèmes mathématiques généraux.

Les chercheurs ont d'abord examiné si Transformer pouvait fournir des réponses aux questions ci-dessus sans générer d'étapes intermédiaires. Ils ont considéré une hypothèse très cohérente avec la réalité : un transformateur de précision logarithmique, c'est-à-dire que chaque neurone du transformateur ne peut représenter qu'un nombre à virgule flottante de précision limitée (la précision est de log n bits), où n est la longueur maximale. de la phrase. Cette hypothèse est très proche de la réalité, par exemple dans GPT-3, la précision de la machine (16 ou 32 bits) est généralement bien inférieure à la longueur maximale de la phrase de sortie (2048).

Sous cette hypothèse, les chercheurs ont prouvé un résultat impossible : Pour un modèle de transformateur autorégressif avec une couche constante et une largeur de d, lors de la résolution des deux problèmes mathématiques ci-dessus en produisant directement des réponses, il est nécessaire d'utiliser extrêmement grand modèle largeur d. Plus précisément, d doit devenir plus grand que le polynôme à mesure que la longueur d'entrée n augmente.

La raison essentielle de ce résultat est qu'il n'existe pas d'algorithme parallèle efficace pour les deux problèmes ci-dessus, donc Transformer, en tant que modèle parallèle typique, ne peut pas les résoudre. L’article utilise la théorie de la complexité des circuits en informatique théorique pour prouver rigoureusement le théorème ci-dessus.

Et si le modèle ne génère pas la réponse directement, mais génère les étapes de dérivation intermédiaires sous la forme de la figure ci-dessus ? Les chercheurs ont en outre prouvé par construction que lorsque le modèle peut générer des étapes intermédiaires, un modèle de transformateur autorégressif de taille fixe (ne dépendant pas de la longueur d'entrée n) peut résoudre les deux problèmes mathématiques ci-dessus. En comparant les résultats précédents, on peut voir que l'ajout de CoT améliore considérablement la capacité d'expression des grands modèles. Les chercheurs ont en outre donné une compréhension intuitive de cela : en effet, l'introduction de CoT renverra continuellement les mots de sortie générés à la couche d'entrée, ce qui augmente considérablement la profondeur effective du modèle, le rendant proportionnel à la longueur de sortie de CoT. améliorant ainsi considérablement l'efficacité du modèle. La complexité parallèle de Transformer a été grandement améliorée.

CoT est la clé pour résoudre des problèmes généraux de prise de décision

En plus des problèmes mathématiques, les chercheurs ont également examiné la capacité de CoT à résoudre des tâches générales. Partant du problème de prise de décision, ils ont considéré un cadre général pour résoudre les problèmes de prise de décision, appelé programmation dynamique.L'idée de base de la programmation dynamique (DP) est de décomposer un problème complexe en une série de sous-problèmes à petite échelle qui peuvent être résolus en séquence. La décomposition du problème garantit qu'il existe une interrelation (chevauchement) significative entre les différents sous-problèmes, de sorte que chaque sous-problème puisse être résolu efficacement en utilisant les réponses aux sous-problèmes précédents.

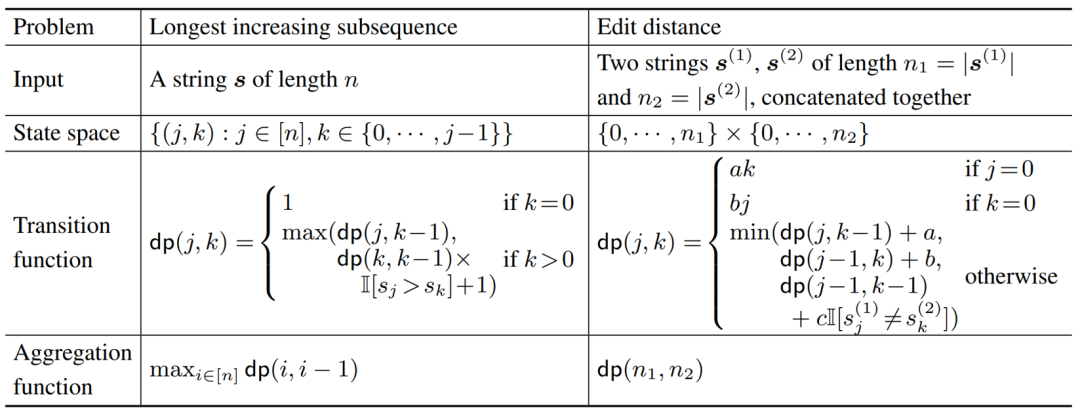

La sous-séquence ascendante la plus longue (LIS) et la résolution de la distance d'édition (ED) sont deux problèmes DP célèbres proposés dans le livre "Introduction aux algorithmes". Le tableau suivant répertorie les espaces d'état et les transitions de ces deux problèmes. de fonction.

Les chercheurs ont prouvé que le modèle de transformateur autorégressif peut produire une chaîne de pensée de programmation dynamique complète dans l'ordre de résoudre des sous-problèmes, de sorte qu'il puisse produire toutes les tâches qui peuvent être résolues par programmation dynamique Bonne réponse. De même, les chercheurs ont en outre démontré que les chaînes de pensée génératives sont nécessaires : pour de nombreux problèmes de programmation dynamique difficiles, un modèle Transformer à couche constante et de taille polynomiale ne peut pas directement produire la bonne réponse. L'article donne un contre-exemple au problème des tests d'appartenance à la grammaire sans contexte.

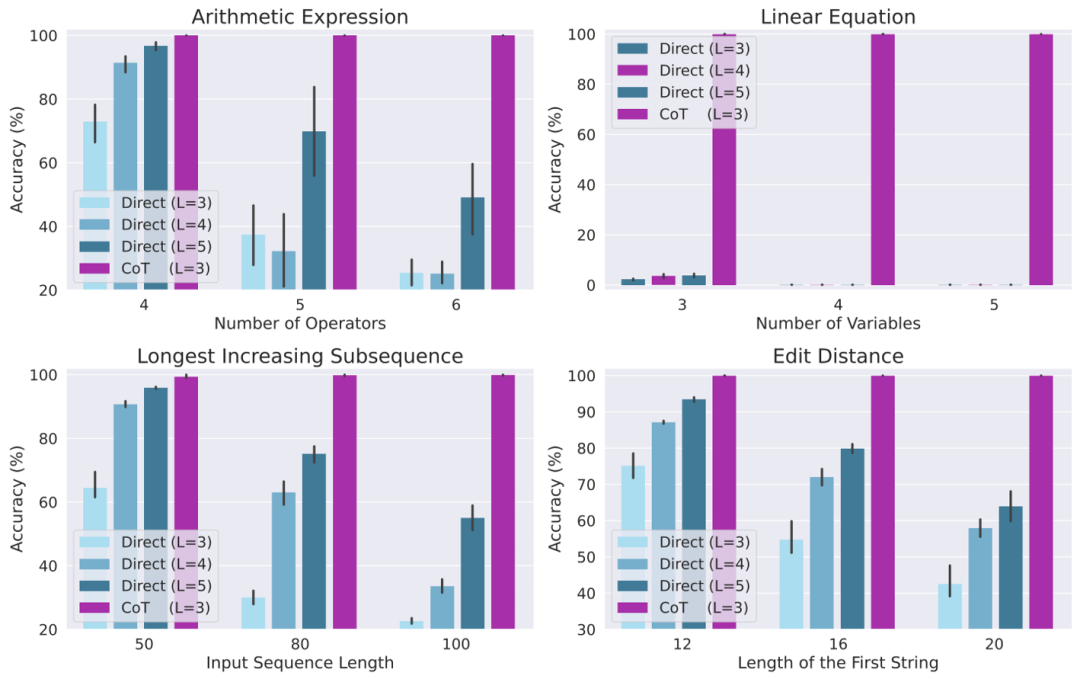

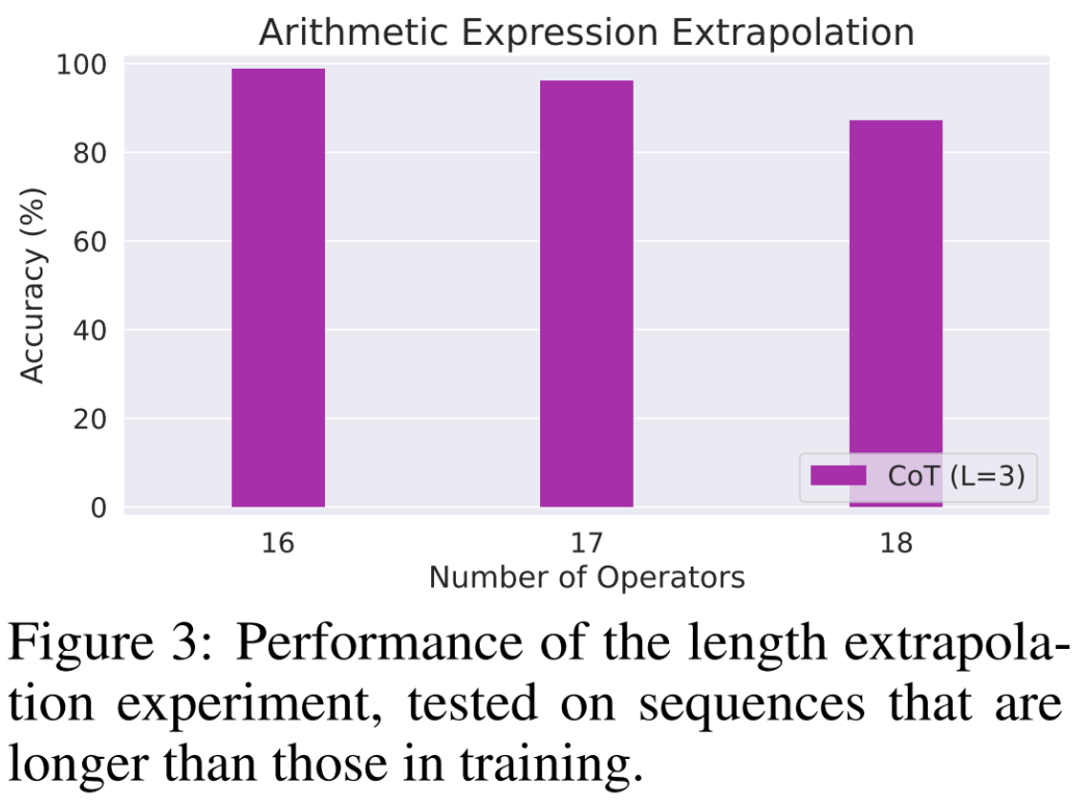

ExpériencesLes chercheurs ont finalement conçu un grand nombre d'expériences pour vérifier la théorie ci-dessus, en considérant quatre tâches différentes : évaluer des expressions arithmétiques, résoudre des équations linéaires, résoudre la sous-séquence ascendante la plus longue et résoudre la distance d'édition.Les résultats expérimentaux montrent que lorsqu'il est entraîné à l'aide de données CoT, un modèle de transformateur autorégressif à 3 couches a pu atteindre des performances presque parfaites sur toutes les tâches. Cependant, la sortie directe de la bonne réponse donne de mauvais résultats sur toutes les tâches (même avec des modèles plus profonds). Ce résultat démontre clairement la capacité du transformateur autorégressif à résoudre une variété de tâches complexes et démontre l'importance du CoT dans la résolution de ces tâches.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

La différence entre maître et hôte

La différence entre maître et hôte

La différence entre le masquage et le démasquage des caractères génériques

La différence entre le masquage et le démasquage des caractères génériques

Quels sont les sept principes des spécifications du code PHP ?

Quels sont les sept principes des spécifications du code PHP ?

Logiciel d'enregistrement du temps

Logiciel d'enregistrement du temps

Comment utiliser Winimage

Comment utiliser Winimage

Comment afficher le code source de Tomcat

Comment afficher le code source de Tomcat

outils de développement php

outils de développement php

Comment utiliser la fonction de filtre

Comment utiliser la fonction de filtre