En mars de cette année, face à la tendance croissante de l'IA, le « Silicon Valley Sword King » a changé son attitude japonaise et a pris l'initiative de monter sur scène et a annoncé le lancement de DGX Cloud, mettant des GPU spécifiques à l'IA sur le cloud pour la « location ».

Dans le passé, les sociétés de cloud computing étaient chargées de vendre la puissance de calcul. Ils achètent plusieurs modèles de cartes graphiques et d'accélérateurs d'intelligence artificielle, les fixent en fonction des performances matérielles ou de la durée d'utilisation, puis les louent à des clients en aval.

Dans ce processus, NVIDIA vend des GPU à des plates-formes de cloud computing ou directement à des sociétés d'IA. Par exemple, le premier supercalculateur NVIDIA DGX a été livré à OpenAI par Huang personnellement en 2016. Il n'a pas vendu de puissance de calcul directement, tout au plus. "vendeur de pelle".

Quant à la transition du DGX vers le cloud, même si NVIDIA doit encore l'héberger sur la plate-forme cloud, il a essentiellement franchi la frontière.

Nvidia, qui a toujours été en coulisses, pourquoi est-il passé au premier plan cette fois-ci ?

NVIDIA est sans aucun doute le plus grand bénéficiaire de ce boom de l'IA, peut-être même aucun.

Le prix des puces GPU utilisées pour entraîner l'IA a grimpé en flèche. Les prix à l'étranger des A100 et H100 par puce ont augmenté respectivement à 15 000 $ US et 40 000 $ US. Le prix d'un serveur d'IA national équipé de 8 A100 et d'un espace de stockage de 80 G a également augmenté. depuis le milieu de l’année dernière, 80 000/unité ont grimpé pour atteindre 1,65 million/unité actuellement.

Mais tout l'argent n'a pas afflué dans les poches de NVIDIA, et la prime a été retirée par les canaux. La clé est qu'il n'y a aucun moyen d'acheter et de vendre NVIDIA.

DGX Cloud est né dans cette situation, et le prix clé semble être très bon marché. Le DGX Cloud équipé de 8 modules GPU H100 dispose d'un forfait mensuel de seulement 37 000 $ US, ce qui équivaut au prix d'un seul H100.

Pour les entreprises d'IA qui ont un besoin urgent de puissance de calcul et de fonds mais qui sont à court de ressources, DGX Cloud est sans aucun doute un oreiller qui tombe du ciel lorsqu'elles dorment ; pour NVIDIA, vendre de la puissance de calcul en nuage peut non seulement rapporter de l'argent, mais aussi lier. clients.

Mais derrière cette situation apparemment gagnant-gagnant se cache une guerre secrète qui commence avec l’IA.

Puissance de calcul égale

Du point de vue des caractéristiques de l'industrie, l'AIGC actuel basé sur la puissance du cloud computing est très similaire au précédent minage d'actifs cryptographiques, mais les ressources requises sont beaucoup plus élevées que ce dernier.

Guosheng Securities a déjà comparé les similitudes et les différences entre l'extraction d'actifs cryptographiques et l'industrie AIGC dans "L'évolution de la puissance informatique de l'AIGC d'un point de vue Web3" :

1 La consommation d'énergie de l'industrie AIGC dépassera la consommation d'énergie actuelle de l'industrie minière Bitcoin dans environ 1,6 à 7,5 ans. Le principal facteur déterminant est la croissance rapide des grands modèles de langage GPT en termes de paramètres de modèle, d'activité quotidienne et de nombre de modèles. ;

2 Semblable au minage de Bitcoin, le contenu piloté par la puissance de calcul dans l'industrie AIGC est soumis à une concurrence de haute intensité. Ce n'est qu'en produisant continuellement et rapidement un contenu de haute qualité que les participants peuvent garantir que l'attention des utilisateurs qu'ils obtiennent ne diminuera pas.

Cela conduit à deux caractéristiques majeures de l’industrie AIGC : le coût élevé et la durabilité.

Parmi eux, le coût ne se limite pas à la consommation d'énergie. Bien entendu, la consommation d'énergie peut être utilisée comme une preuve très intuitive. Par exemple, le centre de calcul de Yangquan utilisé par Baidu pour entraîner le raisonnement Wen Xinyiyan consomme 64 000 kWh (degré) par heure. Selon la norme de consommation électrique commerciale de 0,45 yuan/kWh, la facture annuelle d'électricité atteint 250 millions.

Le coût le plus élevé provient de l'investissement dans la puissance de calcul.

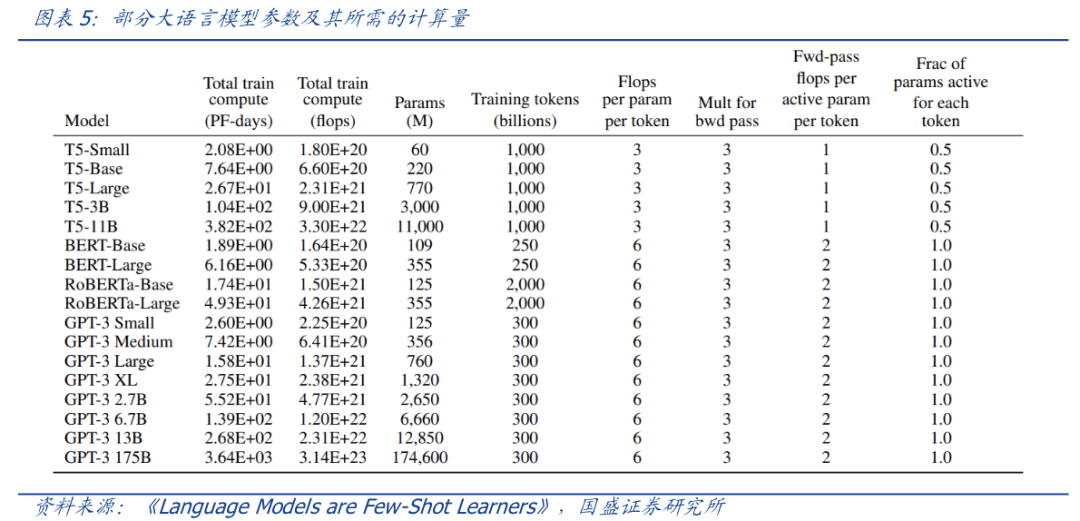

Prenons ChatGPT comme exemple. La puissance de calcul requise pour le processus d'inférence, qui est fortement liée à l'activité quotidienne, n'est pas prise en compte. Selon les calculs, une formation de GPT-3 avec 175 milliards de paramètres est nécessaire. environ 6 000 cartes graphiques Nvidia A100 si l'on prend en compte la perte d'interconnexion, environ des dizaines de milliers de A100 sont nécessaires.

Sur la base de 100 000 yuans pour une seule puce A100, une formation à grande échelle nécessite un investissement d'environ 1 milliard, ce qui est tout simplement inabordable pour les fabricants ordinaires. Les paramètres du modèle GPT-4 sont plus grands, il y a plus d'identifiants pour la formation et la puissance de calcul requise est plus considérable.

Et, avec la sortie de modèles AIGC plus grands, la puissance de calcul requise est montée en flèche.

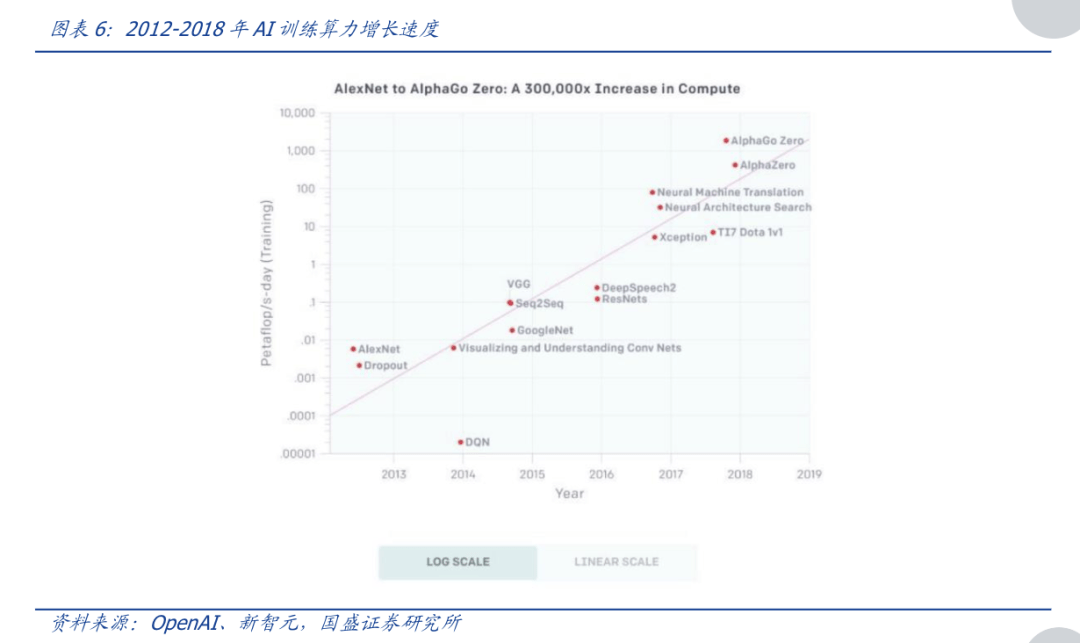

Selon les calculs d'OpenAI, de 2012 à 2018, la puissance de calcul nécessaire pour entraîner l'IA a doublé environ tous les 3-4 mois, avec une augmentation totale de 300 000 fois (alors que la loi de Moore n'a augmenté que 7 fois pendant la même période), la puissance de calcul Les exigences pour les modèles de formation des chefs augmentent jusqu'à 10 fois chaque année, et l'augmentation globale est exponentielle.

À l'heure actuelle, les avantages de la puissance du cloud computing peuvent être résumés en 8 mots : divisez-le en plusieurs parties et payez à la demande.

La puissance de calcul du cloud permet aux grands fabricants de modèles AIGC de louer directement à la demande la puissance de calcul fournie par la plate-forme de puissance de calcul en nuage sans acheter de matériel tel que les cartes graphiques NVIDIA A100. Cela permet aux start-ups ou aux fabricants de modèles non principaux d'essayer également d'entrer. le domaine AIGC.

Même cette approche du « diviser en plusieurs parties » est bénéfique pour toutes les parties de la chaîne industrielle :

1) Pour les fabricants de puissance de calcul en amont, lorsque le matériel de puissance de calcul entre hors-saison et que les stocks augmentent, ils peuvent lisser les fluctuations des revenus en vendant de la puissance de cloud computing, réserver de l'énergie « active » pour la haute saison et répondre à la demande dans un délai raisonnable. en temps opportun Rebond de la demande du marché

2) Pour les fournisseurs de services cloud intermédiaires, cela contribuera à augmenter le flux de clients

;3) Pour les demandeurs de puissance de calcul en aval, cela peut minimiser le seuil d'utilisation de la puissance de calcul et favoriser l'avènement de l'ère AIGC pour tous.

Si les grands fabricants d'AIGC sont prêts à transférer plus de ressources, ils peuvent également coopérer plus profondément avec la plateforme cloud. Un cas typique à cet égard est la coopération entre Microsoft Cloud et OpenAI. La coopération entre les deux ne se limite pas à la location de puissance de calcul, mais va en profondeur dans l'intégration des capitaux propres et des produits.

De plus, dans les compétitions de grands modèles, en plus du coût évident d'investissement matériel, il existe également un coût invisible en temps.

De manière générale, les besoins en puissance de calcul des grands modèles sont divisés en deux étapes : l'une est le processus de formation d'un grand modèle similaire à ChatGPT ; l'autre est le processus d'inférence de commercialisation de ce modèle ;

Et plus ce processus dure longtemps, mieux c'est pour les modèles plus grands. Alors maintenant, si nous regardons NVIDIA DGX Cloud, il n'est pas difficile de comprendre ce qu'a fait Lao Huang.

Utilisez la méthode cloud pour réduire le prix des GPU utilisés pour la formation en IA, conquérir les petites et moyennes entreprises avec un accès égal à la puissance de calcul, puis fidéliser les clients sur la base du facteur de durabilité de la formation à grande échelle. King" fait d'une pierre deux coups.

Ce n'est peut-être pas NVIDIA qui en profite

Depuis décembre de l'année dernière, le prix du Nvidia A100 a augmenté de 37,5 % en cinq mois, et le prix du A800 a augmenté de 20,0 % au cours de la même période.

La flambée des prix des GPU a sans aucun doute augmenté le seuil permettant à l'AIGC de former de grands modèles, mais pour les principaux fabricants, ils doivent acheter des GPU quelle que soit l'augmentation des prix. Mais pour les entreprises de taille, si le prix n'augmente pas, elles risquent de serrer la main et de passer des commandes. Une fois le prix augmenté, elles ne pourront peut-être pas compter sur les GPU. Les 50 millions de dollars de financement reçus par Wang Huiwen pour démarrer une entreprise ne pourront peut-être pas compter sur les GPU. même pouvoir acheter toutes les cartes graphiques nécessaires à la formation.

Donc, lorsque Lao Huang a retiré DGX Cloud à ce moment-là, c'était comme ouvrir une société de location de voitures de luxe, afin que les personnes qui n'en ont pas les moyens puissent également la louer.

Bien sûr, une autre considération derrière cela est de devancer les concurrents et de fidéliser davantage de clients de petite et moyenne taille.

En plus d'OpenAI, les entreprises d'IA qui sortent le plus du cercle dans cette vague d'engouement pour l'IA ne sont autres que Midjourney et Authropic. Le premier est une application de dessin d'IA qui a récemment lancé une activité nationale en coopération avec la chaîne QQ. Le fondateur du second vient d'OpenAI, et son robot conversationnel Claude compare directement ChatGPT.

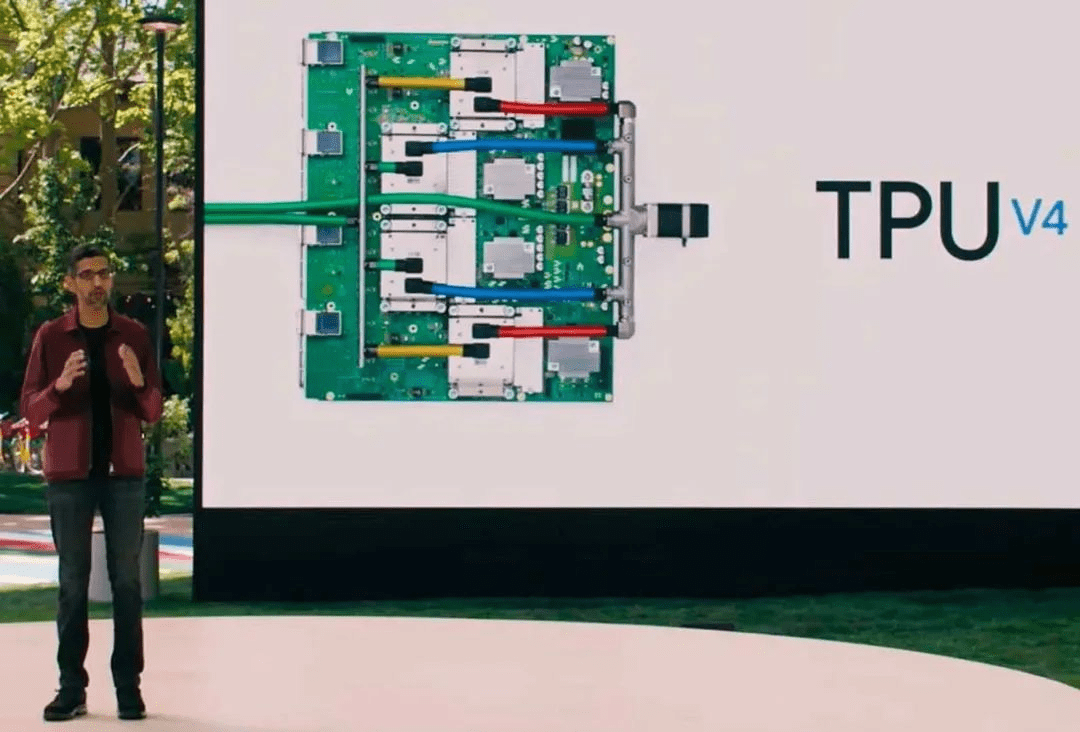

Les deux sociétés ont une chose en commun : elles n’ont pas acheté de GPU Nvidia pour construire des superordinateurs, mais ont plutôt utilisé les services informatiques de Google.

Ce service est fourni par un système de calcul intensif intégrant 4096 TPU v4, axé sur les propres recherches de Google.

Un autre géant qui se lance dans les puces auto-développées est Microsoft, le leader de cette vague d'IA. La rumeur dit que cette puce appelée Athena utilise un processus avancé de 5 nm et est fabriquée par TSMC. Le nombre d'équipes de R&D est proche de 300 personnes.

De toute évidence, l’objectif de cette puce est de remplacer les coûteux A100/H100, de fournir un moteur de puissance de calcul pour OpenAI et de s’emparer à terme du gâteau de Nvidia via le service cloud Azure de Microsoft.

En plus des trahisons des sociétés de cloud computing, le principal client de Nvidia, Tesla, veut également faire cavalier seul.

En août 2021, Musk a montré au monde extérieur le supercalculateur Dojo ExaPOD construit avec 3 000 de ses propres puces D1. Parmi elles, la puce D1 est fabriquée par TSMC et utilise un processus de 7 nm. 3 000 puces D1 font directement de Dojo le cinquième plus grand ordinateur au monde en termes de puissance de calcul.

En comparaison, même si les entreprises nationales concernées par l'interdiction ont également des projets alternatifs, elles dépendent toujours fortement de Nvidia à court terme.

Les puces nationales peuvent effectuer un travail d'inférence cloud qui ne nécessite pas une granularité d'informations aussi élevée, mais la plupart d'entre elles sont actuellement incapables de gérer une formation cloud qui nécessite une puissance de calcul ultra-élevée.

Suiyuan Technology, Biren Technology, Tianshu Zhixin, Cambrian et d'autres sociétés ont lancé leurs propres produits cloud, et les indicateurs de performance théoriques ne sont pas faibles.

Selon des informations précédemment révélées, le centre de calcul de Yangquan utilisé par Baidu pour entraîner l'inférence Wen Xinyiyan, en plus de l'A100, utilise également certains produits fabriqués dans le pays, tels que le noyau Kunlun auto-développé par Baidu et le Siyuan 590 de Cambrian, y compris News montre que Siyuan représente environ 10 à 20 % du plan d’approvisionnement pour 2023.

Parmi eux, les capacités principales de la couche de puce de Wen Xinyiyan proviennent de la puce IA Kunlun Core de 2e génération, qui utilise une architecture XPU-R auto-développée, un processus 7 nm et une mémoire vidéo haute vitesse GDDR6, améliorant considérablement la polyvalence et les performances ; INT8 et le niveau de puissance de calcul de 128 TFLOPS@FP16 est 2 à 3 fois supérieur à celui de la génération précédente.

En mars de cette année, Robin Li a également déclaré lors du Yabuli China Entrepreneur Forum que les puces Kunlun sont désormais très adaptées à l'inférence de grands modèles et seront adaptées à la formation à l'avenir.

Épilogue

À partir de RIVA128, NVIDIA a démontré ses étonnantes capacités d'observation du marché. Au cours de la dernière décennie, du minage de crypto-monnaie au métaverse en passant par le boom de l'IA, Nvidia a profité de la tendance à étendre ses clients de cartes graphiques des joueurs aux géants de la technologie.

À mesure que la guerre s’étend, la valeur marchande de Nvidia a également augmenté, passant d’une entreprise de puces de deuxième rang au numéro 1 de l’ensemble du secteur. Cependant, Huang Renxun a déclaré que le moment de l'IA iPhone était arrivé, alors comment Nvidia peut-il être invincible même si Nokia était vaincu par Apple.

Références

[1] Option longue d'AIGC : puissance de cloud computing de l'IA, Guosheng Securities

[2] Théorie de l'évolution de la puissance de calcul AIGC du point de vue de Web3, Guosheng Securities

[3] Une fissure dans l'empire NVIDIA, Yuanchuan Research Institute

[4] L'exploitation minière de la puissance du cloud computing pourrait être le moyen le plus stable d'accéder au Bitcoin à l'heure actuelle, Odaily Planet Daily

[5] Interprétation experte de « Wen Xin Yi Yan », Unicorn Think Tank de Baidu

[6] À l'ère des grands modèles, les GPU domestiques accélèrent « sauvagement », et l'ère numérique est en plein essor

[7] NVIDIA Jensen Huang : les capacités de supercalcul IA seront fournies par les fournisseurs de services cloud chinois, et l'iPhone IA arrive ! Actualités économiques en Chine

[8] Aperçu de la chaîne industrielle de la puissance de calcul de l'IA : l'itération technologique favorise les percées dans les goulots d'étranglement et l'augmentation des scénarios AIgc stimule la demande de puissance de calcul, Essence Securities

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Comment ouvrir le fichier exe

Comment ouvrir le fichier exe

La différence entre MS Office et WPS Office

La différence entre MS Office et WPS Office

Comment utiliser la fonction dateiff

Comment utiliser la fonction dateiff

tableau d'insertion de mots

tableau d'insertion de mots

Qu'est-ce qui fait que l'écran de l'ordinateur devient jaune ?

Qu'est-ce qui fait que l'écran de l'ordinateur devient jaune ?

Introduction aux caractères de retour chariot et de saut de ligne en Java

Introduction aux caractères de retour chariot et de saut de ligne en Java

Est-il nécessaire de mettre à niveau Windows 11 ?

Est-il nécessaire de mettre à niveau Windows 11 ?

Comment utiliser le stockage cloud

Comment utiliser le stockage cloud