nginx est un serveur http et un serveur proxy inverse gratuit, open source et hautes performances ; c'est également un serveur proxy imap, pop3 et smtp ; nginx peut être utilisé comme serveur http pour la publication et le traitement de sites Web, et nginx peut être utilisé comme serveur proxy inverse. Implémentation de l'équilibrage de charge vers le proxy.

Ici, nous présentons brièvement nginx à travers trois aspects

Fonctionnalités d'équilibrage de charge du proxy inverse nginx 1. Proxy inverse

À propos du proxy

En parlant de proxy, nous devons tout d'abord clarifier un concept, le soi-disant proxy est un représentant, Un canal ;

À l'heure actuelle, deux rôles sont conçus, l'un est le rôle d'agent et l'autre est le rôle cible. Le processus par lequel le rôle d'agent accède au rôle cible via cet agent pour effectuer certaines tâches est appelé. le processus de fonctionnement de l'agent ; tout comme un monopole dans la vie Magasin ~ Un client a acheté une paire de chaussures dans un magasin adidas. Ce magasin est un agent, le rôle d'agent est le fabricant adidas et le rôle cible est l'utilisateur

.

forward agent

Avant de parler d'agence inversée, regardons-le d'abord. En ce qui concerne le proxy forward, le proxy forward est également le modèle de proxy le plus courant avec lequel tout le monde entre en contact. Nous parlerons du modèle de traitement du forward proxy. proxy sous deux aspects, et expliquez ce qu'est le proxy direct du point de vue logiciel et du côté vie respectivement

Dans l'environnement réseau actuel, si nous devons accéder à certains sites Web étrangers en raison de besoins techniques, vous constaterez que nous ne pouvons pas accéder à un certain. site Web étranger via un navigateur. À l'heure actuelle, tout le monde peut utiliser un Pour utiliser fq pour accéder, la méthode principale de fq est de trouver un serveur proxy pouvant accéder aux sites Web étrangers. Nous envoyons la demande au serveur proxy et au serveur proxy. accède au site Web étranger, puis nous transmet les données consultées !

Le mode proxy ci-dessus est appelé proxy de transfert. La plus grande caractéristique du proxy de transfert est que le client est très clair sur l'adresse du serveur auquel il souhaite accéder ; le serveur sait uniquement de quel serveur proxy provient la requête, mais pas de quel client spécifique. cela vient de : positif Les informations du client réel sont bloquées ou masquées en mode proxy.

Proxy inverse

Comprenant ce qu'est un proxy direct, continuons à examiner les méthodes de traitement du proxy inverse. Par exemple, j'ai un site Web à Datianchao Le nombre de visiteurs connectés au. Le site Web à la même heure a explosé chaque jour. Le tableau 1 montre qu'un seul serveur est loin de pouvoir satisfaire le désir d'achat croissant des gens. À cette époque, un terme familier est apparu : déploiement distribué, c'est-à-dire en déployant plusieurs serveurs. pour résoudre le problème de la limitation du nombre de visiteurs ; dans un certain site Web au trésor, la plupart des fonctions sont également implémentées directement en utilisant nginx pour le proxy inverse, et après avoir encapsulé nginx et d'autres composants, il a un nom fantaisiste : tengine

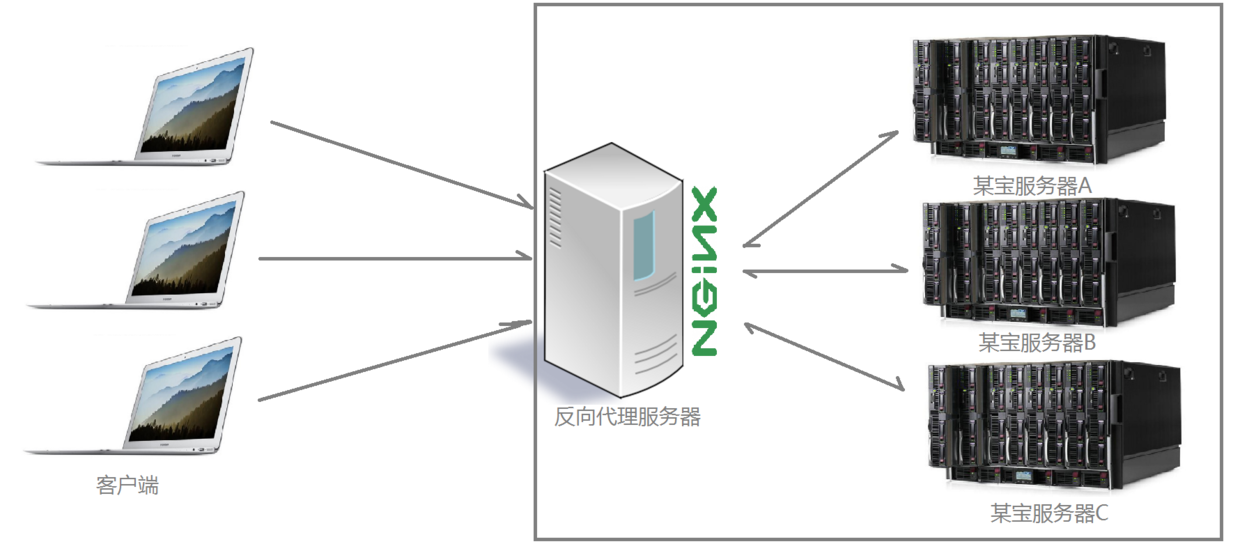

Alors, de quelle manière est-il proxy inverse implémenté et distribué ? Quant au fonctionnement du cluster, regardons d'abord un diagramme schématique :

Vous pouvez voir clairement à travers le diagramme ci-dessus Après les requêtes envoyées par plusieurs clients au serveur, le serveur nginx les reçoit. et les distribue au backend selon certaines règles. Le serveur de traitement métier à l'extrémité est traité. À l'heure actuelle, la source de la requête est claire, c'est-à-dire le client, mais il n'est pas clair quel serveur gère la requête. nginx joue le rôle d'un proxy inverse

Proxy inverse, principalement utilisé pour la distribution de clusters de serveurs dans le En cas de déploiement, le reverse proxy cache les informations du serveur !

Scénario de projet

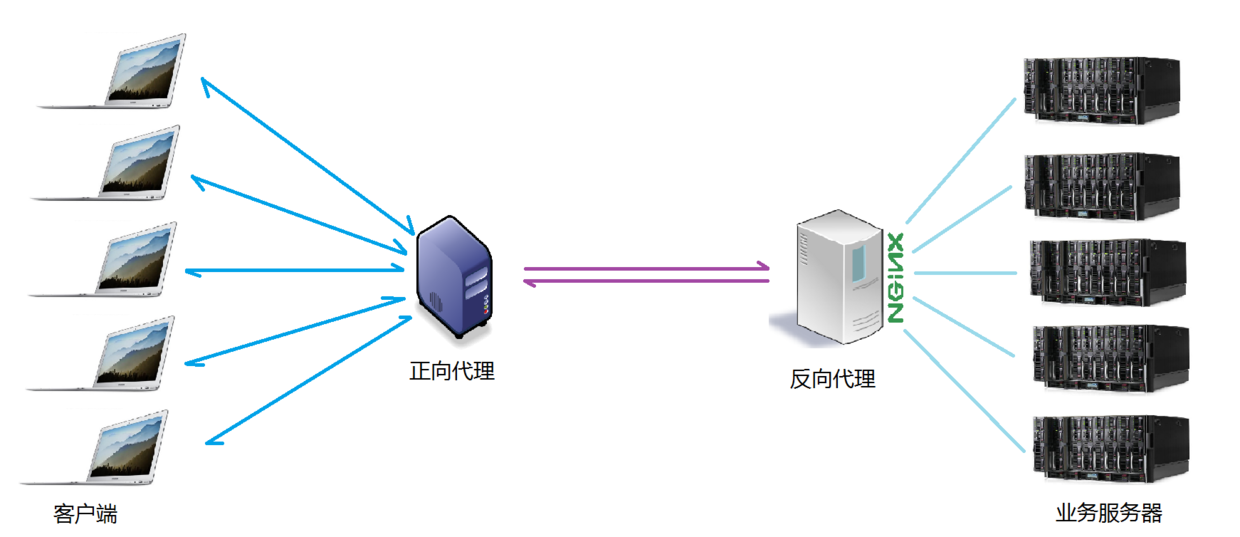

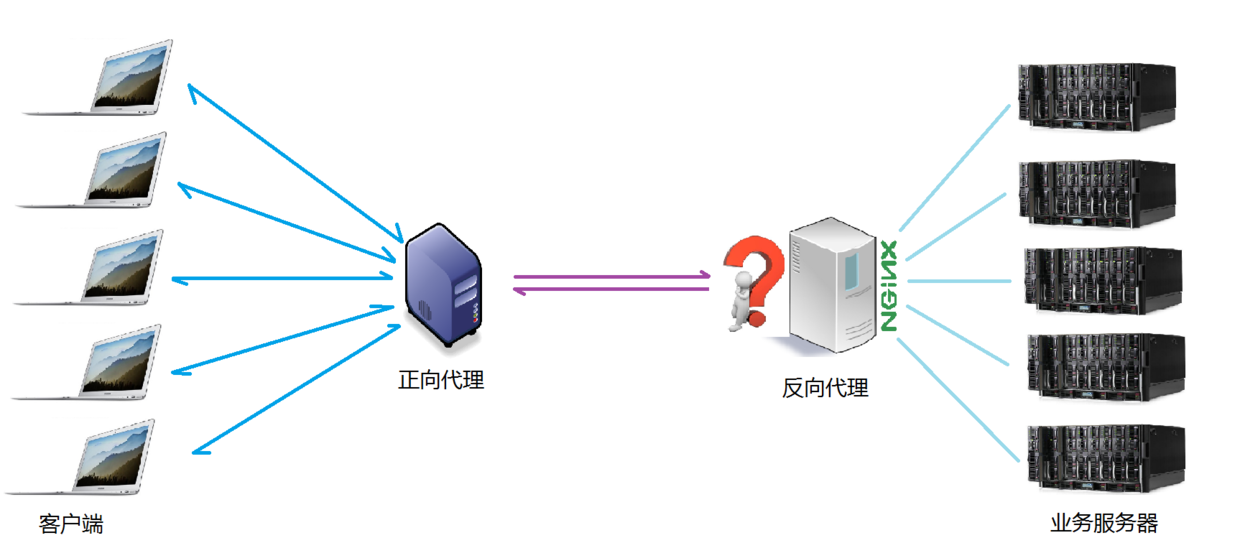

Normalement, lorsque nous exploitons le projet réel, le proxy direct et le proxy inverse sont susceptibles d'exister dans un scénario d'application. La demande du client proxy forward pour accéder au serveur cible, cible Le serveur est un single inverse. -serveur d'intérêt, qui proxy inverse plusieurs serveurs de traitement d'entreprise réels. Le diagramme de topologie spécifique est le suivant :

2. Équilibrage de charge

Nous avons clarifié le concept de ce qu'on appelle le serveur proxy, donc ensuite, nginx joue le rôle d'un serveur proxy inverse, et quelles sont ses règles. basé sur Qu'en est-il des demandes de distribution ? Les règles de distribution peuvent-elles être contrôlées pour différents scénarios d'application de projet ?

Le nombre de requêtes envoyées par le client et reçues par le serveur proxy inverse nginx mentionné ici est ce que nous appelons charge

Le nombre de requêtes est distribué aux différents serveurs pour être traitées selon certaines règles, qui sont une sorte d'équilibre.

Donc~ le processus de distribution des requêtes reçues par le serveur selon des règles est appelé équilibrage de charge.

Dans le processus de fonctionnement réel du projet, il existe deux types d'équilibrage de charge : l'équilibrage de charge matérielle et l'équilibrage de charge logicielle est également appelé charge dure, comme l'équilibrage de charge f5, qui est relativement coûteux et coûteux, mais la stabilité et la stabilité. sécurité des données, etc. Des entreprises telles que China Mobile et China Unicom choisiront des opérations de charge lourde uniquement lorsqu'elles disposent de très bonnes garanties ; de plus en plus d'entreprises choisiront d'utiliser l'équilibrage de charge logiciel pour des raisons de coût. L'équilibrage de charge logiciel utilise la technologie existante combinée aux ordinateurs hôtes. . Un mécanisme de distribution de file d'attente de messages implémenté dans le matériel

nginx prend en charge l'algorithme de planification d'équilibrage de charge comme suit :

interrogation de poids (par défaut) : les requêtes reçues sont distribuées aux différents serveurs back-end une par une dans l'ordre, Même si un serveur principal tombe en panne pendant l'utilisation, nginx supprimera automatiquement le serveur de la file d'attente et l'acceptation de la demande ne sera en aucun cas affectée. De cette manière, une valeur de poids (poids) peut être définie pour différents serveurs back-end afin d'ajuster le taux d'allocation des requêtes sur différents serveurs ; plus les données de poids sont grandes, plus la probabilité d'être attribuée à la valeur de poids est grande ; , Il est principalement ajusté pour différentes configurations matérielles de serveur back-end dans des environnements de travail réels.

ip_hash : chaque requête est mise en correspondance en fonction du résultat de hachage de l'adresse IP du client initiateur. Sous cet algorithme, un client avec une adresse IP fixe accédera toujours au même serveur back-end, ce qui résout également le problème de l'environnement de déploiement de cluster. dans une certaine mesure. Problèmes avec le partage de session.

équitable : ajustement intelligent de l'algorithme de planification, allocation dynamique et équilibrée basée sur le temps écoulé entre le traitement de la demande et la réponse du serveur back-end. Les serveurs avec un temps de réponse court et une efficacité de traitement élevée ont une forte probabilité d'être alloués à la demande. , et les serveurs avec un temps de réponse long et une faible efficacité de traitement sont alloués. Moins de requêtes sont reçues un algorithme de planification qui combine les avantages des deux premiers ; Cependant, il convient de noter que nginx ne prend pas en charge l'algorithme fair par défaut. Si vous souhaitez utiliser cet algorithme de planification, veuillez installer le module amont_fair

url_hash : alloue les requêtes en fonction du résultat de hachage de l'url accédée, et de l'url consultée. de chaque requête pointera vers un emplacement fixe sur le backend. Un serveur peut améliorer l'efficacité de la mise en cache lorsque nginx est utilisé comme serveur statique. Il convient également de noter que nginx ne prend pas en charge cet algorithme de planification par défaut. Si vous souhaitez l'utiliser, vous devez installer le package logiciel de hachage nginx

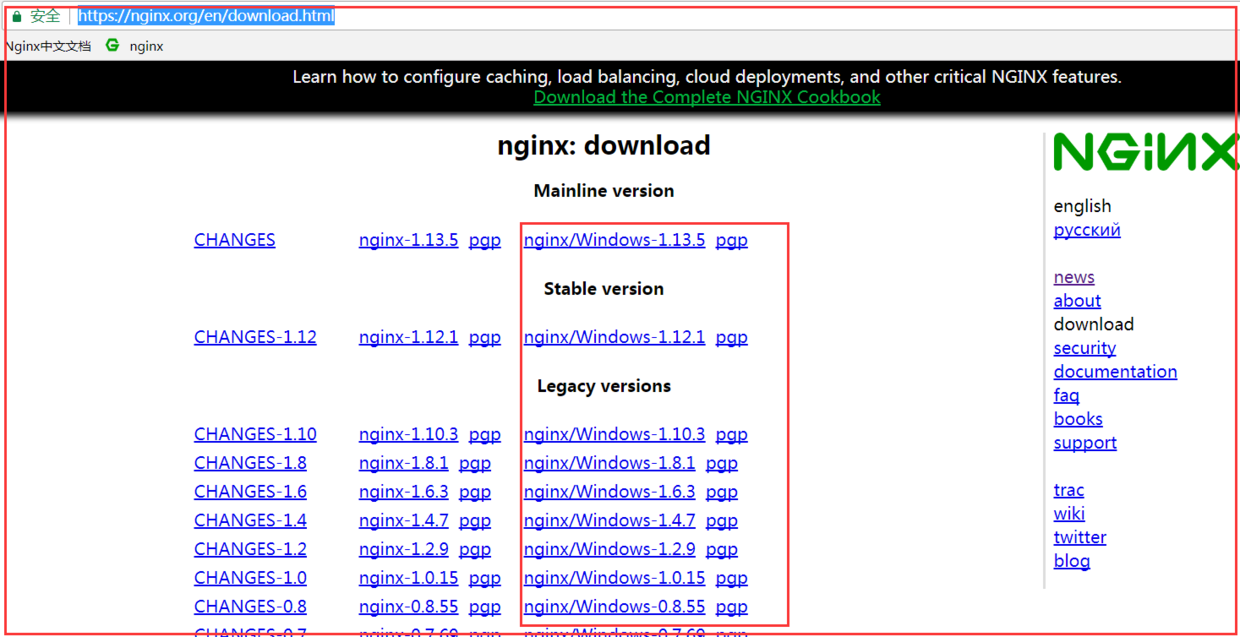

Installation de nginx 1. Installation de Windows

Adresse de téléchargement officielle du site Web :

https://nginx.org/en/download.html

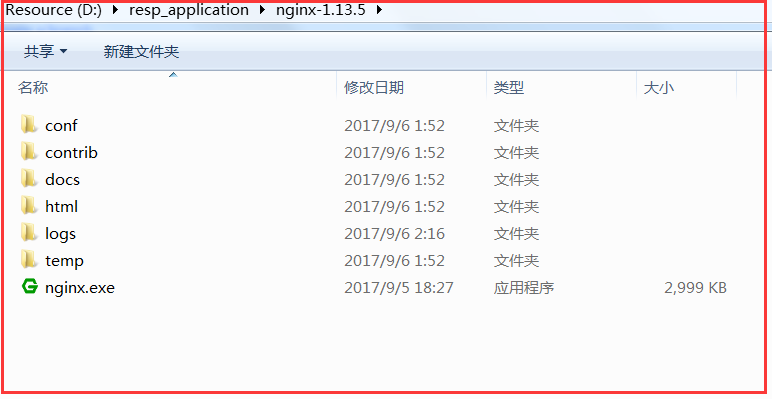

Comme le montre la figure ci-dessous, téléchargez la version correspondante. Décompressez simplement le package compressé nginx dans le dossier où le logiciel est stocké sur votre ordinateur. Une fois la décompression terminée, la structure des répertoires de fichiers est la suivante :

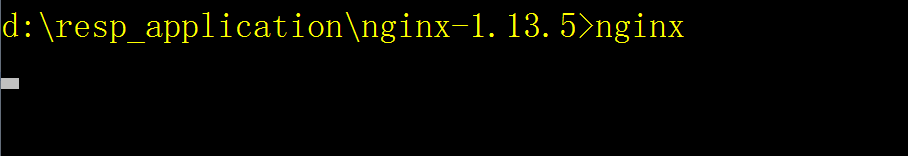

Démarrez nginx

.1) Double-cliquez directement sur nginx dans ce répertoire.exe, vous pouvez démarrer le serveur nginx

d:/resp_application/nginx-1.13.5> nginx

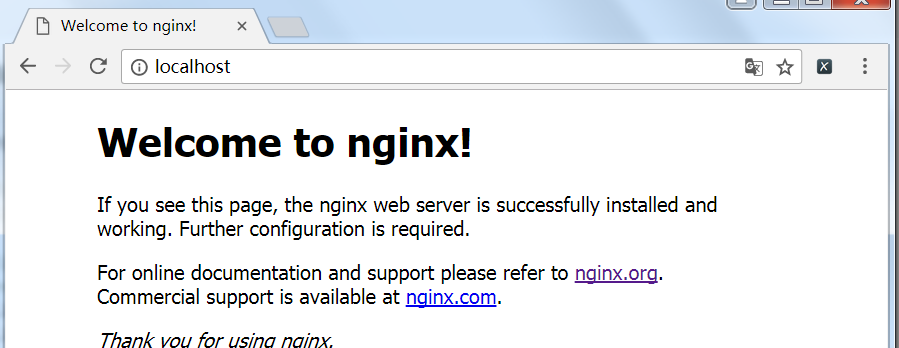

. Visitez nginx

Ouvrez le navigateur et saisissez l'adresse : http:// localhost, accédez à la page, la page suivante apparaît pour indiquer un accès réussi

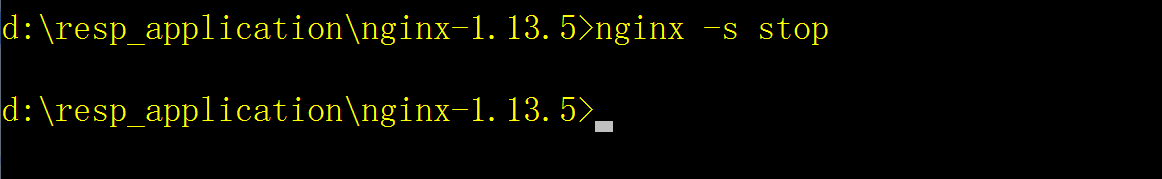

Arrêtez nginx

Ligne de commande pour entrer dans le répertoire racine de nginx, exécutez le commande suivante pour arrêter le serveur :

# 强制停止nginx服务器,如果有未处理的数据,丢弃 d:/resp_application/nginx-1.13.5> nginx -s stop # 优雅的停止nginx服务器,如果有未处理的数据,等待处理完成之后停止 d:/resp_application/nginx-1.13.5> nginx -s quit

2. Installation d'Ubuntu

Suivez la méthode d'installation normale du logiciel : Installez directement via la commande suivante :

$ sudo apt-get install nginx

L'installation est terminée. Le répertoire est le répertoire où se trouve la commande nginx et le répertoire /etc/nginx/ est le répertoire où se trouvent tous les fichiers de configuration nginx. Utilisé pour configurer le serveur nginx et les informations d'équilibrage de charge

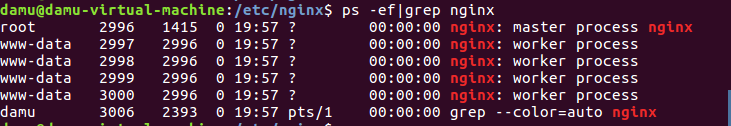

Vérifiez si le processus nginx est démarré

$ ps -ef|grep nginx

Remarque : les processus de service démarrés ici sont en réalité 4 processus, car lorsque le processus nginx est démarré, il sera accompagné d'un processus démon pour empêcher le processus officiel de se terminer anormalement ; si le processus démon revient, l'héritage nginx est terminé et le processus sera automatiquement redémarré.

Le processus démon est généralement appelé processus maître et le processus métier est appelé processus de travail

$ nginx

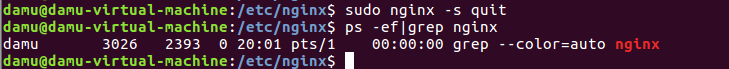

Stop

Commande de service nginx

和windows系统执行过程一样,两种停止方式

$ nginx -s stop or $ nginx -s quit

重新启动加载

同样也可以使用命令reopen和reload来重新启动nginx或者重新加载配合着文件。

3. mac os安装

直接通过brew进行nginx的安装,或者下载tar.gz压缩包都是可以的。

直接通过brew进行安装

brew install nginx

安装完成后,后续的命令操作,服务器的启动、进程查看、服务器的停止、服务器的重启已经文件加载命令都是一致的。

nginx配置

nginx是一个功能非常强大的web服务器加反向代理服务器,同时又是邮件服务器等等

在项目使用中,使用最多的三个核心功能是反向代理、负载均衡和静态服务器

这三个不同的功能的使用,都跟nginx的配置密切相关,nginx服务器的配置信息主要集中在nginx.conf这个配置文件中,并且所有的可配置选项大致分为以下几个部分

main # 全局配置

events { # nginx工作模式配置

}

http { # http设置

....

server { # 服务器主机配置

....

location { # 路由配置

....

}

location path {

....

}

location otherpath {

....

}

}

server {

....

location {

....

}

}

upstream name { # 负载均衡配置

....

}

}如上述配置文件所示,主要由6个部分组成:

main:用于进行nginx全局信息的配置 events:用于nginx工作模式的配置 http:用于进行http协议信息的一些配置 server:用于进行服务器访问信息的配置 location:用于进行访问路由的配置 upstream:用于进行负载均衡的配置 main模块

观察下面的配置代码

# user nobody nobody; worker_processes 2; # error_log logs/error.log # error_log logs/error.log notice # error_log logs/error.log info # pid logs/nginx.pid worker_rlimit_nofile 1024;

上述配置都是存放在main全局配置模块中的配置项

user用来指定nginx worker进程运行用户以及用户组,默认nobody账号运行 worker_processes指定nginx要开启的子进程数量,运行过程中监控每个进程消耗内存(一般几m~几十m不等)根据实际情况进行调整,通常数量是cpu内核数量的整数倍 error_log定义错误日志文件的位置及输出级别【debug / info / notice / warn / error / crit】 pid用来指定进程id的存储文件的位置 worker_rlimit_nofile用于指定一个进程可以打开最多文件数量的描述 event 模块

上干货

event {

worker_connections 1024;

multi_accept on;

use epoll;

}上述配置是针对nginx服务器的工作模式的一些操作配置

worker_connections 指定最大可以同时接收的连接数量,这里一定要注意,最大连接数量是和worker processes共同决定的。 multi_accept 配置指定nginx在收到一个新连接通知后尽可能多的接受更多的连接 use epoll 配置指定了线程轮询的方法,如果是linux2.6+,使用epoll,如果是bsd如mac请使用kqueue http模块

作为web服务器,http模块是nginx最核心的一个模块,配置项也是比较多的,项目中会设置到很多的实际业务场景,需要根据硬件信息进行适当的配置,常规情况下,使用默认配置即可!

http {

##

# 基础配置

##

sendfile on;

tcp_nopush on;

tcp_nodelay on;

keepalive_timeout 65;

types_hash_max_size 2048;

# server_tokens off;

# server_names_hash_bucket_size 64;

# server_name_in_redirect off;

include /etc/nginx/mime.types;

default_type application/octet-stream;

##

# ssl证书配置

##

ssl_protocols tlsv1 tlsv1.1 tlsv1.2; # dropping sslv3, ref: poodle

ssl_prefer_server_ciphers on;

##

# 日志配置

##

access_log /var/log/nginx/access.log;

error_log /var/log/nginx/error.log;

##

# gzip 压缩配置

##

gzip on;

gzip_disable "msie6";

# gzip_vary on;

# gzip_proxied any;

# gzip_comp_level 6;

# gzip_buffers 16 8k;

# gzip_http_version 1.1;

# gzip_types text/plain text/css application/json application/javascript

text/xml application/xml application/xml+rss text/javascript;

##

# 虚拟主机配置

##

include /etc/nginx/conf.d/*.conf;

include /etc/nginx/sites-enabled/*;1) 基础配置

sendfile on:配置on让sendfile发挥作用,将文件的回写过程交给数据缓冲去去完成,而不是放在应用中完成,这样的话在性能提升有有好处 tc_nopush on:让nginx在一个数据包中发送所有的头文件,而不是一个一个单独发 tcp_nodelay on:让nginx不要缓存数据,而是一段一段发送,如果数据的传输有实时性的要求的话可以配置它,发送完一小段数据就立刻能得到返回值,但是不要滥用哦 keepalive_timeout 10:给客户端分配连接超时时间,服务器会在这个时间过后关闭连接。一般设置时间较短,可以让nginx工作持续性更好 client_header_timeout 10:设置请求头的超时时间 client_body_timeout 10:设置请求体的超时时间 send_timeout 10:指定客户端响应超时时间,如果客户端两次操作间隔超过这个时间,服务器就会关闭这个链接 limit_conn_zone $binary_remote_addr zone=addr:5m :设置用于保存各种key的共享内存的参数, limit_conn addr 100: 给定的key设置最大连接数 server_tokens:虽然不会让nginx执行速度更快,但是可以在错误页面关闭nginx版本提示,对于网站安全性的提升有好处哦 include /etc/nginx/mime.types:指定在当前文件中包含另一个文件的指令 default_type application/octet-stream:指定默认处理的文件类型可以是二进制 type_hash_max_size 2048:混淆数据,影响三列冲突率,值越大消耗内存越多,散列key冲突率会降低,检索速度更快;值越小key,占用内存较少,冲突率越高,检索速度变慢

2) 日志配置

access_log logs/access.log:设置存储访问记录的日志 error_log logs/error.log:设置存储记录错误发生的日志

3) ssl证书加密

ssl_protocols:指令用于启动特定的加密协议,nginx在1.1.13和1.0.12版本后默认是ssl_protocols sslv3 tlsv1 tlsv1.1 tlsv1.2,tlsv1.1与tlsv1.2要确保openssl >= 1.0.1 ,sslv3 现在还有很多地方在用但有不少被攻击的漏洞。 ssl prefer server ciphers:设置协商加密算法时,优先使用我们服务端的加密套件,而不是客户端浏览器的加密套件

4) 压缩配置

gzip 是告诉nginx采用gzip压缩的形式发送数据。这将会减少我们发送的数据量。 gzip_disable 为指定的客户端禁用gzip功能。我们设置成ie6或者更低版本以使我们的方案能够广泛兼容。 gzip_static 告诉nginx在压缩资源之前,先查找是否有预先gzip处理过的资源。这要求你预先压缩你的文件(在这个例子中被注释掉了),从而允许你使用最高压缩比,这样nginx就不用再压缩这些文件了(想要更详尽的gzip_static的信息,请点击这里)。 gzip_proxied 允许或者禁止压缩基于请求和响应的响应流。我们设置为any,意味着将会压缩所有的请求。 gzip_min_length 设置对数据启用压缩的最少字节数。如果一个请求小于1000字节,我们最好不要压缩它,因为压缩这些小的数据会降低处理此请求的所有进程的速度。 gzip_comp_level 设置数据的压缩等级。这个等级可以是1-9之间的任意数值,9是最慢但是压缩比最大的。我们设置为4,这是一个比较折中的设置。 gzip_type 设置需要压缩的数据格式。上面例子中已经有一些了,你也可以再添加更多的格式。

5) 文件缓存配置

open_file_cache 打开缓存的同时也指定了缓存最大数目,以及缓存的时间。我们可以设置一个相对高的最大时间,这样我们可以在它们不活动超过20秒后清除掉。 open_file_cache_valid 在open_file_cache中指定检测正确信息的间隔时间。 open_file_cache_min_uses 定义了open_file_cache中指令参数不活动时间期间里最小的文件数。 open_file_cache_errors 指定了当搜索一个文件时是否缓存错误信息,也包括再次给配置中添加文件。我们也包括了服务器模块,这些是在不同文件中定义的。如果你的服务器模块不在这些位置,你就得修改这一行来指定正确的位置。

server模块

srever模块配置是http模块中的一个子模块,用来定义一个虚拟访问主机,也就是一个虚拟服务器的配置信息

server {

listen 80;

server_name localhost 192.168.1.100;

root /nginx/www;

index index.php index.html index.html;

charset utf-8;

access_log logs/access.log;

error_log logs/error.log;

......

}核心配置信息如下:

server:一个虚拟主机的配置,一个http中可以配置多个server

server_name:用力啊指定ip地址或者域名,多个配置之间用空格分隔

root:表示整个server虚拟主机内的根目录,所有当前主机中web项目的根目录

index:用户访问web网站时的全局首页

charset:用于设置www/路径中配置的网页的默认编码格式

access_log:用于指定该虚拟主机服务器中的访问记录日志存放路径

error_log:用于指定该虚拟主机服务器中访问错误日志的存放路径

location模块

location模块是nginx配置中出现最多的一个配置,主要用于配置路由访问信息

在路由访问信息配置中关联到反向代理、负载均衡等等各项功能,所以location模块也是一个非常重要的配置模块

基本配置

location / {

root /nginx/www;

index index.php index.html index.htm;

}location /:表示匹配访问根目录

root:用于指定访问根目录时,访问虚拟主机的web目录

index:在不指定访问具体资源时,默认展示的资源文件列表

反向代理配置方式

通过反向代理代理服务器访问模式,通过proxy_set配置让客户端访问透明化

location / {

proxy_pass http://localhost:8888;

proxy_set_header x-real-ip $remote_addr;

proxy_set_header host $http_host;

}uwsgi配置

wsgi模式下的服务器配置访问方式

location / {

include uwsgi_params;

uwsgi_pass localhost:8888

}upstream模块

upstream模块主要负责负载均衡的配置,通过默认的轮询调度方式来分发请求到后端服务器

简单的配置方式如下

upstream name {

ip_hash;

server 192.168.1.100:8000;

server 192.168.1.100:8001 down;

server 192.168.1.100:8002 max_fails=3;

server 192.168.1.100:8003 fail_timeout=20s;

server 192.168.1.100:8004 max_fails=3 fail_timeout=20s;

}核心配置信息如下

ip_hash:指定请求调度算法,默认是weight权重轮询调度,可以指定

server host:port:分发服务器的列表配置

--down : Indique que l'hôte a suspendu le service

-- max_fails : Indique le nombre maximum d'échecs dépasse le service, le service est suspendu

--fail_timeout : Indique que si le service est suspendu. la demande ne parvient pas à être acceptée, la demande sera réinitialisée après la pause du délai spécifié

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

redémarrage de nginx

redémarrage de nginx

Explication détaillée de la configuration de nginx

Explication détaillée de la configuration de nginx

Explication détaillée de la configuration de nginx

Explication détaillée de la configuration de nginx

Quelles sont les différences entre Tomcat et Nginx

Quelles sont les différences entre Tomcat et Nginx

Comment résoudre l'erreur 443

Comment résoudre l'erreur 443

Qu'est-ce qu'une procédure stockée MYSQL ?

Qu'est-ce qu'une procédure stockée MYSQL ?

js sous-chaîne

js sous-chaîne

Comment installer l'interpréteur pycharm

Comment installer l'interpréteur pycharm