Récemment, l'EMNLP 2022, la plus grande conférence dans le domaine du traitement du langage naturel, s'est tenue à Abu Dhabi, la capitale des Émirats arabes unis.

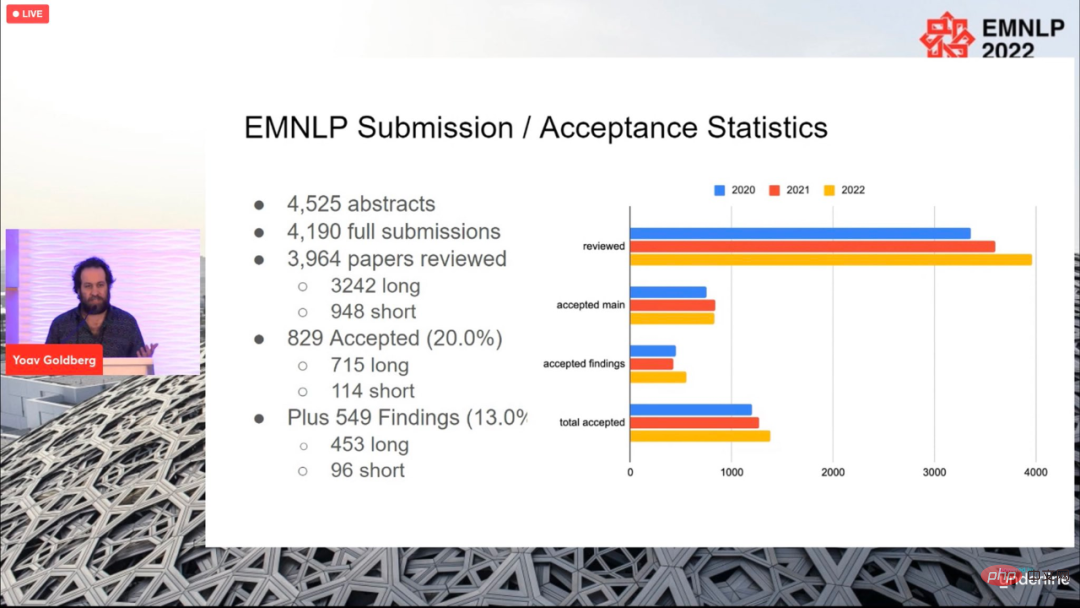

Au total, 4190 articles ont été soumis à la conférence de cette année, et 829 articles ont finalement été acceptés (715 articles longs, 114 articles), avec un taux d'acceptation global de 20 %, ce qui n'est pas très différent des précédents. années.

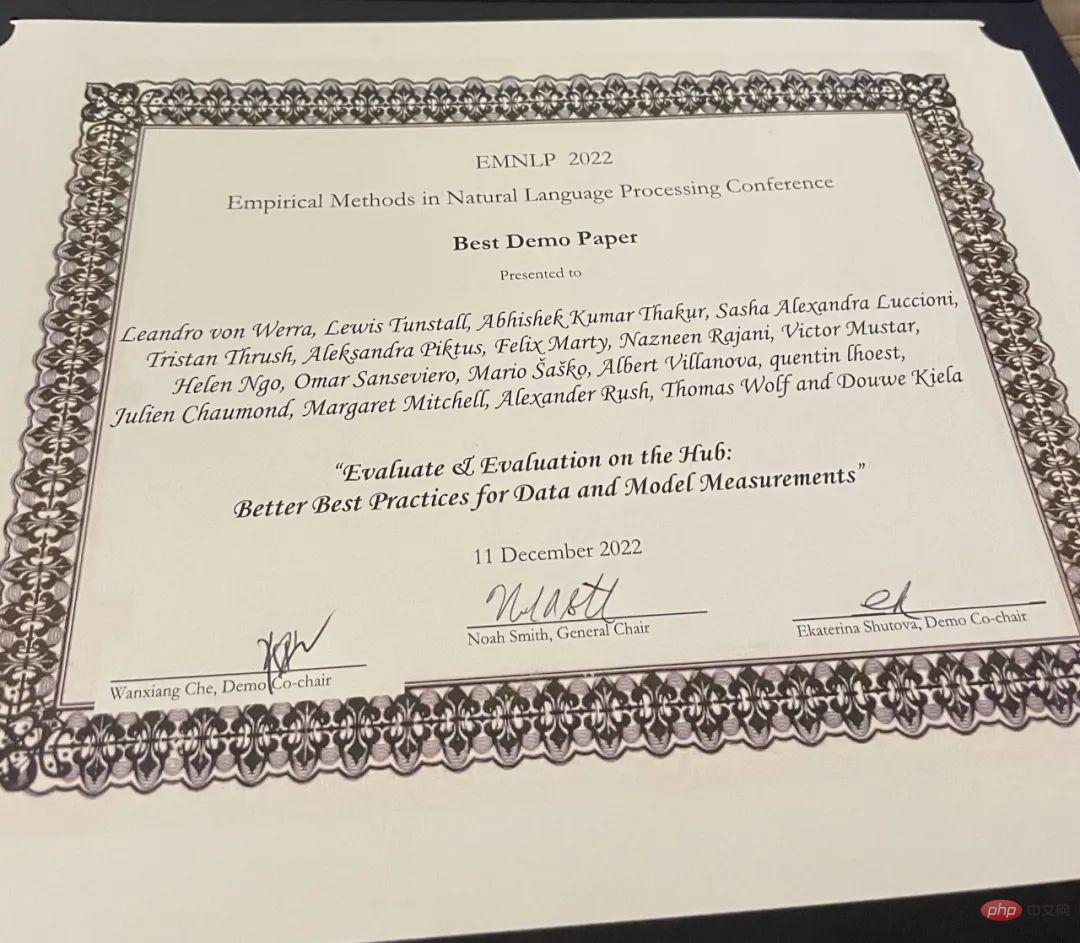

La conférence s'est terminée le 11 décembre, heure locale, et les prix des articles de cette année ont également été annoncés, notamment le meilleur article long (1 pièce), le meilleur article court (1 pièce) et le meilleur article de démonstration (1 article).

Article : Raisonnement visuel abstrait avec des formes de Tangram

Paper résumé : Dans cet article, les chercheurs présentent "KiloGram", une bibliothèque de ressources pour étudier le raisonnement visuel abstrait des humains et des machines. KiloGram améliore considérablement les ressources existantes de deux manières. Tout d’abord, les chercheurs ont conservé et numérisé 1 016 formes, créant ainsi une collection deux fois plus grande que celles utilisées dans les travaux existants. Cette collection augmente considérablement la couverture de toute la gamme des variations de dénomination, offrant une perspective plus complète sur le comportement humain en matière de dénomination. Deuxièmement, la collection traite chaque tangram non pas comme une forme globale unique, mais comme une forme vectorielle composée des pièces du puzzle original. Cette décomposition permet de raisonner sur des formes entières et leurs parties. Les chercheurs ont utilisé cette nouvelle collection de graphiques de puzzles numériques pour collecter une grande quantité de données de description textuelle, reflétant la grande diversité des comportements de dénomination.

Les chercheurs ont exploité le crowdsourcing pour étendre le processus d'annotation, en collectant plusieurs annotations pour chaque forme afin de représenter la distribution des annotations qu'elle a suscitées plutôt qu'un seul échantillon. Au total, 13 404 annotations ont été collectées, chacune décrivant un objet complet et ses parties divisées. Le potentiel de

KiloGram est vaste. Nous avons utilisé cette ressource pour évaluer les capacités de raisonnement visuel abstrait des modèles multimodaux récents et avons observé que les poids pré-entraînés présentaient des capacités de raisonnement abstrait limitées qui s'amélioraient considérablement avec un réglage fin. Ils ont également observé que les descriptions explicites facilitent le raisonnement abstrait à la fois par les humains et les modèles, en particulier lors du codage conjoint du langage et de l'entrée visuelle.

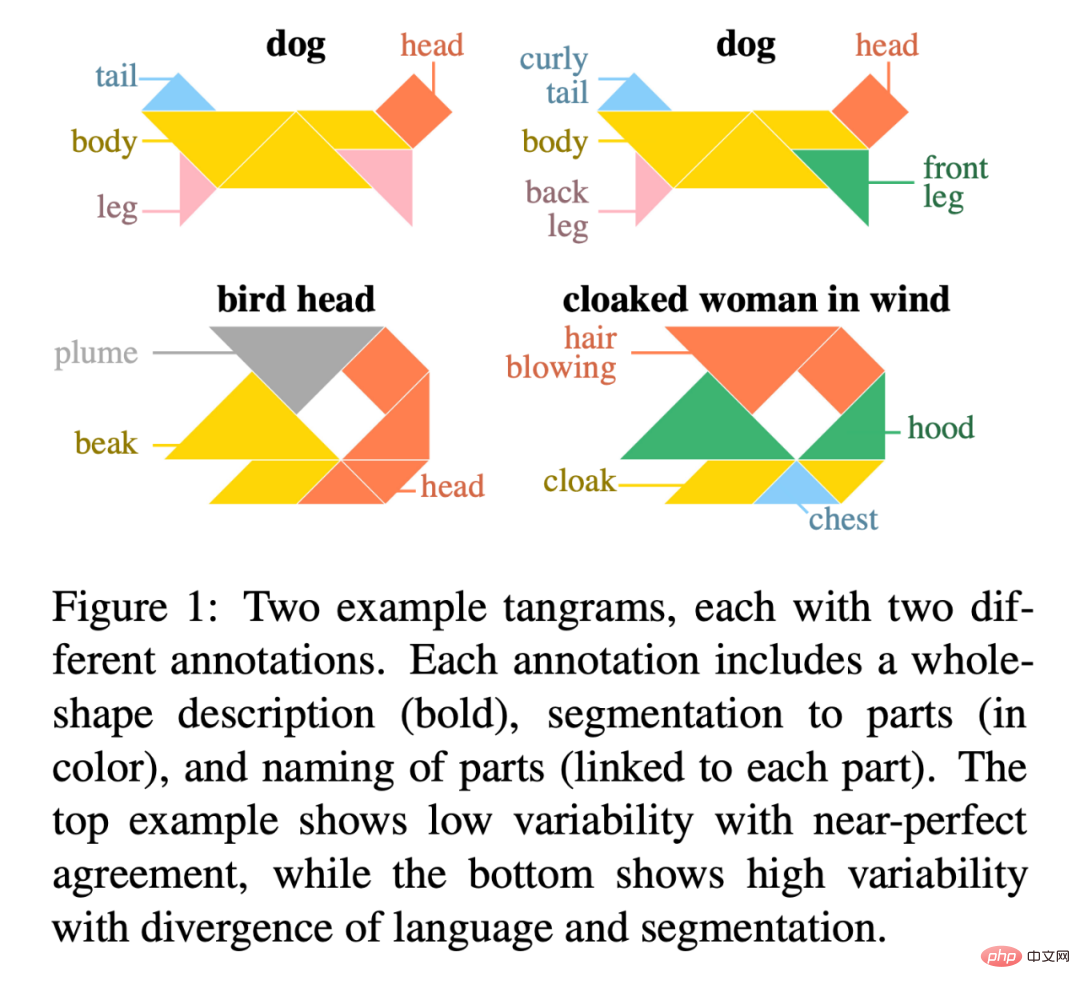

La figure 1 est un exemple de deux tangrams, chacun avec deux annotations différentes. Chaque annotation comprend une description de la forme entière (en gras), une segmentation des parties (en couleur) et un nom pour chaque partie (liée à chaque partie). L'exemple supérieur montre une faible variabilité pour un accord presque parfait, tandis que l'exemple inférieur montre une forte variabilité pour la divergence de langue et de segmentation.

Adresse KiloGram : https://lil.nlp.cornell.edu/kilogram

Les nominations pour les meilleurs articles longs pour cette conférence sont de Kayo Yin et Graham Neubig Obtenu par deux chercheurs.

Article : Interprétation des modèles linguistiques avec des explications contrastées

Résumé de l'article : La méthode d'interprétabilité du modèle est souvent utilisée pour expliquer la PNL Modélisez les décisions sur des tâches telles que la classification de texte, où l'espace de sortie est relativement petit. Cependant, lorsqu’elle est appliquée à la génération de langage, l’espace de sortie est souvent constitué de dizaines de milliers de jetons, et ces méthodes ne peuvent pas fournir d’explications informatives. Les modèles linguistiques doivent prendre en compte diverses caractéristiques pour prédire un jeton, telles que sa partie du discours, son nombre, son temps ou sa sémantique. Étant donné que les méthodes explicatives existantes combinent les preuves de toutes ces caractéristiques en une seule explication, cela est moins interprétable pour la compréhension humaine.

Pour distinguer les différentes décisions en matière de modélisation du langage, les chercheurs explorent des modèles de langage qui se concentrent sur des explications contrastées. Ils recherchent des jetons d'entrée qui se démarquent et expliquent pourquoi le modèle a prédit un jeton mais pas un autre. La recherche démontre que les explications contrastées sont bien meilleures que les explications non contrastées pour valider les phénomènes grammaticaux majeurs et qu'elles améliorent considérablement la simulatabilité du modèle contrastif pour les observateurs humains. Les chercheurs ont également identifié des groupes de décisions contrastées pour lesquels le modèle a utilisé des preuves similaires et ont pu décrire les jetons d'entrée utilisés par le modèle dans diverses décisions de génération de langage.

Adresse du code : https://github.com/kayoyin/interpret-lm

Article : Apprentissage de la représentation de la paternité par sujet régularisé

Résumé : Dans cette étude, les chercheurs ont proposé la représentation de la paternité régulière isation, un cadre de distillation qui améliore les performances multi-sujets et peut également gérer des auteurs invisibles. Cette approche peut être appliquée à n’importe quel modèle de représentation de la paternité. Les résultats expérimentaux montrent que dans un contexte multi-sujets, les performances 4/6 sont améliorées. Dans le même temps, l'analyse des chercheurs montre que dans les ensembles de données comportant un grand nombre de sujets, les fragments de formation répartis sur plusieurs sujets présentent des problèmes de fuite d'informations sur les sujets, affaiblissant ainsi leur capacité à évaluer les attributs inter-sujets. "Meilleur article de démonstration" Luccioni et al

Institution : Hugging Face

Lien papier : https://arxiv.org/pdf/2210.01970.pdf

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Combien de personnes pouvez-vous élever sur Douyin ?

Combien de personnes pouvez-vous élever sur Douyin ?

Trois frameworks majeurs pour le développement Android

Trois frameworks majeurs pour le développement Android

Windows ne peut pas ouvrir ajouter une imprimante

Windows ne peut pas ouvrir ajouter une imprimante

Solution à l'autorisation refusée

Solution à l'autorisation refusée

Quels sont les logiciels de sauvegarde de données ?

Quels sont les logiciels de sauvegarde de données ?

correctif SP2

correctif SP2

Windows ne trouve pas la solution au certificat

Windows ne trouve pas la solution au certificat

Site officiel d'OKEX

Site officiel d'OKEX