Dans le roman de science-fiction "Le problème à trois corps", les Trisolariens qui tentent d'occuper la terre se voient proposer un cadre tout à fait unique : partager des informations par le biais d'ondes cérébrales, avec une pensée transparente et de mauvaises intentions entre eux. Pour eux, penser et parler sont le même mot. Les êtres humains, de leur côté, ont profité de la nature opaque de leur pensée pour élaborer le « Plan face au mur », et ont finalement réussi à tromper les Trisolarans et à remporter une victoire par étapes.

La question est alors : la pensée humaine est-elle vraiment complètement opaque ? Avec l’émergence de certains moyens techniques, la réponse à cette question ne semble plus aussi absolue. De nombreux chercheurs tentent de décoder les mystères de la pensée humaine et de décoder certains signaux cérébraux en texte, images et autres informations.

Récemment, deux équipes de recherche ont réalisé des progrès importants dans le sens du décodage d'images en même temps, et les articles connexes ont été acceptés par le CVPR 2023.

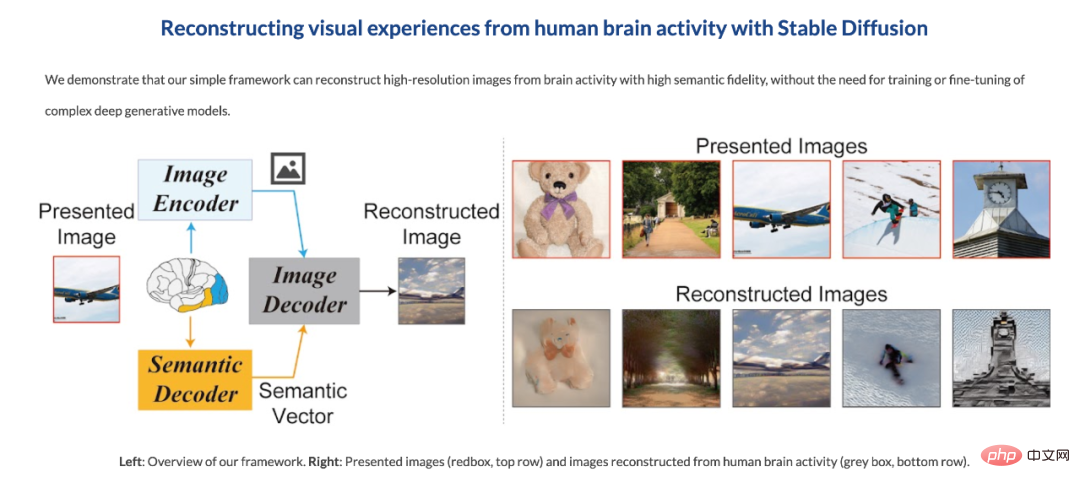

La première équipe vient de l'Université d'Osaka. Ils utilisent la diffusion stable, récemment très populaire, pour reconstruire des images de haute résolution et de haute précision de l'activité cérébrale à partir d'images d'activité cérébrale humaine obtenues par imagerie par résonance magnétique fonctionnelle (IRMf) ( Voir " Stable Diffusion lit les signaux de votre cerveau pour reproduire des images, et la recherche a été acceptée par le CVPR").

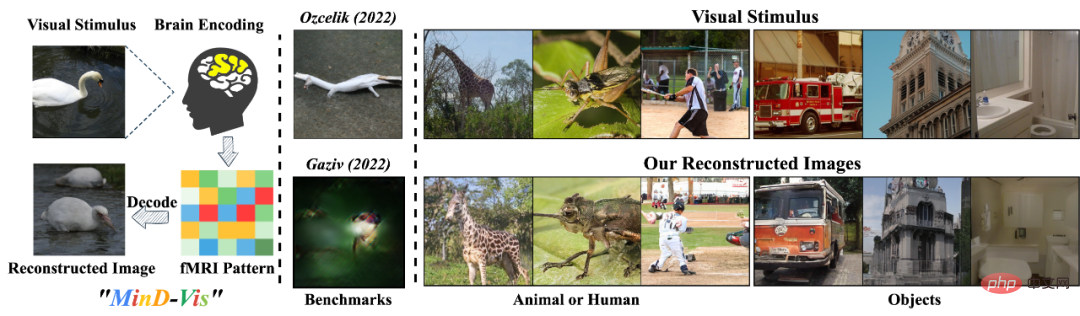

Par coïncidence, presque au même moment, les équipes chinoises de l'Université nationale de Singapour, de l'Université chinoise de Hong Kong et de l'Université de Stanford ont également obtenu des résultats similaires. Ils ont développé un décodeur visuel humain appelé « MinD-Vis », qui peut décoder directement les stimuli visuels humains à partir des données IRMf grâce à une modélisation de masque pré-entraînée et un modèle de diffusion latente. Il génère ces images qui sont non seulement raisonnablement détaillées, mais qui représentent également avec précision la sémantique et les caractéristiques de l'image (telles que la texture et la forme). Actuellement, le code de cette recherche est open source.

Titre de l'article : Voir au-delà du cerveau : modèle de diffusion conditionnelle avec modélisation masquée clairsemée pour le décodage de la vision

Ensuite, nous présenterons cet article en détail.

"Ce que vous voyez est ce que vous pensez."

La perception humaine et les connaissances antérieures sont étroitement liées dans le cerveau. Notre perception du monde n'est pas seulement affectée par des stimuli objectifs, mais aussi par notre expérience. Ces effets forment des activités cérébrales complexes. Comprendre ces activités cérébrales et décoder les informations est l’un des objectifs importants des neurosciences cognitives, où le décodage des informations visuelles constitue un problème difficile.

L'imagerie par résonance magnétique fonctionnelle (IRMf) est une méthode non invasive et efficace couramment utilisée qui peut être utilisée pour récupérer des informations visuelles telles que des catégories d'images.

MinD-Vis vise à explorer la possibilité d'utiliser des modèles d'apprentissage profond pour décoder les stimuli visuels directement à partir des données IRMf.

Les méthodes précédentes qui décodaient des activités neuronales complexes directement à partir des données IRMf souffrent d'un manque d'appariement {IRMf - image} et d'un guidage biologique efficace, de sorte que les images reconstruites sont souvent floues et dénuées de sens sémantiquement. C’est donc un défi important d’apprendre efficacement les représentations IRMf, qui aident à établir le lien entre l’activité cérébrale et les stimuli visuels.

De plus, la variabilité individuelle complique le problème, et nous devons apprendre les représentations à partir de grands ensembles de données et assouplir les contraintes liées à la génération d'une synthèse conditionnelle à partir de l'IRMf.

Par conséquent, L'auteur estime que l'utilisation de l'apprentissage auto-supervisé (apprentissage auto-supervisé avec tâche pré-texte) couplé à des modèles génératifs à grande échelle peut donner au modèle une connaissance contextuelle et des performances étonnantes après avoir été affiné sur un Ensemble de données relativement petit. Capacité générative .

Sur la base de l'analyse ci-dessus, MinD-Vis a proposé une modélisation du signal masqué et un modèle de diffusion latente bi-conditionnelle pour le décodage visuel humain. Les contributions spécifiques sont les suivantes :

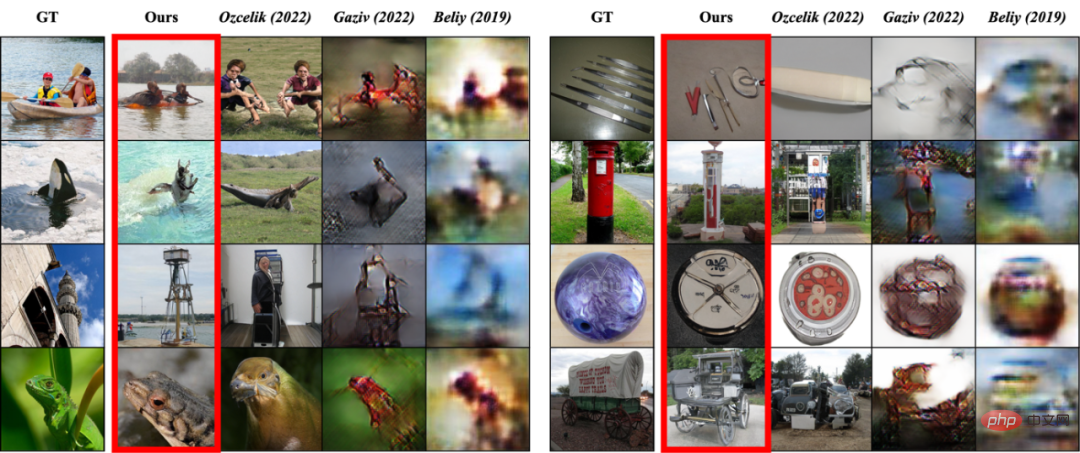

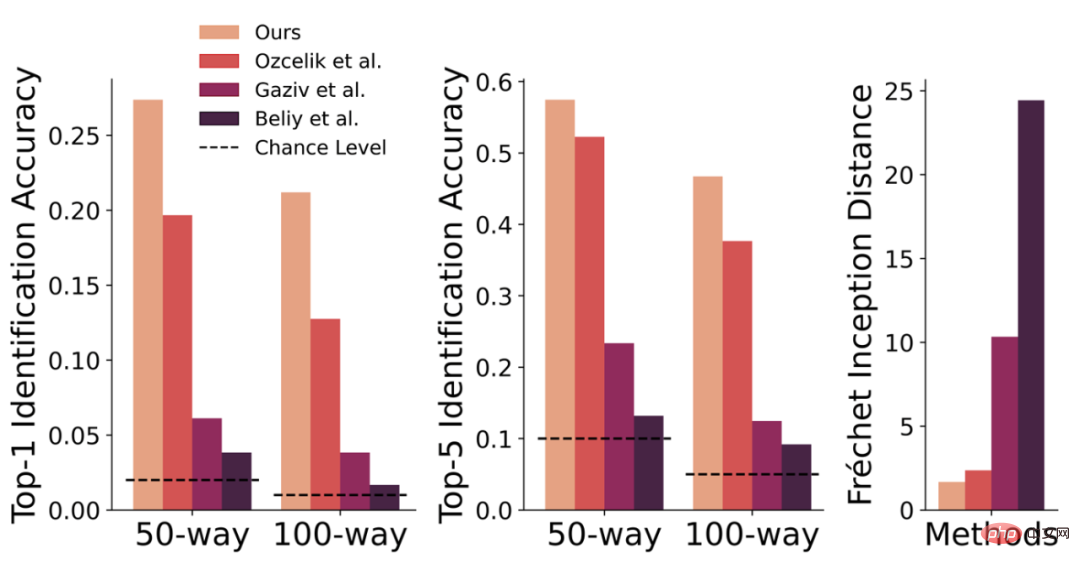

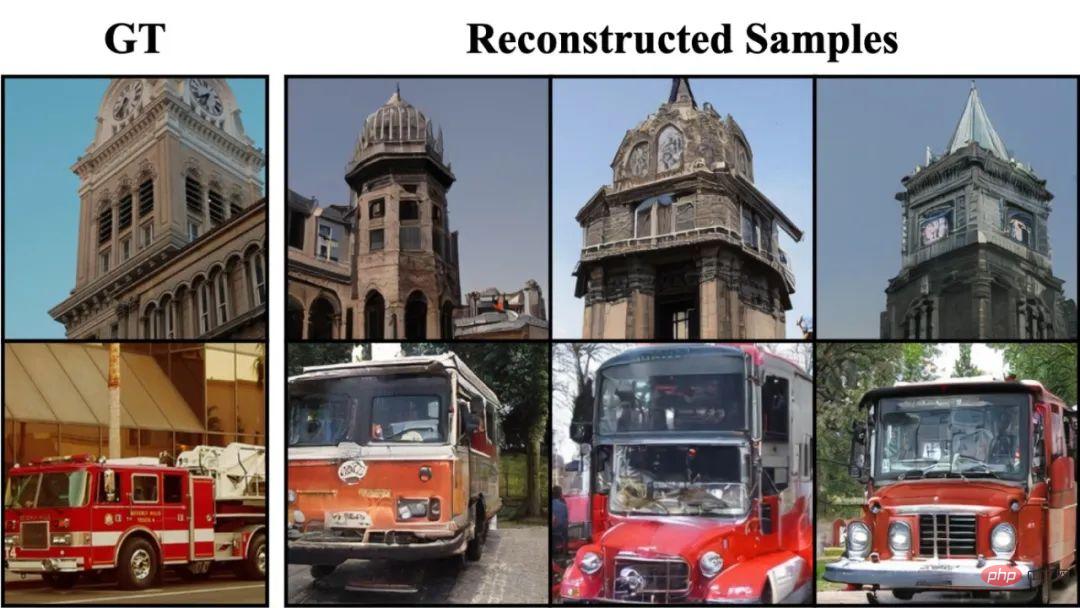

Comparaison avec les méthodes précédentes – Qualité de génération

Comparaison avec les méthodes précédentes – Comparaison quantitative des indicateurs d'évaluation

Étant donné que la collecte de paires {IRMf - image} est très coûteuse et prend beaucoup de temps, cette tâche a toujours souffert d'un manque d'annotation des données. De plus, chaque ensemble de données et les données de chaque individu auront un certain décalage de domaine.

Dans cette tâche, les chercheurs visent à établir un lien entre l'activité cérébrale et la stimulation visuelle, et ainsi à générer des informations d'image correspondantes.

Pour ce faire, ils ont utilisé un apprentissage auto-supervisé et des modèles génératifs à grande échelle. Ils pensent que cette approche permet d’affiner les modèles sur des ensembles de données relativement petits et d’acquérir des connaissances contextuelles et des capacités génératives étonnantes.

Ce qui suit présentera le cadre MinD-Vis en détail et présentera les raisons et les idées de la conception.

Les données IRMf présentent ces caractéristiques et problèmes :

Pour résoudre ces problèmes, MinD-Vis contient deux étapes :

Ces deux étapes seront présentées en détail ici.

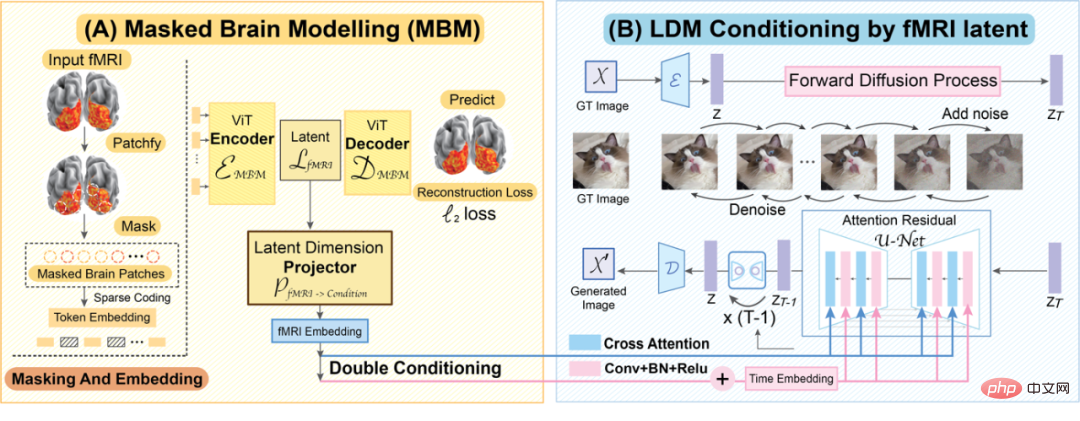

Présentation de MinD-Vis

(A) Modélisation cérébrale masquée à code clairsemé (SC-MBM) (Aperçu de MinD-Vis à gauche)

Merci à l'IRMf space Les informations sont redondantes et les données IRMf peuvent toujours être récupérées même si elles sont largement obscurcies. Par conséquent, dans la première étape de MinD-Vis, la plupart des données IRMf sont masquées pour gagner du temps de calcul. Ici, l'auteur utilise une approche similaire à Masked Autoencoder :

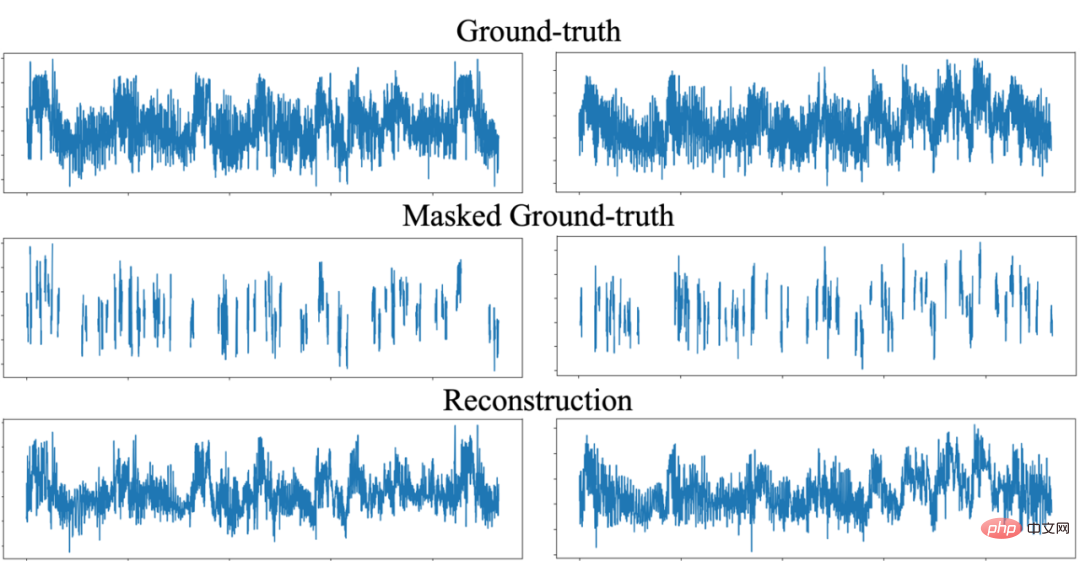

SC-MBM peut restaurer efficacement les informations IRMf masquées

Ceci Quelle est la différence entre le design et le masqueed Autoencoder ?

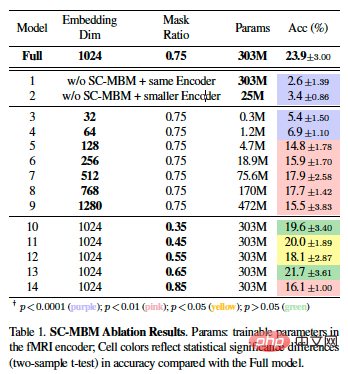

Expérience d'ablation de SC-MBM

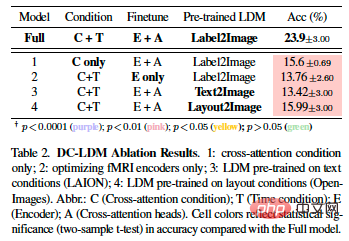

(B) LDM à double condition (DC-LDM) (aperçu MinD-Vis à droite)

Au stade A Après avoir effectué un apprentissage contextuel à grande échelle, l'encodeur IRMf peut convertir les données IRMf en une représentation clairsemée avec des contraintes de localité. Ici, les auteurs formulent la tâche de décodage comme un problème de génération conditionnelle et utilisent le LDM pré-entraîné pour résoudre ce problème.

Nous avons démontré la stabilité de notre méthode en décodant plusieurs fois des images dans différents états aléatoires.

Réglage fin

Une fois que l'encodeur IRMf est pré-entraîné par SC-MBM, il est intégré au LDM pré-entraîné par double conditionnement. Ici, par :

Détails supplémentaires

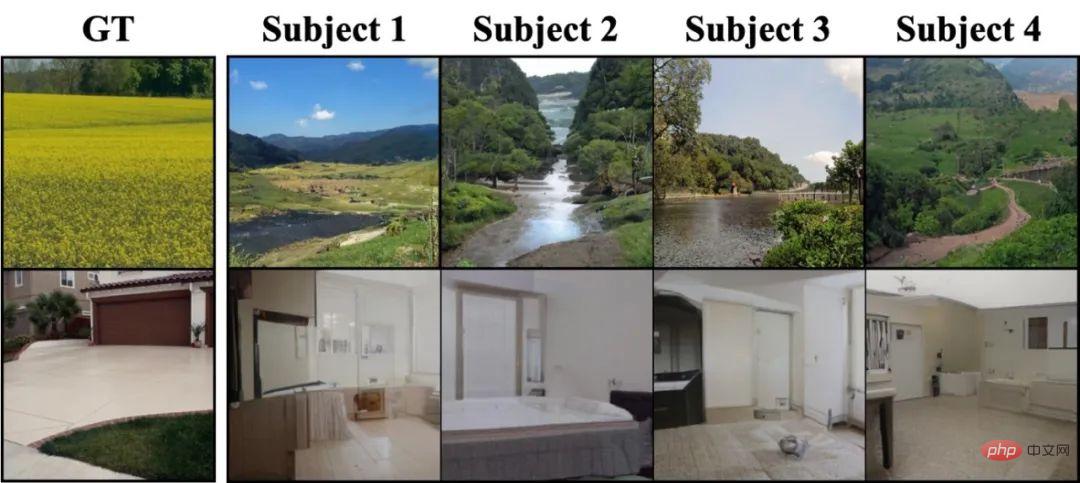

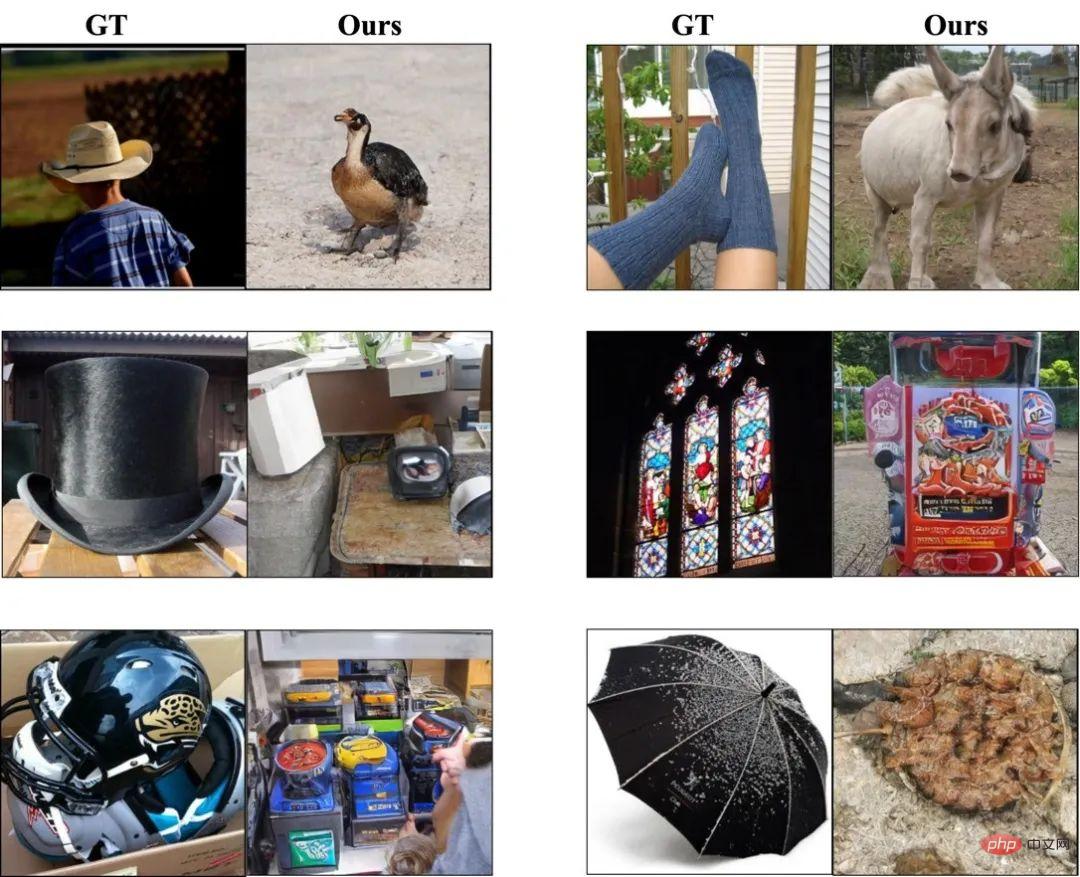

De façon inattendue, MinD-Vis peut décoder certaines choses qui n'existent pas réellement dans l'image de vérité terrain, mais des détails qui sont très pertinents par rapport au contenu de l’image. Par exemple, lorsque l'image est un paysage naturel, MinD-Vis décode une rivière et un ciel bleu ; lorsqu'il s'agit d'une maison, MinD-Vis décode une décoration intérieure similaire. Cela présente à la fois des avantages et des inconvénients. Le bon côté est que cela montre que nous pouvons décoder ce que nous avions imaginé ; le mauvais côté est que cela peut affecter l’évaluation des résultats du décodage. L'auteur estime que lorsque le nombre d'échantillons d'apprentissage est petit, la difficulté de décoder le stimulus sera différente. Par exemple, l'ensemble de données GOD contient plus d'échantillons de dressage d'animaux que de vêtements. Cela signifie qu'un mot sémantiquement similaire à « poilu » est plus susceptible d'être décodé comme un animal plutôt que comme un vêtement, comme le montre l'image ci-dessus, où une chaussette est décodée comme un mouton.Configuration expérimentale

Ensembles de données

Ici, l'auteur a utilisé trois ensembles de données publics.

La première étape de pré-formation : utilisation du projet Human Connectome, qui fournit 136 000 segments de données IRMf, pas d'images, uniquement IRMf.

Affinement de l'encodeur et du modèle de génération de deuxième étape : des ensembles de données génériques de décodage d'objets (GOD) et des ensembles de données Brain, Object, Landscape (BOLD5000) ont été utilisés. Ces deux ensembles de données fournissent respectivement 1 250 et 5 254 paires {IRMf, Image}, dont 50 et 113 ont été prises respectivement comme ensembles de test.

Structure du modèleLa conception de la structure du modèle (ViT et modèle de diffusion) dans cet article fait principalement référence à la littérature passée. Veuillez vous référer au texte pour plus de détails sur les paramètres du modèle. De même, ils adoptent également une architecture asymétrique : l’encodeur vise à apprendre des représentations IRMf significatives, tandis que le décodeur tente de prédire les correctifs obscurcis. Par conséquent, nous suivons la conception précédente et réduisons la taille du décodeur, que nous rejetons après la pré-formation.

Indice d'évaluation

Les expériences présentées dans cet article ont été menées au niveau individuel, c'est-à-dire que le modèle a été formé et testé sur le même individu. À des fins de comparaison avec la littérature précédente, les résultats pour le troisième sujet de l'ensemble de données GOD sont rapportés ici et les résultats pour les autres sujets sont répertoriés en annexe.

À travers ce projet, l'auteur a démontré la faisabilité de restaurer les informations visuelles du cerveau humain grâce à l'IRMf. Cependant, de nombreuses questions doivent être abordées dans ce domaine, telles que la manière de mieux gérer les différences entre les individus, la manière de réduire l'impact du bruit et des interférences sur le décodage et la manière de combiner le décodage IRMf avec d'autres techniques de neurosciences pour parvenir à un résultat optimal. compréhension plus complète des mécanismes et des fonctions du cerveau humain. Dans le même temps, nous devons également mieux comprendre et respecter les questions éthiques et juridiques entourant le cerveau humain et la vie privée des individus.

De plus, nous devons également explorer des scénarios d'application plus larges, tels que la médecine et l'interaction homme-machine, afin de transformer cette technologie en applications pratiques. Dans le domaine médical, la technologie de décodage IRMf pourrait être utilisée à l’avenir pour aider des groupes spéciaux tels que les personnes malvoyantes, les malentendants et même les patients souffrant de paralysie générale à décoder leurs pensées. En raison d’un handicap physique, ces personnes sont incapables d’exprimer leurs pensées et leurs souhaits via les méthodes de communication traditionnelles. En utilisant la technologie IRMf, les scientifiques peuvent décoder leur activité cérébrale pour accéder à leurs pensées et à leurs souhaits, leur permettant ainsi de communiquer avec eux de manière plus naturelle et plus efficace. Dans le domaine de l'interaction homme-machine, la technologie de décodage IRMf peut être utilisée pour développer des interfaces homme-machine et des systèmes de contrôle plus intelligents et adaptatifs, tels que le décodage de l'activité cérébrale de l'utilisateur pour obtenir une expérience d'interaction homme-machine plus naturelle et plus efficace.

Nous pensons qu'avec le soutien d'ensembles de données à grande échelle + de grands modèles + de puissance de calcul, le décodage IRMf aura un impact plus large et de grande envergure, favorisant le développement des neurosciences cognitives et de l'intelligence artificielle.

Remarque : *La base biologique de l'apprentissage des représentations de stimuli visuels dans le cerveau à l'aide d'un codage clairsemé : un codage clairsemé a été proposé comme stratégie pour la représentation des informations sensorielles. La recherche montre que les stimuli visuels sont peu codés dans le cortex visuel, ce qui augmente l’efficacité de la transmission de l’information et réduit la redondance dans le cerveau. Grâce à l'IRMf, le contenu visuel de scènes naturelles peut être reconstruit à partir de petites quantités de données collectées dans le cortex visuel. Le codage clairsemé peut être un moyen efficace de coder en vision par ordinateur. L'article mentionne la méthode SC-MBM, qui divise les données IRMf en petits blocs pour introduire des contraintes de localité, puis code de manière clairsemée chaque petit bloc dans un espace vectoriel de grande dimension, qui peut être utilisé comme un apprenant biologiquement efficace et efficient des caractéristiques cérébrales. , utilisé pour l'encodage et le décodage visuel.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Quelle est la différence entre les vues et les tables de base de données

Quelle est la différence entre les vues et les tables de base de données

La différence entre les ports d'accès et les ports réseau

La différence entre les ports d'accès et les ports réseau

Comment fonctionne un interrupteur ?

Comment fonctionne un interrupteur ?

Qu'est-ce qu'Avalanche

Qu'est-ce qu'Avalanche

Collection de codes d'images HTML

Collection de codes d'images HTML

utilisation de la fonction ubound

utilisation de la fonction ubound

Quels sont les composants d'un système Linux ?

Quels sont les composants d'un système Linux ?

Quel est le meilleur moyen d'apprendre en premier, le langage C ou le C++ ?

Quel est le meilleur moyen d'apprendre en premier, le langage C ou le C++ ?