Périphériques technologiques

Périphériques technologiques

IA

IA

Le boom de l'intelligence artificielle a provoqué une pénurie de puissance de calcul et Microsoft lance un nouveau plan de location de serveurs

Le boom de l'intelligence artificielle a provoqué une pénurie de puissance de calcul et Microsoft lance un nouveau plan de location de serveurs

Le boom de l'intelligence artificielle a provoqué une pénurie de puissance de calcul et Microsoft lance un nouveau plan de location de serveurs

La popularité continue de ChatGPT a conduit à une pénurie de puces : il n'y a pas assez de puissance de calcul pour répondre aux besoins informatiques de ChatGPT, ce qui a surchargé les serveurs d'OpenAI. La dernière pénurie de puces à grande échelle a été provoquée par une exploitation folle de monnaies virtuelles. Cependant, à mesure que la demande en matière d’intelligence artificielle générative continue d’augmenter, la pénurie de puissance de calcul pourrait cette fois perdurer pendant un certain temps.

Microsoft espère combler cette lacune avec un nouveau produit de machine virtuelle appelé ND H100 v5, qui comprend un grand nombre des derniers GPU H100 de Nvidia, nommés Hopper, pour les applications d'intelligence artificielle générative.

L'idée est de fournir des vitesses de calcul plus élevées aux entreprises travaillant sur l'IA générative, qui peuvent approfondir les données, établir des relations, raisonner et prédire des réponses. L’IA générative en est encore à ses débuts, mais la popularité d’applications comme ChatGPT démontre déjà le potentiel de la technologie.

Mais cette technologie nécessite également une énorme puissance de calcul, et Microsoft l'intègre aux services cloud Azure.

L'offre de machines virtuelles s'adapte à la taille des applications d'IA générative et s'adapte à des milliers de GPU H100 interconnectés via la technologie Quantum-2 InfiniBand du fabricant de puces.

Le prix des machines virtuelles H100 sur Azure n'a pas été immédiatement annoncé. Le prix des machines virtuelles varie en fonction de la configuration, avec une machine virtuelle A100 entièrement chargée avec 96 cœurs de processeur, 900 Go de stockage et huit GPU A100 coûtant près de 20 000 $ par mois.

Lorsque ChatGPT a été lancé pour la première fois l'année dernière, le GPU NVIDIA a été mis à rude épreuve. Ses calculs sont effectués par le supercalculateur OpenAI, construit avec des GPU Nvidia A100.

Mais le serveur a été rapidement submergé par la folle augmentation de la demande de ChatGPT, et les utilisateurs se sont plaints du fait que le serveur ne pouvait pas répondre et traiter les tâches de requête à temps.

Le H100 peut combler l'écart de vitesse nécessaire à l'IA générative, qui est déjà utilisée dans les soins de santé, la robotique et d'autres secteurs. Diverses sociétés de développement cherchent également à combler le dernier kilomètre et à déployer une interface pour rendre l'IA simple et utilisable, comme ChatGPT.

Nvidia et Microsoft construisent déjà un supercalculateur d'intelligence artificielle utilisant le H100. Le GPU est conçu pour fonctionner au mieux avec les applications codées en CUDA (CUDA est le framework de programmation parallèle de Nvidia). Les produits incluent également le serveur d'inférence Triton, qui aidera à déployer le modèle d'intelligence artificielle GPT-3 sur son environnement GPU.

Microsoft a commencé à intégrer pleinement l'intelligence artificielle dans ses produits : une version personnalisée de GPT-3.5, le grand modèle de langage derrière ChatGPT, a été implémentée dans le moteur de recherche Bing. Microsoft adopte une approche itérative de style DevOps (opérations de développement) pour Bing AI, dans laquelle les applications peuvent être rapidement mises à jour en se renseignant sur les utilisateurs au fur et à mesure qu'ils utilisent le modèle. Microsoft 365 Copilot est la suite OFFICE originale avec intelligence artificielle intégrée. Des logiciels familiers tels que WORD, PPT et EXCEL modifieront les méthodes de travail traditionnelles avec de nouvelles fonctionnalités. Et derrière tout cela, elle est indissociable du support de la puissance de calcul.

La nouvelle configuration de base de la machine virtuelle Azure peut interconnecter huit GPU H100 Tensor Core via l'interconnexion NVLink 4.0 propriétaire de NVIDIA. Cette configuration peut être étendue à des GPU supplémentaires via l'interconnexion Quantum-2. Le serveur dispose de processeurs évolutifs Intel Xeon (Sapphire Rapids) de 4e génération, avec transfert de données vers et depuis le GPU via PCIe Gen5.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undress AI Tool

Images de déshabillage gratuites

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

Bytedance Cutting lance le super abonnement SVIP : 499 yuans pour un abonnement annuel continu, offrant une variété de fonctions d'IA

Jun 28, 2024 am 03:51 AM

Bytedance Cutting lance le super abonnement SVIP : 499 yuans pour un abonnement annuel continu, offrant une variété de fonctions d'IA

Jun 28, 2024 am 03:51 AM

Ce site a rapporté le 27 juin que Jianying est un logiciel de montage vidéo développé par FaceMeng Technology, une filiale de ByteDance. Il s'appuie sur la plateforme Douyin et produit essentiellement du contenu vidéo court pour les utilisateurs de la plateforme. Il est compatible avec iOS, Android et. Windows, MacOS et autres systèmes d'exploitation. Jianying a officiellement annoncé la mise à niveau de son système d'adhésion et a lancé un nouveau SVIP, qui comprend une variété de technologies noires d'IA, telles que la traduction intelligente, la mise en évidence intelligente, l'emballage intelligent, la synthèse humaine numérique, etc. En termes de prix, les frais mensuels pour le clipping SVIP sont de 79 yuans, les frais annuels sont de 599 yuans (attention sur ce site : équivalent à 49,9 yuans par mois), l'abonnement mensuel continu est de 59 yuans par mois et l'abonnement annuel continu est de 59 yuans par mois. est de 499 yuans par an (équivalent à 41,6 yuans par mois) . En outre, le responsable de Cut a également déclaré que afin d'améliorer l'expérience utilisateur, ceux qui se sont abonnés au VIP d'origine

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

Le DALL-E 3 a été officiellement introduit en septembre 2023 en tant que modèle considérablement amélioré par rapport à son prédécesseur. Il est considéré comme l’un des meilleurs générateurs d’images IA à ce jour, capable de créer des images avec des détails complexes. Cependant, au lancement, c'était exclu

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

L'ensemble de données ScienceAI Question Answering (QA) joue un rôle essentiel dans la promotion de la recherche sur le traitement du langage naturel (NLP). Des ensembles de données d'assurance qualité de haute qualité peuvent non seulement être utilisés pour affiner les modèles, mais également évaluer efficacement les capacités des grands modèles linguistiques (LLM), en particulier la capacité à comprendre et à raisonner sur les connaissances scientifiques. Bien qu’il existe actuellement de nombreux ensembles de données scientifiques d’assurance qualité couvrant la médecine, la chimie, la biologie et d’autres domaines, ces ensembles de données présentent encore certaines lacunes. Premièrement, le formulaire de données est relativement simple, et la plupart sont des questions à choix multiples. Elles sont faciles à évaluer, mais limitent la plage de sélection des réponses du modèle et ne peuvent pas tester pleinement la capacité du modèle à répondre aux questions scientifiques. En revanche, les questions et réponses ouvertes

SK Hynix présentera de nouveaux produits liés à l'IA le 6 août : HBM3E à 12 couches, NAND à 321 hauteurs, etc.

Aug 01, 2024 pm 09:40 PM

SK Hynix présentera de nouveaux produits liés à l'IA le 6 août : HBM3E à 12 couches, NAND à 321 hauteurs, etc.

Aug 01, 2024 pm 09:40 PM

Selon les informations de ce site le 1er août, SK Hynix a publié un article de blog aujourd'hui (1er août), annonçant sa participation au Global Semiconductor Memory Summit FMS2024 qui se tiendra à Santa Clara, Californie, États-Unis, du 6 au 8 août, présentant de nombreuses nouvelles technologies de produit. Introduction au Future Memory and Storage Summit (FutureMemoryandStorage), anciennement Flash Memory Summit (FlashMemorySummit) principalement destiné aux fournisseurs de NAND, dans le contexte de l'attention croissante portée à la technologie de l'intelligence artificielle, cette année a été rebaptisée Future Memory and Storage Summit (FutureMemoryandStorage) pour invitez les fournisseurs de DRAM et de stockage et bien d’autres joueurs. Nouveau produit SK hynix lancé l'année dernière

Les performances de SOTA, la méthode d'IA de prédiction d'affinité protéine-ligand multimodale de Xiamen, combinent pour la première fois des informations sur la surface moléculaire

Jul 17, 2024 pm 06:37 PM

Les performances de SOTA, la méthode d'IA de prédiction d'affinité protéine-ligand multimodale de Xiamen, combinent pour la première fois des informations sur la surface moléculaire

Jul 17, 2024 pm 06:37 PM

Editeur | KX Dans le domaine de la recherche et du développement de médicaments, il est crucial de prédire avec précision et efficacité l'affinité de liaison des protéines et des ligands pour le criblage et l'optimisation des médicaments. Cependant, les études actuelles ne prennent pas en compte le rôle important des informations sur la surface moléculaire dans les interactions protéine-ligand. Sur cette base, des chercheurs de l'Université de Xiamen ont proposé un nouveau cadre d'extraction de caractéristiques multimodales (MFE), qui combine pour la première fois des informations sur la surface des protéines, la structure et la séquence 3D, et utilise un mécanisme d'attention croisée pour comparer différentes modalités. alignement. Les résultats expérimentaux démontrent que cette méthode atteint des performances de pointe dans la prédiction des affinités de liaison protéine-ligand. De plus, les études d’ablation démontrent l’efficacité et la nécessité des informations sur la surface des protéines et de l’alignement des caractéristiques multimodales dans ce cadre. Les recherches connexes commencent par "S

Iyo One : en partie casque, en partie ordinateur audio

Aug 08, 2024 am 01:03 AM

Iyo One : en partie casque, en partie ordinateur audio

Aug 08, 2024 am 01:03 AM

A tout moment, la concentration est une vertu. Auteur | Editeur Tang Yitao | Jing Yu La résurgence de l'intelligence artificielle a donné naissance à une nouvelle vague d'innovation matérielle. L’AIPin le plus populaire a rencontré des critiques négatives sans précédent. Marques Brownlee (MKBHD) l'a qualifié de pire produit qu'il ait jamais examiné ; David Pierce, rédacteur en chef de The Verge, a déclaré qu'il ne recommanderait à personne d'acheter cet appareil. Son concurrent, le RabbitR1, n'est guère mieux. Le plus grand doute à propos de cet appareil d'IA est qu'il ne s'agit évidemment que d'une application, mais Rabbit a construit un matériel de 200 $. De nombreuses personnes voient l’innovation matérielle en matière d’IA comme une opportunité de renverser l’ère des smartphones et de s’y consacrer.

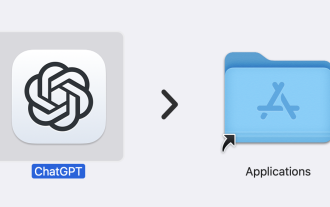

ChatGPT est désormais disponible pour macOS avec la sortie d'une application dédiée

Jun 27, 2024 am 10:05 AM

ChatGPT est désormais disponible pour macOS avec la sortie d'une application dédiée

Jun 27, 2024 am 10:05 AM

L'application ChatGPT Mac d'Open AI est désormais accessible à tous, après avoir été limitée aux seuls utilisateurs disposant d'un abonnement ChatGPT Plus au cours des derniers mois. L'application s'installe comme n'importe quelle autre application Mac native, à condition que vous disposiez d'un Apple S à jour.

Préparant des marchés tels que l'IA, GlobalFoundries acquiert la technologie du nitrure de gallium de Tagore Technology et les équipes associées

Jul 15, 2024 pm 12:21 PM

Préparant des marchés tels que l'IA, GlobalFoundries acquiert la technologie du nitrure de gallium de Tagore Technology et les équipes associées

Jul 15, 2024 pm 12:21 PM

Selon les informations de ce site Web du 5 juillet, GlobalFoundries a publié un communiqué de presse le 1er juillet de cette année, annonçant l'acquisition de la technologie de nitrure de gallium (GaN) et du portefeuille de propriété intellectuelle de Tagore Technology, dans l'espoir d'élargir sa part de marché dans l'automobile et Internet. des objets et des domaines d'application des centres de données d'intelligence artificielle pour explorer une efficacité plus élevée et de meilleures performances. Alors que des technologies telles que l’intelligence artificielle générative (GenerativeAI) continuent de se développer dans le monde numérique, le nitrure de gallium (GaN) est devenu une solution clé pour une gestion durable et efficace de l’énergie, notamment dans les centres de données. Ce site Web citait l'annonce officielle selon laquelle, lors de cette acquisition, l'équipe d'ingénierie de Tagore Technology rejoindrait GF pour développer davantage la technologie du nitrure de gallium. g