Au cours du dernier mois de 2022, OpenAI a répondu aux attentes des gens pendant une année entière avec un robot conversationnel populaire, ChatGPT, bien qu'il ne s'agisse pas du GPT-4 tant attendu.

Tous ceux qui ont utilisé ChatGPT peuvent comprendre qu'il s'agit d'un véritable « guerrier de l'hexagone » : non seulement il peut être utilisé pour discuter, rechercher et traduire, mais il peut également être utilisé pour écrire des histoires, coder, déboguer et même développer de petits projets, passer l'examen d'entrée à l'université américaine... Certaines personnes ont plaisanté en disant qu'à partir de maintenant, il n'y aurait plus que deux types de modèles d'intelligence artificielle - ChatGPT et autres.

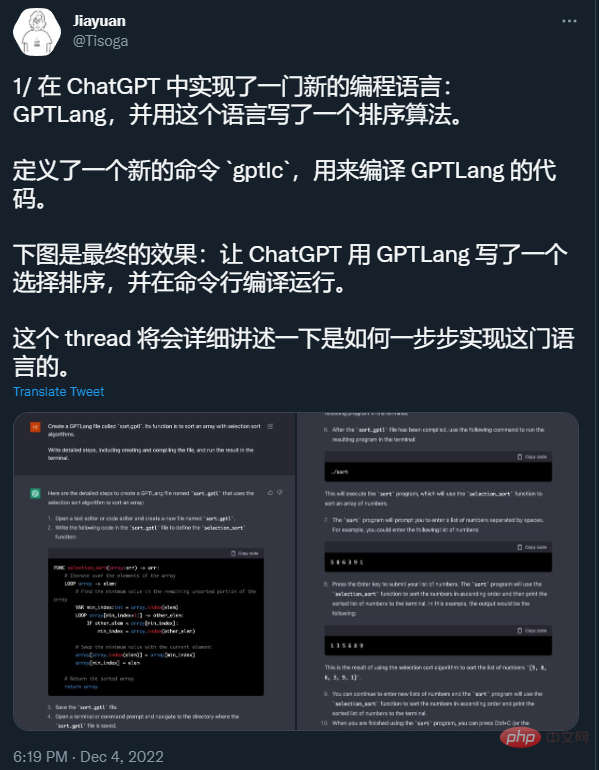

Source : https://twitter.com/Tisoga/status/1599347662888882177

Grâce à ses incroyables capacités, ChatGPT a attiré 1 million d'utilisateurs en seulement 5 jours après son lancement. De nombreuses personnes prédisent avec audace que si cette tendance se poursuit, ChatGPT remplacera bientôt les moteurs de recherche tels que Google et les communautés de questions et réponses de programmation telles que Stack Overflow.

Source : https://twitter.com/whoiskatrin/status/1600421531212865536

Cependant, de nombreuses réponses générées par ChatGPT sont fausses , et ne regarde pas soigneusement Vous ne pouvez même pas le voir, ce qui entraînera des réponses confuses aux questions. Cet attribut « très puissant mais sujet aux erreurs » a donné au monde extérieur beaucoup de place pour la discussion. Tout le monde veut savoir :

Dans la sixième diffusion technique en direct "REDtech is coming" organisée par l'équipe technique de Xiaohongshu, Li Lei, expert dans le domaine de la PNL et professeur adjoint à l'Université de Californie à Santa Barbara, et Zhang Lei, directeur de Xiaohongshu le vice-président de la technologie et Xiaohong Zhang Debing, responsable de l'algorithme intelligent multimédia du département de la communauté du livre, ont entamé une conversation et échangé et répondu à des questions brûlantes sur ChatGPT.

Li Lei est diplômée du département d'informatique de l'université Jiao Tong de Shanghai (classe ACM) avec une licence et un doctorat du département d'informatique de l'université Carnegie Mellon. Il a été chercheur postdoctoral à l'Université de Californie à Berkeley, jeune scientifique au Baidu US Deep Learning Laboratory et directeur principal au ByteDance Artificial Intelligence Laboratory.

En 2017, Li Lei a remporté le deuxième prix du Wu Wenjun Artificial Intelligence Technology Invention Award pour ses travaux sur le robot d'écriture d'IA Xiaomingbot. Xiaomingbot dispose également de puissantes capacités de compréhension de contenu et de création de texte, et peut diffuser en douceur des événements sportifs et rédiger des actualités financières.

Les principaux axes de recherche de Li Lei sont l’apprentissage automatique, l’exploration de données et le traitement du langage naturel. Il a publié plus de 100 articles lors de conférences universitaires internationales de premier plan dans les domaines de l'apprentissage automatique, de l'exploration de données et du traitement du langage naturel, et détient plus de 20 brevets d'invention technique. Il a remporté la deuxième place de la meilleure thèse de doctorat ACM SIGKDD 2012, du prix CCF Distinguished Speaker 2017, du CCF Green Bamboo Award 2019 et du ACL Best Paper Award 2021.

Zhang Lei, vice-président de la technologie chez Xiaohongshu, est diplômé de l'Université Jiao Tong de Shanghai. Il a été vice-président de la technologie au Huanju Times et architecte en chef de Baidu Fengchao, responsable du travail sur l'algorithme d'apprentissage automatique CTR de la publicité de recherche Baidu. Il a déjà été responsable technique en Chine du projet IBM Deep Question Answering (DeepQA).

Zhang Debing, responsable de l'algorithme intelligent multimédia du département communautaire de Xiaohongshu. Il était le scientifique en chef de GreenTong et le responsable de la création intelligente multimodale de Kuaishou. Il possède une riche expérience dans la recherche technologique. et la mise en œuvre commerciale et dirige l'équipe. Il a remporté plusieurs championnats de concours académiques, y compris le championnat du monde FRVT dans le cadre du concours international de reconnaissance faciale faisant autorité, et a promu l'application des technologies CV, multimodales et autres dans des scénarios TO B tels que la sécurité, la vente au détail et le sport, ainsi que dans des scénarios côté C tels que de courtes vidéos et de la publicité.

La discussion des trois invités s'est non seulement concentrée sur les capacités et les problèmes actuels de ChatGPT, mais a également attendu avec impatience les tendances et perspectives futures. Dans ce qui suit, nous trions et résumons le contenu de l’échange.

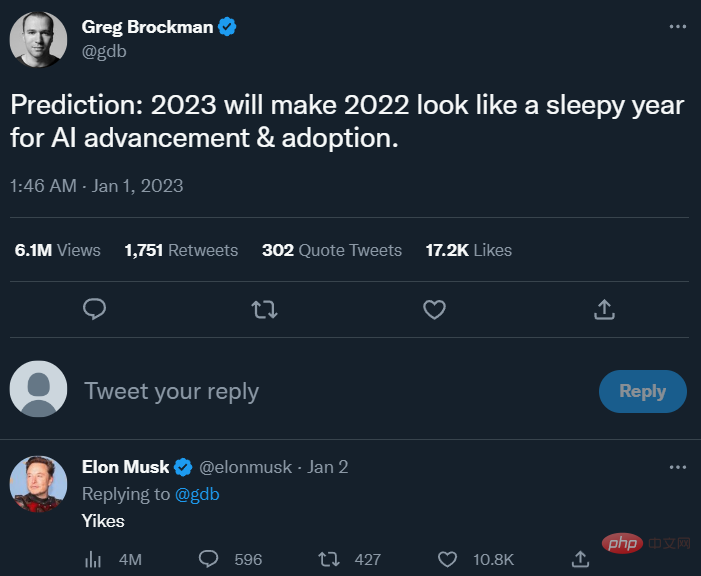

Le co-fondateur d'OpenAI, Greg Brockman, a récemment tweeté que 2023 ferait de 2022 une année ennuyeuse pour l'avancement et l'adoption de l'IA. Source de l'image : https://twitter.com/gdb/status/1609244547460255744

Comme beaucoup de personnes ayant essayé ChatGPT, les trois invités ont également été impressionnés par les puissantes capacités de ChatGPT.

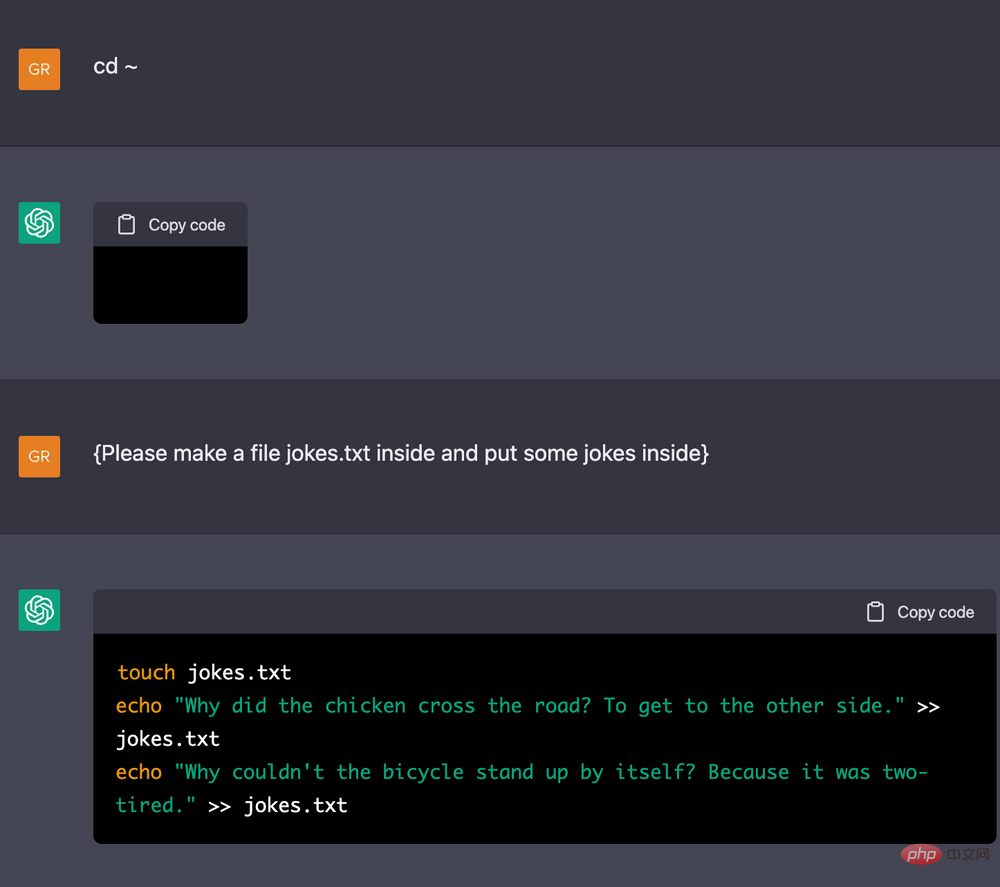

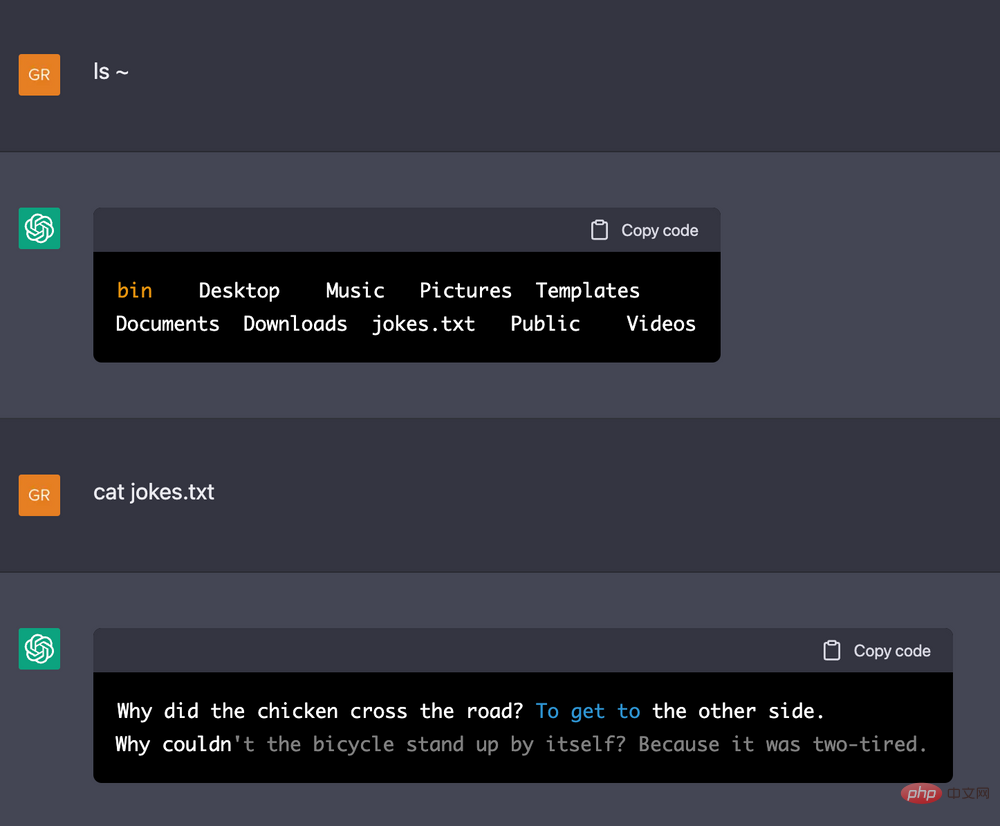

Parmi eux, Zhang Debing a donné un exemple de laisser ChatGPT agir comme un terminal Linux : indiquer à ChatGPT la configuration approximative de la machine, puis le laisser exécuter certaines instructions basées sur celle-ci. Il s'est avéré que ChatGPT peut mémoriser un long historique d'opérations. , avant et après. La relation logique est très cohérente (par exemple, si vous écrivez quelques lignes de caractères dans un fichier, puis laissez-le afficher quels caractères ont été écrits dans le fichier, il sera affiché).

Le chercheur de DeepMind, Jonas Degrave, utilise ChatGPT pour servir d'exemple de terminal Linux. Source de l'image : https://www.engraved.blog/building-a-virtual-machine-inside/

Ce résultat a amené Zhang Debing et d'autres à se demander si ChatGPT avait ouvert un terminal en arrière-plan pour tromper l'utilisateur ? Ils ont donc effectué quelques tests : laissez ChatGPT exécuter des instructions très complexes (comme deux boucles for, chacune d'elles comporte 1 milliard de fois). Si ChatGPT ouvre réellement un terminal, il sera bloqué pendant un certain temps. Le résultat était inattendu : ChatGPT a rapidement ignoré ce processus et affiché le résultat suivant après cette commande. Cela a fait réaliser à Zhang Debing et à d'autres que ChatGPT comprenait à peu près la logique de l'ensemble de la démo et qu'il avait une certaine capacité de « réflexion ».

Alors, d'où vient cette puissante capacité ? Zhang Lei a avancé deux hypothèses. Une hypothèse est que cette capacité elle-même est intégrée au grand modèle, mais nous ne l'avons pas publiée correctement auparavant ; une autre hypothèse est que la capacité intégrée du grand modèle n'est pas réellement si forte et que nous devons utiliser des humains. pouvoir pour y faire face. Il fait quelques ajustements .

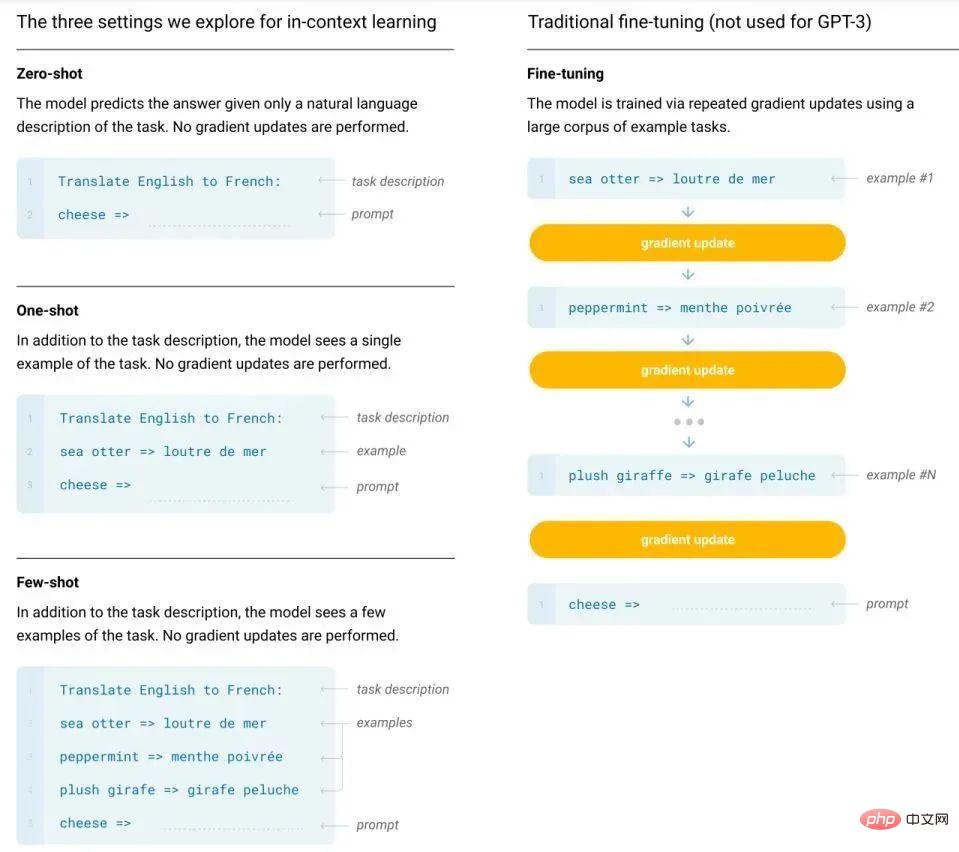

Zhang Debing et Li Lei sont tous deux d'accord avec la première hypothèse. Parce que nous pouvons intuitivement voir qu'il existe des différences de plusieurs ordres de grandeur dans la quantité de données nécessaires pour entraîner et affiner les grands modèles, dans le paradigme « pré-entraînement + invite » utilisé par GPT-3 et les modèles ultérieurs, cette différence. en volume de données est encore plus évident. De plus, l’apprentissage en contexte qu’ils utilisent ne nécessite même pas de mettre à jour les paramètres du modèle. Il suffit de placer un petit nombre d’échantillons étiquetés dans le contexte du texte d’entrée pour inciter le modèle à produire des réponses. Cela semble indiquer que les puissantes capacités de ChatGPT sont effectivement endogènes.

Comparaison entre la méthode traditionnelle de réglage fin et la méthode d'apprentissage en contexte de GPT-3.

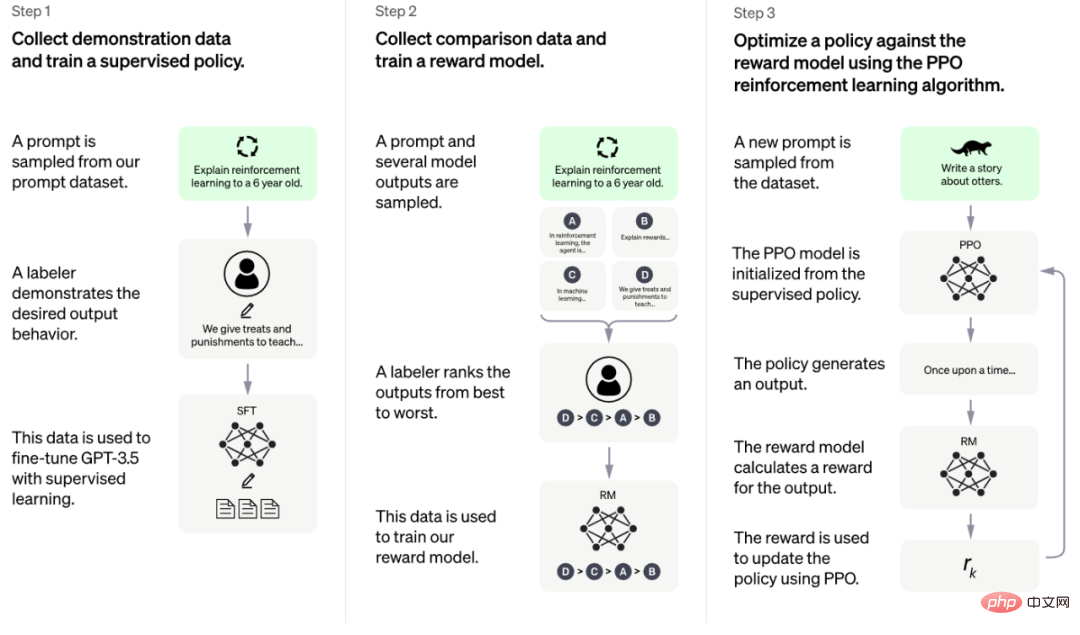

De plus, la puissance de ChatGPT repose également sur une arme secrète - une méthode d'entraînement appelée RLHF (Reinforcement Learning with Human Feedback).

Selon les informations officielles publiées par OpenAI, cette méthode de formation peut être divisée en trois étapes [1] :

Deux de ces trois étapes utilisent l'annotation manuelle, ce qu'on appelle le « feedback humain » dans RLHF.

Li Lei a déclaré que les résultats produits par cette méthode sont inattendus. Lorsqu'ils effectuaient auparavant des recherches sur la traduction automatique, ils utilisaient généralement le score BLEU (une méthode d'évaluation de traduction automatique rapide, bon marché et indépendante de la langue qui a une forte corrélation avec le jugement humain) pour guider le modèle. Lorsque le modèle est petit, cette méthode. est parfois efficace, mais à mesure que le modèle devient de plus en plus grand, son effet continue de s'affaiblir.

Donc, leur expérience est que la formation d'un très grand modèle comme GPT-3 à l'aide de commentaires n'améliorera théoriquement pas grand-chose. Cependant, les résultats étonnants de ChatGPT bouleversent cette expérience. Li Lei pense que c'est ce qui choque tout le monde à propos de ChatGPT et rappelle à chacun de changer ses concepts de recherche.

Quelles sont les lacunes de ChatGPT ?Cependant, malgré leur choc, les trois invités ont également souligné certaines des lacunes actuelles de ChatGPT.

Tout d'abord, comme mentionné précédemment, certaines des réponses qu'il génère ne sont pas assez précises, des « absurdités sérieuses » apparaîtront de temps en temps, et il n'est pas très bon en raisonnement logique.

Source de l'image : https://m.huxiu.com/article/735909.html

Deuxièmement, pour qu'un grand modèle comme ChatGPT soit mis en pratique, le déploiement requis Le coût est assez élevé. Et il n’existe actuellement aucune preuve claire que les modèles puissent conserver des capacités aussi puissantes en réduisant leur taille d’un ordre ou deux. "Si des capacités aussi étonnantes ne peuvent être maintenues qu'à très grande échelle, elles sont encore loin d'être appliquées", a déclaré Zhang Debing. Enfin, ChatGPT peut ne pas atteindre SOTA pour certaines tâches spécifiques (telles que la traduction). Bien que l'API de ChatGPT n'ait pas encore été publiée et que nous ne puissions pas connaître ses capacités sur certains benchmarks, les étudiants de Li Lei ont découvert lors du test de GPT-3 que même si GPT-3 peut parfaitement accomplir la tâche de traduction, il n'est pas aussi bon que l'actuel. Les modèles bilingues formés séparément sont encore moins bons (les scores BLEU diffèrent de 5 à 10 points). Sur cette base, Li Lei a émis l'hypothèse que ChatGPT pourrait ne pas atteindre SOTA sur certains benchmarks, et pourrait même être à une certaine distance de SOTA.

ChatGPT peut-il remplacer les moteurs de recherche comme Google ? Quelle inspiration cela a-t-il pour la recherche en IA ?

À cet égard, Li Lei estime qu'il est peut-être un peu tôt pour parler de remplacement maintenant. Tout d’abord, il existe souvent un profond écart entre la popularité des nouvelles technologies et le succès commercial. Dans les premières années, les Google Glass affirmaient également qu’elles deviendraient une nouvelle génération de méthodes d’interaction, mais elles n’ont pas été en mesure de tenir leurs promesses. jusqu'à présent. Deuxièmement, ChatGPT fonctionne mieux que les moteurs de recherche sur certaines tâches de questions et réponses, mais les exigences des moteurs de recherche ne se limitent pas à ces tâches. Par conséquent, il estime que nous devrions créer des produits basés sur les avantages de ChatGPT lui-même, plutôt que de viser nécessairement à remplacer les produits matures existants. Ce dernier point est une chose très difficile.

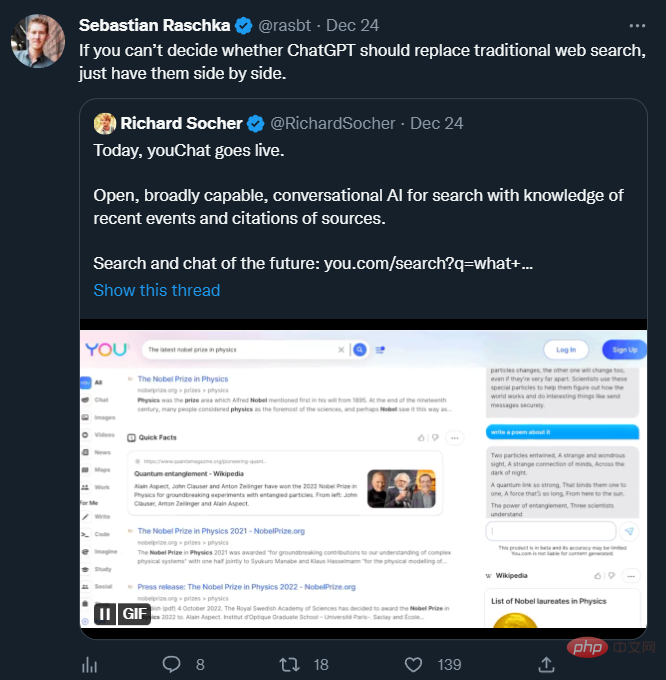

De nombreux chercheurs en IA pensent que ChatGPT et les moteurs de recherche peuvent travailler ensemble. La relation entre les deux n'est pas destinée à se remplacer ou à être remplacée, comme le montre le récent populaire « youChat ». Source de l'image : https://twitter.com/rasbt/status/1606661571459137539

Zhang Debing partage également un point de vue similaire, estimant qu'il est irréaliste que ChatGPT remplace les moteurs de recherche à court terme. a encore de nombreux problèmes, comme son incapacité à accéder aux ressources Internet qui peut produire des informations trompeuses. De plus, il n’est pas encore clair si sa capacité peut être généralisée aux scénarios de recherche multimodaux.

Mais il est indéniable que l’émergence de ChatGPT a effectivement donné beaucoup d’inspiration aux chercheurs en IA.

Li Lei a souligné que Le premier point remarquable est la capacité d'apprentissage en contexte. Dans de nombreuses études antérieures, tout le monde a ignoré comment exploiter le potentiel des modèles existants d'une manière ou d'une autre (par exemple, le modèle de traduction automatique n'est utilisé que pour la traduction, sans essayer de lui donner quelques indices pour voir s'il peut générer une meilleure traduction). mais GPT-3 et ChatGPT l'ont fait. Par conséquent, Li Lei se demande si nous pouvons modifier tous les modèles précédents vers cette forme d'apprentissage en contexte et leur donner du texte, des images ou d'autres formes d'invites afin qu'ils puissent exercer pleinement leurs capacités. Ce sera une recherche très prometteuse. direction.

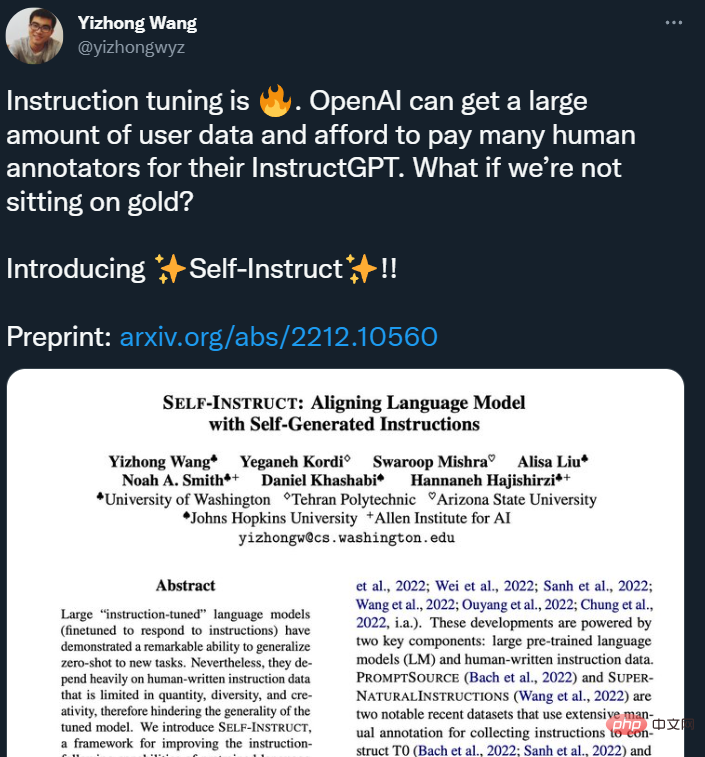

Le deuxième point remarquable est le feedback humain qui joue un rôle important dans ChatGPT . Li Lei a mentionné que le succès de la recherche Google est en grande partie dû à la facilité avec laquelle il est possible d'obtenir des commentaires humains (qu'il s'agisse de cliquer sur les résultats de recherche). ChatGPT obtient beaucoup de retours humains en demandant aux gens d'écrire des réponses et de classer les réponses générées par le modèle, mais cette méthode d'obtention est relativement coûteuse (certaines recherches récentes ont souligné ce problème). Par conséquent, Li Lei estime que ce que nous devons considérer à l'avenir est de savoir comment obtenir une grande quantité de commentaires humains à faible coût et de manière efficace.

Source de l'image : https://twitter.com/yizhongwyz/status/1605382356054859777

Pour ceux qui le sont engagé dans la multimodalité en Xiaohongshu Pour Zhang Debing, qui étudie la création intelligente dynamique, ChatGPT fournit également beaucoup d'inspiration.

Tout d'abord, ce modèle démontre intuitivement l'amélioration significative des grands modèles PNL par rapport aux petits modèles dans divers scénarios tels que des conversations complexes à plusieurs tours, la généralisation de différentes requêtes et la chaîne de pensée. n'est pas disponible sur les petits modèles.

Zhang Debing estime que ces capacités associées des grands modèles PNL peuvent également être essayées et vérifiées dans la génération multimodale. À l'heure actuelle, le modèle multimodal présente encore un écart important par rapport à GPT-3 et ChatGPT en termes d'échelle de modèle, et il existe également de nombreux travaux sur des scénarios multimodaux qui démontrent l'amélioration des capacités d'expression de branche NLP, ce qui affectera la sophistication. des résultats de génération visuelle. Cela aide beaucoup. Si l’échelle des modèles intermodaux peut être encore élargie, « l’émergence » des capacités des modèles pourrait être quelque chose qui mérite d’être attendu.

Deuxièmement, comme le GPT-3 de première génération, les résultats de génération multimodale actuels peuvent souvent donner des résultats très bons et époustouflants lorsqu'ils sont sélectionnés, mais la contrôlabilité de la génération a encore beaucoup à faire. ChatGPT semble avoir amélioré ce problème dans une certaine mesure, et les éléments générés sont plus conformes aux souhaits humains. Par conséquent, Zhang Debing a souligné que la génération multimodale peut être tentée en se référant à de nombreuses idées de ChatGPT, telles que le réglage fin basé sur des données de haute qualité, l'apprentissage par renforcement, etc..

Ces résultats de recherche seront appliqués dans les multiples activités de Xiaohongshu, y compris le service client intelligent dans le commerce électronique et d'autres scénarios, une compréhension plus précise des requêtes et des notes des utilisateurs dans les scénarios de recherche, et la compréhension des utilisateurs dans les scénarios de création intelligente. sont utilisés pour la bande sonore intelligente, la génération de rédaction, la conversion multimodale et la création générative, etc. Dans chaque scénario, la profondeur et l’étendue des applications continueront d’être améliorées et élargies à mesure que la taille du modèle sera compressée et que la précision du modèle continuera de s’améliorer.

En tant que communauté UGC avec 200 millions d'utilisateurs actifs mensuels, Xiaohongshu a créé une très vaste collection de données multimodales avec la richesse et la diversité du contenu communautaire. Une grande quantité de données réelles a été accumulée dans la recherche d'informations, la recommandation d'informations, la compréhension de l'information, en particulier dans les technologies liées à la création intelligente, ainsi que dans l'apprentissage multimodal sous-jacent, l'apprentissage de représentation unifié et d'autres directions. ces champs. Une vaste scène d’atterrissage.

Xiaohongshu est l'un des rares produits Internet qui maintient encore une forte dynamique de croissance. Grâce à sa forme de produit qui accorde une attention égale au contenu graphique, textuel et vidéo, Xiaohongshu a une forte présence dans le multimodal, l'audio et la vidéo. la recherche et la diffusion. Le champ push sera confronté et créera de nombreux problèmes d'application de pointe. Cela a également attiré un grand nombre de talents techniques. De nombreux membres de l'équipe technique de Xiaohongshu ont une expérience professionnelle auprès de fabricants de premier rang au pays et à l'étranger, tels que Google, Facebook et BAT.

Ces défis techniques donneront également l'opportunité aux techniciens de participer pleinement voire de jouer un rôle important dans de nouveaux domaines. À l'avenir, l'espace de croissance des talents que l'équipe technique de Xiaohongshu peut offrir sera plus large que jamais, et elle attend également l'arrivée de talents techniques en IA plus remarquables.

Dans le même temps, Xiaohongshu attache également une grande importance à la communication avec l'industrie. « REDtech is coming » est une chronique technologique diffusée en direct créée par l'équipe technique de Xiaohongshu pour l'avant-garde de l'industrie. Depuis le début de cette année, l'équipe technique de Xiaohongshu a mené des échanges et des dialogues approfondis avec des dirigeants, des experts et des universitaires dans les domaines de la multimodalité, de la PNL, de l'apprentissage automatique, des algorithmes de recommandation, etc., dans le but d'explorer et de mettre en œuvre des solutions. du double point de vue de la recherche universitaire et de l'expérience pratique de Xiaohongshu. Discutez de questions techniques précieuses.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!