La popularité de ChatGPT et de GPT-4 a jusqu'à présent mis les modèles linguistiques à grande échelle à leur point culminant. Mais où aller ensuite ?

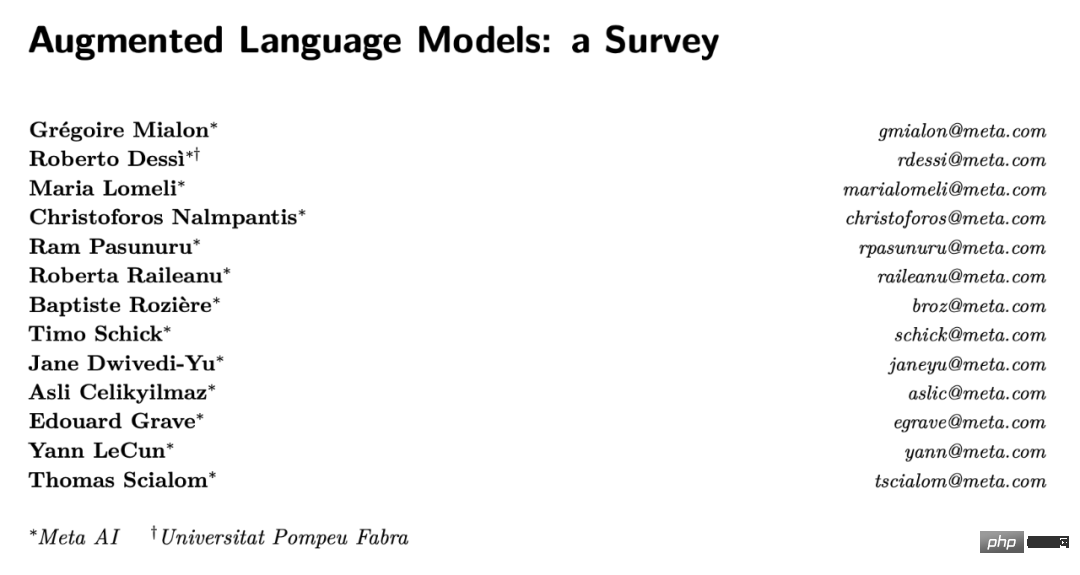

Yann LeCun a récemment participé à une étude qui a souligné que l'amélioration des modèles linguistiques pourrait être une direction prometteuse.

Il s'agit d'un article de synthèse Cet article présentera brièvement le contenu principal de l'article.

Les modèles linguistiques à grande échelle ont grandement favorisé les progrès du traitement du langage naturel. Les technologies associées ont créé plusieurs produits avec des millions d'utilisateurs, notamment l'assistant de codage Copilot, le moteur de recherche Google et le récemment populaire ChatGPT. En combinant la mémoire avec des capacités de composition, les grands modèles de langage peuvent effectuer des tâches telles que la compréhension du langage ou la génération de texte conditionnelle et inconditionnelle avec des performances sans précédent, faisant ainsi de l'interaction homme-machine à bande passante plus élevée une réalité.

Cependant, les grands modèles de langage présentent encore certaines limitations qui empêchent leur déploiement à plus grande échelle. Les grands modèles linguistiques fournissent souvent des prédictions non factuelles mais plausibles, souvent appelées hallucinations. Cela conduit à de nombreuses erreurs évitables, par exemple dans des contextes arithmétiques ou dans des chaînes de raisonnement. De plus, mesurées par le nombre de paramètres pouvant être entraînés, les capacités révolutionnaires de nombreux grands modèles de langage semblent apparaître à mesure que l'échelle augmente. Par exemple, certains chercheurs ont démontré qu'une fois qu'un grand modèle de langage atteint une certaine échelle, il est capable de le faire. effectuer certaines tâches via des invites à quelques échantillons. Bien qu’une série de travaux récents aient produit des modèles de langage à petite échelle qui conservent encore certaines caractéristiques des grands modèles, les coûts de formation et de maintenance des grands modèles de langage restent élevés en raison de leur taille et de leurs besoins en données. L'apprentissage continu des grands modèles reste un problème de recherche ouvert, et Goldberg a déjà évoqué d'autres limitations des grands modèles de langage dans le contexte du chatbot ChatGPT basé sur GPT-3.

Dans une étude récente, des chercheurs de Meta et d'autres institutions ont analysé que les problèmes ci-dessus proviennent d'un défaut essentiel des grands modèles de langage : ils sont généralement formés pour effectuer des tâches étant donné (i) un modèle à paramètre unique et (ii) effectuer modélisation de langage statistique avec un contexte limité (généralement n jetons précédents ou environnants). Bien que n ait augmenté en raison des innovations logicielles et matérielles ces dernières années, la plupart des modèles utilisent encore des contextes relativement petits par rapport aux contextes potentiellement volumineux requis pour effectuer correctement et de manière cohérente une modélisation du langage. Par conséquent, les modèles nécessitent une échelle énorme pour stocker des connaissances qui ne sont pas présentes dans le contexte mais qui sont nécessaires pour accomplir la tâche à accomplir.

Lien papier : https://arxiv.org/pdf/2302.07842v1.pdf

Par conséquent, de plus en plus de recherches visent à résoudre ces problèmes, et un léger écart le paradigme de modélisation du langage purement statistique décrit ci-dessus.

Par exemple, il existe un travail pour contourner la taille limitée du contexte en augmentant la pertinence des grands modèles de langage, en ajoutant des informations extraites de documents externes pertinents. En équipant les grands modèles de langage de modules qui récupèrent ces documents à partir d'une base de données pour un contexte donné, il est possible de faire correspondre certaines des capacités de certains des plus grands modèles de langage avec moins de paramètres. Notez que le modèle résultant est désormais non paramétrique car il peut interroger des sources de données externes. En général, les modèles de langage peuvent également améliorer leur contexte grâce à des stratégies d'inférence pour générer un contexte plus pertinent et économiser davantage de calculs avant de générer une réponse.

Une autre stratégie consiste à permettre au modèle de langage d'exploiter des outils externes pour augmenter le contexte actuel avec des informations manquantes importantes non incluses dans les pondérations du modèle de langage. Bien qu’une grande partie de ces travaux visent à atténuer les lacunes des modèles de langage mentionnées ci-dessus, ils illustrent également directement qu’une utilisation plus systématique de l’inférence et d’outils pour améliorer les modèles de langage peut conduire à des agents plus puissants. Ces modèles sont appelésModèles de langage augmentés (ALM). À mesure que cette tendance s’accélérait, le nombre d’études connexes augmentait considérablement, nécessitant la classification des œuvres et la définition de termes techniques pour différents usages.

Les termes utilisés dans cet article sont définis comme suit :

raisonnement.Dans le contexte des modèles de langage augmentés, l'inférence est la décomposition d'une tâche potentiellement complexe en sous-tâches plus simples que le modèle de langage peut plus facilement résoudre par lui-même ou à l'aide d'outils. Il existe différentes manières de décomposer les sous-tâches, par exemple de manière récursive ou itérative. En ce sens, le raisonnement est similaire à la « planification » telle que définie dans l'article de LeCun de 2022 « A Path Towards Autonomous Machine Intelligence ». Dans cet article, l'inférence impliquera souvent diverses stratégies pour améliorer les compétences d'inférence de modèles de langage, telles que l'inférence étape par étape à l'aide de quelques exemples. Il n'est pas tout à fait clair si le modèle de langage raisonne réellement ou s'il génère simplement un contexte plus large qui augmente la probabilité de prédire correctement le jeton manquant. Il peut être utile de se référer à la discussion sur ce sujet par d'autres chercheurs (Huang et Chang (2022)) : bien que le raisonnement puisse être un abus de langage basé sur les résultats actuels de SOTA, le terme est déjà utilisé dans la communauté. Une définition plus pratique du raisonnement contextuel dans les modèles de langage augmenté consiste à donner au modèle davantage d'étapes de calcul avant de générer une réponse à une invite.

Outils.Pour les modèles de langage augmentés, un outil est un module externe, généralement appelé à l'aide de règles ou de jetons spéciaux, dont la sortie est incluse dans le contexte du modèle de langage augmenté. L’outil peut collecter des informations externes ou avoir un impact sur le monde virtuel ou physique (souvent perçu par un modèle de langage augmenté). Un exemple d'outil qui obtient des informations externes est un outil de récupération de documents, tandis qu'un outil qui a des effets externes est un bras robotique. Les outils peuvent être appelés pendant la formation ou le temps d'inférence. En général, apprendre à interagir avec un outil peut inclure l’apprentissage de l’appel de son API.

comportement.Pour les modèles de langage augmenté, une action consiste à invoquer un outil qui a un impact sur le monde virtuel ou physique et à observer les résultats, généralement en l'incluant dans le contexte actuel du modèle de langage augmenté. Par exemple, certains des travaux mentionnés dans cet article abordent la recherche sur le Web ou la manipulation de bras robotiques à travers des modèles linguistiques. Pour abuser un peu de la terminologie, les chercheurs qualifient parfois l’invocation d’outils par un modèle de langage augmenté de comportement, même s’il n’a aucun effet externe.

Pourquoi faut-il discuter ensemble du raisonnement et des outils ?La combinaison de raisonnement et d'outils dans les modèles de langage est utilisée pour résoudre un grand nombre de tâches complexes sans avoir besoin d'heuristiques et possède donc de meilleures capacités de généralisation. En règle générale, l'inférence facilitera les modèles de langage qui décomposent un problème donné en sous-tâches potentiellement plus simples, tandis que les outils aideront à corriger chaque étape, comme l'obtention des résultats d'opérations mathématiques. En d’autres termes, l’inférence est un moyen pour les modèles de langage de combiner différents outils pour résoudre des tâches complexes, et les outils sont un moyen d’éviter les échecs d’inférence grâce à une décomposition efficace. Les deux devraient bénéficier de l’autre. De plus, l'inférence et les outils peuvent être placés sous le même « capot » puisque tous deux améliorent le contexte du modèle de langage pour mieux prédire les jetons manquants, bien que de différentes manières.

Pourquoi les outils et les actions sont-ils discutés ensemble ?Les modèles linguistiques peuvent être invoqués de la même manière que des outils qui collectent des informations supplémentaires et ont un impact sur le monde virtuel ou physique. Par exemple, il ne semble y avoir aucune différence entre un modèle de langage produisant du code Python pour résoudre une opération mathématique et un modèle de langage produisant du code Python pour faire fonctionner un bras robotique. Certains des travaux abordés dans cet article ont utilisé des modèles de langage ayant des implications pour les mondes virtuels ou physiques. De ce point de vue, on peut dire que les modèles de langage ont un potentiel comportemental et que les progrès importants qu'ils ont réalisés en tant qu'orientation pour les agents automatisés méritent également d'être attendus.

Cet article divise les recherches incluses dans l'enquête en trois parties. La section 2 examine les travaux visant à améliorer les capacités de raisonnement des modèles de langage tels que définis ci-dessus. La section 3 se concentre sur les travaux qui permettent aux modèles de langage d'interagir avec des outils externes et d'agir sur ceux-ci. Enfin, la section 4 explore si le raisonnement et l'utilisation des outils sont obtenus par l'heuristique ou par l'apprentissage, par exemple par la supervision ou le renforcement. L'enquête comprend également d'autres éléments, dont les auteurs discutent dans la section V. Par souci de concision, l'enquête se concentre sur les travaux qui combinent l'inférence ou les outils avec des modèles de langage. Enfin, bien que cet article se concentre sur les grands modèles de langage, toutes les études considérées n'ont pas utilisé de grands modèles. Par conséquent, pour garantir l'exactitude, les modèles de langage seront également respectés dans les enquêtes restantes.

Inférence

Des travaux antérieurs ont montré que les grands modèles de langage peuvent résoudre des problèmes d'inférence simples mais pas des problèmes d'inférence complexes : par conséquent, cette section se concentre sur diverses stratégies pour améliorer les compétences d'inférence des modèles de langage. L’un des défis des problèmes d’inférence complexes pour les modèles linéaires est d’obtenir correctement la solution en combinant leurs réponses correctes prédites en sous-problèmes. Par exemple, un modèle linguistique peut prédire avec précision les dates de naissance et de décès de personnes célèbres, mais il peut ne pas prédire avec précision leur âge. Certains chercheurs appellent cette différence l’écart de composition des modèles linguistiques. Le reste de cette section traite des travaux liés à trois paradigmes populaires d'inférence induite dans les modèles de langage. Puisque les travaux actuels se concentrent sur l’inférence combinée à des outils, le lecteur est renvoyé ici à une discussion plus approfondie des travaux d’autres chercheurs sur l’inférence de grands modèles de langage.

Utilisation d'outils et de comportements

Des lignes récentes de recherche sur les modèles de langage permettent aux modèles d'accéder à des connaissances qui ne sont pas nécessairement stockées dans leurs poids, comme les connaissances factuelles. Plus précisément, des tâches telles qu'un calcul précis ou une recherche d'informations peuvent être déléguées à des modules externes, comme un interpréteur Python ou un module de moteur de recherche interrogé par le modèle, auquel cas ces modules utilisent des outils. De plus, lorsqu’un outil a un impact sur le monde extérieur, on peut dire que le modèle de langage a réalisé une action. Incluez facilement des outils et des comportements sous la forme de jetons spéciaux, une fonctionnalité pratique combinée à la modélisation du langage Transformer.

Après avoir examiné comment les modèles de langage peuvent être améliorés pour exercer leur capacité à raisonner et à appliquer des outils, cette enquête décrit également comment enseigner aux modèles à appliquer ces capacités.

Pour plus de détails sur la recherche, veuillez vous référer à l'article original.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Comment acheter et vendre du Bitcoin dans le pays

Comment acheter et vendre du Bitcoin dans le pays Le rôle de la fonction float() en python

Le rôle de la fonction float() en python pagination mysql

pagination mysql Utilisation de la valeur de retour Python

Utilisation de la valeur de retour Python Quel est le symbole du droit d'auteur

Quel est le symbole du droit d'auteur Cinq composants majeurs d'un ordinateur von Neumann

Cinq composants majeurs d'un ordinateur von Neumann Comment trouver la valeur maximale et minimale d'un élément de tableau en Java

Comment trouver la valeur maximale et minimale d'un élément de tableau en Java gestion des exceptions Java

gestion des exceptions Java