Les sujets liés à ChatGPT doivent être considérés comme le hotspot d'intelligence artificielle le plus populaire depuis AlphaGo. Pour faire simple, c'est un robot qui peut parler en langage naturel. Vous pouvez lui poser n'importe quelle question (bien sûr, il peut répondre de manière erronée, mais vous pouvez le guider et le corriger), et il répondra de manière naturelle et très fluide. langue vous. Non seulement cela, il peut également répondre à des questions de codage, à des questions de mathématiques, etc., et vous pouvez avoir une bonne conversation avec lui sur n'importe quel problème.

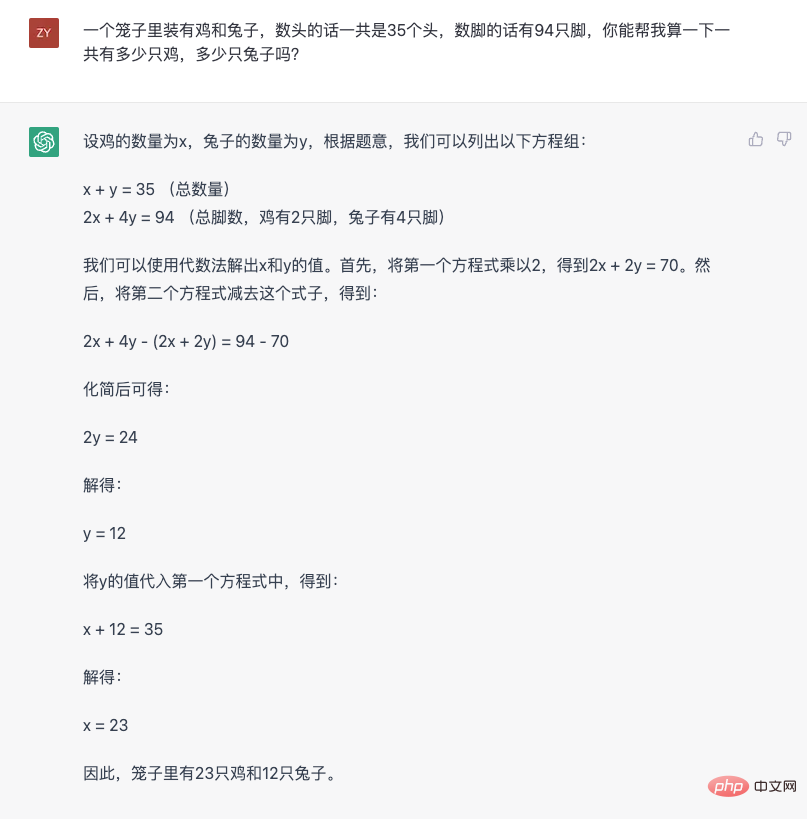

Nous pouvons utiliser un problème classique de poulet et de lapin dans la même cage pour comprendre les capacités de ChatGPT de manière perceptuelle :

Plusieurs caractéristiques peuvent être observées à partir de cette réponse. Le premier est la capacité de comprendre et de convertir le langage naturel en problèmes mathématiques. Deuxièmement, il décompose étape par étape un problème de raisonnement plus complexe pour obtenir la réponse finale étape par étape. Cette capacité est appelée « chaîne de pensée » dans l'industrie. Ensuite, changez la question et voyez comment elle répond.

Il ressort de cette image que ChatGPT est conscient de ce qu'il dit et peut donner des raisons de le dire. De plus, on peut également constater qu'il fait des erreurs (la première fois que j'ai calculé le nombre d'oreilles était erroné. Voici un fait anecdotique, les poulets ont des organes fonctionnels similaires aux "oreilles"), mais on peut lui donner des conseils. Donnez la bonne réponse et expliquez pourquoi vous vous trompez.

Si je ne vous dis pas à l'avance qu'il s'agit d'un modèle d'intelligence artificielle, ChatGPT ressemble à une vraie personne avec de réelles capacités de pensée logique et de communication linguistique. Pour la première fois, son apparition donne à tout le monde le sentiment que l'intelligence artificielle peut enfin communiquer normalement avec les gens. Même si elle fait parfois des erreurs, au moins il n'y a pas de barrières linguistiques ni logiques dans le processus de communication. parlez-vous et vous donner des commentaires en fonction des schémas de pensée humains et des normes linguistiques. Cette expérience très intelligente est la raison pour laquelle elle traverse les petits cercles de l'industrie et apporte un sentiment d'impact au public.

Je tiens également à souligner à nouveau cette question d'expérience, car peut-être dans le passé, en raison de limitations techniques, l'industrie l'ignorait afin d'accomplir des tâches spécifiques dans la scène. L’émergence de ChatGPT aujourd’hui signifie que l’intelligence artificielle n’est plus la forme « utile, mais stupide » du passé.

Afin de mieux comprendre comment se produit le sentiment très intelligent de ChatGPT, il est inévitable de commencer par l’intelligence artificielle « stupide » du passé. Pour être précis, ChatGPT utilise toujours la technologie de traitement du langage naturel (NLP), mais elle brise le paradigme original.

Pour comprendre cela, vous pouvez d’abord jeter un œil à la pratique dominante actuelle. La communication humaine repose sur le langage, et beaucoup de gens croient même que la pensée humaine repose également sur le langage. Par conséquent, comprendre et utiliser le langage naturel a toujours été un sujet important en intelligence artificielle. Mais le langage est trop complexe, donc pour que les ordinateurs comprennent et utilisent le langage, ce processus est généralement divisé en plusieurs subdivisions. C'est ce que l'on appelle souvent « tâche » dans le domaine technique. Voici quelques exemples :

Il existe de nombreuses tâches de ce type, toutes à partir d'un certain Analyser et traiter le langage naturel du côté subdivisé. Cela présente de nombreux avantages. Par exemple, avec ces divisions, vous pouvez examiner les capacités de segmentation d'un système de traitement du langage naturel à partir de différentes dimensions ; vous pouvez également concevoir un système ou un modèle spécifiquement pour un certain élément segmenté. D’un point de vue technique, diviser une tâche complexe (compréhension et utilisation du langage naturel) en plusieurs tâches simples (diverses tâches de PNL) est en effet une manière typique de résoudre des problèmes complexes. C’est également une pratique courante. Cependant, après l’émergence de ChatGPT, avec le recul, cette scission n’est peut-être pas le moyen le plus efficace pour permettre aux ordinateurs de comprendre et d’utiliser le langage naturel.

Car d’excellentes performances sur une seule tâche ne signifie pas que le système maîtrise le langage naturel. Le « sens de l'intelligence » de l'humain à l'égard de l'intelligence artificielle repose sur sa capacité globale à lui appliquer le langage naturel, ce qui se reflète clairement dans ChatGPT. Bien qu'OpenAI n'ait pas ouvert le service API de ChatGPT et que le monde extérieur n'ait pas été en mesure d'évaluer ses effets spécifiques sur diverses tâches PNL subdivisées, des tests externes antérieurs de son prédécesseur GPT-3, InstructGPT et d'autres modèles ont montré que pour certaines tâches spécifiques. Pour les tâches, un petit modèle affiné avec des données spécialisées peut en effet obtenir de meilleurs résultats (pour une analyse détaillée, veuillez vous référer à « Compréhension approfondie de la capacité émergente des modèles linguistiques »). Mais ces petits modèles qui fonctionnent mieux sur une seule tâche ne provoquent pas d’effet hors du cercle important. En fin de compte, c'est parce qu'ils n'ont qu'une seule capacité. Une seule capacité exceptionnelle ne signifie pas qu’ils ont la capacité de comprendre et d’utiliser le langage naturel et ne peuvent donc pas jouer seuls un rôle dans des scénarios d’application réels. Pour cette raison, généralement dans un scénario d'application réel, plusieurs modules dotés de capacités ponctuelles sont artificiellement conçus et assemblés. Cette manière artificielle de patchwork rend les anciens systèmes d'intelligence artificielle inintelligents.

Du point de vue des êtres humains comprenant et utilisant le langage naturel, ce phénomène est en fait facile à comprendre. Lorsque les gens ordinaires comprennent et utilisent le langage naturel, ils ne le divisent pas en plusieurs étapes différentes dans leur esprit, n'analysent pas chaque tâche une par une, puis ne la résument pas. Ce n'est pas ainsi que les humains utilisent le langage naturel. Tout comme lorsqu'une personne entend une phrase, elle n'analyse pas sa structure syntaxique, son contenu et sa relation, sa tendance émotionnelle, etc. un par un, puis reconstitue le sens de la phrase. Le processus de compréhension du langage par les gens est. un processus holistique. De plus, la compréhension globale de cette phrase par les gens sera pleinement exprimée sous forme de langage naturel à travers les réponses. Ce processus n'est pas comme un système d'intelligence artificielle, qui divise une seule tâche, puis génère des étiquettes d'analyse des sentiments, des fragments d'informations sur l'entité ou les résultats d'une autre tâche unique, un par un, puis utilise ces éléments pour reconstituer une réponse.

EtReprésenté par ChatGPT, ce que font les modèles de la série GPT est vraiment proche de la capacité humaine à comprendre et à utiliser le langage - recevoir directement le langage naturel, puis répondre directement au langage naturel et assurer la maîtrise de la langue. Et de la logique . C'est un moyen pour les gens de communiquer, donc tout le monde le considère comme une expérience « très intelligente ». Peut-être que beaucoup de gens penseront que ce serait formidable si cela pouvait être fait comme ChatGPT. Dans le passé, la répartition des tâches était un dernier recours en raison de limitations techniques. Du point de vue de l’application technique, une telle approche détournée est bien entendu nécessaire. Cette méthode est adoptée depuis longtemps et peut en effet résoudre de nombreux problèmes dans des scénarios pratiques. Mais si vous regardez le processus de développement des modèles de la série GPT, vous constaterez qu'OpenAI a « parié » sur une autre voie, et ils ont « parié » et ont gagné.

La première génération de GPT, là où tout a commencé

Dès 2018, OpenAI a publié la version initiale du modèle GPT. D'après l'article public d'OpenAI (Improving Language Understanding by Generative Pre-Training), nous pouvons apprendre que ce modèle utilise une structure Transformer Decoder à 12 couches et prend environ 5 Go. de données textuelles non supervisées pour les tâches de formation du modèle de langage. Bien que le modèle GPT de première génération utilise déjà le pré-entraînement génératif (qui est aussi à l'origine du nom de GPT, Generative Pre-Training, c'est-à-dire pré-entraînement génératif), il utilise le paradigme du pré-entraînement non supervisé. + mise au point des tâches en aval . Ce paradigme n'est en fait pas une invention nouvelle. Il a été largement utilisé dans le domaine de la CV (vision par ordinateur). Cependant, en raison des performances exceptionnelles du modèle ELMo cette année-là, il a été réintroduit dans le domaine de la PNL.

L'émergence du modèle GPT a attiré une certaine attention dans l'industrie cette année-là, mais ce n'était pas le protagoniste C cette année-là. Car la même année, le modèle BERT de Google est sorti, attirant presque toute l'attention avec ses excellents résultats (cette scène est un peu comme l'actuel ChatGPT, je ne peux m'empêcher de soupirer que les « griefs » entre Google et OpenAI sont vraiment réincarnation).

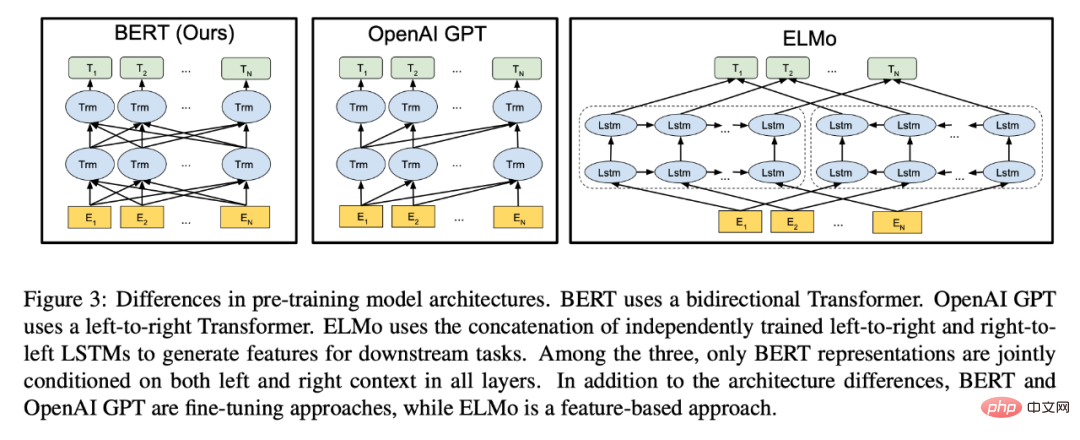

L'image provient de l'article BERT. D'après l'illustration, vous pouvez voir que BERT a été comparé à GPT et a fièrement souligné la capacité d'encodage bidirectionnel.

Bien que le modèle BERT utilise également la même structure de modèle Transformer que GPT, il s'agit presque d'un modèle adapté au paradigme de « pré-formation non supervisée + réglage fin des tâches en aval ». Par rapport à GPT, bien que le modèle de langage masqué utilisé par BERT perde la capacité de générer directement du texte, il acquiert la capacité d'encodage bidirectionnel, ce qui donne au modèle un encodage de texte plus fort. Les performances se reflètent directement dans l'amélioration substantielle des effets des tâches en aval. Afin de conserver la possibilité de générer du texte, GPT ne peut utiliser qu'un codage unidirectionnel.Du point de vue de cette année-là, BERT est définitivement un meilleur modèle. Étant donné que BERT et GPT adoptent tous deux le paradigme « pré-formation + réglage fin » et que les tâches en aval sont toujours des formes de tâches « classiques » de PNL telles que la classification, l'appariement, l'étiquetage de séquences, etc., le modèle BERT accorde plus d'attention à codage des fonctionnalités Pour les tâches en aval, le choix d'une fonction de perte appropriée pour correspondre à la tâche à affiner est évidemment plus direct que GPT, qui utilise la génération de texte pour « contourner » l'exécution de ces tâches.

Après la sortie du modèle BERT, le paradigme de « formation non supervisée + réglage fin des tâches en aval » a établi sa domination. Diverses méthodes ont suivi les idées de BERT et ont réfléchi à « comment obtenir un meilleur encodage des fonctionnalités de texte ». Il y en a tellement que GPT. , un modèle ciblant les tâches génératives, apparaît comme un « extraterrestre ». Avec le recul, si OpenAI avait « suivi la tendance » et abandonné la voie de la pré-formation générative, nous aurions peut-être dû attendre plus longtemps pour voir des modèles comme ChatGPT.

L'espoir apporté par GPT-2

Bien sûr, nous avons maintenant vu ChatGPT, donc OpenAI n'a pas abandonné la voie de la pré-formation générative. En fait, la « récompense » de la persévérance se profilait au cours de la deuxième année, c’est-à-dire en 2019. OpenAI a publié le modèle GPT-2 avec une structure Transformer à 48 couches. Dans l'article publié (Language Models are Unsupervised Multitask Learners), ils ont découvert que grâce à des données non supervisées et à une formation générative, GPT démontrait des capacités multitâches sans tir. Ce qui est étonnant, c’est que ces capacités multitâches ne sont pas ajoutées explicitement ou artificiellement aux données d’entraînement. Pour donner un exemple en termes simples, l'une des capacités démontrées par GPT-2 est la traduction, mais étonnamment, les modèles habituellement utilisés spécifiquement pour la traduction nécessitent une grande quantité de corpus parallèles (c'est-à-dire entre deux langues différentes). formation, mais GPT-2 n'utilise pas ce type de données, mais effectue uniquement une formation générative sur une grande quantité de corpus, et peut ensuite être traduit « soudainement ». Cette découverte est plus ou moins subversive. Elle montre aux gens trois phénomènes importants :Bien que du point de vue d'aujourd'hui, les différentes capacités démontrées par GPT-2 à cette époque étaient encore relativement rudimentaires et que les résultats étaient encore significativement différents de certains autres modèles affinés à l'aide de données supervisées, cela n'a pas été le cas d'OpenAI. est plein d'attentes quant aux capacités potentielles qu'il contient, à tel point que dans la dernière phrase du résumé de l'article, ils mettent en avant leurs attentes pour l'avenir de la série de modèles GPT : « Ces résultats suggèrent un avenir prometteur. chemin vers la construction de systèmes de traitement du langage qui apprennent à effectuer des tâches à partir de leurs démonstrations naturelles. Si en 2018, lors de la sortie du modèle GPT de première génération, la pré-formation générative de GPT risquait encore d'être écrasée sous tous ses aspects par des modèles de pré-formation tels que BERT dans le but d'« extraire des fonctionnalités », alors dans GPT-2, il Il a été constaté que la pré-formation générative offre un avantage potentiel qui ne peut être remplacé par les modèles de type BERT, à savoir la capacité multitâche apportée par la tâche de modèle de langage, et cette capacité multitâche ne nécessite pas d'étiquetage de données. Bien sûr, à cette époque, la voie de la technologie générative est encore confrontée à des risques et à des défis. Après tout, les performances de GPT-2 à cette époque sur diverses tâches étaient encore pires que celles du modèle affiné. Cela faisait que, même si GPT-2 disposait de capacités de traduction, de résumé, etc., l'effet était trop médiocre pour être réellement efficace. utilisé. Par conséquent, si vous souhaitez un modèle de traduction utilisable à ce moment-là, la meilleure option reste d'utiliser les données annotées pour entraîner un modèle spécifiquement pour la traduction. GPT-3, le début du volant de données En regardant en arrière depuis l'ère ChatGPT, peut-être que la découverte d'OpenAI dans GPT-2 a vraiment renforcé leur confiance dans les modèles de la série GPT et a décidé d'augmenter la recherche et le développement Faites des efforts. Parce qu'en 2020, ils ont publié GPT-3 avec 175 milliards de paramètres, un modèle étonnamment vaste même du point de vue actuel. Bien qu'OpenAI n'ait pas divulgué le coût de formation de ce modèle, tout le monde estimait à l'époque qu'il coûtait 12 millions de dollars. Un article de plus de 60 pages (Language Models are Few-Shot Learners) est également publié, qui détaille les nouvelles capacités démontrées par ce nouveau géant. La découverte la plus importante est ce qui est indiqué dans le titre de l'article, à savoir que le modèle de langage a la capacité d'apprendre avec de petits échantillons (quelques plans). L'apprentissage par petits échantillons est un terme professionnel dans le domaine de l'apprentissage automatique, mais il a un concept très simple, à savoir : « les êtres humains peuvent apprendre une nouvelle tâche linguistique à travers un petit nombre d'exemples ». Imaginez que vous appreniez dans un cours de chinois comment remplacer le mot « mettre » par le mot « être » (les vêtements ont été mouillés par la pluie - les vêtements ont été mouillés par la pluie). L'enseignant donnera quelques exemples et les élèves le feront). Être capable de maîtriser cette capacité. Mais pour les modèles d'apprentissage profond, il faut généralement apprendre (entraîner) des milliers d'exemples pour maîtriser une nouvelle capacité, mais tout le monde a trouvé que GPT-3 a des capacités similaires à celles des humains. Et le point clé est qu'il vous suffit de lui montrer quelques exemples, et il "imitera" les tâches données par les exemples sans nécessiter de formation supplémentaire (c'est-à-dire sans avoir besoin d'une rétropropagation de gradient et d'une mise à jour des paramètres de formation conventionnelle). Des recherches ultérieures ont montré que cette capacité est propre aux modèles géants et est appelée « apprentissage en contexte » dans l'industrie.

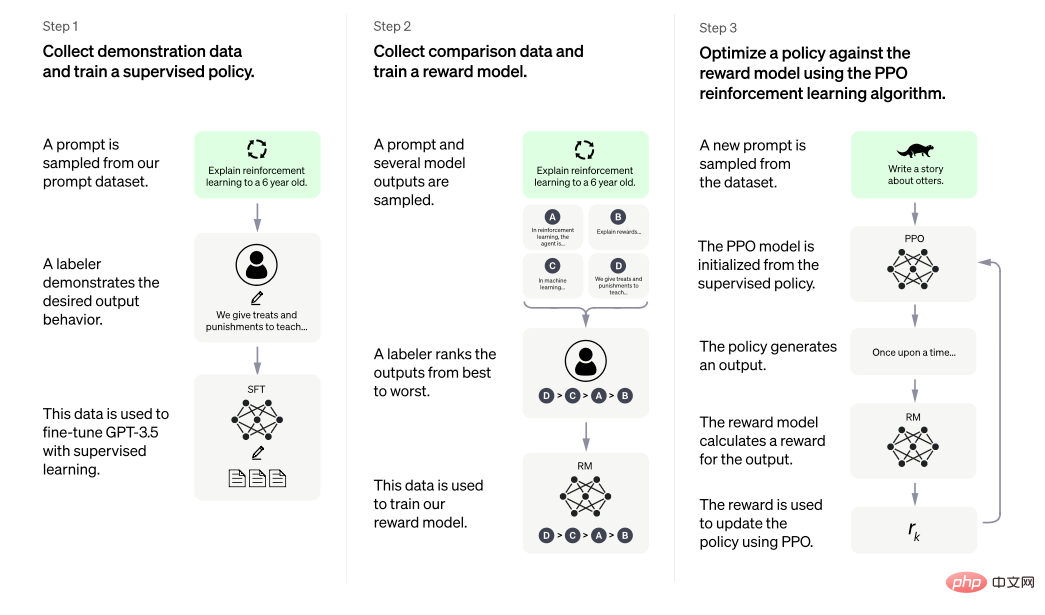

La capacité d'apprentissage en contexte de l'anglais vers le français démontrée dans l'article GPT-3. En fait, la capacité d'apprendre avec de petits échantillons n'est pas une découverte étonnante en soi. Après tout, l'industrie a mené des recherches sur l'apprentissage sur petits échantillons, et de nombreux modèles spécialisés dans l'apprentissage sur petits échantillons ont d'excellentes capacités d'apprentissage sur petits échantillons. Cependant, la capacité « d'apprentissage en contexte » sur un petit échantillon démontrée par GPT-3 est très inattendue. La raison est la même que la capacité multitâche démontrée par GPT-2 : Mais avec l'ouverture de ce service de modèle, de plus en plus de personnes tentent d'utiliser ce modèle. Depuis lors, OpenAI collecte également des données plus diverses en les ouvrant au public (le contenu saisi par les utilisateurs peut être utilisé pour la formation du modèle, qui est écrit dans les termes de l'utilisateur), ces données jouent également un rôle important dans les itérations ultérieures du modèle. . . Différent de ChatGPT, GTP-3 n'est pas un modèle d'interaction conversationnelle, mais un modèle de continuation de texte (c'est-à-dire écrire après le texte que vous saisissez), il n'a donc pas la capacité de conversation à plusieurs tours que ChatGPT d'aujourd'hui a. Mais il peut déjà faire beaucoup de choses, comme écrire des histoires, compléter automatiquement des emails, etc. Mais en même temps, tout le monde a progressivement découvert certains problèmes. Par exemple, cela produira du contenu qui ne correspond pas aux faits, et cela produira des remarques nuisibles, etc. C'est l'inconvénient le plus important de ce modèle de génération de texte. Bien qu'il ait connu de nombreuses itérations, ChatGPT est toujours confronté à des problèmes similaires aujourd'hui. CodeX, laisse l'ordinateur écrire son propre code OpenAI a également fait une découverte inattendue lors de ses recherches sur GPT-3, il peut générer du code très simple basé sur quelques commentaires. Par conséquent, en 2021, ils ont consacré des investissements de recherche dédiés à la génération de code et ont publié le modèle CodeX. . D'un point de vue externe, on ne peut pas dire si la recherche sur la génération de code et le développement des modèles de la série GPT sont menés en même temps. Mais à cette époque, il était effectivement plus significatif d’un point de vue pratique de donner au modèle la capacité de générer du code. Après tout, GPT-3 ne disposait pas encore des puissantes capacités de ChatGPT aujourd’hui. D’un autre côté, laisser le modèle générer du code évite également le risque qu’il génère du contenu textuel nuisible. Plusieurs points clés ont été mentionnés dans l'article CodeX. Le premier est que l'entraînement du modèle GPT pré-entraîné sur des données texte sur des données de code spécialisées (les données proviennent du code open source de github, un total de 159G) peut en effet considérablement. améliorer la précision du modèle et les capacités de sortie. Deuxièmement, le document utilise un « petit » modèle avec 12 milliards de paramètres. Ces informations reflètent le fait qu'en plus du modèle GPT-3 de 175 milliards de paramètres avec une interface ouverte, il existe d'autres versions de modèles de différentes tailles au sein d'OpenAI. L'intention initiale de l'ajout d'une formation au code pour permettre au modèle de comprendre et de générer des décisions de code est peut-être simplement d'avoir un scénario d'application supplémentaire pour GPT. Cela ne semble pas avoir beaucoup de lien avec la capacité des modèles de la série GPT à comprendre et à utiliser le langage naturel, mais selon des recherches ultérieures (pour une analyse détaillée, veuillez vous référer à l'article "Le démontage retrace l'origine de divers capacités de GPT-3.5 》), l’augmentation de la formation sur les données de code est susceptible de déclencher la capacité du dernier modèle GPT à effectuer des raisonnements et des chaînes de réflexion complexes en langage naturel. Peut-être qu'OpenAI ne s'attendait pas à un tel résultat lorsqu'ils ont commencé à travailler sur CodeX, mais c'est comme s'ils utilisaient des tâches de génération de texte pour créer des modèles GPT, puis les "déverrouillaient" dans GPT-2 et GPT-3. "La capacité d'effectuer plusieurs tâches à la fois" et "la capacité d'apprendre en contexte", l'introduction des données de code leur a une fois de plus apporté des gains inattendus. Même si cela semble un peu accidentel, une compréhension prospective du parcours technique, associée à la persévérance et à un investissement continu, est évidemment un facteur crucial. InstructGPT, laissez GPT parler de lui-même Nous avons mentionné plus tôt que bien que GPT-3 ait déjà de fortes capacités, alors que de plus en plus de personnes l'utilisent après sa mise en ligne, de nombreux problèmes ont été découverts, le plus les plus sérieux devraient « dire des bêtises sérieusement » et « publier du contenu préjudiciable ». Alors qu'OpenAI semble se concentrer temporairement sur la compréhension et la génération de code par les modèles en 2021, ils auraient dû essayer de résoudre ces problèmes avec GPT-3. Début 2022, OpenAI a publié l'article InstructGPT (Training Language Models to Follow Instructions with Human Feedback), à partir duquel nous pouvons avoir un aperçu de la façon de résoudre ces problèmes. L'idée centrale de l'article est de permettre au modèle d'accepter l'enseignement humain (feedback), ce qui est clairement indiqué dans le titre. La raison pour laquelle GPT-3 a des problèmes tels que « dire sérieusement des bêtises » et « produire du contenu nuisible » vient des données d'entraînement qu'il utilise. Un géant comme GPT-3 nécessite d’énormes quantités de données. Nous pouvons trouver ses sources de données dans les articles GPT-3, qui peuvent être grossièrement divisés en trois catégories : le contenu Web, le contenu encyclopédique et les livres. Bien que la quantité de contenu Web soit très importante, elle est également très « sale, désordonnée et pauvre » et contient naturellement beaucoup de contenu faux et nuisible. GPT-3 s'entraîne sur ces données et apprend naturellement ces choses. Mais en tant que produit fournissant des services au monde extérieur, GPT-3 devrait être plus prudent dans ses réponses. Pour résoudre ce problème, une des difficultés réside dans la manière de définir comment le modèle doit parler. Parce que le contenu de sortie du modèle génératif est le langage naturel lui-même, plutôt qu'un contenu clair et objectif, bon ou mauvais, tel qu'une étiquette de classification ou un nom d'entité. Il n’y a pas de bien ou de mal clair, ce qui rend impossible la conception de tâches de formation directement en fonction de l’objectif, comme la formation de modèles PNL classiques. La solution donnée par InstructGPT est très directe. Puisqu'il existe de nombreux facteurs d'influence différents pour l'indice d'évaluation de la « bonne réponse », et que ces facteurs sont étroitement liés les uns aux autres, laissez quelqu'un lui apprendre à rédiger la réponse. Parce que les humains sont meilleurs pour gérer ce genre de problème avec « à la fois des exigences claires et une portée vague », laissez de vraies personnes écrire des « excellents exemples » et laissez le modèle apprendre ces « excellents exemples ». C'est exactement ce que InstructGPT a proposé Idée générale. Plus précisément, InstructGPT propose un parcours en deux étapes pour permettre à GPT d'apprendre "d'excellents exemples" donnés par des humains. La première étape est un apprentissage supervisé et la deuxième étape est un apprentissage par renforcement. Dans la première étape (correspondant à l'étape 1 la plus à gauche dans la figure ci-dessous), laissez la personne réelle suivre différentes invites (en gros, cela peut être considéré comme le texte que nous saisissons dans la boîte de dialogue lors de l'utilisation de ChatGPT. Dans l'industrie, cette chose s'appelle une commande) Écrivez des réponses qui sont véridiques, inoffensives et utiles. Dans le processus opérationnel réel, afin de garantir la qualité de ce contenu, certaines directives normatives seront données aux annotateurs qui rédigent les réponses, puis le modèle GPT pré-entraîné continuera à être formé sur ces données éditées par l'homme. Cette étape peut être considérée comme une sorte de « discipline » pour le modèle. Pour utiliser une analogie vague, c'est comme si un professeur de chinois vous demandait d'écrire d'excellents essais en silence.

L'image provient de l'article InstructGPT, qui propose de rendre le résultat du modèle raisonnable grâce à un réglage fin de l'instruction supervisée + un apprentissage par renforcement avec retour humain.

La deuxième étape est l'apprentissage par renforcement, qui est techniquement divisé en deux étapes. La première étape (correspondant à l'étape 2 au milieu de l'image ci-dessus) consiste à laisser le modèle « entraîné » générer plusieurs réponses différentes basées sur différentes invites, et à demander aux humains de trier ces réponses selon de bonnes ou de mauvaises normes. Utilisez ensuite ces données étiquetées pour entraîner un modèle de notation afin qu'il puisse automatiquement trier et noter davantage de données. La deuxième étape de l'étape d'apprentissage par renforcement (correspondant à l'étape 3 à droite dans la figure ci-dessus) consiste à utiliser ce modèle de notation comme retour environnemental dans l'apprentissage par renforcement, et à utiliser le gradient politique (Policy Gradient, pour être précis, l'algorithme PPO). ) à Le modèle GPT formé est formé. L'ensemble du processus de la deuxième étape peut être considéré comme un « renforcement » du modèle. Pour utiliser une analogie vague, c'est comme si un professeur de chinois vous donnait des notes pour vos dissertations et vous demandait de distinguer à partir des notes ce qui est bon et ce qui est bon. . Pas bon, et puis continuez à vous améliorer.

Par conséquent, Pour le dire d'une manière très vague, mais que les gens ordinaires peuvent comprendre, InstructGPT permet d'abord à un GPT "discret" de l'apprendre en "dictant d'excellents exemples humains" "Parlez bien", puis "donnez-lui une note sur ce qu'il écrit seul, laissez-le revenir en arrière et le comprendre, et continuer à progresser". Bien sûr, les choses seront plus techniques, comme les questions de données telles que les spécifications spécifiques et la quantité d'"excellents essais", ainsi que les questions algorithmiques telles que la sélection de modèles de notation dans l'apprentissage par renforcement et la définition des paramètres de l'algorithme, qui tout cela affectera le résultat final et aura un impact. Mais les résultats finaux montrent que cette méthode est très efficace. L'article souligne également qu'un petit modèle de 1,3 milliard formé par la méthode ci-dessus peut surpasser un modèle plus grand qui n'a pas été formé de cette manière.

De plus, certains contenus du journal méritent d'être mentionnés. Tout d’abord, quelques conclusions sur Prompt. L'invite utilisée lors de la formation InstructGPT est principalement composée de deux parties. Une partie est écrite par un formateur spécialisé en IA, et l'autre partie provient du contenu rédigé par les utilisateurs lors du service en ligne du modèle OpenAI. le volant de données est reflété. On peut constater que quel que soit le type d'invites, ces invites sont écrites par de vraies personnes. Bien que l'article ne procède pas à une analyse détaillée de la couverture spécifique, de la distribution et des méthodes de questionnement de ces invites, on peut raisonnablement deviner que. ces invites ont certaines caractéristiques et une grande qualité. En fait, l'article compare le modèle formé à l'aide de ces invites écrites par de vraies personnes et le modèle formé à l'aide d'invites intégrées à certains ensembles de données de tâches PNL open source (tels que l'ensemble de données T0, l'ensemble de données FLAN). La conclusion est que le modèle est entraîné. par de vraies personnes écrivant des invites, les réponses données sont plus acceptables pour les évaluateurs.

Un autre point concerne la capacité de généralisation du modèle formé au nouveau Prompt. Il est concevable que si le modèle formé ne peut pas produire la capacité de généralisation de Prompt, alors les performances actuelles de ChatGPT, la capacité de répondre à presque toutes les questions est. peu probable. Car dans la phase de mise au point du modèle, quelle que soit la quantité de données disponibles, il est impossible de couvrir complètement tout le contenu que les gens peuvent saisir. L'article InstrctGPT souligne que la méthode utilisée dans l'article peut produire la capacité de généralisation de Prompt.

La raison pour laquelle j'ai passé plus de mots à présenter InstructGPT est que, selon l'introduction sur la page officielle de ChatGPT, les méthodes d'InstructGPT sont exactement les méthodes utilisées pour entraîner ChatGPT. La différence est que ChatGPT utilise une méthode d'organisation des données conversationnelles. .

L'ère GPT-3.5 et la naissance de ChatGPT

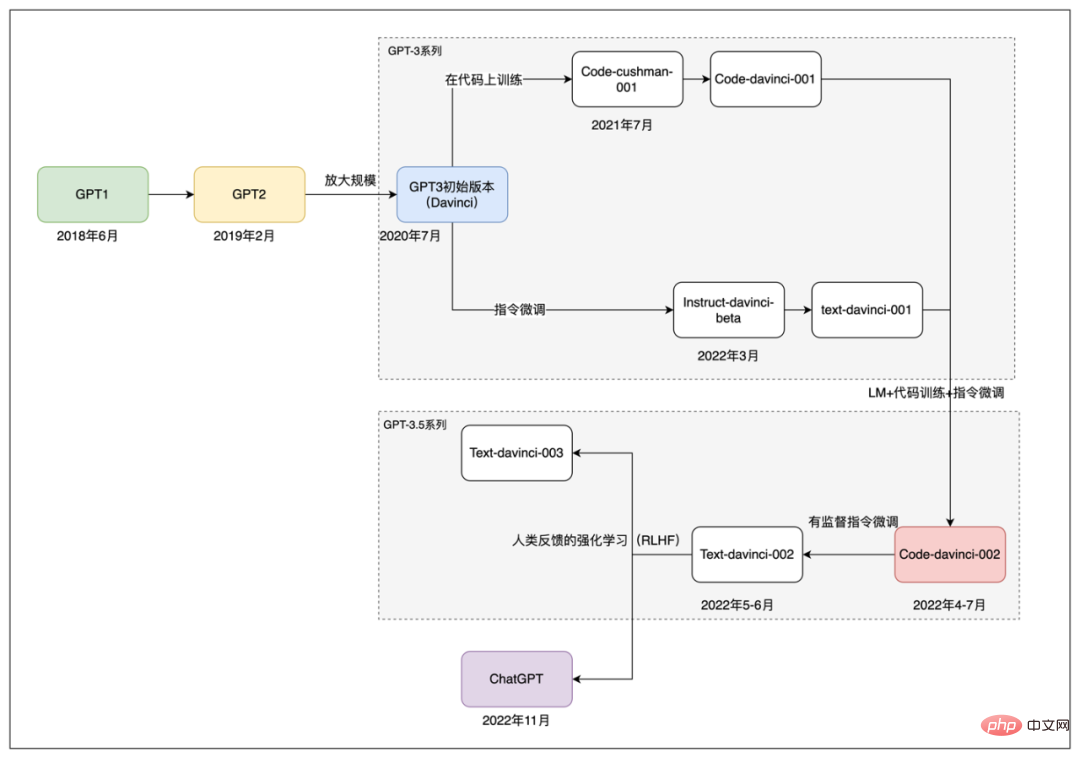

Par la suite, OpenAI a publié plusieurs modèles appelés série GPT-3.5, bien que ces modèles n'aient pas été suivis d'articles connexes, selon cet article Selon l'analyse, le . La série GPT-3.5 devrait être développée en intégrant la technologie, les données et l'expérience accumulées par OpenAI à l'ère GPT-3. Puisqu’il n’existe pas de référence officielle détaillée en matière d’informations publiques, le monde extérieur spécule principalement sur les informations spécifiques de ces modèles en analysant l’expérience d’utilisation, les documents techniques associés et l’introduction de la documentation de l’API d’OpenAI.

Selon l'analyse, les modèles de la série GPT-3.5 n'ont peut-être pas été peaufinés sur GPT-3, mais ont peut-être été fusionnés avec du code et des données en langage naturel pour recycler une base à partir de zéro. Ce modèle, qui pourrait être plus grand que les 175 milliards de paramètres de GPT-3, est nommé codex-davinci-002 dans l’API d’OpenAI. Ensuite, sur la base de ce modèle de base, une série de modèles ultérieurs ont été obtenus grâce à un réglage fin des instructions et à des commentaires humains, notamment ChatGPT.

Le chemin de développement des modèles de la série GPT.

En bref, à partir du modèle code-davince-002, text-davinci-002 est obtenu grâce à un réglage fin des instructions supervisées. Et les text-davinci-003 et ChatGPT ultérieurs ont également été obtenus grâce à un réglage fin des instructions et à un retour d'apprentissage par renforcement humain sur un modèle de la série GPT-3.5. Et text-davinci-003 et ChatGPT ont tous deux été publiés en novembre 2022. La différence est que text-davinci-003, comme GPT-3, est un modèle de complétion de texte. Selon l'introduction officielle de ChatGPT, il est formé en traitant les données passées sous forme d'interaction conversationnelle et en ajoutant de nouvelles données conversationnelles.

Jusqu'à présent, nous avons examiné grossièrement le processus de développement et d'itération des modèles de la série OpenAI GPT, du GPT original en 2018 au ChatGPT actuel. Dans ce processus, OpenAI a toujours maintenu son « entêtement » dans le chemin technique des modèles génératifs de pré-formation, et a également absorbé de nouvelles méthodes issues de l'évolution de la technologie PNL, de la structure originale du modèle Transformer, plus tard, avec L'émergence de technologies telles que le réglage fin des commandes (Prompt tuning), ces facteurs ont contribué conjointement au succès de ChatGPT aujourd'hui. Avec une compréhension du développement des modèles de la série GPT, nous pouvons revenir en arrière et examiner le ChatGPT d'aujourd'hui.

Dans le premier chapitre, nous avons expliqué que la principale raison pour laquelle ChatGPT est hors du cercle est : « Il utilise un langage naturel fluide et logique pour réagir au langage naturel saisi par les humains. ." , apportant ainsi un fort "sentiment d'intelligence" à ceux qui communiquent avec lui. Dans le chapitre 2, nous découvrirons le chemin du succès de ChatGPT en passant en revue l'historique de développement des modèles de la série GPT. Ce chapitre tentera d'approfondir un peu le contenu technique d'une manière aussi compréhensible que possible pour les étrangers, et d'explorer pourquoi certains des modèles actuels de génération de texte à grande échelle ne parviennent pas à obtenir le même effet. Les principales références pour cette partie proviennent des deux articles « Compréhension approfondie des capacités émergentes des modèles de langage » et « Démantèlement et traçage des origines des capacités GPT-3.5 » ainsi que de certains articles connexes. Elle est recommandée à ceux qui le souhaitent. veulent en savoir plus sur les détails. Les lecteurs lisent le texte original.

Bien qu'il ait été souligné dans le premier chapitre que les effets étonnants apportés par ChatGPT se reflètent de manière exhaustive dans de nombreuses tâches différentes de PNL, en analysant la technologie qui la sous-tend, il est encore possible de démonter ses capacités un peu plus clairement. Dans l'ensemble, les capacités incarnées par ChatGPT peuvent être grossièrement divisées dans les dimensions suivantes :

- Capacités de génération de texte : Toutes les sorties de ChatGPT sont des textes générés, les capacités de génération de texte sont donc ses exigences de base les plus importantes.

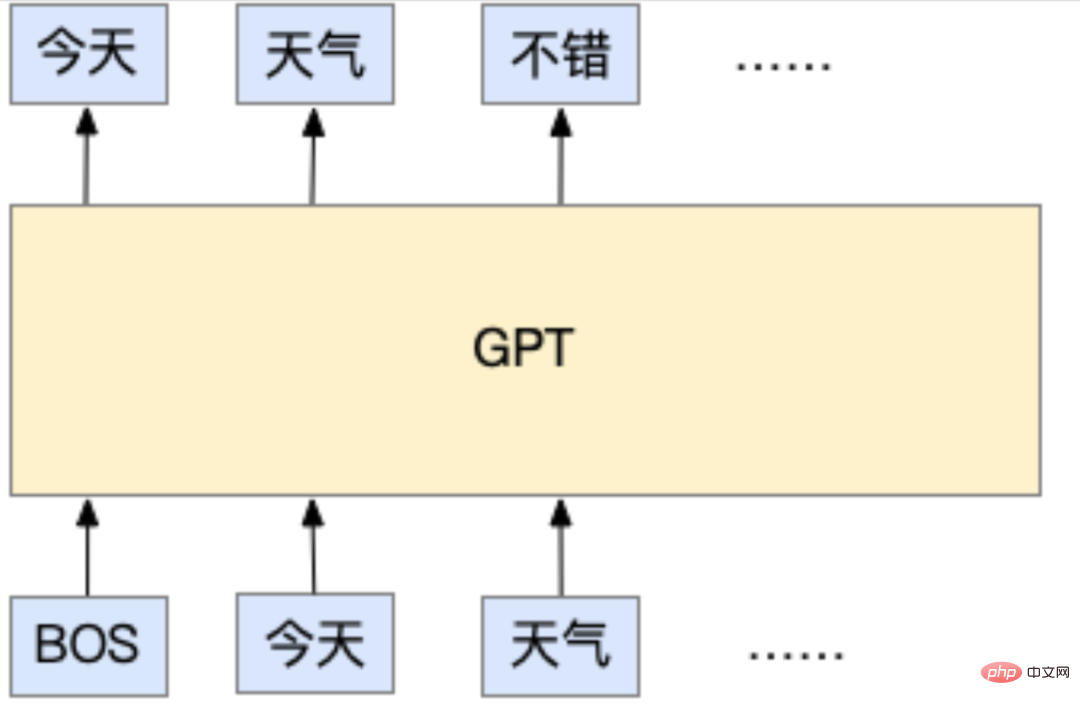

Cette capacité vient en fait de sa méthode de formation. Lorsque ChatGPT est pré-entraîné, il s'agit d'une tâche de modèle de langage autorégressif standard, qui constitue la base de tous les modèles de la série OpenAI GPT. La tâche dite de modèle de langage autorégressif, selon l'interprétation populaire, est la suivante : elle peut prédire quel devrait être le prochain jeton en fonction du texte qui a été saisi. Le token mentionné ici représente la plus petite unité de fragments de caractères utilisée par le modèle. Il peut s'agir d'un caractère (il est très courant d'utiliser des caractères en chinois) ou d'un mot (chaque mot en anglais est naturellement séparé par des espaces, donc). des mots sont souvent utilisés), voire des lettres. Mais les méthodes actuelles utilisent généralement des sous-mots (sous-mots, entre lettres et mots, le but principal étant de réduire le nombre de mots). Mais quel que soit celui-ci, l'idée de base de la tâche de modèle de langage autorégressif est de prédire le prochain texte à afficher en fonction du texte qui a été saisi, comme dans l'exemple ci-dessous :

Dans cet exemple, BOS représente le début de l'entrée, et chaque jeton est un mot. Le modèle GPT prédit que la prochaine sortie est « bonne » en fonction des mots d'entrée « aujourd'hui » et « météo ».

Pendant la formation, de nombreuses données textuelles seront préparées, telles que des articles sur des pages Web, divers livres, etc. Tant qu'il s'agit d'un contenu textuel normal, il peut être utilisé pour la formation. Il convient de mentionner que ce type de données ne nécessite pas d'annotation manuelle supplémentaire, car ce type de données est initialement écrit par des personnes. Ce que le modèle doit faire, c'est apprendre « à partir du texte précédent, sur la base du texte écrit par ces personnes. , Puis la question « Quelle devrait être cette place derrière ces mots ? C'est ce que l'industrie appelle « la formation non supervisée ». En fait, le modèle n'est pas vraiment non supervisé (sinon, qu'apprendrait le modèle ?), mais ses données ne nécessitent pas d'annotation manuelle supplémentaire. Précisément parce que cette tâche ne nécessite pas d'annotation supplémentaire, une grande quantité de données peut être obtenue « gratuitement ». Grâce à la popularité d'Internet, une grande quantité de contenu textuel écrit par de vraies personnes peut être « facilement » obtenue pour la formation. C'est également l'une des caractéristiques de la série de modèles GPT. Des quantités massives de données sont utilisées pour former de grands modèles.

Alors quand on utilise ChatGPT, comment ça marche ? En fait, c'est la même chose que sa méthode de formation. Le modèle prédira le prochain jeton suivant le contenu en fonction du contenu que nous saisissons dans la boîte de dialogue. Après avoir obtenu ce jeton, il sera fusionné avec le contenu précédent dans un. nouveau. Le texte est donné au modèle, et le modèle prédit le prochain jeton, et ainsi de suite, jusqu'à ce qu'une certaine condition soit remplie et s'arrête. Il existe de nombreuses façons différentes de concevoir cette condition d'arrêt. Par exemple, il se peut que le texte de sortie atteigne une longueur spécifique ou que le modèle prévoie un jeton spécial utilisé pour représenter l'arrêt. Il convient également de mentionner que lorsque le modèle prédit le prochain jeton, il s'agit en fait d'un processus d'échantillonnage en coulisse. En d’autres termes, lorsque le modèle prédit un jeton, il génère en fait la probabilité de tous les jetons possibles, puis échantillonne un jeton à partir de cette distribution de probabilité. Par conséquent, lorsque vous utilisez ChatGPT, vous constaterez que même pour la même entrée, sa sortie sera différente à chaque fois car elle échantillonne secrètement différents jetons en sortie.

Après avoir compris cela, vous pouvez revenir en arrière et réfléchir à ce que le modèle apprend. Est-ce apprendre à répondre aux questions et aux réponses ? Ou s’agit-il d’apprendre à comprendre les informations, la logique et les émotions contenues dans le langage naturel ? Ou est-ce l’apprentissage d’une énorme quantité de connaissances ? À en juger par la conception de la tâche de formation, il semble que cela n'existe pas. Elle apprend uniquement à partir des données textuelles massives « ce qu'un humain écrira ensuite en fonction du texte saisi ». Mais c'est ce genre de modèle qui, lorsqu'il « évolue » vers ChatGPT, a maîtrisé des connaissances riches, un raisonnement logique complexe, etc. Il semble avoir maîtrisé presque toutes les capacités requises par un humain pour utiliser le langage. C'est une chose très magique, et son processus « d'évolution » sera présenté plus en profondeur dans le prochain chapitre.

- Riche réserve de connaissances : ChatGPT peut répondre correctement à de nombreuses questions, notamment l'histoire, la littérature, les mathématiques, la physique, la programmation, etc. Étant donné que la version actuelle de ChatGPT n'utilise pas de connaissances externes, le contenu de ces connaissances est « stocké » dans le modèle.

La riche base de connaissances deChatGPT vient de ses données de formation et de son volume suffisamment important pour apprendre ces contenus. Bien que le responsable n'ait pas divulgué les détails spécifiques des données de formation utilisées par ChatGPT, on peut déduire de l'article de son prédécesseur GPT-3 que les données peuvent être grossièrement divisées en trois grandes catégories : contenu Web, contenu de livre et encyclopédie. contenu. Il est concevable que ces contenus contiennent naturellement une grande quantité de connaissances, sans parler des encyclopédies et des livres, mais le contenu Web contient également beaucoup d'actualités, de commentaires, d'opinions, etc., et les pages Web comprennent également de nombreux sites verticaux spécialisés de questions-réponses. , ce sont les sources de connaissances de ChatGPT. L'introduction officielle souligne que ChatGPT ne peut pas répondre à ce qui s'est passé après 2021, il est donc raisonnable de supposer que la collecte de données de formation se termine en 2021.

Mais la quantité de données n'est qu'un aspect parmi d'autres. Pour que le modèle « maîtrise » ces données, son propre volume ne peut pas être petit. Prenons l'exemple de GPT-3. Il comporte 175 milliards de paramètres. On peut grossièrement comprendre que le contenu de ces données et les différentes capacités du modèle sont fixés dans le modèle entraîné sous la forme de valeurs spécifiques de chaque paramètre. . La compréhension perceptuelle est que si un modèle n'a qu'un seul paramètre, alors il ne peut rien faire. Pour une analyse et une comparaison plus rigoureuses, vous pouvez vous référer à l'évaluation de cet article « Évaluation holistique des modèles linguistiques ». La conclusion directionnelle est que plus le modèle est grand, plus il est performant sur les tâches qui nécessitent des connaissances.

Adresse papier : https://arxiv.org/pdf/2211.09110.pdf

- La capacité de raisonnement logique et de chaîne de pensée : à partir de l'exemple d'un poulet et d'un lapin dans la même cage dans le Dans l'image du premier chapitre, vous pouvez voir que ChatGPT a de fortes capacités de raisonnement logique. Et il peut décomposer un contenu complexe en plusieurs petites étapes, effectuer un raisonnement étape par étape et obtenir la réponse finale. Cette capacité est appelée chaîne de réflexion.

Dès l'introduction précédente, nous savons que le modèle n'est pas spécifiquement conçu pour le raisonnement logique et les chaînes de réflexion lors de l'entraînement. L’opinion dominante actuelle est que le raisonnement logique et les chaînes de réflexion sont susceptibles d’être liés à deux facteurs. Le premier est la taille du modèle et le second est de savoir si le modèle a été formé sur des données de code.

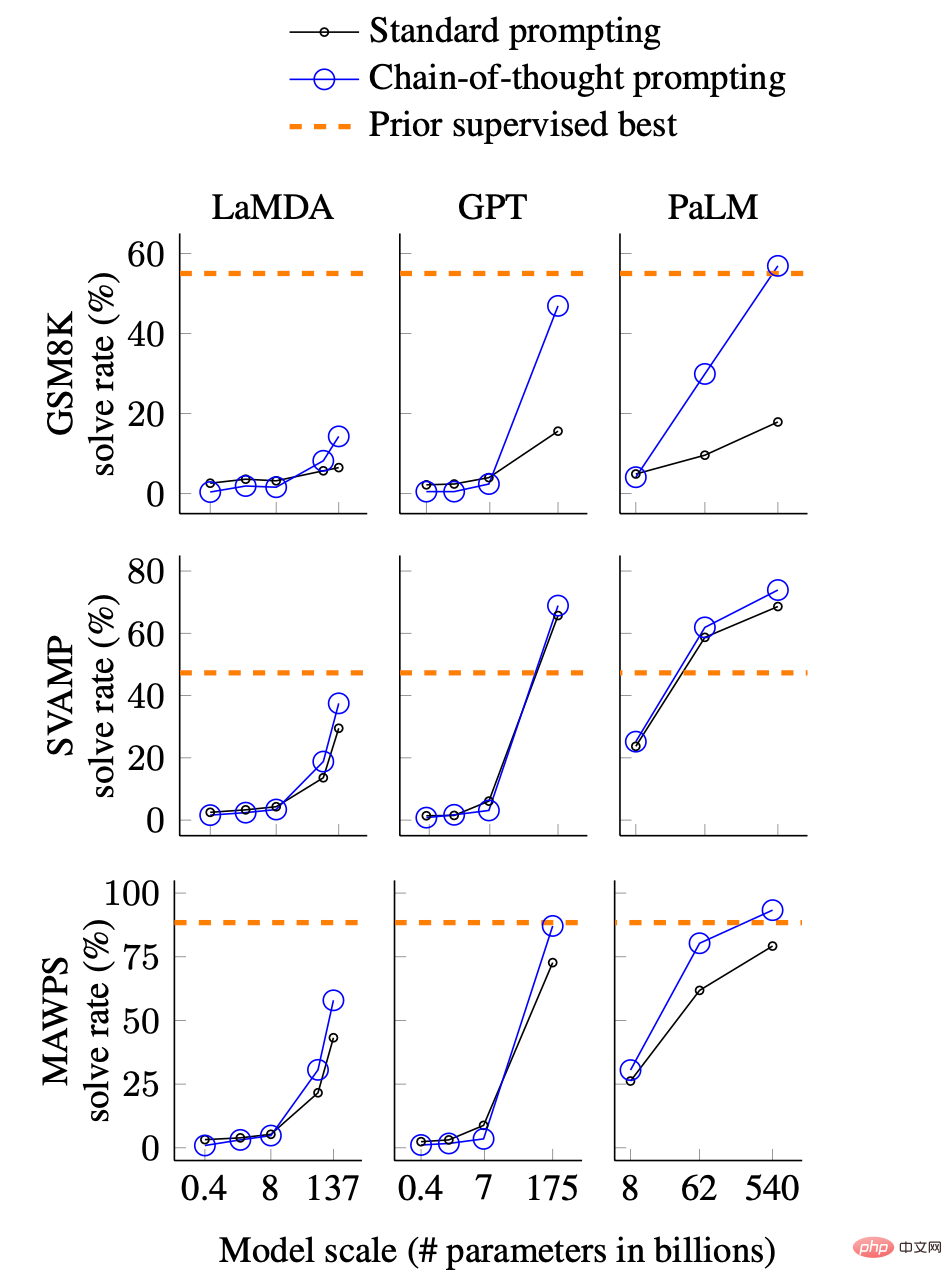

Concernant la relation entre la taille du modèle et les capacités de raisonnement et de chaîne de pensée, il existe une introduction correspondante dans « Compréhension approfondie de la capacité émergente des modèles de langage ». L'image ci-dessous montre la relation entre les capacités de la chaîne de réflexion et la taille du modèle.

Comparaison des effets de chaîne de pensée de différents modèles et de différentes tailles, l'image vient du papier. GSM8K, SVAMP et MAWPS sont trois ensembles de données de problèmes de mots mathématiques qui nécessitent un raisonnement logique, et LaMDA, GPT et PaLM sont respectivement trois modèles différents.

En bref, le graphique montre les taux de réponse correcte de trois modèles différents sur trois ensembles de données de problèmes de mots mathématiques. Ce qui mérite l'attention, ce sont les aspects suivants :

En termes simples, lorsque le modèle est suffisamment grand, la capacité de la chaîne de réflexion apparaît soudainement, qui peut atteindre ou même dépasser les modèles spécialement formés à l'entraînement supervisé sur des ensembles de données d'inférence. Ce chiffre peut expliquer en partie les excellentes capacités de raisonnement et de chaîne de pensée de ChatGPT que nous voyons actuellement.

Un autre facteur concernant les capacités de raisonnement et de chaîne de réflexion est lié au fait que le modèle a été formé sur les données de code. À l'heure actuelle, il ne s'agit que d'une inférence. L'analyse dans « Démantèlement et traçage de l'origine des capacités de GPT-3.5 » montre que les grands modèles de taille similaire ont une chaîne de pensée et un raisonnement très faibles, voire presque inexistants, s'ils n'ont pas été formés. la capacité du code. Et ChatGPT est en effet formé sur les données de code, ce qui se voit également à travers sa capacité à comprendre et à générer du code. Comme mentionné dans l'examen du processus de développement au chapitre 2, OpenAI a publié le modèle CodeX spécifiquement pour le code en 2021. L'ajout de données de code aux données d'entraînement de GPT aurait dû commencer à partir de ce moment-là.

- La capacité de répondre aux questions ou aux instructions des gens : en plus de l'interaction étroite basée sur les « questions et réponses », ChatGPT peut également répondre aux exigences de saisie. Par exemple, il a également démontré d'excellentes capacités en répondant à des demandes directives telles que « Écrivez-moi une lettre ». Cette capacité en fait non seulement un « moteur de recherche avancé » qui fournit des réponses, mais également un outil de traitement de texte capable d'interagir avec le langage naturel.

Bien que le public se concentre actuellement sur ChatGPT en tant qu'outil de type moteur de recherche, accéder à des connaissances pertinentes et donner des réponses n'est pas sa seule capacité. En fait, en ce qui concerne ChatGPT lui-même, répondre aux questions de connaissances n'est pas son point fort. Après tout, ses propres données de formation sont fixées en 2021. Même s'il est formé avec des données mises à jour, il ne peut pas suivre l'évolution de l'actualité. Par conséquent, si vous souhaitez l'utiliser comme outil de questions et réponses de connaissances, vous devez toujours le combiner avec des sources de connaissances externes telles que les moteurs de recherche, tout comme ce que Bing fait maintenant.

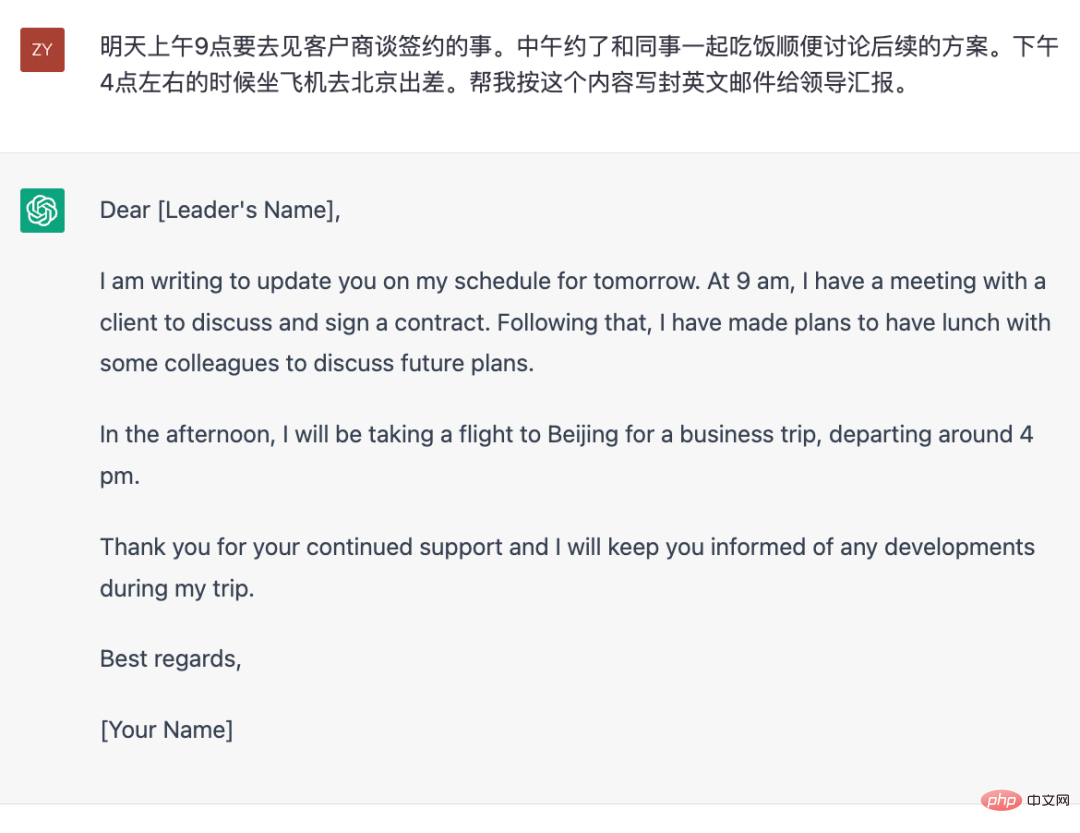

Mais d'un autre point de vue, ChatGPT est comme un outil de texte « linguistique complet », c'est-à-dire qu'il peut compléter le contenu spécifié qui peut être exprimé sous forme de texte selon les exigences que vous lui donnez, comme le suivant Cet exemple .

Générez des e-mails en anglais pour les rapports en fonction du contenu du plan donné.

La « complétude du langage » mentionnée ici fait référence à la capacité d'utiliser le langage. On peut voir que dans l'exemple ci-dessus, aucun contenu intellectuel n'est en fait impliqué, car le contenu dont il a besoin pour écrire lui a déjà été fourni. Mais rédiger cet e-mail implique la capacité d'utiliser le langage, comme choisir des mots et des phrases, changer de langue, de format d'e-mail, etc.

Maintenant, revenons en arrière et essayons d'analyser comment il a obtenu sa capacité à « accomplir des tâches selon les instructions ». Dans le monde universitaire, ce type d'instruction est appelé invite. En fait, les entrées des utilisateurs dans les conversations et les questions dans les questions-réponses sont également des invites. Par conséquent, on peut grossièrement comprendre que tout ce qui est saisi dans la boîte de discussion est rapide. Si vous comprenez ce que nous avons présenté au modèle de langage dans la première section de ce chapitre, alors une déclaration plus rigoureuse devrait être que « les entrées ci-dessus dans le modèle » sont toutes des invites. La capacité de

ChatGPT à répondre en fonction de la commande d'entrée (invite) provient d'une méthode de formation de modèle appelée réglage fin de la commande (réglage de l'invite). En fait, le principe est très simple. Le modèle consiste toujours à « prédire le prochain jeton en fonction du contenu d'entrée ». Cependant, lors de la phase de réglage fin des instructions, le contenu d'entrée est remplacé par ces invites pré-écrites et le contenu. qui doit être généré après l'invite est , qui est la réponse écrite à l'avance. Par conséquent, la plus grande différence entre cette étape et la formation de modèles linguistiques autorégressifs non supervisés mentionnée au début réside dans les données. Les données ici, c'est-à-dire les invites et les réponses correspondantes, sont toutes écrites par des humains. En d'autres termes, cette étape utilise un entraînement supervisé avec des données étiquetées manuellement.

Lorsqu'il s'agit de données étiquetées manuellement, cela implique naturellement la quantité de données requise, car chaque élément de données étiquetées nécessite un coût. S'il n'y a pas besoin d'étiquetage (tout comme lors de la première étape de la formation), alors il y aura naturellement une quantité massive de données textuelles disponibles pour la formation, mais si un étiquetage est requis, quelle quantité de ces données est nécessaire ? Vous savez, le coût est très élevé pour l'annotateur d'écrire manuellement une invite, puis d'écrire manuellement une réponse vraie et détaillée de plusieurs centaines de mots. Selon l'article « Former des modèles de langage pour suivre des instructions avec des commentaires humains », les données requises ne nécessitent en réalité pas beaucoup de données (par rapport aux données utilisées dans l'étape non supervisée). Bien qu'il n'y ait aucune information exacte divulguée sur la quantité d'utilisation de ChatGPT, il est certain que son ampleur doit être beaucoup plus petite que les ensembles de données composés de pages Web, d'encyclopédies et de livres utilisés pour la formation non supervisée.

Adresse papier : https://arxiv.org/pdf/2203.02155.pdf

Seule une quantité relativement faible de données d'invite annotées manuellement est nécessaire pour atteindre l'objectif consistant à permettre au modèle de répondre en fonction de Derrière ce point se cache en réalité un phénomène appelé capacité de généralisation de l’invite dans le monde académique. Comme vous pouvez l'imaginer, des gens du monde entier posent tout le temps des questions à ChatGPT, et les questions qu'ils posent doivent être toutes sortes d'étranges. Ces questions sont en fait des invites. Mais il n'y a certainement pas beaucoup d'invites utilisées pour affiner les instructions de ChatGPT. Cela montre qu'une fois que le modèle a appris un certain nombre d'invites et de réponses correspondantes, il peut « tirer des conclusions » sur des invites qu'il n'a jamais vues auparavant. est la capacité de généralisation de l'invite. L'analyse de l'article "Démanteler et tracer les origines des différentes capacités de GPT-3.5" souligne que cette capacité de généralisation est liée à la quantité et à la diversité des données annotées que le modèle apprend lors de la phase de mise au point pédagogique.

De plus, une petite quantité de données d'invite peut être utilisée pour affiner un modèle doté de fonctionnalités puissantes telles que ChatGPT. Il y a une autre hypothèse derrière cela, c'est-à-dire que les différentes capacités affichées par le modèle peuvent être affectées par une utilisation non supervisée. formation. Les étapes existent déjà dans le modèle. En fait, c'est facile à comprendre : après tout, par rapport aux données non supervisées, le nombre de ces invites étiquetées manuellement est trop petit. Il est difficile d'imaginer que le modèle ait développé diverses capacités en apprenant uniquement à partir de ces données étiquetées. De ce point de vue, le processus de réglage fin de l'instruction consiste davantage à laisser le modèle apprendre à répondre selon certaines spécifications, et ses connaissances, sa logique et ses autres capacités existent déjà.

- Capacité « objective et impartiale » : Si vous posez à ChatGPT des questions nuisibles ou controversées, vous pouvez voir que les réponses de ChatGPT sont très « prudentes », un peu comme la réponse d'un porte-parole de presse qualifié. Bien qu'elle ne soit pas encore suffisante, cette capacité est le facteur essentiel qui pousse OpenAI à oser l'utiliser publiquement en tant que produit.

Rendre le résultat du modèle cohérent avec les valeurs humainesc'est ce que fait OpenAI. Dès GPT-3 en 2020, OpenAI a découvert que ce modèle entraîné via des données en ligne générerait des contenus discriminatoires, dangereux et controversés. En tant que produit fournissant des services externes, ces contenus préjudiciables sont évidemment inappropriés. Le ChatGPT actuel s'est considérablement amélioré sur ce point. La principale méthode permettant au modèle d'effectuer ce « changement de comportement » provient également du document InstructGPT. Pour être plus précis, cela se fait par un réglage fin des instructions supervisées et par un retour humain. conjointement avec l’apprentissage par renforcement, qui a également été introduit au chapitre 2.

Grâce à l'analyse ci-dessus, nous pouvons constater que du point de vue des méthodes techniques, tout le contenu lié à ChatGPT est connu, mais pourquoi est-il le seul à offrir des performances aussi étonnantes actuellement ? En fait, depuis le lancement de ChatGPT, la communauté PNL analyse les raisons. Bien que de nombreuses conclusions soient spéculatives, elles apportent également quelques éclaircissements pour la localisation de modèles similaires.

Facteurs de taille du modèle

La prémisse de l'émergence des capacités est que la taille du modèle atteint une certaine échelle. Bien qu'il n'y ait pas de lignes directrices spécifiques en matière d'indicateurs, à en juger par la situation factuelle actuelle, elle est similaire à. la chaîne de pensée, etc. Les capacités relativement « avancées » doivent fonctionner suffisamment bien dans des modèles comportant des dizaines de milliards de paramètres ou plus.

Facteur de volume des données

La taille du modèle n'est pas le seul facteur. DeepMind fournit quelques conclusions analytiques dans cet article "Training Compute-Optimal Large Language Models", soulignant que la quantité de données de formation doit augmenter en conséquence avec la taille du modèle. Pour être plus précis, lors de la formation du modèle ", a vu The. le nombre de « jetons » doit augmenter avec la taille du modèle.

Adresse papier : https://arxiv.org/pdf/2203.15556.pdf

Facteurs de qualité des données

Pour les données non supervisées, la quantité de données n'est relativement pas très importante Gros un obstacle, mais la qualité des données est souvent négligée. En fait, dans le document GPT-3, il y a un contenu spécial sur le traitement des données. Afin de nettoyer les données de formation de GPT-3, OpenAI a spécialement formé un modèle de filtrage de données pour obtenir des données de meilleure qualité à partir de données massives de pages Web. En comparaison, certains modèles open source de taille comparable à GPT-3, comme Opt de Meta et Bloom de BigScience, ne semblent pas avoir subi cette étape de nettoyage. C'est peut-être l'une des raisons pour lesquelles ces deux modèles open source sont pires que GPT-3.

De plus, la dimension de mesure de la qualité des données n'est pas unique. Des facteurs tels que la diversité des données, la duplication du contenu et la distribution des données sont tous des facteurs qui doivent être pris en compte. Par exemple, bien que la quantité totale de données de pages Web soit la plus importante parmi les trois catégories de données utilisées par GPT-3 : pages Web, encyclopédies et livres, l'échantillonnage de ces trois types de données pendant la formation n'est pas basé sur la quantité de données réelles.

Il convient également de mentionner que dans la phase de mise au point des instructions, le recours à l'écriture manuelle des instructions peut être un facteur d'influence important. L'article InstructGPT souligne clairement que pendant le processus d'évaluation, les modèles formés à l'aide d'instructions écrites manuellement ont de meilleurs résultats que les modèles formés à l'aide d'ensembles de données PNL existants pour construire des instructions via des modèles. Cela peut expliquer pourquoi les modèles formés sur des ensembles de données d'instructions composés d'ensembles de données NLP tels que T0 et FLAN sont moins efficaces.

L'impact du processus de formation

Ce type de modèle géant est formé via le cluster pendant la formation, tout en utilisant le parallélisme des données, le parallélisme des modèles et l'optimiseur ZeRO (une méthode pour réduire l'utilisation de la mémoire de la formation processus). Cette méthode introduit davantage de variables dans la stabilité de la formation. L'analyse suivante souligne que même si le modèle utilise la précision bfloat16, cela a un impact significatif sur les résultats.

Lien d'analyse : https://jingfengyang.github.io/gpt

Je pense qu'après avoir compris le contenu ci-dessus, tout le monde aura une idée générale sur la façon de forger une méthode de type ChatGPT et les problèmes qui seront confrontés à la compréhension. Heureusement, OpenAI a prouvé que cette voie technique est réalisable, et l'émergence de ChatGPT change effectivement la tendance de développement de la technologie NLP.

ChatGPT a attiré une grande attention depuis son lancement en novembre 2022. Je crois que même les non-professionnels, et même les groupes qui ont peu de contact avec les ordinateurs, sont plus ou moins conscients de son existence. Ce phénomène lui-même reflète déjà que son apparition est quelque peu inhabituelle. Le public extérieur au cercle perçoit son apparition de manière plus perceptuelle avec curiosité, surprise ou admiration. Pour les praticiens, son émergence relève davantage d’une réflexion sur les tendances technologiques futures.

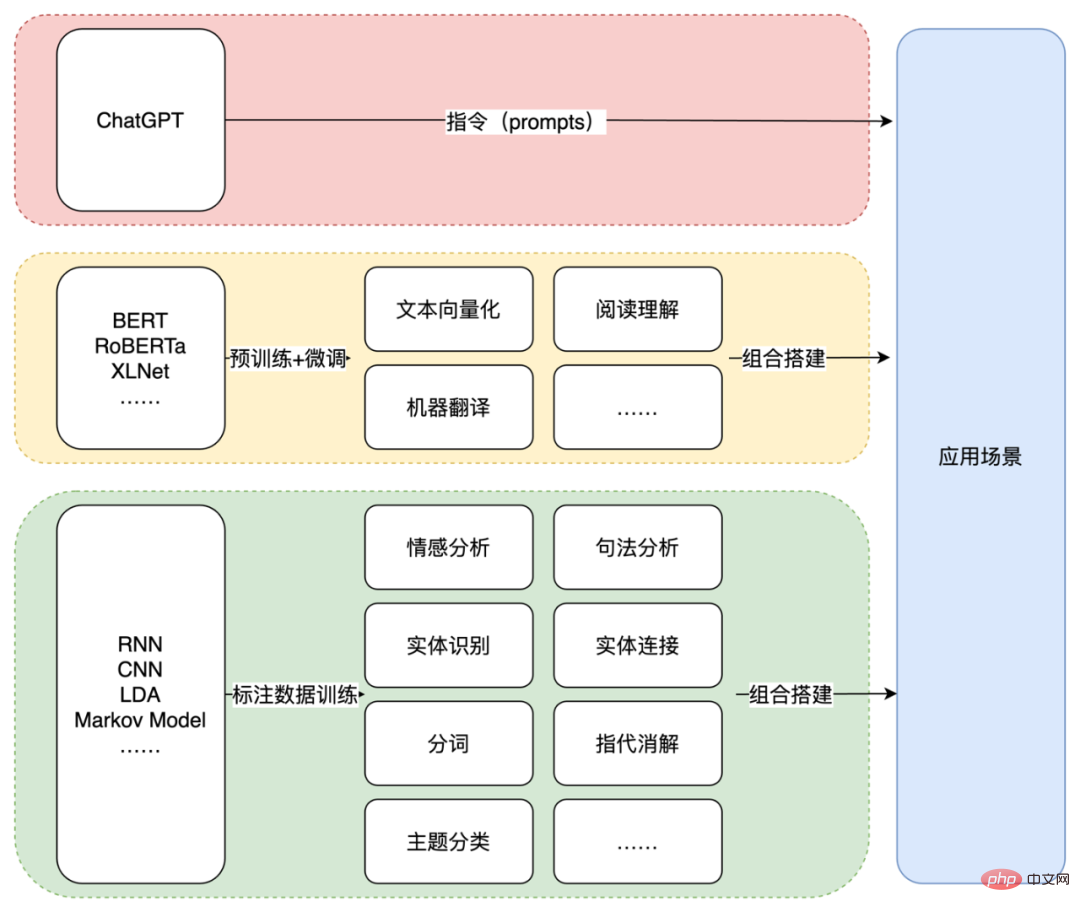

D'un point de vue technique, l'émergence de ChatGPT marque un autre changement de paradigme dans le domaine de la PNL. La raison pour laquelle on dit que c'est « encore » est qu'en 2018, année de sortie de la première génération de GPT, le modèle BERT sorti la même année a créé le paradigme « pré-formation + réglage fin » de la PNL avec ses excellentes performances. Le contenu spécifique de l’époque a été introduit dans le chapitre 2. Ici, nous introduisons principalement le paradigme de « Génération de texte + Instructions » activé par ChatGPT. Plus précisément, il s'agit d'utiliser le ChatGPT formé ou un modèle de génération de texte similaire pour réaliser un scénario spécifique en saisissant les instructions appropriées (invite).

Ce paradigme est très différent des applications précédentes de la technologie PNL. Qu'il s'agisse de la première ère d'utilisation de modèles statistiques tels que LDA et RNN ou de petits modèles d'apprentissage profond, ou de la dernière ère d'utilisation de la pré-formation et du réglage fin tels que BERT, les capacités fournies par la technologie sont relativement atomisées et sont loin d'être disponibles. loin des scénarios d'application réels.Prenons l'exemple ci-dessus consistant à demander à ChatGPT d'écrire un e-mail en anglais selon les exigences. Selon la pratique précédente, il peut être nécessaire d'extraire d'abord les entités, les événements et d'autres contenus (tels que l'heure, le lieu, les événements, etc.) , puis formez l'e-mail via un modèle ou un modèle. Les styles sont ensuite convertis en anglais via un modèle de traduction. Bien entendu, si la quantité de données est suffisante pour entraîner le modèle de bout en bout, vous pouvez également ignorer certaines étapes intermédiaires. Mais quelle que soit la méthode utilisée, soit la scène finale doit être décomposée en tâches PNL atomiques, soit les données d'annotation correspondantes sont nécessaires. Pour ChatGPT, il suffit d’une commande adaptée.

Trois étapes du paradigme technologique de la PNL.

Cette façon de combiner le modèle génératif avec l'invite ignore directement les différents composants de capacité NLP au milieu et résout les problèmes du scénario d'application de la manière la plus directe. Dans ce paradigme, le chemin technique pour compléter les applications de terminaux ne sera plus une combinaison de modules de capacité NLP à point unique via des blocs de construction.

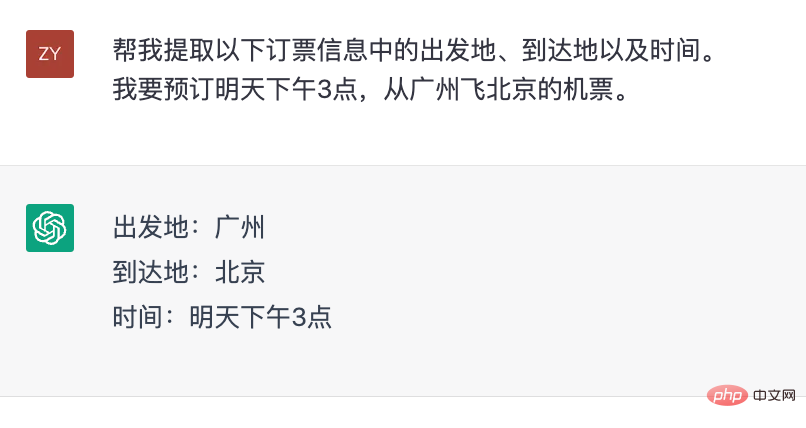

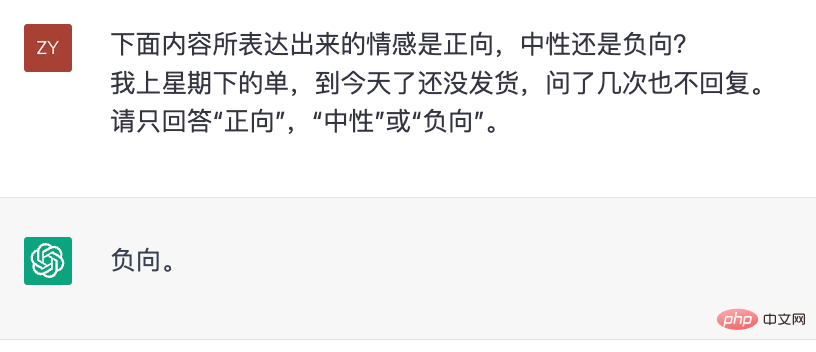

Bien sûr, ce processus ne se réalise pas du jour au lendemain, et cela ne signifie pas non plus que la capacité ponctuelle de la PNL devient sans importance. Du point de vue de l'évaluation, la qualité de chaque point de capacité peut toujours être utilisée comme indicateur pour évaluer l'efficacité du modèle. De plus, dans certains scénarios, les capacités centralisées restent une forte demande. Par exemple, dans le système de réservation de billets, il est nécessaire d’extraire l’heure et le lieu. Mais contrairement à avant, ChatGPT lui-même peut également compléter des capacités ponctuelles sans utiliser de modules fonctionnels supplémentaires.

ChatGPT pour l'extraction d'informations.

ChatGPT pour le jugement émotionnel.

De ce point de vue, ChatGPT peut être considéré comme un outil de PNL qui utilise le langage naturel comme support interactif. Si dans le passé, nous avons complété une certaine capacité NLP via des tâches de formation modèle + données + conception, alors ChatGPT complète ces capacités via des instructions de conception.

Comme vous pouvez l'imaginer, l'émergence de ChatGPT a considérablement abaissé le seuil d'application de la technologie PNL. Mais il n’est pas encore tout-puissant. Le point le plus important est qu'il lui manque une connaissance précise et fiable des domaines verticaux. Afin de fiabiliser ses réponses, le moyen le plus direct est de lui fournir des sources de connaissances externes, tout comme Microsoft utilise les résultats de recherche de Bing comme source d'informations. ses réponses.

Par conséquent, la technologie PNL « traditionnelle » ne disparaîtra pas complètement, mais jouera un rôle « auxiliaire » pour compléter les lacunes actuelles de ChatGPT. Cela pourrait être un nouveau paradigme pour les applications technologiques PNL à l'avenir.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Inscription ChatGPT

Inscription ChatGPT

Encyclopédie ChatGPT nationale gratuite

Encyclopédie ChatGPT nationale gratuite

Comment installer chatgpt sur un téléphone mobile

Comment installer chatgpt sur un téléphone mobile

Chatgpt peut-il être utilisé en Chine ?

Chatgpt peut-il être utilisé en Chine ?

Quel est le meilleur moyen d'apprendre en premier, le langage C ou le C++ ?

Quel est le meilleur moyen d'apprendre en premier, le langage C ou le C++ ?

Comment trier dans Excel

Comment trier dans Excel

Solution d'erreur httpsstatus500

Solution d'erreur httpsstatus500

solution contre les virus exe

solution contre les virus exe