Échouer au test de mathématiques du secondaire est un cauchemar pour de nombreuses personnes.

Si vous dites que votre test de mathématiques au lycée n'est pas aussi bon que l'IA, est-ce plus difficile à accepter ?

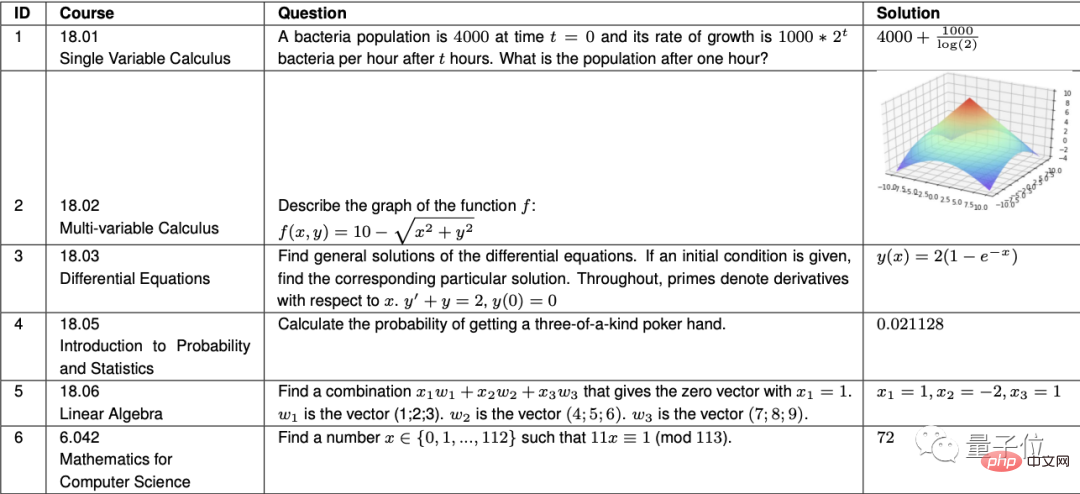

C'est vrai, le Codex d'OpenAI a atteint un taux de précision de 81,1 % dans 7 cours de mathématiques avancées au MIT, qui sont au niveau des étudiants de premier cycle du MIT.

Les cours vont du calcul élémentaire aux équations différentielles, en passant par la théorie des probabilités et l'algèbre linéaire. En plus des calculs, les questions incluent également le dessin.

Cet incident est récemment devenu une tendance sur Weibo.

△ "Seulement" a marqué 81 points, les attentes envers l'IA sont trop élevées

Maintenant, la dernière grande nouvelle vient de Google :

Pas seulement en mathématiques, notre IA est même performante dans l'ensemble des sciences et dans les matières d'ingénierie, j'ai déjà obtenu les meilleurs scores !

Il semble que les géants de la technologie aient atteint un nouveau niveau en cultivant des « experts en questions d'IA ».

Google, le dernier créateur de questions sur l'IA, a passé quatre examens.

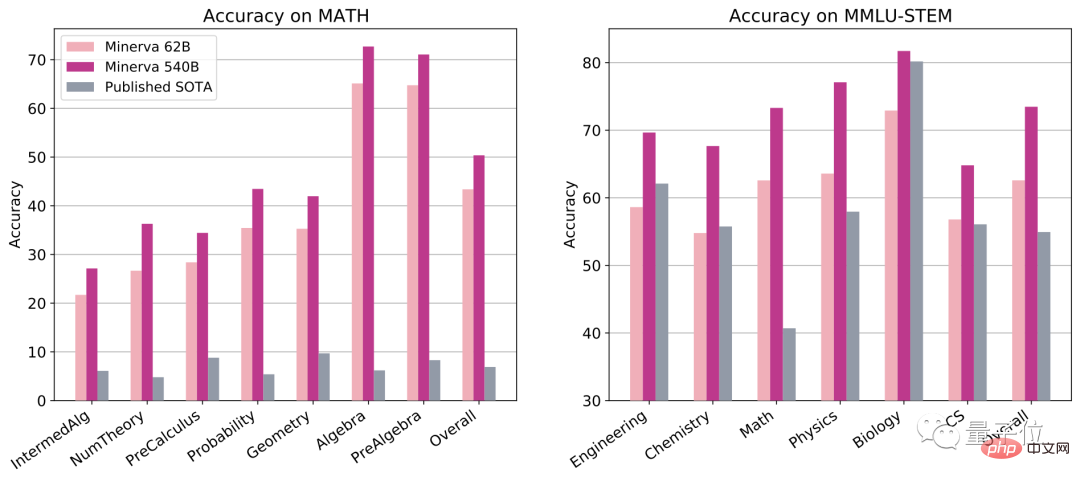

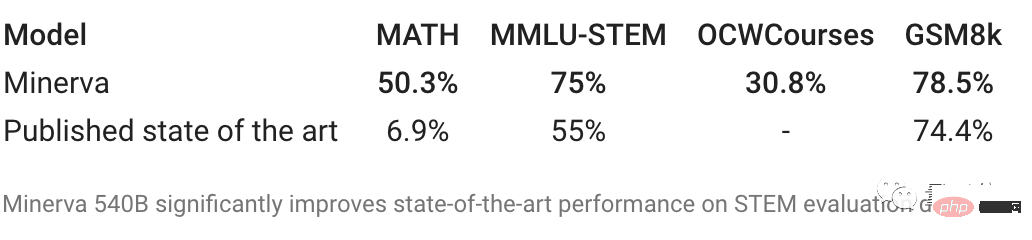

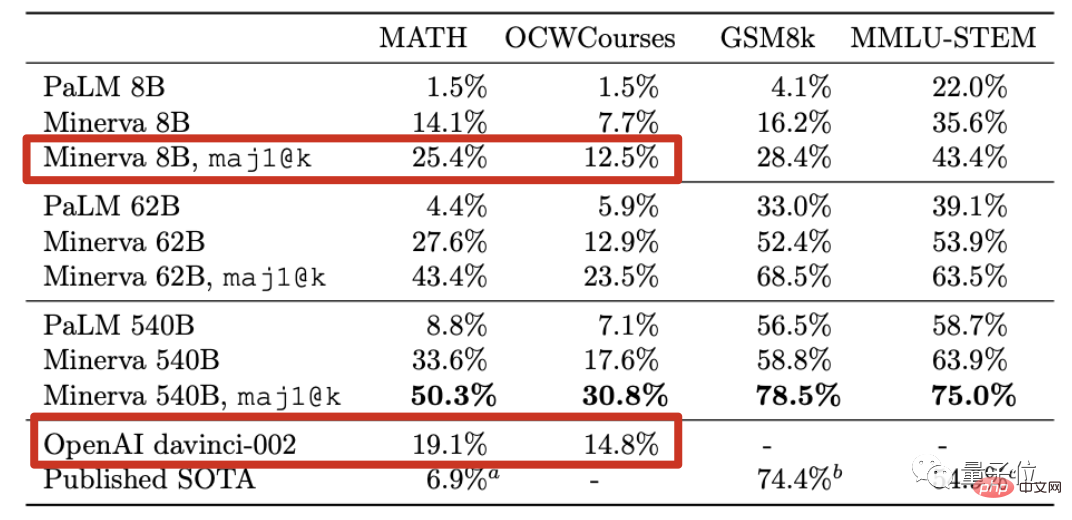

Pour le concours de mathématiques MATH, seuls les trois fois médaillés d'or de l'OMI ont marqué 90 points dans le passé, et les informaticiens ordinaires ne peuvent obtenir qu'environ 40 points.

Comme pour les autres questions-réponses sur l'IA, le meilleur score précédent n'était que de 6,9 points...

Mais cette fois, la nouvelle IA de Google a marqué 50 points, ce qui est supérieur à celui du docteur en informatique.

L'examen de synthèse MMLU-STEM comprend les mathématiques, la physique, la chimie, l'ingénierie électronique et l'informatique. La difficulté des questions atteint le niveau secondaire ou même collégial.

Cette fois, la « version santé complète » de Google AI a également obtenu le score le plus élevé parmi toutes les questions, augmentant directement le score d'environ 20 points.

GSM8k, une question de mathématiques à l'école primaire, a directement élevé le score à 78 points. En comparaison, GPT-3 a échoué (seulement 55 points).

Même pour les cours de premier cycle et des cycles supérieurs du MIT tels que la chimie du solide, l'astronomie, les équations différentielles et la relativité restreinte, la nouvelle IA de Google peut répondre à près d'un tiers des plus de 200 questions.

Le plus important est que contrairement à la méthode d'OpenAI consistant à obtenir des scores élevés en mathématiques en s'appuyant sur des "compétences en programmation", Google AI prend cette fois la voie de "penser comme un humain" -

C'est comme un étudiant en arts libéraux, je viens d'approuver les notes sans répondre aux questions, mais j'ai maîtrisé de meilleures compétences en résolution de problèmes en sciences et en ingénierie.

Il convient de mentionner que Lewkowycz, le premier auteur de l'article, a également partagé un point culminant qui n'a pas été mentionné dans l'article :

Notre modèle a participé à l'examen d'entrée à l'université polonaise de mathématiques de cette année, et son score était supérieur à la moyenne nationale.

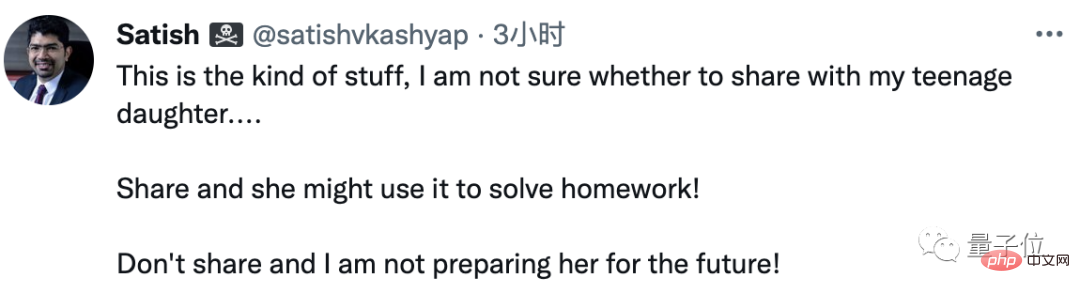

Voyant cela, certains parents ne peuvent plus rester assis.

Si je dis cela à ma fille, j'ai peur qu'elle utilise l'IA pour faire ses devoirs. Mais si vous ne lui dites pas, vous ne la préparez pas pour l’avenir !

Aux yeux des initiés de l'industrie, atteindre ce niveau en s'appuyant uniquement sur des modèles de langage sans coder en dur l'arithmétique, la logique et l'algèbre est la chose la plus étonnante de cette recherche.

Alors, comment ça se passe ?

Le nouveau modèle Minerva est basé sur le modèle de langage général PaLM sous l'architecture Pathway.

La formation continue est réalisée sur la base de modèles PaLM respectivement de 8 milliards, 60 milliards et 540 milliards de paramètres.

L’approche de Minerva pour répondre aux questions est complètement différente de celle du Codex.

La méthode de Codex consiste à réécrire chaque problème mathématique en un problème de programmation, puis à le résoudre en écrivant du code.

Minerva, quant à lui, lisait follement les articles et se forçait à comprendre les symboles mathématiques de la même manière que le langage naturel.

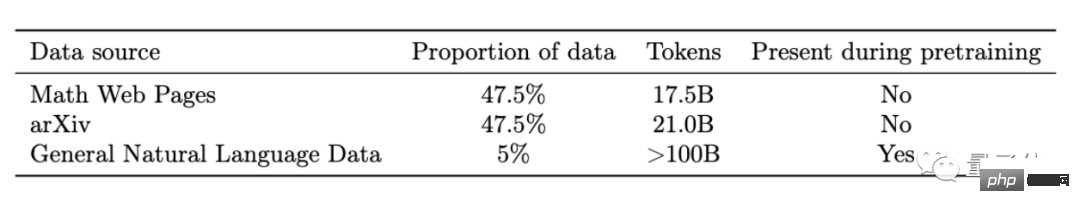

Poursuivre la formation sur la base de PaLM. Le nouvel ensemble de données comprend trois parties :

Comprend principalement 2 millions d'articles académiques collectés sur arXiv, 60 Go de pages Web avec des formules LaTeX et une petite partie utilisée dans l'étape de formation PaLM pour le texte transmis.

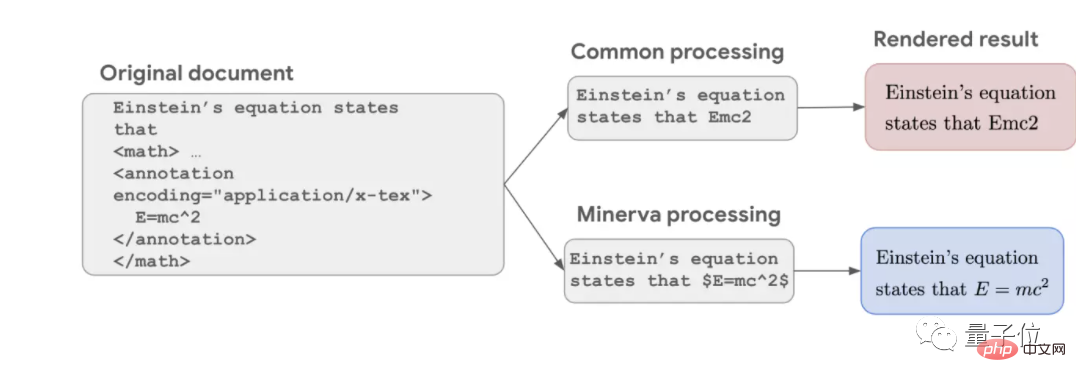

Le processus habituel de nettoyage des données PNL supprimera tous les symboles et ne conservera que le texte pur, ce qui entraînera des formules incomplètes. Par exemple, seul Emc2 reste dans la célèbre équation masse-énergie d'Einstein.

Mais cette fois, Google a conservé toutes les formules et a suivi le programme de formation Transformer tout comme le texte brut, permettant à l'IA de comprendre les symboles comme le langage.

C'est l'une des raisons pour lesquelles Minerva est plus performant sur les problèmes mathématiques que les modèles de langage précédents.

Mais par rapport à l'IA spécialisée dans la résolution de problèmes mathématiques, Minerva n'a pas de structure mathématique sous-jacente explicite dans sa formation, ce qui présente un inconvénient et un avantage.

L'inconvénient est que l'IA peut utiliser de mauvaises étapes pour obtenir la bonne réponse.

L'avantage est qu'il peut être adapté à différentes disciplines. Même si certains problèmes ne peuvent pas être exprimés en langage mathématique formel, ils peuvent être résolus en combinant les capacités de compréhension du langage naturel.

Au stade du raisonnement de l'IA, Minerva combine également plusieurs nouvelles technologies récemment développées par Google.

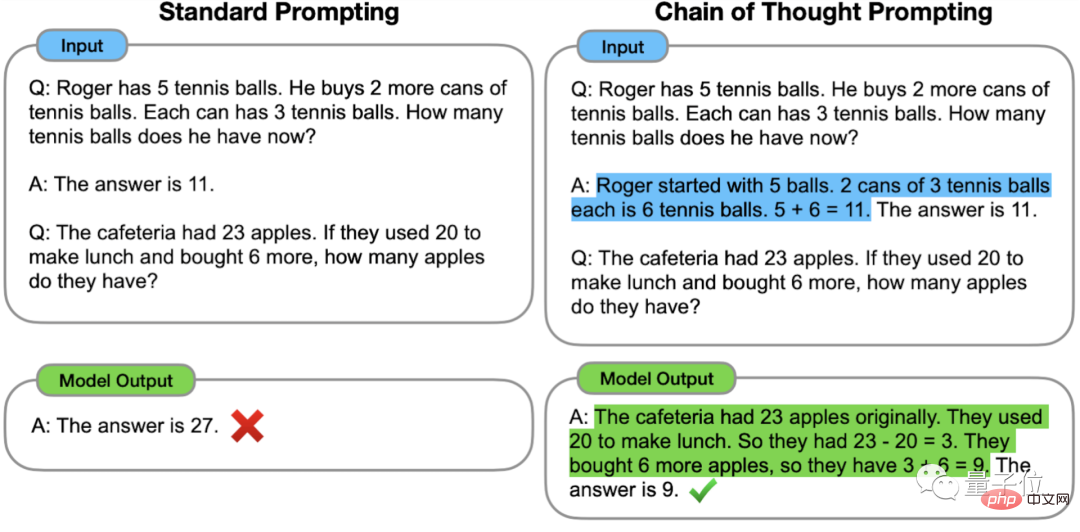

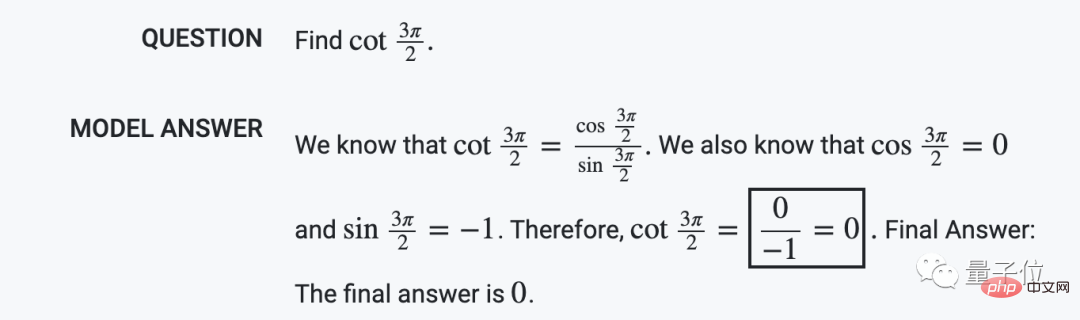

Le premier est l'invite de lien de réflexion Chain of Thought, proposée par l'équipe Google Brain en janvier de cette année.

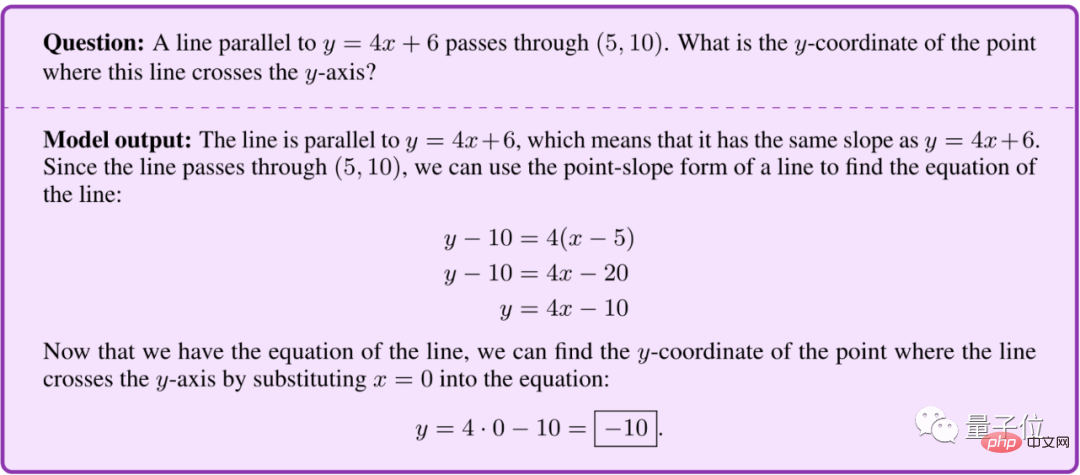

Plus précisément, lorsque vous posez une question, donnez un exemple de réponse étape par étape pour vous guider. L’IA peut utiliser un processus de réflexion similaire lorsqu’elle répond à des questions pour répondre correctement à des questions auxquelles il ne serait pas répondu correctement.

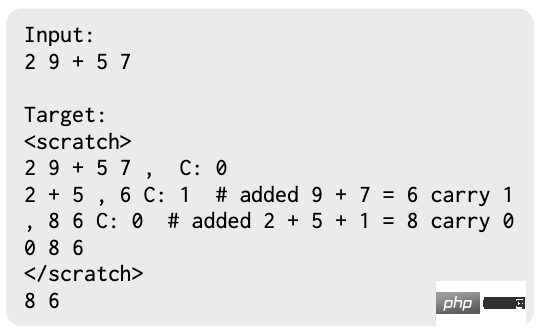

Ensuite, il y a la méthode Scrathpad développée conjointement par Google et le MIT, qui permet à l'IA de stocker temporairement les résultats intermédiaires de calculs étape par étape.

Enfin, il y a la méthode du vote majoritaire, qui n'a été publiée qu'en mars de cette année.

Laissez l'IA répondre plusieurs fois à la même question et choisissez la réponse qui apparaît le plus fréquemment.

Après avoir utilisé toutes ces techniques, Minerva avec 540 milliards de paramètres atteint SOTA dans divers ensembles de tests.

Même la version à 8 milliards de paramètres de Minerva peut atteindre le niveau de la dernière version davinci-002 mise à jour de GPT-3 dans les problèmes de mathématiques de niveau compétition et les problèmes de cours ouverts du MIT.

Cela dit, quelles questions spécifiques Minerva peut-elle répondre ?

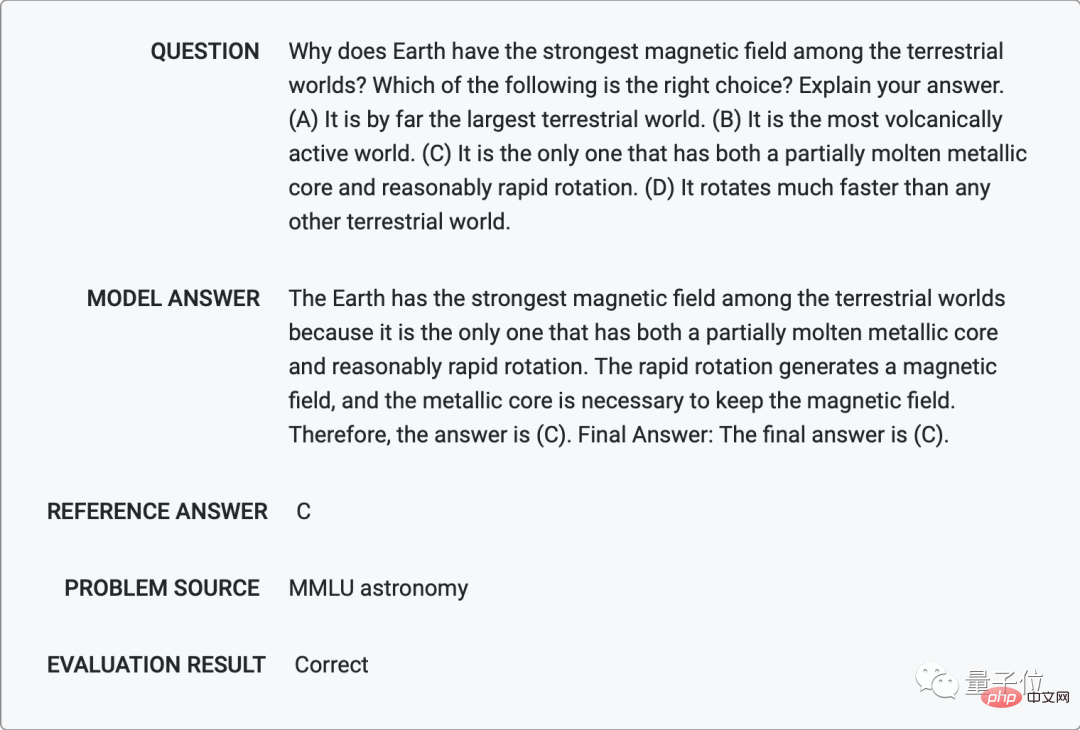

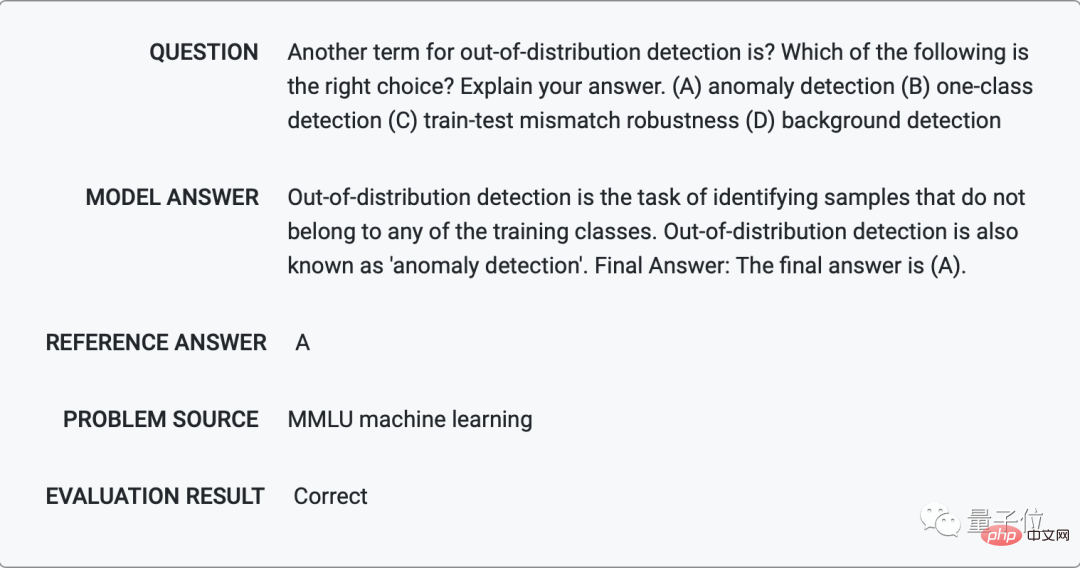

Google a également ouvert un ensemble d'échantillons, jetons-y un coup d'œil.

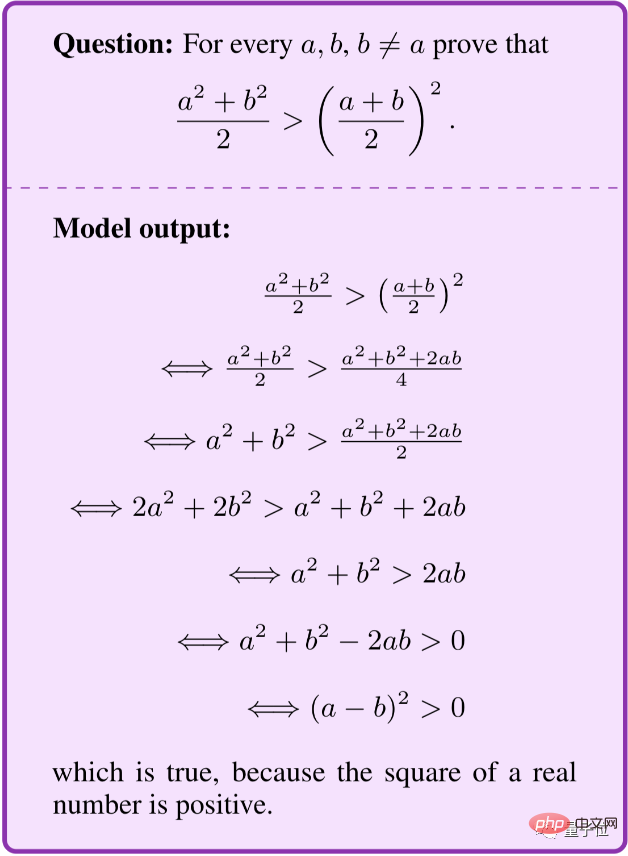

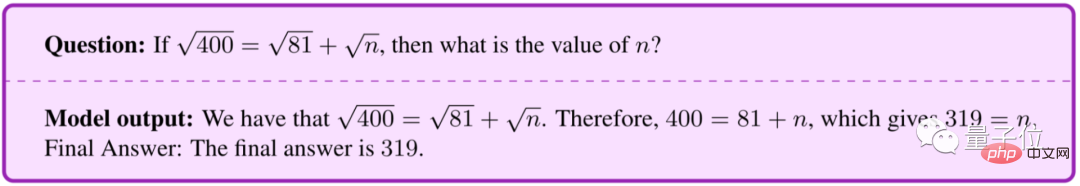

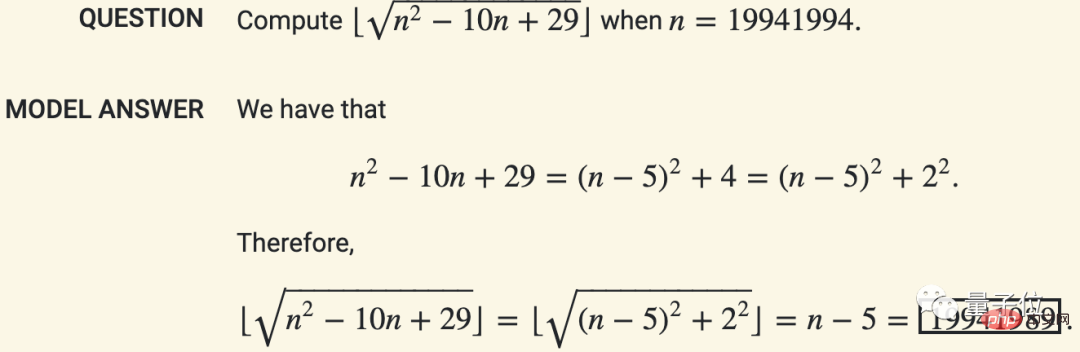

En mathématiques, Minerva peut calculer des valeurs étape par étape comme les humains, au lieu de résoudre directement des problèmes violents.

Pour les problèmes de mots, vous pouvez créer vos propres équations et les simplifier.

Vous pouvez même en tirer la preuve.

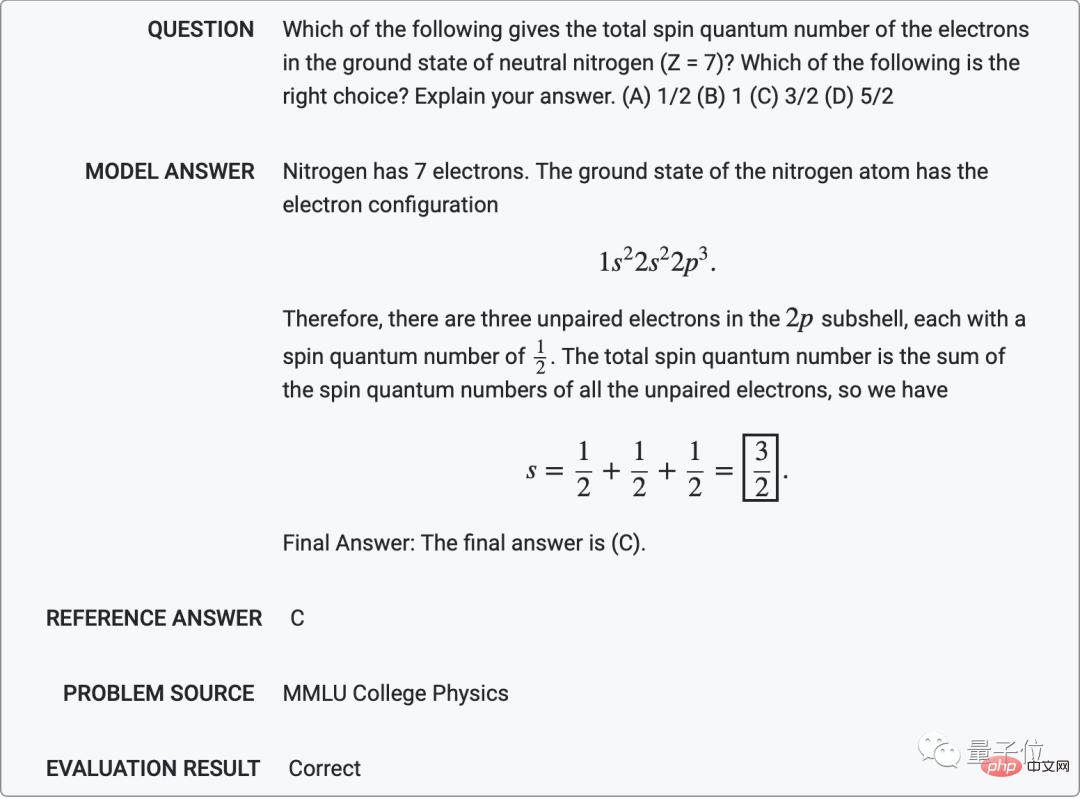

En physique, Minerva peut résoudre des questions de niveau universitaire telles que trouver le nombre quantique de spin total des électrons dans l'état fondamental de l'azote neutre (Z = 7).

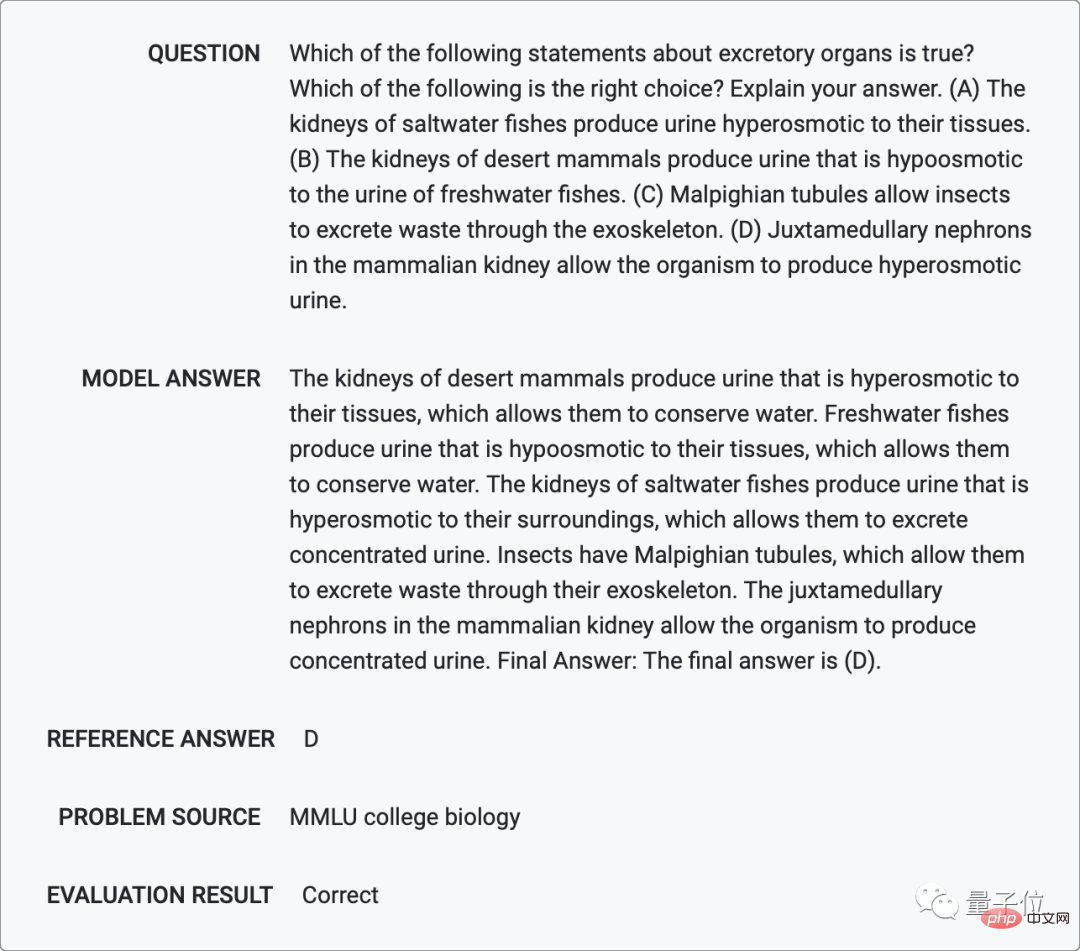

En biologie et en chimie, Minerva peut également répondre à diverses questions à choix multiples grâce à sa capacité de compréhension du langage.

Laquelle des formes suivantes de mutations ponctuelles n'a pas d'impact négatif sur les protéines formées à partir de séquences d'ADN ?

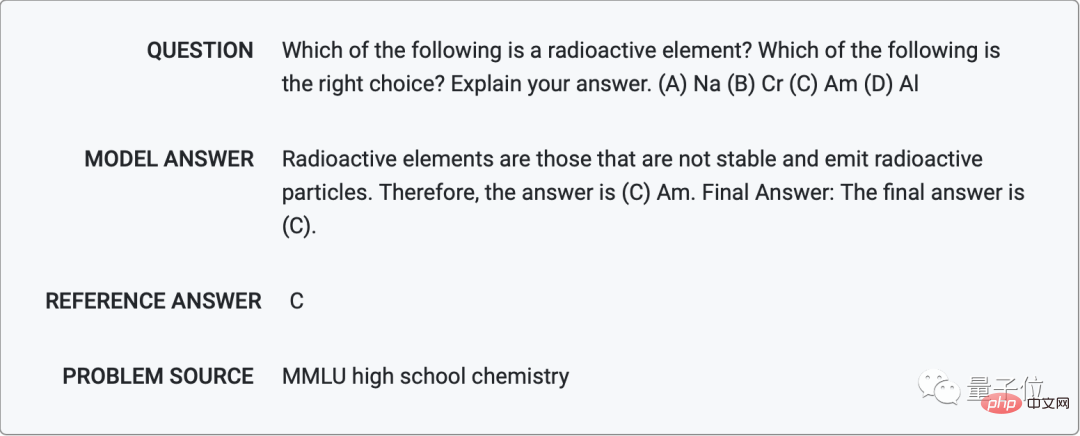

Lequel des éléments suivants est un élément radioactif ?

Et l'Astronomie : Pourquoi la Terre a-t-elle un champ magnétique puissant ?

En termes d'apprentissage automatique, cela donne correctement une autre façon de dire ce terme en expliquant la signification spécifique de « détection d'échantillons hors distribution ».

...

Cependant, Minerva fait parfois des erreurs stupides, comme annuler le √ des deux côtés de l'équation.

De plus, Minerva aura des situations de « faux positifs » où le processus de raisonnement est erroné mais le résultat est correct, comme ce qui suit, avec une probabilité de 8 %.

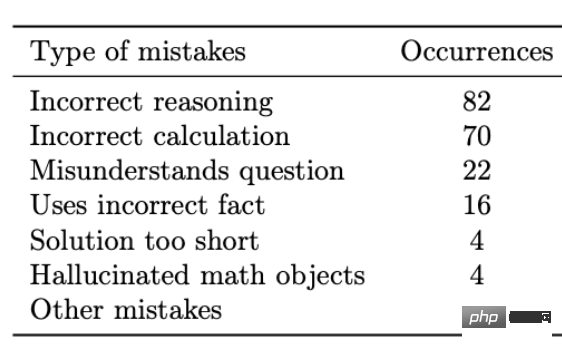

Après analyse, l'équipe a constaté que les principales formes d'erreurs provenaient d'erreurs de calcul et d'erreurs de raisonnement, et que seule une petite partie provenait d'autres situations telles que des erreurs dans la compréhension du sens de la question et l'utilisation de faits erronés dans le mesures.

Les erreurs de calcul peuvent être facilement résolues en accédant à une calculatrice externe ou à un interpréteur Python, mais d'autres types d'erreurs sont difficiles à corriger car le réseau neuronal est trop grand.

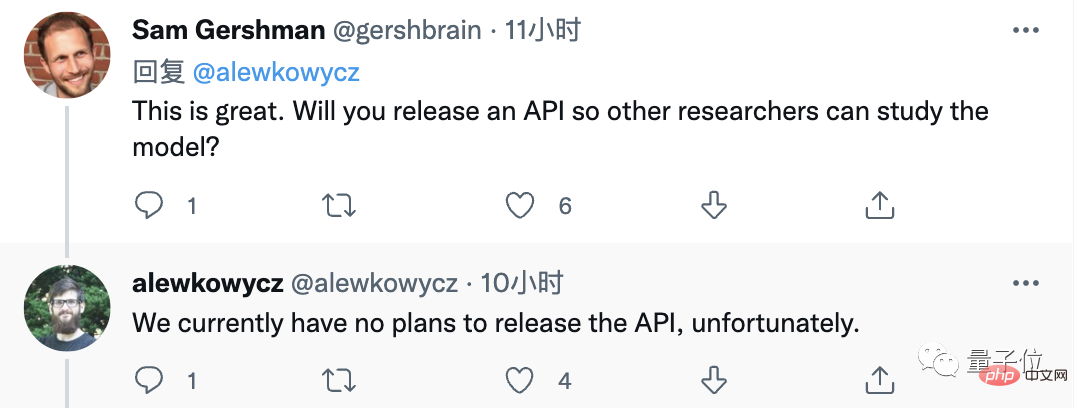

En général, les performances de Minerva ont surpris de nombreuses personnes, et ils ont demandé des API dans la zone de commentaires (malheureusement, Google n'a pas encore rendu public ses plans).

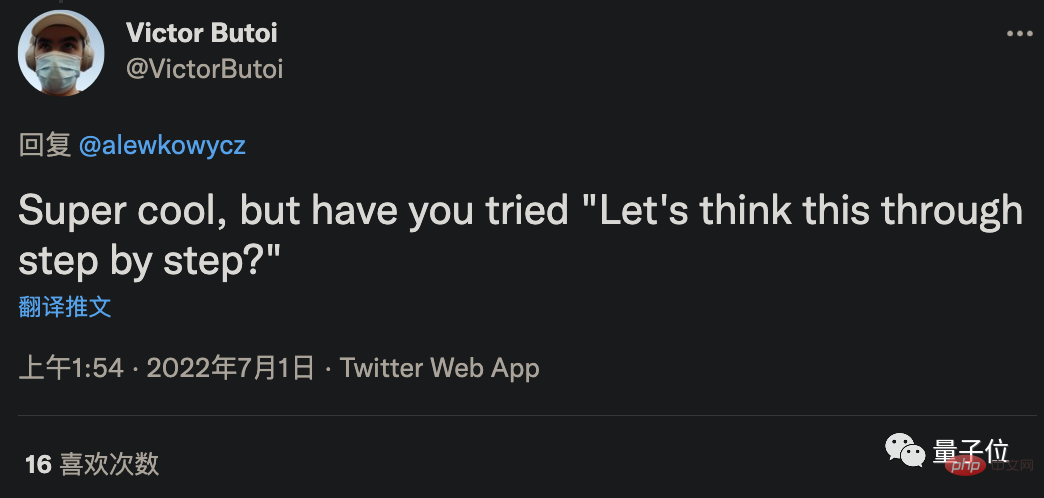

Certains internautes pensaient que, couplée à la méthode de « cajolage » qui a fait grimper de 61 % la précision de résolution de problèmes de GPT-3 au cours des derniers jours, son taux de précision pourrait encore être amélioré ?

Cependant, la réponse de l'auteur est que la méthode de cajolage appartient à l'apprentissage sur échantillon zéro, et peu importe sa force, elle n'est peut-être pas aussi bonne que l'apprentissage sur quelques échantillons avec 4 exemples.

Certains internautes ont également demandé, puisqu'il peut poser des questions, peut-il être utilisé à l'envers ?

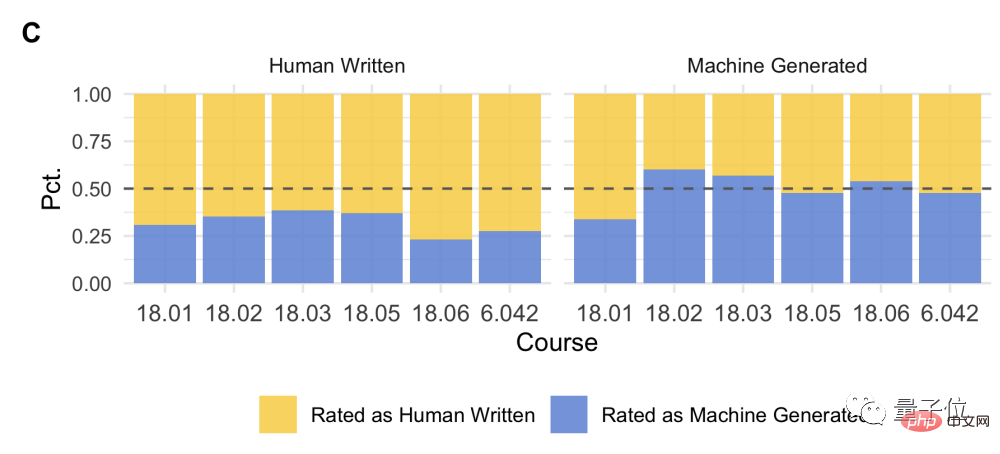

En fait, le MIT s'est associé à OpenAI pour utiliser l'IA afin de poser des questions aux étudiants.

Ils ont mélangé des questions posées par des humains et des questions posées par l'IA, et ont demandé aux étudiants de répondre à des questionnaires. Il était difficile pour tout le monde de dire si une question était posée par l'IA.

En bref, la situation actuelle, à l'exception de ceux qui sont engagés dans l'IA, sont occupés à lire cet article.

Les étudiants ont hâte de pouvoir un jour utiliser l'IA pour faire leurs devoirs.

Les enseignants attendent également avec impatience le jour où ils pourront utiliser l'IA pour produire des épreuves.

Adresse papier : https://storage.googleapis.com/minerva-paper/minerva_paper.pdf

Adresse de démonstration : https://minerva-demo.github.io/

Articles connexes : Chaîne de pensée https://arxiv.org/abs/2201.11903Scrathpads https://arxiv.org/abs/2112.00114Vote majoritaire https://arxiv.org/abs/2203.11171

https://ai.googleblog .com/2022/06/minerva-solving-quantitative-reasoning.html

https://twitter.com/bneyshabur/status/1542563148334596098

https://twitter.com/alewkowycz/status/1542559176483823622

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

point de symbole spécial

point de symbole spécial Que dois-je faire si le navigateur IE affiche une erreur de script ?

Que dois-je faire si le navigateur IE affiche une erreur de script ? 0x00000006 Que faire si l'imprimante ne peut pas être connectée ?

0x00000006 Que faire si l'imprimante ne peut pas être connectée ? Comment télécharger et enregistrer les vidéos phares du jour

Comment télécharger et enregistrer les vidéos phares du jour Que signifie le routage Java ?

Que signifie le routage Java ? Comment redémarrer régulièrement

Comment redémarrer régulièrement outils de développement php

outils de développement php utilisation de l'insertion Oracle

utilisation de l'insertion Oracle