Aucune annotation manuelle n'est requise, une seule formation est nécessaire pour permettre au modèle 3D de comprendre le langage et d'identifier les catégories non étiquetées.

La segmentation des modèles 3D est désormais mains libres !

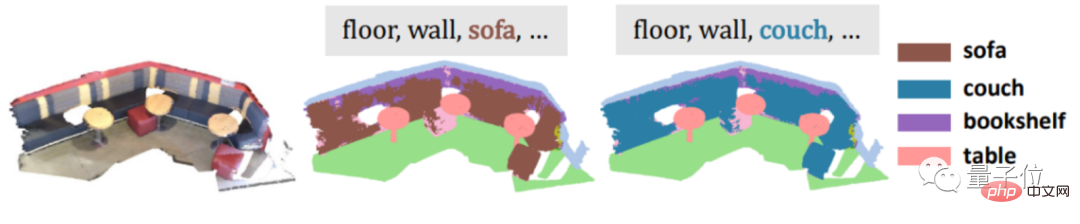

L'Université de Hong Kong et ByteDream ont collaboré et ont mis au point une nouvelle méthode :

Aucune annotation manuelle n'est requise, et une seule formation est nécessaire pour permettre au modèle 3D de comprendre le langage et d'identifier les catégories non étiquetées.

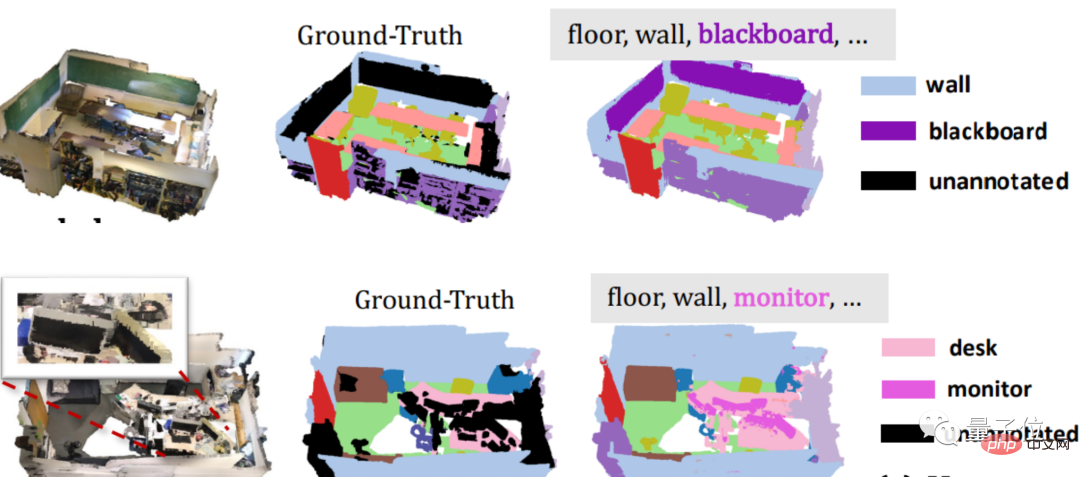

Par exemple, regardez l'exemple ci-dessous, tableau noir et moniteur non annotés. Une fois que le modèle 3D est entraîné par cette méthode, il peut rapidement « saisir » la cible pour la segmentation.

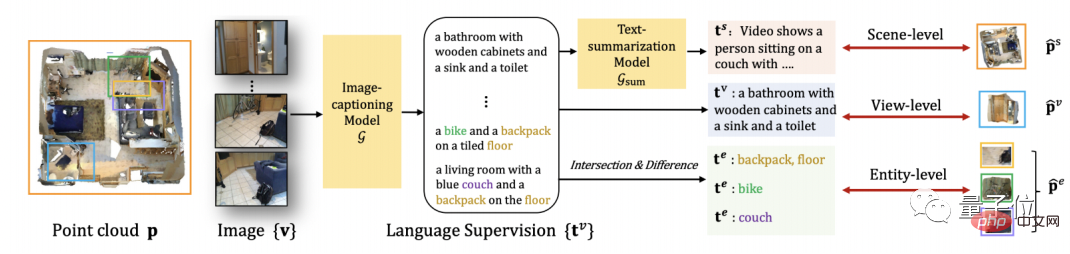

Pour un autre exemple, si vous entrez des synonymes tels que canapé et que vous toussez pour rendre les choses difficiles, cela peut être facilement gagné.

Même les catégories abstraites telles que la salle de bain peuvent être résolues.

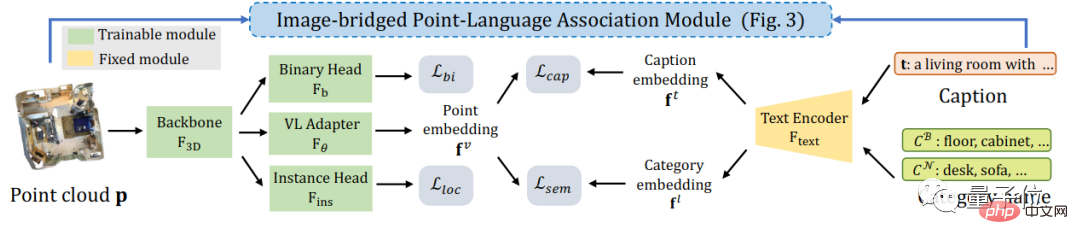

Cette nouvelle méthode s'appelle PLA (Point-Language Assocation), qui est une méthode qui combine le nuage de points (une collection massive de points de caractéristiques de surface cible) et le langage naturel.

Actuellement, cet article a été accepté par le CVPR 2023.

Mais cela dit, aucun étiquetage manuel n'est requis, un seul entraînement est effectué, et la classification abstraite des synonymes peut également être reconnue... Il s'agit d'une superposition de plusieurs buffs.

Vous devez savoir que les données 3D et le langage naturel utilisés par les méthodes générales ne peuvent pas être obtenus directement à partir d'Internet gratuitement et nécessitent souvent des annotations manuelles coûteuses, et que les méthodes générales ne peuvent pas identifier de nouvelles catégories basées sur les connexions sémantiques entre les mots.

Alors, comment le PLA fait-il ? Jetons un coup d'oeil~

En fait, pour parler franchement, l'étape la plus importante pour réussir la division du modèle 3D est de faire comprendre le langage naturel aux données 3D.

Professionnellement parlant, il s'agit d'introduire des descriptions en langage naturel dans des nuages de points 3D.

Comment le présenter ?

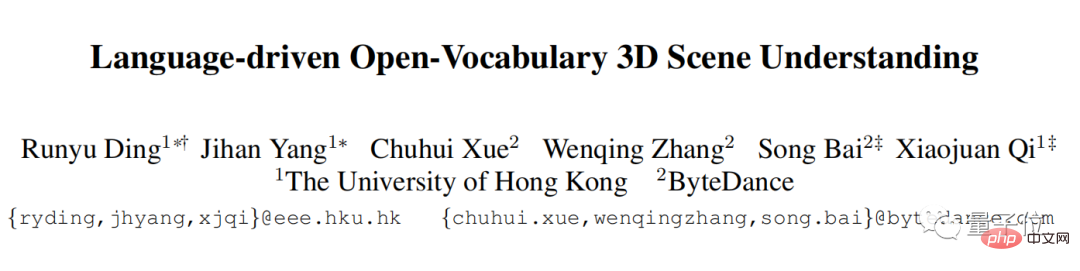

Compte tenu du fait qu'il existe actuellement des méthodes relativement efficaces pour diviser des images 2D, l'équipe de recherche a décidé de commencer par des images 2D.

Tout d'abord, convertissez le nuage de points 3D en l'image 2D correspondante, puis utilisez-le comme entrée du grand modèle multimodal 2D et extrayez-en la description linguistique de l'image.

Ensuite, en utilisant la relation de projection entre l'image et le nuage de points, la description linguistique de l'image peut naturellement être associée aux données du nuage de points 3D.

Et, afin d'être compatible avec des objets 3D de différentes granularités, PLA propose également une méthode de corrélation multi-granularité nuage de points 3D-langage naturel.

Pour l'ensemble de la scène 3D, PLA résume les descriptions de langage extraites de toutes les images correspondant à la scène, et utilise ce langage résumé pour associer l'ensemble de la scène 3D.

Pour la scène 3D partielle correspondant à chaque vue d'image, PLA utilise directement l'image comme pont pour associer le nuage de points 3D et le langage correspondant.

Pour les objets 3D plus fins, le PLA fournit des méthodes liées au langage 3D plus fines.

De cette manière, l'équipe de recherche peut obtenir des paires de nuages de points 3D - langage naturel, ce qui résout directement le problème de l'annotation manuelle.

PLA utilise le couple "nuage de points 3D-langage naturel" obtenu et la supervision des jeux de données existants pour permettre au modèle 3D de comprendre la définition du problème de détection et de segmentation.

Plus précisément, l'apprentissage contrastif est utilisé pour raccourcir la distance entre chaque paire de nuages de points 3D et le langage naturel dans l'espace des fonctionnalités, et pour repousser le nuage de points 3D et la description en langage naturel qui ne correspondent pas.

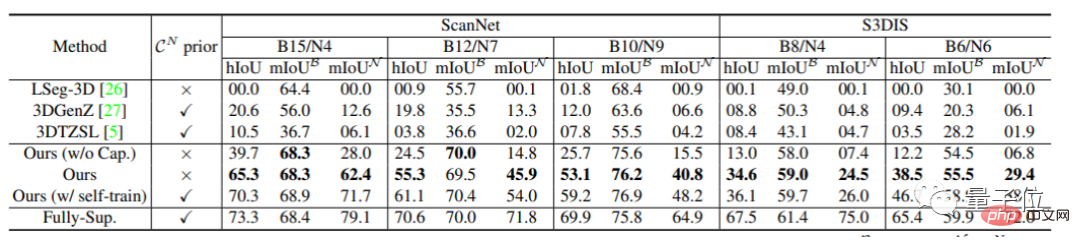

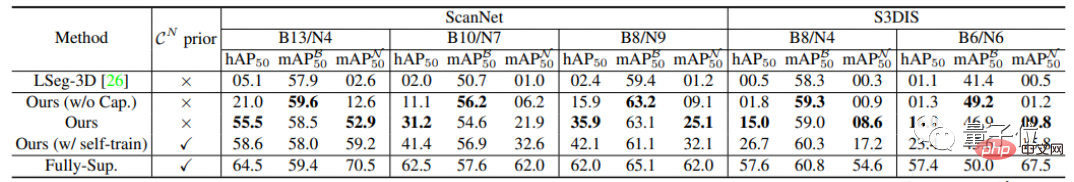

Après avoir parlé de tant de principes, comment le PLA se comporte-t-il dans des tâches de segmentation spécifiques ?

Les chercheurs ont testé les performances du modèle 3D du monde ouvert dans des catégories non étiquetées comme principal critère de mesure.

Premièrement, sur les tâches de segmentation sémantique de ScanNet et S3DIS, PLA a dépassé la méthode de base précédente de 35 % à 65 %.

Dans la tâche de segmentation d'instance, le PLA a également été amélioré Par rapport à la méthode précédente, l'amélioration du PLA varie de 15 % à 50 %.

L'équipe de recherche de ce projet provient du CVMI Lab de l'Université de Hong Kong et de ByteDance.

CVMI Lab est un laboratoire d'intelligence artificielle de l'Université de Hong Kong. Le laboratoire a été créé le 1er février 2020.

Le champ de recherche couvre la vision par ordinateur et la reconnaissance de formes, l'apprentissage automatique/apprentissage profond, l'analyse de contenu image/vidéo et l'analyse du Big Data industriel basée sur l'intelligence artificielle.

Adresse théorique :https://arxiv.org/pdf/2211.16312.pdf

Propriétaire du projet :https://github.com/CVMI-Lab/PLA

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Classements des échanges de crypto-monnaie

Classements des échanges de crypto-monnaie

La différence entre tas et pile

La différence entre tas et pile

utilisation de location.reload

utilisation de location.reload

que signifie bbs

que signifie bbs

Logiciel gratuit pour créer des sites Web

Logiciel gratuit pour créer des sites Web

Que dois-je faire si mon ordinateur ne s'allume pas ?

Que dois-je faire si mon ordinateur ne s'allume pas ?

si qu'est-ce que ça veut dire

si qu'est-ce que ça veut dire

Comment vérifier le plagiat sur CNKI Étapes détaillées pour vérifier le plagiat sur CNKI

Comment vérifier le plagiat sur CNKI Étapes détaillées pour vérifier le plagiat sur CNKI