qu'est-ce que Hadoop

Hadoop est une infrastructure système distribuée développée par la Fondation Apache, un cadre logiciel capable de traiter de grandes quantités de données ; Hadoop traite les données de manière fiable, efficace et évolutive. Les utilisateurs peuvent développer des programmes distribués sans problème ; comprendre les détails sous-jacents de la distribution.

Les utilisateurs peuvent facilement développer et exécuter des applications qui traitent d'énormes quantités de données sur Hadoop.

Hadoop implémente un système de fichiers distribué (Hadoop Distributed File System), appelé HDFS. HDFS est hautement tolérant aux pannes et conçu pour être déployé sur du matériel à faible coût ; il offre un débit élevé pour accéder aux données d'application, ce qui le rend adapté aux applications disposant de grands ensembles de données. HDFS assouplit les exigences POSIX et permet un accès en streaming aux données du système de fichiers.

La conception de base du framework Hadoop est : HDFS et MapReduce. HDFS permet le stockage de données massives, tandis que MapReduce permet le calcul de données massives.

Hadoop présente principalement les avantages suivants :

● Haute fiabilité. La capacité de Hadoop à stocker et traiter les données petit à petit est digne de confiance.

● Haute évolutivité. Hadoop distribue les données et effectue des tâches informatiques entre les clusters d'ordinateurs disponibles, qui peuvent être facilement étendus à des milliers de nœuds.

● Efficacité. Hadoop peut déplacer dynamiquement les données entre les nœuds et assurer l'équilibre dynamique de chaque nœud, de sorte que la vitesse de traitement est très rapide.

● Haute tolérance aux pannes. Hadoop peut enregistrer automatiquement plusieurs copies de données et redistribuer automatiquement les tâches ayant échoué.

● Faible coût. Comparé aux machines tout-en-un, aux entrepôts de données commerciaux et aux datamarts tels que QlikView et Yonghong Z-Suite, hadoop est open source, le coût logiciel du projet sera donc considérablement réduit.

Hadoop est livré avec un framework écrit en langage Java, il est donc idéal pour fonctionner sur les plateformes de production Linux. Les applications sur Hadoop peuvent également être écrites dans d'autres langages, tels que C++.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undress AI Tool

Images de déshabillage gratuites

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Erreurs Java : erreurs Hadoop, comment les gérer et les éviter

Jun 24, 2023 pm 01:06 PM

Erreurs Java : erreurs Hadoop, comment les gérer et les éviter

Jun 24, 2023 pm 01:06 PM

Erreurs Java : erreurs Hadoop, comment les gérer et les éviter Lorsque vous utilisez Hadoop pour traiter des données volumineuses, vous rencontrez souvent des erreurs d'exception Java, qui peuvent affecter l'exécution des tâches et provoquer l'échec du traitement des données. Cet article présentera quelques erreurs Hadoop courantes et fournira des moyens de les gérer et de les éviter. Java.lang.OutOfMemoryErrorOutOfMemoryError est une erreur provoquée par une mémoire insuffisante de la machine virtuelle Java. Quand Hadoop est

Construction de grappes par hadoop pseudo-distribuée

May 07, 2025 pm 04:45 PM

Construction de grappes par hadoop pseudo-distribuée

May 07, 2025 pm 04:45 PM

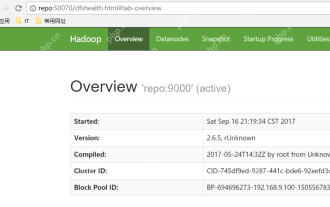

Préparation du logiciel J'utilise une machine virtuelle avec CentOS-6.6, avec le nom de nom d'hôte. Reportez-vous aux étapes pour installer une machine virtuelle Linux dans Windows, j'ai installé JDK dans cette machine virtuelle, reportez-vous au guide pour installer JDK dans Linux. De plus, la machine virtuelle est configurée avec une connexion sans clé elle-même, et les paramètres de configuration de connexion sans clé entre chaque machine virtuelle sont référencés. L'adresse de téléchargement du package d'installation de Hadoop est: https://mirrors.aliyun.com/apache/hadoop/common/. J'utilise la version Hadoop 2.6.5. Téléchargez le package d'installation de Hadoop sur le serveur et dézip [root @ repo ~] #tarzxv

Comment utiliser PHP et Hadoop pour le traitement du Big Data

Jun 19, 2023 pm 02:24 PM

Comment utiliser PHP et Hadoop pour le traitement du Big Data

Jun 19, 2023 pm 02:24 PM

Alors que la quantité de données continue d’augmenter, les méthodes traditionnelles de traitement des données ne peuvent plus relever les défis posés par l’ère du Big Data. Hadoop est un cadre informatique distribué open source qui résout le problème de goulot d'étranglement des performances causé par les serveurs à nœud unique dans le traitement du Big Data grâce au stockage distribué et au traitement de grandes quantités de données. PHP est un langage de script largement utilisé dans le développement Web et présente les avantages d'un développement rapide et d'une maintenance facile. Cet article explique comment utiliser PHP et Hadoop pour le traitement du Big Data. Qu'est-ce que HadoopHadoop ?

Explorez l'application de Java dans le domaine du big data : compréhension de Hadoop, Spark, Kafka et d'autres piles technologiques

Dec 26, 2023 pm 02:57 PM

Explorez l'application de Java dans le domaine du big data : compréhension de Hadoop, Spark, Kafka et d'autres piles technologiques

Dec 26, 2023 pm 02:57 PM

Pile technologique Java Big Data : Comprendre l'application de Java dans le domaine du Big Data, comme Hadoop, Spark, Kafka, etc. Alors que la quantité de données continue d'augmenter, la technologie Big Data est devenue un sujet brûlant à l'ère d'Internet d'aujourd'hui. Dans le domaine du big data, on entend souvent les noms de Hadoop, Spark, Kafka et d’autres technologies. Ces technologies jouent un rôle essentiel et Java, en tant que langage de programmation largement utilisé, joue également un rôle majeur dans le domaine du Big Data. Cet article se concentrera sur l'application de Java en général

Comment installer Hadoop sous Linux

May 18, 2023 pm 08:19 PM

Comment installer Hadoop sous Linux

May 18, 2023 pm 08:19 PM

1 : Installez JDK1. Exécutez la commande suivante pour télécharger le package d'installation de JDK1.8. wget--no-check-certificatehttps://repo.huaweicloud.com/java/jdk/8u151-b12/jdk-8u151-linux-x64.tar.gz2 Exécutez la commande suivante pour décompresser le package d'installation JDK1.8 téléchargé. . tar-zxvfjdk-8u151-linux-x64.tar.gz3 Déplacez et renommez le package JDK. mvjdk1.8.0_151//usr/java84. Configurez les variables d'environnement Java. écho'

Utilisation de Hadoop et HBase dans Beego pour le stockage et les requêtes Big Data

Jun 22, 2023 am 10:21 AM

Utilisation de Hadoop et HBase dans Beego pour le stockage et les requêtes Big Data

Jun 22, 2023 am 10:21 AM

Avec l'avènement de l'ère du Big Data, le traitement et le stockage des données sont devenus de plus en plus importants, et la gestion et l'analyse efficaces de grandes quantités de données sont devenues un défi pour les entreprises. Hadoop et HBase, deux projets de la Fondation Apache, proposent une solution de stockage et d'analyse du Big Data. Cet article explique comment utiliser Hadoop et HBase dans Beego pour le stockage et les requêtes Big Data. 1. Introduction à Hadoop et HBase Hadoop est un système informatique et de stockage distribué open source qui peut

Utiliser PHP pour réaliser des traitements de données à grande échelle : Hadoop, Spark, Flink, etc.

May 11, 2023 pm 04:13 PM

Utiliser PHP pour réaliser des traitements de données à grande échelle : Hadoop, Spark, Flink, etc.

May 11, 2023 pm 04:13 PM

Alors que la quantité de données continue d’augmenter, le traitement des données à grande échelle est devenu un problème auquel les entreprises doivent faire face et résoudre. Les bases de données relationnelles traditionnelles ne peuvent plus répondre à cette demande pour le stockage et l'analyse de données à grande échelle, les plateformes informatiques distribuées telles que Hadoop, Spark et Flink sont devenues les meilleurs choix. Dans le processus de sélection des outils de traitement de données, PHP devient de plus en plus populaire parmi les développeurs en tant que langage facile à développer et à maintenir. Dans cet article, nous explorerons comment exploiter PHP pour le traitement de données à grande échelle et comment

Utilisation de l'intégration de la base de données Oracle avec Hadoop dans un environnement Big Data

Jun 04, 2025 pm 10:24 PM

Utilisation de l'intégration de la base de données Oracle avec Hadoop dans un environnement Big Data

Jun 04, 2025 pm 10:24 PM

La raison principale de l'intégration des bases de données Oracle avec Hadoop est de tirer parti des puissantes capacités de gestion des données et de transaction d'Oracle, ainsi que des capacités de stockage et d'analyse de données à grande échelle de Hadoop. Les méthodes d'intégration comprennent: 1. Exporter les données d'OracleBigDataconnector à Hadoop; 2. Utilisez Apachesqoop pour la transmission des données; 3. Lisez les données Hadoop directement via la fonction de table externe d'Oracle; 4. Utilisez OracleGoldEngate pour obtenir la synchronisation des données.