Résumé : Avant de pouvoir extraire la valeur des données, elles doivent d'abord passer par des processus tels que la collecte, le stockage, l'analyse et le calcul. L'obtention de données complètes et précises est la base de l'exploration de la valeur des données. Ce numéro de « Big Data Story » du CSDN Cloud Computing Club commencera par les méthodes de collecte de données les plus courantes : les robots RSS et les moteurs de recherche.

Le 30 décembre, l'événement CSDN Cloud Computing Club s'est tenu au 3W Coffee. Le thème de l'événement était "RSS et robots d'exploration : l'histoire du Big Data - En commençant par comment collecter des données". Avant de pouvoir exploiter la valeur des données, elles doivent d'abord passer par des processus tels que la collecte, le stockage, l'analyse et le calcul. L'obtention de données complètes et précises constitue la base de l'exploration de la valeur des données. Peut-être que les données actuelles ne peuvent pas apporter une réelle valeur à l'entreprise ou à l'organisation, mais en tant que décideur clairvoyant, vous devez comprendre que les données importantes doivent être collectées et sauvegardées le plus tôt possible. Ce numéro de « Big Data Story » commencera par les méthodes de collecte de données les plus courantes : les robots RSS et les moteurs de recherche.

L'événement était plein à craquer

Tout d'abord, Cui Kejun, directeur général de la division bibliothèque de Beijing Wanfang Software Co., Ltd., a partagé le thème de « Mise en œuvre RSS à grande échelle Applications initiales de l'agrégation et du téléchargement de sites Web dans la recherche scientifique. » Cui Kejun a travaillé dans le secteur des bibliothèques et de l'information pendant 12 ans et possède une riche expérience dans la collecte de données. Il a principalement partagé le RSS, un moyen important d'agrégation d'informations, et sa technologie de mise en œuvre.

RSS (Really Simple Syndication) est une spécification de format source utilisée pour regrouper des sites Web qui publient fréquemment des données mises à jour, telles que des articles de blog, des actualités, des extraits audio ou vidéo. Les fichiers RSS contiennent du texte intégral ou des extraits de texte, ainsi que des extraits de données et des métadonnées d'autorisation du réseau auquel l'utilisateur est abonné.

L'agrégation de centaines, voire de milliers de graines RSS étroitement liées à un certain secteur vous permettra de comprendre rapidement et de manière complète les derniers développements dans un certain secteur. En téléchargeant des données complètes à partir d'un site Web et en effectuant une exploration de données, vous sera capable de comprendre les tenants et les aboutissants du développement d'un certain sujet dans l'industrie.

Cui Kejun, directeur général du département de bibliothèque de Beijing Wanfang Software Co., Ltd.

Cui Kejun a présenté le rôle du RSS dans l'Institut de La physique des hautes énergies comme exemple. Applications dans les instituts de recherche scientifique. La surveillance des informations sur la physique des hautes énergies cible les institutions homologues de la physique des hautes énergies du monde entier : laboratoires, sociétés industrielles, associations internationales, agences gouvernementales en charge de la recherche scientifique dans divers pays, publications scientifiques complètes clés, projets expérimentaux de physique des hautes énergies et installations expérimentales. . Les types d'informations surveillées sont : actualités, articles, rapports de conférences, analyses et critiques, prépublications, études de cas, multimédia, livres, informations de recrutement, etc.

Les informations sur la littérature sur la physique des hautes énergies utilisent le système de gestion de contenu open source le plus avancé Drupal, la technologie de recherche open source Apache Solr, ainsi que la technologie PubSubHubbub développée par les employés de Google pour s'abonner aux actualités en temps réel et à celles d'Amazon. OpenSearch pour établir un ensemble de physique des hautes énergies Le système de surveillance des informations est différent de l'abonnement et du push RSS traditionnels, et réalise la capture d'informations presque en temps réel et la diffusion active de nouvelles avec n'importe quel mot-clé, n'importe quelle catégorie et condition composée.

Ensuite, Cui Kejun a partagé son expérience dans l'utilisation de technologies telles que Drupal, Apache Solr, PubSubHubbub et OpenSearch.

Ensuite, Ye Shunping, l'architecte et chef d'équipe du département de recherche de Yisou Technology, a donné un partage intitulé "Web Search Crawler Timeliness System", comprenant les principaux objectifs, l'architecture et divers sous-modules de le système de conception des délais.

Ye Shunping, architecte et chef de l'équipe d'exploration du département de recherche de Yisou Technology

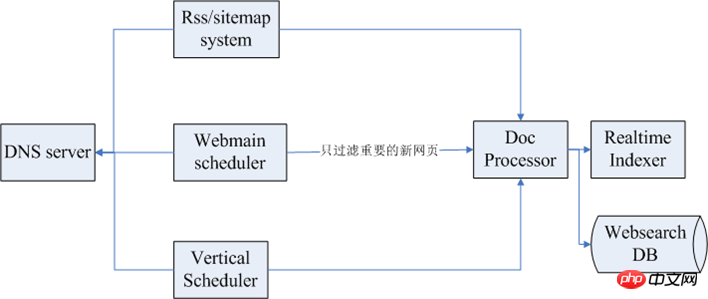

Les différents objectifs des robots d'exploration Web sont une couverture élevée et un faible taux de liens morts Comme pour une bonne efficacité, l'objectif du système d'efficacité des robots d'exploration est similaire, principalement pour parvenir à une inclusion rapide et complète de nouvelles pages Web. La figure suivante montre l'architecture globale du système d'actualité :

Parmi eux, le premier ci-dessus est le sous-système RSS/sitemap, et le suivant est le planificateur Webmain, le système de planification pour l'exploration des pages Web, puis un module de rapidité Vertical Scheduler. L'extrême gauche est le service DNS. Lors de l'exploration, il y a généralement des dizaines, voire des centaines de clusters d'exploration. Si chacun est protégé, la pression sur le DNS sera. être relativement élevé, il existe donc généralement un module de service DNS pour fournir des services globaux. Une fois les données capturées, un traitement ultérieur des données est généralement effectué.

Les modules liés à l'efficacité sont les suivants :

Système RSS/plan du site : le processus d'utilisation du RSS/plan du site par le système de rapidité consiste à extraire des graines, à les explorer régulièrement et à analyser le temps de publication du lien. . Explorez et indexez d'abord les pages Web les plus récentes.

Système d'exploration panoramique : si le système d'exploration panoramique est bien conçu, il contribuera à améliorer la couverture élevée des pages Web sensibles au temps, mais l'exploration panoramique doit raccourcir le cycle de planification autant que possible.

Système de planification des semences : il s'agit principalement d'une bibliothèque de semences urgente. Cette bibliothèque de semences contient certaines informations. Le système de planification analysera en permanence la base de données, puis l'enverra au cluster d'analyse. extraira certains liens, puis les enverra par catégorie, et chaque canal vertical obtiendra des données en temps opportun.

Exploration de graines : implique l'analyse de pages ou d'autres méthodes d'extraction, qui peuvent être construites via des plans de site et des barres de navigation, et en fonction des caractéristiques structurelles de la page et des règles de changement de page.

Mécanisme de mise à jour des graines : enregistrez l'historique d'exploration de chaque graine, suivez les informations du lien, mettez régulièrement à jour le cycle de mise à jour de la graine en fonction des caractéristiques du lien externe de la graine et recalculez le cycle de mise à jour de la graine.

Système d'exploration et analyse JavaScript : utilisez le navigateur pour explorer et créer un cluster d'exploration basé sur l'exploration du navigateur. Ou adoptez un projet open source tel que Qtwebkit.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Quels sont les quatre outils d'analyse du Big Data ?

Quels sont les quatre outils d'analyse du Big Data ?

Nodejs implémente le robot d'exploration

Nodejs implémente le robot d'exploration

qq voix

qq voix

Codes couramment utilisés en langage HTML

Codes couramment utilisés en langage HTML

Comment dessiner des lignes pointillées dans PS

Comment dessiner des lignes pointillées dans PS

Quel est le format du caj

Quel est le format du caj

shib coin dernières nouvelles

shib coin dernières nouvelles

Solution à l'invite de table de partition non valide au démarrage de Windows 10

Solution à l'invite de table de partition non valide au démarrage de Windows 10