Le sujet le plus passionnant dans le monde de la technologie en 2016 est de savoir comment la réalité virtuelle va changer le monde. Certains films ont commencé à s'impliquer dans la réalité virtuelle, permettant aux utilisateurs non seulement de voir des images 3D, mais également de s'immerger dans la scène en utilisant la technique de « transformation », apportant une expérience visuelle immersive sans précédent. De plus, le domaine du jeu a également commencé ; pour devenir VR, les utilisateurs n'ont plus à supporter une seule scène dans un package de jeu. Ces effets sympas laissent un immense espace à l'imagination et la réalité virtuelle se rapproche de la vie des gens. Cependant, la réalité est qu'en plus de découvrir occasionnellement les merveilles de la technologie noire, la VR n'est pas vraiment devenue populaire. Derrière l'enthousiasme des fabricants de capitaux et de matériel, les doutes montent également les uns après les autres.

À l'heure actuelle, bien que le développement du matériel VR soit sur la voie rapide, le contenu est très mince. Le coût d’un film VR est assez élevé et les jeux VR ne le sont pas moins. Le coût élevé de la création de contenu a conduit à la notoriété de la réalité virtuelle. Afin de se débarrasser de sa splendeur aristocratique et de s'introduire dans les foyers des gens ordinaires, la réalité virtuelle doit encore résoudre le problème de l'offre de contenu. Le développement de la technologie Web représentée par HTML5 pourrait sortir de cette impasse. Actuellement, les derniers navigateurs Google Chrome et Mozilla Firefox ont ajouté la prise en charge de la fonction WebVR pour la technologie HTML5, et toutes les parties élaborent et enrichissent les dernières normes API WebVR du secteur. Ces normes de réalité virtuelle basées sur le Web réduiront davantage les coûts de création technique et les seuils du contenu VR, et aideront les développeurs HTML5 (JavaScript), le plus grand groupe de développeurs au monde, à entrer dans le domaine de la création de contenu VR. Il s’agit non seulement d’une avancée significative dans le développement de la technologie Web, mais cela crée également une opportunité pour le décollage de la réalité virtuelle.

Avantages de la réalité virtuelle côté Web

Le Web peut abaisser le seuil de l'expérience VR

La technologie Web rend non seulement le coût de création de la réalité virtuelle moins cher, mais réduit également considérablement les coûts techniques seuil. S'appuyant sur le développement rapide de la technologie WebGL, Web VR utilise le GPU pour effectuer des calculs et la technologie des moteurs de jeu pour optimiser les API au niveau de la puce, ce qui améliore les capacités informatiques de rendu graphique et réduit considérablement le seuil permettant aux développeurs d'entrer dans le domaine de la réalité virtuelle. , Web VR peut également être mieux combiné à la technologie du cloud computing, il complète la puissance de calcul des terminaux VR et améliore l'expérience interactive.

Il est certain que le Web a élargi la portée de l'utilisation de la réalité virtuelle. Un certain nombre de cas innovants ont émergé dans les domaines de la publicité et du marketing, de la vidéo panoramique, et de nombreux contenus orientés vers la vie ont également été incorporés dans la réalité virtuelle. création, comme le tourisme réel et les actualités, les rapports, les achats virtuels, etc., leur affichage de contenu et leur interaction peuvent être facilement créés par le moteur HTML5. Cela laissera sans aucun doute plus de place à l’imagination pour son développement futur.

La base de développeurs Web est énorme

En plus de ses avantages de mise en œuvre technique, le Web peut également apporter un énorme pouvoir d'innovation à la VR car il dispose d'un large éventail d'applications et d'un développement énorme. La base d'utilisateurs peut aider la technologie VR à gagner une guerre populaire, de sorte que la VR ne soit plus seulement un jeu capital pour les magnats de l'industrie, mais entre dans tous les aspects de la vie quotidienne des utilisateurs de manière civile.

Je crois qu'avec le temps, les applications VR seront comme les applications omniprésentes d'aujourd'hui, avec l'aide du faible seuil de développement Web, un grand nombre de développeurs VR entreront tous en même temps. des sortes d'idées étranges et étranges émergeront dans un flux sans fin, et la réalité virtuelle deviendra des outils commerciaux nécessaires pour les commerçants en ligne, etc. Si elle atteint ce stade, la VR ne sera pas loin d’une véritable prospérité.

Développer du contenu VR côté Web

Ensuite, nous utiliserons des opérations pratiques pour produire réellement du contenu VR côté Web et découvrir les avantages pratiques de WebVR. Nous savons que de nombreuses expériences VR sont présentées sous forme d’applications, ce qui signifie que vous devez les rechercher et les télécharger avant de pouvoir expérimenter la VR. Web VR change cette forme, il déplace l'expérience VR dans le navigateur, Web VR = WebVR. Avant d’entrer dans la pratique, analysons d’abord l’état technique de la mise en œuvre de WebVR.

Méthodes de développement WebVR

Il existe trois façons de développer des applications VR sur le Web :

HTML5 Java Scnipt WebGL API WebVR

Moteur traditionnel Emscripten [1 ]

Outils tiers, tels que A-Frame[2]

La première méthode consiste à utiliser WebGL combiné avec l'API WebVR, basée sur des applications 3D Web classiques via l'API et la VR les appareils interagissent pour obtenir l’implémentation VR correspondante. La deuxième méthode est basée sur le contenu de développement de moteurs traditionnels, tels que Unity, Unreal, etc., utilisant Emscripten pour transplanter le code C/C dans la version Java Scnipt, réalisant ainsi la réalité virtuelle sur le Web. La troisième méthode consiste à encapsuler la première méthode et à produire spécifiquement du contenu VR côté Web pour les utilisateurs ordinaires qui n'ont aucune base de programmation. Dans cet article, nous prenons principalement les première et troisième méthodes comme exemples pour illustrer.

WebVR Draft

WebVR est une API JavaScript ancienne et expérimentale qui fournit des API pour accéder aux fonctions des appareils VR tels que Oculus Rift, HTC Vive et Google Cardboard. Les applications VR nécessitent des interfaces de haute précision et à faible latence pour offrir une expérience acceptable. Pour les interfaces telles que Device Orientation Event, même si une entrée VR peu profonde peut être obtenue, elle ne fournit pas les exigences de précision nécessaires pour une VR de haute qualité. WebVR fournit une interface dédiée pour accéder au matériel VR, permettant aux développeurs de créer des expériences VR confortables.

L'API WebVR est actuellement disponible pour Oculus Rift avec Firefox installé la nuit, une version expérimentale de Chrome et le navigateur Samsung Gear VR.

Utilisez A-Frame pour développer du contenu VR

Si vous souhaitez expérimenter le développement WebVR avec un seuil inférieur, vous pouvez utiliser le framework A-Frame développé par l'équipe MozVR. A-Frame est un framework WebVR open source permettant de créer des expériences VR via HTML. Les scènes VR créées via ce framework sont compatibles avec les smartphones, les PC, l'Oculus Rift et le HTC Vive. L'équipe MozVR a développé le framework A-Frame pour faciliter et accélérer la création de scènes 3D/VR, afin d'attirer la communauté de développement Web dans l'écosystème WebVR. Pour que WebVR réussisse, il a besoin de contenu. Mais il n’existe actuellement qu’un petit nombre de développeurs WebGL, mais il existe des millions de développeurs et concepteurs Web. A-Frame veut donner à chacun le pouvoir de créer du contenu 3D/VR. Il présente les avantages et caractéristiques suivants :

A-Frame peut réduire le code redondant. Le code redondant et complexe est devenu un obstacle pour les premiers utilisateurs. A-Frame réduit le code complexe et redondant à une seule ligne de code HTML. Si vous créez une scène, vous n'avez besoin que d'une seule balise

A-Frame est spécialement conçu pour les développeurs Web. Il est basé sur DOM, il peut donc exploiter du contenu 3D/VR comme les autres applications Web. Bien entendu, il peut également être utilisé avec des frameworks JavaScript tels que box, d3 et React.

A-Frame structure le code. Le code Three.js est généralement lâche et A-Frame construit un système de composants d'entité déclaratif au-dessus de Three.js. De plus, les composants peuvent être publiés et partagés afin que d'autres développeurs puissent les utiliser sous forme HTML.

Le code est implémenté comme suit :

// 引入A-Frame框架<script src="./aframe.min.js"></script><a-scene>

<!-- 定义并创建球体 -->

<a-sphere position="0 1 -1" radius="1" color="#EF2D5E"></a-sphere>

<!-- 定义交创建立方体 -->

<a-box width="1" height="1" rotation="0 45 0" depth="1" color="#4CC3D9" position="-1 0.5 1"></a-box>

<!-- 定义并创建圆柱体 -->

<a-cylinder position="1 0.75 1" radius="0.5" height="1.5" color="#FFC65D"></a-cylinder>

<!-- 定义并创建底板 -->

<a-plane rotation="-90 0 0" width="4" height="4" color="#7BC8A4"></a-plane>

<!-- 定义并创建基于颜色的天空盒背景-->

<a-sky color="#ECECEC"></a-sky>

<!-- 设置并指定摄像机的位置 -->

<a-entity position="0 0 4">

<a-camera></a-camera>

</a-entity></a-scene>Utiliser Three.js pour développer du contenu VR

Comme mentionné ci-dessus, nous avons mentionné une autre méthode qui est plus proche du bas. Dans le même temps, un moyen plus flexible de produire du contenu WebVR consiste à utiliser directement l'API WebGL WebVR. L'avantage de cette méthode par rapport à A-Frame est que la prise en charge de la réalité virtuelle peut être facilement introduite dans notre propre moteur Web3D. En même temps, davantage d'opérations d'optimisation peuvent être effectuées sur la couche inférieure, en particulier le module de rendu, pour améliorer les performances et l'expérience. du temps d'exécution VR.

Peu importe si vous n'avez pas votre propre moteur Web3D. Vous pouvez directement utiliser des frameworks de rendu matures, tels que Three.js et Babylon.js. Ce sont des moteurs de rendu Web3D (frameworks) populaires et excellents. ). Ensuite, nous prendrons Three.js comme exemple pour expliquer comment produire du contenu WebVR dessus.

Tout d'abord, les trois éléments de tout programme de rendu sont similaires, à savoir l'établissement d'une scène, d'un moteur de rendu et d'une caméra. L'opération de paramétrage du moteur de rendu, de la scène et de la caméra est la suivante :

var renderer = new THREE.WebGLRenderer({antialias: true});

renderer.setPixelRatio(window.devicePixelRatio);

document.body.appendChild(renderer.domElement);

// 创建Three.js的场景

var scene = new THREE.Scene();

// 创建Three.js的摄像机

var camera = new THREE.PerspectiveCamera(60, window.innerWidth / window.innerHeight, 0.1, 10000);

// 调用WebVR API中的摄像机控制器对象,并将其与主摄像机进行绑定

var controls = new THREE.VRControls(camera);

// 设置为站立姿态controls.standing = true;

// 调用WebVR API中的渲染控制器对象,并将其与渲染器进行绑定

var effect = new THREE.VREffect(renderer);

effect.setSize(window.innerWidth, window.innerHeight);// 创建一个全局的VR管理器对象,并进行初始化的参数设置

var params = {

hideButton: false, // Default: false.

isUndistorted: false // Default: false.

};

var manager = new WebVRManager(renderer, effect, params);Le code ci-dessus complète les paramètres d'initialisation avant le rendu. Ensuite, vous devez ajouter des objets modèles spécifiques à la scène. Les principales opérations sont les suivantes :

function onTextureLoaded(texture) {

texture.wrapS = THREE.RepeatWrapping;

texture.wrapT = THREE.RepeatWrapping;

texture.repeat.set(boxSize, boxSize);

var geometry = new THREE.BoxGeometry(boxSize, boxSize, boxSize);

var material = new THREE.MeshBasicMaterial({

map: texture,

color: 0x01BE00,

side: THREE.BackSide

});

// Align the skybox to the floor (which is at y=0).

skybox = new THREE.Mesh(geometry, material);

skybox.position.y = boxSize/2;

scene.add(skybox);

// For high end VR devices like Vive and Oculus, take into account the stage

// parameters provided.

setupStage();

}

// Create 3D objects.

var geometry = new THREE.BoxGeometry(0.5, 0.5, 0.5);

var material = new THREE.MeshNormalMaterial();

var targetMesh = new THREE.Mesh(geometry, material);

var light = new THREE.DirectionalLight( 0xffffff, 1.5 );

light.position.set( 10, 10, 10 ).normalize();

scene.add( light );

var ambientLight = new THREE.AmbientLight(0xffffff);

scene.add(ambientLight);

var loader = new THREE.ObjectLoader();

loader.load('./assets/scene.json', function (obj){

mesh = obj;

// Add cube mesh to your three.js scene

scene.add(mesh);

mesh.traverse(function (node) {

if (node instanceof THREE.Mesh) {

node.geometry.computeVertexNormals();

}

});

// Scale the object

mesh.scale.x = 0.2;

mesh.scale.y = 0.2;

mesh.scale.z = 0.2;

targetMesh = mesh;

// Position target mesh to be right in front of you.

targetMesh.position.set(0, controls.userHeight * 0.8, -1);

});La dernière opération consiste à définir la mise à jour dans requestAnimationFrame. Dans la fonction d'animation, nous devons obtenir en permanence les informations renvoyées par le HMD et mettre à jour la caméra.

// Request animation frame loop functionvar lastRender = 0;function animate(timestamp) {

var delta = Math.min(timestamp - lastRender, 500);

lastRender = timestamp;

// Update VR headset position and apply to camera.

//更新获取HMD的信息

controls.update();

// Render the scene through the manager.

//进行camera更新和场景绘制

manager.render(scene, camera, timestamp);

requestAnimationFrame(animate);

}Expériences et idées

Grâce à l'introduction ci-dessus, nous pouvons essentiellement implémenter une application VR côté Web avec une expérience interactive préliminaire, mais ce n'est que la première étape de mise en œuvre purement technique. est loin d'être réel. Il existe encore un certain écart en termes d'ingénierie. Car après l'ingénierie finale, le produit orienté utilisateur doit prendre en compte des éléments plus précis que le prototype technique, comme la qualité du rendu, la fluidité de l'interaction, l'immersion de la virtualisation, etc., qui déterminent in fine si les utilisateurs continueront à utiliser le produit et l'accepter. Les services fournis par le produit, etc., il y a donc encore beaucoup de travail d'optimisation et d'amélioration à faire avant que la technologie ci-dessus puisse être appliquée en ingénierie. Voici quelques expériences personnelles dans le processus de création d’applications VR côté Web, qui sont partagées à titre de référence pour les lecteurs.

Sélection du moteur. Si vous utilisez un moteur WebGL existant, vous pouvez vous référer à la documentation dans [5] pour l'intégration du SDK VR. Ici, vous devez rendre la couche moteur compatible avec la couche VR SDK et intégrer le mode VR avec la partie outil du moteur. Vous pouvez également vous référer au modèle de développement de moteurs de bureau tels que Unity3D et Unreal sur l'intégration du SDK VR. Si vous choisissez un moteur WebGL tiers, vous pouvez choisir parmi Three.js ou Babylon.js. Ces moteurs WebGL grand public ont (certaines fonctions) intégrées au SDK VR.

Appareil débogué. Le débogage d'applications VR sur le Web nécessite également la prise en charge d'appareils VR spécifiques. Pour le contenu WebM de bureau, vous devriez essayer d'utiliser des appareils VR hautement immersifs tels que HTC Vive ou Oculus. Pour les applications Web mobiles, en raison des grandes différences entre les navigateurs sur la plate-forme Android, les performances seront incohérentes. Il est donc recommandé d'utiliser des appareils iOS pour le développement et le débogage. Cependant, davantage d'appareils Android doivent être adaptés avant la version finale. tests et optimisation.

Optimisation des performances. Lors du dessin et du rendu 3D sur le Web, les performances restent le principal goulot d'étranglement. Par conséquent, les performances du rendu en temps réel doivent être améliorées autant que possible, afin de laisser davantage de ressources pour la partie VR. Le WebVR actuel n'a pas la capacité d'appeler de nombreuses interfaces sous-jacentes au GPU pour une optimisation en profondeur telle que le rendu stéréo en temps réel comme le SDK VR de bureau, il consomme donc toujours beaucoup de performances.

Problèmes connus. À l'heure actuelle, WebVR est encore instable et présente de nombreux bugs. Par exemple, le suivi des appareils peut être perdu dans certains cas et l'efficacité n'est pas très élevée. La plupart des applications WebVR peuvent être utilisées comme réserves et comme pré-recherche pour des produits ultérieurs, mais il reste encore un long chemin à parcourir avant de pouvoir lancer des produits réellement utilisables par les utilisateurs et offrir une expérience fluide.

Autant jeter un oeil au processus de développement d'une DÉMO VR.

Ce qui suit est une brève introduction aux liens de développement qui pourraient vous préoccuper :

1. Concernant le développement d'un projet. d'une certaine taille Le temps nécessaire à la DÉMO VR

Il y a soixante jours, un livre intitulé "UNITY du débutant au maître" était posé sur la table dans notre salle de conférence. Nous ne savions pas si ce temps de développement était un. bonne chose ou pas. Il est facile pour les gens de penser que c'est une autre chose créée par "China Speed".

Plus tard, nous sommes passés au moteur UE. Bien sûr, UE peut être très heureux de voir à quel point notre moteur est efficace, à quel point le plan est pratique et à quel point les ressources du centre commercial sont faciles à utiliser. ...

Il convient également de souligner que ces 60 jours n'ont pas réellement commencé avec zéro fondement. Notre équipe est relativement plus âgée, presque 30 ans. Ils ont tous dix ans d'expérience de base en art 3D. a joué le rôle de partie B pendant longtemps. En conséquence, c'est mieux en termes de mise en œuvre technologique et de concept de temps. De plus, c’est parce que je crée quelque chose moi-même, donc tout le monde s’y investit davantage. Je dis donc que c'est une période étrange et heureuse, mais bien sûr le prix payé est également très élevé. Durant cette période, nous n'avons reçu aucune nouvelle commande commerciale.

2. Concernant le moteur à utiliser pour le développement VR

En fait, le moteur à utiliser n'a pas vraiment d'importance, j'ai également vu divers articles intelligents des maîtres sur Zhihu avant d'en discuter. que ce soit pour utiliser UE ou UNITY pour le développement VR, l'opinion est presque unilatérale en faveur de UNITY. Semblable à l'utilisation de UE, vous tomberez dans un piège... Mais nous avons étudié pendant un certain temps et avons estimé que nous étions toujours adaptés. utiliser l'UE, et maintenant nous vivons toujours relativement heureux. L'histoire de "Petit Poney traversant la rivière" est L'avez-vous lu ?

J'ai rappelé les outils que nous utilisions auparavant : MAX et MAYA. Les deux sont bons, selon l'usage que vous en faites. Si vous faites de l'animation architecturale, utilisez MAX car il est rapide ; si vous réalisez des films d'animation basés sur des personnages, utilisez MAYA. Le module d'action est facile à utiliser et permet de le faire. collaboration en équipe.

De plus, l'UE y travaille désormais très dur En regardant ses tutoriels officiels, on voit que le centre commercial y a mis beaucoup d'efforts, et l'outil de blueprint est également très adapté aux équipes. qui préfèrent une utilisation visuelle.

Cependant, le nombre de lectures sur le compte public officiel de l’UE est à chaque fois incroyablement faible. Cela forme un contraste intéressant avec un thème VR si en vogue en Chine. Je ne sais vraiment pas quel compte ils suivent.

Un autre gros problème est qu'il y a relativement peu de personnes en UE. Nous ne pouvons passer du temps à explorer que par nous-mêmes. Il est difficile de trouver des personnes toutes faites. Cette méthode est appelée impasse.

3. Avantages et inconvénients de l'équipe CG développant la VR

Je pense que notre avantage réside dans la conception visuelle. Par exemple, nous pensons que le contrôleur Vive en tant qu'outil interactif devrait également être différent dans différents domaines. thème de scénarios, donc divers beaux contrôleurs sont apparus, et je pense qu'ils peuvent tous être mis sur le centre commercial officiel.

Je pense que les parcours des développeurs de contenu VR en Chine peuvent être divisés en plusieurs types :

Le premier est la vidéo panoramique avec un seuil technique relativement bas. La plupart de ces parcours proviennent de la vie réelle. tournage. , le titre précédent était généralement réalisateur.

Le deuxième type est une société de jeux. L'avantage est que le programme et le flux de travail sont similaires à ceux de la VR, et il est facile à transformer techniquement. Mais ce qui est embarrassant, c'est que si vous souhaitez poursuivre les effets visuels, c'est ce qui se passe. Il est préférable de créer des jeux de nouvelle génération, mais en Chine, la plupart des jeux en ligne sont désormais basés sur les mobiles et les jeux de nouvelle génération sont principalement externalisés.

Le troisième type est issu de l'industrie CG du passé, qui est notre genre. L'avantage est que nous avons une plus grande recherche de visuels. Certaines équipes étrangères s'en sortent plutôt bien et ont suivi cette approche. auparavant, mais ils doivent être techniquement avancés. Certaines améliorations et transformations ont été apportées, mais heureusement, les principes sous-jacents sont similaires et peuvent être compris d'un seul coup d'œil.

Le quatrième type est une équipe de programmeurs. Leur avantage est qu'ils peuvent développer du code génial, écrire les shaders qu'ils veulent et obtenir les fonctions qu'ils veulent. Ce qui demande des efforts, c'est de savoir comment donner une belle apparence aux choses.

Le dernier est de dire qu'il fait de la VR.

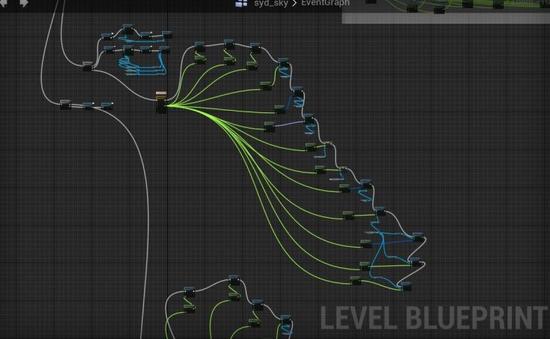

4. Plan du moteur UE

Le plan est un module visuel de programmation développé par UE spécifiquement pour améliorer l'efficacité du travail. Sans cela, notre DÉMO ne peut pas être produite. .

Donnez-moi un exemple :

Dans la seconde moitié de la DÉMO, vos bras se sont transformés en ailes. Vous avez agité vos ailes et vous avez volé dans le ciel lorsque vous êtes arrivé à un lac salé avec le. de la même couleur que l'eau et le ciel, tes ailes se sont transformées en plumes volant partout dans le ciel... une scène tellement romantique.

Pour réaliser cela, vous avez besoin de l'aide de plans. Bien sûr, notre annotation est très terre-à-terre, et ceux qui peuvent la comprendre la comprendront certainement.

En bref, il s'agit d'une DÉMO avec un plan complet sans écrire une seule ligne de code. Cela ne semble-t-il pas assez haut niveau ? En fait, quel est le but du plan de développement de l'UE ? N'est-il pas de vous permettre de vous concentrer sur des choses qui sont plus utiles à l'effet final ? Le processus qui convient à votre équipe est le bon processus.

5. Autre point technique : le processus PBR

Le processus PBR aurait été introduit par l'industrie du jeu après avoir appris de l'industrie du CG, mais j'ai honte que dans les étapes ultérieures de l'industrie du CG, nous ayons rarement exposé des UV en raison du type de projet.

Le système de matériaux PBR permet aux objets d'afficher des textures plus réalistes et des détails riches dans le moteur. Il s'agit également d'un système de matériaux courant pour cette génération de moteurs de jeu. Les artistes peuvent travailler davantage en conformité avec les principes d'éclairage du moteur. monde réel. La logique dessine la texture et ajuste la matière. La série de logiciels d'outils Substance Tools basée sur ce système intègre des textures, des matériaux, des shaders et d'autres systèmes de la collaboration d'outils multi-logiciels d'origine dans un système complet. Dans le même temps, le flux de travail flexible permet de gagner considérablement du temps de production et facilite la production de. les textures et les matériaux sérialisés. L'itération et la mise à jour rendent le processus de travail de cartographie des matériaux plus intuitif et efficace.

Grâce au logiciel Substance Painter, ce processus est bien meilleur que les allers-retours entre les textures d'aplatissement PS et MAX de nos premières années.

La technologie est très importante, mais face à une nouvelle méthode d'expérience audiovisuelle, la création est très importante, et c'est aussi un point difficile dans la conception d'expériences VR.

7. Concernant la sélection du sujet de l'expérience VR

Celui que nous avons choisi est en fait un thème relativement impopulaire. La plupart des thèmes VR que l'on peut voir actuellement concernent le tir au pistolet. J'étais plus intéressé par les thèmes culturels, et plusieurs de nos collègues étaient des passionnés d'aviation, j'ai donc choisi ce sujet.

Nous avons remarqué qu'il y avait une équipe étrangère sur STEAM qui avait fait l'expérience d'alunissage d'Apollo, nous l'avons donc téléchargé et étudié, mais nous avons pensé qu'il nous avait donné une mauvaise expérience. Je pense que cette équipe est un groupe de. les ingénieurs ennuyeux sont tellement ennuyeux que je ne peux pas le supporter. La production culturelle est quelque chose dans lequel nous sommes relativement bons. Cela peut avoir quelque chose à voir avec notre expérience professionnelle antérieure, et nous devrions utiliser les nouvelles technologies pour faire quelque chose de significatif. Il est nécessaire de vaincre les monstres, mais ce serait une erreur de simplement vaincre les monstres.

Ma propre conclusion est qu'il est préférable que le sujet soit quelque chose que vous aimez, sur lequel vous faites des recherches approfondies et qui soit adapté à l'expression VR.

8. En quoi le langage narratif de la VR sera-t-il différent d'avant

D'un point de vue créatif, dans le passé, le réalisateur tenait la caméra dans sa main et vous laissait regarder où vous vouliez ? , et il y a eu des montages, etc. Cela fait réfléchir ; mais dans le monde de la VR, vous êtes un participant en direct, et le réalisateur doit vous guider pour voir ce qu'il veut que vous voyiez et auquel vous participiez.

Nous avons participé à la planification et à l'exécution de nombreux événements en direct depuis 2008. Je pense que cette expérience est en fait similaire à la VR dans un grand espace, où il y a du bruit et de la lumière, comment guider la ligne de vue. et favoriser le développement de l'intrigue est une affaire délicate et amusante.

Je pense donc que le langage visuel de la VR n'est pas une approche cinématographique, mais une approche événementielle ou performance en direct.

En termes de processus technique, les postes de composition et d'édition d'origine ont été supprimés, mais ils ne sont pas complètement retirés, mais ils ont simplement modifié la plate-forme d'édition non linéaire qui est en fait ajoutée à l'UE. , et vous pouvez également avoir des filtres de post-production et des trucs vraiment intéressants.

9. À propos du processus et de la division du travail

Il y aura environ 20 personnes impliquées avant et après. La plupart des personnes seront concentrées dans la position des matériaux d'art 3D, ce qui est similaire. à la répartition du personnel de développement de jeux. Il y a un directeur, notre honnête professeur Pu An, qui coordonnera le tout et assurera le contrôle artistique. Ensuite, d'autres collègues et moi travaillerons ensemble pour faire avancer le processus technique.

Fondamentalement parlant, ce sujet est peut-être un peu trop vaste pour commencer. L'avantage est que l'ensemble du langage de l'audition sera abordé de manière plus complète et approfondie. L'inconvénient est qu'il nécessite beaucoup de ressources. Bien que nous ayons développé beaucoup de ressources au cours des dix dernières années, Zhong est une équipe particulièrement douée pour construire de gros volumes et vendre d'excellents produits. Cependant, compte tenu du temps limité, certaines ressources peuvent ne pas être suffisamment précises. Il serait préférable que nous disposions de plus de temps. J'ai eu la chance de ne pas rencontrer d'embûches dont je m'attendais à ce qu'il soit impossible de sortir, et j'ai toujours transformé le désastre en bonne chance. Par exemple, au début, je pensais qu'un grand nombre d'objets finiraient par rester coincés, mais grâce à un chargement et à une dissimulation raisonnables, le problème a été résolu. la fréquence d'images était toujours correcte, c'est-à-dire que la capacité de charge du moteur est en fait meilleure que ce que nous avions imaginé.

La différence entre la charge rapide PD et la charge rapide générale

La différence entre la charge rapide PD et la charge rapide générale

Comment générer un fichier bin avec mdk

Comment générer un fichier bin avec mdk

À quelle devise appartient l'USDT ?

À quelle devise appartient l'USDT ?

puce FAI

puce FAI

Que dois-je faire si chaturbate est bloqué ?

Que dois-je faire si chaturbate est bloqué ?

Qu'est-ce qu'un lecteur optique

Qu'est-ce qu'un lecteur optique

ps quitter la touche de raccourci plein écran

ps quitter la touche de raccourci plein écran

Éléments de base des présentations

Éléments de base des présentations