Sur la base de données cliniques limitées, des centaines d'algorithmes médicaux ont été approuvés. Les scientifiques se demandent qui devrait tester les outils et comment le faire au mieux.

Qui teste les systèmes d'IA médicale ?

Les applications médicales basées sur l'IA, comme celle que Singh développe, sont souvent considérées comme des dispositifs médicaux par les organismes de réglementation des médicaments, notamment la FDA américaine et l'Agence britannique de réglementation des médicaments et des produits de santé. Par conséquent, les normes d’examen et d’autorisation d’utilisation sont généralement moins strictes que celles applicables aux produits pharmaceutiques. Seul un petit sous-ensemble de dispositifs, ceux qui peuvent présenter un risque élevé pour les patients, nécessitent des données d'essais cliniques pour être approuvés.

Beaucoup de gens pensent que le seuil est trop bas. Lorsque Gary Weissman, médecin de soins intensifs à l'Université de Pennsylvanie à Philadelphie, a examiné les appareils d'IA approuvés par la FDA dans son domaine, il a constaté que sur les dix appareils qu'il a identifiés, seuls trois citent des données publiées dans leur autorisation. Seuls quatre d'entre eux ont mentionné une évaluation de la sécurité, et aucun n'incluait une évaluation des biais, qui analyse si les résultats de l'outil sont équitables pour différents groupes de patients. "Le problème est que ces appareils peuvent avoir un impact sur les soins au chevet du patient", a-t-il déclaré. "La vie des patients peut dépendre de ces décisions.

Le manque de données rend difficile pour les hôpitaux et les systèmes de santé de décider d'utiliser ou non ces technologies." Dans une situation difficile. Dans certains cas, des incitations financières entrent en jeu. Aux États-Unis, par exemple, les régimes d’assurance maladie remboursent déjà aux hôpitaux l’utilisation de certains dispositifs médicaux d’IA, ce qui les rend financièrement attractifs. Ces institutions peuvent également être enclines à adopter des outils d’IA qui promettent des économies de coûts, même s’ils n’améliorent pas nécessairement les soins aux patients.

Ouyang a déclaré que ces incitations pourraient empêcher les entreprises d’IA d’investir dans les essais cliniques. « De nombreuses entreprises commerciales peuvent imaginer qu’elles vont travailler plus dur pour s’assurer que leurs outils d’IA sont remboursables », a-t-il déclaré.

La situation peut varier selon les marchés. Au Royaume-Uni, par exemple, un plan national de santé financé par le gouvernement pourrait fixer des seuils de preuve plus élevés avant que les centres médicaux puissent acheter des produits spécifiques, a déclaré Xiaoxuan Liu, chercheur clinicien à l'Université de Birmingham qui étudie l'innovation responsable en matière d'intelligence artificielle. une incitation à mener des essais cliniques. "

Une fois qu'un hôpital achète un produit d'IA, il n'a pas besoin de procéder à des tests supplémentaires et peut l'utiliser immédiatement comme les autres logiciels. Cependant, certaines agences reconnaissent que l’approbation réglementaire ne garantit pas que le dispositif sera réellement bénéfique. Ils ont donc choisi de le tester eux-mêmes. Actuellement, bon nombre de ces efforts sont menés et financés par des centres médicaux universitaires, a déclaré Ouyang.

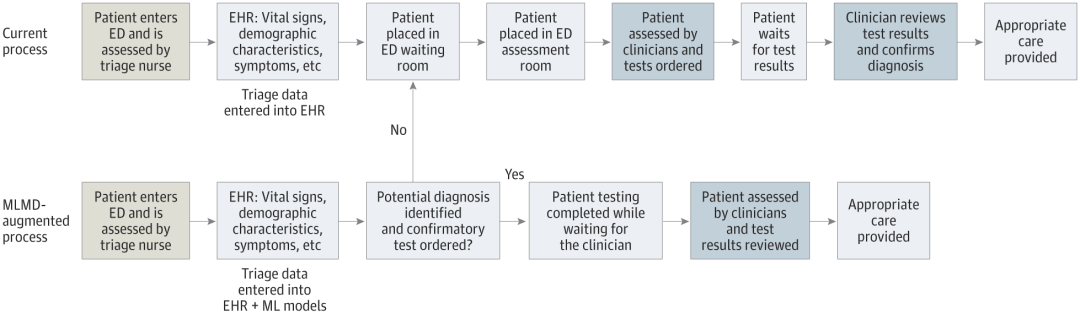

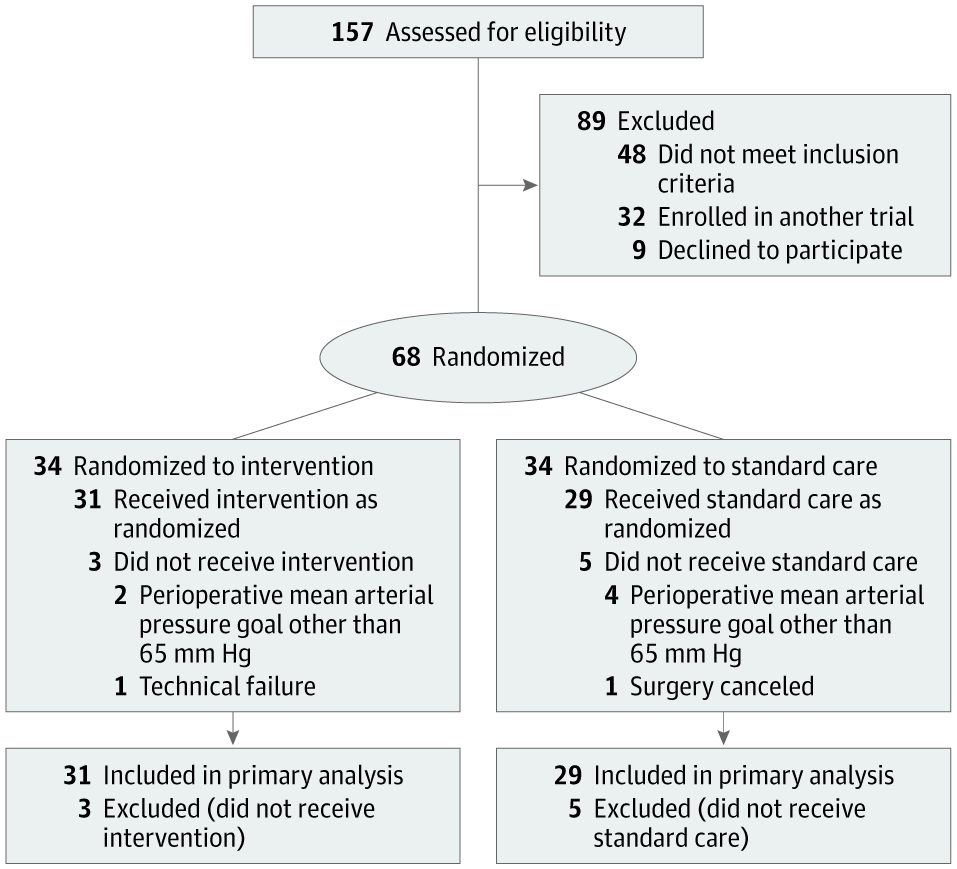

Alexander Vlaar, directeur médical des soins intensifs au centre médical universitaire d'Amsterdam, et Denise Veelo, anesthésiste dans la même institution, ont lancé une telle initiative en 2017. Leur objectif était de tester un algorithme conçu pour prédire la survenue d’une hypotension lors d’une intervention chirurgicale. Cette condition, connue sous le nom d'hypotension peropératoire, peut entraîner des complications potentiellement mortelles telles que des lésions du muscle cardiaque, une crise cardiaque et une insuffisance rénale aiguë, voire la mort.

L'algorithme, développé par Edwards Lifesciences, basé en Californie, utilise les données de forme d'onde artérielle – les lignes rouges avec des pics et des creux affichées sur les moniteurs des services d'urgence ou des unités de soins intensifs. La méthode peut prédire l’hypotension quelques minutes avant qu’elle ne se produise, permettant ainsi une intervention précoce.

Pada masa ini, kebanyakan alatan AI perubatan membantu profesional penjagaan kesihatan dengan pemeriksaan, diagnosis atau perancangan rawatan. Pesakit mungkin tidak menyedari bahawa teknologi ini sedang diuji atau digunakan secara rutin dalam penjagaan mereka, dan tiada negara pada masa ini memerlukan penyedia penjagaan kesihatan untuk mendedahkan perkara ini.

Perdebatan berterusan mengenai perkara yang perlu diberitahu kepada pesakit tentang teknologi kecerdasan buatan. Beberapa apl ini telah mendorong isu persetujuan pesakit menjadi perhatian pembangun. Begitulah halnya dengan peranti kecerdasan buatan yang sedang dibangunkan oleh pasukan Singh untuk menyelaraskan penjagaan kanak-kanak di bilik kecemasan SickKids.

Apa yang sangat berbeza tentang teknologi ini ialah ia menyingkirkan doktor daripada keseluruhan proses, membenarkan kanak-kanak (atau ibu bapa atau penjaga mereka) menjadi pengguna akhir.

“Apa yang dilakukan oleh alat ini ialah mengambil data percubaan kecemasan, membuat ramalan dan memberi kelulusan terus kepada ibu bapa — ya atau tidak — jika anak mereka boleh diuji,” kata Singh. Ini mengurangkan beban doktor dan mempercepatkan keseluruhan proses. Tetapi ia juga membawa banyak masalah yang tidak pernah berlaku sebelum ini. Siapa yang bertanggungjawab jika berlaku masalah kepada pesakit? Siapa yang membayar jika ujian yang tidak perlu dilakukan?

« Nous devons obtenir le consentement éclairé des familles de manière automatisée. » a déclaré Singh, et le consentement doit être fiable et authentique. "Cela ne peut pas être comme lorsque vous vous inscrivez sur les réseaux sociaux et que vous avez 20 pages de petits caractères et que vous cliquez simplement sur Accepter.

Pendant que Singh et ses collègues attendent un financement pour démarrer des essais sur des patients, l'équipe travaille avec les services juridiques." experts et Engager l'organisme de réglementation du pays, Santé Canada, à examiner ses propositions et à considérer les implications réglementaires. Actuellement, « le paysage réglementaire ressemble un peu au Far West », a déclaré Anna Goldenberg, informaticienne et coprésidente de la SickKids' Children's Medical Artificial Intelligence Initiative.

Les établissements médicaux adoptent prudemment les outils d'IA et effectuent des tests autonomes.

Les facteurs de coût ont incité les chercheurs et les établissements médicaux à explorer des alternatives.

Les grands établissements médicaux ont moins de difficultés, tandis que les petits établissements sont confrontés à de plus grands défis.

La Mayo Clinic teste un outil d’IA à utiliser dans les établissements de soins de santé communautaires.

La Health AI Alliance a créé un laboratoire de garantie pour évaluer le modèle.

Duke University propose des capacités de tests internes pour vérifier localement les modèles d'IA.

La radiologue Nina Kottler souligne l'importance d'une vérification locale.

Les facteurs humains doivent être pris en compte pour garantir l'exactitude de l'intelligence artificielle et des utilisateurs finaux.

Contenu de référence : https://www.nature.com/articles/d41586-024-02675-0

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Quelles sont les touches de raccourci couramment utilisées dans WPS ?

Quelles sont les touches de raccourci couramment utilisées dans WPS ? Solution à l'absence de son dans le système Win7

Solution à l'absence de son dans le système Win7 Où puis-je me procurer le costume Douyin Little Fire Man ?

Où puis-je me procurer le costume Douyin Little Fire Man ? outil de test d'application

outil de test d'application Comment débloquer un téléphone Oppo si j'ai oublié le mot de passe

Comment débloquer un téléphone Oppo si j'ai oublié le mot de passe Comment ouvrir le fichier DB

Comment ouvrir le fichier DB Utilisation de && et || en langage C

Utilisation de && et || en langage C Robot d'exploration Web

Robot d'exploration Web