Bonjour les amis, je m'appelle Luga, aujourd'hui nous parlerons des technologies liées au domaine écologique de l'intelligence artificielle (IA) - cadre de développement LLM.

Dans le domaine du développement d'applications LLM (Large Scale Language Model), les frameworks open source jouent un rôle essentiel, fournissant un support d'outils puissant aux développeurs. En tant que leader dans ce domaine, LangChain a été largement salué pour sa conception innovante et ses fonctionnalités complètes. Mais dans le même temps, certains cadres alternatifs ont également émergé, offrant de meilleurs choix pour répondre aux besoins dans différents scénarios.

Après tout, tout framework a inévitablement certaines limites. Par exemple, l'abstraction rapide de LangChain peut rendre le démarrage plus difficile dans certains cas, l'expérience de débogage doit être améliorée et la qualité de certains codes mérite également d'être améliorée. C'est exactement la direction vers laquelle travaillent les produits alternatifs. Ils s'efforcent de créer une expérience de création d'applications plus pratique et plus efficace pour les développeurs en optimisant la conception architecturale, en améliorant les pratiques d'ingénierie, en renforçant le soutien de la communauté, etc.

Il s'agit d'un framework open source populaire, LangChain est conçu pour aider les développeurs à créer des applications d'intelligence artificielle. LangChain simplifie le processus de développement d'applications basées sur LLM (LangLink Model) en fournissant des interfaces standard pour le chaînage, les proxys et les modules de mémoire.

Dans les scénarios d'application pratiques, le framework LangChain+ est particulièrement utile pour créer rapidement des preuves de concept (POC). Cependant, l’utilisation de n’importe quel framework comporte certains défis. Plus précisément comme suit :

Dans la recrudescence du développement et de l'application de LLM (modèle de langage à grande échelle), l'évaluation et l'autorisation des avantages de différentes plates-formes d'outils seront un maillon crucial. Une analyse complète basée sur sept dimensions clés, notamment l'ingénierie rapide, l'intégration des données, l'orchestration des flux de travail, la visualisation des tests, les indicateurs d'évaluation, la préparation à la production et la gestion du cycle de vie, est sans aucun doute une idée et une orientation très prospectives et systématiques.

Ensuite, nous procéderons à une analyse détaillée une par une :

Il ne fait aucun doute qu'une ingénierie rapide de haute qualité est la condition préalable et la pierre angulaire pour exploiter pleinement le potentiel du LLM. Une plate-forme d'outils idéale doit non seulement fournir une interface de construction d'invites concise et flexible, mais également intégrer des technologies avancées telles que la compréhension du langage naturel et l'analyse sémantique pour réaliser la génération et l'optimisation automatiques des invites, maximiser l'adaptation à des contextes de tâches spécifiques et réduire les coûts. d'intervention manuelle.

De plus, pour les tâches complexes en plusieurs étapes, la possibilité de prendre en charge la gestion paramétrée et le contrôle de version des invites sera également une considération importante.

La montée en puissance du paradigme RAG fait des fonctions efficaces d'intégration de bases de connaissances externes une capacité nécessaire pour les plates-formes d'outils. Une excellente plate-forme doit non seulement être capable de connecter et d'importer facilement diverses sources de données hétérogènes, mais également disposer de solides capacités de prétraitement des données et de contrôle qualité pour garantir l'exactitude et la cohérence de l'injection de connaissances. De plus, l’analyse visuelle et l’optimisation des résultats de recherche massifs amélioreront également considérablement l’efficacité du travail des développeurs.

Face à des exigences de tâches complexes dans le monde réel, il est généralement difficile pour un seul LLM de les réaliser de manière indépendante. Par conséquent, la capacité d’orchestrer de manière flexible le flux de travail de plusieurs modules de modèle et de réaliser des combinaisons différenciées grâce au contrôle des paramètres deviendra le cœur de la compétitivité de la plate-forme d’outils.

Dans le même temps, une bonne prise en charge de la gestion des versions de flux de travail, du réglage des paramètres, de la répétabilité et d'autres fonctionnalités améliorera également considérablement l'efficacité du développement.

En tant qu'IA typique de « boîte noire », le mécanisme interne du système LLM a toujours été déroutant. Une excellente plate-forme d'outils doit s'efforcer de briser cette limitation et de fournir des informations sur l'état interne du modèle grâce à des moyens tels que la visualisation de la répartition de l'attention et le suivi du chemin de raisonnement. Dans le même temps, elle doit prendre en charge un dépannage plus précis des erreurs, une correction des écarts et une optimisation des performances. , améliorant ainsi véritablement l'interprétabilité et la fiabilité du système.

Un processus d'évaluation strict est un élément clé pour garantir la qualité des candidatures LLM. À ce stade, l'infrastructure d'évaluation fournie par les différentes plateformes, les dimensions des indicateurs couvertes, le niveau d'automatisation et le degré d'intégration avec l'évaluation manuelle détermineront directement l'objectivité et l'autorité des résultats de l'évaluation.

D'une manière générale, un système d'évaluation mature fournira certainement une solide garantie de qualité pour la mise en œuvre réelle du produit final.

Pour les applications de qualité industrielle orientées vers les environnements de production, les capacités de déploiement, d'exploitation et de maintenance de la plate-forme d'outils seront une considération essentielle. Un mécanisme en ligne complet, des options de déploiement prises en charge (cloud, appareils de périphérie, etc.), la conformité en matière de sécurité, l'optimisation des performances, la surveillance et les alarmes ainsi que d'autres garanties de produits affecteront directement la disponibilité finale et la fiabilité du système LLM.

En tant que technologie innovante de pointe, l'intégration transparente de la plateforme LLM avec les piles technologiques d'entreprise existantes est une condition préalable pour garantir son application généralisée. Un énorme magasin d'applications tiers et une bibliothèque de ressources partenaires contribueront à créer un écosystème riche couvrant un plus large éventail de scénarios industriels et de besoins différenciés, favorisant ainsi la vulgarisation à grande échelle et l'application innovante de la technologie LLM.

Grâce à une analyse complète et à une comparaison des compromis des sept dimensions ci-dessus, nous pouvons évaluer de manière relativement objective les avantages et les inconvénients des différentes plates-formes d'outils de développement LLM. Par exemple, pour les scénarios axés sur des capacités d'ingénierie rapides, nous pourrions être plus enclins à choisir des plates-formes performantes dans ce domaine, tandis que pour les applications de niveau industriel qui nécessitent de solides garanties d'exploitation et de maintenance, des facteurs tels que le déploiement et la fiabilité seront pris en compte. dimensions de considération plus importantes.

Bien sûr, en plus des sept fonctionnalités fonctionnelles ci-dessus, nous devons également prendre en compte d'autres facteurs non fonctionnels, tels que la convivialité, la courbe d'apprentissage, la qualité des documents, l'activité de la communauté, l'itinéraire de développement, etc., en fonction des exigences spécifiques de la scène. et les habitudes de travail, pouvons-nous prendre une décision de sélection d'outils vraiment de haut niveau.

Dans le même temps, la vitalité et les capacités de développement durable de la plateforme d'outils sont également des perspectives indispensables. Une communauté de développement active, un plan de soutien commercial complet et un parcours d'innovation technologique continue nous fourniront un soutien fiable et à long terme. Après tout, le développement de la technologie LLM en est à ses balbutiements et les plates-formes d'outils doivent suivre le rythme de leur temps et s'adapter et adopter en permanence les nouvelles tendances de changement.

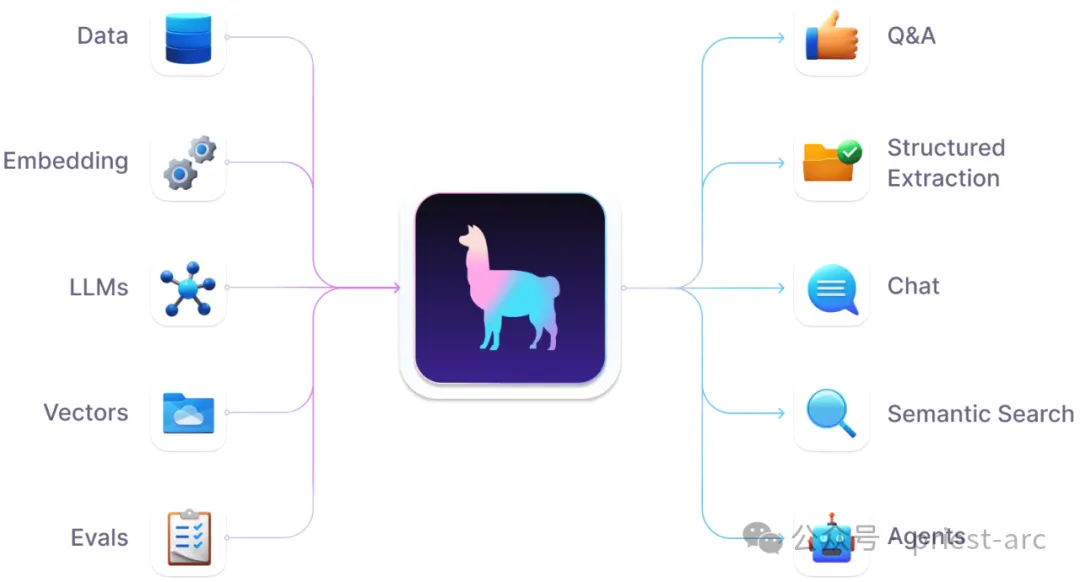

Dans la vague du LLM (Large Scale Language Model), l'architecture RAG (Retrieval Augmented Generation) devient de plus en plus le paradigme dominant. En tant que framework de données open source axé sur la création d'applications RAG, LlamaIndex présente sans aucun doute un potentiel de développement prometteur.

Frame de données LlamaIndex pour les applications LLM (Source : LlamaIndex)

Par rapport à des projets bien connus tels que Langchain, LlamaIndex offre aux utilisateurs plus d'efficacité et de professionnalisme grâce à son optimisation de terrain ciblée et à ses concepts de conception innovants. Expérience de développement d'applications RAG . Autant avoir une analyse plus approfondie de ses principales caractéristiques et avantages :

Tout d’abord, LlamaIndex fonctionne de manière exceptionnelle en matière d’ingestion et de prétraitement des données. Il est non seulement compatible avec une variété de formats de données structurés et non structurés, mais plus important encore, grâce à une segmentation de texte flexible, une vectorisation et d'autres mécanismes, il garantit que les données sont codées dans la mémoire LLM avec une haute qualité. Cela pose une base solide pour la compréhension contextuelle pendant la phase de génération.

Dans le même temps, LlamaIndex fournit une riche sélection de structures de données d'index et de stratégies de requête, permettant aux développeurs d'exploiter pleinement les avantages de l'efficacité des requêtes dans différents scénarios et d'obtenir une récupération sémantique haute performance. Cette optimisation ciblée est l’une des exigences clés des applications RAG.

Un autre point fort digne d’attention est la prise en charge naturelle de LlamaIndex pour les données multimodales (telles que les images, les vidéos, etc.). En s'intégrant aux principaux modèles sémantiques visuels, un contexte multimodal riche peut être introduit dans le processus de génération RAG, ajoutant de nouvelles dimensions au résultat. Nul doute que cela ouvrira la voie à de nombreuses applications innovantes.

En plus des fonctions de base de gestion des données, LlamaIndex se concentre également sur la pratique d'ingénierie du développement d'applications RAG. Il fournit des fonctionnalités avancées telles que les requêtes parallèles et la prise en charge de l'informatique distribuée basée sur Dask, qui améliorent considérablement l'efficacité du traitement des données et jettent les bases d'une production à grande échelle.

D'un point de vue architectural, LlamaIndex adhère au concept de conception modulaire et évolutif. Le système de plug-in flexible permet aux développeurs d'introduire facilement des chargeurs de données personnalisés, des séparateurs de texte, des index vectoriels et d'autres modules pour répondre pleinement aux besoins personnalisés dans différents scénarios.

De plus, l'intégration parfaite de l'écologie open source est également un avantage unique inhérent à LlamaIndex. Il dispose d'une prise en charge intégrée prête à l'emploi d'outils et de frameworks populaires tels que Hugging Face, FAISS, etc., permettant aux utilisateurs d'exploiter les capacités avancées d'IA/ML sans aucune barrière pour aider à créer efficacement des produits innovants.

En tant qu'outil de niveau professionnel ancré dans les applications RAG, LlamaIndex est devenu un excellent complément aux frameworks généraux tels que Langchain. Les développeurs peuvent désormais choisir librement entre le chemin efficace et optimisé de LlamaIndex et le paradigme général et flexible de Langchain en fonction des besoins réels, maximisant ainsi l'efficacité du développement et la qualité des produits.

Bien sûr, LlamaIndex est un projet jeune et dynamique après tout, et il y a encore beaucoup de place à l'amélioration et au développement. Par exemple, améliorer encore les capacités de modélisation de scénarios plus complexes, fournir des suggestions d'optimisation automatique plus intelligentes et renforcer l'accumulation de meilleures pratiques et de cas d'utilisation de référence seront autant d'orientations clés à l'avenir.

Dans le même temps, LlamaIndex continuera de suivre les derniers développements des architectures LLM et RAG et d'intégrer en temps opportun les innovations émergentes en matière de modèles et de paradigmes pour maintenir les normes de pointe de l'industrie dans toutes les dimensions. Rien de tout cela ne serait possible sans l'investissement à long terme et le soutien continu d'une communauté de développeurs active, d'entreprises partenaires de premier plan et de collègues de la communauté de la recherche scientifique.

Dans le domaine du développement d'applications LLM (modèle de langage à grande échelle), abaisser le seuil et améliorer l'efficacité ont toujours été les aspirations communes de l'industrie. En tant qu'outil de création d'applications LLM open source et sans code, Flowise devient un praticien puissant dans cette quête.

Différent des frameworks de développement de codage traditionnels, l'interface visuelle innovante par glisser-déposer de Flowise est son plus grand point fort. Les développeurs n'ont pas besoin de maîtriser en profondeur les langages de programmation. Il leur suffit de glisser-déposer des modules de composants prédéfinis sur l'interface, et grâce à une configuration et un câblage simples des paramètres, ils peuvent facilement créer de puissantes applications LLM. Ce nouveau paradigme de développement a considérablement abaissé la barrière à l'entrée, faisant du développement d'applications LLM le domaine exclusif des codeurs. Les utilisateurs ordinaires peuvent également exprimer leur créativité et réaliser leurs besoins d'automatisation.

Flowise AI Reference Flow (Source : Flowise)

Ce qui mérite d'être mentionné, c'est que Flowise n'est pas un simple outil low-code, mais est profondément intégré à LangChain, le meilleur framework de l'industrie, au niveau du noyau. Cela signifie que Flowise prend en charge nativement toutes les fonctions principales telles que la puissante orchestration LLM de LangChain, les applications chaînées et l'amélioration des données, et les expose entièrement à l'interface sans code via des composants glisser-déposer, garantissant la flexibilité et l'expansion du développement d'applications. capacité. Que vous construisiez un simple système de questions-réponses ou un processus d'analyse multimodal complexe, Flowise peut pleinement répondre à vos besoins.

En plus de ses fonctionnalités complètes, un autre avantage exceptionnel de Flowise est son intégration transparente avec l'écosystème existant. En tant que projet véritablement open source, Flowise fournit une prise en charge prête à l'emploi pour les modèles et chaînes d'outils LLM traditionnels, permettant aux développeurs d'utiliser ces capacités techniques sans aucun obstacle et de créer facilement des applications uniques et innovantes qui suivent le rythme.

Par exemple, Flowise est parfaitement compatible avec les modèles LLM grand public tels qu'Anthropic, OpenAI, Cohere, etc. Les utilisateurs peuvent appeler les capacités linguistiques les plus récentes et les plus puissantes avec une configuration simple en même temps, il est également compatible avec l'écologie d'intégration de données ; tels que Pandas, SQL, Web API, etc. Le support natif permet également aux applications d'accéder librement à de riches sources de données hétérogènes.

La chose la plus attrayante est que Flowise n'est pas un système fermé, mais fournit une API ouverte et un mécanisme d'intégration intégré. Les développeurs peuvent facilement intégrer les applications Flowise dans n'importe quel environnement de produit tel que des sites Web, des applications, des logiciels de bureau, etc., et accepter les demandes personnalisées de toutes les parties pour obtenir une expérience en boucle fermée de bout en bout.

On peut dire que Flowise, avec l'aide du puissant noyau technique de LangChain, de sa propre architecture visuelle flexible et de son intégration transparente avec l'écosystème, est devenu un lien puissant reliant le LLM aux utilisateurs finaux et favorisant le processus de démocratisation du LLM. Tout individu ou entreprise dans le besoin peut créer et déployer ses propres applications intelligentes en un seul clic sur la plateforme Flowis et profiter des améliorations de productivité apportées par l'IA.

En tant que framework léger et extensible, AutoChain s'appuie sur l'expérience de ses prédécesseurs tels que LangChain et AutoGPT pour offrir aux développeurs une expérience de création d'agents intelligents conversationnels plus efficace et plus flexible.

from autochain.agent.conversational_agent.conversational_agent import (ConversationalAgent,)from autochain.chain.chain import Chainfrom autochain.memory.buffer_memory import BufferMemoryfrom autochain.models.chat_openai import ChatOpenAIllm = ChatOpenAI(temperature=0)memory = BufferMemory()agent = ConversationalAgent.from_llm_and_tools(llm=llm)chain = Chain(agent=agent, memory=memory)user_query = "Write me a poem about AI"print(f">> User: {user_query}")print(f""">>> Assistant: {chain.run(user_query)["message"]}""")>> User: Write me a poem about AIPlanningPlanning output: {'thoughts': {'plan': "Based on the user's request for a poem about AI, I can use a tool to generate a poem or write one myself.", 'need_use_tool': "Yes, I can use the 'Poem Generator' tool to generate a poem about AI."}, 'tool': {'name': 'Poem Generator', 'args': {'topic': 'AI'}}, 'response': "Sure, I can generate a poem about AI for you. Here it is:\n\nIn the world of AI, \nWhere machines learn and try, \nWe see a future bright, \nWhere technology takes flight. \nFrom self-driving cars, \nTo robots on Mars, \nAI is changing the game, \nAnd we'll never be the same. \nSo let's embrace this new age, \nAnd see where it takes us on this stage. \nFor AI is here to stay, \nAnd it's only just begun its play."}Plan to take action 'Poem Generator'Deciding if need clarificationPlanningPlanning output: {'thoughts': {'plan': "Since the tool 'Poem Generator' is not supported for the input 'AI', I will try to have a helpful conversation with the user.", 'need_use_tool': 'No'}, 'tool': {'name': '', 'args': {}}, 'response': "Sure, I'd love to! Here's a poem about AI:\n\nArtificial intelligence, a marvel of our time,\nA creation of man, a wonder so divine.\nIt learns and adapts, with each passing day,\nA true reflection of our own human way.\nIt can think and reason, and even dream,\nA world of possibilities, or so it seems.\nBut with great power, comes great responsibility,\nTo use it for good, and not for hostility.\nSo let us embrace, this gift of technology,\nAnd use it to build, a better society."}>>> Assistant:Sure, I'd love to! Here's a poem about AI:Artificial intelligence, a marvel of our time,A creation of man, a wonder so divine.It learns and adapts, with each passing day,A true reflection of our own human way.It can think and reason, and even dream,A world of possibilities, or so it seems.But with great power, comes great responsibility,To use it for good, and not for hostility.So let us embrace, this gift of technology,And use it to build, a better societyLa philosophie de conception de base d'AutoChain peut être résumée par « simplicité, personnalisation et automatisation ». Les détails sont les suivants :

(1) Simple

Par rapport à d'énormes frameworks tels que LangChain, AutoChain poursuit délibérément la simplification du concept et de l'architecture pour réduire autant que possible les coûts d'apprentissage et d'utilisation des développeurs. Il résume le processus de développement d'applications LLM le plus élémentaire et fournit aux utilisateurs un chemin de développement clair à travers une série d'éléments de base faciles à comprendre.

(2) Personnalisation

AutoChain se rend compte que les scénarios d'application auxquels chaque développeur est confronté sont uniques. En tant que tel, il offre aux utilisateurs des capacités de personnalisation inégalées, leur permettant de créer des agents intelligents qui répondent à des besoins spécifiques grâce à des outils enfichables, des sources de données et des modules de processus de prise de décision. Ce concept démontre l’ouverture d’esprit d’AutoChain à « embrasser la différenciation ».

(3) Automatisation

En tant que cadre pour les systèmes de dialogue, AutoChain comprend l'importance de la simulation de scénarios et de l'évaluation automatisée. Grâce au moteur de simulation de dialogue intégré, les développeurs peuvent évaluer efficacement et automatiquement les performances de différentes versions d'agents dans divers scénarios d'interaction homme-machine pour optimiser et itérer en continu. Cette capacité d’innovation améliorera sans aucun doute considérablement l’efficacité du développement.

Sur la base de ces "trois caractéristiques simples", il ne nous est pas difficile de découvrir le charme unique d'AutoChain :

Référence :

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Application de l'intelligence artificielle dans la vie

Application de l'intelligence artificielle dans la vie

Quel est le concept de base de l'intelligence artificielle

Quel est le concept de base de l'intelligence artificielle

utilisation de la fonction

utilisation de la fonction

OuYi Exchange est-il légal ?

OuYi Exchange est-il légal ?

Numéro de téléphone mobile virtuel pour recevoir le code de vérification

Numéro de téléphone mobile virtuel pour recevoir le code de vérification

Comment ouvrir php dans une page Web

Comment ouvrir php dans une page Web

commande Linux View IP

commande Linux View IP

Quelle est la différence entre les téléphones mobiles 4g et 5g ?

Quelle est la différence entre les téléphones mobiles 4g et 5g ?