Laut der kürzlich veröffentlichten Liste des World Intellectual Property Office (WIPO) hat Apple kürzlich ein Gestenerkennungspatent namens „GESTURE RECOGNITION WITH HAND-OBJECT INTERACTION“ erhalten. Diese Nachricht weist darauf hin, dass die verschiedenen Technologien zur Luftgestensteuerung, die jetzt für das Vision Pro-Headset verfügbar sind, möglicherweise auf andere Geräte wie iPhones, iPads und MacBooks ausgeweitet werden.

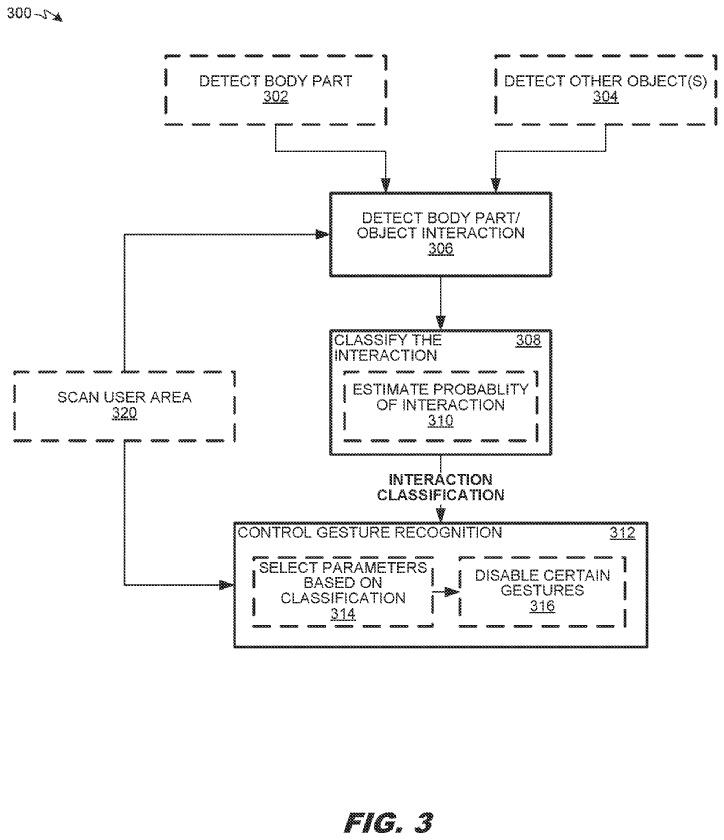

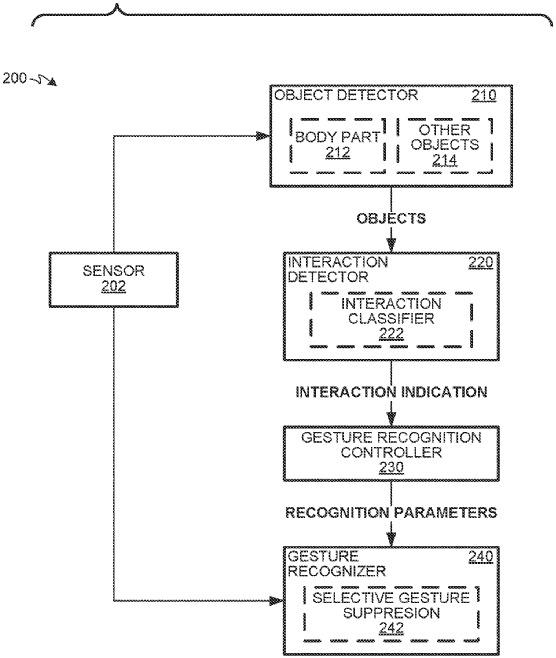

Der Schlüssel zu dieser patentierten Technologie besteht darin, dass das Gerät die Gesten des Benutzers scannen und erkennen und die Daten analysieren kann, um bestimmte Gesten zu identifizieren. Beispielsweise kann eine Kamera ein Bild vom Arm des Benutzers aufnehmen oder ein Beschleunigungsmesser an der Hand kann Handbewegungsinformationen aufzeichnen. Durch die Analyse der erfassten Gestendaten und den Vergleich mit vordefinierten Gesten kann das Gerät entsprechende interaktive Vorgänge umsetzen.

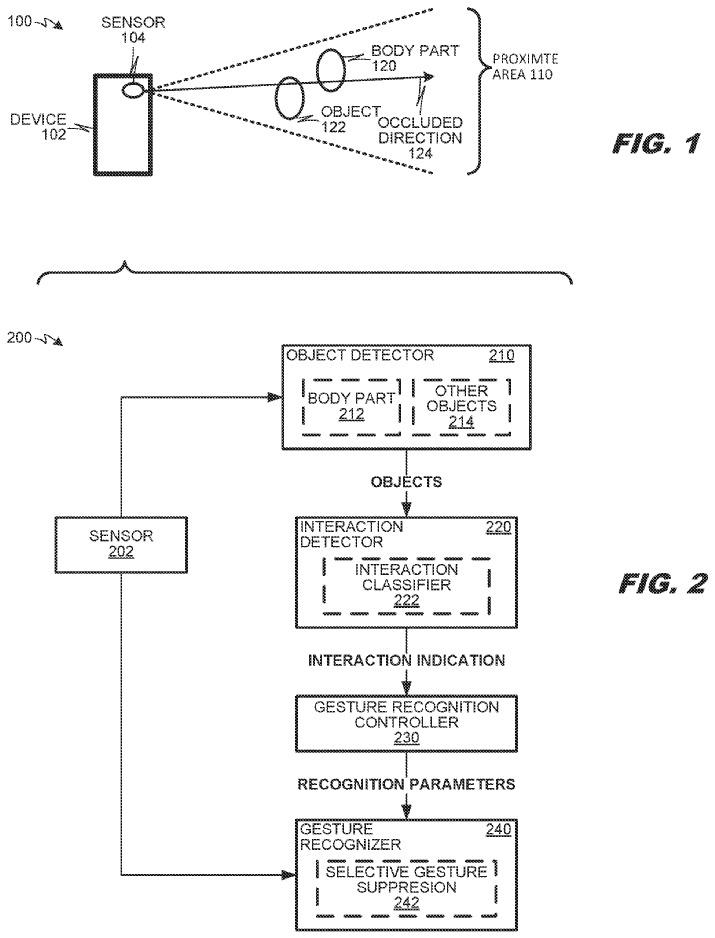

Abbildung 1 zeigt ein Beispielszenario 100 der Gestenerkennung. In diesem Szenario ist das Gerät 102 mit einem Sensor 104 zum Scannen des Körperteils 120 des betreffenden Benutzers und eines anderen Objekts 122 innerhalb des Nahbereichsbereichs 110 ausgestattet. Der Sensor erkennt und versteht die Absicht des Benutzers, indem er die Gesten und Bewegungen des Benutzers erfasst. Diese Technologie kann dazu beitragen, dass Geräte besser mit Benutzern interagieren und ein intelligenteres Benutzererlebnis bieten. Durch die Analyse der vom Sensor erhaltenen Daten kann das Gerät verschiedene Gesten, wie Winken, Nicken oder andere Gesten, erkennen und entsprechende Vorgänge ausführen oder entsprechend zeigen. In einigen Aspekten kann das Objekt 122 ein Nahbereichsbereich 110 sein, alles außer dem Körper Teile 120.

Zum Beispiel könnte Körperteil 120 eine Hand sein und Objekt 122 könnte ein Stift oder eine andere Hand sein. Körperteil 120 und andere Objekte 122 können beim Scannen des Nahbereichsbereichs 110 interagieren, beispielsweise können Körperteil 120 und Objekt 122 so interagieren, dass eines das andere verdeckt.

Kommentar des Herausgebers: Die Genehmigung dieses Patents bringt eine flexiblere und intuitivere Interaktionsmethode für Apples Geräte, nicht nur Vision Pro, sondern auch zukünftige Benutzer können es auf Geräten wie iPhone, iPad und MacBook genießen ein intelligenteres Gestensteuerungserlebnis.

Kommentar des Herausgebers: Die Genehmigung dieses Patents bringt eine flexiblere und intuitivere Interaktionsmethode für Apples Geräte, nicht nur Vision Pro, sondern auch zukünftige Benutzer können es auf Geräten wie iPhone, iPad und MacBook genießen ein intelligenteres Gestensteuerungserlebnis.

Das obige ist der detaillierte Inhalt vonDezentralisierung der Vision Pro-Funktion? iPhone, iPad und andere Geräte unterstützen möglicherweise Luftgesten. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Welche Netzwerkdateiserver-Tools gibt es?

Welche Netzwerkdateiserver-Tools gibt es?

So implementieren Sie die Online-Chat-Funktion von Vue

So implementieren Sie die Online-Chat-Funktion von Vue

So stellen Sie Videos wieder her, die offiziell aus Douyin entfernt wurden

So stellen Sie Videos wieder her, die offiziell aus Douyin entfernt wurden

Warum der Computer immer wieder automatisch neu startet

Warum der Computer immer wieder automatisch neu startet

So stellen Sie aus dem Papierkorb geleerte Dateien wieder her

So stellen Sie aus dem Papierkorb geleerte Dateien wieder her

So lösen Sie den HTTP-Status 404

So lösen Sie den HTTP-Status 404

Regulärer Ausdruck enthält nicht

Regulärer Ausdruck enthält nicht

Welche Sortiermethoden gibt es?

Welche Sortiermethoden gibt es?