Knowledge Graph: der ideale Partner für große Modelle

Großformatige Sprachmodelle (LLM) sind in der Lage, flüssige und kohärente Texte zu generieren, was neue Perspektiven für Bereiche wie den Dialog mit künstlicher Intelligenz und kreatives Schreiben eröffnet. Allerdings weist LLM auch einige wesentliche Einschränkungen auf. Erstens beschränkt sich ihr Wissen auf Muster, die aus Trainingsdaten erkannt werden, und es mangelt ihnen an einem echten Verständnis der Welt. Zweitens sind die Denkfähigkeiten begrenzt und können keine logischen Schlussfolgerungen ziehen oder Fakten aus mehreren Datenquellen zusammenführen. Bei komplexeren und offeneren Fragen können die Antworten von LLM absurd oder widersprüchlich werden, was als „Illusionen“ bekannt ist. Obwohl LLM in einigen Aspekten sehr nützlich ist, weist es dennoch gewisse Einschränkungen bei der Bearbeitung komplexer Probleme und realer Situationen auf.

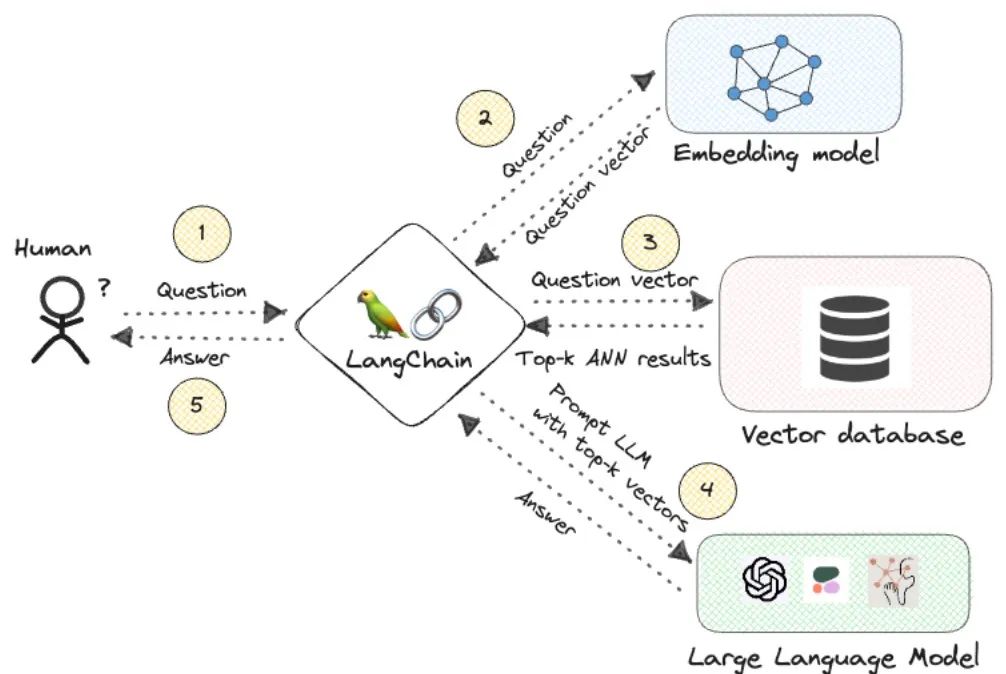

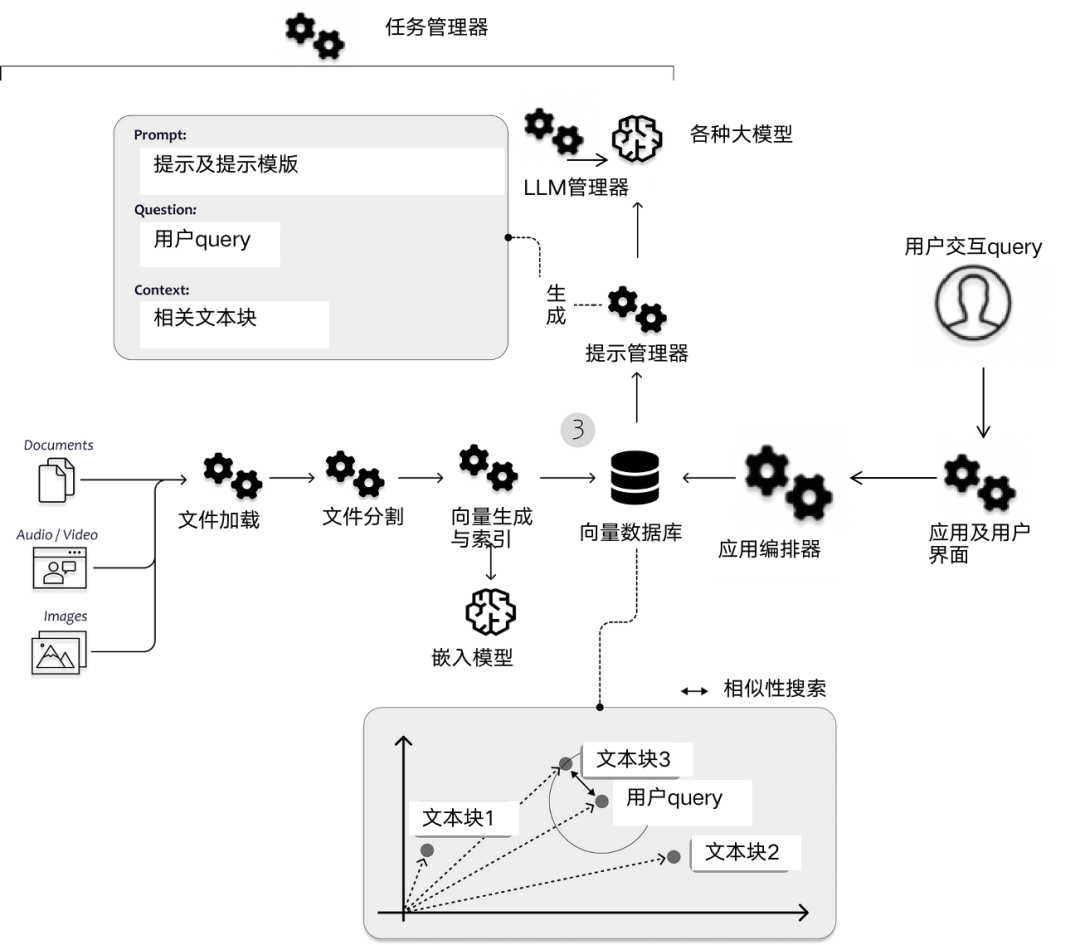

Um diese Lücken zu schließen, sind in den letzten Jahren Retrieval Augmented Generation (RAG)-Systeme entstanden, deren Kernidee darin besteht, LLM Kontext bereitzustellen, indem relevantes Wissen aus externen Quellen abgerufen wird, um fundiertere Antworten zu geben. Aktuelle Systeme verwenden zum Abrufen von Passagen meist semantische Ähnlichkeit von Vektoreinbettungen. Dieser Ansatz weist jedoch seine eigenen Mängel auf, wie z. B. das Fehlen einer echten Korrelation, die Unfähigkeit, Fakten zu aggregieren, und das Fehlen von Inferenzketten. Die Anwendungsgebiete von Wissensgraphen können diese Probleme lösen. Der Wissensgraph ist eine strukturierte Darstellung realer Entitäten und Beziehungen. Durch die Kodierung der Zusammenhänge zwischen kontextuellen Fakten überwinden Wissensgraphen die Mängel der reinen Vektorsuche, und die Graphensuche ermöglicht komplexe mehrstufige Argumentationen über mehrere Informationsquellen hinweg.

Die Kombination aus Vektoreinbettung und Wissensgraph kann die Argumentationsfähigkeit von LLM verbessern und seine Genauigkeit und Interpretierbarkeit verbessern. Diese Partnerschaft verbindet Oberflächensemantik perfekt mit strukturiertem Wissen und Logik und ermöglicht es LLM, statistisches Lernen und symbolische Darstellung gleichzeitig anzuwenden.

Bilder

Bilder

1. Einschränkungen der Vektorsuche

Die meisten RAG-Systeme finden den Kontext von LLM durch die Vektorsuche von Passagen in einer Sammlung von Dokumenten. In diesem Prozess gibt es mehrere wichtige Schritte.

- Textkodierung: Das System verwendet ein Einbettungsmodell wie BERT, um Text aus Absätzen im Korpus in Vektordarstellungen zu kodieren. Jeder Artikel wird in einen dichten Vektor komprimiert, um die Semantik zu erfassen.

- Index: Diese Kanalvektoren werden in einem hochdimensionalen Vektorraum indiziert, um eine schnelle Suche nach nächsten Nachbarn zu ermöglichen. Beliebte Methoden sind unter anderem Faiss und Pinecone.

- Abfragekodierung: Die Abfrageanweisung des Benutzers wird mithilfe desselben Einbettungsmodells auch in eine Vektordarstellung kodiert.

- Ähnlichkeitsabfrage: Eine Nächste-Nachbarn-Suche wird über die indizierten Absätze ausgeführt, wobei die Absätze, die dem Abfragevektor am nächsten liegen, basierend auf einer Distanzmetrik (z. B. Kosinusdistanz) gefunden werden.

- Absatzergebnisse zurückgeben: Gibt den ähnlichsten Absatzvektor zurück und extrahiert den Originaltext, um Kontext für LLM bereitzustellen.

Diese Pipeline weist mehrere wesentliche Einschränkungen auf:

- Kanalvektoren erfassen möglicherweise nicht vollständig die semantische Absicht der Abfrage, Einbettungen können bestimmte Inferenzverbindungen nicht darstellen und wichtiger Kontext wird letztendlich ignoriert.

- Durch das Zusammenfassen eines gesamten Absatzes in einem einzigen Vektor gehen Nuancen verloren und wichtige, im Satz eingebettete relevante Details werden unscharf.

- Der Abgleich erfolgt unabhängig für jeden Absatz, es gibt keine gemeinsame Analyse über verschiedene Absätze hinweg und es mangelt an der Verknüpfung von Fakten und der Erzielung von Antworten, die aggregiert werden müssen.

- Der Ranking- und Matching-Prozess ist undurchsichtig, es gibt keine Transparenz darüber, warum bestimmte Passagen als relevanter angesehen werden.

- Nur semantische Ähnlichkeit wird kodiert, Beziehungen, Strukturen, Regeln und andere Inhalte zwischen unterschiedlichen Zusammenhängen werden nicht dargestellt.

- Ein einziger Fokus auf semantische Vektorähnlichkeit führt zu einem Mangel an wirklichem Verständnis beim Abrufen.

Je komplexer die Abfragen werden, desto offensichtlicher werden diese Einschränkungen in der Unfähigkeit, über den abgerufenen Inhalt nachzudenken.

2. Wissensgraph integrieren

Wissensgraph basiert auf Entitäten und Beziehungen, überträgt Informationen über miteinander verbundene Netzwerke und verbessert die Abruffähigkeiten durch komplexe Argumentation.

- Explizite Fakten Fakten werden direkt als Knoten und Kanten erfasst und nicht in undurchsichtige Vektoren komprimiert, wodurch wichtige Details erhalten bleiben.

- Kontextdetails, Entitäten enthalten umfangreiche Attribute wie Beschreibungen, Aliase und Metadaten, die wichtigen Kontext bereitstellen.

- Die Netzwerkstruktur drückt die tatsächlichen Verbindungen, Erfassungsregeln, Hierarchien, Zeitpläne usw. zwischen Beziehungsmodellierungseinheiten aus.

- Mehrstufiges Denken basiert auf der Durchquerung von Beziehungen und der Verknüpfung von Fakten aus verschiedenen Quellen, um Antworten abzuleiten, die eine Argumentation über mehrere Schritte hinweg erfordern.

- Gemeinsames Denken verbindet sich durch Entitätsauflösung mit denselben realen Objekten und ermöglicht so eine kollektive Analyse.

- Interpretierbare Korrelation, Diagrammtopologie bietet eine Transparenz, die erklären kann, warum bestimmte basierte Fakten aufgrund Zusammenhängen relevant sind.

- Personalisierung, Erfassung von Benutzerattributen, Kontext und historischen Interaktionen, um maßgeschneiderte Ergebnisse zu erzielen.

Der Wissensgraph ist nicht nur eine einfache Übereinstimmung, sondern ein Prozess des Durchlaufens des Graphen, um kontextbezogene Fakten im Zusammenhang mit der Abfrage zu sammeln. Interpretierbare Ranking-Methoden nutzen die Topologie von Diagrammen, um die Abruffähigkeiten durch die Kodierung strukturierter Fakten, Beziehungen und Kontexte zu verbessern und so eine genaue mehrstufige Schlussfolgerung zu ermöglichen. Dieser Ansatz bietet im Vergleich zu reinen Vektorsuchen eine größere Korrelation und Erklärungskraft.

3. Verwenden Sie einfache Einschränkungen, um die Einbettung von Wissensgraphen zu verbessern.Die Einbettung von Wissensgraphen in einen kontinuierlichen Vektorraum ist ein aktueller Forschungsschwerpunkt. Wissensgraphen nutzen Vektoreinbettungen zur Darstellung von Entitäten und Beziehungen zur Unterstützung mathematischer Operationen. Darüber hinaus können zusätzliche Einschränkungen die Darstellung weiter optimieren.

- Nicht-Negativitätsbeschränkungen, die die Einbettung von Entitäten auf positive Werte zwischen 0 und 1 beschränken, führen zu Sparsität, modellieren explizit ihre positive Natur und verbessern die Interpretierbarkeit.

- Implikationsbeschränkungen kodieren logische Regeln wie Symmetrie, Inversion, Zusammensetzung usw. direkt in relational eingebettete Beschränkungen, um diese Muster durchzusetzen.

- Konfidenzmodellierung, weiche Einschränkungen mit Slack-Variablen können die Konfidenz logischer Regeln auf der Grundlage von Beweisen kodieren.

- Regularisierung, die eine nützliche induktive Vorspannung auferlegt und nur einen Projektionsschritt hinzufügt, ohne die Optimierung komplexer zu machen.

- Interpretierbarkeit und strukturierte Einschränkungen sorgen für Transparenz für die vom Modell gelernten Muster, was den Inferenzprozess erklärt.

- Genauigkeit und Einschränkung verbessern die Generalisierung, indem sie den Hypothesenraum auf eine Darstellung reduzieren, die den Anforderungen entspricht.

Einfache und universelle Einschränkungen werden der Einbettung des Wissensgraphen hinzugefügt, was zu einer optimierteren, einfacher zu interpretierenden und logisch kompatiblen Darstellung führt. Einbettungen erhalten induktive Verzerrungen, die Strukturen und Regeln der realen Welt nachahmen, ohne viel zusätzliche Komplexität für genauere und interpretierbarere Überlegungen mit sich zu bringen.

4. Integrieren Sie mehrere ArgumentationsrahmenWissensdiagramme erfordern Argumentation, um neue Fakten abzuleiten, Fragen zu beantworten und Vorhersagen zu treffen:

Logische Regeln drücken Wissen als logische Axiome und Ontologien aus, vernünftig und sinnvoll vollständige Argumentation durch Theorembeweise und begrenzte Unsicherheitsverarbeitung. Bei der Grapheinbettung handelt es sich um eine eingebettete Wissensgraphenstruktur, die für Vektorraumoperationen verwendet wird und mit Unsicherheit umgehen kann, aber nicht ausdrucksstark ist. Neuronale Netze in Kombination mit Vektorsuchen sind adaptiv, die Schlussfolgerung ist jedoch undurchsichtig. Regeln können automatisch durch statistische Analyse der Diagrammstruktur und der Daten erstellt werden, die Qualität ist jedoch ungewiss. Hybride Pipelines kodieren explizite Einschränkungen durch logische Regeln, Einbettungen stellen Vektorraumoperationen bereit und neuronale Netze profitieren durch gemeinsames Training von den Vorteilen der Fusion. Nutzen Sie fallbasierte, Fuzzy- oder probabilistische Logikmethoden, um die Transparenz zu erhöhen, Unsicherheit auszudrücken und das Vertrauen in Regeln zu stärken. Erweitern Sie Ihr Wissen, indem Sie abgeleitete Fakten und erlernte Regeln in Diagramme umsetzen und so eine Rückkopplungsschleife schaffen.

Der Schlüssel besteht darin, die erforderlichen Inferenztypen zu identifizieren und sie auf geeignete Techniken abzubilden, indem logische Formen, Vektordarstellungen und zusammensetzbare Pipelines neuronaler Komponenten kombiniert werden, um Robustheit und Interpretierbarkeit zu gewährleisten.

4.1 Aufrechterhaltung des Informationsflusses von LLM

Das Abrufen von Fakten im Wissensgraphen für LLM führt zu Informationsengpässen, die konstruktionsbedingt aufrechterhalten werden müssen, um die Relevanz aufrechtzuerhalten. Durch das Aufteilen von Inhalten in kleine Abschnitte wird die Isolation verbessert, es geht jedoch der umgebende Kontext verloren, was die Argumentation zwischen Abschnitten erschwert. Durch die Generierung von Blockzusammenfassungen wird der Kontext prägnanter, wobei wichtige Details komprimiert werden, um die Bedeutung hervorzuheben. Fügen Sie Zusammenfassungen, Titel, Tags usw. als Metadaten hinzu, um den Kontext zum Quellinhalt beizubehalten. Durch das Umschreiben der ursprünglichen Abfrage in eine detailliertere Version kann der Abruf besser auf die Anforderungen des LLM ausgerichtet werden. Die Durchquerungsfunktion des Wissensgraphen hält die Verbindung zwischen Fakten aufrecht und behält den Kontext bei. Durch chronologisches Sortieren oder Sortieren nach Relevanz kann die Informationsstruktur des LLM optimiert werden, und die Umwandlung impliziten Wissens in explizite, für das LLM angegebene Fakten kann die Argumentation erleichtern.

Das Ziel besteht darin, die Relevanz, den Kontext, die Struktur und den expliziten Ausdruck des abgerufenen Wissens zu optimieren, um die Denkfähigkeit zu maximieren. Es muss ein Gleichgewicht zwischen Granularität und Kohäsion gefunden werden. Knowledge-Graph-Beziehungen helfen dabei, einen Kontext für isolierte Fakten aufzubauen.

4.2 Denkfähigkeiten freischalten

Die Kombination von Wissensgraphen und eingebetteter Technologie hat den Vorteil, dass die Schwächen des jeweils anderen überwunden werden.

Wissensdiagramm bietet einen strukturierten Ausdruck von Entitäten und Beziehungen. Verbessern Sie komplexe Argumentationsfunktionen durch Traversierungsfunktionen und verarbeiten Sie mehrstufiges Denken; die Einbettung kodiert Informationen für ähnlichkeitsbasierte Operationen im Vektorraum, unterstützt eine effektive Näherungssuche in einem bestimmten Maßstab und deckt potenzielle Muster auf. Durch die gemeinsame Kodierung werden Einbettungen für Entitäten und Beziehungen in Wissensgraphen generiert. Graphische neuronale Netze bearbeiten Graphstrukturen und eingebettete Elemente über differenzierbare Nachrichtenübermittlung.

Der Wissensgraph sammelt zunächst strukturiertes Wissen und bettet dann eine auf verwandte Inhalte ausgerichtete Suche und Abfrage ein. Explizite Wissensgraph-Beziehungen sorgen für Interpretierbarkeit für den Argumentationsprozess. Abgeleitetes Wissen kann auf Diagramme ausgeweitet werden, und GNNs ermöglichen das Lernen kontinuierlicher Darstellungen.

Diese Partnerschaft erkennt man am Muster! Die Skalierbarkeit von Kräften und neuronalen Netzen verbessert die Darstellung strukturierten Wissens. Dies ist der Schlüssel zum Bedarf an statistischem Lernen und symbolischer Logik, um die sprachliche KI voranzutreiben.

4.3 Verwenden Sie kollaborative Filterung, um die Suche zu verbessern.

Die kollaborative Filterung nutzt die Verbindungen zwischen Entitäten, um die Suche zu verbessern. Der allgemeine Prozess ist wie folgt:

- Erstellen Sie einen Wissensgraphen, in dem Knoten Entitäten und Kanten Beziehungen darstellen.

- Generieren Sie einen Einbettungsvektor für bestimmte Schlüsselknotenattribute (wie Titel, Beschreibung usw.).

- Vektorindex – Erstellt einen Vektorähnlichkeitsindex von Knoteneinbettungen.

- Suche nach nächsten Nachbarn – Finden Sie für eine Suchabfrage Knoten mit den ähnlichsten Einbettungen.

- Kollaborative Anpassung – Knotenbasierte Verbindungen unter Verwendung von Algorithmen wie PageRank, um Ähnlichkeitswerte zu verbreiten und anzupassen.

- KantengewichtーPassen Sie das Gewicht je nach Kantentyp, Stärke, Selbstvertrauen usw. an.

- Score-Normalisierung ーーNormalisiert angepasste Scores, um relative Rankings beizubehalten.

- Ergebnisse neu geordnetーーErste Ergebnisse neu geordnet basierend auf angepassten Kollaborationsergebnissen.

- Benutzerkontextーーweiter abgestimmt auf Benutzerprofil, Verlauf und Präferenzen.

Bilder

Bilder

5. Befeuerung der RAG-Engine – Datenschwungrad

Der Aufbau eines immer besser werdenden, leistungsstarken Retrieval Augmentation Generation (RAG)-Systems erfordert möglicherweise die Implementierung eines Datenschwungrads. Wissensgraphen erschließen neue Argumentationsfähigkeiten für Sprachmodelle, indem sie strukturiertes Weltwissen bereitstellen. Die Erstellung qualitativ hochwertiger Karten bleibt jedoch eine Herausforderung. Hier kommt das Datenschwungrad ins Spiel, indem es Systeminteraktionen analysiert, um den Wissensgraphen kontinuierlich zu verbessern.

Protokollieren Sie alle Systemabfragen, Antworten, Bewertungen, Benutzeraktionen und mehr, um Einblick in die Verwendung des Wissensgraphen zu erhalten. Nutzen Sie die Datenaggregation, um fehlerhafte Antworten aufzudecken, gruppieren und analysieren Sie diese Antworten, um Muster zu identifizieren, die auf Wissenslücken hinweisen. Überprüfen Sie manuell problematische Systemreaktionen und führen Sie Probleme auf fehlende oder falsche Fakten in der Karte zurück. Ändern Sie dann das Diagramm direkt, um die fehlenden Sachdaten hinzuzufügen, die Struktur zu verbessern, die Klarheit zu verbessern und vieles mehr. Die oben genannten Schritte werden in einer kontinuierlichen Schleife ausgeführt und jede Iteration verbessert den Wissensgraphen weiter.

Das Streamen von Echtzeit-Datenquellen wie Nachrichten und sozialen Medien sorgt für einen ständigen Fluss neuer Informationen, um den Wissensgraphen auf dem neuesten Stand zu halten. Die Verwendung der Abfragegenerierung zur Identifizierung und Schließung kritischer Wissenslücken geht über den Rahmen der Möglichkeiten von Streaming hinaus. Finden Sie Lücken in der Grafik, stellen Sie Fragen, rufen Sie fehlende Fakten ab und ergänzen Sie sie. Für jeden Zyklus wird der Wissensgraph schrittweise verbessert, indem Nutzungsmuster analysiert und Datenprobleme behoben werden. Der verbesserte Graph steigert die Leistung des Systems.

Dieser Schwungradprozess ermöglicht die gemeinsame Entwicklung von Wissensgraphen und Sprachmodellen auf der Grundlage des Feedbacks aus der realen Nutzung. Karten werden aktiv an die Anforderungen des Modells angepasst.

Kurz gesagt bietet das Datenschwungrad ein Gerüst für die kontinuierliche und automatische Verbesserung des Wissensgraphen durch die Analyse von Systeminteraktionen. Dies fördert die Genauigkeit, Relevanz und Anpassungsfähigkeit graphabhängiger Sprachmodelle.

6. Zusammenfassung

Künstliche Intelligenz muss externes Wissen und Argumentation kombinieren, und hier kommt der Wissensgraph ins Spiel. Wissensgraphen bieten strukturierte Darstellungen realer Entitäten und Beziehungen und kodieren Fakten über die Welt und die Verbindungen zwischen ihnen. Dies ermöglicht komplexes logisches Denken über mehrere Schritte hinweg, indem diese miteinander verbundenen Fakten durchlaufen werden.

Wissensgraphen haben jedoch ihre eigenen Einschränkungen wie Sparsität und mangelnde Unsicherheitsbehandlung, und hier helfen Grapheinbettungen bei der Lokalisierung. Durch die Kodierung von Elementen von Wissensgraphen im Vektorraum ermöglichen Einbettungen statistisches Lernen von großen Korpora bis hin zu Darstellungen latenter Muster und ermöglichen außerdem effiziente, auf Ähnlichkeit basierende Operationen.

Weder Wissensgraphen noch Vektoreinbettungen allein reichen aus, um eine menschenähnliche Sprachintelligenz zu bilden, aber zusammen bieten sie eine effektive Kombination aus strukturierter Wissensdarstellung, logischem Denken und statistischem Lernen, und der Wissensgraph deckt das darüber hinausgehende neuronale Netzwerkmodell ab Die Fähigkeit, symbolische Logik und Beziehungen zu erkennen, Techniken wie graphische neuronale Netze vereinheitlichen diese Ansätze durch Informationsübertragungsgraphenstrukturen und -einbettungen weiter. Diese symbiotische Beziehung ermöglicht es dem System, sowohl statistisches Lernen als auch symbolische Logik zu nutzen und so die Vorteile neuronaler Netze und strukturierter Wissensdarstellung zu kombinieren.

Es gibt immer noch Herausforderungen bei der Erstellung hochwertiger Wissensdiagramme, Benchmark-Tests, Rauschverarbeitung usw. Hybridtechnologien, die symbolische und neuronale Netze umfassen, bleiben jedoch vielversprechend. Da sich Wissensgraphen und Sprachmodelle weiterentwickeln, wird ihre Integration neue Bereiche erklärbarer KI eröffnen.

Das obige ist der detaillierte Inhalt vonKnowledge Graph: der ideale Partner für große Modelle. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undress AI Tool

Ausziehbilder kostenlos

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Stock Market GPT

KI-gestützte Anlageforschung für intelligentere Entscheidungen

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Iyo One: Teils Kopfhörer, teils Audiocomputer

Aug 08, 2024 am 01:03 AM

Iyo One: Teils Kopfhörer, teils Audiocomputer

Aug 08, 2024 am 01:03 AM

Konzentration ist zu jeder Zeit eine Tugend. Autor |. Herausgeber Tang Yitao |. Jing Yu Das Wiederaufleben der künstlichen Intelligenz hat zu einer neuen Welle von Hardware-Innovationen geführt. Der beliebteste AIPin hat beispiellose negative Bewertungen erhalten. Marques Brownlee (MKBHD) bezeichnete es als das schlechteste Produkt, das er jemals rezensiert habe; David Pierce, Herausgeber von The Verge, sagte, er würde niemandem empfehlen, dieses Gerät zu kaufen. Sein Konkurrent, der RabbitR1, ist nicht viel besser. Der größte Zweifel an diesem KI-Gerät besteht darin, dass es sich offensichtlich nur um eine App handelt, Rabbit jedoch eine 200-Dollar-Hardware gebaut hat. Viele Menschen sehen KI-Hardware-Innovationen als Chance, das Smartphone-Zeitalter zu untergraben und sich ihm zu widmen.

Das Transformer-Autoren-Startup Sakana AI bringt AI Scientist auf den Markt, das erste vollautomatische KI-System für wissenschaftliche Entdeckungen

Aug 13, 2024 pm 04:43 PM

Das Transformer-Autoren-Startup Sakana AI bringt AI Scientist auf den Markt, das erste vollautomatische KI-System für wissenschaftliche Entdeckungen

Aug 13, 2024 pm 04:43 PM

Herausgeber | ScienceAI Vor einem Jahr verließ Llion Jones, der letzte Autor des Transformer-Artikels von Google, das Unternehmen, um ein Unternehmen zu gründen, und gründete zusammen mit dem ehemaligen Google-Forscher David Ha das Unternehmen für künstliche Intelligenz SakanaAI. SakanaAI behauptet, ein neues Basismodell zu schaffen, das auf von der Natur inspirierten Intelligenz basiert! Jetzt hat SakanaAI seinen Antwortbogen eingereicht. SakanaAI kündigt die Einführung von AIScientist an, dem weltweit ersten KI-System für automatisierte wissenschaftliche Forschung und offene Entdeckung! Von der Konzeption, dem Schreiben von Code, der Durchführung von Experimenten und der Zusammenfassung der Ergebnisse bis hin zum Verfassen ganzer Arbeiten und der Durchführung von Peer-Reviews ermöglicht AIScientist KI-gesteuerte wissenschaftliche Forschung und Beschleunigung

HyperOS 2.0 debütiert mit Xiaomi 15, KI steht im Mittelpunkt

Sep 01, 2024 pm 03:39 PM

HyperOS 2.0 debütiert mit Xiaomi 15, KI steht im Mittelpunkt

Sep 01, 2024 pm 03:39 PM

Kürzlich wurde bekannt, dass Xiaomi im Oktober die mit Spannung erwartete HyperOS 2.0-Version herausbringen wird. 1.HyperOS2.0 wird voraussichtlich gleichzeitig mit dem Xiaomi 15-Smartphone veröffentlicht. HyperOS 2.0 wird die KI-Fähigkeiten insbesondere in der Foto- und Videobearbeitung deutlich verbessern. HyperOS2.0 wird eine modernere und verfeinerte Benutzeroberfläche (UI) mit sich bringen, die flüssigere, klarere und schönere visuelle Effekte bietet. Das HyperOS 2.0-Update enthält außerdem eine Reihe von Verbesserungen der Benutzeroberfläche, wie erweiterte Multitasking-Funktionen, verbesserte Benachrichtigungsverwaltung und mehr Optionen zur Anpassung des Startbildschirms. Die Veröffentlichung von HyperOS 2.0 ist nicht nur ein Beweis für Xiaomis technische Stärke, sondern auch für seine Vision für die Zukunft der Smartphone-Betriebssysteme.

C Sprachdatenstruktur: Die Schlüsselrolle von Datenstrukturen in der künstlichen Intelligenz

Apr 04, 2025 am 10:45 AM

C Sprachdatenstruktur: Die Schlüsselrolle von Datenstrukturen in der künstlichen Intelligenz

Apr 04, 2025 am 10:45 AM

C Sprachdatenstruktur: Überblick über die Schlüsselrolle der Datenstruktur in der künstlichen Intelligenz im Bereich der künstlichen Intelligenz sind Datenstrukturen für die Verarbeitung großer Datenmengen von entscheidender Bedeutung. Datenstrukturen bieten eine effektive Möglichkeit, Daten zu organisieren und zu verwalten, Algorithmen zu optimieren und die Programmeffizienz zu verbessern. Gemeinsame Datenstrukturen, die häufig verwendete Datenstrukturen in der C -Sprache sind: Arrays: Eine Reihe von nacheinander gespeicherten Datenelementen mit demselben Typ. Struktur: Ein Datentyp, der verschiedene Arten von Daten zusammen organisiert und ihnen einen Namen gibt. Linked List: Eine lineare Datenstruktur, in der Datenelemente durch Zeiger miteinander verbunden werden. Stack: Datenstruktur, die dem LEST-In-First-Out-Prinzip (LIFO) folgt. Warteschlange: Datenstruktur, die dem First-In-First-Out-Prinzip (FIFO) folgt. Praktischer Fall: Die benachbarte Tabelle in der Graphentheorie ist künstliche Intelligenz

Der ehemalige Google-Chef Schmidt machte eine überraschende Aussage: KI-Unternehmertum könne zunächst „gestohlen' und später „verarbeitet' werden

Aug 15, 2024 am 11:53 AM

Der ehemalige Google-Chef Schmidt machte eine überraschende Aussage: KI-Unternehmertum könne zunächst „gestohlen' und später „verarbeitet' werden

Aug 15, 2024 am 11:53 AM

Laut Nachrichten dieser Website vom 15. August sorgte eine Rede des ehemaligen Google-CEO und -Vorsitzenden Eric Schmidt gestern an der Stanford University für große Kontroversen. Als er über die zukünftige Entwicklung der künstlichen Intelligenz sprach, sorgte er nicht nur für Kontroversen, als er sagte, Google-Mitarbeiter seien der Meinung, dass „von zu Hause aus zu arbeiten wichtiger sei als zu gewinnen“, und erklärte offen, dass KI-Startups zunächst durch KI-Tools geistiges Eigentum (IP) stehlen können und dann Rechtsanwälte beauftragen, die sich mit Rechtsstreitigkeiten befassen. Schmidt spricht über die Auswirkungen des TikTok-Verbots. Als Beispiel nennt Schmidt die Kurzvideoplattform TikTok und behauptet, dass bei einem Verbot von TikTok jeder KI nutzen könne, um eine ähnliche Anwendung zu generieren und alle Nutzer, sämtliche Musik und andere Inhalte direkt zu stehlen (MakemeacopyofTikTok , stehlen Sie alles

ACM MM2024 | Die multimodale Forschung von NetEase Fuxi erlangte erneut internationale Anerkennung und förderte neue Durchbrüche im modalübergreifenden Verständnis in bestimmten Bereichen

Aug 07, 2024 pm 08:16 PM

ACM MM2024 | Die multimodale Forschung von NetEase Fuxi erlangte erneut internationale Anerkennung und förderte neue Durchbrüche im modalübergreifenden Verständnis in bestimmten Bereichen

Aug 07, 2024 pm 08:16 PM

1. Die 32. ACM International Conference on Multimedia (ACM MM) gab die Annahmeergebnisse von NetEase Fuxis neuestem Forschungsergebnis „Selection and Reconstruction of Key Locals: A Novel Specific Domain Image-Text Retrieval Method“ bekannt. Die Forschungsrichtungen dieser Arbeit umfassen visuelles Sprachvortraining (VLP), modalübergreifendes Bild- und Textabrufen (CMITR) und andere Bereiche. Diese Auswahl unterstreicht die multimodalen Fähigkeiten von NetEase Fuxi Lab

Die Integration von KI in Komponist: Potenzial erkunden

May 01, 2025 am 12:02 AM

Die Integration von KI in Komponist: Potenzial erkunden

May 01, 2025 am 12:02 AM

KI kann ihre Stärken im Bereich der Musikschöpfung zeigen. 1) AI erzeugt Musik durch maschinelles Lernen und tiefes Lernen und verbessert die Vielfalt und Innovation. 2) KI -Komponisten können Komponisten unterstützen und Inspiration und Kreativität liefern. 3) In den tatsächlichen Anwendungen muss die Leistung optimiert werden, um die Probleme der Kohärenz und Innovation bei der Generierung von Musik zu lösen.

Deepseek veröffentlicht V3/R1 Theoretische tägliche Einkommen, Gewinnmarge von bis zu 545%

Mar 12, 2025 pm 02:18 PM

Deepseek veröffentlicht V3/R1 Theoretische tägliche Einkommen, Gewinnmarge von bis zu 545%

Mar 12, 2025 pm 02:18 PM

Kürzlich veröffentlichte das Inferenzsystem für künstliche Intelligenz Deepseek einen Artikel, in dem die wichtigsten Geheimnisse seines V3/R1 -Inferenzsystems umfassend enthüllt. Der Artikel enthüllte wichtige Informationen wie Deepseeks theoretische Kosten und Gewinnmarge zum ersten Mal. Berichten zufolge verwenden alle Dienste von Deepseekv3 und R1 H800GPU und nehmen dieselbe Genauigkeit wie Schulungen ein, um die Wirksamkeit der Service zu gewährleisten. Gleichzeitig erkennt Deepseek die Allokation der Tag-Nacht-Ressourcen, um die Hardware-Nutzung zu maximieren. Laut Statistiken betragen die Kosten für die GPU -Miete 2 USD pro Stunde USD pro Stunde, die Gesamtkosten für Deepseek für einen Tag 87.072 USD. Wenn alle Token gemäß den Preisgestaltung von Deepseekl1 berechnet werden, beträgt das theoretische Gesamteinkommen eines Tages 56.202