Lassen Sie uns zunächst den geschäftlichen Hintergrund, den Datenhintergrund und die grundlegende Algorithmusstrategie der umfassenden Informationsflussempfehlung von Baidu vorstellen. 1. Empfehlung für den umfassenden Informationsfluss von Baidu Wie Sie dem Bild oben entnehmen können, umfassen die empfohlenen Inhaltsformate immersive Empfehlungen ähnlich wie bei Douyin sowie einspaltige und zweispaltige Empfehlungen, ähnlich dem Layout von Xiaohongshu Notes. Es gibt auch viele Möglichkeiten für Benutzer, mit Inhalten zu interagieren. Sie können Inhalte auf der Zielseite kommentieren, mit „Gefällt mir“ markieren. Sie können auch die Autorenseite aufrufen, um relevante Informationen anzuzeigen und zu interagieren. Das Design des gesamten umfassenden Informationsflusses ist sehr reichhaltig und vielfältig und kann den unterschiedlichen Bedürfnissen und Interaktionsmethoden der Benutzer gerecht werden.

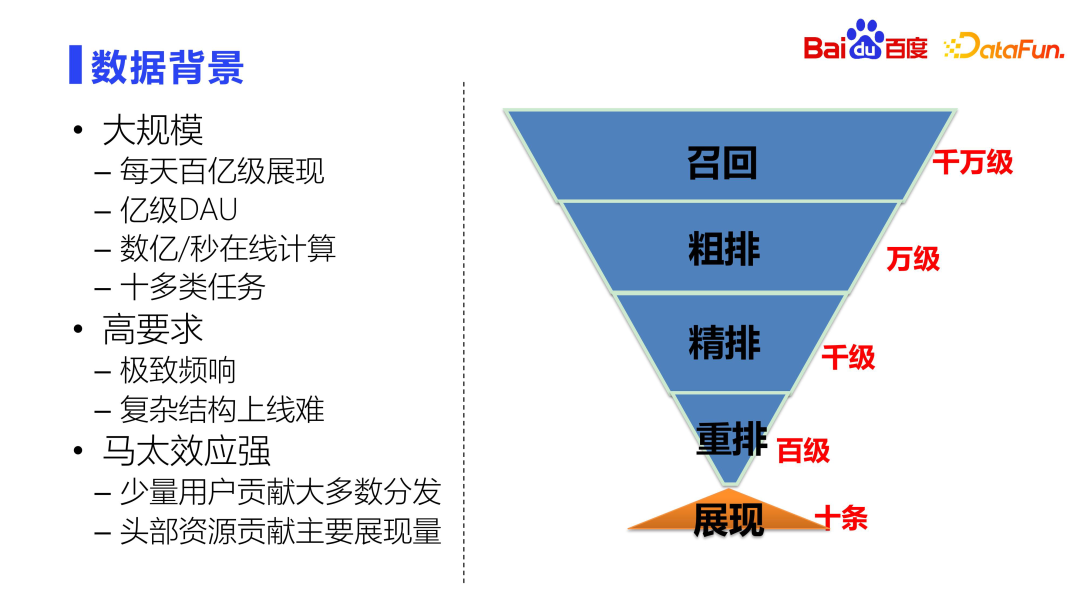

Großer Maßstab

. Das tägliche Anzeigeniveau übersteigt mehrere zehn Milliarden, daher muss das Modell einen Durchsatz von mehreren zehn Milliarden pro Tag haben. Die tägliche DAU übersteigt 100 Millionen, was auch bedeutet, dass das gesamte Modell mit hohem Durchsatz und hoher Skalierbarkeit entworfen werden muss. Für das Sortiermodell sind Hunderte Millionen Berechnungen pro Sekunde erforderlich. Daher müssen wir beim Entwurf des Modells nicht nur den Effekt berücksichtigen, sondern auch die Leistung. Es ist notwendig, einen guten Kompromiss zwischen Leistung und Effekt zu erzielen. Die Diversifizierung der Benutzerinteraktionsformen und -szenarien erfordert auch, dass das Modell mehrere Arten von Aufgaben vorhersagen kann.

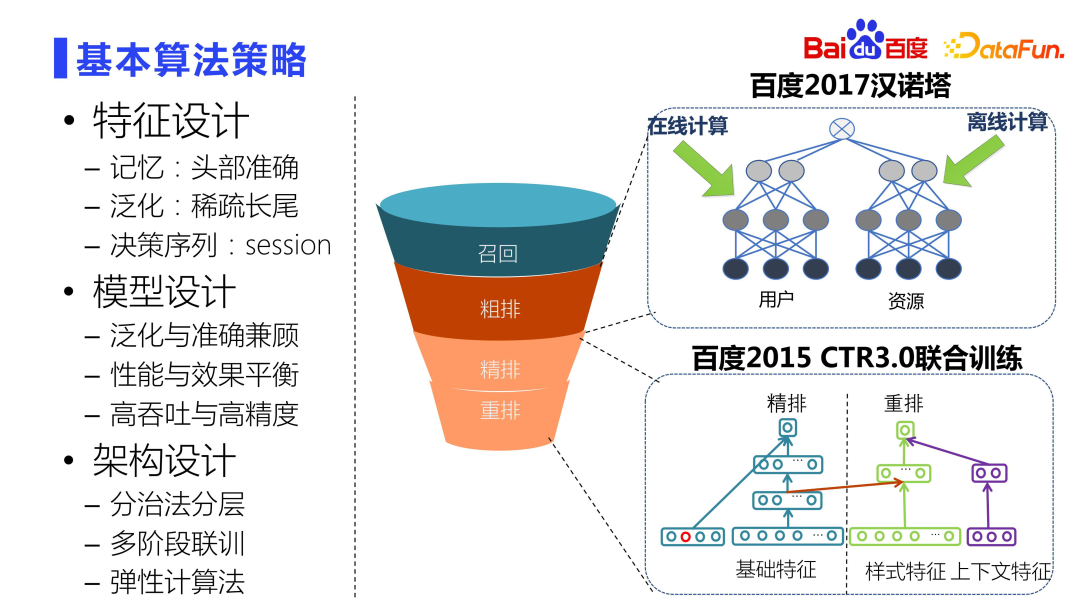

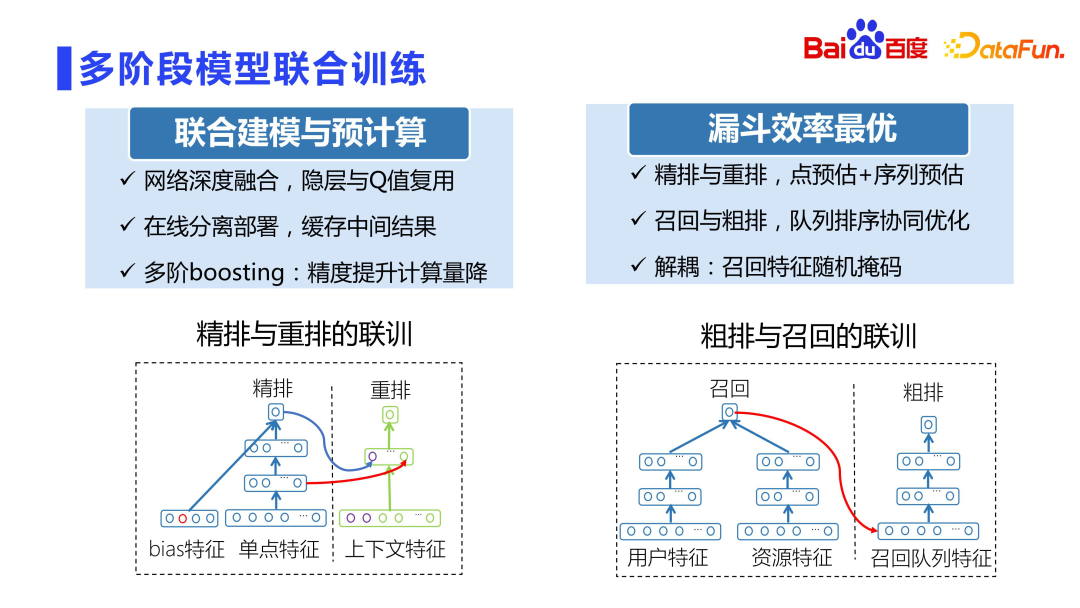

Das Tower of Hanoi-Projekt rechts im Bild oben setzt die Trennungsmodellierung von Benutzern und Ressourcen auf grober Layoutebene sehr geschickt um. Es gibt auch ein gemeinsames CTR3.0-Training, das ein mehrschichtiges und mehrstufiges gemeinsames Training ermöglicht. Das Feinranking ist beispielsweise das komplexeste und exquisiteste Modell im gesamten System Die Modellierung, das Feinranking und die Neuanordnung von Wise sind eng miteinander verbunden. Die von uns vorgeschlagene gemeinsame Trainingsmethode hat sehr gute Online-Ergebnisse erzielt.

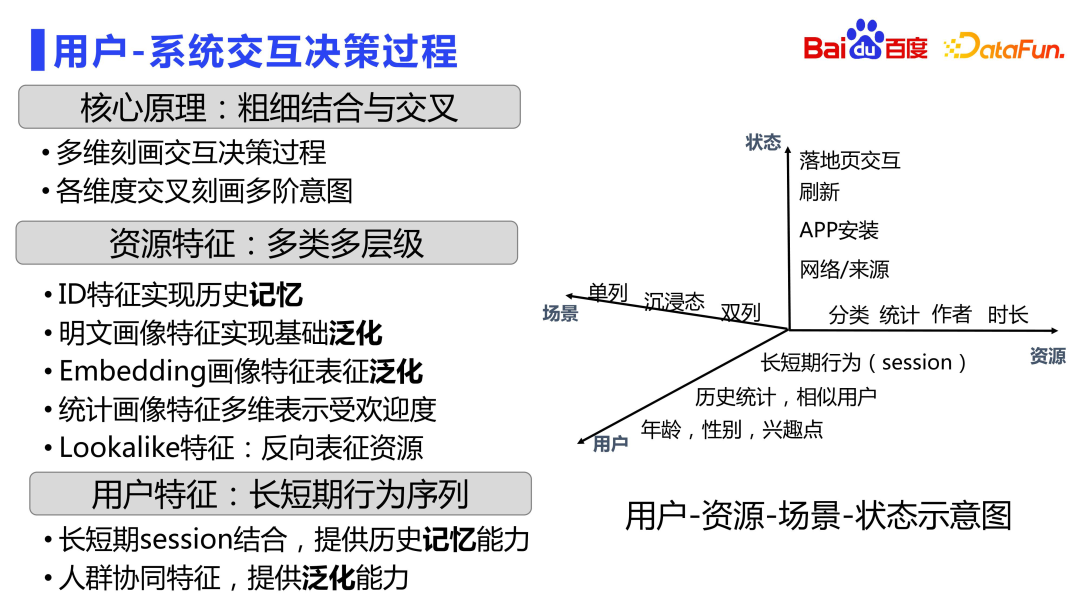

Als nächstes werden wir es aus den drei Perspektiven Features, Algorithmen und Architektur näher vorstellen. ?? Die folgende Abbildung zeigt das Benutzer-Ressourcen-Szenario-Zustand-räumlich-zeitliche Beziehungs-Interaktionsmatrixdiagramm. In der Ressourcendimension wird es auch ID-artige Merkmale geben, um den Status der Ressource selbst aufzuzeichnen, die vom Speicher dominiert wird. Es gibt auch Klartext-Porträtfunktionen, um grundlegende Generalisierungsfunktionen zu erreichen. Neben grobkörnigen Merkmalen wird es auch detailliertere Ressourcenmerkmale geben, z. B. Einbettungsporträtmerkmale, die auf der Grundlage vorab trainierter Modelle wie Multimodalität und detaillierterer Modellierung der Beziehung zwischen Ressourcen in der diskreten Einbettung erstellt werden Raum. Es gibt auch statistische Porträtmerkmale, die die nachträgliche Leistung von Ressourcen unter verschiedenen Umständen beschreiben. Neben Lookalike-Funktionen können Benutzer Ressourcen auch umgekehrt charakterisieren, um die Genauigkeit zu verbessern. In Bezug auf die Szenendimensionen gibt es unterschiedliche Szenenmerkmale wie einspaltige, immersive und zweispaltige Szenen. Stellt den Entscheidungsprozess der Benutzer-System-Interaktion umfassend anhand der vier Dimensionen Benutzer, Ressource, Status und Szenario dar. In vielen Fällen werden auch Kombinationen zwischen mehreren Dimensionen vorgenommen. 2. Prinzip des diskreten Feature-Designs Als nächstes stellen wir das Prinzip des diskreten Feature-Designs vor.

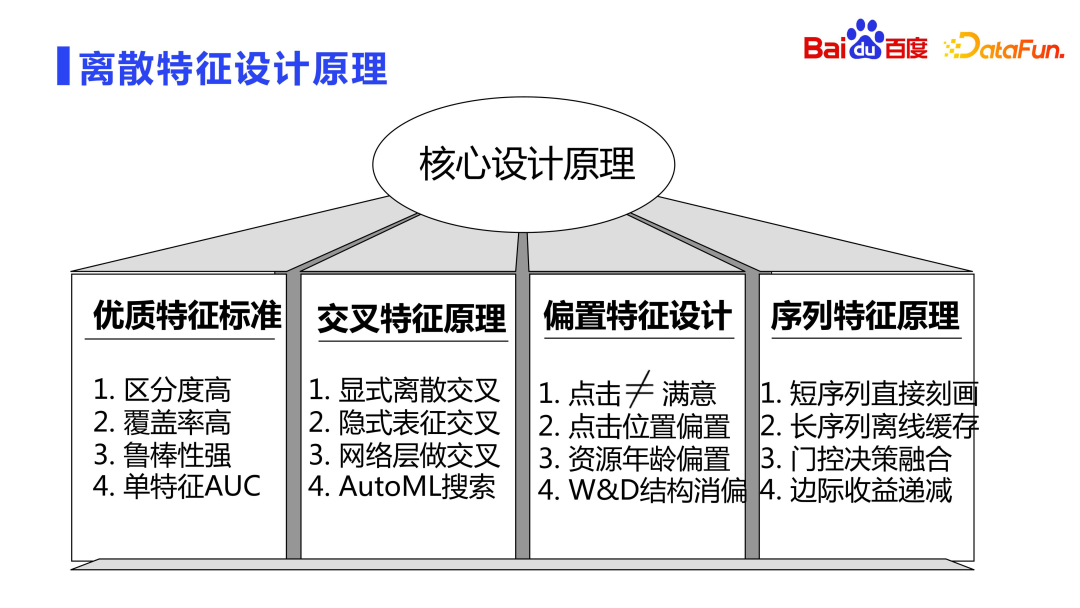

Hochwertige Merkmale weisen normalerweise drei Merkmale auf: hohe Unterscheidungsfähigkeit, hohe Abdeckung und starke Robustheit.

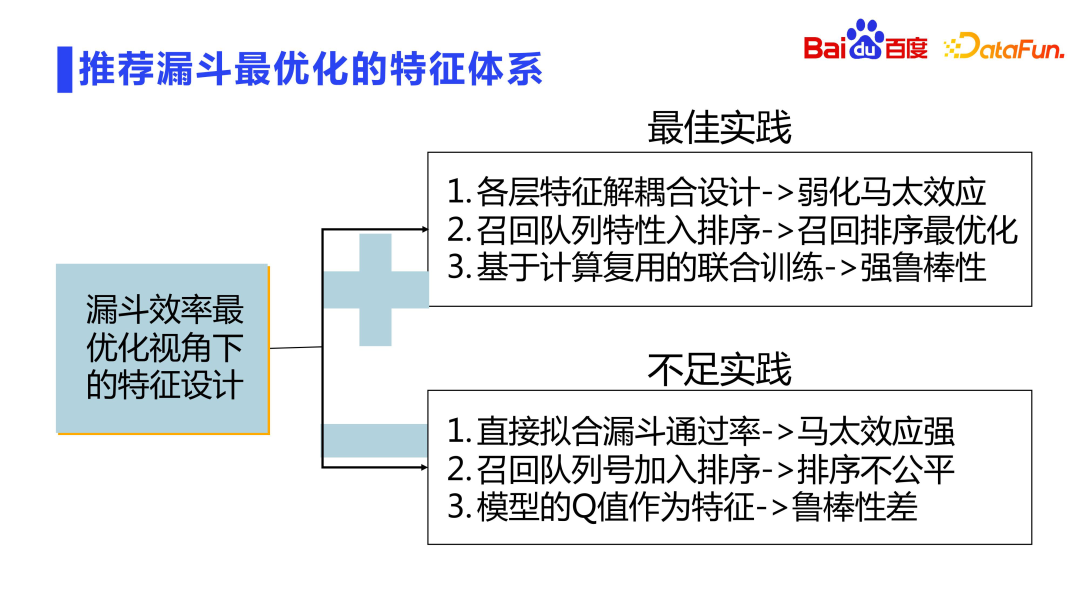

Hohe Abdeckung: Wenn die Abdeckung der hinzugefügten Merkmale in der gesamten Stichprobe nur einige Zehntausendstel oder Hunderttausendstel beträgt, besteht eine hohe Wahrscheinlichkeit, dass die Merkmale nicht unterscheidbar sind, selbst wenn sie sehr unterscheidbar sind Wirkung. Starke Robustheit: Die Verteilung der Features selbst muss relativ stabil sein und darf sich im Laufe der Zeit nicht sehr drastisch ändern. Der gesamte Empfehlungstrichter ist in Schichten gestaltet, und jede Schicht wird gefiltert und gekürzt. Wie erreicht man maximale Effizienz in einem geschichteten Design mit Filterkürzung? Wie bereits erwähnt, werden wir gemeinsam Modelle trainieren. Darüber hinaus können verwandte Designs auch in der Dimension Feature Design durchgeführt werden. Hier gibt es auch einige Probleme:

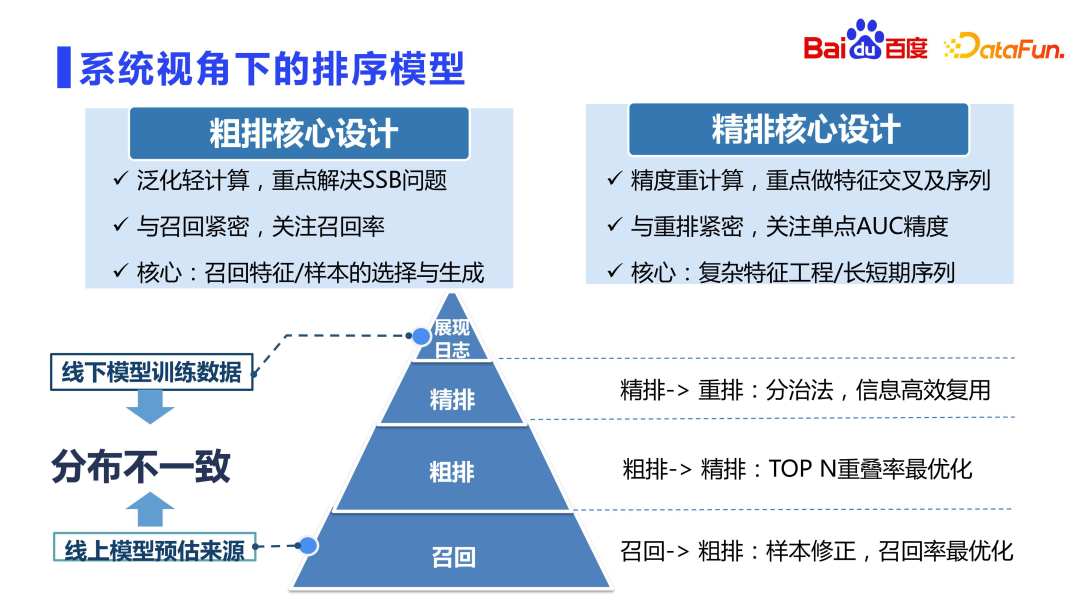

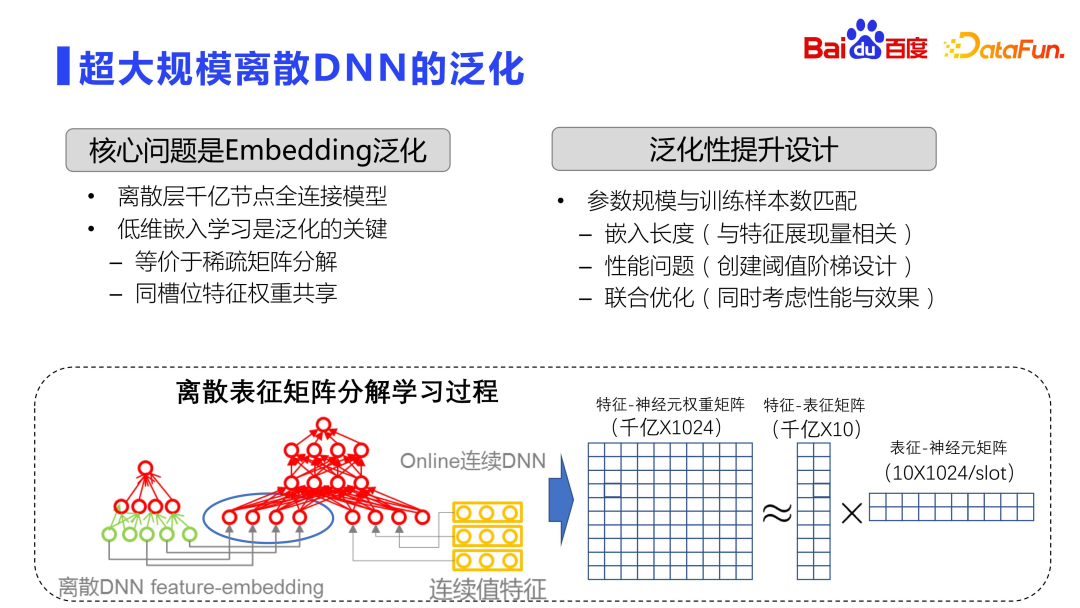

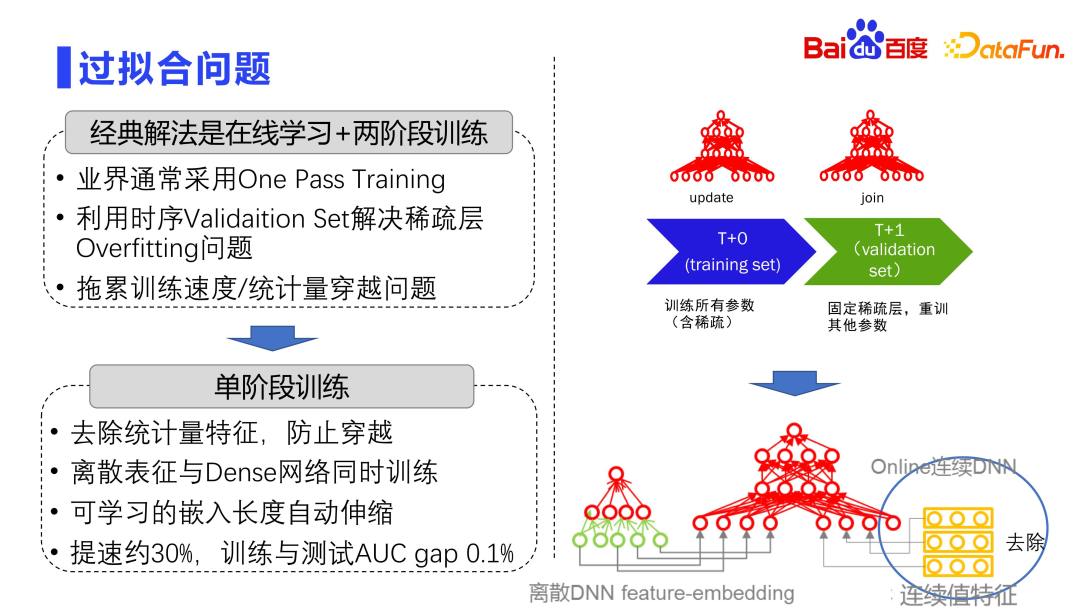

Als nächstes stellen wir das Design des Kernalgorithmus vor. Schauen wir uns zunächst das Empfehlungssortiermodell an. Es wird allgemein angenommen, dass das Feinranking das genaueste Modell im Empfehlungssystem ist. In der Branche herrscht die Ansicht vor, dass das Groblayout mit dem Feinlayout verknüpft ist und aus dem Feinlayout gelernt werden kann. In der Praxis hat sich jedoch herausgestellt, dass das Groblayout nicht direkt aus dem Feinlayout gelernt werden kann, was zu vielen Problemen führen kann. Wie Sie auf dem Bild oben sehen können, ist die Positionierung von Grobsortierung und Feinsortierung unterschiedlich. Im Allgemeinen sind die Trainingsmuster für die Grobsortierung dieselben wie die Muster für die Feinsortierung, bei denen es sich auch um Anzeigemuster handelt. Jedes Mal, wenn Zehntausende Kandidaten zur groben Einstufung und Bewertung zurückgerufen werden, werden mehr als 99 % der Ressourcen nicht angezeigt, und das Modell verwendet nur etwa ein Dutzend Ressourcen, die schließlich für das Training angezeigt werden, was die Unabhängigkeit unterbricht Unter der Annahme einer identischen Verteilung variiert die Verteilung von Offline-Modellen stark. Diese Situation ist beim Rückruf am schwerwiegendsten, da es sich bei den Rückrufkandidatensätzen um Millionen, Dutzende Millionen oder sogar Hunderte Millionen handelt und die meisten der zurückgegebenen Ergebnisse nicht angezeigt werden. Eine grobe Sortierung ist ebenfalls relativ schwerwiegend die Zehntausende. Die Feinsortierung ist relativ besser. Nach dem Durchlaufen des zweischichtigen Rückruftrichters und der Grobsortierung ist die grundlegende Qualität der Ressourcen gewährleistet. Daher ist das Problem der Offline-Verteilungsinkonsistenz beim Feinranking nicht so schwerwiegend, und es besteht keine Notwendigkeit, das Problem der Stichprobenauswahlverzerrung (SSB) zu sehr zu berücksichtigen. Da der Kandidatensatz jedoch klein ist, können umfangreiche Berechnungen durchgeführt werden Das Feinranking konzentriert sich auf Merkmalsüberschneidungen, Sequenzmodellierung usw. . Der Grad der Grobsortierung kann jedoch nicht direkt aus der Feinsortierung gelernt werden, noch kann er ähnlich wie bei der Feinsortierung direkt neu berechnet werden, da der Berechnungsaufwand um ein Vielfaches höher ist als bei der Feinsortierung, wenn Sie die Feinsortierung direkt verwenden Das Designkonzept besteht darin, dass Online-Maschinen völlig unerträglich sind. Daher erfordert das grobe Layout ein hohes Maß an Geschick, um Leistung und Wirkung in Einklang zu bringen. Es handelt sich um ein leichtes Modul. Der Schwerpunkt der groben Sortieriteration unterscheidet sich von dem der Feinsortierung. Sie löst hauptsächlich Probleme wie Stichprobenauswahlverzerrung und Optimierung der Rückrufwarteschlange. Da die Grobsortierung eng mit dem Rückruf zusammenhängt, wird der durchschnittlichen Qualität von Tausenden von Ressourcen, die zur Feinsortierung zurückgeführt werden, mehr Aufmerksamkeit geschenkt als der genauen Sortierbeziehung. Das Feinranking steht in engerem Zusammenhang mit der Neuordnung und konzentriert sich mehr auf die AUC-Genauigkeit eines einzelnen Punkts. Daher geht es bei der Gestaltung des Grobrankings eher um die Auswahl und Generierung von Stichproben sowie die Gestaltung von Generalisierungsmerkmalen und Netzwerken. Das verfeinerte Design kann komplexe Schnittfunktionen mehrerer Ordnungen, die Modellierung ultralanger Sequenzen usw. durchführen. Die vorherige Einführung erfolgt auf der Makroebene. Insbesondere im Hinblick auf den Modelltrainingsprozess besteht der derzeitige Mainstream in der Branche darin, diskretes DNN in extrem großem Maßstab zu verwenden, und das Generalisierungsproblem wird schwerwiegender sein. Da das diskrete DNN im ultragroßen Maßstab über die Einbettungsschicht hauptsächlich die Speicherfunktion übernimmt. Siehe die Abbildung oben. Der gesamte Einbettungsraum ist eine sehr große Matrix, normalerweise mit Hunderten von Milliarden oder Billionen Zeilen und 1.000 Spalten. Daher ist das Modelltraining vollständig verteilt, wobei Dutzende oder sogar Hunderte von GPUs das verteilte Training durchführen. Theoretisch werden für eine so große Matrix keine heftigen Berechnungen direkt durchgeführt, sondern es werden Operationen ähnlich der Matrixzerlegung verwendet. Natürlich unterscheidet sich diese Matrixzerlegung von der Standard-SVD-Matrixzerlegung. Die Matrixzerlegung lernt hier zunächst die niedrigdimensionale Darstellung und reduziert den Rechen- und Speicheraufwand durch die gemeinsame Nutzung von Parametern zwischen Slots, d. h. sie wird in zerlegt zwei Matrizen. Die erste ist die Merkmals- und Darstellungsmatrix, die die Beziehung zwischen dem Merkmal und der niedrigdimensionalen Einbettung erlernt. Diese Einbettung ist sehr gering, und normalerweise wird eine Einbettung von etwa zehn Dimensionen ausgewählt. Die andere ist die Einbettungs- und Neuronenmatrix, und die Gewichte zwischen den einzelnen Slots werden gemeinsam genutzt. Dadurch wird das Lagervolumen reduziert und die Wirkung verbessert. Low-dimensionales Einbettungslernen ist der Schlüssel zur Optimierung der Generalisierungsfähigkeit von Offline-DNN. Es entspricht der Durchführung einer spärlichen Matrixzerlegung. Daher liegt der Schlüssel zur Verbesserung der Generalisierungsfähigkeit des gesamten Modells Maßstab und Probennummer stimmen besser überein. Optimieren Sie unter mehreren Gesichtspunkten: Die Branche verwendet normalerweise eine zweistufige Trainingsmethode, um einer Überanpassung vorzubeugen. Das gesamte Modell besteht aus zwei Schichten, eine ist eine große diskrete Matrixschicht und die andere ist eine kleine Schicht mit dichten Parametern. Die diskrete Matrixschicht lässt sich sehr leicht überanpassen, daher wird in der Industrie in der Regel One Pass Training verwendet, also Online-Lernen, bei dem alle Daten durchgereicht werden und Batch-Training nicht wie in der Wissenschaft durchgeführt wird. Darüber hinaus verwendet die Branche normalerweise einen Timing-Validierungssatz, um das Überanpassungsproblem spärlicher Schichten zu lösen. Teilen Sie den gesamten Trainingsdatensatz entsprechend der Zeitdimension in viele Deltas, T0, T1, T2 und T3, auf. Jedes Training wird mit der diskreten Parameterschicht fixiert, die vor einigen Stunden trainiert wurde, und dann werden die nächsten Delta-Daten zur Feinabstimmung des dichten Netzwerks verwendet. Das heißt, durch Korrigieren der dünn besetzten Schicht und erneutes Trainieren anderer Parameter kann das Überanpassungsproblem des Modells gemildert werden. Dieser Ansatz bringt auch ein weiteres Problem mit sich, da das Training geteilt ist und die diskreten Parameter zum Zeitpunkt T0 jedes Mal festgelegt werden müssen und dann die Verbindungsstufe zum Zeitpunkt t + 1 neu trainiert wird, was die Zeit nach unten zieht Das gesamte Training bringt Skalierbarkeitsherausforderungen mit sich. Daher wurde in den letzten Jahren ein einstufiges Training eingeführt, das heißt, die diskrete Darstellungsschicht und die dichte Netzwerkschicht werden gleichzeitig in einem Delta aktualisiert. Es gibt auch ein Problem beim einstufigen Training, da das gesamte Modell zusätzlich zu den Einbettungsfunktionen auch über viele kontinuierlich bewertete Funktionen verfügt. Diese kontinuierlich bewerteten Funktionen zählen daher möglicherweise die Anzeigeklicks Gefahr der Datenüberschreitung. Daher besteht in der tatsächlichen Praxis der erste Schritt darin, die Merkmale der Statistik zu entfernen, und der zweite Schritt besteht darin, das dichte Netzwerk zusammen mit der diskreten Darstellung unter Verwendung einer einstufigen Trainingsmethode zu trainieren. Darüber hinaus ist die gesamte eingebettete Länge automatisch skalierbar. Durch diese Methodenreihe kann das Modelltraining um etwa 30 % beschleunigt werden. Die Praxis zeigt, dass der Grad der Überanpassung dieser Methode sehr gering ist und der Unterschied zwischen der AUC von Training und Test 1/1000 oder weniger beträgt.

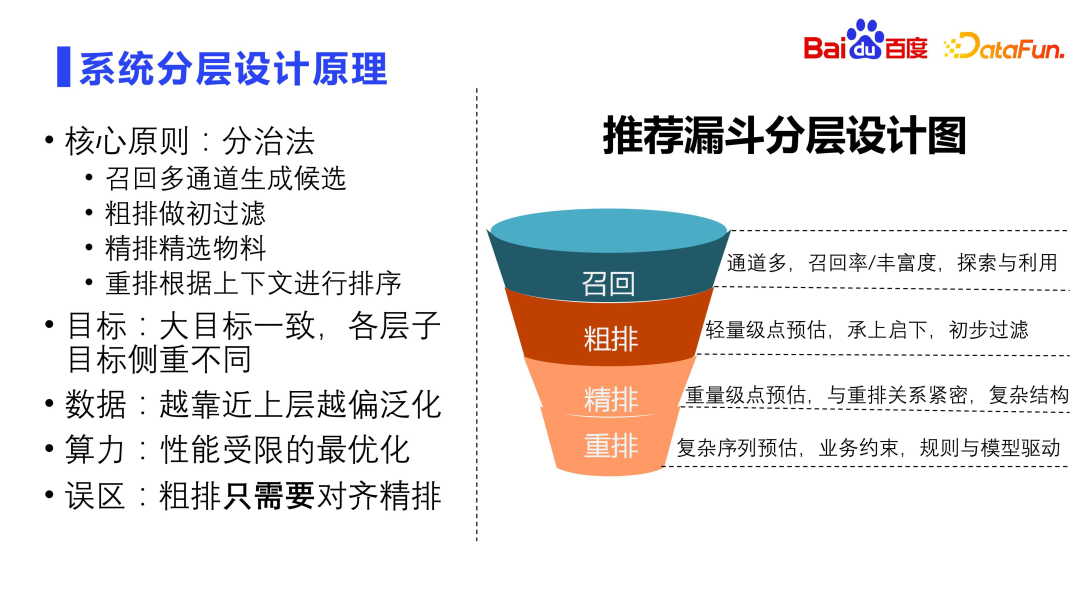

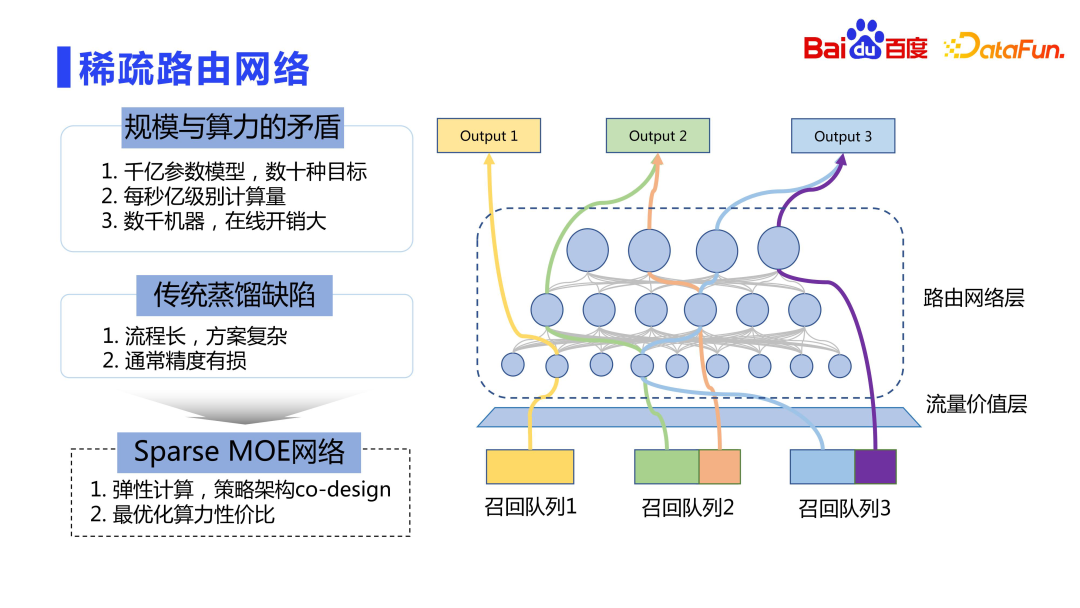

Als nächstes werde ich meine Gedanken und Erfahrungen zum Architekturdesign vorstellen. Das Kernprinzip des Systemdesigns ist die Divide-and-Conquer-Methode. Der Rückruf erfordert mehrere Kanäle. Das Hauptziel besteht darin, die Rückrufrate und den Umfang der Rückrufressourcen zu verbessern. Gleichzeitig sollte der Rückruf auch die Fragen der Exploration und Nutzung berücksichtigen, die die grundlegende Garantie für den Empfehlungseffekt darstellen. Die grobe Sortierung ist die erste Filterebene, hauptsächlich für die einfache Punktschätzung, und verbindet den vorherigen mit dem nächsten. Das Feinranking erfordert in der Regel umfangreiche Berechnungen und Vorhersagen. Es verwendet normalerweise sehr komplexe Strukturen und steht auch im Mittelpunkt der Branchenforschung. Die Neuanordnung ist die letzte Ebene und bestimmt die endgültige Anzeigereihenfolge. Basierend auf den Ergebnissen der Feineinstufung wird der Kontext berücksichtigt und eine komplexe Reihenfolgenvorhersage vorgenommen, d. h. eine listenweise Sortierung. Bei der Neuordnung müssen viele geschäftliche Einschränkungen berücksichtigt werden. Es enthält viele Regeln, einschließlich Trennung, LCN, Exit usw. Es handelt sich um ein Modul, das sowohl von Regeln als auch von Modellen gesteuert wird. Die Ziele jeder Ebene des Empfehlungssystems sind grundsätzlich gleich, aber der Fokus jeder Ebene ist unterschiedlich. Beim Rückruf und der groben Einstufung liegt der Schwerpunkt auf der Generalisierung und der Rückrufrate, bei der Feineinstufung liegt der Schwerpunkt auf der Genauigkeit der Einzelpunkt-AUC und bei der Neuordnung liegt der Schwerpunkt auf der Gesamtsequenzoptimierung. Aus Datensicht gilt: Je näher der Rückruf an der Grobsortierung liegt, desto allgemeiner ist er, und je näher er an der Feinsortierung und Neuanordnung liegt, desto mehr Präzision ist erforderlich. Je näher an der Rückrufquelle, desto gravierender ist die Leistungseinschränkung, denn je mehr Kandidatenressourcen vorhanden sind, desto größer ist die Rechenkomplexität. Es ist ein Missverständnis, dass die Grobsortierung nur mit der Feinsortierung abgeglichen werden muss. Bei der Grobsortierung muss die Konsistenz mit der Feinsortierung berücksichtigt werden, sie kann jedoch nicht nur mit der Feinsortierung abgeglichen werden. Wenn Sie nichts für die grobe Sortierung tun und nur eine Ausrichtung und eine feine Sortierung vornehmen, wird dies zu einem sehr ernsten Pferd -Effekt führen. Denn gutes Ranking ist nicht die Grundwahrheit, sondern das Benutzerverhalten. Sie müssen das Benutzerverhalten gut erlernen, nicht das gute Ranking. In den Anfangsjahren wurde die Neuordnung direkt anhand der Ergebnisse des Feinrankings trainiert , es ist sehr ernst. Andererseits kann die direkte Verwendung einer präzisen Bewertung für das Training leicht zu Online-Schwankungen führen. Baidu Fengchao CTR 3.0 gemeinsames Trainingsprojekt für feines Ranking und Neuordnung nutzt sehr geschickt Modelle, um gleichzeitig zu trainieren, um das Problem der Punktekopplung zu vermeiden. Dieses Projekt verwendet die verborgene Schicht und die interne Bewertung des Feinranking-Subnetzwerks als Merkmale des Neuordnungs-Subnetzwerks. Anschließend werden die Feinranking- und Neuordnungs-Subnetzwerke getrennt und in ihren jeweiligen Modulen eingesetzt. Einerseits können die Zwischenergebnisse ohne das durch die Scoring-Kopplung verursachte Fluktuationsproblem gut wiederverwendet werden. Gleichzeitig wird die Genauigkeit der Neuanordnung um ein Perzentil verbessert. Dies war auch eines der Teilprojekte, die in diesem Jahr die höchste Auszeichnung von Baidu erhielten. Beachten Sie außerdem, dass es sich bei diesem Projekt nicht um ESSM handelt, sondern um CTCVR-Modellierung und Mehrobjektivmodellierung. Das gemeinsame CTR3.0-Training löst hauptsächlich das Problem der Bewertung der Kopplungs- und Neuordnungsmodellgenauigkeit. Außerdem müssen Rückruf und Grobsortierung entkoppelt werden, da neue Warteschlangen hinzukommen, was den neuen Warteschlangen möglicherweise nicht gerecht wird. Daher wird eine zufällige Maskierungsmethode vorgeschlagen, bei der einige Merkmale zufällig ausgeblendet werden, sodass der Kopplungsgrad nicht so stark ist. Abschließend werfen wir einen Blick auf den Online-Bereitstellungsprozess. Die Skala der Modellparameter liegt in der Größenordnung von Hunderten von Milliarden bis Billionen, und es gibt viele Ziele. Die direkte Online-Bereitstellung ist sehr teuer, und wir können nicht nur den Effekt berücksichtigen, ohne die Leistung zu berücksichtigen. Ein besserer Weg ist die elastische Berechnung, ähnlich der Idee von Sparse MOE. Rough Queue hat Zugriff auf viele Warteschlangen, mit Dutzenden oder sogar Hunderten von Warteschlangen. Diese Warteschlangen haben unterschiedliche Online-Werte (LTV). Die Verkehrswertschicht berechnet den Wert verschiedener Rückrufwarteschlangen für die Online-Klickdauer. Der Kerngedanke besteht darin, dass die Berechnungen umso komplexer sind, je größer der Gesamtbeitrag der Rückrufwarteschlange ist. Dadurch ist es möglich, mit begrenzter Rechenleistung höherwertigen Datenverkehr zu bedienen. Daher haben wir nicht die traditionelle Destillationsmethode verwendet, sondern eine ähnliche Idee wie Sparse MOE für elastisches Computing übernommen, nämlich das gemeinsame Design von Strategie und Architektur, sodass verschiedene Rückrufwarteschlangen das am besten geeignete Ressourcennetzwerk für die Berechnung verwenden können .

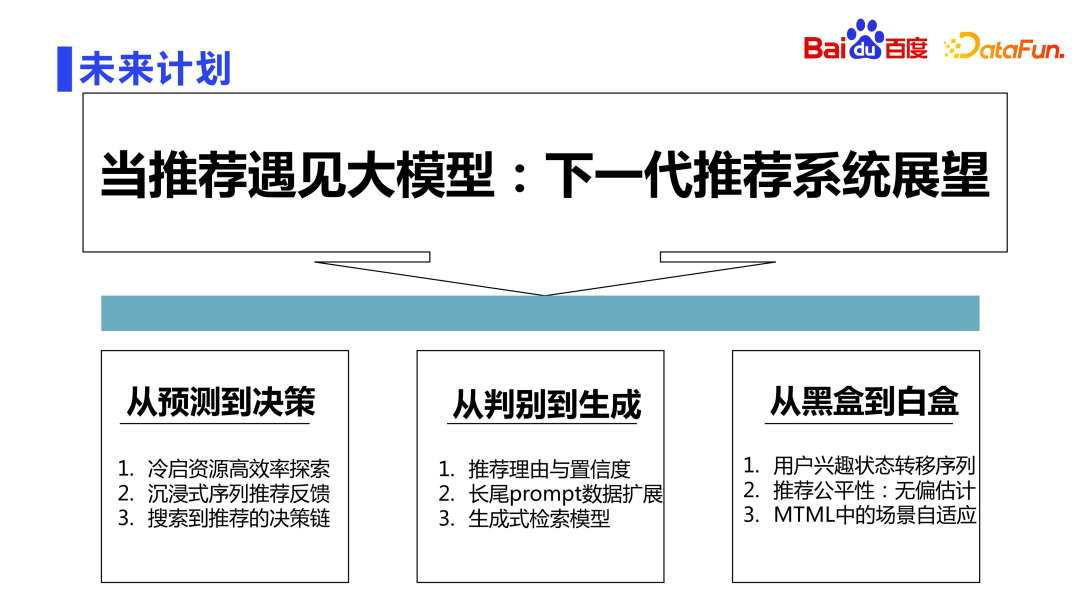

Wie wir alle wissen, sind wir jetzt in die Ära der LLM-Großmodelle eingetreten. Baidus Untersuchung des Empfehlungssystems der nächsten Generation basierend auf dem großen LLM-Sprachmodell wird unter drei Aspekten durchgeführt. Der erste Aspekt besteht darin, das Modell von der einfachen Vorhersage auf die Fähigkeit, Entscheidungen zu treffen, zu aktualisieren. Beispielsweise können wichtige Themen wie die effiziente Erkundung klassischer Kaltstartressourcen, immersives Feedback zu Sequenzempfehlungen und die Entscheidungskette von der Suche bis zur Empfehlung mithilfe großer Modelle gelöst werden. Der zweite Aspekt betrifft die Unterscheidung bis zur Generierung. In Zukunft werden wir generative Empfehlungsmethoden untersuchen, z. B. die automatische Generierung von Empfehlungsgründen, die automatische Verbesserung von Long-Tail-Daten auf der Grundlage von Eingabeaufforderungen und generative Methoden Retrieval-Modell. Der dritte Aspekt ist von der Black Box zur White Box. Im traditionellen Empfehlungssystem wird oft gesagt, dass neuronale Netzwerke eine Alchemie und eine Black Box sind einer der wichtigen Aufgaben der Zukunft. Basierend auf Ursache und Wirkung können wir beispielsweise die Gründe für Zustandsübergänge im Benutzerverhalten untersuchen, bessere unvoreingenommene Schätzungen der Empfehlungsgerechtigkeit vornehmen und eine bessere Szenenanpassung in Multi-Task-Machine-Learning-Szenarien durchführen.

Unterteilen Sie zunächst alle Signale in die vier Dimensionen Benutzer, Ressourcen, Szenarien und Zustände, denn im Wesentlichen wollen wir die Beziehung zwischen Benutzern und Ressourcen modellieren. In jeder Dimension können verschiedene Porträtdaten erzeugt werden.

Aus Benutzersicht die grundlegendsten Porträts von Alter, Geschlecht und Sehenswürdigkeiten. Auf dieser Grundlage wird es auch einige feinkörnige Funktionen geben, wie etwa ähnliche Benutzer und das historische Präferenzverhalten der Benutzer für verschiedene Ressourcentypen. Sitzungsmerkmale sind hauptsächlich lang- und kurzfristige Verhaltenssequenzen. Es gibt viele Sequenzmodelle in der Branche, daher werde ich hier nicht auf Details eingehen. Unabhängig davon, welche Art von Sequenzmodell Sie erstellen, sind diskrete Sitzungsfunktionen auf Funktionsebene unverzichtbar. In der Suchmaschinenwerbung von Baidu wurde diese Art von feinkörniger Sequenzfunktion vor mehr als 10 Jahren eingeführt, die das Klickverhalten, das Verbrauchsverhalten usw. des Benutzers auf verschiedenen Ressourcentypen in verschiedenen Zeitfenstern sorgfältig darstellt.

Hohe Unterscheidungskraft: Nach dem Hinzufügen von Merkmalen ist der hintere Teil sehr unterschiedlich. Beispielsweise ist bei einer Stichprobe, die Merkmal a hinzufügt, die Lücke zwischen der hinteren Klickrate und der hinteren Klickrate, die Merkmal a nicht trifft, sehr groß.

Es gibt eine sehr klassische Struktur für voreingenommene Funktionen, nämlich die von Google vorgeschlagene Wide&Deep-Struktur. Auf der breiten Seite werden normalerweise verschiedene voreingenommene Funktionen platziert, die direkt online zugeschnitten werden können der Effekt einer unvoreingenommenen Schätzung.

3. Optimiertes Funktionssystem des Empfehlungstrichters

3. Algorithmus

1. Sortiermodell aus Systemperspektive

2. Verallgemeinerung sehr großer diskreter DNN

3. Überanpassungsproblem

IV. Architektur

1. System-Layer-Design-Prinzip

2. Mehrstufiges Modell-Gemeinschaftstraining

3. Sparse-Routing-Netzwerk

5. Zukunftspläne

Das obige ist der detaillierte Inhalt vonErforschung und Anwendung der Baidu-Sortiertechnologie. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

So laden Sie Binance herunter

So laden Sie Binance herunter

Der Unterschied zwischen Win7 32-Bit und 64-Bit

Der Unterschied zwischen Win7 32-Bit und 64-Bit

So verwenden Sie die Shift-Hintertür

So verwenden Sie die Shift-Hintertür

Welche anmeldefreien Plätze gibt es in China?

Welche anmeldefreien Plätze gibt es in China?

vlookup gleicht zwei Datenspalten ab

vlookup gleicht zwei Datenspalten ab

Lösung für fehlgeschlagene Verbindung zwischen wsus und Microsoft-Server

Lösung für fehlgeschlagene Verbindung zwischen wsus und Microsoft-Server

Welche Videoformate gibt es?

Welche Videoformate gibt es?

Waffenkammerkiste

Waffenkammerkiste