Papier: Lift-Attend-Splat-Methode für die Fusion von Vogelperspektivenkameras und Lidar mithilfe der Transformer-Technologie

Bitte klicken Sie auf den Link, um die Datei anzuzeigen: https://arxiv.org/pdf/2312.14919.pdf

Zur Sicherheit- Bei kritischen Anwendungen wie dem autonomen Fahren ist es entscheidend, komplementäre Sensormodalitäten zu kombinieren. Neuere Kamera-Lidar-Fusionsmethoden für autonomes Fahren verwenden eine monokulare Tiefenschätzung, um die Wahrnehmung zu verbessern. Dies ist jedoch eine schwierige Aufgabe im Vergleich zur direkten Nutzung von Tiefeninformationen aus Lidar. Unsere Studie kommt zu dem Schluss, dass dieser Ansatz die Tiefeninformationen nicht vollständig ausnutzt, und zeigt, dass eine naive Verbesserung der Tiefenschätzung nicht zu einer Verbesserung der Objekterkennungsleistung führt. Überraschenderweise beeinträchtigt das vollständige Entfernen der Tiefenschätzung nicht die Objekterkennungsleistung

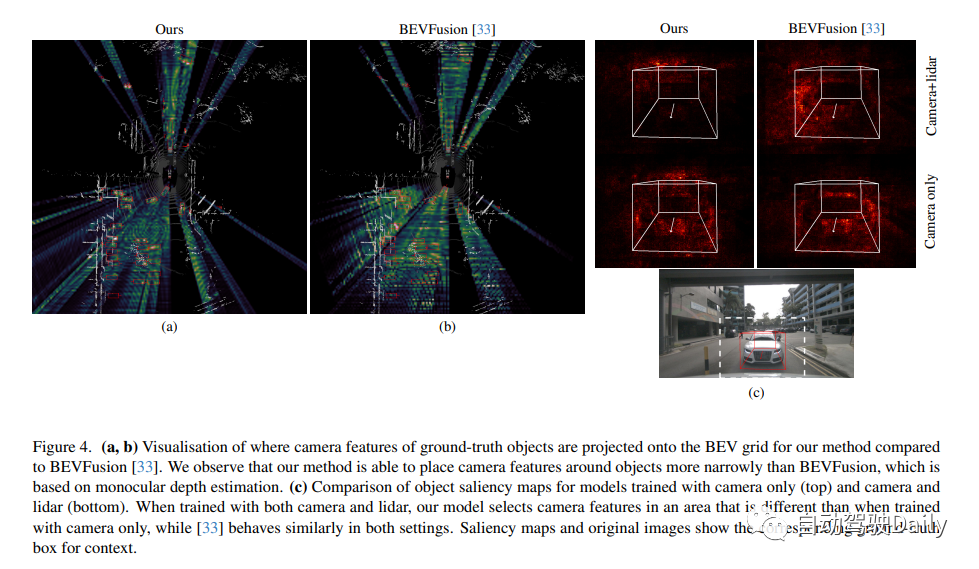

Dies deutet darauf hin, dass die Abhängigkeit von der monokularen Tiefe ein unnötiger architektonischer Engpass bei der Kamera-Lidar-Fusion sein könnte. Diese Studie schlägt eine neue Fusionsmethode vor, die die monokulare Tiefenschätzung vollständig umgeht und stattdessen einen einfachen Aufmerksamkeitsmechanismus verwendet, um Kamera- und Lidar-Merkmale in einem BEV-Gitter auszuwählen und zu fusionieren. Die Ergebnisse zeigen, dass das vorgeschlagene Modell in der Lage ist, die Verwendung von Kamerafunktionen basierend auf der Verfügbarkeit von Lidar-Funktionen anzupassen und eine bessere 3D-Erkennungsleistung im nuScenes-Datensatz aufweist als Basismodelle, die auf monokularer Tiefenschätzung basieren.

Einführung in diese Studie Eine neue Kamera -Lidar-Fusion-Methode namens „Lift Attented Splat“ entwickelt. Diese Methode vermeidet eine monokulare Tiefenschätzung und nutzt stattdessen einen einfachen Transformator zur Auswahl und Fusion von Kamera- und Lidar-Funktionen im BEV. Experimente belegen, dass diese Forschungsmethode im Vergleich zu Methoden, die auf monokularer Tiefenschätzung basieren, Kameras besser nutzen und die Objekterkennungsleistung verbessern kann. Die Beiträge dieser Studie sind wie folgt:

Die Genauigkeit der Tiefenvorhersage ist normalerweise gering. Qualitative und quantitative Analysen können durchgeführt werden, indem die von BEVFusion vorhergesagte Tiefenqualität mit LIDAR-Tiefenkarten unter Verwendung des absoluten relativen Fehlers (Abs.Rel.) und des quadratischen Mittelfehlers (RMSE) verglichen wird. Wie in Abbildung 1 dargestellt, spiegelt die Tiefenvorhersage die Struktur der Szene nicht genau wider und unterscheidet sich erheblich von der Lidar-Tiefenkarte, was darauf hindeutet, dass die monokulare Tiefe nicht wie erwartet vollständig genutzt wird. Die Studie ergab auch, dass eine Verbesserung der Tiefenvorhersage die Objekterkennungsleistung nicht verbessert! Das vollständige Entfernen der Tiefenvorhersage hat keinen Einfluss auf die Objekterkennungsleistung

Wir schlagen eine Kamera-Lidar-Fusionsmethode vor, die die monokulare Tiefenschätzung vollständig umgeht und stattdessen einen einfachen Transformator verwendet, um Kamera- und Lidar-Funktionen aus der Vogelperspektive zu fusionieren. Aufgrund der großen Anzahl von Kamera- und Lidar-Funktionen und der quadratischen Natur der Aufmerksamkeit ist es jedoch schwierig, die Transformatorarchitektur einfach auf das Kamera-Lidar-Fusionsproblem anzuwenden. Bei der Projektion von Kameramerkmalen in BEV kann die Geometrie des Problems genutzt werden, um den Aufmerksamkeitsbereich erheblich einzuschränken, da Kameramerkmale nur zur Position entlang ihrer entsprechenden Strahlen beitragen sollten. Wir wenden diese Idee auf den Fall der Kamera-Lidar-Fusion an und stellen eine einfache Fusionsmethode vor, die die Kreuzaufmerksamkeit zwischen Säulen in der Kameraebene und Polarstrahlen im Lidar-BEV-Gitter nutzt! Anstatt die monokulare Tiefe vorherzusagen, lernt die Kreuzaufmerksamkeit, welche Kameramerkmale im Kontext, der durch LIDAR-Merkmale entlang ihrer Strahlen bereitgestellt wird, am hervorstechendsten sind

Unser Modell hat eine ähnliche Gesamtarchitektur wie Methoden, die auf dem Lift-Splat-Paradigma basieren, zusätzlich zur Projektion von Kameramerkmalen im BEV. Wie in der Abbildung unten dargestellt, besteht es aus einem Kamera- und Lidar-Backbone, einem Modul, das jedes modale Merkmal unabhängig generiert, einem Projektions- und Fusionsmodul, das die Kameramerkmale in das BEV einbettet und sie mit dem Lidar verschmilzt, und einem Erkennungskopf. Bei der Betrachtung der Zielerkennung besteht die endgültige Ausgabe des Modells aus den Attributen des Ziels in der Szene, einschließlich Position, Abmessung, Richtung, Geschwindigkeit und Klassifizierungsinformationen, dargestellt in Form eines 3D-Begrenzungsrahmens

Lift Attented Splat-Kamera-Lidar-Fusion Architektur ist unten dargestellt. (Links) Gesamtarchitektur: Merkmale der Kamera und des Lidar-Backbones werden miteinander verschmolzen, bevor sie an den Erkennungskopf weitergeleitet werden. (Einschub) Die Geometrie unserer 3D-Projektion: Der „Lift“-Schritt bettet die LIDAR-BEV-Features in den projizierten Horizont ein, indem bilineares Sampling verwendet wird, um die LIDAR-Features entlang der Z-Richtung anzuheben. Der „Splat“-Schritt entspricht der inversen Transformation, da er bilineares Sampling verwendet, um die Merkmale vom projizierten Horizont zurück auf das BEV-Gitter zu projizieren, wiederum entlang der Z-Richtung! Rechts finden Sie die Details zum Projektmodul.

Originallink: https://mp.weixin.qq.com/s/D7xgvrp8633S2SeUfCRFXQ

Das obige ist der detaillierte Inhalt vonNeue BEV LV Fusion-Lösung: Lift-Attend-Splat über BEVFusion hinaus. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

So behalten Sie die Anzahl der Dezimalstellen in C++ bei

So behalten Sie die Anzahl der Dezimalstellen in C++ bei

Was ist xfce

Was ist xfce

Netzwerktopologie

Netzwerktopologie

Warum ist die Mobilfunkkarte auf Notrufe beschränkt?

Warum ist die Mobilfunkkarte auf Notrufe beschränkt?

Welche Netzwerksicherheitstechnologien gibt es?

Welche Netzwerksicherheitstechnologien gibt es?

Mit welchen Methoden kann Docker in den Container gelangen?

Mit welchen Methoden kann Docker in den Container gelangen?

Gängige Methoden zur Erkennung von Website-Schwachstellen

Gängige Methoden zur Erkennung von Website-Schwachstellen

Welche Mobiltelefone unterstützt Hongmeng OS?

Welche Mobiltelefone unterstützt Hongmeng OS?